近年來(lái),預(yù)訓(xùn)練語(yǔ)言模型(PLM)在各種下游自然語(yǔ)言處理任務(wù)中表現(xiàn)出卓越的性能,受益于預(yù)訓(xùn)練階段的自監(jiān)督學(xué)習(xí)目標(biāo),PLM 可以有效地捕獲文本中的語(yǔ)法和語(yǔ)義,并為下游 NLP 任務(wù)提供蘊(yùn)含豐富信息的語(yǔ)言表示。然而,傳統(tǒng)的預(yù)訓(xùn)練目標(biāo)并沒(méi)有對(duì)文本中的關(guān)系事實(shí)進(jìn)行建模,而這些關(guān)系事實(shí)對(duì)于文本理解至關(guān)重要。

在這篇被ACL 2021主會(huì)錄用的文章中,清華大學(xué)聯(lián)合騰訊微信模式識(shí)別中心與伊利諾伊大學(xué)厄巴納香檳分校(UIUC),提出了一種新穎的對(duì)比學(xué)習(xí)框架ERICA,幫助PLM深入了解文本中的實(shí)體及實(shí)體間關(guān)系。具體來(lái)說(shuō),作者提出了兩個(gè)輔助性預(yù)訓(xùn)練任務(wù)來(lái)幫助PLM更好地理解實(shí)體和實(shí)體間關(guān)系:(1)實(shí)體區(qū)分任務(wù),給定頭實(shí)體和關(guān)系,推斷出文本中正確的尾實(shí)體;(2)關(guān)系判別任務(wù),區(qū)分兩個(gè)關(guān)系在語(yǔ)義上是否接近,這在長(zhǎng)文本情景下涉及復(fù)雜的關(guān)系推理。實(shí)驗(yàn)結(jié)果表明,ERICA在不引入額外神經(jīng)網(wǎng)絡(luò)參數(shù)的前提下,僅僅對(duì)PLM進(jìn)行少量的額外訓(xùn)練,就可以提升典型PLM(例如BERT 和 RoBERTa)在多種自然語(yǔ)言理解任務(wù)上(包括關(guān)系抽取、實(shí)體類(lèi)別區(qū)分、問(wèn)題回答等)的性能。尤其是在低資源(low-resource)的設(shè)定下,性能的提升更加明顯。

一、問(wèn)題背景

傳統(tǒng)的預(yù)訓(xùn)練目標(biāo)沒(méi)有對(duì)文本中的關(guān)系事實(shí)進(jìn)行顯式建模,而這些關(guān)系事實(shí)對(duì)于理解文本至關(guān)重要。為了解決這個(gè)問(wèn)題,一些研究人員試圖改進(jìn) PLM 的架構(gòu)、預(yù)訓(xùn)練任務(wù)等,以更好地理解實(shí)體之間的關(guān)系。但是它們通常只對(duì)文本中的句子級(jí)別的單個(gè)關(guān)系進(jìn)行建模,不僅忽略了長(zhǎng)文本場(chǎng)景下多個(gè)實(shí)體之間的復(fù)雜關(guān)系,也忽略了對(duì)實(shí)體本身的理解,例如圖1中所展現(xiàn)的,對(duì)于長(zhǎng)文本來(lái)說(shuō),為了讓PLM更加充分理解地單個(gè)實(shí)體,我們需要考慮該實(shí)體和其他實(shí)體之間的復(fù)雜關(guān)系;而這些復(fù)雜的關(guān)系的理解通常涉及復(fù)雜的推理鏈,往往需要綜合多個(gè)句子的信息得出結(jié)論。針對(duì)這兩個(gè)痛點(diǎn),本文提出了實(shí)體區(qū)分任務(wù)和關(guān)系區(qū)分任務(wù)來(lái)增強(qiáng)PLM對(duì)于實(shí)體和實(shí)體間關(guān)系的理解。

二 、文檔級(jí)預(yù)訓(xùn)練數(shù)據(jù)收集

ERICA的訓(xùn)練依賴(lài)于大規(guī)模文檔級(jí)遠(yuǎn)程監(jiān)督數(shù)據(jù),該數(shù)據(jù)的構(gòu)造有三個(gè)階段:首先從wikipedia中爬取文本段落,然后用命名實(shí)體識(shí)別工具(例如spacy)進(jìn)行實(shí)體標(biāo)注,將所有獲得的實(shí)體和wikidata中標(biāo)注的實(shí)體對(duì)應(yīng)上,并利用遠(yuǎn)程監(jiān)督(distant supervision)信號(hào)獲得實(shí)體之間可能存在的關(guān)系,最終保留長(zhǎng)度在128到512之間,含有多于4個(gè)實(shí)體,實(shí)體間多于4個(gè)遠(yuǎn)程監(jiān)督關(guān)系的段落。注意這些遠(yuǎn)程監(jiān)督的關(guān)系中存在大量的噪聲,而大規(guī)模的預(yù)訓(xùn)練可以一定程度上實(shí)現(xiàn)降噪。作者也開(kāi)源了由100萬(wàn)個(gè)文檔組成的大規(guī)模遠(yuǎn)程監(jiān)督預(yù)訓(xùn)練數(shù)據(jù)。

三 、實(shí)體與實(shí)體間關(guān)系的表示

鑒于每個(gè)實(shí)體可能在段落中出現(xiàn)多次,并且每次出現(xiàn)時(shí)對(duì)應(yīng)的描述(mention)可能也不一樣,作者在使用PLM對(duì)tokenize后的段落進(jìn)行編碼后,取每個(gè)描述的所有token均勻池化后的結(jié)果作為該描述的表示,接著對(duì)于全文中該實(shí)體所有的描述進(jìn)行第二次均勻池化,得到該實(shí)體在該文檔中的表示;對(duì)于兩個(gè)實(shí)體,它們之間的關(guān)系表示為兩個(gè)實(shí)體表示的簡(jiǎn)單拼接。以上是最簡(jiǎn)單的實(shí)體/實(shí)體間關(guān)系的表示方法,不需要引入額外的神經(jīng)網(wǎng)絡(luò)參數(shù)。作者在文中還探索了其它的表示方法,并驗(yàn)證了所有方法相比baseline都有一致的提升。

四 、實(shí)體區(qū)分任務(wù)

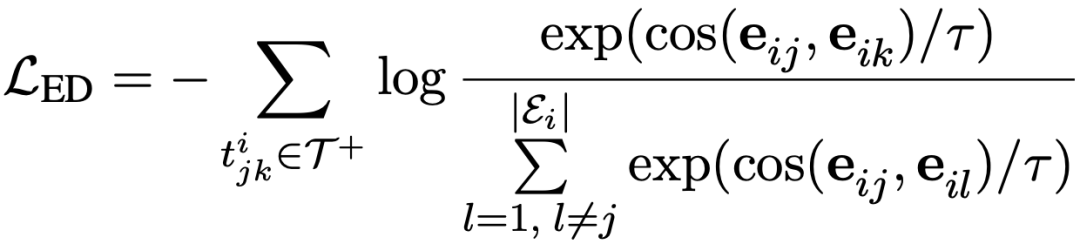

實(shí)體區(qū)分任務(wù)旨在給定頭實(shí)體和關(guān)系,從當(dāng)前文檔中尋找正確的尾實(shí)體。例如在上圖中,Sinaloa和Mexico具有country的遠(yuǎn)程關(guān)系,于是作者將關(guān)系country和頭實(shí)體Sinaloa拼接在原文檔的前面作為提示(prompt),在此條件下區(qū)分正確的尾實(shí)體的任務(wù)可以在對(duì)比學(xué)習(xí)的框架下轉(zhuǎn)換成拉近頭實(shí)體和正確尾實(shí)體的實(shí)體表示的距離,推遠(yuǎn)頭實(shí)體和文檔中其它實(shí)體(負(fù)樣本)的實(shí)體表示的距離,具體的公式如下所示:

五、關(guān)系區(qū)分任務(wù)

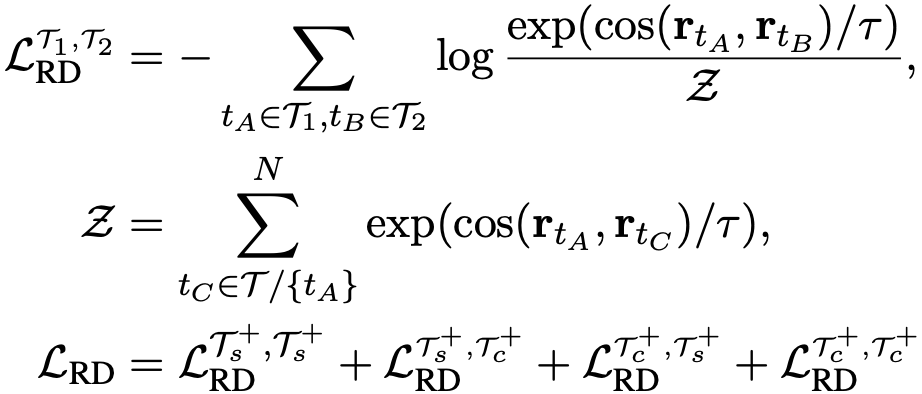

關(guān)系區(qū)分任務(wù)旨在區(qū)分兩個(gè)關(guān)系的表示在語(yǔ)義空間上的相近程度。由于作者采用文檔級(jí)而非句子級(jí)的遠(yuǎn)程監(jiān)督,文檔中的關(guān)系區(qū)分涉及復(fù)雜的推理鏈。具體而言,作者隨機(jī)采樣多個(gè)文檔,并從每個(gè)文檔中得到多個(gè)關(guān)系表示,這些關(guān)系可能只涉及句子級(jí)別的推理,也可能涉及跨句子的復(fù)雜推理。之后基于對(duì)比學(xué)習(xí)框架,根據(jù)遠(yuǎn)程監(jiān)督的標(biāo)簽在關(guān)系空間中對(duì)不同的關(guān)系表示進(jìn)行訓(xùn)練,如前文所述,每個(gè)關(guān)系表示均由文檔中的兩個(gè)實(shí)體表示構(gòu)成。正樣本即具有相同遠(yuǎn)程監(jiān)督標(biāo)簽的關(guān)系表示,負(fù)樣本與此相反。作者在實(shí)驗(yàn)中還發(fā)現(xiàn)進(jìn)一步引入不具有遠(yuǎn)程監(jiān)督關(guān)系的實(shí)體對(duì)作為負(fù)樣本可以進(jìn)一步提升模型效果。由于進(jìn)行對(duì)比訓(xùn)練的兩個(gè)關(guān)系表示可能來(lái)自于多個(gè)文檔,也可能來(lái)自于單個(gè)文檔,因此文檔間/跨文檔的關(guān)系表示交互都得到了實(shí)現(xiàn)。巧妙的是,對(duì)于涉及復(fù)雜推理的關(guān)系,該方法不需要顯示地構(gòu)建推理鏈,而是“強(qiáng)迫”模型理解這些關(guān)系并在頂層的關(guān)系語(yǔ)義空間中區(qū)分這些關(guān)系。具體的公式如下所示:

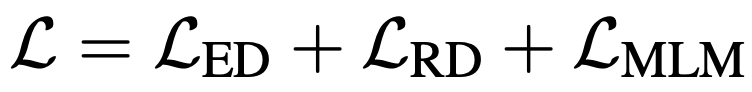

為了避免災(zāi)難性遺忘,作者將上述兩個(gè)任務(wù)同masked language modeling (MLM)任務(wù)一起訓(xùn)練,總的訓(xùn)練目標(biāo)如下所示:

六、實(shí)驗(yàn)結(jié)果

ERICA的訓(xùn)練不需要引入除了PLM之外的任何參數(shù),并且對(duì)于任意模型均能夠適配,具體的,作者采用了兩個(gè)經(jīng)典的PLM:BERT和RoBERTa,并對(duì)其進(jìn)行一定時(shí)間的post-training,最后在文檔級(jí)關(guān)系抽取、實(shí)體類(lèi)別區(qū)分、問(wèn)題回答等任務(wù)上進(jìn)行了測(cè)試,并對(duì)比了例如CorefBERT, SpanBERT, ERNIE, MTB,CP等基線模型,驗(yàn)證了ERICA框架的有效性。具體結(jié)果如下:

a) 文檔級(jí)關(guān)系抽取,模型需要區(qū)分文檔中的多個(gè)實(shí)體之間的關(guān)系,這需要PLM對(duì)實(shí)體間關(guān)系有較好的理解。

b) 實(shí)體類(lèi)別區(qū)分,模型需要區(qū)分文本中的實(shí)體的具體類(lèi)別,這需要PLM對(duì)實(shí)體本身有較好的理解。

c) 問(wèn)題回答,作者測(cè)試了兩種常見(jiàn)的問(wèn)題回答任務(wù):多選問(wèn)答(multi-choice QA)和抽取式問(wèn)答(extractive QA)。這需要PLM對(duì)實(shí)體和實(shí)體間關(guān)系有較好的理解。

七、分析

a) 消融分析(ablation study)。作者對(duì)ERICA框架中的所有組成成分進(jìn)行了細(xì)致的分析,并證明了這些組成成分對(duì)于模型整體效果的提升是缺一不可的。

b) 可視化分析。作者對(duì)經(jīng)過(guò)ERICA訓(xùn)練前后的PLM對(duì)實(shí)體和實(shí)體間關(guān)系的表示進(jìn)行了可視化,結(jié)果如下圖所示。通過(guò)ERICA的對(duì)比學(xué)習(xí)訓(xùn)練,PLM對(duì)于同類(lèi)別的實(shí)體/實(shí)體關(guān)系的表示有明顯的聚類(lèi)現(xiàn)象,這充分驗(yàn)證了ERICA能夠顯著增強(qiáng)PLM對(duì)實(shí)體和實(shí)體間關(guān)系的理解。

c) 此外,作者分析了遠(yuǎn)程監(jiān)督關(guān)系的多樣性/預(yù)訓(xùn)練文檔數(shù)量對(duì)于模型效果的提升。實(shí)驗(yàn)結(jié)果發(fā)現(xiàn),更加多樣的遠(yuǎn)程監(jiān)督關(guān)系與更大的預(yù)訓(xùn)練數(shù)據(jù)集對(duì)于性能的提升有積極的作用。

d) 除了使用均勻池化的方式來(lái)獲得實(shí)體/關(guān)系表示,作者也嘗試使用entity marker的表示方法來(lái)測(cè)試模型的性能。實(shí)驗(yàn)結(jié)果證明,ERICA對(duì)各種實(shí)體/關(guān)系表示方法均適用,進(jìn)一步驗(yàn)證了該架構(gòu)的通用性。

八、總結(jié)

在本文中,作者提出了ERICA框架,通過(guò)對(duì)比學(xué)習(xí)幫助PLM提高實(shí)體和實(shí)體間關(guān)系的理解。作者在多個(gè)自然語(yǔ)言理解任務(wù)上驗(yàn)證了該框架的有效性,包括關(guān)系提取、實(shí)體類(lèi)別區(qū)分和問(wèn)題問(wèn)答。實(shí)驗(yàn)結(jié)果表明ERICA顯著優(yōu)于所有基線模型,尤其是在低資源的設(shè)定下,這意味著 ERICA 可以更好地幫助 PLM捕獲文本中的相關(guān)事實(shí)并綜合有關(guān)實(shí)體及其關(guān)系的信息。

責(zé)任編輯:lq6

-

PLM

+關(guān)注

關(guān)注

2文章

136瀏覽量

21332 -

實(shí)體

+關(guān)注

關(guān)注

0文章

8瀏覽量

7360

原文標(biāo)題:ERICA: 提升預(yù)訓(xùn)練語(yǔ)言模型實(shí)體與關(guān)系理解的統(tǒng)一框架

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

如何在MQTT中發(fā)布和訂閱實(shí)體

藍(lán)牙技術(shù)聯(lián)盟正式成立中國(guó)實(shí)體,擴(kuò)展全球市場(chǎng)布局

鯤云科技入選工信部2024年實(shí)體經(jīng)濟(jì)和數(shù)字經(jīng)濟(jì)深度融合典型案例

探秘定制鋰電池實(shí)體店:開(kāi)啟專(zhuān)屬電力新體驗(yàn)

研發(fā)數(shù)據(jù)管理:從前PLM時(shí)代的Excel到PLM3.0、PLM 4.0

半導(dǎo)體企業(yè)回應(yīng)美國(guó)出口管制 多家A股公司談實(shí)體清單影響

如何使用ar增強(qiáng)現(xiàn)實(shí)體驗(yàn)

南方智能推出三維地理實(shí)體生產(chǎn)軟件

PLM系統(tǒng) PLM軟件 PLM項(xiàng)目管理系統(tǒng)軟件 PLM產(chǎn)品生命周期管理系統(tǒng)哪個(gè)好?

傳音控股入選2023新型實(shí)體企業(yè)TOP100

立訊精密上榜《2023新型實(shí)體企業(yè)TOP100》

一站式解決企業(yè)難題:彩虹PLM系統(tǒng)引領(lǐng)企業(yè)管理革新

信號(hào)的時(shí)域波形和頻譜間的關(guān)系是什么

如何學(xué)習(xí)智能家居?8:Text文本實(shí)體使用方法

智能家居之旅(9):HomeAssistant 的開(kāi)關(guān)實(shí)體具象化

怎樣去增強(qiáng)PLM對(duì)于實(shí)體和實(shí)體間關(guān)系的理解?

怎樣去增強(qiáng)PLM對(duì)于實(shí)體和實(shí)體間關(guān)系的理解?

評(píng)論