EpsAvlc:

這個事情的回答需要基于你的動機。

如果你想改進已有的算法以獲得在數(shù)據(jù)集上的視覺里程計定位精度上的提升,那么我的判斷是比較難。

如果你是在實際場景中發(fā)現(xiàn)已有的框架(例如ORB-SLAM)的定位精度不能達到論文中,或者你預想的精度,那么這個事情是可以根據(jù)實際場景討論的。

排名6, 11, 12, 14, 15的方案是基于視覺的,或者至少融合了視覺。其漂移誤差大都低于1%。這是什么概念?我本科時參加的機器人競賽里,經(jīng)過仔細標定的輪式里程計,精度也不過1%。當然,視覺里程計的最終漂移誤差一般都是回環(huán)后再算的,直接使用的話根據(jù)前端的調(diào)教程度,大概可以看做1%左右。不過無論怎樣,對于增量式的定位方案,1%的誤差應該都可以算是差強人意了。想要再有提升還是挺困難的,要么就加入許多Trick(過擬合數(shù)據(jù)集),但是感覺意義不大。

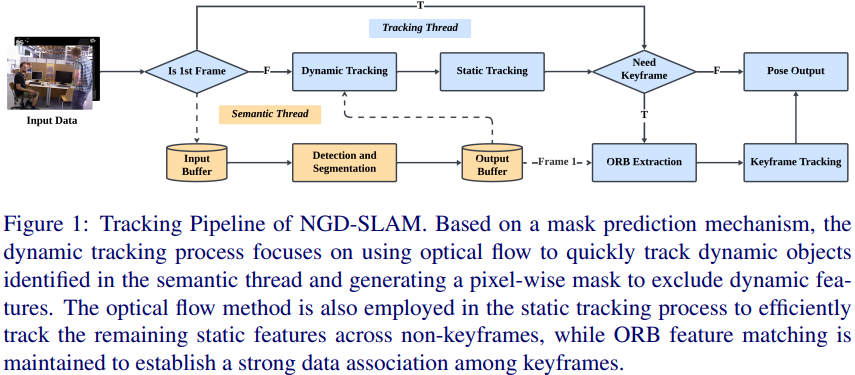

如果是在一些復雜場景下需要提升定位精度,那么還是有許多事情可以做的。像之前答主提到的,用語義分割,將動態(tài)物體上的特征點濾去,以提升BA精度。我認為有一些場景,是目前已有的框架力所不能逮的:

1.Long-term場景。如何保證夏天建的室外地圖,在冬天也能用?這涉及到季節(jié)不變的路標的設計與提取。語義分割天然就有l(wèi)ong-term特性,將語義分割考慮進去是一個較好的方法。

2.高度動態(tài)的場景。比如走在去菜市場的路上,來往人群很多。人是可以精確定位的,但是SLAM可能就要抓瞎了。

3.紋理缺失的場景。這算是室內(nèi)SLAM時經(jīng)常需要面對的事情了。

這三個問題,其實都有許多工作已經(jīng)在做了。谷歌學術(shù)上搜索相關(guān)關(guān)鍵字就有。

就像綜述《Past, Present, and Future of SimultaneousLocalization And Mapping: Towards theRobust-Perception Age》標題所述,目前魯棒才是SLAM的關(guān)鍵命題。發(fā)布于 06-27

鄭純?nèi)唬?/p>

可以做一些深度學習輔助提取路標的工作,比如:如果已經(jīng)知道圖像中某個物體屬于一個既定的類別,然后再提角點,就會比針對全圖提角點魯棒性高很多。

劉宴誠:

具體細節(jié)太多了,ORBSLAM2這個框架基本上所有的代碼都在圍繞如何提高特征點的質(zhì)量。其實想想特征點法提高定位精度無非就是如何保證特征點匹配的準確以及特征點選取的準確,可問題就出在無法保證百分百絕對精確,所以通過很多騷操作把這個事情做到極致,就可以提高定位精度了。

編輯:jq

-

SLAM

+關(guān)注

關(guān)注

24文章

440瀏覽量

32484 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25428 -

深度學習

+關(guān)注

關(guān)注

73文章

5560瀏覽量

122765

原文標題:視覺SLAM怎么去提高定位精度?

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

一種適用于動態(tài)環(huán)境的實時RGB-D SLAM系統(tǒng)

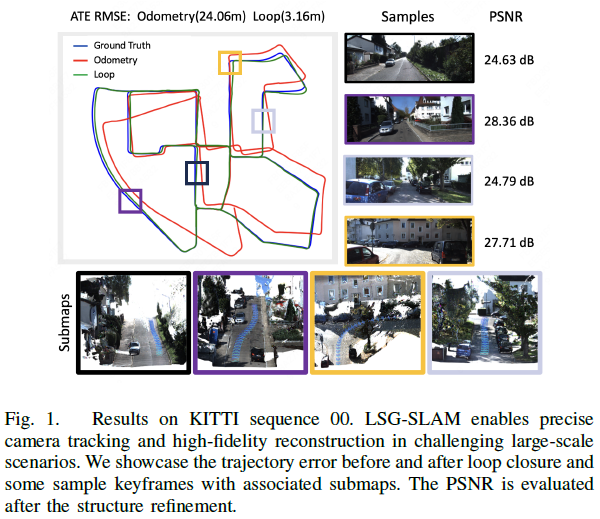

三維高斯?jié)姙R大規(guī)模視覺SLAM系統(tǒng)解析

【「# ROS 2智能機器人開發(fā)實踐」閱讀體驗】視覺實現(xiàn)的基礎算法的應用

【「# ROS 2智能機器人開發(fā)實踐」閱讀體驗】+ROS2應用案例

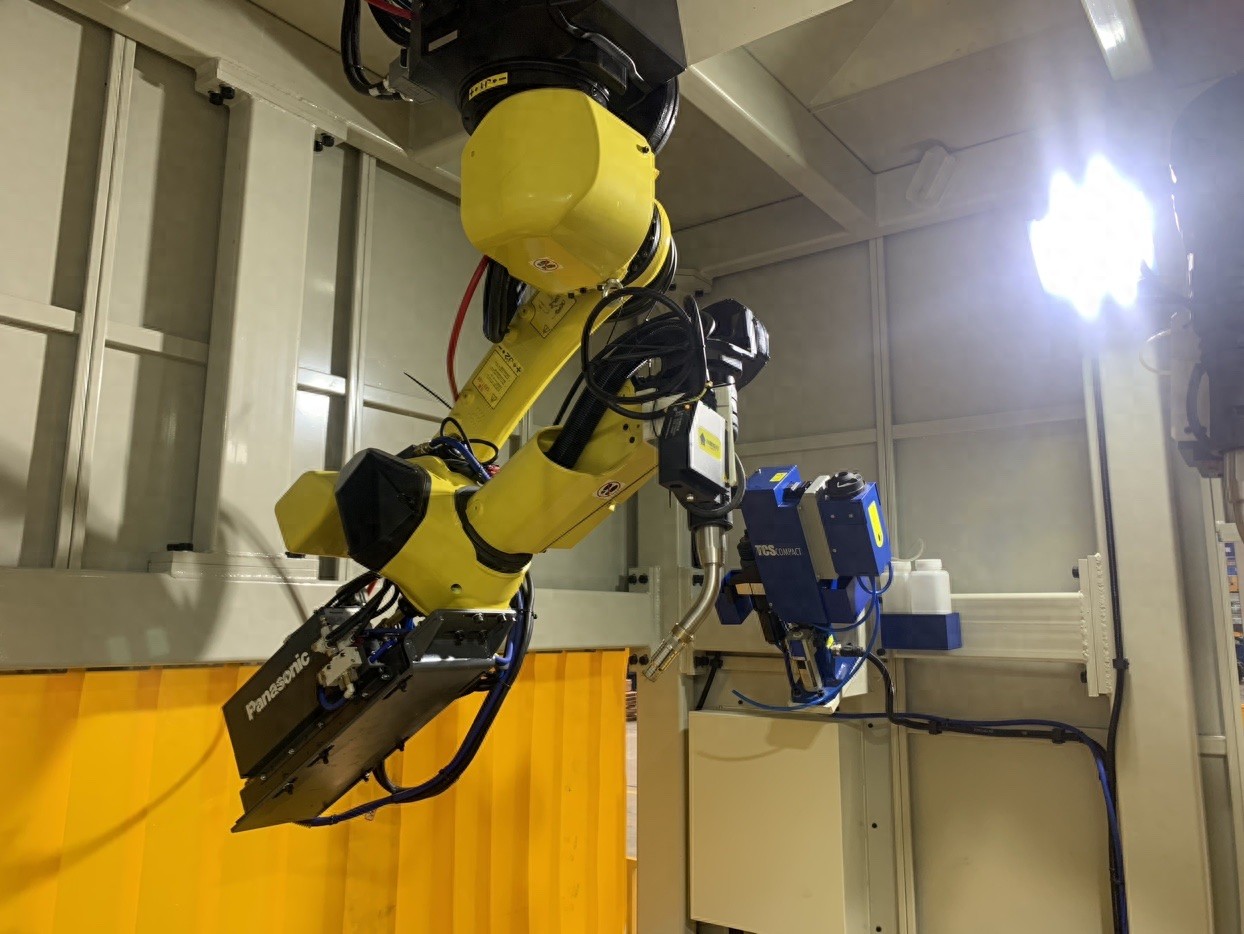

精準對接:焊接機器人視覺定位系統(tǒng)如何革新制造工藝

視覺定位在焊接機器人中的作用

如何提高數(shù)控機床精度

利用VLM和MLLMs實現(xiàn)SLAM語義增強

最新圖優(yōu)化框架,全面提升SLAM定位精度

MG-SLAM:融合結(jié)構(gòu)化線特征優(yōu)化高斯SLAM算法

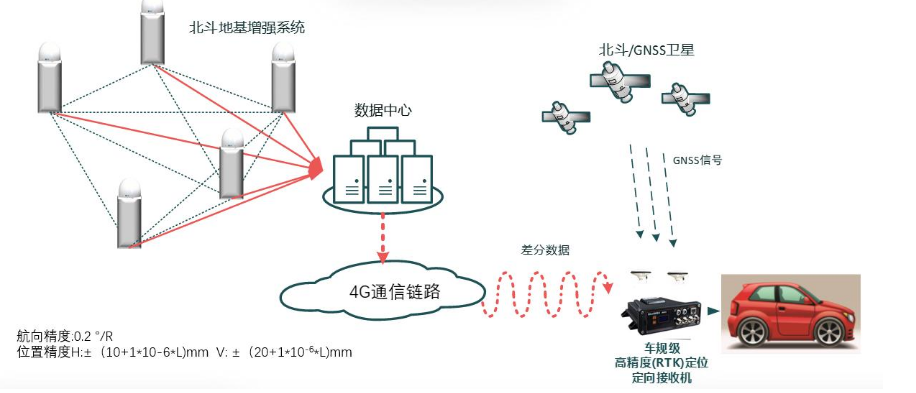

物聯(lián)網(wǎng)系統(tǒng)中高精度RTK定位方案的實現(xiàn)_高精度定位模塊

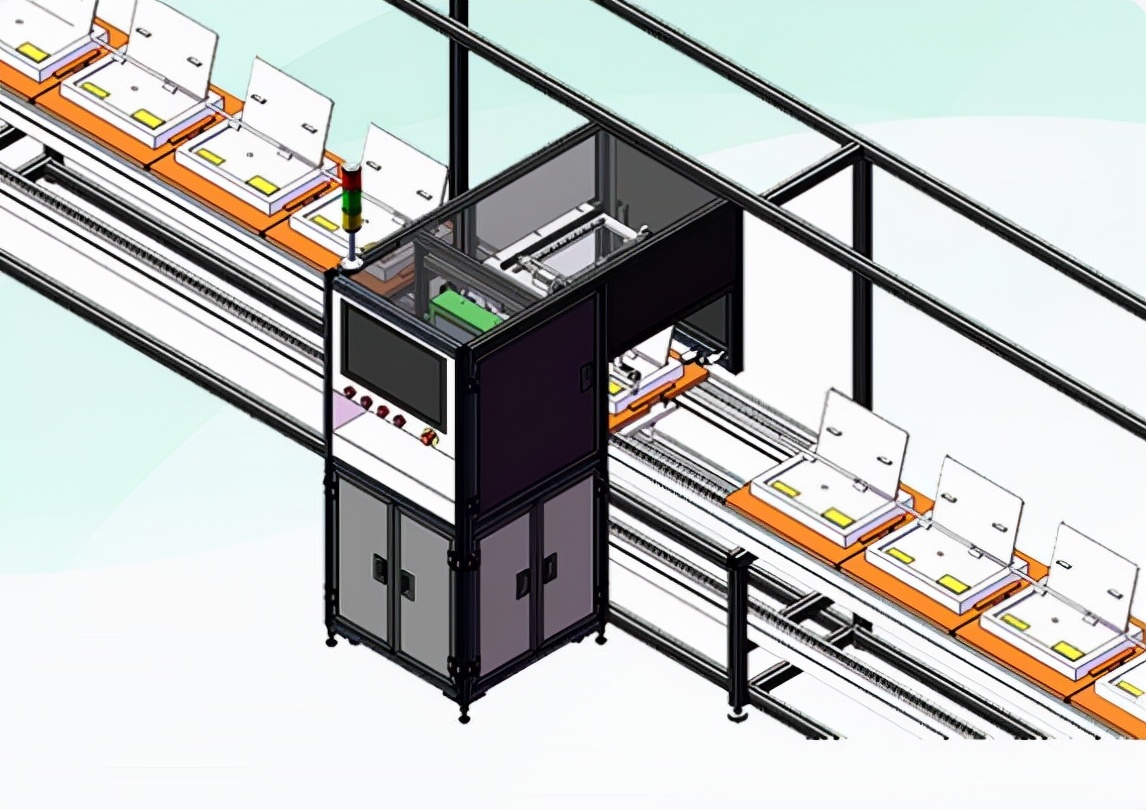

視覺檢測精度能達到 0.01 嗎

教你們視覺SLAM如何去提高定位精度

教你們視覺SLAM如何去提高定位精度

評論