人工智能的快速發展正在推高數據集的規模,以及網絡的規模和復雜性。支持人工智能的應用程序,如電子商務產品推薦、基于語音的助手和呼叫中心自動化,需要數十到數百個經過培訓的人工智能模型。推理服務幫助基礎設施管理人員部署、管理和擴展這些模型,并在生產中保證實時服務質量( QoS )。此外,基礎架構經理希望提供和管理用于部署這些 AI 模型的正確計算基礎架構,最大限度地利用計算資源,靈活地放大或縮小規模,以優化部署的運營成本。將人工智能投入生產既是一項推理服務,也是一項基礎設施管理挑戰。

NVIDIA 與谷歌云合作,將 CPU 和 GPU 通用推理服務平臺 NVIDIA Triton Inference Server的功能與谷歌 Kubernetes 引擎( GKE )相結合,使企業更容易將人工智能投入生產。NVIDIA Triton Inference Server 是一個托管環境,用于在安全的谷歌基礎設施中部署、擴展和管理容器化人工智能應用程序。

使用 NVIDIA Triton 推理服務器在谷歌云上的 CPU 和 GPU 上提供推理服務

在企業應用程序中操作 AI 模型帶來了許多挑戰——為在多個框架中培訓的模型提供服務,處理不同類型的推理查詢類型,并構建一個能夠跨 CPU 和 GPU 等多個部署平臺進行優化的服務解決方案。

Triton 推理服務器通過提供一個單一的標準化推理平臺來解決這些挑戰,該平臺可以從任何基于 TensorFlow 、TensorRT、 PyTorch 、 ONNX 運行時、 OpenVINO 或自定義 C ++/ Python 框架的本地存儲或谷歌云的托管存儲在任何基于 GPU 或 CPU 的基礎設施上部署經過培訓的 AI 模型。

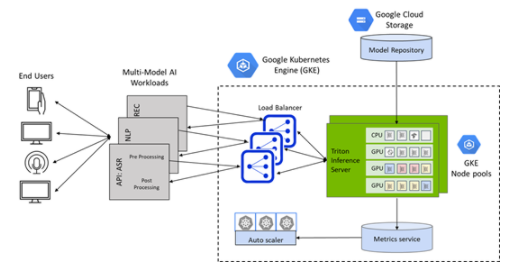

圖 1 Triton 部署在 Google Kubernetes 引擎( GKE )上的推理服務器

在 GKE 集群上一鍵部署 NVIDIA Triton 推理服務器

Google Kubernetes Engine ( GKE )上的 Triton 為部署在 CPU 和 GPU 上的 AI 模型提供了通用推理服務平臺,并結合了 Kubernetes 群集管理、負載平衡和基于需求的自動縮放計算的方便性。

使用谷歌市場上新的一鍵式 Triton GKE 推理服務器應用程序,可以將 Triton 無縫部署為 Google Kubernetes Engine ( GKE )管理的集群上的容器化微服務。

GKE 的 Triton 推理服務器應用程序是一個 helm chart 部署程序,可自動安裝和配置 Triton ,以便在具有 NVIDIA GPU 節點池的 GKE 集群上使用,包括 NVIDIA A100 Tensor Core GPU s 和 NVIDIA T4 Tensor Core GPU s ,并利用谷歌云上的 Istio 進行流量進入和負載平衡。它還包括一個水平 pod autoscaler ( HPA ),它依賴堆棧驅動程序自定義度量適配器來監控 GPU 占空比,并根據推理查詢和 SLA 要求自動縮放 GKE 集群中的 GPU 節點。

關于作者

Uttara Kumar 是 NVIDIA 的高級產品營銷經理,專注于 GPU - 云計算中的人工智能加速應用。她非常關心讓每個人都能獲得技術的民主化,讓開發者能夠利用 NVIDIA 數據中心平臺的力量來加快創新步伐。在 NVIDIA 之前,她領導半導體和科學計算軟件公司的軟件產品營銷。她擁有安娜堡密歇根大學的 Eel CTR 工程碩士學位。

審核編輯:郭婷

-

cpu

+關注

關注

68文章

11054瀏覽量

216268 -

服務器

+關注

關注

13文章

9730瀏覽量

87449 -

人工智能

+關注

關注

1805文章

48843瀏覽量

247404

發布評論請先 登錄

AI 推理服務器都有什么?2025年服務器品牌排行TOP10與選購技巧

推理服務器的7大可靠性指標,寬溫/抗震/EMC防護實測數據分享

國產推理服務器如何選擇?深度解析選型指南與華頡科技實戰案例

英偉達GTC25亮點:NVIDIA Dynamo開源庫加速并擴展AI推理模型

浪潮信息發布元腦R1推理服務器

摩爾線程宣布成功部署DeepSeek蒸餾模型推理服務

嵌入式和人工智能究竟是什么關系?

什么是AI服務器?AI服務器的優勢是什么?

AMD助力HyperAccel開發全新AI推理服務器

NVIDIA Triton推理服務器簡化人工智能推理

NVIDIA Triton推理服務器簡化人工智能推理

評論