HyperAccel 是一家成立于 2023 年 1 月的韓國(guó)初創(chuàng)企業(yè),致力于開(kāi)發(fā) AI 推理專(zhuān)用型半導(dǎo)體器件和硬件,最大限度提升推理工作負(fù)載的存儲(chǔ)器帶寬使用,并通過(guò)將此解決方案應(yīng)用于大型語(yǔ)言模型來(lái)提高成本效率。HyperAccel 針對(duì)新興的生成式 AI 應(yīng)用提供超級(jí)加速的芯片 IP/解決方案。HyperAccel 已經(jīng)打造出一個(gè)快速、高效且低成本的推理系統(tǒng),加速了基于轉(zhuǎn)換器的大型語(yǔ)言模型( LLM )的推理,此類(lèi)模型通常具有數(shù)十億個(gè)參數(shù),例如 OpenAI 的 ChatGPT 和 Meta 的 Llama 3 等 Llama LLM。其 AI 芯片名為時(shí)延處理單元( LPU ),是專(zhuān)門(mén)用于 LLM 端到端推理的硬件加速器。

項(xiàng)目挑戰(zhàn)

隨著 LLM 應(yīng)用的擴(kuò)展,對(duì)高效、快速和具成本效益的推理解決方案的需求不斷上升。對(duì)于云服務(wù)提供商而言,快速且成本效益高的推理硬件對(duì)于托管高性能的生成式 AI 應(yīng)用并降低總擁有成本( TCO )至關(guān)重要。對(duì)于 AI 企業(yè)來(lái)說(shuō),一個(gè)直觀的軟件堆棧平臺(tái)是實(shí)現(xiàn)其應(yīng)用或模型無(wú)縫部署的必備條件。對(duì)于服務(wù)業(yè)務(wù),提供全面的端到端解決方案也是必要的,有利于將最先進(jìn)的 AI 技術(shù)集成到更有效和先進(jìn)的服務(wù)中。

解決方案

HyperAccel 提出通過(guò)開(kāi)發(fā)名為“Orion”的服務(wù)器來(lái)解決成本和性能問(wèn)題,該服務(wù)器搭載了一個(gè)為 LLM 推理量身定制的專(zhuān)用處理器,基于多個(gè)高性能 AMD FPGA部署。Orion 充分利用每個(gè) FPGA 的存儲(chǔ)器帶寬和硬件資源以獲得最高水平的性能。這種可擴(kuò)展的架構(gòu)支持最新的 LLM,此類(lèi)模型通常包含數(shù)十億個(gè)參數(shù)。

Orion 擁有 16 個(gè)時(shí)延處理單元( LPU ),它們分布在兩個(gè) 2U 機(jī)架中,提供總共 7.36TB/s 的 HBM 帶寬和 14.4 萬(wàn)個(gè) DSP。LPU 能加速內(nèi)存和計(jì)算都非常密集的超大規(guī)模生成式 AI 工作負(fù)載。Orion 及其 256GB 的 HBM 容量支持多達(dá)千億參數(shù)的最先進(jìn) LLM。上圖展示了兩個(gè) 2U 機(jī)箱之一,配有 8 個(gè) LPU。

下圖顯示了 LPU 架構(gòu),其中矢量執(zhí)行引擎由 AMD Alveo U55C 高性能計(jì)算卡支持。Alveo U55C 卡具有高帶寬存儲(chǔ)器( HBM2 ),解決了提供低時(shí)延AI 的最關(guān)鍵性能瓶頸——存儲(chǔ)器帶寬。此外,它們能夠?qū)?200 Gbps的高速網(wǎng)絡(luò)集成到單個(gè)小型板卡中,并且經(jīng)過(guò)精心設(shè)計(jì)可在任何服務(wù)器中部署。

反過(guò)來(lái),每個(gè) Alveo 加速卡都由 FPGA 架構(gòu)驅(qū)動(dòng)。鑒于 FPGA 的大規(guī)模硬件并行性和靈活應(yīng)變的存儲(chǔ)器層次結(jié)構(gòu),F(xiàn)PGA 固有的低時(shí)延特性非常適合 LLM 所需的實(shí)時(shí) AI 服務(wù)。Alveo 卡采用了強(qiáng)大的 Virtex XCU55P UltraScale+ FPGA,可提供高達(dá) 38 TOPS 的 DSP 計(jì)算性能,有助于 AI 推理優(yōu)化,包括用于定點(diǎn)與浮點(diǎn)計(jì)算的 INT8。這款 FPGA 能夠根據(jù)客戶(hù)反饋調(diào)整其處理器( LPU )的架構(gòu),例如,根據(jù)要求在Llama模型中實(shí)現(xiàn)一些非標(biāo)準(zhǔn)的處理,進(jìn)而提供靈活的解決方案,能夠適應(yīng)不斷變化的市場(chǎng)和 LLM 參數(shù)條件。

設(shè)計(jì)成效

Orion 的高性能和可擴(kuò)展性是通過(guò) LPU 實(shí)現(xiàn)的,由 AMD Alveo 加速卡和相關(guān)的 FPGA 以及HyperAccel 的可擴(kuò)展同步鏈路( ESL )技術(shù)提供支持。這些技術(shù)最大限度提升了 P2P 傳輸中的存儲(chǔ)器帶寬使用,有利于靈活處理,同時(shí)消除了 P2P 計(jì)算的同步開(kāi)銷(xiāo) ESL 屬于為 LLM 推理中的數(shù)據(jù)傳輸優(yōu)化的通信鏈路。值得注意的是,Orion 在支持標(biāo)準(zhǔn) FP16 數(shù)據(jù)精度的硬件上保持了卓越的準(zhǔn)確性。

HyperAccel Orion

的性能

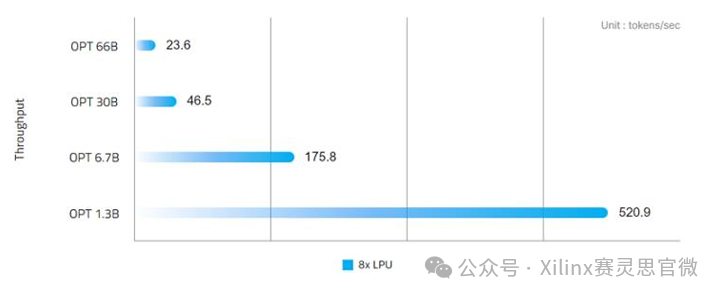

針對(duì)時(shí)延進(jìn)行優(yōu)化的 HyperAccel Orion 與基于轉(zhuǎn)換器的 LLM(如 GPT、Llama 和 OPT)無(wú)縫集成,能夠在 1.3B 模型上每秒生成超過(guò) 520 個(gè)令牌,在 7B 模型上每秒生成 175 個(gè)令牌。除了卓越的性能外,Orion 還展示了出色的能源效率,在 66B 模型上生成單個(gè)令牌只需 24 毫秒,而功耗僅為 600W。

HyperAccel LPU 的性能(來(lái)源:https://www.hyperaccel.ai)

HyperAccel Orion

—— 工作負(fù)載多樣性

Orion 提供端到端的解決方案服務(wù),可作為云端服務(wù)部署。對(duì)于擁有專(zhuān)有 LLM 的AI 企業(yè)或存在內(nèi)部數(shù)據(jù)隱私與安全需求的專(zhuān)業(yè)部門(mén),Orion 也能夠以本地解決方案的形式進(jìn)行安裝。Orion 能夠處理以下工作負(fù)載/應(yīng)用:

客戶(hù)服務(wù):通過(guò)虛擬聊天機(jī)器人和虛擬助手實(shí)時(shí)處理查詢(xún),因此人工客服將有時(shí)間處理更復(fù)雜的問(wèn)題。

人機(jī)界面:在自助服務(wù)終端、機(jī)器人和其它設(shè)備中支持與語(yǔ)言相關(guān)的功能,以增強(qiáng)客戶(hù)互動(dòng)體驗(yàn)。

文本生成:協(xié)助生產(chǎn)、總結(jié)和精煉復(fù)雜的文本內(nèi)容,為用戶(hù)提供便利。

語(yǔ)言翻譯:翻譯客戶(hù)查詢(xún)和回復(fù)信息,打破語(yǔ)言障礙,擴(kuò)大企業(yè)的全球影響力。

問(wèn)答:根據(jù)大量數(shù)據(jù)以及此前的互動(dòng)和偏好記錄,定制針對(duì)個(gè)別客戶(hù)的回復(fù),以提高客戶(hù)滿意度。

進(jìn)一步了解AMD Virtex UltraScale+ FPGA和Alveo U55C 加速卡,請(qǐng)?jiān)L問(wèn)產(chǎn)品專(zhuān)區(qū)。

-

FPGA

+關(guān)注

關(guān)注

1644文章

22007瀏覽量

616384 -

amd

+關(guān)注

關(guān)注

25文章

5577瀏覽量

136122 -

服務(wù)器

+關(guān)注

關(guān)注

13文章

9749瀏覽量

87548 -

AI

+關(guān)注

關(guān)注

88文章

34765瀏覽量

276936

原文標(biāo)題:HyperAccel 借助 AMD 加速卡與 FPGA 打造全新 AI 推理服務(wù)器

文章出處:【微信號(hào):賽靈思,微信公眾號(hào):Xilinx賽靈思官微】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

ai服務(wù)器是什么?與普通服務(wù)器有什么區(qū)別

RAKsmart服務(wù)器如何助力企業(yè)破解AI轉(zhuǎn)型的難題

基于RAKsmart云服務(wù)器的AI大模型實(shí)時(shí)推理方案設(shè)計(jì)

RAKsmart服務(wù)器如何賦能AI開(kāi)發(fā)與部署

AI 推理服務(wù)器都有什么?2025年服務(wù)器品牌排行TOP10與選購(gòu)技巧

RAKsmart服務(wù)器如何重塑AI高并發(fā)算力格局

國(guó)產(chǎn)推理服務(wù)器如何選擇?深度解析選型指南與華頡科技實(shí)戰(zhàn)案例

NVIDIA 推出開(kāi)放推理 AI 模型系列,助力開(kāi)發(fā)者和企業(yè)構(gòu)建代理式 AI 平臺(tái)

AMD助力HyperAccel開(kāi)發(fā)全新AI推理服務(wù)器

AMD助力HyperAccel開(kāi)發(fā)全新AI推理服務(wù)器

評(píng)論