YOLOX目標檢測模型

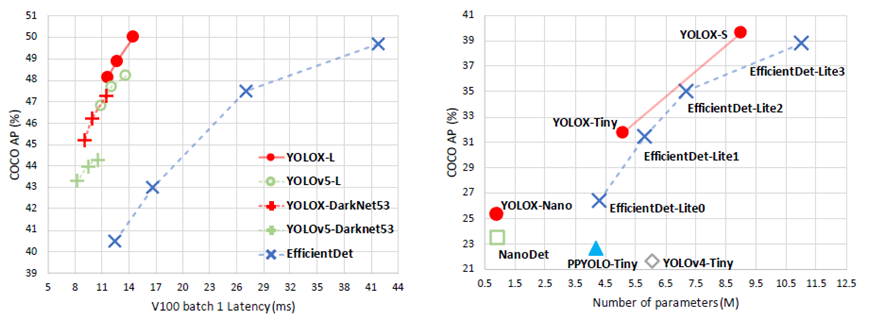

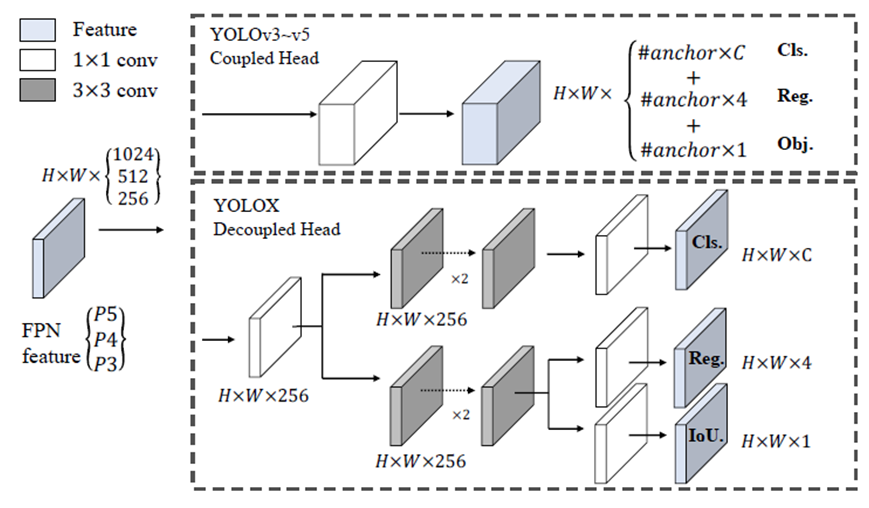

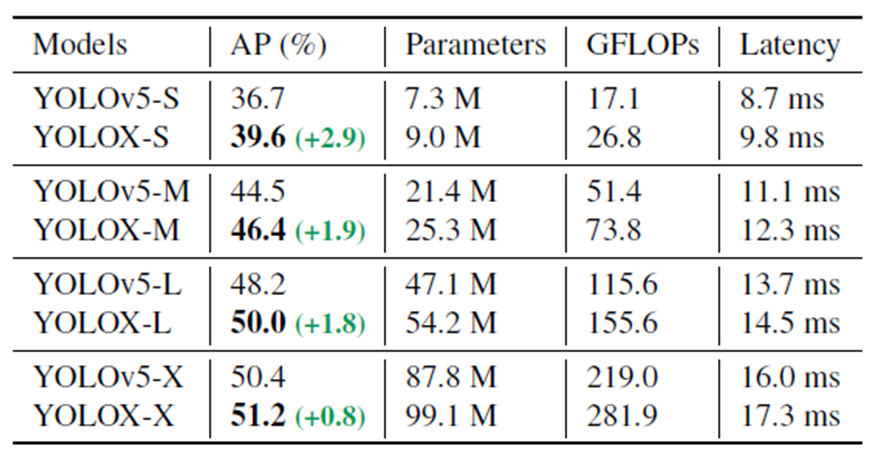

曠視科技開源了內部目標檢測模型-YOLOX,性能與速度全面超越YOLOv5早期版本!

https://arxiv.org/pdf/2107.08430.pdfhttps://github.com/Megvii-BaseDetection/YOLOX

ONNX格式模型轉與部署

下載YOLOX的ONNX格式模型(github上可以下載)https://github.com/Megvii-BaseDetection/YOLOX/tree/main/demo/ONNXRuntimehttps://github.com/Megvii-BaseDetection/YOLOX/releases/download/0.1.1rc0/yolox_s.onnx

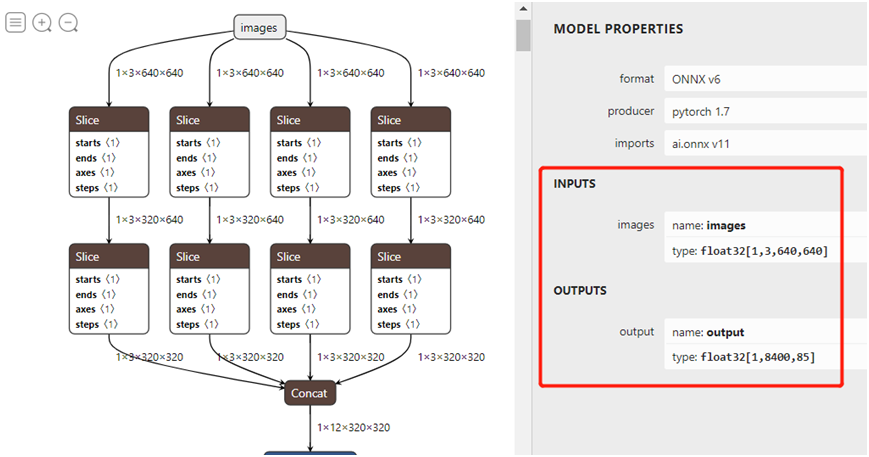

下載ONNX格式模型,打開之后如圖:

官方說明ONNX格式支持OpenVINO、ONNXRUNTIME、TensorRT三種方式,而且都提供源碼,官方提供的源碼參考如下:輸入格式:1x3x640x640,默認BGR,無需歸一化。輸出格式:1x8400x85

https://github.com/Megvii-BaseDetection/YOLOX/tree/main/demo

本人就是參考上述的代碼然后一通猛改,分別封裝成三個類,完成了統一接口,公用了后處理部分的代碼,基于本人筆記本的硬件資源與軟件版本:

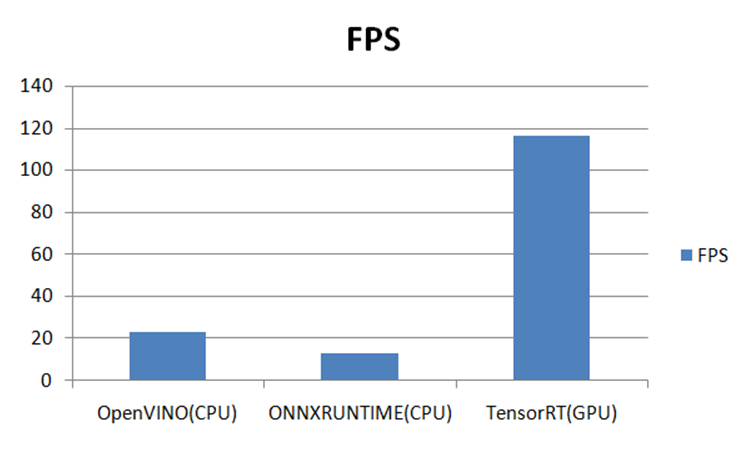

在三個推理平臺上測試結果如下:-GPU 3050Ti-CPU i7 11代-OS:Win10 64位-OpenVINO2021.4-ONNXRUNTIME:1.7-CPU-OpenCV4.5.4-Python3.6.5-YOLOX-TensorRT8.4.x

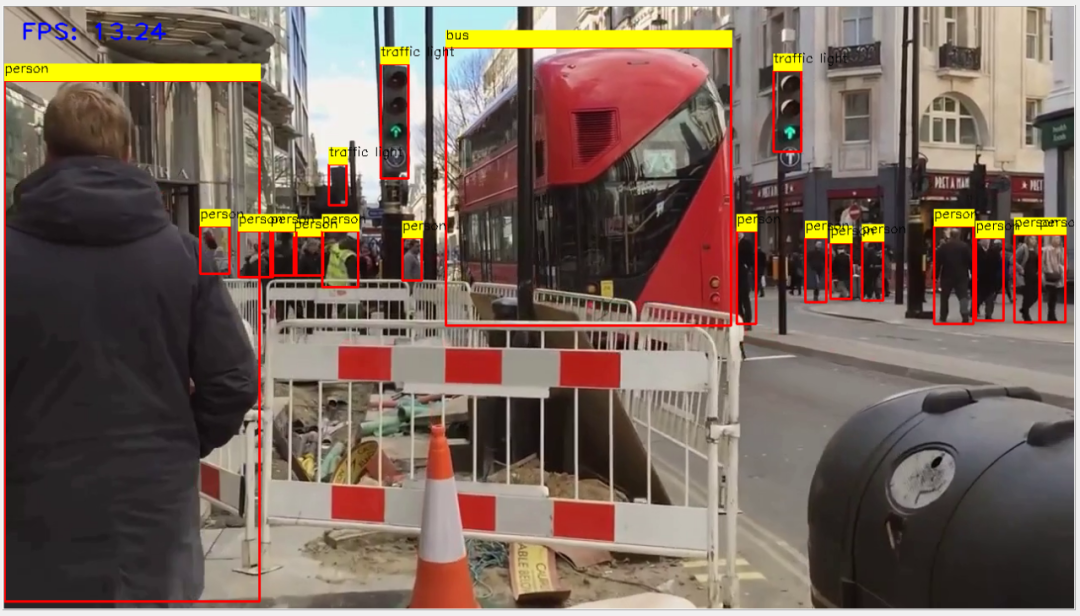

OpenVINO推理

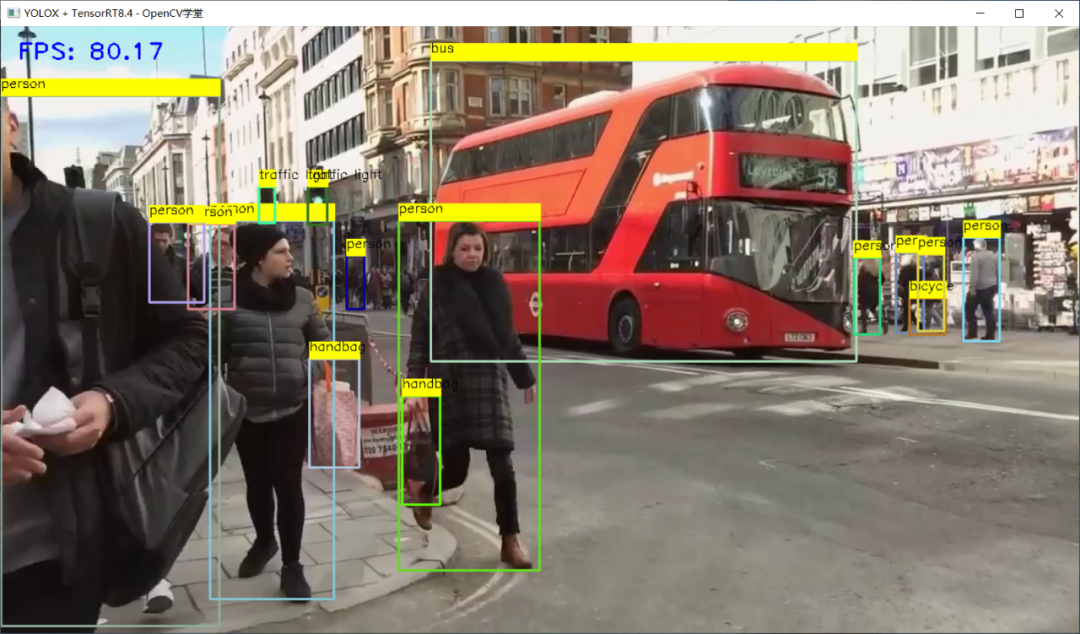

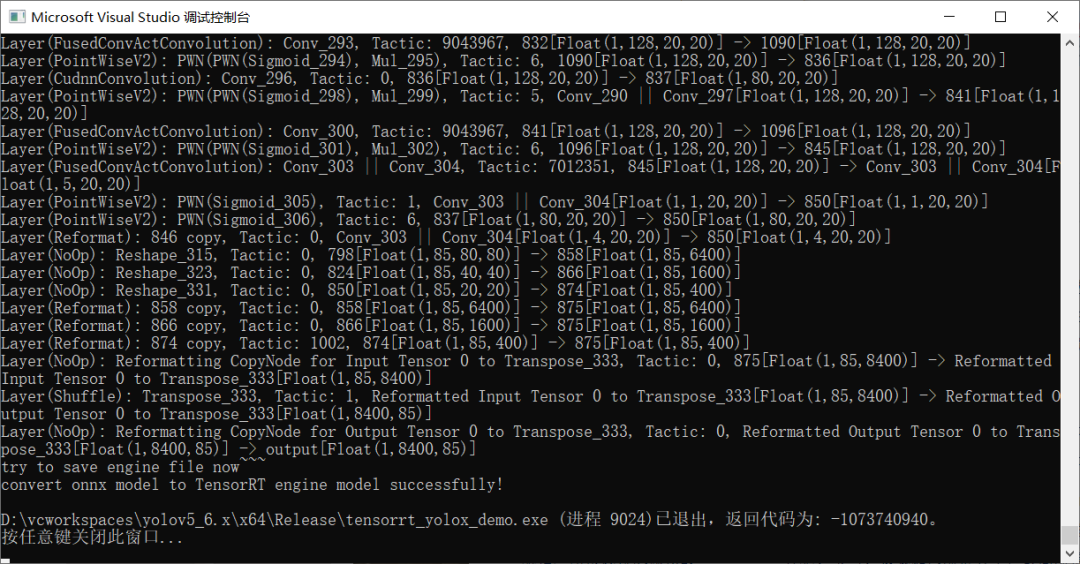

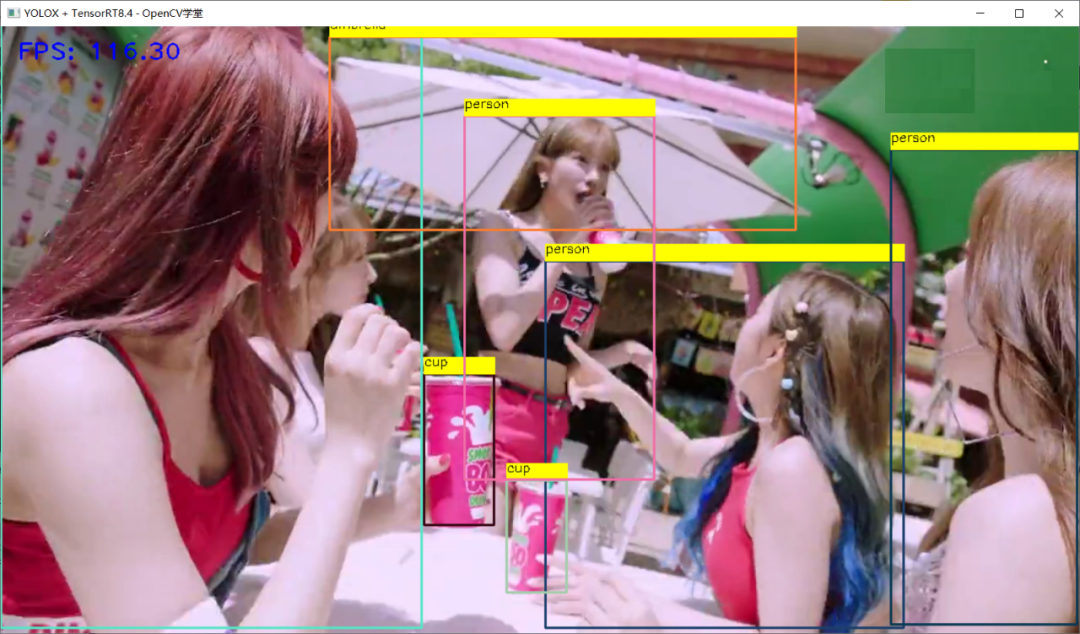

TensorRT推理 - FP32

轉威FP16

TensorRT推理 - FP16

總結

之前我寫過一篇文章比較了YOLOv5最新版本在OpenVINO、ONNXRUNTIME、OpenCV DNN上的速度比較,現在加上本篇比較了YOLOX在TensorRT、OpenVINO、ONNXRUNTIME上推理部署速度比較,得到的結論就是:能不改代碼,同時支持CPU跟GPU推理是ONNXRUNTIMEOpenCV DNN毫無意外的速度最慢(CPU/GPU)CPU上速度最快的是OpenVINOGPU上速度最快的是TensorRT

原文標題:YOLOX在OpenVINO、ONNXRUNTIME、TensorRT上面推理部署與速度比較

文章出處:【微信公眾號:OpenCV學堂】歡迎添加關注!文章轉載請注明出處。

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

模型

+關注

關注

1文章

3521瀏覽量

50427 -

目標檢測

+關注

關注

0文章

225瀏覽量

16019 -

OpenCV

+關注

關注

32文章

642瀏覽量

42900

原文標題:YOLOX在OpenVINO、ONNXRUNTIME、TensorRT上面推理部署與速度比較

文章出處:【微信號:CVSCHOOL,微信公眾號:OpenCV學堂】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

熱點推薦

如何在魔搭社區使用TensorRT-LLM加速優化Qwen3系列模型推理部署

TensorRT-LLM 作為 NVIDIA 專為 LLM 推理部署加速優化的開源庫,可幫助開發者快速利用最新 LLM 完成應用原型驗證與產品部署。

大模型推理顯存和計算量估計方法研究

隨著人工智能技術的飛速發展,深度學習大模型在各個領域得到了廣泛應用。然而,大模型的推理過程對顯存和計算資源的需求較高,給實際應用帶來了挑戰。為了解決這一問題,本文將探討大模型

發表于 07-03 19:43

基于LockAI視覺識別模塊:C++目標檢測

快速部署高性能的目標檢測應用。

特點:

高性能:優化了推理速度,在保持高精度的同時實現了快速響應。

靈活性:支持多種預訓練模型,可以根據具體

發表于 06-06 14:43

labview調用yolo目標檢測、分割、分類、obb

labview調用yolo目標檢測、分割、分類、obb、pose深度學習,支持CPU和GPU推理,32/64位labview均可使用。

(yolov5~yolov12)

發表于 03-31 16:28

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

這也會帶來新問題,隨著模型參數增加,回復速度會明顯下降,實際應用中需根據需求權衡。使用 Ollama 工具部署的推理模型運行時主要依賴 CPU 運算。從運行監測數據能看到,模型回復時

發表于 02-14 17:42

摩爾線程宣布成功部署DeepSeek蒸餾模型推理服務

近日,摩爾線程智能科技(北京)有限責任公司在其官方渠道發布了一則重要消息,宣布公司已經成功實現了對DeepSeek蒸餾模型推理服務的部署。這一技術突破,標志著摩爾線程在人工智能領域邁出了堅實的一步

采用華為云 Flexus 云服務器 X 實例部署 YOLOv3 算法完成目標檢測

一、前言 1.1 開發需求 這篇文章講解:?采用華為云最新推出的 Flexus 云服務器 X 實例部署 YOLOv3 算法,完成圖像分析、目標檢測。 隨著計算機視覺技術的飛速發展,深度學習模型

AI模型部署邊緣設備的奇妙之旅:目標檢測模型

以及邊緣計算能力的增強,越來越多的目標檢測應用開始直接在靠近數據源的邊緣設備上運行。這不僅減少了數據傳輸延遲,保護了用戶隱私,同時也減輕了云端服務器的壓力。然而,在邊緣端部署高效且準確的目標

發表于 12-19 14:33

在樹莓派上部署YOLOv5進行動物目標檢測的完整流程

卓越的性能。本文將詳細介紹如何在性能更強的計算機上訓練YOLOv5模型,并將訓練好的模型部署到樹莓派4B上,通過樹莓派的攝像頭進行實時動物目標檢測

YOLOv6在LabVIEW中的推理部署(含源碼)

YOLOv6 是美團視覺智能部研發的一款目標檢測框架,致力于工業應用。如何使用python進行該模型的部署,官網已經介紹的很清楚了,但是對于如何在LabVIEW中實現該

手冊上新 |迅為RK3568開發板NPU例程測試

yolov5目標檢測

6.13 yolov5-seg語義分割

6.14 yolov6目標檢測

6.15 yolov7目標

發表于 10-23 14:06

手冊上新 |迅為RK3568開發板NPU例程測試

yolov5目標檢測

6.13 yolov5-seg語義分割

6.14 yolov6目標檢測

6.15 yolov7目標

發表于 08-12 11:03

LLM大模型推理加速的關鍵技術

LLM(大型語言模型)大模型推理加速是當前人工智能領域的一個研究熱點,旨在提高模型在處理復雜任務時的效率和響應速度。以下是對LLM大模型

YOLOX目標檢測模型的推理部署

YOLOX目標檢測模型的推理部署

評論