TensorRT-LLM作為 NVIDIA 專為 LLM 推理部署加速優(yōu)化的開(kāi)源庫(kù),可幫助開(kāi)發(fā)者快速利用最新 LLM 完成應(yīng)用原型驗(yàn)證與產(chǎn)品部署。TensorRT-LLM 提供了一個(gè)全面的開(kāi)源 SDK,用于加速和優(yōu)化 LLM 推理,包含了最新極致優(yōu)化的計(jì)算 Kernel、高性能 Attention 實(shí)現(xiàn)、多機(jī)多卡通信分布式支持、豐富的并行和量化策略等,從而在 NVIDIA GPU 上實(shí)現(xiàn)突破性的 LLM 推理性能。此外,TensorRT-LLM 采用了 PyTorch 的全新架構(gòu),提供了直觀簡(jiǎn)潔的模型定義 API,便于定義和構(gòu)建新模型,顯著減少了代碼量,同時(shí)大幅降低了 debugging 難度,進(jìn)一步優(yōu)化了模型部署流程,提升了開(kāi)發(fā)者的使用體驗(yàn)。

本文將介紹如何在魔搭社區(qū)使用 TensorRT-LLM 加速優(yōu)化 Qwen3 系列模型推理部署。

Qwen3 模型

通義千問(wèn) Qwen3 是阿里巴巴開(kāi)發(fā)并開(kāi)源的混合推理大語(yǔ)言模型 (LLM),Qwen3 開(kāi)源模型系列包含兩款混合專家模型 (MoE) 235B-A22B(總參數(shù) 2,350 億,激活參數(shù) 220 億)和 30B-A3B,以及六款稠密 (Dense) 模型 0.6B、1.7B、4B、8B、14B、32B。作為中國(guó)首個(gè)混合推理模型,Qwen3 在 AIME、LiveCodeBench、ArenaHard、BFCL 等權(quán)威評(píng)測(cè)集上均獲得出色的表現(xiàn)(信息來(lái)源于阿里巴巴官方微信公眾號(hào)),在推理、指令遵循、Agent 能力、多語(yǔ)言支持等方面均大幅增強(qiáng),是全球領(lǐng)先的開(kāi)源模型。

Qwen 系列開(kāi)源模型因其突出的模型能力、豐富的模型尺寸和持續(xù)更新的生態(tài),在開(kāi)源社區(qū)直接使用、二次開(kāi)發(fā)和落地應(yīng)用上都有著極其深刻的影響力。

近期 Qwen3 還進(jìn)一步補(bǔ)齊了開(kāi)源序列中的 Embedding 和 Rerank 模型,強(qiáng)大的模型矩陣全面覆蓋從復(fù)雜推理、Agent 任務(wù)到輕量級(jí)部署的需求,進(jìn)一步鞏固和加強(qiáng)了整個(gè) Qwen 開(kāi)源生態(tài)。

ModelScope 魔搭社區(qū)

ModelScope 魔搭作為中國(guó)最大最活躍的開(kāi)源模型社區(qū),旨在打造下一代開(kāi)源的模型即服務(wù)共享平臺(tái),為泛 AI 開(kāi)發(fā)者提供靈活、易用、低成本的一站式模型服務(wù)產(chǎn)品,讓模型應(yīng)用更簡(jiǎn)單。

超過(guò) 1,600 萬(wàn)開(kāi)發(fā)者可以在 ModelScope 輕松下載和部署模型,快速體驗(yàn)?zāi)P托Ч⑼ㄟ^(guò)云端 AI 環(huán)境實(shí)現(xiàn)在線推理與訓(xùn)練,無(wú)需復(fù)雜的本地配置。同時(shí),ModelScope 支持多種靈活的部署方式,包括云端、本地及設(shè)備端部署,助力開(kāi)發(fā)者以更低的成本和更高的效率推動(dòng) AI 技術(shù)的應(yīng)用落地。

除了模型和數(shù)據(jù)集的托管和靈活調(diào)用部署,ModelScope 還提供特色功能社區(qū)。比如在ModelScope MCP 廣場(chǎng)中上線將近 4,000 多個(gè) MCP server,能夠幫助廣大開(kāi)發(fā)者更好的通過(guò)標(biāo)準(zhǔn)化工具接口,實(shí)現(xiàn)模型智能邊界的外拓,讓魔搭的開(kāi)源模型生態(tài)能更好的與 MCP 生態(tài)產(chǎn)生更多的碰撞與化學(xué)效應(yīng)(介紹來(lái)源于魔搭社區(qū))。

利用 TensorRT-LLM 加速優(yōu)化Qwen3 模型推理部署

在 Qwen3 開(kāi)源發(fā)布的同時(shí),TensorRT-LLM 便已實(shí)現(xiàn)支持相關(guān)系列模型的推理加速優(yōu)化部署。針對(duì) Qwen3 推理加速優(yōu)化,TensorRT-LLM 支持的重要特性包括:

模型并行:支持 TP (Tensor Parallelism),EP (Expert Parallelism) 和 Attention DP (Data Parallelism) 等多機(jī)多卡并行方式,滿足大尺寸模型的并行切分以及高服務(wù)級(jí)別目標(biāo)的需求。

量化:除了原生 BF16 數(shù)據(jù)類型之外,現(xiàn)已支持 per-tensor FP8 量化與 blockwise FP8 量化的支持。通過(guò)低精度量化顯著降低顯存和算力需求,在保證模型整體精度的同時(shí)進(jìn)一步提升推理部署的延遲和整體吞吐。其中,BF16 模型和 FP8 blockwise 量化模型的 checkpoint 可直接通過(guò) ModelScope 相關(guān)頁(yè)面進(jìn)行訪問(wèn)和下載(例如:Qwen3-235B-A22B-FP8),F(xiàn)P8 per-tensor 量化模型 checkpoint 可通過(guò)NVIDIA TensorRT-Model-Optimizer工具進(jìn)行量化處理得到。

Prefill-Decode 分離式部署:通過(guò)將 LLM 的 prefill 和 decode 階段解耦在不同的 executors 執(zhí)行,可以自由調(diào)整 PD 比例、并行方式乃至異構(gòu) GPU 型號(hào),以進(jìn)一步提升推理系統(tǒng)整體的靈活性和性價(jià)比,并綜合調(diào)整 TTFT 及 TPOT 等 SLO 級(jí)別。

下面將快速介紹如何通過(guò) TensorRT-LLM 快速部署并拉起由 ModelScope 托管的 Qwen3 模型推理服務(wù)(以 Qwen3-235B-A22B 在單機(jī) 8 卡 GPU 上推理為例)。

1. 安裝 TensorRT-LLM

當(dāng)前可通過(guò)多種方式來(lái)進(jìn)行 TensorRT-LLM 的安裝。

pip 安裝

(Optional) pip3 install torch==2.7.0torchvision torchaudio--index-url https://download.pytorch.org/whl/cu128 sudo apt-get-y install libopenmpi-dev&&pip3 install--upgrade pip setuptools && pip3 install tensorrt_llm

使用預(yù)編譯好的 NGC 容器鏡像

源碼編譯容器鏡像:下載 TensorRT-LLM github 源代碼后,在代碼主目錄運(yùn)行編譯命令

make-C docker release_build

2. 從 ModelScope 下載模型 checkpoint

# Using modelscope cmd tool to download pipinstall modelscope modelscopedownload --model Qwen/Qwen3-235B-A22B # or using git clone gitlfs install gitclone https://www.modelscope.cn/Qwen/Qwen3-235B-A22B.git

3. 使用 trtllm-serve 命令進(jìn)行推理服務(wù)部署

# Setup LLM API configuration file cat>./extra-llm-api-config.yml<

4. 請(qǐng)求服務(wù)測(cè)試:部署完成后便可通過(guò)標(biāo)準(zhǔn) OpenAI API 進(jìn)行推理服務(wù)請(qǐng)求發(fā)送,例如如下 curl 命令

curl http://localhost:8000/v1/completions -H "Content-Type: application/json" -d '{ "model":"Qwen3-235B-A22B/", "prompt":"Please describe what is Qwen.", "max_tokens":128, "temperature":0 }'

在上述已實(shí)現(xiàn)的各項(xiàng)優(yōu)化特性之外,針對(duì) Qwen3 系列模型,TensorRT-LLM 還在不斷研發(fā)和探索新的優(yōu)化方法,包括 kernel 層面的持續(xù)優(yōu)化、算子融合、基于 sparse attention 的超長(zhǎng)文本支持、基于 Eagle-3 的投機(jī)性采樣、MoE 模型的 expert 負(fù)載均衡、新的量化精度 (W4AFP8 / NVFP4) 等等,期待您緊密關(guān)注 TensorRT-LLM 最新進(jìn)展。

總結(jié)

除了 Qwen3 系列模型,TensorRT-LLM 現(xiàn)已支持 ModelScope 社區(qū)主流的生成式 AI 大模型,模型列表請(qǐng)參考 TensorRT-LLM Support Matrix 和 ModelScope 社區(qū) TensorRT-LLM 專題頁(yè)。

通過(guò)雙方在生成式 AI 模型軟件加速庫(kù)層面的技術(shù)合作,使用性能強(qiáng)大、敏捷靈活的軟件棧,能夠大大簡(jiǎn)化開(kāi)發(fā)者快速進(jìn)行大模型的原型驗(yàn)證與產(chǎn)品研發(fā)部署的工作流,并獲得極致推理部署性能,進(jìn)一步加快大模型的廣泛落地和應(yīng)用生態(tài)。

作者

金國(guó)強(qiáng)

NVIDIA 資深解決方案架構(gòu)師,主要負(fù)責(zé)深度學(xué)習(xí)生成式 AI 領(lǐng)域模型訓(xùn)練、推理優(yōu)化以及大模型開(kāi)發(fā)與應(yīng)用云端落地等技術(shù)方向合作。

-

NVIDIA

+關(guān)注

關(guān)注

14文章

5292瀏覽量

106147 -

開(kāi)源

+關(guān)注

關(guān)注

3文章

3657瀏覽量

43722 -

模型

+關(guān)注

關(guān)注

1文章

3511瀏覽量

50271

原文標(biāo)題:在魔搭社區(qū)使用 NVIDIA TensorRT-LLM PyTorch 新架構(gòu)優(yōu)化 Qwen3 系列模型推理

文章出處:【微信號(hào):NVIDIA-Enterprise,微信公眾號(hào):NVIDIA英偉達(dá)企業(yè)解決方案】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

NVIDIA使用Qwen3系列模型的最佳實(shí)踐

使用NVIDIA Triton和TensorRT-LLM部署TTS應(yīng)用的最佳實(shí)踐

現(xiàn)已公開(kāi)發(fā)布!歡迎使用 NVIDIA TensorRT-LLM 優(yōu)化大語(yǔ)言模型推理

如何在 NVIDIA TensorRT-LLM 中支持 Qwen 模型

NVIDIA加速微軟最新的Phi-3 Mini開(kāi)源語(yǔ)言模型

魔搭社區(qū)借助NVIDIA TensorRT-LLM提升LLM推理效率

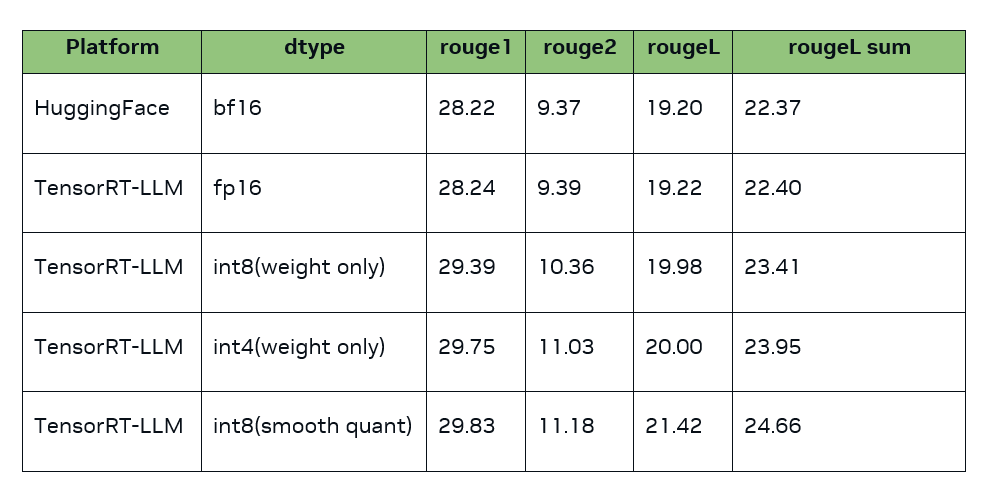

TensorRT-LLM低精度推理優(yōu)化

解鎖NVIDIA TensorRT-LLM的卓越性能

在NVIDIA TensorRT-LLM中啟用ReDrafter的一些變化

如何在魔搭社區(qū)使用TensorRT-LLM加速優(yōu)化Qwen3系列模型推理部署

如何在魔搭社區(qū)使用TensorRT-LLM加速優(yōu)化Qwen3系列模型推理部署

評(píng)論