概述

云計算和基于容器的應用是推動當今IT領域產生重大變革的兩大趨勢。與其他技術和方法相比,二者都能夠以更高的靈活性和更低的成本去運行和操作應用,因此日益受到歡迎。然而,在所有新的機遇面前,要實現潛在優勢也都會有巨大的挑戰。

層出不窮的新技術通常會對業務運營產生漸進式的影響。但是,以云計算作為運行模式,結合管理云原生應用的Kubernetes——這一做法已經改變了信息技術的交付、管理和使用方式。

此外,為支持這些環境而設計的系統需要選擇計算、網絡,尤其是存儲系統,這些系統具備高度可擴展的容量和性能,而無需采用傳統管理方式。Kubernetes提供機制,幫助應用以透明的方式利用多種計算和存儲資源。但是,要確保應用對持久數據的訪問,需要底層存儲基礎架構具有彈性,同時還能滿足成千上萬個應用的容量和性能需求。

在此背景下,Evaluator Group獲邀對適合云原生應用環境的兩種存儲系統展開對比。

●Ceph:云原生環境中常用的開源軟件定義存儲

●Lightbits云數據平臺:專為云環境設計的軟件定義存儲

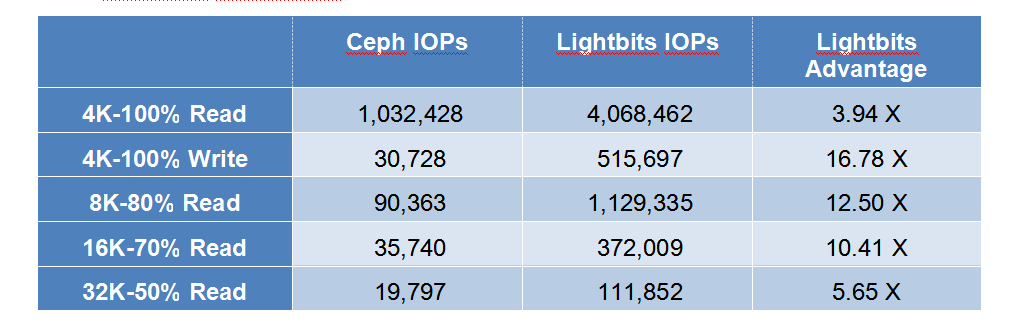

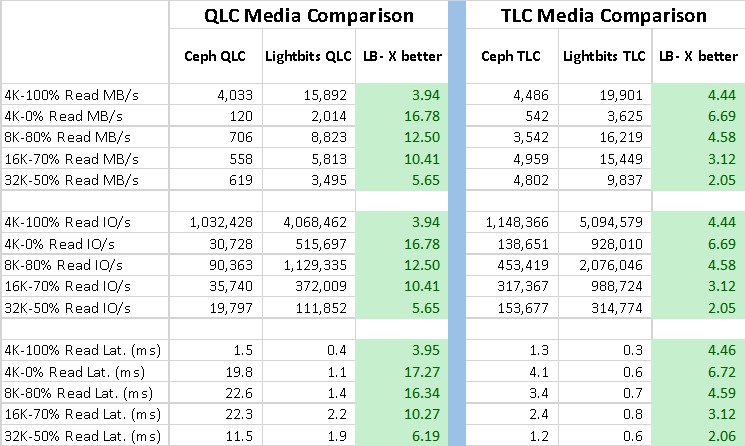

如下所示,在使用相同硬件和存儲介質的情況下,Lightbits在所有工作負載測試中,實現的性能均遠遠優于Ceph。表1匯總顯示了使用QLC介質的NVMe固態硬盤(SSD)的測試結果。該測試使用在OpenShift Kubernetes環境中作為容器運行的工作負載來進行。

表1:在容器環境中使用QLC介質時的Lightbits與Ceph I/O速率比較。(來源:Evaluator Group)

本文的其余部分將更深入地探討二者的技術和性能差異,以及使用NVMe SSD與TLC介質時的性能數據。

新興技術

如前所述,多個趨勢正在推動IT領域發生重大變化;其中,利用公共云等服務的趨勢正在改變IT運行的地點和付費方式,影響了應用程序的運行方式。云原生應用程序(CNA)的推行正在改變應用程序的開發和管理方式,這在一定程度上得益于企業向服務和云端遷移的趨勢。此外,可通過Fabric去訪問NVMe存儲的新技術,以及新的非易失性存儲技術的出現,使得那些能夠利用這些功能的系統擁有顯著的性能優勢。

云原生應用程序

基于容器的應用程序設計旨在運行于云環境,包括本地云和公共云。云原生應用程序被設計為可獨立擴展的服務,又稱為微服務。借助微服務架構,CNA能夠在少量或甚至無需管理介入的情況下,按需擴展應用程序的各個部分。

此外,CNA部署在一個位置后,可以根據可用資源甚至根據資源的價格而移動到其他位置。另外,許多此類應用程序所需的持久性存儲也必須動態響應不斷變化的容量和性能需求。

NVMe over Fabrics協議

非易失性存儲主機控制器接口規范(NVMe)是一個支持固態硬盤(SSD)去使用高速PCIe總線進行通信的接口,以實現對固態設備的低時延訪問。與SCSI或SATA設備相比,NVMe支持數十億條命令,顯著減少了延遲或時延。為了兼容與外部設備的通信,NVMe over Fabrics擴展了NVMe協議,支持通過Fabric去訪問NVMe。

NVMe over Fabric訪問的最新選擇之一是使用TCP傳輸協議,即NVMe/TCP。實施這項協議的技術負擔可顯著減少,無需任何特定的硬件或交換機設置即可支持商用以太網。總體而言,與TCP上的其他存儲協議相比,在仍然使用現有網絡基礎設施的情況下,NVMe over TCP具有更低的時延和更高的吞吐量。

持久性存儲

持久性存儲(PMem)兼具存儲特性(特別是無需能耗即可保留或“持久保存”數據的能力),以及內存總線訪問特性(例如極低的時延和字節尋址能力)。持久性存儲有兩種主要類型,分別是NVDIMM和英特爾傲騰持久性存儲(Optane Persistent Memory)。NVDIMM和傲騰PMem之間的主要區別在于存儲密度和成本,其中,與NVDIMM設備相比,英特爾傲騰PMem持久性存儲在這兩個方面都具有顯著優勢。

英特爾PMem既可用于“應用程序直接訪問模式”,也可用于“內存模式”。前者需要修改應用程序,后者以低于DRAM的成本、透明地擴展系統內存容量。Lightbits在App Direct模式下使用PMem作為非易失性寫入緩沖區,將寫入和元數據訪問直接定向至PMem,減少了備份介質的磨損,改善了系統寫入性能。

解決方案概述

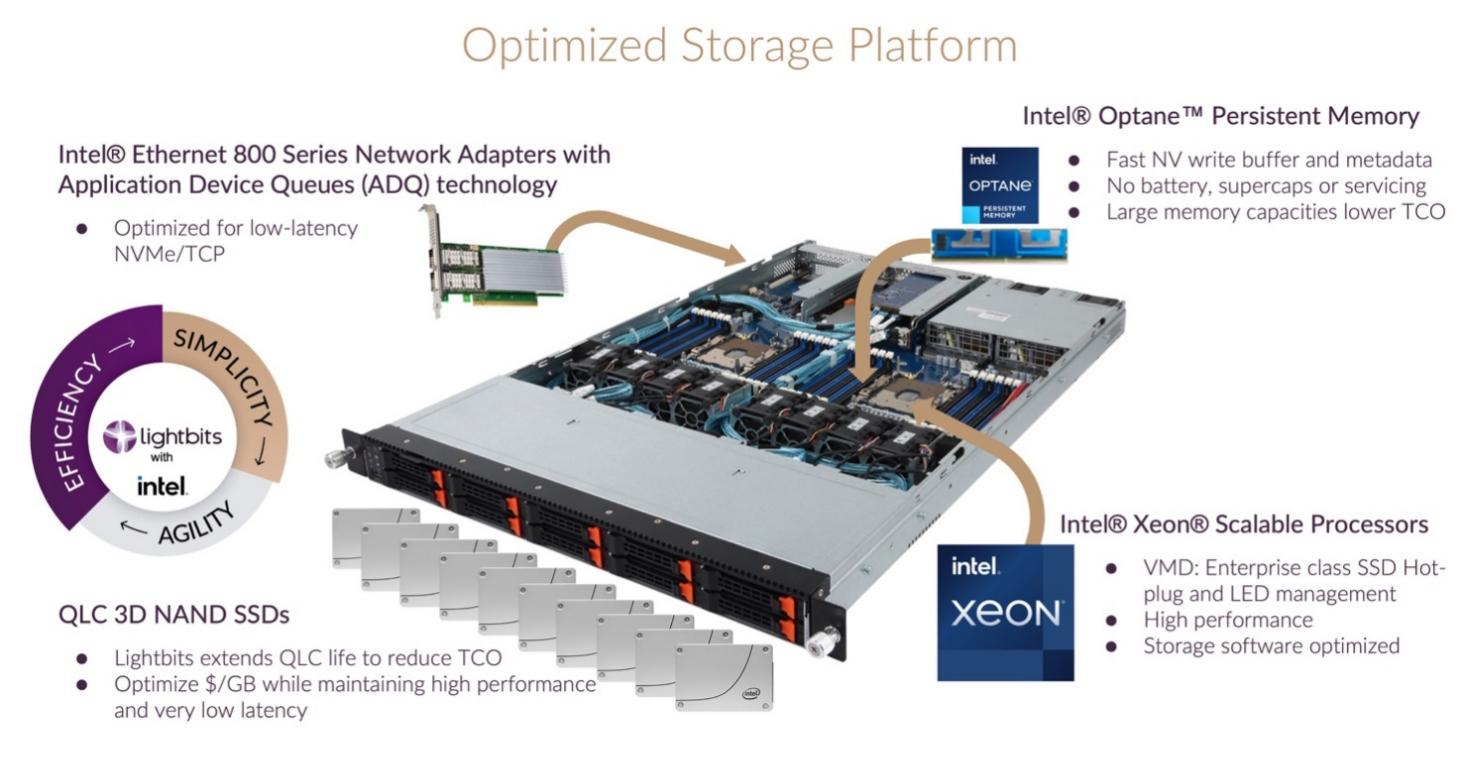

過去幾十年里,使用商用硬件、以“軟件或軟件定義存儲(SDS)”的形式運行的存儲系統日益受到追捧。這種方法之所以引人入勝,是因為它能夠在不可使用專用或專有硬件的環境中運行彈性的數據中心級存儲。此外,其靈活性有利于在不同的環境和部署規模中使用相同的SDS堆棧。如前所述,我們的評估中就使用兩種不同的SDS選項,為容器應用提供持久存儲。隨后將概述它們的功能。采用英特爾技術的Lightbits解決方案如圖1所示。

圖1:用于Lightbits軟件定義存儲的英特爾平臺(來源:英特爾)

英特爾

英特爾為當今許多領先的服務器和存儲解決方案提供基礎平臺組件。這些組件包括英特爾至強處理器、英特爾網絡適配器和英特爾傲騰?技術等,其中,英特爾傲騰?可作為NVMe固態硬盤,或內存形式的傲騰持久性存儲(PMem)設備提供。此外,具有應用設備隊列(ADQ)的英特爾Ethernet800系列提供了高性能、低時延的NVMe/TCP網絡接口卡。

Lightbits云數據平臺

Lightbits云數據平臺是一種軟件定義存儲,旨在運用最新的技術,包括NAND閃存和英特爾傲騰持久性存儲(PMem);它使用高速100GbE網絡接口卡,支持NVMe over TCP。Lightbits使用分布式架構,能夠按需獨立擴展CPU、內存、PMem或NVMe設備。因此,Lightbits能夠提供可擴展的企業級存儲,性能優于本地NVMe設備。

Lightbits智能閃存管理解決方案Intelligent Flash Management?(IFM)支持最大限度地提高SSD性能和延長其耐用性。其主要特性包括寫條帶化、無IOP元數據訪問、智能垃圾收集、追加寫策略和并行讀/寫通道。

通過將英特爾的高性能硬件平臺與Lightbits方案進行耦合,可提供可擴展的解決方案,降低總體擁有成本(TCO)。Lightbits解決方案特別采用了以下技術:

●英特爾?至強?處理器系統

o高性能CPU、內存、I/O和PCIe Gen4

o使用高性能CPU架構的高效存儲軟件

o企業級SSD熱插拔和LED支持NVMe介質

●英特爾傲騰持久性存儲(PMem)

o低時延、非易失性寫緩沖區和元數據存儲

o無需電池或電容器即可維持持久性

o大容量持久性存儲,總擁有成本低于其他替代方案

●英特爾Ethernet800系列網絡適配器

o提供應用設備隊列(ADQ)

o高性能應用設備隊列

o低時延NVMe/TCP,無需使用定制的驅動程序

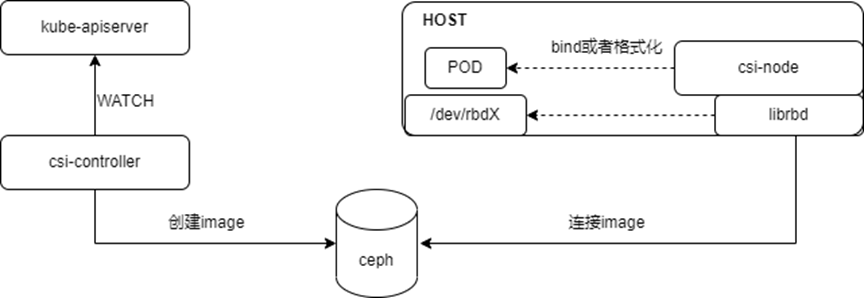

通過Kubernetes容器存儲接口(CSI),Kubernetes管理的容器可以作為持久卷(PV)訪問Lightbits存儲。Lightbits CSI插件使Kubernetes能夠使用其“Elastic RAID”在Lightbits集群中存儲持久卷(PV),該“Elastic RAID”提供糾刪碼保護,防止每個節點的數據丟失。其他Lightbits服務包括壓縮、復制、卷快照、克隆和用于多租戶環境中的基于角色的訪問控制(RBAC)。

Ceph

Ceph是一款開源的軟件定義存儲產品,帶有多個不同的接口,可作為塊設備、文件系統和目標存儲進行訪問。設計Ceph時,采用旋轉硬盤驅動器作為主要的存儲介質,基于NAND的SSD在大多數主流存儲系統中不發揮作用。

自Ceph設計以來的15年間,各種外形規格的固態閃存已成為高性能存儲系統的主要介質。但Ceph初始設計中旨在提高旋轉物理介質性能的許多元素仍得以保留。最近,更新后的Ceph已經可以使用固態的“BlueStore”和“RocksDB”進行元數據操作。迄今為止,Ceph還沒有針對持久性存儲進行優化,也不支持NVMe over fabrics或NVMe over TCP。

我們在測試中使用Ceph的開源版本,詳見附錄。

存儲效率

與一些軟件定義存儲系統相比,Lightbits的彈性設計擁有更多優勢。Lightbits針對每個節點使用糾刪碼保護,確保在丟失存儲設備時的數據可用性;此外,節點之間可進行復制,因此,Lightbits能夠在減少開銷和存儲容量浪費的同時,提供 更大的彈性。在測試期間,Lightbits的配置是:在每個節點上使用糾刪碼來保護數據,同時在Lightbits集群中的另一個節點上額外制作一份數據拷貝。

與此相反,Ceph的配置是:創建三個數據副本來進行數據保護,此時,如果一個節點的驅動器和另一個節點出現故障斷電,則無法確保數據可用性。盡管這兩種保護方法的存儲效率相似,但Lightbits方法的可用性更高。

不同容器工作負載下的性能

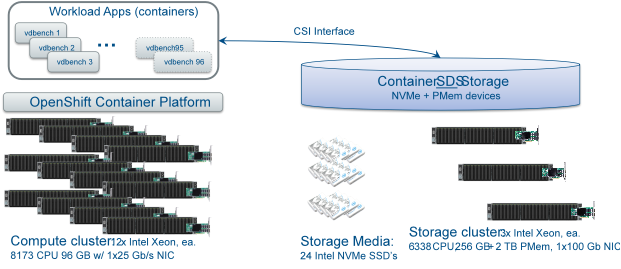

Evaluator Group需對Kubernetes應用環境中作為容器運行的兩種不同的存儲產品進行分析。我們對Lightbits軟件定義存儲與面向容器的開源軟件定義存儲產品Ceph進行了比較。測試環境由12個Kubernetes節點組成,在專用的3節點Lightbits集群或3節點Ceph集群中運行容器工作負載。容器應用測試圖表和其他細節、硬件、軟件和其他方面的詳細信息,請參見附錄描述。

測量存儲性能時,使用眾所周知的“vdbench”工具創建工作負載,每個節點使用8個運行vdbench的容器實例,總共96個vdbench實例。

測試包括性能敏感型應用中常見的5種不同的訪問模式和塊大小:

●4KB,100%讀取,100%隨機訪問

●4KB,100%寫入,100%隨機訪問

●8KB,80%讀取/20%寫入,80%隨機訪問

●16KB,70%讀取/30%寫入,80%隨機訪問

●32KB,50%讀取/50%寫入,80%隨機訪問

這些工作負載用于比較Lightbits與Ceph的性能,使用QLC固態介質作為主要存儲介質,并根據每個存儲系統使用適當的高速持久介質。在所有情況下,分別多次運行5個工作負載,獲得可用于比較的平均結果。有關Lightbits和Ceph配置的具體細節,請參見附錄。

Evaluator Group評論:測試結果顯示,使用Lightbits具有巨大的性能優勢,其中,4KB寫入工作負載的性能是Ceph的16倍。考慮到在所有比較中,底層介質的數量和類型是相同的,這種優勢尤為明顯。

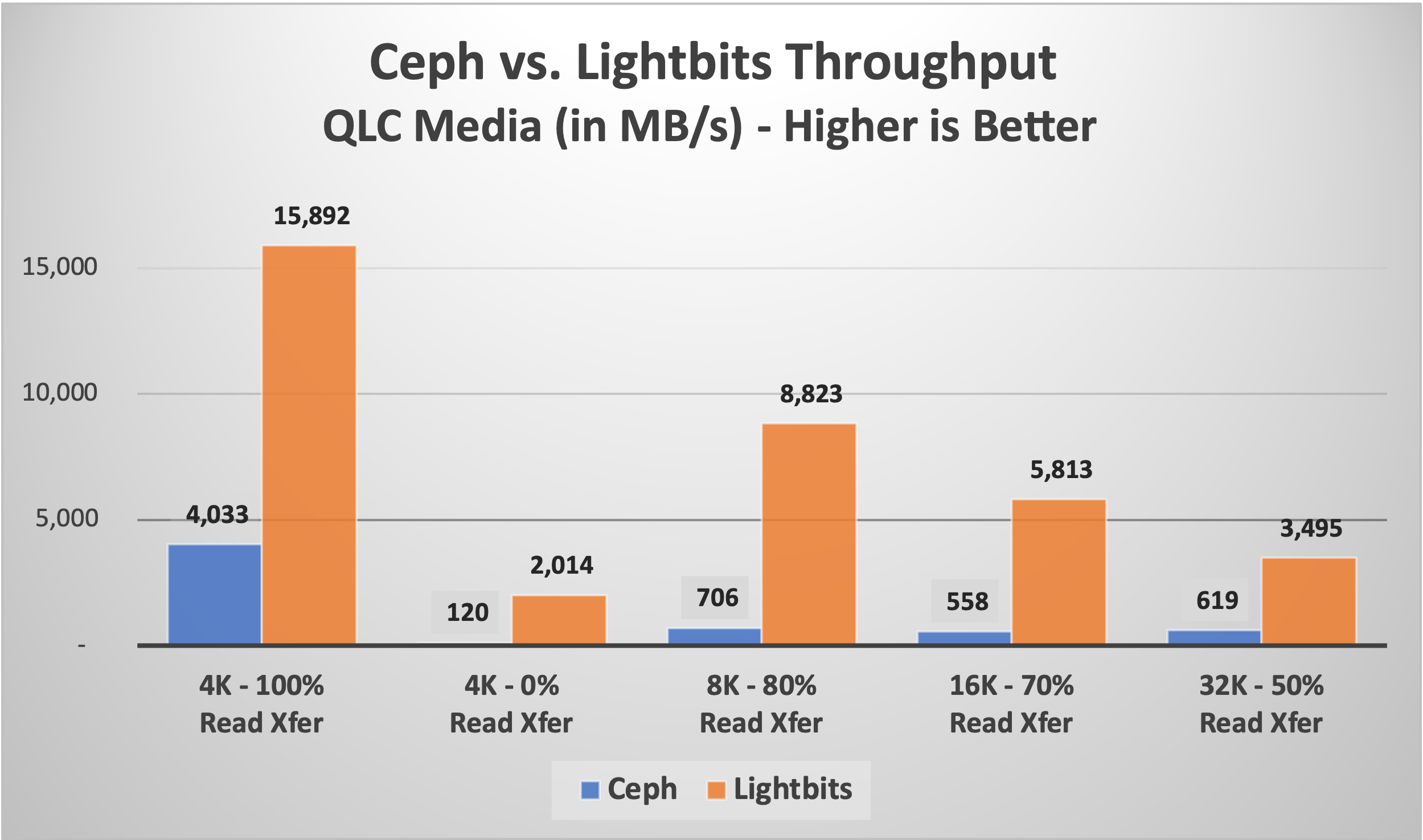

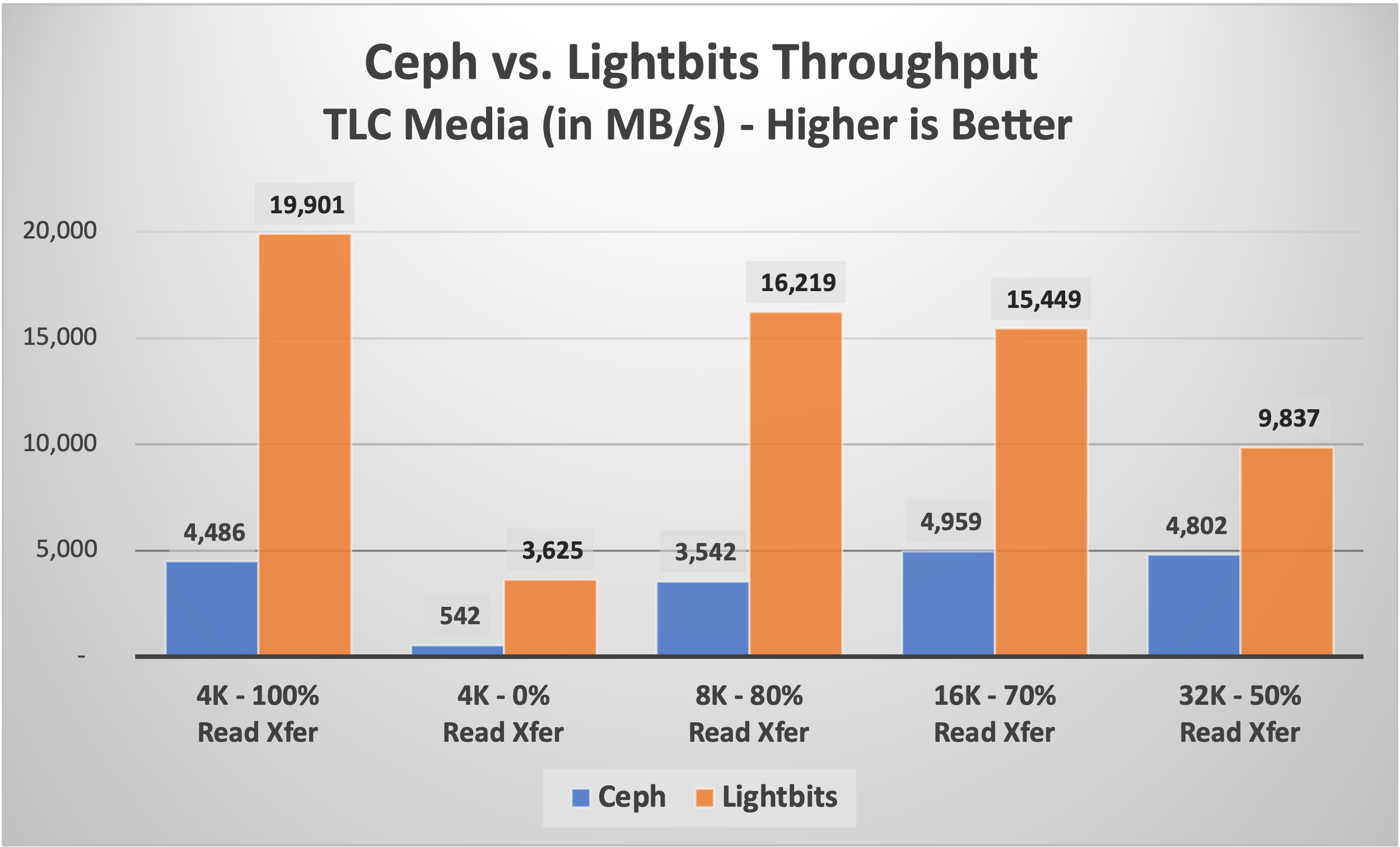

圖2:Ceph與Lightbits吞吐量比較(來源:Evaluator Group)

圖2顯示了使用QLC介質時,Lightbits和Ceph在5種不同訪問模式下的吞吐量結果。吞吐量結果是直接可比較的,因為它們考慮了數據塊大小的差異,因此將其全部顯示在一起。

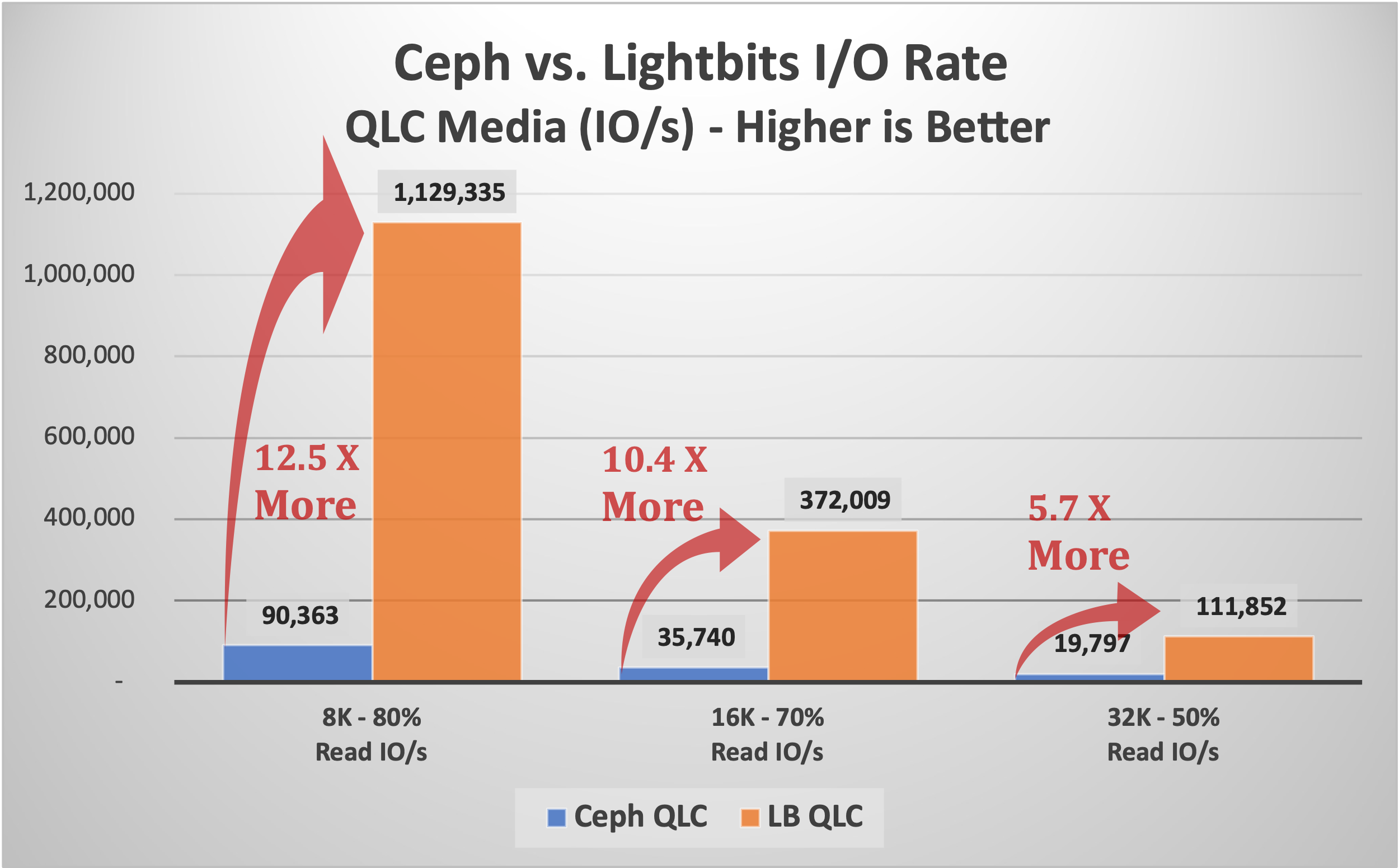

性能詳情

I/O速率(以每秒I/O傳輸次數或IOPs衡量)是小數據塊工作負載的常用指標,但不利于對比不同的數據塊大小。如下方圖3所示,對典型應用大小——8KB、16KB和32 KB進行比較,繪制I/O速率,以每秒I/O傳輸次數衡量。在32KB時,Lightbits的優勢是5.7倍,在16KB時,優勢是10.4倍,在8K工作負載時,Lightbits的性能超過Ceph 12倍。

圖3:使用QLC介質時Lightbits與Ceph的性能對比–不同數據塊大小的吞吐量(來源:Evaluator Group)

上文顯示的三種工作負載是數據庫或其他事務應用程序中的常見負載。盡管許多數據庫嘗試執行16K或32K大小的I/O,但在許多情況下,如果更改較小或事務率較高,它們傾向于使用較小數據塊。數據庫將執行8K甚至4K事務,而非等待合并幾個較小的I/O。

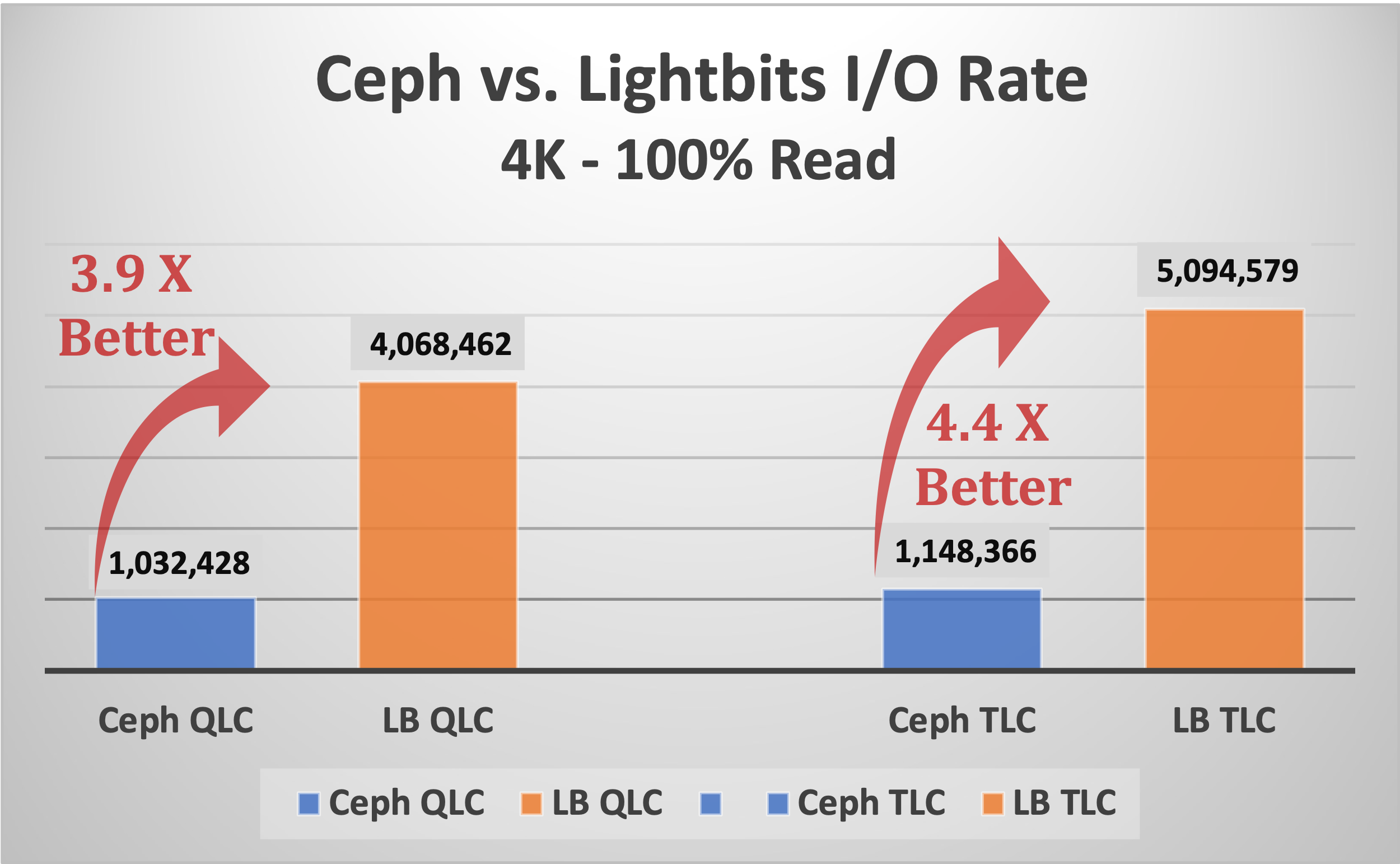

以下顯示Ceph和Lightbits使用兩種不同類型的存儲介質,即QLC和TLC介質時,4KB讀取操作的I/O速率比較。

圖4:使用QLC和TLC介質時,Ceph與Lightbits的4KB讀取I/O速率比較(來源:Evaluator Group)

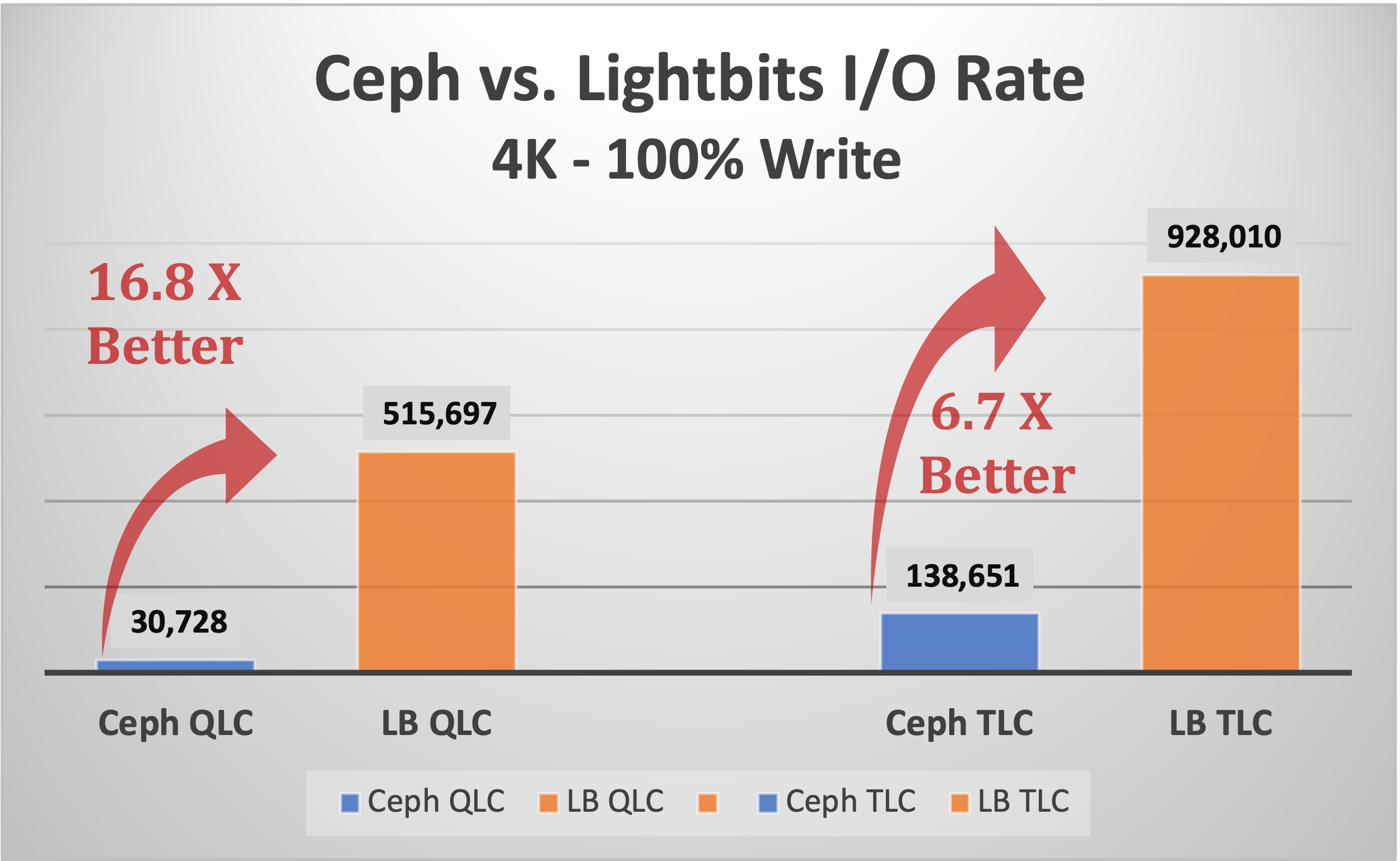

雖然會發生4KB讀取操作,但4KB寫入操作更經常用于數據庫日志記錄操作。使用QLC介質時,Lightbits的性能比Ceph高出近17倍,使用TLC介質時,性能比Ceph高出近7倍,如下圖5所示。

圖5:使用QLC和TLC介質時,Ceph與Lightbits的4KB寫入I/O速率比較(來源:Evaluator Group)

Evaluator Group評論: 數據庫和其他事務應用程序依賴于低時延存儲,尤其是事務日志,后者必須在事務完成前寫入持久介質。日志大多通過4K I/O操作寫入,在此工作負載下,Lightbits顯示出比Ceph更大的優勢:使用TLC介質時,優勢高出近7倍,使用QLC時,優勢高出近17倍。

其他性能數據

下文為性能結果概述,其中指出三個主要指標,包括吞吐量、I/O速率以及時延。Lightbits相對于Ceph的性能優勢極其顯著,因此用“x”倍數來體現這種優勢。使用簡單的除法(即515,697 / 30,728 = 16.78 x)來顯示Lightbits性能優勢倍數。要點如下:

●在所有五個工作負載下的測試結果表明,Lightbits具有4到16倍的優勢

●數據庫經常使用對時延高度敏感的小塊寫入日志或日記

●在4KB寫入下,Lightbits的性能優勢為16.78倍,優勢顯著

表3:Lightbits與Ceph性能比較(來源:Evaluator Group)

關于測試,還有一點值得留意,即在使用QLC介質時,Ceph的時延高于大多數工作負載可接受的水平。這是因為,我們在所有測試中使用相同的隊列深度設置,確保比較結果的公平公正。如果工作負載針對Ceph QLC進行了優化,將使用較低的隊列深度設置,從而降低I/O速率,同時減小時延。如果以這種方式進行測試,Ceph的時延水平更易于接受,但性能會顯著降低,從而放大Lightbits的優勢。

最終結論

性能始終是IT基礎設施的重要考慮因素,尤其是在運行云環境或托管云原生應用程序時。盡管并非每個應用或微服務都需要高I/O速率,但如要運行現代云基礎設施,提供具有高I/O速率和低時延的彈性、可擴展存儲至關重要。

Evaluator Group評論:在使用相同硬件配置的情況下,Lightbits的性能顯著優于Ceph,彈性也更高。Lightbits針對英特爾的高性能技術進行優化,為支持云的Kubernetes環境提供了強大的存儲平臺。

近期技術進展層出不窮,助力IT用戶去大規模、經濟高效地運營基礎設施。當與英特爾傲騰持久性存儲結合使用時,QLC等新型存儲介質可以為要求不高的工作負載支持海量存儲容量,并提供良好的性能。包括新處理器和端到端NVMe在內的其他技術也可以提供性能和成本優勢。

英特爾的專有技術,如Xeon CPU、支持NVMe over TCP的英特爾網卡,以及傲騰持久性存儲和高密度NVMe SSD,為軟件定義產品提供了強大的硬件基礎。由于高效利用了英特爾CPU、網絡接口和持久存儲介質,Lightbits存儲可提供本地NVMe級別的性能,從而持續確保低時延和數據服務。

本文中所示的性能測試使用了IT環境和應用中常見的工具和工作負載。附錄提供了進一步的詳細信息,如希望進一步了解測試,或希望使用自己的硬件配置重復這些測試,可參考附錄。

Evaluator Group評論:借助存儲專業人員熟知的測試工具和工作負載,我們認為,Lightbits可以提升現代應用程序的性能。Lightbits可以通過QLC介質和傲騰PMem,支持時延敏感型應用,而Ceph在明顯具有更高延遲的情況下只能提供很低的I/O速率。

利用持久性存儲和端到端NVMe等新技術,Lightbits即可提供比Ceph更優異的性能,且彈性更高。顯而易見,Lightbits的性能是Ceph的16倍,時延更低,是適合現代應用和云環境的更佳選擇。

附錄

測試環境詳情

測試環境利用以下硬件、軟件和應用工作負載項目。

測試持續4個月,從2021年9月起至12月止。

硬件和基礎設施

●關于測試配置的概述,請參見下方圖6

o在裸機上運行的應用集群,由12個Kubernetes“worker”節點組成

o3節點管理集群/作為虛擬機運行的Kubernetes“master”節點

o運行軟件定義存儲堆棧的3節點存儲集群

●應用環境和編排使用OpenShift 4.6版

圖6:OpenShift訪問存儲節點的工作負載測試設置(來源:Evaluator Group)

軟件環境

●使用Red Hat OpenShift 4.6版作為3個管理節點和12個應用節點

o12個應用(OpenShift“worker”)節點直接運行于硬件上,因此稱為“裸機”

o3個管理(OpenShift“master”)節點作為虛擬機運行,但作為“裸機”安裝

●CentOS 8.4版是3個Ceph節點使用的基礎操作系統

●Ceph SDS堆棧使用開源Ceph 16.2.6版(又名“Pacific”)

●VMware 7.0;3臺虛擬機使用ESXi及vCenter

SUT配置

●一個12節點應用集群,運行Red Hat OpenShift

o應用/工作節點配置:

?雙插槽第一代英特爾至強可擴展系統(Intel Xeon Platinum 8173M)

?96 GB內存(12個8 GB DIMM)

?英特爾XXV710-DA2網卡,每臺主機帶2個25 Gb/s連接

●兩個存儲系統連接到OpenShift應用集群

oSDS #1,Ceph配置:

?雙插槽第三代英特爾至強可擴展系統(Intel Xeon Gold 6338)

?256 GB內存(16個16 GB DIMM)

?2 TB的英特爾傲騰PMem(配置為WAL和Cache設備)

?英特爾E810-CQDA2網卡,每臺主機帶1個100 Gb/s連接

?8個英特爾NVMe存儲介質,可選擇

●QLC SSD介質:英特爾SSD D5-P5316 @ 15.36 TB

●TLC SSD介質:英特爾SSD D7-P5510 @ 3.84 TB

oSDS #2,Lightbits配置:

?雙插槽第三代英特爾至強可擴展系統(Intel Xeon Gold 6338)

?256b GB內存(16個16 GB DIMM)

?2 TB英特爾傲騰持久性存儲Persistent Memory200(配置為Lightbits寫入緩沖區)

?英特爾E810-CQDA2網卡,每臺主機帶1個100 Gb/s連接

?8臺英特爾NVMe存儲設備,可選擇:

●QLC SSD介質:英特爾SSD D5-P5316 @ 15.36 TB

●TLC SSD介質:英特爾SSD D7-P5510 @ 3.84 TB

客戶端配置–基礎設施

●使用運行VMware ESXi的單一英特爾系統來支持基礎設施

o3臺虛擬機用作OpenShift“master”節點

o運行Microsoft Server 2019的“jump”主機,用于遠程訪問基礎設施

SDS存儲配置

Ceph配置

備注:Ceph沒有“默認”配置,由于硬件的可用性和其他配置參數,每次安裝都可能不同。有關配置,請參見下文:

●使用“CentOS 8.4版”作為所有三個節點的主機操作系統

●按照上述定義配置硬件,每個節點配置8個NVMe設備

●下載后,在全部3個節點上配置Ceph“Pacific”

o將2 TB的PMem分成兩個分區,一個用于WAL,另一個用于RocksDB

o每個NVMe SSD配置為6個邏輯OSD(每臺設備設置6個OSD)

●Ceph設備配置

o每臺主機有8個SSD,分別被劃分為6個區域

o在8個物理SSD上使用6個分區,每個系統總共有6 * 8 = 48個OSD

oCeph配置了駐留在Optane PMem上的WAL

●默認資源設置:

oCPU設置為每個OSD 1個CPU,內存設置為每個設備4 GB

Lightbits配置

備注:Lightbits沒有“默認”配置。Lightbits和英特爾工程部門為Lightbits執行了所有的設置操作。有關配置,請參見下文:

●使用“Lightbits”作為全部三個節點的主機操作系統

●按照上述定義配置硬件,每個節點配置8個NVMe設備

●在全部3個節點上配置Lightbits

o指定2 TB的PMem作為緩存設備

o將每個NVMe SSD用作邏輯設備

應用工作負載

●使用“vdbench”工具,生成具有不同數據塊大小和讀寫比率的合成工作負載

o在開始其他測試之前,運行“寫入-填充”工作負載,完全寫入被測的整個存儲容量

o每個測試運行15分鐘進行“預熱”,然后運行30分鐘進行“測量”

o測試按順序進行,每完成5個測試稱為一“組”

o每個測試組重復9次,用9輪運行結果的平均值進行比較

●針對存儲配置測試以下5種工作負載

o4KB,100%讀取,100%隨機訪問

o4KB,100%寫入,100%隨機訪問

o8KB,80%讀取/20%寫入,100%隨機訪問

o16KB,70%讀取/30%寫入,80%隨機訪問

o32KB,50%讀取/50%寫入,50%隨機訪問

測試過程概述

●設置用于應用的服務器和網絡

●設置系統,安裝附加測試基礎設施使用的VMware

●在15個系統上安裝OpenShift(12個“worker”裸機硬件和3個“master”虛擬機節點)

●安裝和配置軟件定義存儲目標集群

o將Lightbits安裝到3個節點上,用于Lightbits SDS存儲

o安裝CentOS,并在用于Ceph SDS存儲的3個節點上安裝Ceph Pacific

●創建包含96個vdbench客戶端容器實例和1個vdbench控制器實例的容器工作負載環境

●在控制器容器上運行vdbench工作負載,將工作負載分配給所有96個vdbench實例

●為每個工作負載收集9組結果,得到平均I/O速率、吞吐量和時延

使用TLC介質進行比較

使用QLC介質測試完畢后,重新將兩個存儲系統配置為使用TLC介質設備,而非QLC設備。眾所周知,TLC介質的寫入I/O速率更優,時延更低。同樣,測試兩個存儲系統時,使用相同的工作負載,在相同的服務器硬件、網絡上運行,最重要的是,使用相同數量和類型的存儲介質。基于TLC的NVMe固態設備作為主要的存儲介質,并根據最佳實踐,為每個存儲堆棧使用英特爾傲騰PMem。

圖7:TLC多工作負載下的Lightbits與Ceph吞吐量比較(來源:Evaluator Group)

圖7顯示了使用TLC SSD介質時,五次相同測試的吞吐量結果。顯示吞吐量結果旨在提供可直接比較的結果,不過I/O速率是更常用于顯示單個小數據塊工作負載的指標。

-

云計算

+關注

關注

39文章

7976瀏覽量

140155 -

IT

+關注

關注

2文章

892瀏覽量

64450 -

應用軟件

+關注

關注

0文章

53瀏覽量

9284

發布評論請先 登錄

應用軟件運行速度提升16倍:Lightbits與Ceph的存儲性能對比

應用軟件運行速度提升16倍:Lightbits與Ceph的存儲性能對比

評論