0. 引言

多機器人協作在搜索救援、工業自動化、智慧農業等領域發展迅猛,而協同SLAM(C-SLAM)是實現多機器人協作的核心技術。現有的EuRoc、KITTI等數據集雖然在單機SLAM領域發揮了重要作用,但卻很難去評價多機協同的軌跡和建圖精度。近日,中山大學團隊開發了一種用于協作SLAM的大規模多模態數據集,由3個無人車沿四種軌跡采集,包含7個室外場景和5個室內場景。這是第一個使用各種室內和室外環境的激光雷達、視覺和慣性數據的C-SLAM數據集,研究機器人協作的小伙伴一定不要錯過!

2. 摘要

隨著使用一組機器人協作完成任務的要求越來越高,研究界對協作同步定位和地圖繪制越來越感興趣。不幸的是,現有的數據集在它們捕獲的協作軌跡的規模和變化方面是有限的,盡管不同主體之間的交互軌跡的一般化對于協作任務的整體可行性是至關重要的。為了幫助將研究社區的貢獻與現實世界的多主體協調SLAM問題結合起來,我們引入了S3E,這是一個由無人駕駛地面車輛車隊沿著四個設計的協作軌跡范例捕獲的新的大規模多模態數據集。S3E由7個室外和5個室內場景組成,每個場景都超過200秒,由同步和校準良好的高質量雙目相機、激光雷達和高頻IMU數據組成。至關重要的是,我們的努力在數據集大小、場景可變性和復雜性方面超過了以前的嘗試。它的平均記錄時間是開創性的EuRoC數據集的4倍。我們還提供仔細的數據集分析以及協作SLAM和單個對應方的基線。

3. 數據集介紹

3.1 數據采集車

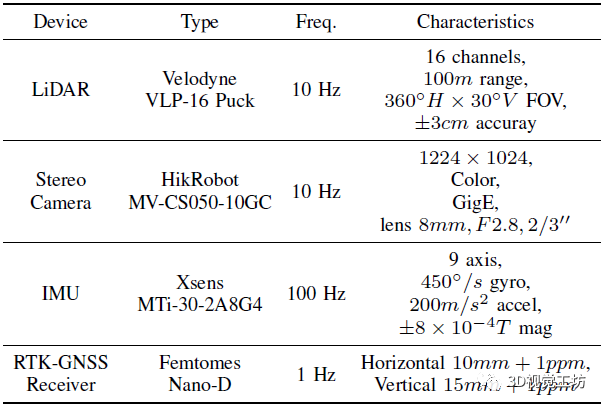

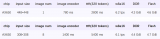

如圖1所示是用于采集S3E數據集的無人車,每個無人車上都有2個高分辨率彩色相機、1個16線激光雷達、1個9軸IMU以及1個雙天線RTK。表1所示是無人車所使用傳感器的具體參數。 表1 傳感器設備參數

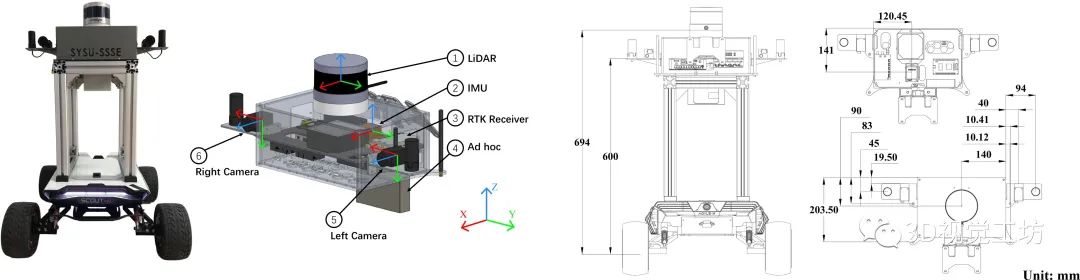

無人車所使用的平臺是Agilex Scout Mini,它是一款四輪驅動、最高車速10km/h的全地形高速遙控移動平臺。在具體的數據采集過程中,作者使用Velodyne VLP-16 Puck來記錄360°點云數據。使用兩臺HikRobot MV-CS050-10GC GigE相機采集雙目視覺數據,其中雙目相機的基線為360mm,圖像通過全局快門掃描捕獲,并從原始圖像降采樣到1224x1024。此外,還使用9軸Xsens MTi-30-2A8G4 IMU記錄三個加速度計和三個陀螺儀。為了進行驗證和測試,作者還使用Femtomes Nano-D RTK配備雙天線在GNSS可用區域捕獲軌跡真值,真值采集頻率為1 Hz。無人車平臺上所有傳感器的安裝位置如圖2所示,采集到的S3E數據集樣例如圖3所示。

圖2 傳感器布局和坐標系

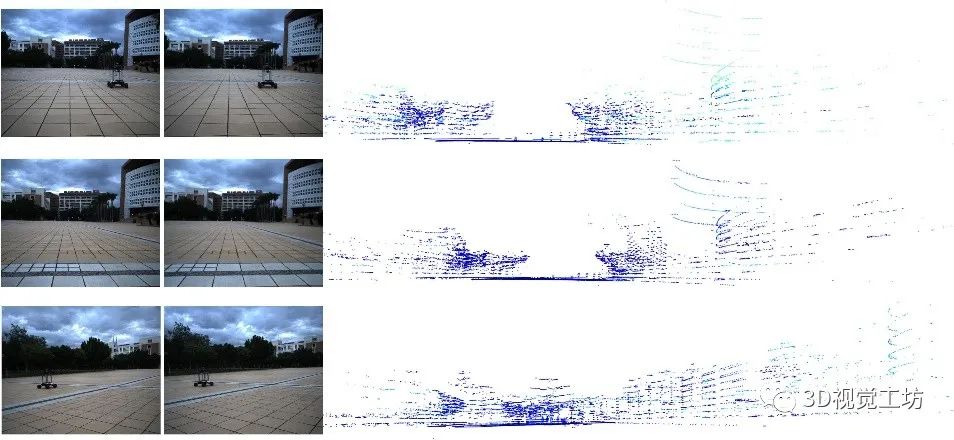

圖3 S3E數據集的數據示例,每行都顯示了不同平臺同時捕捉到的雙目圖像和點云。

3.2 傳感器同步

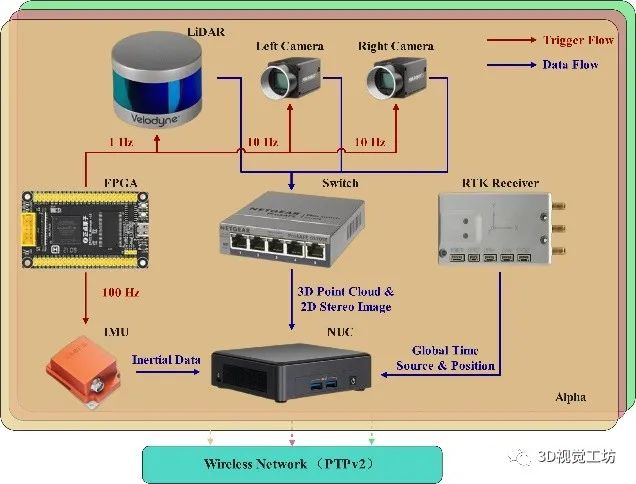

在多傳感器融合中,時間同步和傳感器校準至關重要。因此,作者在此方面也做了很多的工作。 (1) 時間同步:如圖4所示,S3E的同步系統使用Altera EP4CE10板作為觸發器,Intel NUC11TNKv7作為主機。對于不同機器人間的同步,作者把這個問題分成兩種情況來討論。首先,應用GNSS時間作為室外場景中的全局時間源來校準機器人的計時器。之后,在無GNSS系統中(室內場景),所有機器人運行時間校準程序,通過無線網絡從PTP服務器獲取外部全局時間數據。 對于內部同步,觸發單元周期性地產生脈沖來觸發激光雷達、雙目攝像機和IMU。值得注意的是,FPGA產生1 Hz脈沖來觸發激光雷達,然后激光雷達返回10 Hz數據,并在接收到觸發信號后刷新內部計數器寄存器。攝像機和IMU在收到觸發脈沖后立即返回數據。 (2) 傳感器校準:在圖2所示的傳感器布局中,所有的坐標系都遵循右手定則。作者使用標準棋盤校準來運行相機的內部校準。對于激光雷達和IMU,由廠家進行內部傳感器校準。之后進行雙目相機聯合標定和激光雷達-相機聯合標定。此外,在利用Allan標準差對IMU噪聲建模后,作者還進行了相機和IMU的聯合標定。

圖4 基于FPGA的同步系統架構

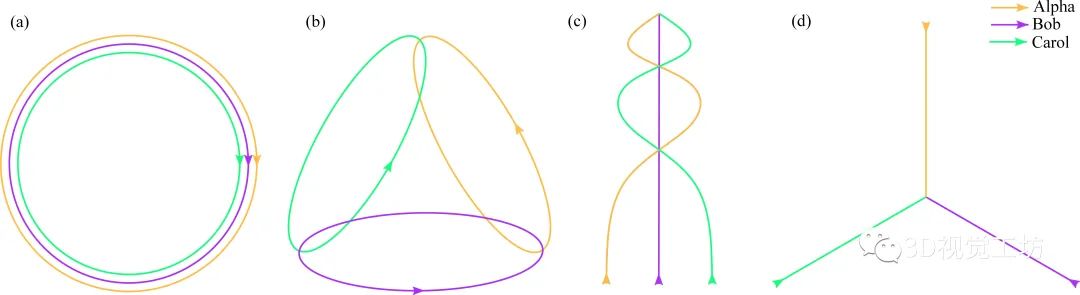

3.3 軌跡范例

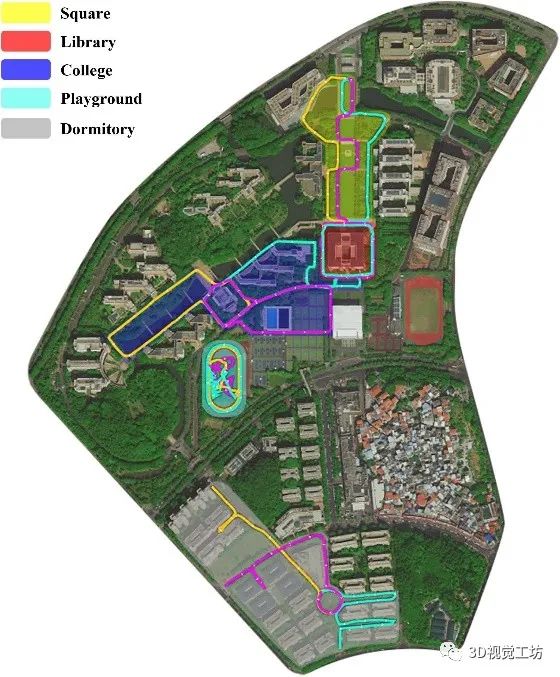

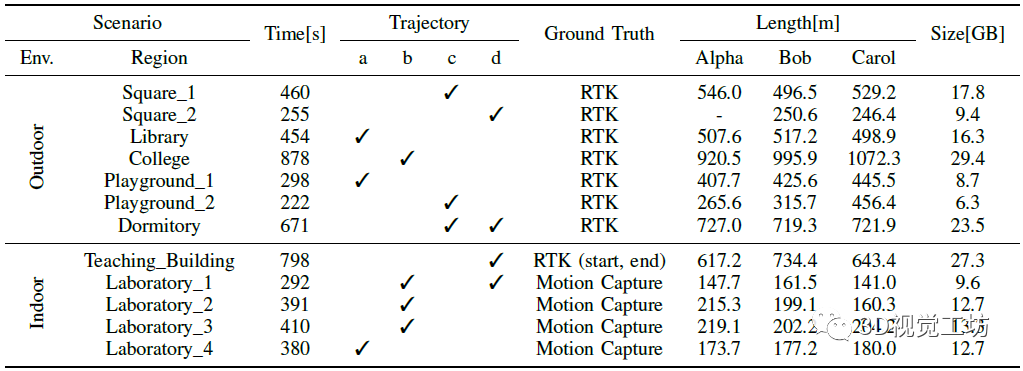

如圖5所示,在S3E數據集中,作者設計了遵循四種不同的機器人內/機器人間規范的閉環軌跡。 第一種軌跡是C-SLAM應用中的典型情況,即機器人編隊同時繞目標運行,主要用于對目標進行稠密三維重建。第二個軌跡模擬區域搜索和救援任務,每個機器人在不同的區域搜索,并在交互過程中與其他機器人共享信息。這種情況要求C-SLAM算法在小的公共區域內具有可靠的機器人內部閉環能力和高效的機器人之間閉環能力。第三條軌跡集中于僅具有機器人間環路閉合的場景,所有的機器人都從不同的地方開始,并在路徑中的一些會合點前進,最后在同一個地方相遇。第四條軌跡中,機器人從不同的地方開始,終點是同一個地點。這種情況在C-SLAM中非常困難,因為所有的機器人只在終點相遇,幾乎沒有為回環提供任何信息。 圖6顯示了室外環境中S3E數據集的軌跡,它包含校園內五個有代表性的功能區域,即廣場、圖書館、學院、操場和宿舍。

圖5 四種軌跡范例

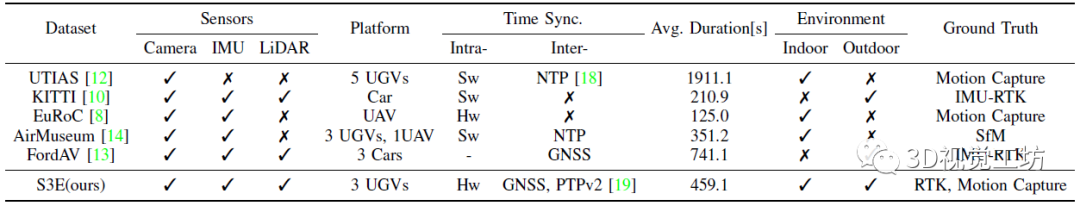

圖6 S3E數據集的室外軌跡,Alpha、Bob和Carol在室外環境中的軌跡用橙色、紫色和青色標注。 S3E數據集的室外和室內分布情況如表2所示,與其他主流SLAM數據集的對比如表3所示。S3E數據集的平均時間為459.1s,這對解決C-SLAM的長期評估問題具有較大幫助。值得注意的是,對于每個設計的軌跡,該數據集至少包含一個序列。此外,Dormitory為第三類和第四類的混合軌跡,Laboratory_1為第二類和第四類的混合軌跡。 表2 S3E數據集分析

表3 與一些流行的SLAM數據集的對比

4. 實驗

4.1 基線

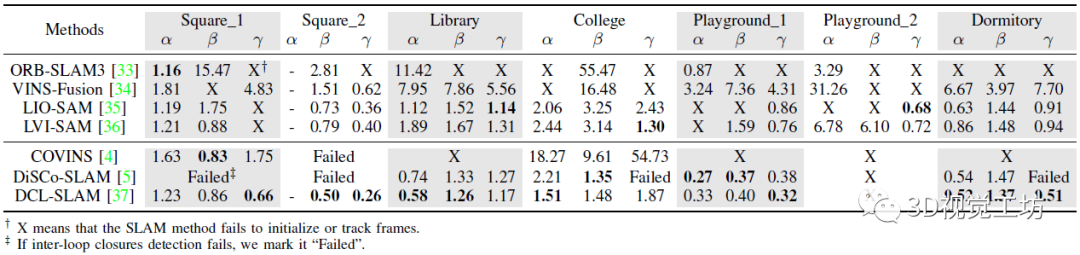

如表4所示,作者在S3E數據集上提供了四個單機器人SLAM和三個C-SLAM基線,評價指標為ATE,均是目前的主流SLAM算法。其中前者包括ORB-SLAM3、VINS-Fusion、LIO-SAM以及LVI-SAM。后者包括COVINS、DiSCo-SLAM以及DCL-SLAM。 作者采用了三種方法來生成軌跡真值:在GNSS可用區域,由雙天線RTK設備記錄的厘米級定位真值。對于無GNSS的場景,用RTK設備記錄建筑物外軌道的起點和終點。并利用運動捕捉設備來記錄室內情況下的起點和終點。 表4 室外環境下單SLAM和C-SLAM的基準ATE。α、β和γ分別代表ALPHA、BOB和CAROL

4.2 結果對比

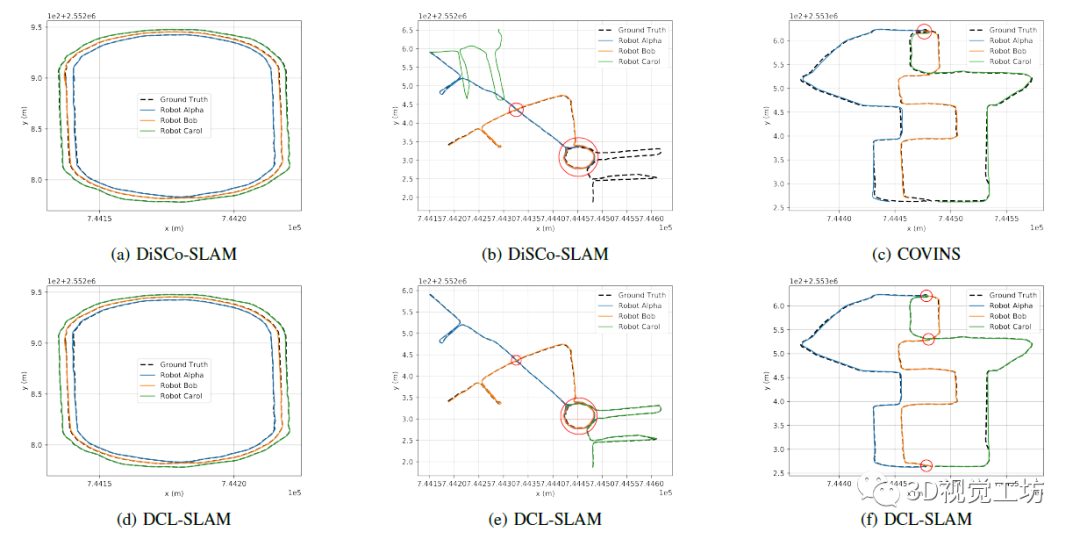

對于單機器人SLAM,基于激光雷達的方法通常優于基于視覺的方法。在S3E中,大多數基于視覺的方法在轉彎時無法跟蹤幀,因此,基于LiDAR的C-SLAM超過了基于視覺的C-SLAM。同時,C-SLAM在成功檢測到回環時,可以狀態估計的魯棒性和準確性。例如DCL-SLAM相比其前端LIO-SAM,平均ATE降低了0.42。在Playground_1序列中,部署單LIO-SAM時,同心圓Alpha和Bob均無法跟蹤幀,單通過DCL-SLAM可以成功跟蹤,并且精度實現了大幅提升。在Square_1中,COVINS以7.09的ATE超過了單SLAM,Carol在ORB-SLAM3失敗時通過協作實現了1.75 ATE。 如圖7所示,紅色圓圈表示C-SLAM成功檢測到回環。在左側,DiSCo-SLAM和DCL-SLAM在簡單的情況下取得成功,因為不同觀測之間的大量重疊保證了后端優化的冗余特性。與DCL-SLAM相比,COVINS在兩個機器人同向移動的端點處成功檢測到不同機器人之間的回環,但在兩個機器人相對移動的中點處未能匹配到Bob和Carol之間的特征。這也是DCL-SLAM優于COVINS的原因之一。結果表明,先進的C-SLAM系統可以在具有相當大重疊度的軌跡間表現良好。

圖7 C-SLAM的定性結果

5. 結論

近期,中山大學開發了一種由三個無人車記錄的大規模C-SLAM數據集,它包含激光雷達-視覺-IMU數據。S3E數據集包含7個室外場景和5個室內場景,并進行了時間同步和傳感器校準。此外,S3E數據集中包含了多個回環檢測,并評估了當前最先進的C-SLAM及其單機器人前端比較器的性能。多機協同是機器人領域的一個重要發展趨勢,而目前多機數據集還較少,S3E很大程度上填補了這方面的空白。

審核編輯 :李倩

-

機器人

+關注

關注

213文章

29741瀏覽量

212871 -

計時器

+關注

關注

1文章

432瀏覽量

33746 -

數據集

+關注

關注

4文章

1224瀏覽量

25447

原文標題:S3E:用于協作SLAM的大規模多模態數據集

文章出處:【微信號:3D視覺工坊,微信公眾號:3D視覺工坊】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

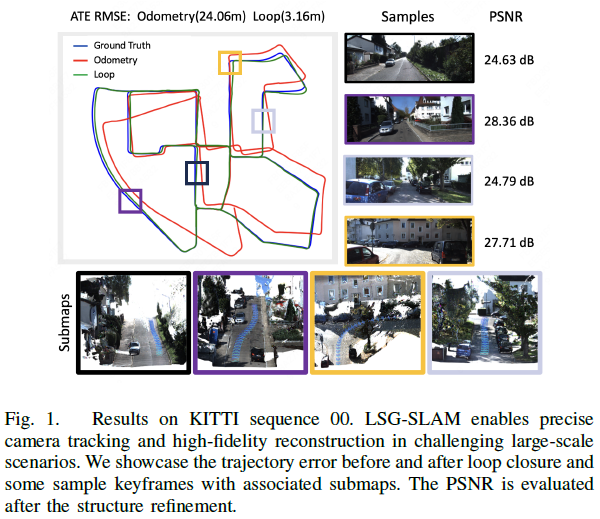

三維高斯潑濺大規模視覺SLAM系統解析

薄型、多頻段、大規模物聯網前端模塊 skyworksinc

愛芯通元NPU適配Qwen2.5-VL-3B視覺多模態大模型

DD10-36S24E3C2 DD10-36S24E3C2

DD6-05S24E3C2 DD6-05S24E3C2

FK6-36S24E2C3 FK6-36S24E2C3

?多模態交互技術解析

商湯日日新多模態大模型權威評測第一

用于SLAM中點云地圖綜合評估的開源框架

利用VLM和MLLMs實現SLAM語義增強

超聲界“內卷終結者”!ZRT智銳通提供全新引擎打造多模態影像融合系統

利用OpenVINO部署Qwen2多模態模型

云知聲山海多模態大模型UniGPT-mMed登頂MMMU測評榜首

S3E:用于協作SLAM的大規模多模態數據集

S3E:用于協作SLAM的大規模多模態數據集

評論