來自美國(guó)阿貢國(guó)家實(shí)驗(yàn)室、NVIDIA、芝加哥大學(xué)等組織機(jī)構(gòu)的研究員開發(fā)了一個(gè)處理基因組規(guī)模數(shù)據(jù)的先進(jìn)模型,并入圍戈登貝爾 COVID-19 研究特別獎(jiǎng)決賽

這一戈登貝爾特別獎(jiǎng)旨在表彰基于高性能計(jì)算的 COVID-19 研究。一位決賽入圍選手教會(huì)了大型語言模型(LLMs)一種新的語言——基因序列,使這些模型能夠提供基因組學(xué)、流行病學(xué)和蛋白質(zhì)工程方面的洞察。

這項(xiàng)開創(chuàng)性的成果發(fā)表于 10 月,是由來自美國(guó)阿貢國(guó)家實(shí)驗(yàn)室、NVIDIA、芝加哥大學(xué)等組織機(jī)構(gòu)的二十多名學(xué)術(shù)和商業(yè)研究員合作完成。

該研究團(tuán)隊(duì)訓(xùn)練了一個(gè) LLM 來追蹤基因突變,并預(yù)測(cè)需要關(guān)注的 SARS-CoV-2(導(dǎo)致 COVID-19 的病毒)變異株。雖然迄今為止大多數(shù)應(yīng)用于生物學(xué)的 LLM 都是在小分子或蛋白質(zhì)的數(shù)據(jù)集上訓(xùn)練的,但這一項(xiàng)目是在原始核苷酸序列(DNA 和 RNA 的最小單位)上訓(xùn)練的首批模型之一。

負(fù)責(zé)帶領(lǐng)該項(xiàng)目的阿貢國(guó)家實(shí)驗(yàn)室計(jì)算生物學(xué)家 Arvind Ramanathan 表示:“我們假設(shè)從蛋白質(zhì)水平到基因水平的數(shù)據(jù)有助于我們構(gòu)建出更易于理解新冠病毒變異株的模型。通過訓(xùn)練模型去追蹤整個(gè)基因組及其進(jìn)化過程中的所有變化,我們不僅能夠更好地預(yù)測(cè) COVID,還能預(yù)測(cè)已掌握足夠基因組數(shù)據(jù)的任何疾病。”

戈登貝爾獎(jiǎng)被譽(yù)為 HPC 領(lǐng)域的諾貝爾獎(jiǎng)。今年的戈登貝爾獎(jiǎng)將在本周的 SC22 上由美國(guó)計(jì)算機(jī)協(xié)會(huì)頒發(fā)。該協(xié)會(huì)代表著全球約 10 萬名計(jì)算領(lǐng)域的專家,自2020年開始向使用 HPC 推進(jìn) COVID-19 研究的杰出研究員頒發(fā)特別獎(jiǎng)。

在一種只有四個(gè)字母的語言上

訓(xùn)練大型語言模型

長(zhǎng)期以來,LLM 一直在接受人類語言的訓(xùn)練,這些語言通常由幾十個(gè)字母組成,可以排列組合成數(shù)萬個(gè)單詞,并連接成長(zhǎng)句和段落。而生物學(xué)語言只有四個(gè)代表核苷酸的字母,即 DNA 中的 A、T、G 和 C,或 RNA 中的 A、U、G 和 C。這些字母按不同順序排列成基因。

雖然較少的字母看似會(huì)降低 AI 學(xué)習(xí)的難度,但實(shí)際上生物學(xué)語言模型要復(fù)雜得多。這是因?yàn)槿祟惖幕蚪M由超過 30 億個(gè)核苷酸組成,而冠狀病毒的基因組由大約 3 萬個(gè)核苷酸組成,因此很難將基因組分解成不同、有意義的單位。

Ramanathan 表示:“在理解基因組這一‘生命代碼’的過程中,我們所面對(duì)的一個(gè)主要挑戰(zhàn)是基因組中的龐大測(cè)序信息。核苷酸序列的意義可能會(huì)受另一序列的影響,以人類的文本做類比,這種影響的范圍不僅僅是文本中的下一句話或下一段話,而是相當(dāng)于一本書中的整個(gè)章節(jié)。”

參與該項(xiàng)目協(xié)作的 NVIDIA 研究員設(shè)計(jì)了一種分層擴(kuò)散方法,使 LLM 能夠?qū)⒓s 1500 個(gè)核苷酸的長(zhǎng)字符串當(dāng)作句子來處理。

論文共同作者、NVIDIA AI 研究高級(jí)總監(jiān)、加州理工學(xué)院計(jì)算+數(shù)學(xué)科學(xué)系布倫講席教授 Anima Anandkumar 表示:“標(biāo)準(zhǔn)語言模型難以生成連貫的長(zhǎng)序列,也難以學(xué)習(xí)不同變異株的基本分布。我們開發(fā)了一個(gè)在更高細(xì)節(jié)水平上運(yùn)作的擴(kuò)散模型,該模型使我們能夠生成現(xiàn)實(shí)中的變異株,并采集到更完善的統(tǒng)計(jì)數(shù)據(jù)。”

預(yù)測(cè)需要關(guān)注的新冠病毒變異株

該團(tuán)隊(duì)首先使用細(xì)菌和病毒生物信息學(xué)資源中心的開源數(shù)據(jù),對(duì)來自原核生物(像細(xì)菌一樣的單細(xì)胞生物)超過 1.1 億個(gè)基因序列進(jìn)行了 LLM 預(yù)訓(xùn)練,然后使用 150 萬個(gè)高質(zhì)量的新冠病毒基因組序列,對(duì)該模型進(jìn)行微調(diào)。

研究員還通過在更廣泛的數(shù)據(jù)集上進(jìn)行預(yù)訓(xùn)練,確保其模型能夠在未來的項(xiàng)目中推廣到其他預(yù)測(cè)任務(wù),使其成為首批具備此能力的全基因組規(guī)模的模型之一。

在對(duì) COVID 數(shù)據(jù)進(jìn)行了微調(diào)后,LLM 就能夠區(qū)分病毒變異株的基因組序列。它還能夠生成自己的核苷酸序列,預(yù)測(cè) COVID 基因組的潛在突變,這可以幫助科學(xué)家預(yù)測(cè)未來需要關(guān)注的變異株。

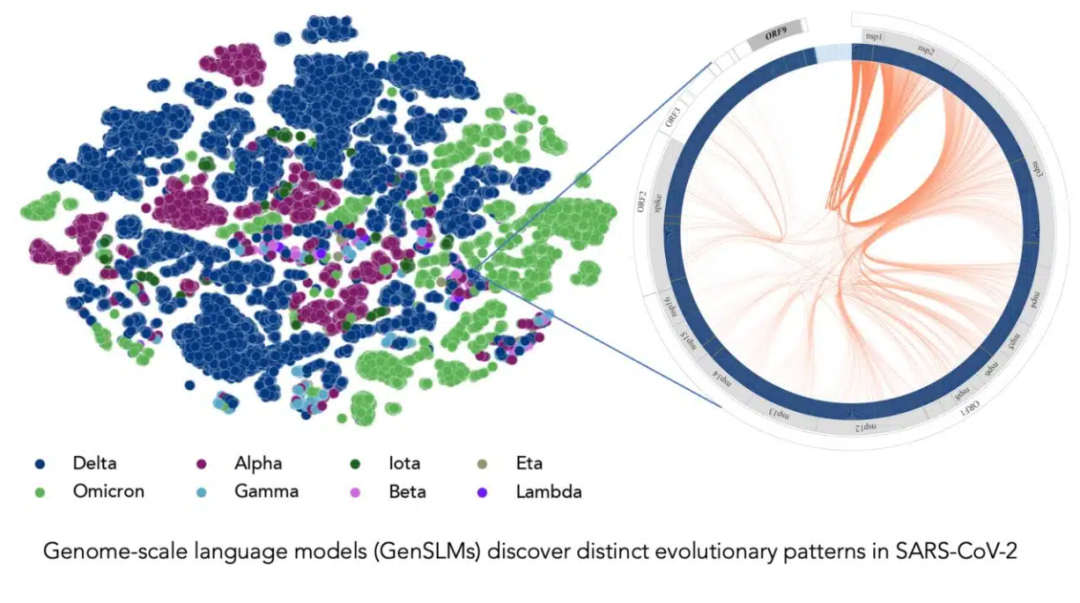

在長(zhǎng)達(dá)一年時(shí)間內(nèi)積累的 SARS-CoV-2 基因組數(shù)據(jù)的訓(xùn)練下,該模型可以推斷出各種病毒株之間的區(qū)別。左邊的每個(gè)點(diǎn)對(duì)應(yīng)一個(gè)已測(cè)序的 SARS-CoV-2 病毒株,并按變異株顏色編碼。右圖放大了該病毒的一個(gè)特定毒株,它捕捉到了該毒株特有的病毒蛋白進(jìn)化耦合關(guān)系。圖片由美國(guó)阿貢國(guó)家實(shí)驗(yàn)室的 Bharat Kale、Max Zvyagin 和 Michael E. Papka 提供。

Ramanathan 表示:“大多數(shù)研究員一直在追蹤新冠病毒突刺蛋白的突變,尤其是與人類細(xì)胞結(jié)合的域。但病毒基因組中還有其他蛋白質(zhì)也會(huì)經(jīng)歷頻繁的突變,所以了解這些蛋白質(zhì)十分重要。”

論文中提到,該模型還可以與 AlphaFold、OpenFold 等常見的蛋白質(zhì)結(jié)構(gòu)預(yù)測(cè)模型整合,幫助研究員模擬病毒結(jié)構(gòu),研究基因突變?nèi)绾斡绊懖《靖腥酒渌拗鞯哪芰ΑpenFold 是 NVIDIA BioNeMo LLM 服務(wù)中包含的預(yù)訓(xùn)練語言模型之一。NVIDIA BioNeMo LLM 服務(wù)面向的是致力于將 LLM 應(yīng)用于數(shù)字生物學(xué)和化學(xué)應(yīng)用的開發(fā)者。

利用 GPU 加速超級(jí)計(jì)算機(jī)

大幅加快 AI 訓(xùn)練速度

該團(tuán)隊(duì)在由 NVIDIA A100 Tensor Core GPU 驅(qū)動(dòng)的超級(jí)計(jì)算機(jī)上開發(fā) AI 模型,包括阿貢國(guó)家實(shí)驗(yàn)室的 Polaris、美國(guó)能源部的 Perlmutter 以及 NVIDIA 的 Selene 系統(tǒng)。通過擴(kuò)展到這些強(qiáng)大的系統(tǒng),他們?cè)谟?xùn)練中實(shí)現(xiàn)了超過 1500 exaflops 的性能,創(chuàng)建了迄今為止最大的生物語言模型。

Ramanathan 表示:“我們?nèi)缃裉幚淼哪P陀卸噙_(dá) 250 億個(gè)參數(shù),預(yù)計(jì)這一數(shù)量未來還會(huì)大幅增加。模型的尺寸、基因序列的長(zhǎng)度、以及所需的訓(xùn)練數(shù)據(jù)量,都意味著我們的確需要搭載數(shù)千顆 GPU 的超級(jí)計(jì)算機(jī)來完成復(fù)雜的計(jì)算。”

研究員估計(jì),訓(xùn)練一個(gè)具有 25 億參數(shù)的模型版本,需要約 4000 個(gè) GPU 耗時(shí)一個(gè)多月。該團(tuán)隊(duì)已經(jīng)在研究用于生物學(xué)的 LLM,在公布論文和代碼之前,他們?cè)谶@個(gè)項(xiàng)目上已耗時(shí)約四個(gè)月。GitHub 頁面上有供其他研究員在 Polaris 和 Perlmutter 上運(yùn)行該模型的說明。

NVIDIA BioNeMo 框架可在 NVIDIA NGC 中心上的 GPU 優(yōu)化軟件中搶先體驗(yàn)。該框架將幫助研究員在多個(gè) GPU 上擴(kuò)展大型生物分子語言模型。作為 NVIDIA Clara Discovery 藥物研發(fā)工具集的一部分,該框架將支持化學(xué)、蛋白質(zhì)、DNA 和 RNA 數(shù)據(jù)格式。

即刻點(diǎn)擊“閱讀原文”或掃描下方海報(bào)二維碼,收下這份 GTC22 精選演講合集清單,在NVIDIA on-Demand 上點(diǎn)播觀看主題演講精選、中國(guó)精選、元宇宙應(yīng)用領(lǐng)域與全球各行業(yè)及領(lǐng)域的最新成果!

原文標(biāo)題:SC22 | 解析基因組的“語言”:戈登貝爾獎(jiǎng)決賽選手使用大型語言模型來預(yù)測(cè)新冠病毒變異株

文章出處:【微信公眾號(hào):NVIDIA英偉達(dá)企業(yè)解決方案】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

英偉達(dá)

+關(guān)注

關(guān)注

22文章

3944瀏覽量

93623

原文標(biāo)題:SC22 | 解析基因組的“語言”:戈登貝爾獎(jiǎng)決賽選手使用大型語言模型來預(yù)測(cè)新冠病毒變異株

文章出處:【微信號(hào):NVIDIA-Enterprise,微信公眾號(hào):NVIDIA英偉達(dá)企業(yè)解決方案】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

中科曙光構(gòu)建全國(guó)產(chǎn)化基因組學(xué)高性能計(jì)算平臺(tái)

小白學(xué)大模型:從零實(shí)現(xiàn) LLM語言模型

?VLM(視覺語言模型)?詳細(xì)解析

無法在OVMS上運(yùn)行來自Meta的大型語言模型 (LLM),為什么?

小白學(xué)大模型:訓(xùn)練大語言模型的深度指南

大語言模型的解碼策略與關(guān)鍵優(yōu)化總結(jié)

大語言模型開發(fā)框架是什么

大語言模型開發(fā)語言是什么

大語言模型如何開發(fā)

如何利用大型語言模型驅(qū)動(dòng)的搜索為公司創(chuàng)造價(jià)值

【《大語言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)知識(shí)學(xué)習(xí)

【《大語言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)篇

DeepL推出新一代翻譯編輯大型語言模型

基于CPU的大型語言模型推理實(shí)驗(yàn)

SC22 | 解析基因組的“語言”:戈登貝爾獎(jiǎng)決賽選手使用大型語言模型來預(yù)測(cè)新冠病毒變異株

SC22 | 解析基因組的“語言”:戈登貝爾獎(jiǎng)決賽選手使用大型語言模型來預(yù)測(cè)新冠病毒變異株

評(píng)論