現(xiàn)在,我們知道立體匹配在實(shí)際應(yīng)用中會(huì)有各種各樣困難的問題需要解決,例如之前提到過的光照、噪聲、鏡面反射、遮擋、重復(fù)紋理、視差不連續(xù)等等導(dǎo)致的匹配錯(cuò)誤或缺失。于是人們就創(chuàng)造了各種各樣的算法來解決這些問題。我們不禁要問一個(gè)問題:我們?nèi)绾喂降谋容^這些算法的優(yōu)劣呢?這就是我在這篇文章中想要闡述的內(nèi)容。讓我們先從評(píng)價(jià)方法的直覺理解開始,然后進(jìn)入到科學(xué)的部分。

一. 視差結(jié)果的評(píng)價(jià)方法

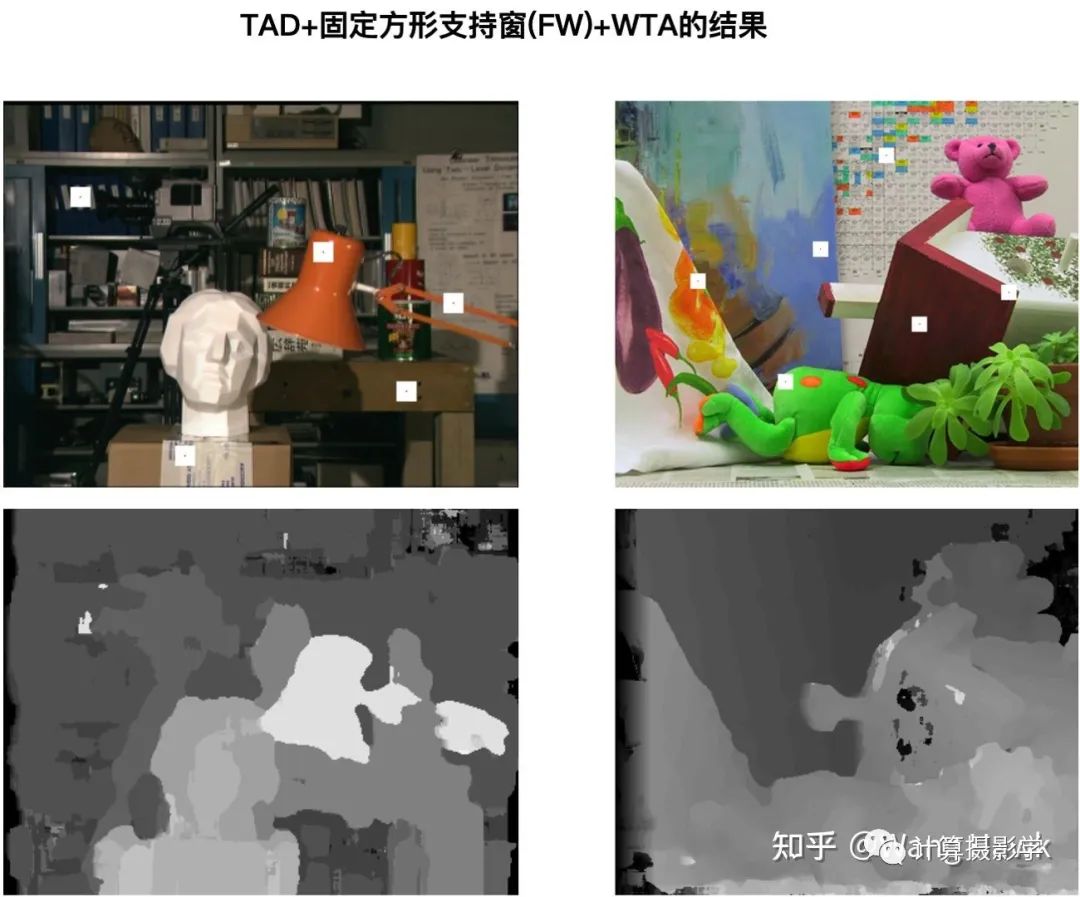

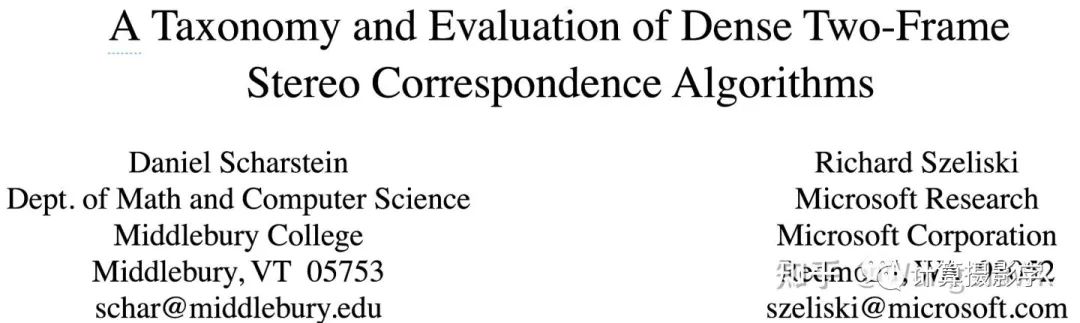

立體匹配里面提到的最基礎(chǔ)的固定窗口法的匹配結(jié)果: 我們可以明顯的看到這個(gè)視差圖中有一些錯(cuò)誤,比如臺(tái)燈支架斷裂了,視差圖上部分區(qū)域是黑色的,還有背景出現(xiàn)不正常的亮區(qū),同時(shí)物體的邊界和原圖的邊界似乎無法對應(yīng)上(比如臺(tái)燈燈罩等)。但如何量化的說明錯(cuò)誤的量呢?如果能夠?qū)㈠e(cuò)誤量化,似乎就可以公平的比較各個(gè)算法了。我想你也已經(jīng)想到,要想量化錯(cuò)誤,就需要有標(biāo)準(zhǔn)的視差圖作為參考,只需要比較算法的結(jié)果和標(biāo)準(zhǔn)視差圖,并計(jì)算不一樣的像素的比例,就可以進(jìn)行評(píng)價(jià)了。這個(gè)領(lǐng)域的先驅(qū)們也正是這樣做的,其中奠基性的成果就是MiddleBurry大學(xué)的Daniel Scharstein和微軟的Richard Szeliski在2002年發(fā)表的下面這篇文章:

我們可以明顯的看到這個(gè)視差圖中有一些錯(cuò)誤,比如臺(tái)燈支架斷裂了,視差圖上部分區(qū)域是黑色的,還有背景出現(xiàn)不正常的亮區(qū),同時(shí)物體的邊界和原圖的邊界似乎無法對應(yīng)上(比如臺(tái)燈燈罩等)。但如何量化的說明錯(cuò)誤的量呢?如果能夠?qū)㈠e(cuò)誤量化,似乎就可以公平的比較各個(gè)算法了。我想你也已經(jīng)想到,要想量化錯(cuò)誤,就需要有標(biāo)準(zhǔn)的視差圖作為參考,只需要比較算法的結(jié)果和標(biāo)準(zhǔn)視差圖,并計(jì)算不一樣的像素的比例,就可以進(jìn)行評(píng)價(jià)了。這個(gè)領(lǐng)域的先驅(qū)們也正是這樣做的,其中奠基性的成果就是MiddleBurry大學(xué)的Daniel Scharstein和微軟的Richard Szeliski在2002年發(fā)表的下面這篇文章: 作者們提出的第一種評(píng)價(jià)方案是構(gòu)造具有理想視差圖的參考圖像集,并利用下面兩大指標(biāo)來評(píng)價(jià)各種立體匹配算法的優(yōu)劣:

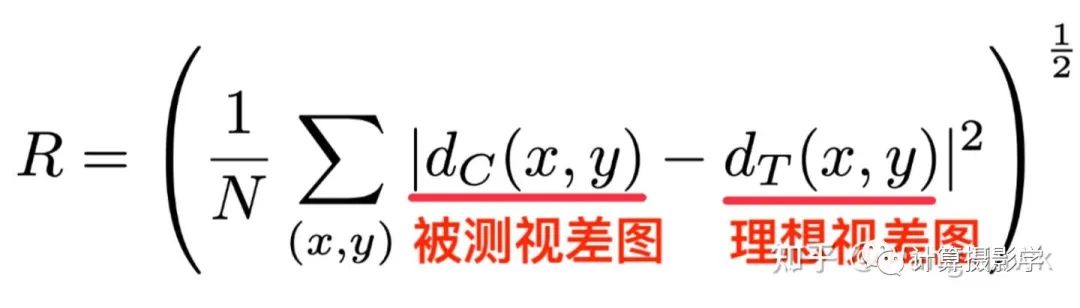

作者們提出的第一種評(píng)價(jià)方案是構(gòu)造具有理想視差圖的參考圖像集,并利用下面兩大指標(biāo)來評(píng)價(jià)各種立體匹配算法的優(yōu)劣:- 均方根誤差(RMS Error),這里N是像素總數(shù)

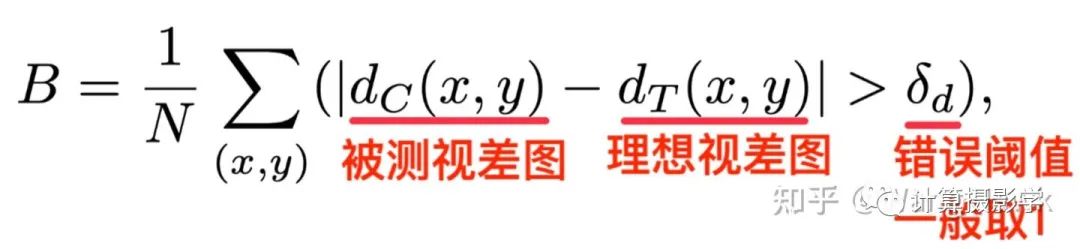

2.錯(cuò)誤匹配像素比例

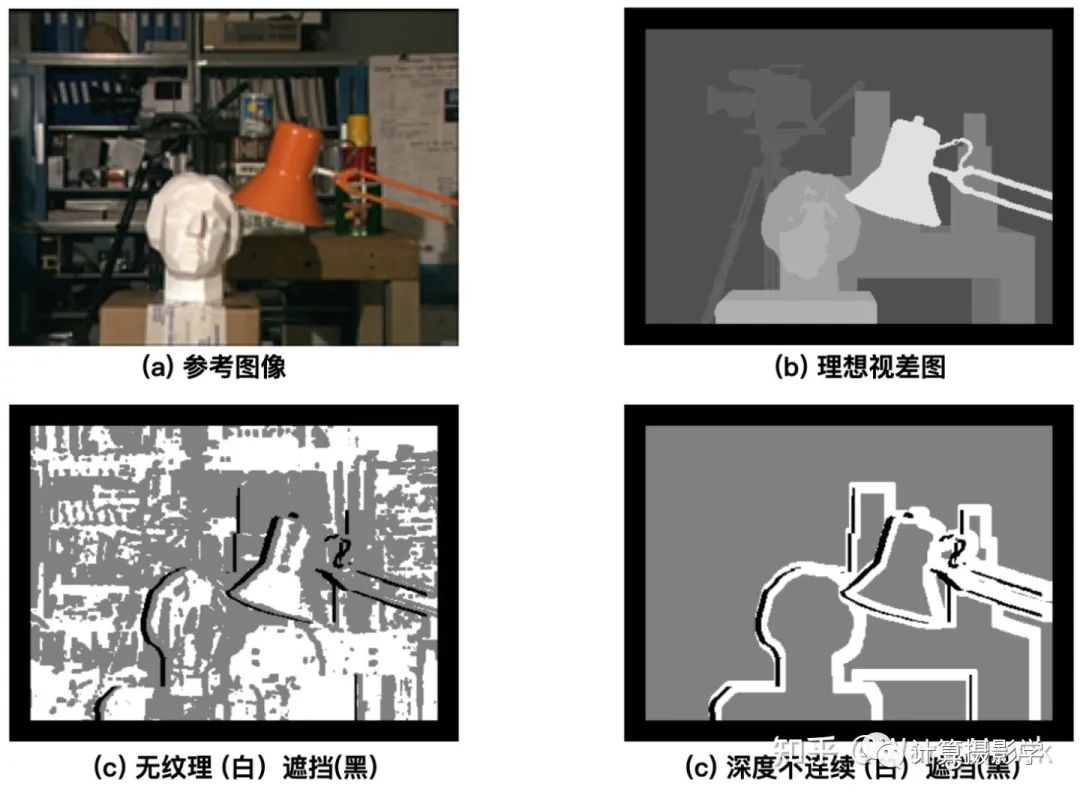

2.錯(cuò)誤匹配像素比例 除了在整體圖像上計(jì)算上述兩個(gè)指標(biāo),他們還將參考圖像和視差圖進(jìn)行預(yù)先分割,從而得到三個(gè)特殊的區(qū)域,在這些區(qū)域上利用上述指標(biāo)進(jìn)行更細(xì)節(jié)的比較。1. 無紋理區(qū)域:這是在原始參考圖像上計(jì)算每個(gè)像素固定大小鄰域窗口內(nèi)的水平梯度平均值。如果這個(gè)值的平方低于某個(gè)閾值,就認(rèn)為它是無紋理區(qū)域。2. 遮擋區(qū)域:這個(gè)容易理解,在73. 三維重建8-立體匹配4中我介紹了如何獲取到遮擋區(qū)域,一般可以利用左右一致性檢測得到。只不過這里記住是利用參考圖像和理想視差值進(jìn)行計(jì)算得到遮擋區(qū)域的。3. 深度不連續(xù)區(qū)域:如果某像素的鄰域內(nèi)像素的視差值差異大于了某個(gè)閾值,那么這個(gè)像素就位于深度不連續(xù)區(qū)域內(nèi)。下面是示意圖:

除了在整體圖像上計(jì)算上述兩個(gè)指標(biāo),他們還將參考圖像和視差圖進(jìn)行預(yù)先分割,從而得到三個(gè)特殊的區(qū)域,在這些區(qū)域上利用上述指標(biāo)進(jìn)行更細(xì)節(jié)的比較。1. 無紋理區(qū)域:這是在原始參考圖像上計(jì)算每個(gè)像素固定大小鄰域窗口內(nèi)的水平梯度平均值。如果這個(gè)值的平方低于某個(gè)閾值,就認(rèn)為它是無紋理區(qū)域。2. 遮擋區(qū)域:這個(gè)容易理解,在73. 三維重建8-立體匹配4中我介紹了如何獲取到遮擋區(qū)域,一般可以利用左右一致性檢測得到。只不過這里記住是利用參考圖像和理想視差值進(jìn)行計(jì)算得到遮擋區(qū)域的。3. 深度不連續(xù)區(qū)域:如果某像素的鄰域內(nèi)像素的視差值差異大于了某個(gè)閾值,那么這個(gè)像素就位于深度不連續(xù)區(qū)域內(nèi)。下面是示意圖: 于是作者就會(huì)在上面三個(gè)區(qū)域,以及無紋理區(qū)域和遮擋區(qū)域的補(bǔ)集,計(jì)算均方根誤差及錯(cuò)誤像素比例這兩個(gè)指標(biāo)。作者還指出了評(píng)價(jià)算法優(yōu)劣的第二種方案:如果我們有多個(gè)視角的原始圖像,那么可以通過把原始圖像通過視差圖進(jìn)行變換到其它的視角,并和其他視角已知的圖像做對比,來量化所謂的預(yù)測誤差.這也是一種評(píng)價(jià)算法優(yōu)劣的方式,理論上算法計(jì)算出的視差圖越精準(zhǔn),預(yù)測誤差越小。比如下面這組圖,其中中間是原始參考圖像,通過和目標(biāo)圖像一起做立體匹配,可以得到1個(gè)視差圖。通過此視差圖,我們能將參考圖像中的點(diǎn)投影到三維空間,然后再投影到不同的視角下。這里左起第1/2/4/5幅圖,就是投影的結(jié)果,其中第4幅對應(yīng)原目標(biāo)圖像所在的視角。如果原本在這幾個(gè)視角有實(shí)拍的圖像,就可以和投影的結(jié)果作對比,對比的結(jié)果可以用于計(jì)算預(yù)測誤差。這種方式被作者稱為前向變換,圖中粉色的像素是在投影后沒有信息來填充的像素——這是因?yàn)椴煌暯堑恼趽跫耙暡顖D中的錯(cuò)誤導(dǎo)致的。

于是作者就會(huì)在上面三個(gè)區(qū)域,以及無紋理區(qū)域和遮擋區(qū)域的補(bǔ)集,計(jì)算均方根誤差及錯(cuò)誤像素比例這兩個(gè)指標(biāo)。作者還指出了評(píng)價(jià)算法優(yōu)劣的第二種方案:如果我們有多個(gè)視角的原始圖像,那么可以通過把原始圖像通過視差圖進(jìn)行變換到其它的視角,并和其他視角已知的圖像做對比,來量化所謂的預(yù)測誤差.這也是一種評(píng)價(jià)算法優(yōu)劣的方式,理論上算法計(jì)算出的視差圖越精準(zhǔn),預(yù)測誤差越小。比如下面這組圖,其中中間是原始參考圖像,通過和目標(biāo)圖像一起做立體匹配,可以得到1個(gè)視差圖。通過此視差圖,我們能將參考圖像中的點(diǎn)投影到三維空間,然后再投影到不同的視角下。這里左起第1/2/4/5幅圖,就是投影的結(jié)果,其中第4幅對應(yīng)原目標(biāo)圖像所在的視角。如果原本在這幾個(gè)視角有實(shí)拍的圖像,就可以和投影的結(jié)果作對比,對比的結(jié)果可以用于計(jì)算預(yù)測誤差。這種方式被作者稱為前向變換,圖中粉色的像素是在投影后沒有信息來填充的像素——這是因?yàn)椴煌暯堑恼趽跫耙暡顖D中的錯(cuò)誤導(dǎo)致的。 另外一種投影方式被作者稱為反向變換。比如下面這組圖,中間是原始參考圖像。而其他的圖像,是在各個(gè)視角拍攝的圖像通過三維重投影變換到參考圖像所在視角后的結(jié)果。這里面粉色像素代表因?yàn)檎趽鯇?dǎo)致的無法填充的結(jié)果。

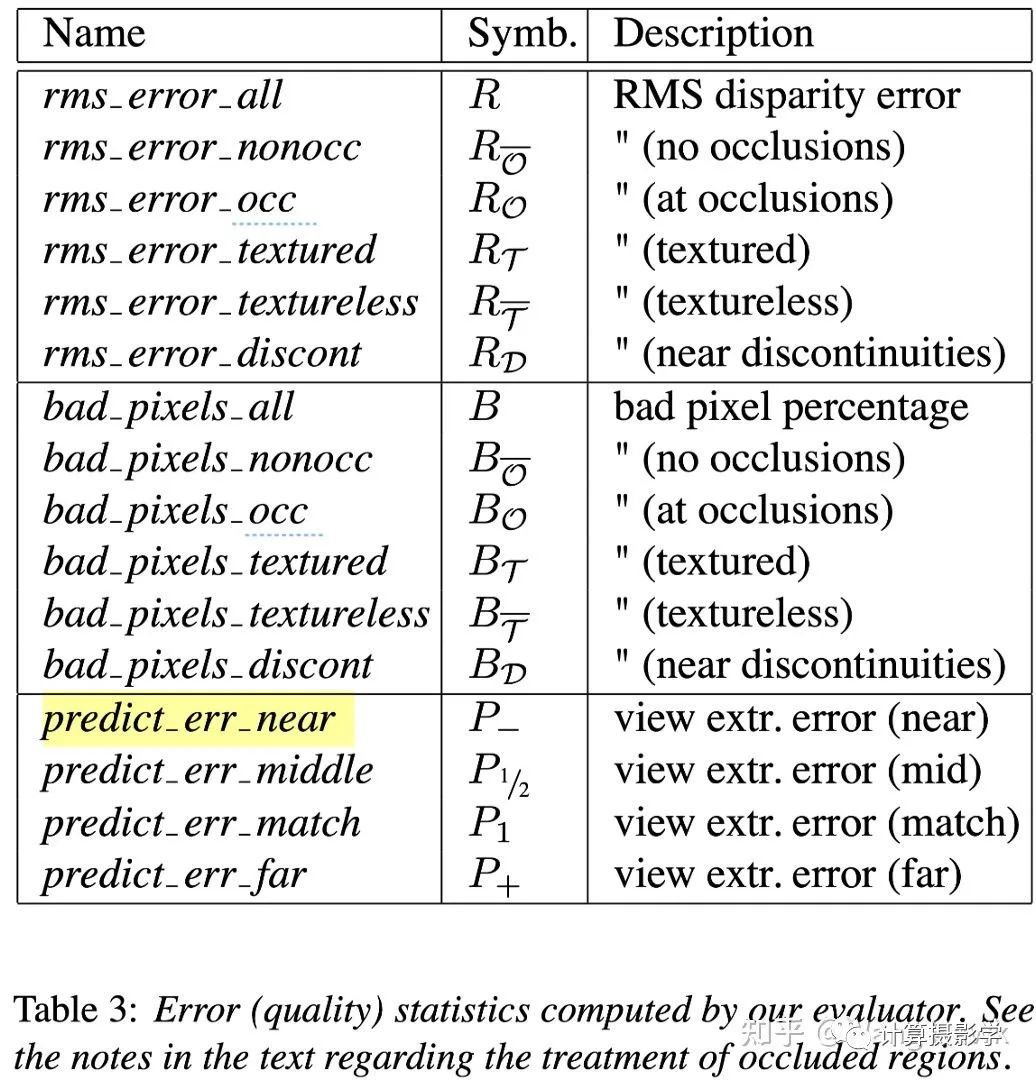

另外一種投影方式被作者稱為反向變換。比如下面這組圖,中間是原始參考圖像。而其他的圖像,是在各個(gè)視角拍攝的圖像通過三維重投影變換到參考圖像所在視角后的結(jié)果。這里面粉色像素代表因?yàn)檎趽鯇?dǎo)致的無法填充的結(jié)果。 根據(jù)作者描述,反向變換帶來的渲染問題更少,更加適合作為計(jì)算預(yù)測誤差所需。所以后面的指標(biāo)都采用了反向變換。我們總結(jié)下作者給出的各種評(píng)價(jià)指標(biāo)吧:1. 在全圖上計(jì)算視差圖和理想視差圖之間的均方根誤差,及錯(cuò)誤像素占比2. 在無紋理區(qū)域,有紋理區(qū)域,遮擋區(qū)域,非遮擋區(qū)域,深度不連續(xù)區(qū)域共5個(gè)區(qū)域計(jì)算和理想視差圖之間的均方根誤差,及錯(cuò)誤像素占比3. 在不同視角下進(jìn)行反向變換,計(jì)算變換后的投影誤差,即所謂預(yù)測誤差于是在論文中就有了一張很復(fù)雜的表格,主要就在說明我剛提到的幾種指標(biāo)。

根據(jù)作者描述,反向變換帶來的渲染問題更少,更加適合作為計(jì)算預(yù)測誤差所需。所以后面的指標(biāo)都采用了反向變換。我們總結(jié)下作者給出的各種評(píng)價(jià)指標(biāo)吧:1. 在全圖上計(jì)算視差圖和理想視差圖之間的均方根誤差,及錯(cuò)誤像素占比2. 在無紋理區(qū)域,有紋理區(qū)域,遮擋區(qū)域,非遮擋區(qū)域,深度不連續(xù)區(qū)域共5個(gè)區(qū)域計(jì)算和理想視差圖之間的均方根誤差,及錯(cuò)誤像素占比3. 在不同視角下進(jìn)行反向變換,計(jì)算變換后的投影誤差,即所謂預(yù)測誤差于是在論文中就有了一張很復(fù)雜的表格,主要就在說明我剛提到的幾種指標(biāo)。 各種視差精度評(píng)價(jià)指標(biāo)我們很明顯能看到,為了計(jì)算上述的指標(biāo),我們的測試數(shù)據(jù)集中需要包含下面兩類信息中至少一種:1. 輸入的兩視角原始圖像,及對應(yīng)的理想視差圖2. 輸入的多視角圖像那么,作者是如何構(gòu)造這樣的測試圖集呢?

各種視差精度評(píng)價(jià)指標(biāo)我們很明顯能看到,為了計(jì)算上述的指標(biāo),我們的測試數(shù)據(jù)集中需要包含下面兩類信息中至少一種:1. 輸入的兩視角原始圖像,及對應(yīng)的理想視差圖2. 輸入的多視角圖像那么,作者是如何構(gòu)造這樣的測試圖集呢?二. 最早期的測試圖集(2001年及以前)

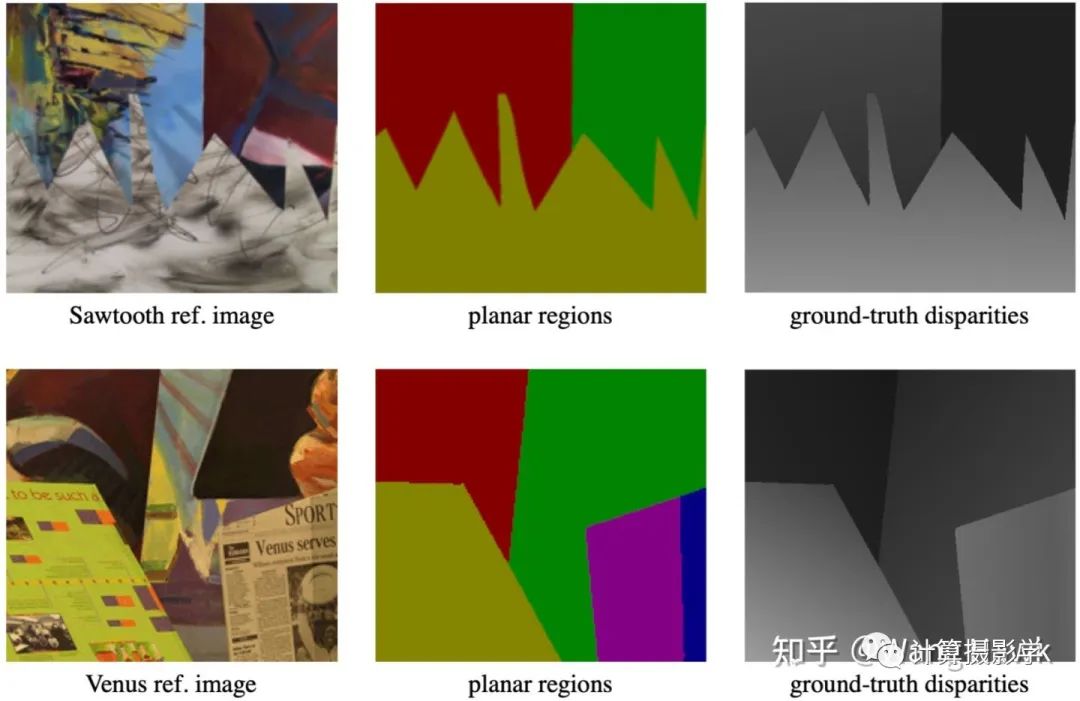

在第1節(jié)提到的論文中,作者說明了測試數(shù)據(jù)集的構(gòu)成,這些數(shù)據(jù)集就是MiddleBurry立體匹配數(shù)據(jù)集網(wǎng)站上的2001版數(shù)據(jù)集。第一類:平面場景數(shù)據(jù)集在vision.middlebury.edu/s上,你可以看到作者制作的6組平面場景數(shù)據(jù)。 每一組數(shù)據(jù)由9張彩色圖像,和2張理想視差圖構(gòu)成。作者通過將相機(jī)擺放在水平導(dǎo)軌上,然后通過移動(dòng)相機(jī)拍攝了這9幅彩色圖像,并進(jìn)行了仔細(xì)的立體校正。而視差圖則是由第3張和第7張圖像進(jìn)行立體匹配,并分別作為參考圖像得到的。這些圖像的尺寸比較小,例如Sawtooth的視差圖尺寸是434x380像素。我們來看看其中兩組圖像:Sawtooth及Venus。這里第1列是參考圖像,其中作者擺放的都是平面的海報(bào)、繪畫等,而第2列是對參考圖像做手動(dòng)標(biāo)記分割為幾個(gè)部分的結(jié)果,屬于同一個(gè)平面的像素被標(biāo)為同樣的顏色。第3列就是理想視差圖。由于現(xiàn)在場景里面都是平面的物體,因此可以通過特征點(diǎn)匹配的方式計(jì)算穩(wěn)定的匹配點(diǎn)對,再利用平面擬合技術(shù),很準(zhǔn)確的計(jì)算出每個(gè)像素的視差。

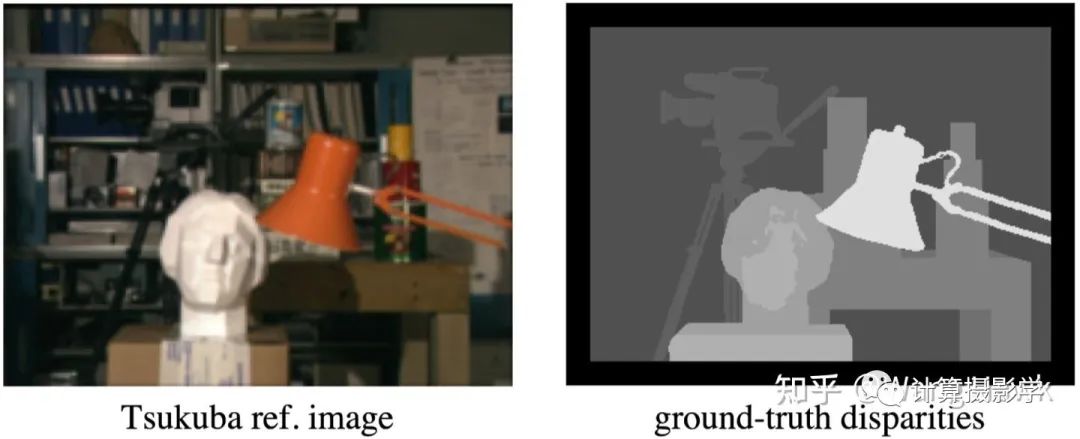

每一組數(shù)據(jù)由9張彩色圖像,和2張理想視差圖構(gòu)成。作者通過將相機(jī)擺放在水平導(dǎo)軌上,然后通過移動(dòng)相機(jī)拍攝了這9幅彩色圖像,并進(jìn)行了仔細(xì)的立體校正。而視差圖則是由第3張和第7張圖像進(jìn)行立體匹配,并分別作為參考圖像得到的。這些圖像的尺寸比較小,例如Sawtooth的視差圖尺寸是434x380像素。我們來看看其中兩組圖像:Sawtooth及Venus。這里第1列是參考圖像,其中作者擺放的都是平面的海報(bào)、繪畫等,而第2列是對參考圖像做手動(dòng)標(biāo)記分割為幾個(gè)部分的結(jié)果,屬于同一個(gè)平面的像素被標(biāo)為同樣的顏色。第3列就是理想視差圖。由于現(xiàn)在場景里面都是平面的物體,因此可以通過特征點(diǎn)匹配的方式計(jì)算穩(wěn)定的匹配點(diǎn)對,再利用平面擬合技術(shù),很準(zhǔn)確的計(jì)算出每個(gè)像素的視差。 第二組圖像是從別的數(shù)據(jù)集中獲得的。這里有Tsukuba大學(xué)的著名數(shù)據(jù)"Head and Lamp"。這組數(shù)據(jù)有5x5=25張彩色圖像,在不同視角拍攝。以中間圖像作為參考圖像,人工標(biāo)注了每個(gè)像素的視差,下面展示了其中1張視差圖。

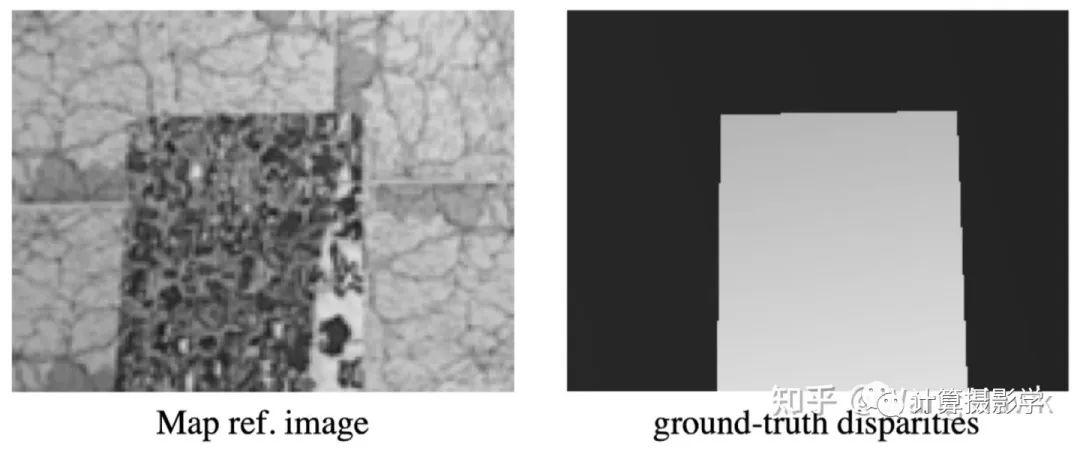

第二組圖像是從別的數(shù)據(jù)集中獲得的。這里有Tsukuba大學(xué)的著名數(shù)據(jù)"Head and Lamp"。這組數(shù)據(jù)有5x5=25張彩色圖像,在不同視角拍攝。以中間圖像作為參考圖像,人工標(biāo)注了每個(gè)像素的視差,下面展示了其中1張視差圖。 另外還有早期由作者之一Szeliski和另外一位先驅(qū)Zabih制作的單色的Map數(shù)據(jù)集,長下面這個(gè)樣子。這也是1個(gè)平面物體構(gòu)成的場景,所以理想視差圖也用上面提到的平面擬合的方式得到。

另外還有早期由作者之一Szeliski和另外一位先驅(qū)Zabih制作的單色的Map數(shù)據(jù)集,長下面這個(gè)樣子。這也是1個(gè)平面物體構(gòu)成的場景,所以理想視差圖也用上面提到的平面擬合的方式得到。 我們看到,早期的這些數(shù)據(jù)集都比較簡單,而且數(shù)量有限。大多數(shù)是平面物體構(gòu)成的場景,像Head and Lamp這樣的數(shù)據(jù),雖然由人工標(biāo)注了視差圖,但最大視差值比較小,難度較低。盡管如此,這對于當(dāng)時(shí)缺乏標(biāo)準(zhǔn)數(shù)據(jù)集的立體匹配研究來說,已經(jīng)是一個(gè)里程碑式的事件了。在第一節(jié)開篇提到的論文中,作者就是利用這樣的數(shù)據(jù)集和評(píng)價(jià)指標(biāo)進(jìn)行了大量客觀的比較,得出了很多重要的結(jié)論。

我們看到,早期的這些數(shù)據(jù)集都比較簡單,而且數(shù)量有限。大多數(shù)是平面物體構(gòu)成的場景,像Head and Lamp這樣的數(shù)據(jù),雖然由人工標(biāo)注了視差圖,但最大視差值比較小,難度較低。盡管如此,這對于當(dāng)時(shí)缺乏標(biāo)準(zhǔn)數(shù)據(jù)集的立體匹配研究來說,已經(jīng)是一個(gè)里程碑式的事件了。在第一節(jié)開篇提到的論文中,作者就是利用這樣的數(shù)據(jù)集和評(píng)價(jià)指標(biāo)進(jìn)行了大量客觀的比較,得出了很多重要的結(jié)論。三. 2003年開始,引入結(jié)構(gòu)光技術(shù)

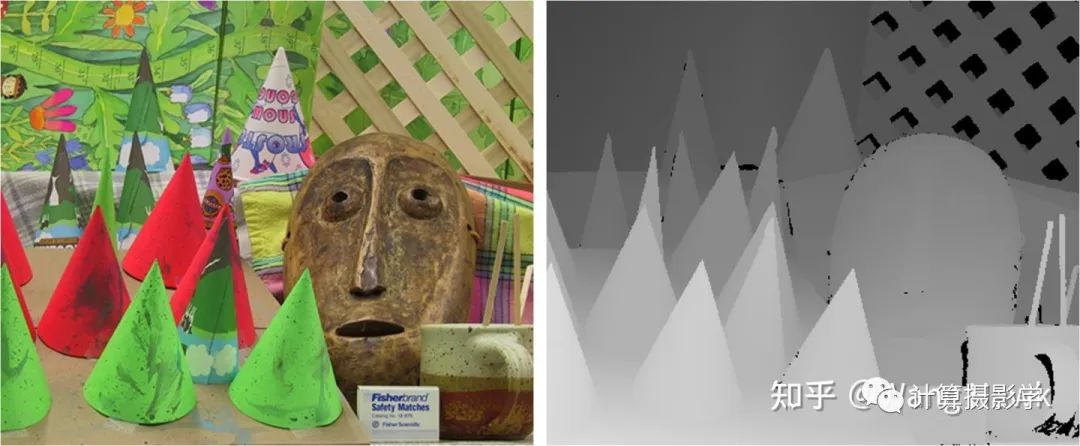

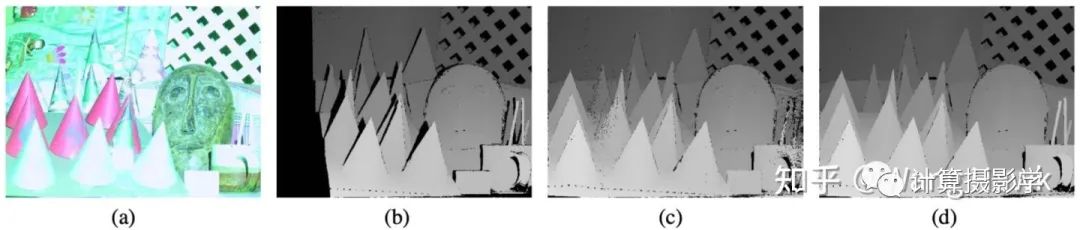

正如上一節(jié)提出的,2001版的數(shù)據(jù)太簡單了,導(dǎo)致后面一些改進(jìn)后的算法很容易就能匹配上前述數(shù)據(jù)集中大多數(shù)像素,按照現(xiàn)在流行的說法:過擬合了。于是,前面兩位作者采用了新的方法制作更接近真實(shí)場景,更加具有挑戰(zhàn)性的數(shù)據(jù)集。這次的數(shù)據(jù)集主要包括下面兩個(gè)更加復(fù)雜的場景:Cones和Teddy, 你可以看到現(xiàn)在不再是平面目標(biāo)構(gòu)成的場景了,而是具有更加復(fù)雜的表面特征,以及陰影和更多深度不連續(xù)的區(qū)域。不僅如此,此次提供的圖像的尺寸也很大,完整尺寸是1800x1500,另外還提供了900x750及450x375兩種版本。同時(shí),還包括了遮擋區(qū)域、無紋理區(qū)域、深度不連續(xù)區(qū)域的掩碼圖像,用于各種指標(biāo)的計(jì)算。Cones: Teddy:

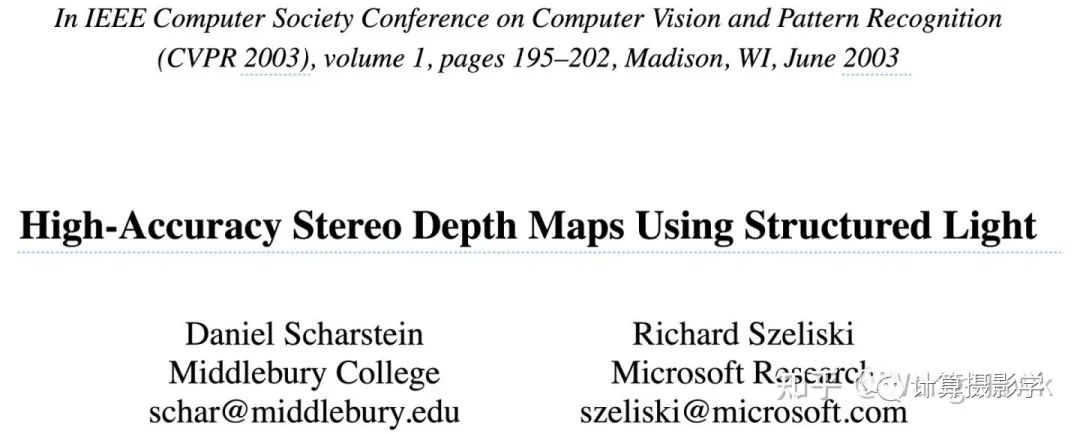

Teddy: 在2003年CVPR中他們發(fā)表了下面這篇文章,闡述了新數(shù)據(jù)集的制作方法:

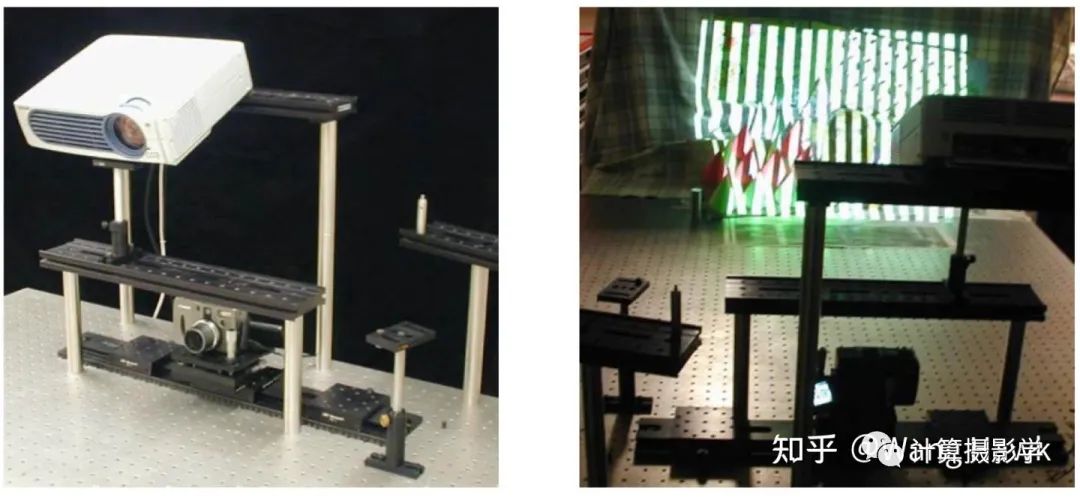

在2003年CVPR中他們發(fā)表了下面這篇文章,闡述了新數(shù)據(jù)集的制作方法: 我們從標(biāo)題就可以看出,這次他們采用了結(jié)構(gòu)光技術(shù)自動(dòng)的計(jì)算出每組圖像的高精度稠密視差圖作為理想?yún)⒖肌O旅媸撬麄兊膶?shí)驗(yàn)設(shè)置。這里采用的相機(jī)是Canon G1,它被安裝在水平導(dǎo)軌上,這樣就可以以固定間隔移動(dòng)拍攝不同視角的圖像,對于同一個(gè)場景作者會(huì)拍攝9個(gè)不同視角的圖像,并用其中第3和第7張來產(chǎn)生理想視差圖。與此同時(shí),有1個(gè)或多個(gè)投影儀照亮場景。

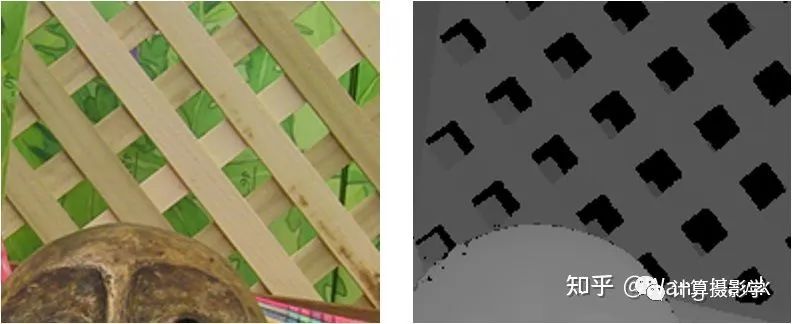

我們從標(biāo)題就可以看出,這次他們采用了結(jié)構(gòu)光技術(shù)自動(dòng)的計(jì)算出每組圖像的高精度稠密視差圖作為理想?yún)⒖肌O旅媸撬麄兊膶?shí)驗(yàn)設(shè)置。這里采用的相機(jī)是Canon G1,它被安裝在水平導(dǎo)軌上,這樣就可以以固定間隔移動(dòng)拍攝不同視角的圖像,對于同一個(gè)場景作者會(huì)拍攝9個(gè)不同視角的圖像,并用其中第3和第7張來產(chǎn)生理想視差圖。與此同時(shí),有1個(gè)或多個(gè)投影儀照亮場景。 比如在拍攝Cones場景時(shí),就用了1個(gè)投影儀從斜上方照亮場景,這樣大部分區(qū)域都可以照亮,除了畫面右上方的格子間有一些陰影,由于陰影前方是平面的柵格,所以這些陰影區(qū)域的視差值能夠通過插值算法恢復(fù)出來。

比如在拍攝Cones場景時(shí),就用了1個(gè)投影儀從斜上方照亮場景,這樣大部分區(qū)域都可以照亮,除了畫面右上方的格子間有一些陰影,由于陰影前方是平面的柵格,所以這些陰影區(qū)域的視差值能夠通過插值算法恢復(fù)出來。 而在拍攝Teddy場景時(shí),則是采用了兩個(gè)投影儀從不同的方向打光照亮場景,盡量減少陰影。不過,由于Teddy場景更加復(fù)雜,即便是用了兩個(gè)方向的照明,依然會(huì)有少量的區(qū)域位于陰影中(沒有任何1個(gè)投影儀能照亮),使得這些區(qū)域的視差不可知。

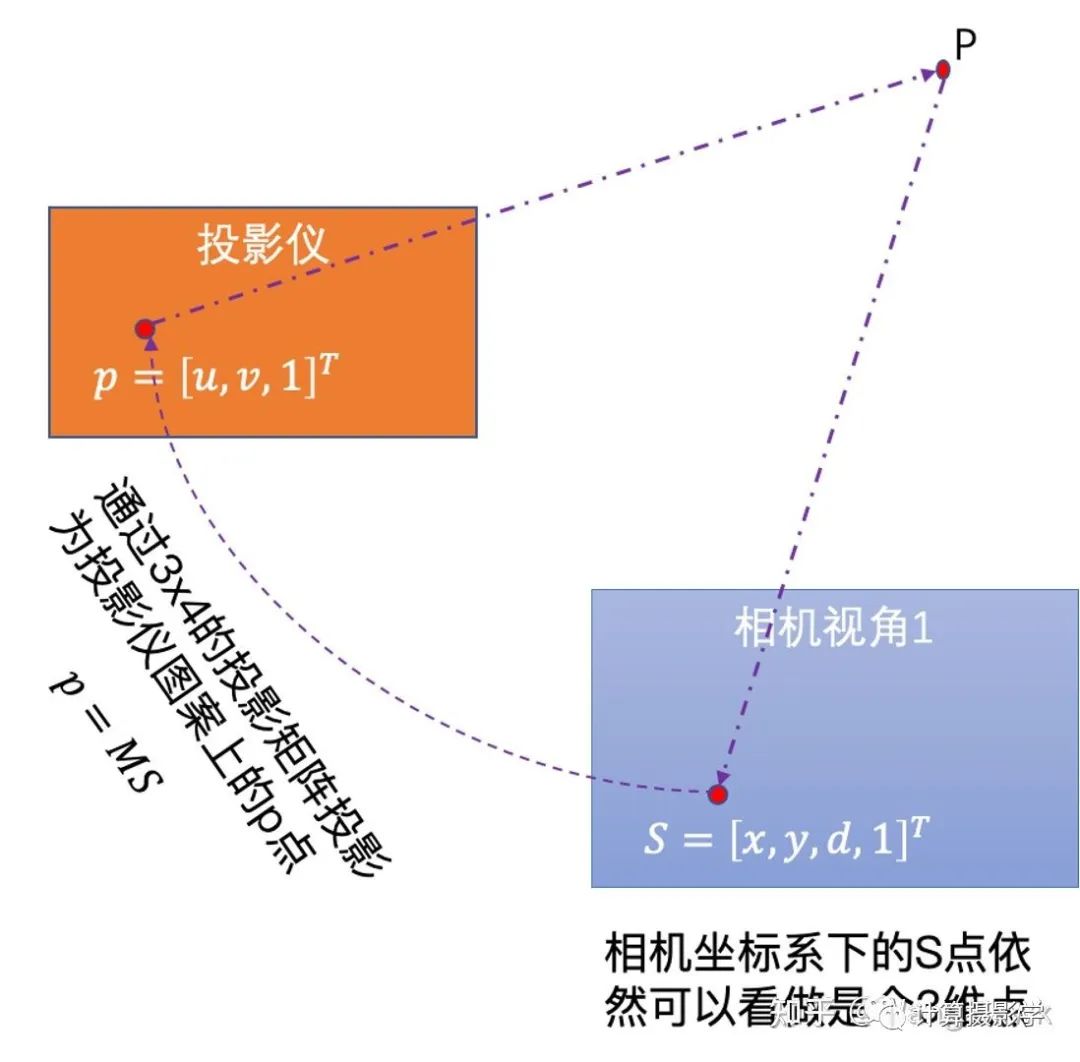

而在拍攝Teddy場景時(shí),則是采用了兩個(gè)投影儀從不同的方向打光照亮場景,盡量減少陰影。不過,由于Teddy場景更加復(fù)雜,即便是用了兩個(gè)方向的照明,依然會(huì)有少量的區(qū)域位于陰影中(沒有任何1個(gè)投影儀能照亮),使得這些區(qū)域的視差不可知。 這里面,投影儀會(huì)按次序發(fā)出N個(gè)結(jié)構(gòu)光圖像照亮場景,相機(jī)則把這一系列圖像拍攝下來。注意看論文中的示意圖。這里用到的是一種叫做格雷碼的圖案(Gray-Code),是一種黑白條紋圖案。

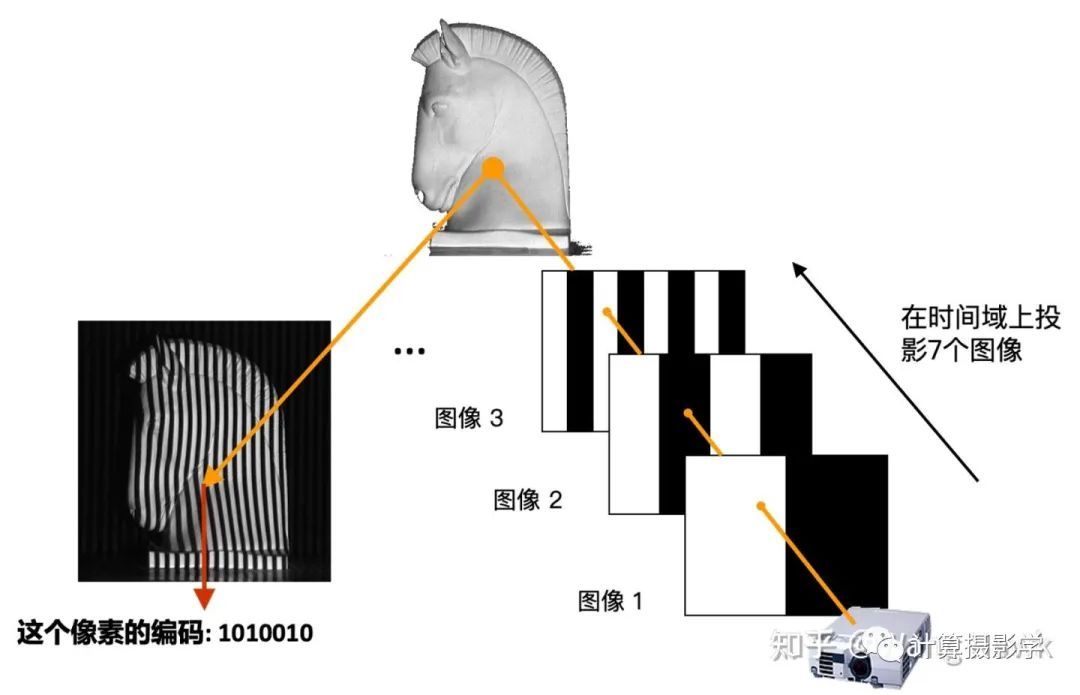

這里面,投影儀會(huì)按次序發(fā)出N個(gè)結(jié)構(gòu)光圖像照亮場景,相機(jī)則把這一系列圖像拍攝下來。注意看論文中的示意圖。這里用到的是一種叫做格雷碼的圖案(Gray-Code),是一種黑白條紋圖案。 為了理解作者是如何獲取高精度視差圖的,我們需要先理解下結(jié)構(gòu)光三維重建的原理。這里我用投影儀發(fā)出最簡單的黑白條紋圖像來做一點(diǎn)點(diǎn)介紹,之后我會(huì)寫更詳細(xì)的文章來介紹結(jié)構(gòu)光三維重建。我們看下面這個(gè)場景,投影儀向場景按時(shí)間順序投出7個(gè)圖像,并被相機(jī)拍攝下來。

為了理解作者是如何獲取高精度視差圖的,我們需要先理解下結(jié)構(gòu)光三維重建的原理。這里我用投影儀發(fā)出最簡單的黑白條紋圖像來做一點(diǎn)點(diǎn)介紹,之后我會(huì)寫更詳細(xì)的文章來介紹結(jié)構(gòu)光三維重建。我們看下面這個(gè)場景,投影儀向場景按時(shí)間順序投出7個(gè)圖像,并被相機(jī)拍攝下來。 拍下來的系列圖像是這樣的:

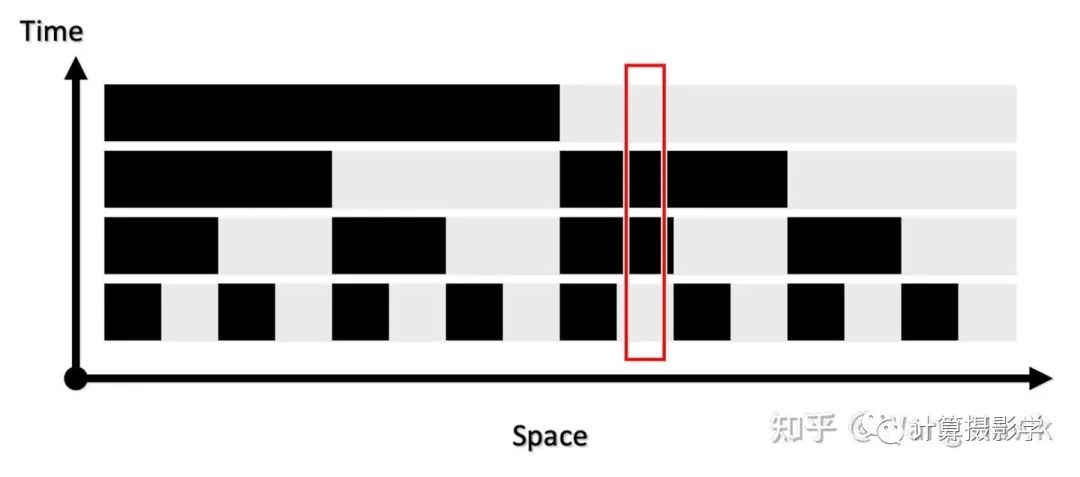

拍下來的系列圖像是這樣的: 我們在時(shí)空兩個(gè)維度上觀察接受到的圖像,就會(huì)發(fā)現(xiàn)每個(gè)場景位置處的信息形成了獨(dú)特的編碼。

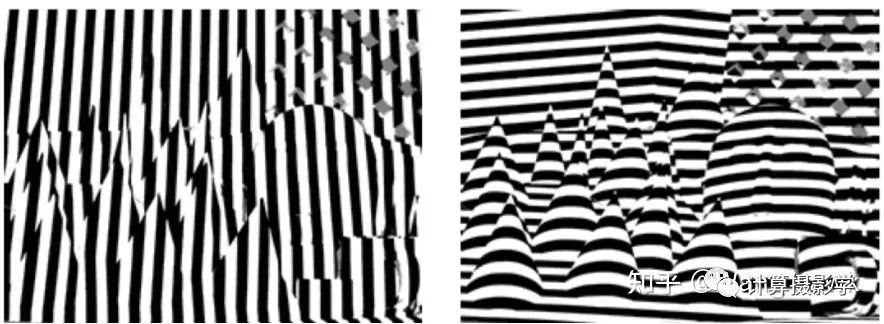

我們在時(shí)空兩個(gè)維度上觀察接受到的圖像,就會(huì)發(fā)現(xiàn)每個(gè)場景位置處的信息形成了獨(dú)特的編碼。 比如上面箭頭所指像素的編碼就是1010010,而且在兩個(gè)視角下對應(yīng)像素的編碼是一致的,這就給了我們精確尋找兩個(gè)圖像的對應(yīng)像素的方法——我們只需要尋找相同編碼的像素即可。這里編碼有7位,意味著我們可以為128列像素指定不同的編碼。如果再發(fā)出的是水平條紋,那么可以為128行像素指定不同的編碼。這樣,就可以支撐尺寸為128x128的像素陣列的視差計(jì)算了。如果編碼長度變?yōu)?0位,那么就可以支持精確計(jì)算出1024x1024的視差圖。現(xiàn)在我們回到Daniel Scharstein和Richard Szeliski的研究,他們確實(shí)是采用了類似原理,通過發(fā)出水平和垂直的條紋結(jié)構(gòu)光來精確的尋找兩個(gè)視角下圖像間的對應(yīng)關(guān)系的。作者用的投影儀是Sony VPL-CX10,投出的圖案是1024x768像素,所以用10位編碼足夠了,也就是投出10個(gè)水平序列圖案和10個(gè)垂直序列圖案。下面展示了其發(fā)出的水平和垂直結(jié)構(gòu)光經(jīng)過閾值分割后的黑白條紋的狀態(tài)。

比如上面箭頭所指像素的編碼就是1010010,而且在兩個(gè)視角下對應(yīng)像素的編碼是一致的,這就給了我們精確尋找兩個(gè)圖像的對應(yīng)像素的方法——我們只需要尋找相同編碼的像素即可。這里編碼有7位,意味著我們可以為128列像素指定不同的編碼。如果再發(fā)出的是水平條紋,那么可以為128行像素指定不同的編碼。這樣,就可以支撐尺寸為128x128的像素陣列的視差計(jì)算了。如果編碼長度變?yōu)?0位,那么就可以支持精確計(jì)算出1024x1024的視差圖。現(xiàn)在我們回到Daniel Scharstein和Richard Szeliski的研究,他們確實(shí)是采用了類似原理,通過發(fā)出水平和垂直的條紋結(jié)構(gòu)光來精確的尋找兩個(gè)視角下圖像間的對應(yīng)關(guān)系的。作者用的投影儀是Sony VPL-CX10,投出的圖案是1024x768像素,所以用10位編碼足夠了,也就是投出10個(gè)水平序列圖案和10個(gè)垂直序列圖案。下面展示了其發(fā)出的水平和垂直結(jié)構(gòu)光經(jīng)過閾值分割后的黑白條紋的狀態(tài)。 通過這種方法,就可以得到精確的視差圖了,作者把此時(shí)得到的視差圖稱為View Disparity。這個(gè)過程可以圖示如下:

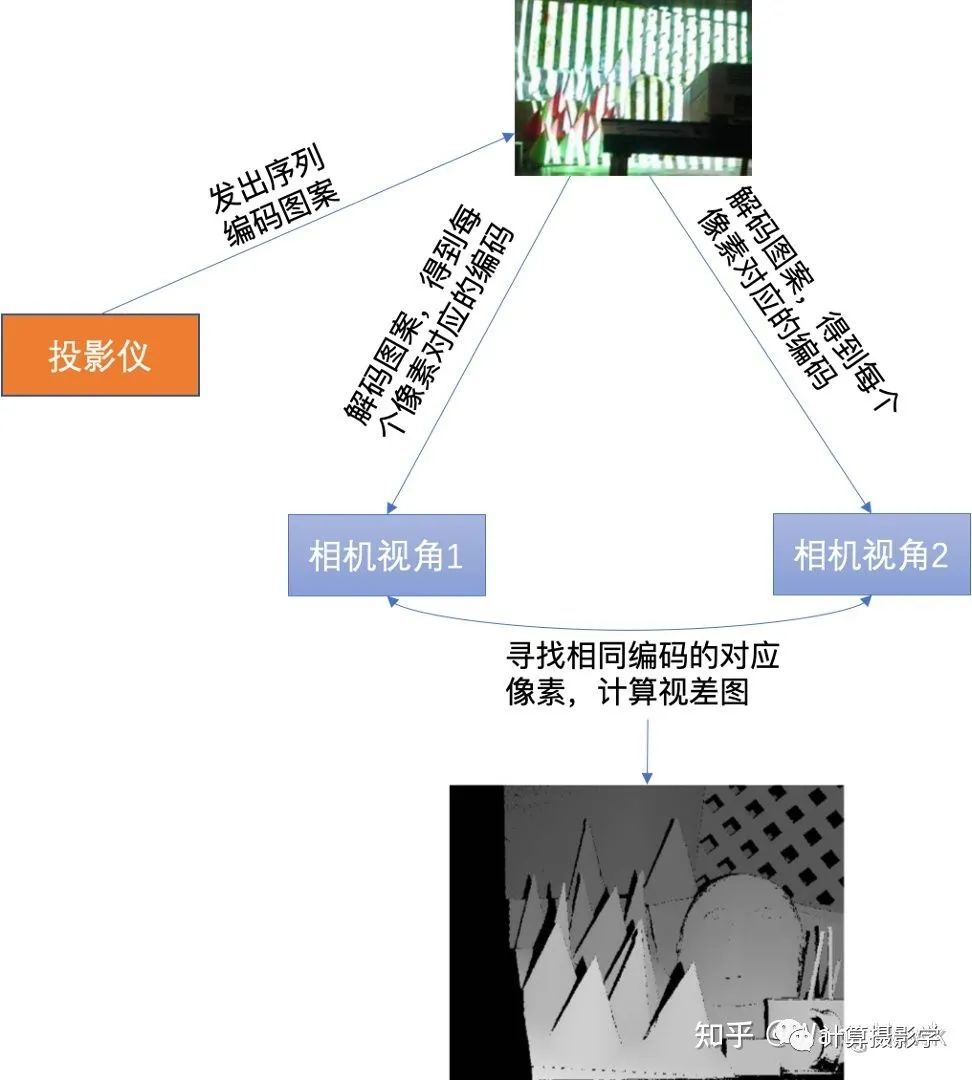

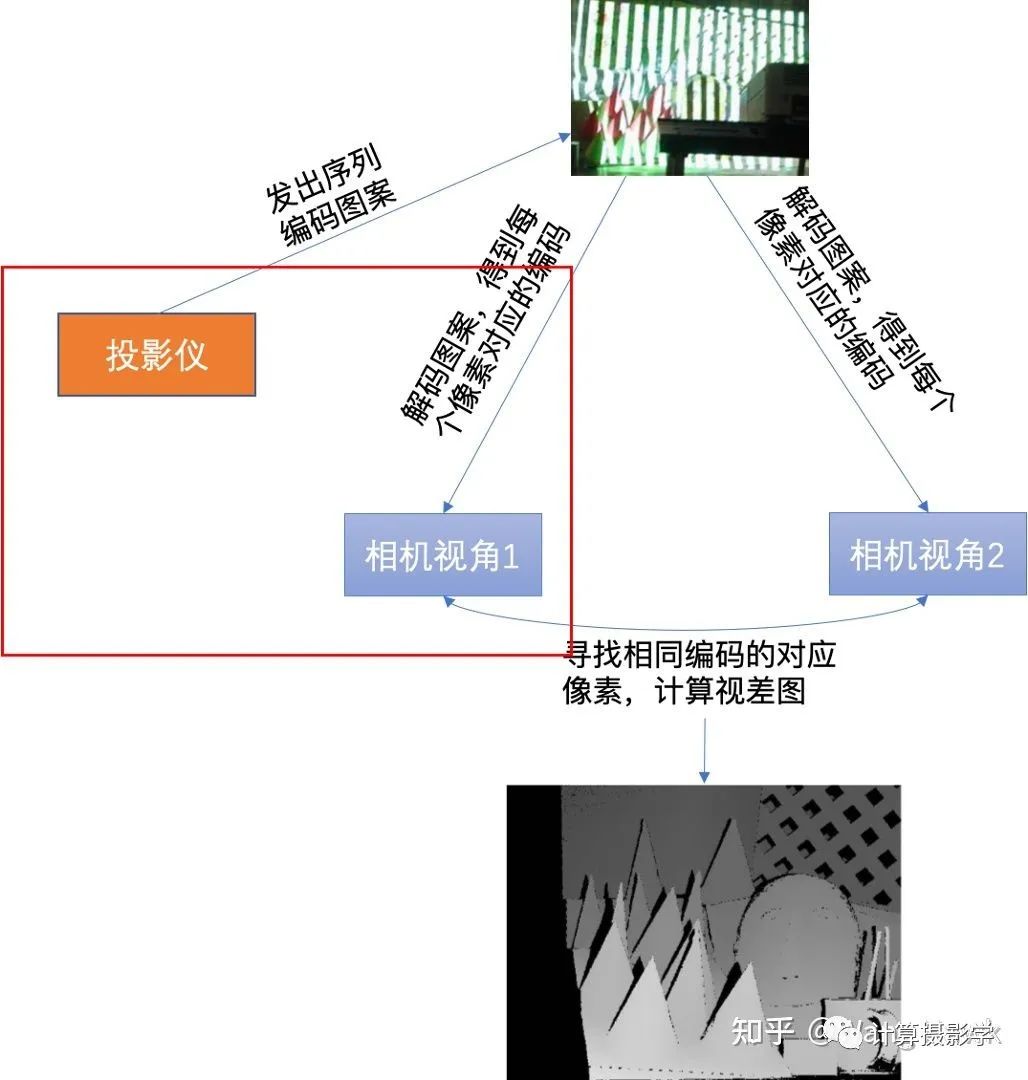

通過這種方法,就可以得到精確的視差圖了,作者把此時(shí)得到的視差圖稱為View Disparity。這個(gè)過程可以圖示如下: 你可以看到,View Dispariy中存在大量的黑色像素,這是怎么回事呢?這里主要由這么幾種情況導(dǎo)致:

你可以看到,View Dispariy中存在大量的黑色像素,這是怎么回事呢?這里主要由這么幾種情況導(dǎo)致:- 遮擋,部分像素只在1個(gè)視角可見,在另外1個(gè)視角不可見

- 陰影或反射,導(dǎo)致部分像素的編碼不可靠,使得匹配失敗。

- 在匹配時(shí),因?yàn)橄鄼C(jī)分辨率和投影儀分辨率不一致,因此所需的插值或者混疊導(dǎo)致了一些像素?zé)o法完美匹配,從而在左右一致性檢查時(shí)失敗。

- 同樣,因?yàn)橥队皟x分辨率不足,導(dǎo)致相機(jī)成像時(shí)多個(gè)像素對應(yīng)同一個(gè)投影儀像素。這可能導(dǎo)致一個(gè)視角下的1個(gè)像素可能和另外一個(gè)視角下多個(gè)像素匹配上,從而在左右一致性檢查時(shí)失敗。

- 還有,就是當(dāng)采用多個(gè)不同的光源方向時(shí),不同光源方向照明時(shí)得到的視差圖不一致。這種不一致的像素也會(huì)被標(biāo)記為黑色像素。

這里,我們注意到當(dāng)相機(jī)視角1下的圖像點(diǎn)和投影儀上的圖案點(diǎn)之間是有明顯的投影關(guān)系的。

這里,我們注意到當(dāng)相機(jī)視角1下的圖像點(diǎn)和投影儀上的圖案點(diǎn)之間是有明顯的投影關(guān)系的。 我們有大量的通過前述過程已知視差值d的像素點(diǎn),因此可以按照上圖建立起超定方程組,并用迭代式的方式求取穩(wěn)定的投影矩陣M。當(dāng)M已求得后,就可以將M當(dāng)成已知量,再次套用p = MS這個(gè)式子,求得每個(gè)像素的視差值——即使這個(gè)像素在此前的view disparity計(jì)算過程中因?yàn)榉N種原因被標(biāo)為了黑色也沒關(guān)系,只要投影儀能夠照亮的像素都可以計(jì)算出一個(gè)視差值,作者把這種方式計(jì)算出來的視差值稱為illumination disparities。由于1個(gè)投影儀可以和左右相機(jī)都計(jì)算出這樣的視差圖,所以我們可以得到2張illumination disparity圖。下面是個(gè)示例圖,(a)是拍攝的序列圖像中的一張,(b)是參考圖像的所謂View Disparity (c)就是Illumination disparitiy。你可以看到,這里標(biāo)為黑色的像素明顯少了很多,大部分都是投影儀無法照亮的像素。(d)則是將(b)和(c)合并的結(jié)果。

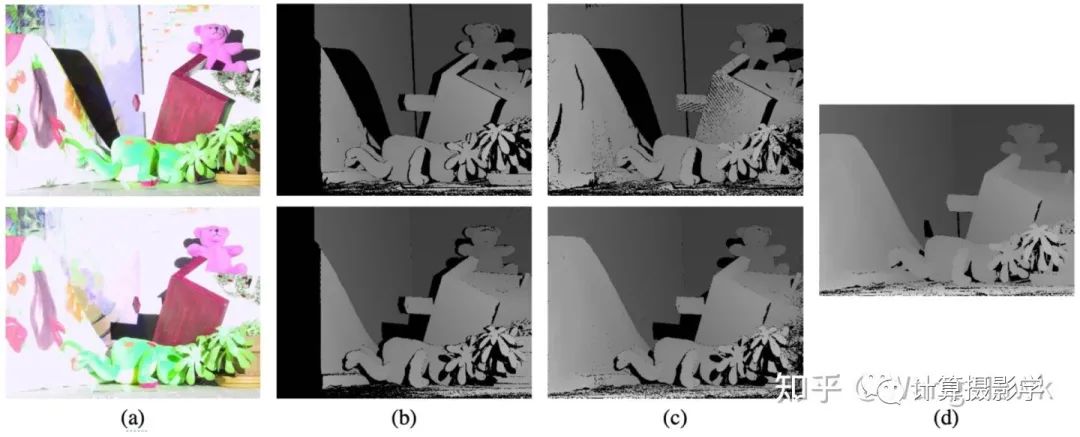

我們有大量的通過前述過程已知視差值d的像素點(diǎn),因此可以按照上圖建立起超定方程組,并用迭代式的方式求取穩(wěn)定的投影矩陣M。當(dāng)M已求得后,就可以將M當(dāng)成已知量,再次套用p = MS這個(gè)式子,求得每個(gè)像素的視差值——即使這個(gè)像素在此前的view disparity計(jì)算過程中因?yàn)榉N種原因被標(biāo)為了黑色也沒關(guān)系,只要投影儀能夠照亮的像素都可以計(jì)算出一個(gè)視差值,作者把這種方式計(jì)算出來的視差值稱為illumination disparities。由于1個(gè)投影儀可以和左右相機(jī)都計(jì)算出這樣的視差圖,所以我們可以得到2張illumination disparity圖。下面是個(gè)示例圖,(a)是拍攝的序列圖像中的一張,(b)是參考圖像的所謂View Disparity (c)就是Illumination disparitiy。你可以看到,這里標(biāo)為黑色的像素明顯少了很多,大部分都是投影儀無法照亮的像素。(d)則是將(b)和(c)合并的結(jié)果。 如果有多個(gè)投影儀,那么每個(gè)投影儀都可以計(jì)算一次對應(yīng)的Illumination Disparity,而且是左右圖都可以計(jì)算出自己的Illumination Disparity,最后將所有計(jì)算出的視差圖合并起來即可。如果我們有N個(gè)投影儀,那么對應(yīng)于左圖的右圖共有2N個(gè)Illumination Disparities,再加上view disparities 2張,一共就需要合并2N+2張視差圖。比如Teddy場景,有兩個(gè)投影儀,就會(huì)有6張視差圖需要合并,下圖是示例,展示了部分視差圖和最終合并的結(jié)果。

如果有多個(gè)投影儀,那么每個(gè)投影儀都可以計(jì)算一次對應(yīng)的Illumination Disparity,而且是左右圖都可以計(jì)算出自己的Illumination Disparity,最后將所有計(jì)算出的視差圖合并起來即可。如果我們有N個(gè)投影儀,那么對應(yīng)于左圖的右圖共有2N個(gè)Illumination Disparities,再加上view disparities 2張,一共就需要合并2N+2張視差圖。比如Teddy場景,有兩個(gè)投影儀,就會(huì)有6張視差圖需要合并,下圖是示例,展示了部分視差圖和最終合并的結(jié)果。 通過上述過程,就可以得到精度非常高的視差圖了,這就會(huì)被作為最終的理想視差圖。Daniel Scharstein和Richard Szeliski采用的這個(gè)方案精度非常高,非常適合制作立體匹配的理想?yún)⒖紨?shù)據(jù)集,于是2005年,MiddleBurry的Anna Blasiak, Jeff Wehrwein和Daniel Scharstein又用此方法構(gòu)造了更多高精度的數(shù)據(jù)集,共9組,下面是一些例子,我想很多人都看到過第1組。這次采集數(shù)據(jù)時(shí),每組數(shù)據(jù)有7個(gè)視角,3種照明,還有3種不同的曝光設(shè)置。視差圖基于第2視角和第6視角計(jì)算,完整的圖像尺寸大概在1300x1100。

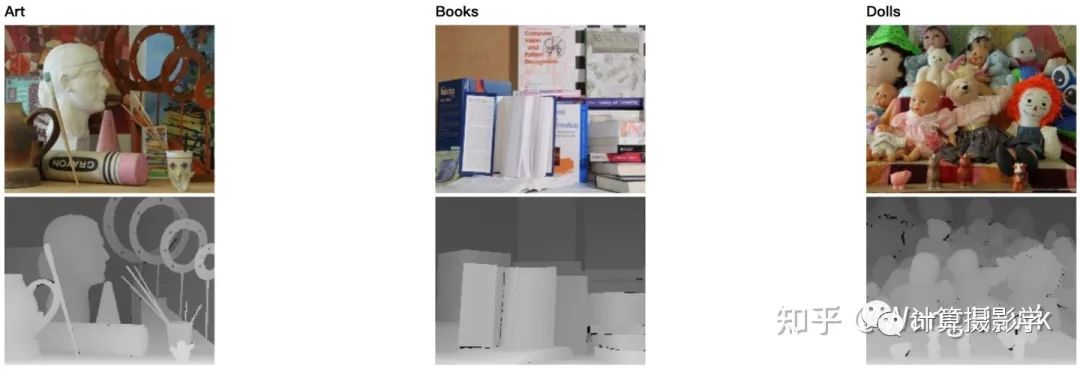

通過上述過程,就可以得到精度非常高的視差圖了,這就會(huì)被作為最終的理想視差圖。Daniel Scharstein和Richard Szeliski采用的這個(gè)方案精度非常高,非常適合制作立體匹配的理想?yún)⒖紨?shù)據(jù)集,于是2005年,MiddleBurry的Anna Blasiak, Jeff Wehrwein和Daniel Scharstein又用此方法構(gòu)造了更多高精度的數(shù)據(jù)集,共9組,下面是一些例子,我想很多人都看到過第1組。這次采集數(shù)據(jù)時(shí),每組數(shù)據(jù)有7個(gè)視角,3種照明,還有3種不同的曝光設(shè)置。視差圖基于第2視角和第6視角計(jì)算,完整的圖像尺寸大概在1300x1100。 這個(gè)數(shù)據(jù)集相比之前的數(shù)據(jù)集更加有挑戰(zhàn)性,因?yàn)閳D像中包括了更大的視差,更多的平坦區(qū)域。到了2006年,還是MiddleBurry大學(xué),Brad Hiebert-Treuer, Sarri Al Nashashibi 以及 Daniel Scharstein一起又制作了21組雙目數(shù)據(jù)。跟2005年一樣,依然是7個(gè)視角,3種照明,3種曝光設(shè)置。這次的完整圖像尺寸大概是1380x1100。這次的數(shù)據(jù)很多人都看過,比如下面幾張就非常出名。

這個(gè)數(shù)據(jù)集相比之前的數(shù)據(jù)集更加有挑戰(zhàn)性,因?yàn)閳D像中包括了更大的視差,更多的平坦區(qū)域。到了2006年,還是MiddleBurry大學(xué),Brad Hiebert-Treuer, Sarri Al Nashashibi 以及 Daniel Scharstein一起又制作了21組雙目數(shù)據(jù)。跟2005年一樣,依然是7個(gè)視角,3種照明,3種曝光設(shè)置。這次的完整圖像尺寸大概是1380x1100。這次的數(shù)據(jù)很多人都看過,比如下面幾張就非常出名。 我們可看到,這些數(shù)據(jù)是越來越有挑戰(zhàn)性,具有豐富的種類,且更多困難的區(qū)域,非常適合對各種立體匹配算法進(jìn)行量化的評(píng)價(jià)。

我們可看到,這些數(shù)據(jù)是越來越有挑戰(zhàn)性,具有豐富的種類,且更多困難的區(qū)域,非常適合對各種立體匹配算法進(jìn)行量化的評(píng)價(jià)。四. 2014年,更加復(fù)雜的制作技術(shù)

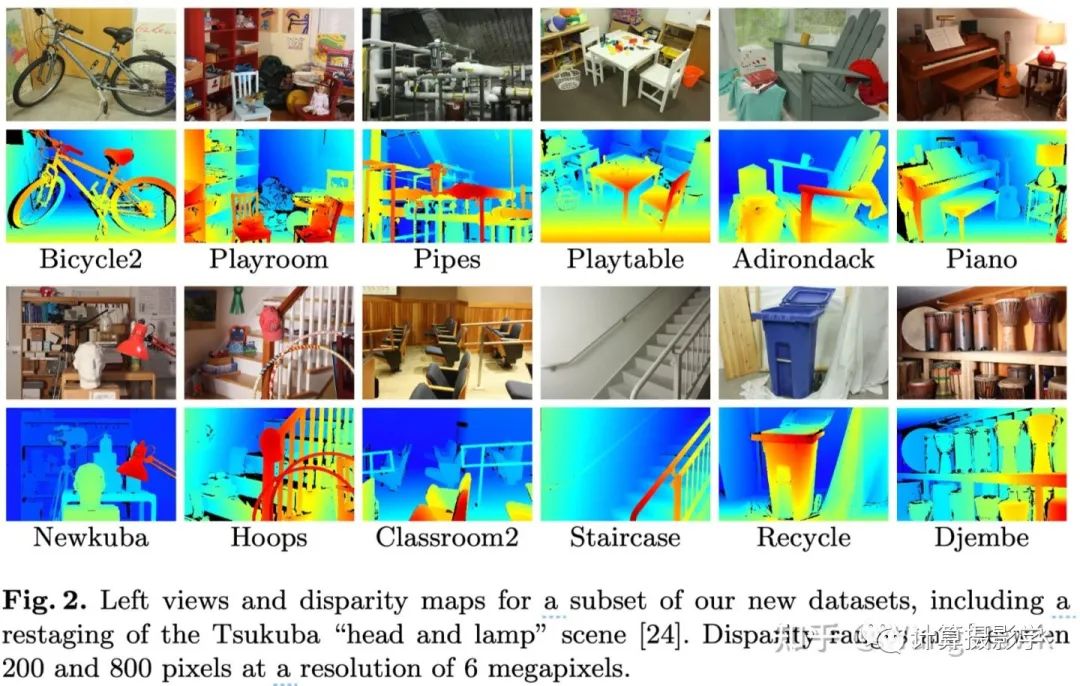

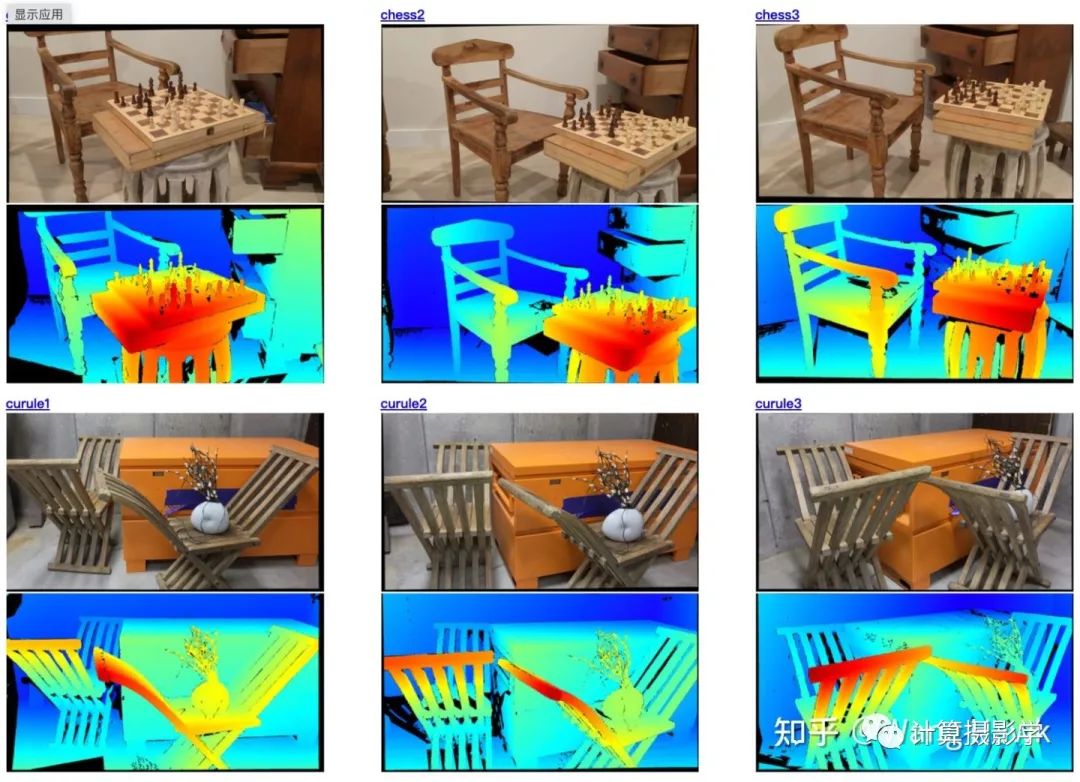

前面講的數(shù)據(jù)集在立體匹配的研究中起了非常大的作用,很多重要的方法都是在這時(shí)候的數(shù)據(jù)集上進(jìn)行評(píng)價(jià)和改進(jìn)的。然而,它們的數(shù)量有限,場景有限,人們認(rèn)識(shí)到需要更多更復(fù)雜的場景,來促進(jìn)立體匹配算法的進(jìn)一步改進(jìn)。于是,2011年到2013年間,MiddleBurry大學(xué)的Nera Nesic, Porter Westling, Xi Wang, York Kitajima, Greg Krathwohl, 以及Daniel Scharstein等人又制作了33組數(shù)據(jù)集,2014年大佬Heiko Hirschmüller完成了對這批數(shù)據(jù)集的優(yōu)化。他們共同在GCPR2014發(fā)表了下面這篇文章,闡述了這批數(shù)據(jù)集的制作方案: 我截取幾組圖像如下,其中很多都是在立體匹配研究中經(jīng)常用到的出名的場景,比如我就特別喜歡圖中那個(gè)鋼琴

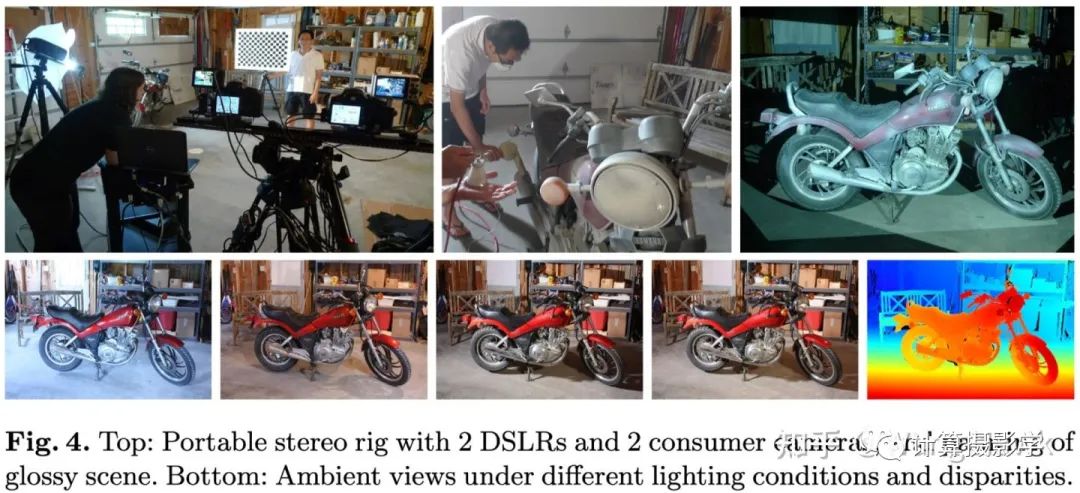

我截取幾組圖像如下,其中很多都是在立體匹配研究中經(jīng)常用到的出名的場景,比如我就特別喜歡圖中那個(gè)鋼琴 那么,這次的數(shù)據(jù)集制作方法相比以前的有什么貢獻(xiàn)呢?主要有下面這幾點(diǎn):1. 作者采用的是可移動(dòng)的雙目系統(tǒng),包括兩個(gè)單反相機(jī),兩個(gè)數(shù)碼相機(jī),以及相應(yīng)的導(dǎo)軌和支架構(gòu)成。這樣就可以在實(shí)驗(yàn)室外拍攝更加豐富的場景。所以最后的數(shù)據(jù)集里面就包括了各種各樣豐富的、更加真實(shí)的場景。而且,這次作者的光照條件更加豐富,有4種,而曝光設(shè)置則有8種。為了能夠重現(xiàn)照明情況,還單獨(dú)拍攝了環(huán)境圖像。下面是論文中的一個(gè)示意圖,你可以看到,摩托車表面可能會(huì)有高反射區(qū)域,為了能夠準(zhǔn)確的獲取這些區(qū)域的理想視差圖,作者在車身表面噴涂了特殊的材質(zhì),我想應(yīng)該是為了減少反光,使得匹配能成功。

那么,這次的數(shù)據(jù)集制作方法相比以前的有什么貢獻(xiàn)呢?主要有下面這幾點(diǎn):1. 作者采用的是可移動(dòng)的雙目系統(tǒng),包括兩個(gè)單反相機(jī),兩個(gè)數(shù)碼相機(jī),以及相應(yīng)的導(dǎo)軌和支架構(gòu)成。這樣就可以在實(shí)驗(yàn)室外拍攝更加豐富的場景。所以最后的數(shù)據(jù)集里面就包括了各種各樣豐富的、更加真實(shí)的場景。而且,這次作者的光照條件更加豐富,有4種,而曝光設(shè)置則有8種。為了能夠重現(xiàn)照明情況,還單獨(dú)拍攝了環(huán)境圖像。下面是論文中的一個(gè)示意圖,你可以看到,摩托車表面可能會(huì)有高反射區(qū)域,為了能夠準(zhǔn)確的獲取這些區(qū)域的理想視差圖,作者在車身表面噴涂了特殊的材質(zhì),我想應(yīng)該是為了減少反光,使得匹配能成功。 2. 更加復(fù)雜的處理流程,得到高精度的數(shù)據(jù)集:

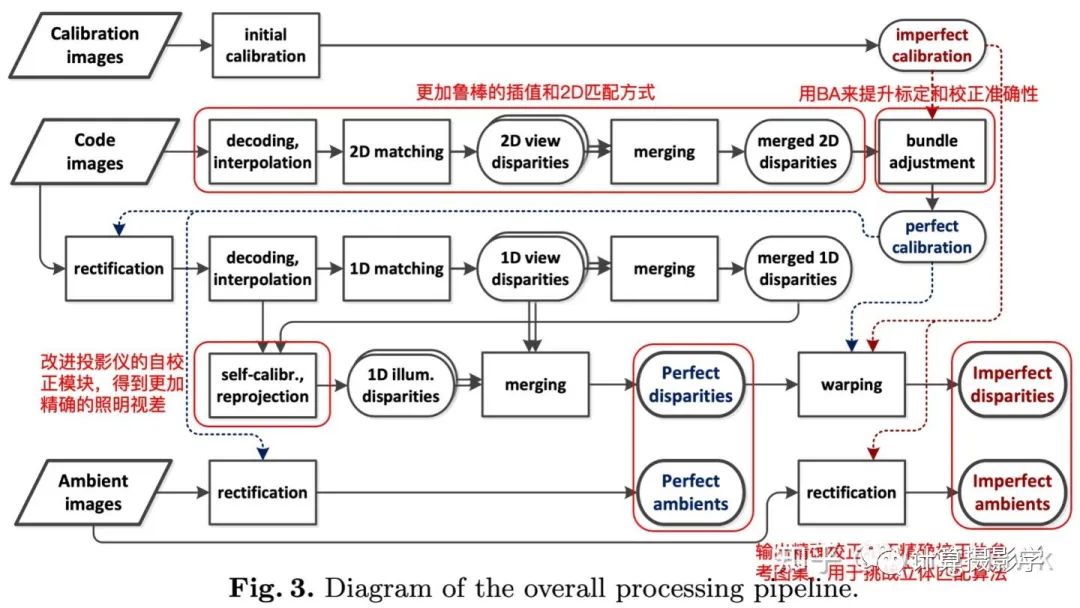

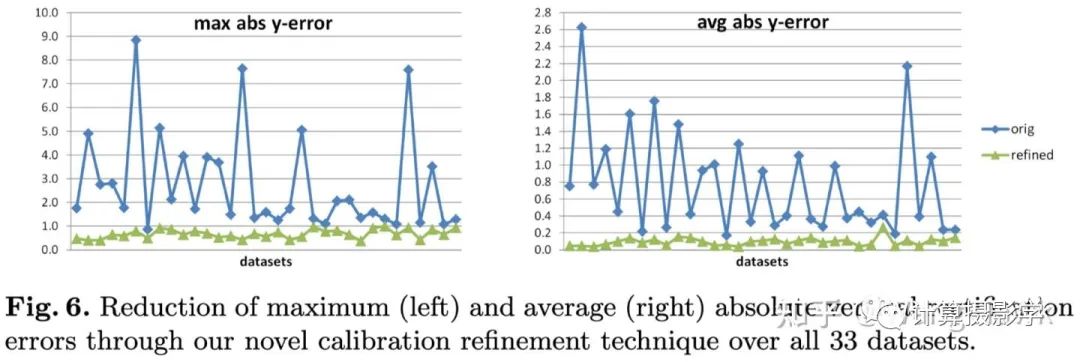

2. 更加復(fù)雜的處理流程,得到高精度的數(shù)據(jù)集: 這里我們看到:1. 2003年的方法沒有很好的處理標(biāo)定和校正帶來的誤差,事實(shí)上這樣的誤差會(huì)影響到最終生成的理想視差圖的精度。這里的新方案采用了Bundle Adjustment來減小標(biāo)定和校正的誤差,進(jìn)一步提升了精度。2. 相比2003年的方法,這里采用了更加魯棒的方式來解碼結(jié)構(gòu)光信息,并用更好的方法來進(jìn)行2D匹配,這樣就可以更準(zhǔn)確的進(jìn)行立體校正。在采用了這兩個(gè)優(yōu)化點(diǎn)后,立體校正的精度和穩(wěn)定性都提升了很多:

這里我們看到:1. 2003年的方法沒有很好的處理標(biāo)定和校正帶來的誤差,事實(shí)上這樣的誤差會(huì)影響到最終生成的理想視差圖的精度。這里的新方案采用了Bundle Adjustment來減小標(biāo)定和校正的誤差,進(jìn)一步提升了精度。2. 相比2003年的方法,這里采用了更加魯棒的方式來解碼結(jié)構(gòu)光信息,并用更好的方法來進(jìn)行2D匹配,這樣就可以更準(zhǔn)確的進(jìn)行立體校正。在采用了這兩個(gè)優(yōu)化點(diǎn)后,立體校正的精度和穩(wěn)定性都提升了很多: 3. 前面我們提到了Illumination Disparity(照明視差)很重要,因此這里引入了更好的自校正模塊,可以得到更好的照明視差4. 另外,為了挑戰(zhàn)立體匹配算法在輸入圖沒有精確rectify的表現(xiàn),這里還輸出了兩種圖集。一種是經(jīng)過精確rectify的,保證滿足對極線水平對齊。另外一種則是沒有經(jīng)過精確rectify的,對算法的挑戰(zhàn)更大。

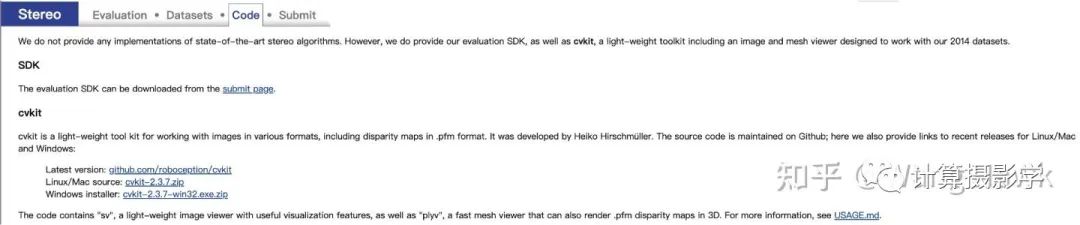

因?yàn)槠颍揖筒辉敿?xì)暫開講解了。總之,這33組數(shù)據(jù)集中,10組釋放出來供大家做訓(xùn)練,10組用于測試(理想視差圖未公開),其他的數(shù)據(jù)用于公開研究。這些數(shù)據(jù)完整的尺寸甚至達(dá)到了3000x2000,最大視差有達(dá)到800像素的!不僅僅如此,在MiddleBurry官網(wǎng)上還提供了完善的工具,可以加載、評(píng)估、分析這些數(shù)據(jù),可以在此處訪問:vision.middlebury.edu/s

3. 前面我們提到了Illumination Disparity(照明視差)很重要,因此這里引入了更好的自校正模塊,可以得到更好的照明視差4. 另外,為了挑戰(zhàn)立體匹配算法在輸入圖沒有精確rectify的表現(xiàn),這里還輸出了兩種圖集。一種是經(jīng)過精確rectify的,保證滿足對極線水平對齊。另外一種則是沒有經(jīng)過精確rectify的,對算法的挑戰(zhàn)更大。

因?yàn)槠颍揖筒辉敿?xì)暫開講解了。總之,這33組數(shù)據(jù)集中,10組釋放出來供大家做訓(xùn)練,10組用于測試(理想視差圖未公開),其他的數(shù)據(jù)用于公開研究。這些數(shù)據(jù)完整的尺寸甚至達(dá)到了3000x2000,最大視差有達(dá)到800像素的!不僅僅如此,在MiddleBurry官網(wǎng)上還提供了完善的工具,可以加載、評(píng)估、分析這些數(shù)據(jù),可以在此處訪問:vision.middlebury.edu/s 比如其中有個(gè)叫plyv的工具,實(shí)現(xiàn)了視角合成功能,便于我們可以從各個(gè)視角來觀察場景:

比如其中有個(gè)叫plyv的工具,實(shí)現(xiàn)了視角合成功能,便于我們可以從各個(gè)視角來觀察場景:

五. 2021年,增加用移動(dòng)設(shè)備拍攝的數(shù)據(jù)集

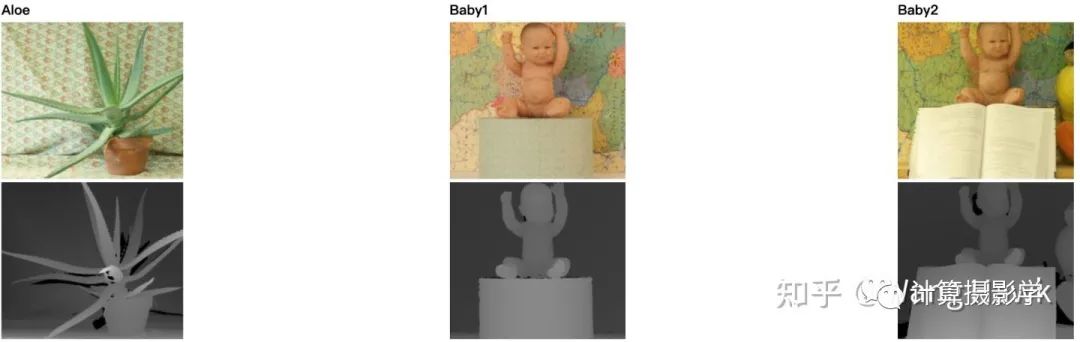

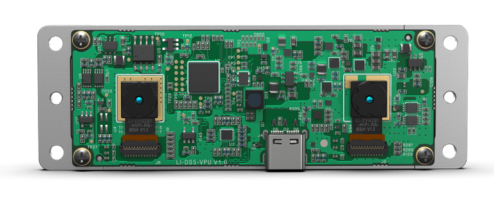

之前的數(shù)據(jù)集都是用單反相機(jī)作為主要成像設(shè)備的,因此圖像的質(zhì)量非常高。2019年到2021年間,Guanghan Pan, Tiansheng Sun, Toby Weed, 和Daniel Scharstein嘗試了用移動(dòng)設(shè)備來拍攝立體匹配數(shù)據(jù)集。這里他們采用的是蘋果的iPod Touch 6G,它被安裝到一個(gè)機(jī)械臂上,在不同視角下拍攝場景。視差圖的生成還是用了上一章介紹的方法,只不過做了適當(dāng)?shù)牟眉簟_@批數(shù)據(jù)一共24組,每個(gè)場景會(huì)有1到3組數(shù)據(jù),下面是例子: 不過我看這里的視差圖依然是用較大差異的兩視角生成的,對于當(dāng)今手機(jī)上的小基距雙攝系統(tǒng)來說,這個(gè)數(shù)據(jù)集的參考價(jià)值沒有那么大,畢竟當(dāng)前手機(jī)上的兩個(gè)攝像頭之間基距大概就10mm左右,與這里的情況差距較大。

不過我看這里的視差圖依然是用較大差異的兩視角生成的,對于當(dāng)今手機(jī)上的小基距雙攝系統(tǒng)來說,這個(gè)數(shù)據(jù)集的參考價(jià)值沒有那么大,畢竟當(dāng)前手機(jī)上的兩個(gè)攝像頭之間基距大概就10mm左右,與這里的情況差距較大。六. 總結(jié)

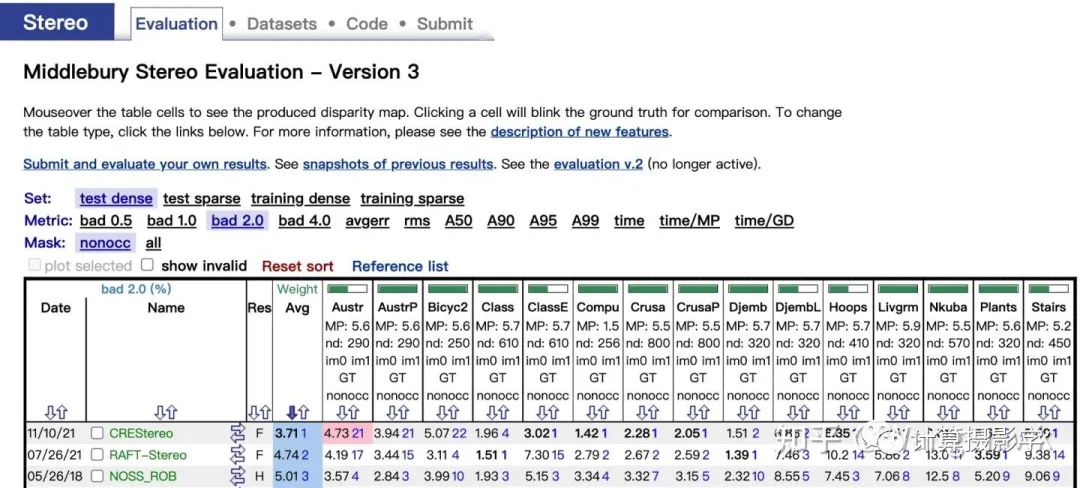

這篇文章里,我為你介紹了幾種核心的立體匹配評(píng)價(jià)指標(biāo),以及MiddleBurry大學(xué)的幾代立體匹配數(shù)據(jù)集的制作方式。現(xiàn)在做相關(guān)研究的人確實(shí)應(yīng)該感謝包括Daniel Scharstein、Richard Szeliski和Heiko Hirschmüller在內(nèi)的先驅(qū)們,他們創(chuàng)建的MiddleBurry立體匹配數(shù)據(jù)集及評(píng)價(jià)系統(tǒng)極大地推動(dòng)了這個(gè)領(lǐng)域的發(fā)展。到了今年,一些計(jì)算機(jī)視覺界的頂會(huì)論文依然會(huì)描述自己在MiddleBurry 立體匹配數(shù)據(jù)集上的評(píng)價(jià)結(jié)果。目前排名第1的算法是曠視研究院今年推出的CREStereo,相關(guān)成果也發(fā)表到了CVPR2022,并會(huì)做口頭報(bào)告,我之后如有時(shí)間也會(huì)撰文加以講解。 總之,立體匹配算法要繼續(xù)發(fā)展,需要大量符合真實(shí)場景復(fù)雜性的高精度數(shù)據(jù)集,我們學(xué)習(xí)前人的做法,是為了能夠找出更好的方法,制作更多的數(shù)據(jù)。我還會(huì)在接下來的文章中,給你介紹其他著名的數(shù)據(jù)集,敬請期待。

總之,立體匹配算法要繼續(xù)發(fā)展,需要大量符合真實(shí)場景復(fù)雜性的高精度數(shù)據(jù)集,我們學(xué)習(xí)前人的做法,是為了能夠找出更好的方法,制作更多的數(shù)據(jù)。我還會(huì)在接下來的文章中,給你介紹其他著名的數(shù)據(jù)集,敬請期待。七. 參考資料

1、MiddleBurry雙目數(shù)據(jù)集2、D. Scharstein and R. Szeliski.A taxonomy and evaluation of dense two-frame stereo correspondence algorithms.International Journal of Computer Vision, 47(1/2/3):7-42, April-June 20023、D. Scharstein and R. Szeliski.High-accuracy stereo depth maps using structured light. InIEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR 2003),volume 1, pages 195-202, Madison, WI, June 2003.4、D. Scharstein and C. Pal.Learning conditional random fields for stereo. InIEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR 2007),Minneapolis, MN, June 2007.5、H. Hirschmüller and D. Scharstein.Evaluation of cost functions for stereo matching. InIEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR 2007),Minneapolis, MN, June 2007.6、D. Scharstein, H. Hirschmüller, Y. Kitajima, G. Krathwohl, N. Nesic, X. Wang, and P. Westling.High-resolution stereo datasets with subpixel-accurate ground truth. InGerman Conference on Pattern Recognition (GCPR 2014), Münster, Germany,September 2014.7、CMU 2021 Fall Computational Photography Course 15-463, Lecture 18

審核編輯 :李倩

聲明:本文內(nèi)容及配圖由入駐作者撰寫或者入駐合作網(wǎng)站授權(quán)轉(zhuǎn)載。文章觀點(diǎn)僅代表作者本人,不代表電子發(fā)燒友網(wǎng)立場。文章及其配圖僅供工程師學(xué)習(xí)之用,如有內(nèi)容侵權(quán)或者其他違規(guī)問題,請聯(lián)系本站處理。

舉報(bào)投訴

-

算法

+關(guān)注

關(guān)注

23文章

4710瀏覽量

95405 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1224瀏覽量

25453

原文標(biāo)題:深度解析MiddleBurry立體匹配數(shù)據(jù)集

文章出處:【微信號(hào):3D視覺工坊,微信公眾號(hào):3D視覺工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評(píng)論請先 登錄

相關(guān)推薦

熱點(diǎn)推薦

使用AICube導(dǎo)入數(shù)據(jù)集點(diǎn)創(chuàng)建后提示數(shù)據(jù)集不合法怎么處理?

重現(xiàn)步驟

data目錄下

labels.txt只有英文

**錯(cuò)誤日志**

但是使用示例的數(shù)據(jù)集可以完成訓(xùn)練并部署

發(fā)表于 06-24 06:07

數(shù)據(jù)集下載失敗的原因?

數(shù)據(jù)集下載失敗什么原因太大了嗎,小的可以下載,想把大的下載去本地訓(xùn)練報(bào)錯(cuò)網(wǎng)絡(luò)錯(cuò)誤

大的數(shù)據(jù)集多大?數(shù)據(jù)量有多少?

發(fā)表于 06-18 07:04

GPU架構(gòu)深度解析

GPU架構(gòu)深度解析從圖形處理到通用計(jì)算的進(jìn)化之路圖形處理單元(GPU),作為現(xiàn)代計(jì)算機(jī)中不可或缺的一部分,已經(jīng)從最初的圖形渲染專用處理器,發(fā)展成為強(qiáng)大的并行計(jì)算引擎,廣泛應(yīng)用于人工智能、科學(xué)計(jì)算

解鎖未來汽車電子技術(shù):軟件定義車輛與區(qū)域架構(gòu)深度解析

解鎖未來汽車電子技術(shù):軟件定義車輛與區(qū)域架構(gòu)深度解析 ——立即下載白皮書,搶占智能汽車發(fā)展先機(jī) *附件:解鎖未來汽車電子技術(shù):軟件定義車輛與區(qū)域架構(gòu)深度解析.pdf 為什么這份白皮書值

風(fēng)華電容命名方法深度解析

在電子元器件領(lǐng)域,風(fēng)華電容憑借其清晰的命名體系、全面的技術(shù)參數(shù)和廣泛的應(yīng)用場景,成為國內(nèi)外市場的標(biāo)志性品牌。本文將從命名規(guī)則、技術(shù)參數(shù)、行業(yè)應(yīng)用及市場優(yōu)勢四個(gè)維度,深度解析風(fēng)華電容的技術(shù)特性

深度解析Linux中的DNS服務(wù)

dns,Domain Name Server,它的作用是將域名解析為 IP 地址,或者將IP地址解析為域名。

航天宏圖PIE-DEM智能采編系統(tǒng)詳解

當(dāng)衛(wèi)星鏡頭掠過青藏高原的冰川裂縫,當(dāng)遙感影像捕捉到亞馬遜雨林0.01℃的溫度變化,一場由深度學(xué)習(xí)驅(qū)動(dòng)的技術(shù)革命正在重塑遙感影像立體匹配技術(shù)獲取高精度DEM/DSM的方式。

請問NanoEdge AI數(shù)據(jù)集該如何構(gòu)建?

我想用NanoEdge來識(shí)別異常的聲音,但我目前沒有辦法生成模型,我感覺可能是數(shù)據(jù)集的問題,請問我該怎么構(gòu)建數(shù)據(jù)集?或者生成模型失敗還會(huì)有哪些原因?

發(fā)表于 03-10 08:20

國產(chǎn)自研新標(biāo)桿:龍芯GM9-3003主板深度解析

國產(chǎn)自研新標(biāo)桿:龍芯GM9-3003主板深度解析

AI艙內(nèi)監(jiān)控虛擬驗(yàn)證平臺(tái):巧破座艙數(shù)據(jù)集困境,速啟高效生成新程!#智能座艙#數(shù)據(jù)集#虛擬驗(yàn)證#AI#AD

數(shù)據(jù)集

康謀自動(dòng)駕駛

發(fā)布于 :2025年02月26日 10:26:42

螺旋卡口式“連接更穩(wěn)固” ,解讀DH系列連接器連接方式匹配數(shù)據(jù)服務(wù)器訴求

景,采用螺旋卡口式連接方式的工業(yè)級(jí)連接器匹配度相對更高,更受青睞。連接器:螺旋卡口式連接方式的特點(diǎn)是什么?螺旋卡口式連接器的特點(diǎn)解析連接更穩(wěn)固通過螺旋卡口鎖定后,連接

玻璃通孔(TGV)技術(shù)深度解析

的性能和可靠性,還推動(dòng)了整個(gè)電子封裝行業(yè)的創(chuàng)新發(fā)展。本文將對TGV技術(shù)的基本原理、制造流程、應(yīng)用優(yōu)勢以及未來發(fā)展進(jìn)行深度解析。

Bumblebee X 立體相機(jī)提升工業(yè)自動(dòng)化中的立體深度感知

深度感知對倉庫機(jī)器人應(yīng)用至關(guān)重要,尤其是在自主導(dǎo)航、物品拾取與放置、庫存管理等方面。通過將深度感知與各種類型的3D數(shù)據(jù)(如體積數(shù)據(jù)、點(diǎn)云、紋理等)相結(jié)合,倉庫機(jī)器人可以在錯(cuò)綜復(fù)雜環(huán)境中

立體視覺新手必看:英特爾? 實(shí)感? D421深度相機(jī)模組

英特爾首款一體化立體深度模組,旨在將先進(jìn)的深度感應(yīng)技術(shù)帶給更廣泛的受眾 2024年9月24日?—— 英特爾? 實(shí)感? 技術(shù)再次突破界限,推出全新的英特爾? 實(shí)感? 深度相機(jī)模組D421

深度解析MiddleBurry立體匹配數(shù)據(jù)集

深度解析MiddleBurry立體匹配數(shù)據(jù)集

評(píng)論