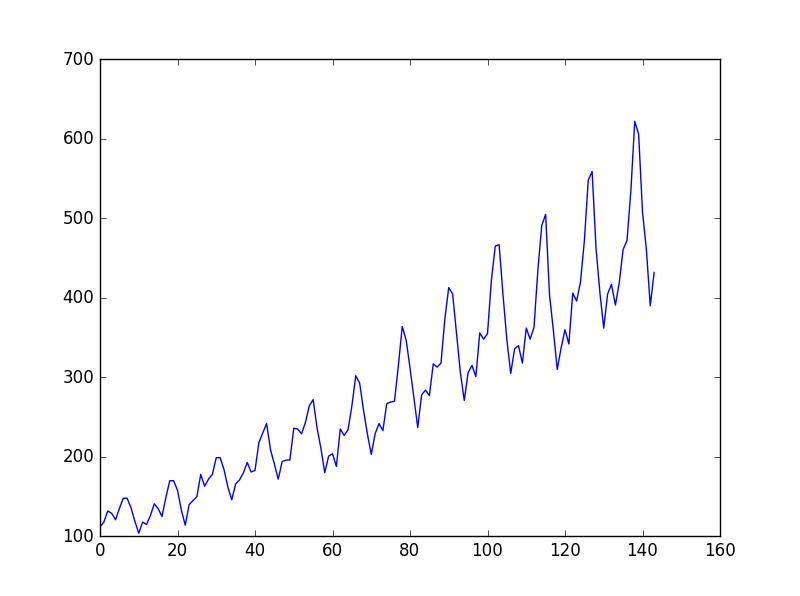

這個問題是國際航空乘客預測問題, 數(shù)據(jù)是1949年1月到1960年12月國際航空公司每個月的乘客數(shù)量(單位:千人),共有12年144個月的數(shù)據(jù)。

數(shù)據(jù)趨勢:

訓練程序:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import torch

from torch import nn

from torch.autograd import Variable

#LSTM(Long Short-Term Memory)是長短期記憶網(wǎng)絡

data_csv = pd.read_csv('C:/Users/my/Desktop/LSTM/data.csv',usecols=[1])

#pandas.read_csv可以讀取CSV(逗號分割)文件、文本類型的文件text、log類型到DataFrame

#原有兩列,時間和乘客數(shù)量,usecols=1:只取了乘客數(shù)量一列

plt.plot(data_csv)

plt.show()

#數(shù)據(jù)預處理

data_csv = data_csv.dropna() #去掉na數(shù)據(jù)

dataset = data_csv.values #字典(Dictionary) values():返回字典中的所有值。

dataset = dataset.astype('float32') #astype(type):實現(xiàn)變量類型轉換

max_value = np.max(dataset)

min_value = np.min(dataset)

scalar = max_value-min_value

dataset = list(map(lambda x: x/scalar, dataset)) #將數(shù)據(jù)標準化到0~1之間

#lambda:定義一個匿名函數(shù),區(qū)別于def

#map(f(x),Itera):map()接收函數(shù)f和一個list,把函數(shù)f依次作用在list的每個元素上,得到一個新的object并返回

'''

接著我們進行數(shù)據(jù)集的創(chuàng)建,我們想通過前面幾個月的流量來預測當月的流量,

比如我們希望通過前兩個月的流量來預測當月的流量,我們可以將前兩個月的流量

當做輸入,當月的流量當做輸出。同時我們需要將我們的數(shù)據(jù)集分為訓練集和測試

集,通過測試集的效果來測試模型的性能,這里我們簡單的將前面幾年的數(shù)據(jù)作為

訓練集,后面兩年的數(shù)據(jù)作為測試集。

'''python

def create_dataset(dataset,look_back=2):#look_back 以前的時間步數(shù)用作輸入變量來預測下一個時間段

dataX, dataY=[], []

for i in range(len(dataset) - look_back):

a = dataset[i:(i+look_back)] #i和i+1賦值

dataX.append(a)

dataY.append(dataset[i+look_back]) #i+2賦值

return np.array(dataX), np.array(dataY) #np.array構建數(shù)組

data_X, data_Y = create_dataset(dataset)

#data_X: 2*142 data_Y: 1*142

#劃分訓練集和測試集,70%作為訓練集

train_size = int(len(data_X) * 0.7)

test_size = len(data_X)-train_size

train_X = data_X[:train_size]

train_Y = data_Y[:train_size]

test_X = data_X[train_size:]

test_Y = data_Y[train_size:]

train_X = train_X.reshape(-1,1,2) #reshape中,-1使元素變?yōu)橐恍校缓筝敵鰹?列,每列2個子元素

train_Y = train_Y.reshape(-1,1,1) #輸出為1列,每列1個子元素

test_X = test_X.reshape(-1,1,2)

train_x = torch.from_numpy(train_X) #torch.from_numpy(): numpy中的ndarray轉化成pytorch中的tensor(張量)

train_y = torch.from_numpy(train_Y)

test_x = torch.from_numpy(test_X)

#定義模型 輸入維度input_size是2,因為使用2個月的流量作為輸入,隱藏層維度hidden_size可任意指定,這里為4

class lstm_reg(nn.Module):

def __init__(self,input_size,hidden_size, output_size=1,num_layers=2):

super(lstm_reg,self).__init__()

#super() 函數(shù)是用于調(diào)用父類(超類)的一個方法,直接用類名調(diào)用父類

self.rnn = nn.LSTM(input_size,hidden_size,num_layers) #LSTM 網(wǎng)絡

self.reg = nn.Linear(hidden_size,output_size) #Linear 函數(shù)繼承于nn.Module

def forward(self,x): #定義model類的forward函數(shù)

x, _ = self.rnn(x)

s,b,h = x.shape #矩陣從外到里的維數(shù)

#view()函數(shù)的功能和reshape類似,用來轉換size大小

x = x.view(s*b, h) #輸出變?yōu)椋╯*b)*h的二維

x = self.reg(x)

x = x.view(s,b,-1) #卷積的輸出從外到里的維數(shù)為s,b,一列

return x

net = lstm_reg(2,4) #input_size=2,hidden_size=4

criterion = nn.MSELoss() #損失函數(shù)均方差

optimizer = torch.optim.Adam(net.parameters(),lr=1e-2)

#構造一個優(yōu)化器對象 Optimizer,用來保存當前的狀態(tài),并能夠根據(jù)計算得到的梯度來更新參數(shù)

#Adam 算法:params (iterable):可用于迭代優(yōu)化的參數(shù)或者定義參數(shù)組的 dicts lr:學習率

for e in range(10000):

var_x = Variable(train_x) #轉為Variable(變量)

var_y = Variable(train_y)

out = net(var_x)

loss = criterion(out, var_y)

optimizer.zero_grad() #把梯度置零,也就是把loss關于weight的導數(shù)變成0.

loss.backward() #計算得到loss后就要回傳損失,這是在訓練的時候才會有的操作,測試時候只有forward過程

optimizer.step() #回傳損失過程中會計算梯度,然后optimizer.step()根據(jù)這些梯度更新參數(shù)

if (e+1)%100 == 0:

print('Epoch: {}, Loss:{:.5f}'.format(e+1, loss.data[0]))

torch.save(net.state_dict(), 'net_params.pkl') #保存訓練文件net_params.pkl

#state_dict 是一個簡單的python的字典對象,將每一層與它的對應參數(shù)建立映射關系

測試程序:

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import torch

from torch import nn

from torch.autograd import Variable

data_csv = pd.read_csv('C:/Users/my/Desktop/LSTM/data.csv',usecols=[1])

# plt.plot(data_csv)

# plt.show()

#數(shù)據(jù)預處理

data_csv = data_csv.dropna() #去掉na數(shù)據(jù)

dataset = data_csv.values #字典(Dictionary) values():返回字典中的所有值。

dataset = dataset.astype('float32') # astype(type):實現(xiàn)變量類型轉換

max_value = np.max(dataset)

min_value = np.min(dataset)

scalar = max_value-min_value

dataset = list(map(lambda x: x/scalar, dataset)) #將數(shù)據(jù)標準化到0~1之間

def create_dataset(dataset,look_back=2):

dataX, dataY=[], []

for i in range(len(dataset)-look_back):

a=dataset[i:(i+look_back)]

dataX.append(a)

dataY.append(dataset[i+look_back])

return np.array(dataX), np.array(dataY)

data_X, data_Y = create_dataset(dataset)

class lstm_reg(nn.Module):

def __init__(self,input_size,hidden_size, output_size=1,num_layers=2):

super(lstm_reg,self).__init__()

self.rnn = nn.LSTM(input_size,hidden_size,num_layers)

self.reg = nn.Linear(hidden_size,output_size)

def forward(self,x):

x, _ = self.rnn(x)

s,b,h = x.shape

x = x.view(s*b, h)

x = self.reg(x)

x = x.view(s,b,-1)

return x

net = lstm_reg(2,4)

net.load_state_dict(torch.load('net_params.pkl'))

data_X = data_X.reshape(-1, 1, 2) #reshape中,-1使元素變?yōu)橐恍校缓筝敵鰹?列,每列2個子元素

data_X = torch.from_numpy(data_X) #torch.from_numpy(): numpy中的ndarray轉化成pytorch中的tensor(張量)

var_data = Variable(data_X) #轉為Variable(變量)

pred_test = net(var_data) #產(chǎn)生預測結果

pred_test = pred_test.view(-1).data.numpy() #view(-1)輸出為一行

plt.plot(pred_test, 'r', label='prediction')

plt.plot(dataset, 'b', label='real')

plt.legend(loc='best') #loc顯示圖像 'best'表示自適應方式

plt.show()

預測結果:

審核編輯:湯梓紅

聲明:本文內(nèi)容及配圖由入駐作者撰寫或者入駐合作網(wǎng)站授權轉載。文章觀點僅代表作者本人,不代表電子發(fā)燒友網(wǎng)立場。文章及其配圖僅供工程師學習之用,如有內(nèi)容侵權或者其他違規(guī)問題,請聯(lián)系本站處理。

舉報投訴

-

神經(jīng)網(wǎng)絡

+關注

關注

42文章

4812瀏覽量

103232 -

python

+關注

關注

56文章

4825瀏覽量

86476 -

LSTM

+關注

關注

0文章

60瀏覽量

4021

發(fā)布評論請先 登錄

相關推薦

熱點推薦

Keras之ML~P:基于Keras中建立的回歸預測的神經(jīng)網(wǎng)絡模型

Keras之ML~P:基于Keras中建立的回歸預測的神經(jīng)網(wǎng)絡模型(根據(jù)200個數(shù)據(jù)樣本預測新的5+1個樣本)——

發(fā)表于 12-20 10:43

結合小波變換的LSTM循環(huán)神經(jīng)網(wǎng)絡的稅收預測

來去除稅收數(shù)據(jù)中的噪聲,提高模型的泛化能力。LSTM神經(jīng)網(wǎng)絡通過加入隱藏神經(jīng)單元和門控單元能夠更妤地學習到歷史稅收數(shù)據(jù)之間的相關關系,并進一步提取有效的輸入

發(fā)表于 04-28 11:26

?10次下載

如何理解RNN與LSTM神經(jīng)網(wǎng)絡

在深入探討RNN(Recurrent Neural Network,循環(huán)神經(jīng)網(wǎng)絡)與LSTM(Long Short-Term Memory,長短期記憶網(wǎng)絡)神經(jīng)網(wǎng)絡之前,我們首先需要明

LSTM神經(jīng)網(wǎng)絡的基本原理 如何實現(xiàn)LSTM神經(jīng)網(wǎng)絡

LSTM(長短期記憶)神經(jīng)網(wǎng)絡是一種特殊的循環(huán)神經(jīng)網(wǎng)絡(RNN),它能夠?qū)W習長期依賴信息。在處理序列數(shù)據(jù)時,如時間

LSTM神經(jīng)網(wǎng)絡在時間序列預測中的應用

時間序列預測是數(shù)據(jù)分析中的一個重要領域,它涉及到基于歷史數(shù)據(jù)預測未來值。隨著深度學習技術的發(fā)展,長短期記憶(

LSTM神經(jīng)網(wǎng)絡的優(yōu)缺點分析

長短期記憶(Long Short-Term Memory, LSTM)神經(jīng)網(wǎng)絡是一種特殊的循環(huán)神經(jīng)網(wǎng)絡(RNN),由Hochreiter和Schmidhuber在1997年提出。LSTM

LSTM神經(jīng)網(wǎng)絡與傳統(tǒng)RNN的區(qū)別

神經(jīng)網(wǎng)絡(RNN) RNN的基本結構 RNN是一種特殊的神經(jīng)網(wǎng)絡,它能夠處理序列數(shù)據(jù)。在RNN中,每個時間步的輸入都會通過一個循環(huán)結構傳遞到

LSTM神經(jīng)網(wǎng)絡在語音識別中的應用實例

神經(jīng)網(wǎng)絡簡介 LSTM是一種特殊的循環(huán)神經(jīng)網(wǎng)絡(RNN),它能夠?qū)W習長期依賴關系。在傳統(tǒng)的RNN中,信息會隨著時間的流逝而逐漸消失,導致

LSTM神經(jīng)網(wǎng)絡的結構與工作機制

LSTM(Long Short-Term Memory,長短期記憶)神經(jīng)網(wǎng)絡是一種特殊的循環(huán)神經(jīng)網(wǎng)絡(RNN),設計用于解決長期依賴問題,特別是在處理時間

LSTM神經(jīng)網(wǎng)絡的訓練數(shù)據(jù)準備方法

: 一、數(shù)據(jù)收集與清洗 數(shù)據(jù)收集 : 根據(jù)LSTM神經(jīng)網(wǎng)絡的應用場景(如時間序列預測、自然語言處理等),收集相關的

如何使用Python構建LSTM神經(jīng)網(wǎng)絡模型

構建一個LSTM(長短期記憶)神經(jīng)網(wǎng)絡模型是一個涉及多個步驟的過程。以下是使用Python和Keras庫構建LSTM模型的指南。 1. 安裝必要的庫 首先,確保你已經(jīng)安裝了

LSTM神經(jīng)網(wǎng)絡在圖像處理中的應用

長短期記憶(LSTM)神經(jīng)網(wǎng)絡是一種特殊的循環(huán)神經(jīng)網(wǎng)絡(RNN),它能夠?qū)W習長期依賴關系。雖然LSTM最初是為處理序列數(shù)據(jù)設計的,但近年來,

深度學習框架中的LSTM神經(jīng)網(wǎng)絡實現(xiàn)

長短期記憶(LSTM)網(wǎng)絡是一種特殊的循環(huán)神經(jīng)網(wǎng)絡(RNN),能夠?qū)W習長期依賴信息。與傳統(tǒng)的RNN相比,LSTM通過引入門控機制來解決梯度消失和梯度爆炸問題,使其在處理

使用BP神經(jīng)網(wǎng)絡進行時間序列預測

使用BP(Backpropagation)神經(jīng)網(wǎng)絡進行時間序列預測是一種常見且有效的方法。以下是一個基于BP神經(jīng)網(wǎng)絡進行

Python中LSTM回歸神經(jīng)網(wǎng)絡的時間序列預測

Python中LSTM回歸神經(jīng)網(wǎng)絡的時間序列預測

評論