InstaDeep、慕尼黑工業(yè)大學(xué)(TUM)和 NVIDIA 之間的合作推動了面向基因組學(xué)的多超級計算規(guī)模的基礎(chǔ)模型開發(fā)進(jìn)程。這些模型在大量預(yù)測任務(wù)(例如啟動子和增強(qiáng)子位點預(yù)測)中展示了最先進(jìn)的性能。

這一聯(lián)合團(tuán)隊的研究指出,經(jīng)過基因組學(xué)訓(xùn)練的大型語言模型(LLM)可將應(yīng)用擴(kuò)展到大量基因組學(xué)任務(wù)。

該團(tuán)隊使用 NVIDIA 的超級計算機(jī) Cambridge-1 來訓(xùn)練參數(shù)規(guī)模從 500M 到 2.5B 不等的各種大型語言模型(LLM)。這些模型在各種基因組數(shù)據(jù)集上進(jìn)行了訓(xùn)練,以探索模型規(guī)模和數(shù)據(jù)多樣性對下游任務(wù)性能的影響。

分類任務(wù)包括預(yù)測增強(qiáng)子和啟動子序列以及轉(zhuǎn)錄因子結(jié)合位點。這些任務(wù)有助于了解 DNA 如何轉(zhuǎn)錄生成 RNA 和蛋白質(zhì),從而開啟新的臨床應(yīng)用。

研究中明確了 20 項任務(wù)。對于每一項任務(wù),性能都隨著模型規(guī)模和數(shù)據(jù)集多樣性的增加而單調(diào)遞增。參照專門的最新模型基線,在多物種數(shù)據(jù)集上訓(xùn)練的具有最大參數(shù)規(guī)模(2.5B 參數(shù))的大型語言模型在 19 項任務(wù)中的 15 項中取得了同等或更高的性能。

這些結(jié)果是通過利用參數(shù)輕量化微調(diào)實現(xiàn)的。然而,即使依靠從 Transformer 模型各層提取的預(yù)訓(xùn)練嵌入以及簡單的淺層感知器(MLP)或邏輯回歸,也足以在 11 個任務(wù)中實現(xiàn)同等乃至更高的性能。

在每個模型檢查點和每個任務(wù)的所有層上應(yīng)用這種探測策略,訓(xùn)練出了 120 萬個 MLP 模型。該研究對大型語言模型的訓(xùn)練和使用等各方面進(jìn)行了詳細(xì)分析,例如不同層對下游任務(wù)性能的影響。

在固定模型規(guī)模下直接比較序列多樣性,顯示出具有重要意義的性能提升,增加模型規(guī)模也是如此。例如,對于一個 500M 參數(shù)模型,僅在人類參考基因組上訓(xùn)練的性能不如在 1000 基因組數(shù)據(jù)集上訓(xùn)練的性能。

同樣,在 1000 基因組數(shù)據(jù)集上訓(xùn)練的 2.5B 參數(shù)模型的性能優(yōu)于任何 500M 參數(shù)模型。而對于相同的模型,性能會遜于在自定義多物種數(shù)據(jù)集上訓(xùn)練的結(jié)果,即使下游性能是在僅涉及人類基因組的任務(wù)上測量的。

研究人員觀察到,并非所有嵌入都是平等創(chuàng)建的。雖然通常的做法建議使用大型語言模型的最后一層進(jìn)行下游預(yù)測。但耐人尋味的是,中間層產(chǎn)生的表征在下游任務(wù)中顯示出明顯更高的性能。研究人員發(fā)現(xiàn),最佳層的選擇取決于任務(wù),表明不同類型的 DNA 特征被不同層的模型所捕獲。

InstaDeep 首席執(zhí)行官 Karim Beguir 表示:“我們相信這些結(jié)果首次清楚地證明了基因組學(xué)基礎(chǔ)模型的可行性,這些模型能夠真正地推廣到多項任務(wù)中。這些結(jié)果從很多方面反映出了過去幾年內(nèi)適應(yīng)性基礎(chǔ)模型在自然語言處理方面的發(fā)展進(jìn)程。如今,其應(yīng)用于藥物研發(fā)和人類健康等如此具有挑戰(zhàn)性的問題,著實令人難以置信的興奮。”

NVIDIA 的 Cambridge-1 對該項目的成功至關(guān)重要。該項目需要高性能計算基礎(chǔ)設(shè)施來訓(xùn)練具有捕獲基因組中遠(yuǎn)程相互作用所需感受域的大型模型。

研究人員嘗試了多種方法、數(shù)據(jù)集大小、模型規(guī)模和分詞器方案,最終使用在 16 個 NVIDIA DGX A100 節(jié)點(128 個 A100 80GB GPU)上訓(xùn)練的 2.5B 參數(shù)稀疏注意力模型,在多任務(wù)上實現(xiàn)了迄今公開發(fā)表的最佳性能。

在未來的研究工作中,該團(tuán)隊計劃通過直接微調(diào)模型,探索進(jìn)一步的下游任務(wù)性能改進(jìn),并將繼續(xù)在應(yīng)用于基因組學(xué)的大型語言模型的架構(gòu)創(chuàng)新方面展開合作。InstaDeep 是首批使用 Cambridge-1 的 NVIDIA 初創(chuàng)加速計劃成員之一。

掃描下方海報二維碼,即可免費注冊 GTC 23,切莫錯過這場 AI 和元宇宙時代的技術(shù)大會!

原文標(biāo)題:基因組學(xué)大型語言模型在多項任務(wù)中均展現(xiàn)出卓越的性能和應(yīng)用擴(kuò)展空間

文章出處:【微信公眾號:NVIDIA英偉達(dá)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

英偉達(dá)

+關(guān)注

關(guān)注

22文章

3933瀏覽量

93383

原文標(biāo)題:基因組學(xué)大型語言模型在多項任務(wù)中均展現(xiàn)出卓越的性能和應(yīng)用擴(kuò)展空間

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達(dá)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

中科曙光構(gòu)建全國產(chǎn)化基因組學(xué)高性能計算平臺

小白學(xué)大模型:從零實現(xiàn) LLM語言模型

小白學(xué)大模型:訓(xùn)練大語言模型的深度指南

添越智創(chuàng)基于 RK3588 開發(fā)板部署測試 DeepSeek 模型全攻略

【「基于大模型的RAG應(yīng)用開發(fā)與優(yōu)化」閱讀體驗】+大模型微調(diào)技術(shù)解讀

NVIDIA 攜手行業(yè)領(lǐng)先機(jī)構(gòu)推動基因組學(xué)、藥物發(fā)現(xiàn)及醫(yī)療健康行業(yè)發(fā)展

Kimi發(fā)布視覺思考模型k1,展現(xiàn)卓越基礎(chǔ)科學(xué)能力

NaVILA:加州大學(xué)與英偉達(dá)聯(lián)合發(fā)布新型視覺語言模型

NVIDIA AI助力日本制藥公司推進(jìn)藥物研發(fā)

騰訊發(fā)布開源MoE大語言模型Hunyuan-Large

AI大模型在自然語言處理中的應(yīng)用

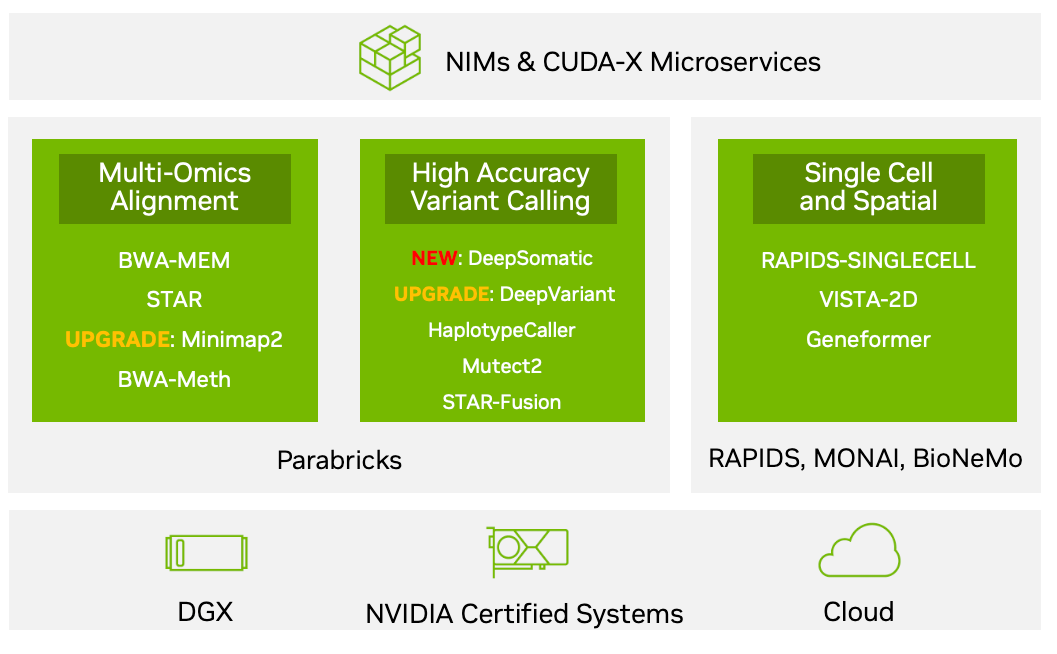

NVIDIA Parabricks v4.3.1版本的新功能

基因組學(xué)大型語言模型在多項任務(wù)中均展現(xiàn)出卓越的性能和應(yīng)用擴(kuò)展空間

基因組學(xué)大型語言模型在多項任務(wù)中均展現(xiàn)出卓越的性能和應(yīng)用擴(kuò)展空間

評論