“一眼就能學會動作”,或許對人而言,這樣的要求有點過高,然而,在機器人的身上,這個想法正在逐步實現中。馬斯克(Elon Musk)創立的人工智能公司Open AI研究通過One-Shot Imitation Learning算法(一眼模仿學習),讓機器人能夠復制人類行為。現階段理想化的目標是人類教機器人一個任務,經過人類演示一次后,機器人可以自學完成指定任務。機器人學習的過程,與人類的學習具有相通之處,但是需要機器人能夠理解任務的動作方式和動作意圖,并且將其轉化為機器人自身的控制運動上。

“機器人學習”是機器人研究的重要方向,其中包含了計算機視覺,自然語言處理,機器人控制等眾多技術。機器人抓取(Robotic manipulation/grasping)是機器人智能化發展道路上亟待解決的問題之一。相較于傳統的開環控制系統,本文將從基于視覺,基于視覺和語音,基于視覺和觸覺三個方向出發,介紹機器人抓取的相關研究進展,并羅列相關的文章供大家查找閱讀。

1、基于視覺信息的機器人抓取學習

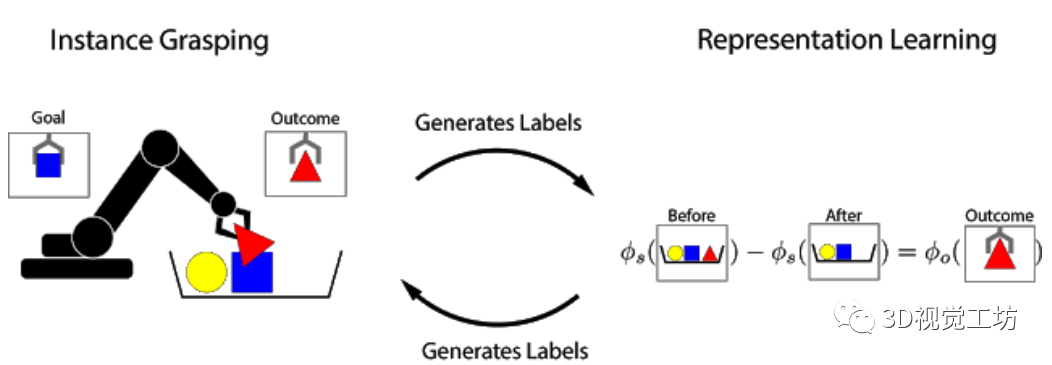

結構良好的視覺表示可以使機器人學習更快,并且可以提高通用性。在本文中,研究人員研究了在沒有人工標記的情況下,如何通過使用自主的機器人與環境的交互獲得有效的以物體為中心的表示方法,即可完成機器人操作任務。這種機器人學習的方法可以讓機器人收集獲取更多的經驗,不斷完善機器人的認知,從而無需人工干預即可有效地進行縮放。本文中的學習方法是基于對象的永久性:當機器人從場景中刪除對象時,該場景的表示會根據被刪除對象的特征而隨之變化。研究人員根據觀察結果會在特征向量之間建立關系,并使用它來學習場景和物體的表示。這些場景和物體可用于識別對象實例,將它們在場景中進行定位,并在機器人從目標箱中檢索命令對象時,執行以目標為導向的任務。整體的抓取過程是通過記錄場景圖像,抓取和移除物體以及記錄結果,該抓取過程也可以用于為文中的方法自動收集訓練數據。文中實驗表明,這種用于任務抓取的自我監督方法明顯優于直接增強圖像學習方法和先前的表征學習方法。

從小時候開始,即使從未有人明確地教過如何做,人們依舊能夠識別并收拾取自己喜歡的物品。根據認知發展研究,這種與世界中的物體相互交互的能力,在人類感知和操縱物體的能力形成的過程中起著重要的作用。通過與周圍世界的互動,人們可以通過自我監督來學習:知道自己采取了什么行動,并且從結果中學到了什么知識。在機器人技術中,人們積極研究了這種自我監督型學習,因為它使機器人系統無需大量的訓練數據或人工監督即可進行學習。

受對象永久性概念的啟發,研究人員提出了Grasp2Vec,一種用于獲取物體表示的簡單而高效的算法。Grasp2Vec算法中嘗試抓取任何東西都會獲取以下幾條信息——如果機器人抓住一個物體并將其抬起,則物體必須在抓取前進入場景。此外,若機器人知道它抓住的物體當前處于夾爪中,就會將其從場景中移除。通過使用這種形式的自監督,機器人可以利用抓取前后的場景視覺變化來學習識別物體。

基于前與X Robotics合作的基礎上(該項目的任務是讓一系列機器人同時學習使用單目相機輸入來抓取家用物品),研究人員使用機械臂“無意間”抓取物體,這種經驗使機器人能夠學習豐富的圖像對象。這些表示可用于獲取“有意抓握”的能力,并且機械臂可以拾取用戶指定的對象。

在強化學習的框架中,通過“獎勵函數”可以衡量任務的成功與否。通過最大化獎勵函數,機器人可以從頭開始自學各種抓握的技能。如果任務的成功與否可以通過簡單的方法來衡量,設計獎勵函數就很容易。一個簡單的例子是當一個按鈕被按下時,該按鈕直接向機器人提供獎勵。

然而,當成功標準取決于對當前任務的“感性理解”時,設計獎勵函數的難度就會加大。考慮實例抓取的任務,其中機器人看到的是期望的物體圖片。當機器人試圖抓住該物體后,將會檢查抓取的對象。此任務的獎勵函數可以看作物體識別問題:抓住的物體是否與期望相匹配?

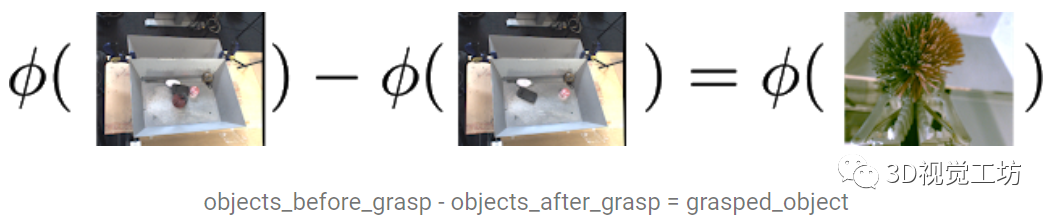

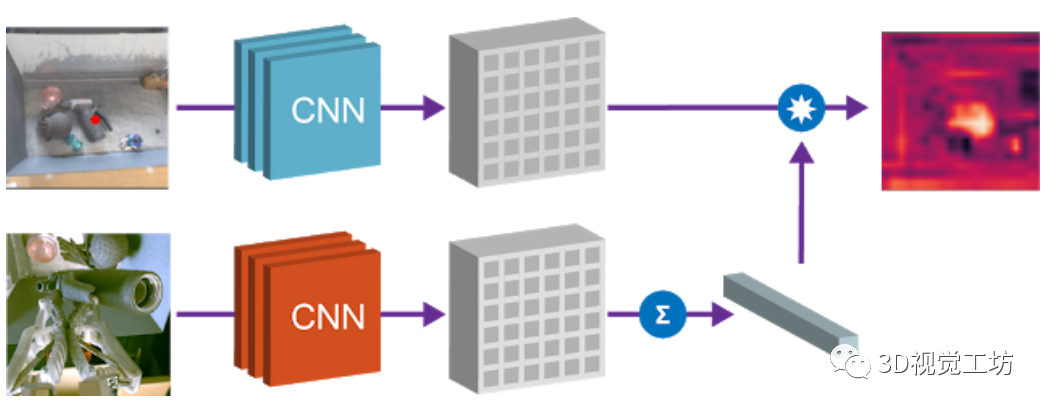

為了解決這種識別問題,需要一種感知系統:該系統能從非結構化圖像數據中提取有意義的物體概念,并能以無監督的方式學習物體的視覺感知。該研究在數據收集的過程中,利用機器人可以操縱物體移動的優勢,提供數據所需的變化因素。通過對物體進行抓取,可以獲得1)抓取前的場景圖像;2)抓取后的場景圖像;3)抓握物體本身的孤立視圖。 研究人員提出了一個從圖像中提取“物體集合”的嵌入函數,該函數滿足以下減法關系:

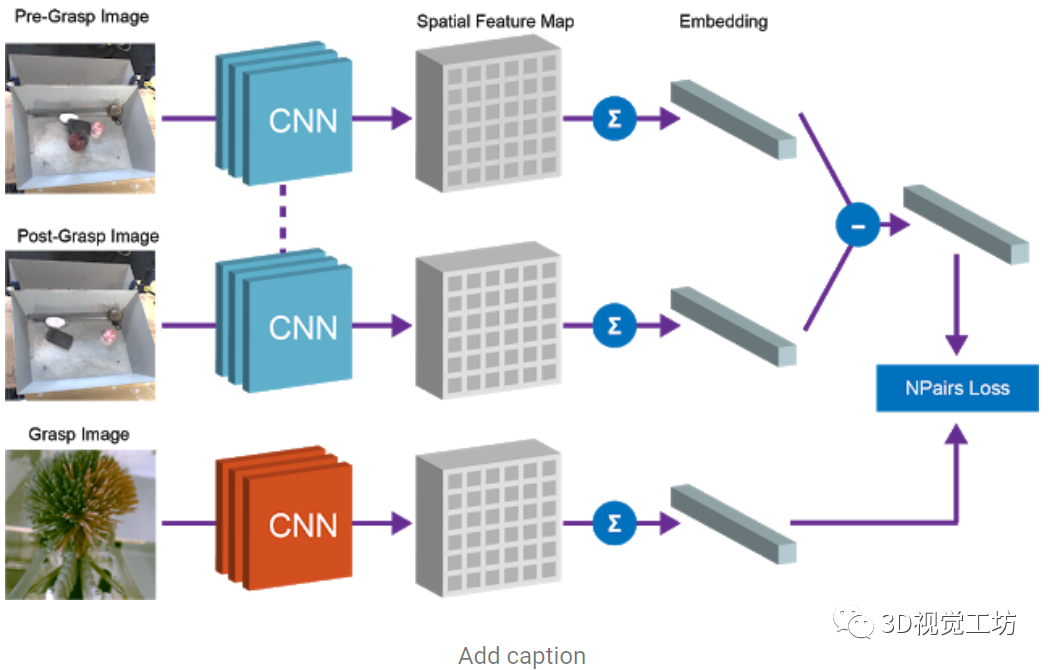

文中使用了全卷積架構和簡單的度量學習算法來實現這種等式關系,特征圖中嵌入抓取前的場景圖像和抓取后的場景圖像,并將其平均池化后保存到向量中,而“抓取前”和“抓取后”向量的差表示一組物體。該向量和對應的被抓取物體的向量表示之間的等價約束是通過N-Pairs目標函數實現的。通過N-Pairs目標函數實現該向量和對應的被抓取物體的向量之間的等價約束關系。

訓練過后,模型中會出現兩個有用的屬性。

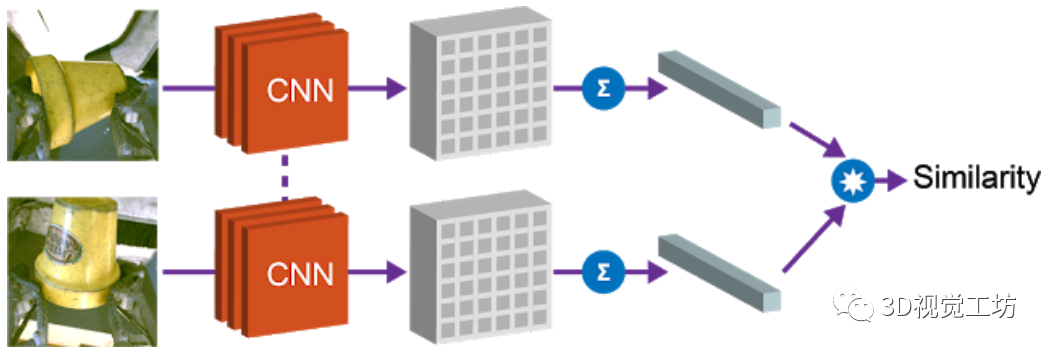

1)物體相似度

第一個屬性是余弦距離,利用向量間的余弦距離對物體進行比較,并確定是否相同。這個屬性可以用于實現強化學習的獎勵函數,并允許機器人在沒有人工提供的標簽的情況下學習實例抓取。

2)目標物體本地化

第二個屬性是,可以組合場景空間映射和物體嵌入來本地化圖像空間中的“查詢對象”。將空間場景的特征圖和查詢對象的向量相乘,以找到兩者之間“匹配”的所有像素。例如下圖中的場景,模型可以檢測出場景中的多個相應的色塊,通過點乘得到的“熱圖”,可用于規劃機器人接近目標物體的方法。

該項目展示了機器人抓取技能如何生成用于學習以物體為中心的表示的數據,并使用表示學習來實現更復雜的技能,例如實例抓取,與此同時保留自主抓取系統中的自監督學習屬性。

2、基于視覺和語音信息的機器人抓取

機器人自然語言理解會需要大量特定性領域和平臺的工程量。例如,移動機器人在特定環境中接收操縱者的命令拾取放置物品,人類可以指定語言為某類命令,并將概念詞與物體對象的屬性進行關聯,例如紅色這樣的概念詞。減輕類似工作量的方法是使環境中的機器人能夠動態適應,不斷學習新的語言構造和感知概念等。在這項工作中,研究人員提出了一種端到端的方法,用于將自然語言命令翻譯為離散的機器人動作,并使用對話框共同明確和改善語義和基礎概念。研究在Amazon Mechanical Turk的虛擬設置上對該目標對象進行訓練和評估,并將該智能體轉移到現實世界中的物理機器人平臺上,進行展示。

隨著機器人在家庭、工廠和醫院等環境中變得無處不在,人類對有效的人機交互的需求也在不斷增長。上述各類場景中會包含特定的詞匯和行為啟示,例如,打開廚房的燈;把托盤往北移6英尺;如果病人的情況有變化,就通知我。因此,預編程機器人的語言理解會需要昂貴的特定性領域和平臺的工程。在本文中,研究人員提出并評估了一種機器人智能體,它可以通過與人類對話的方式擴展一個初始狀態下資源較少、依靠手工編程的語言理解管道,從而與人類伙伴更好地達成共識。

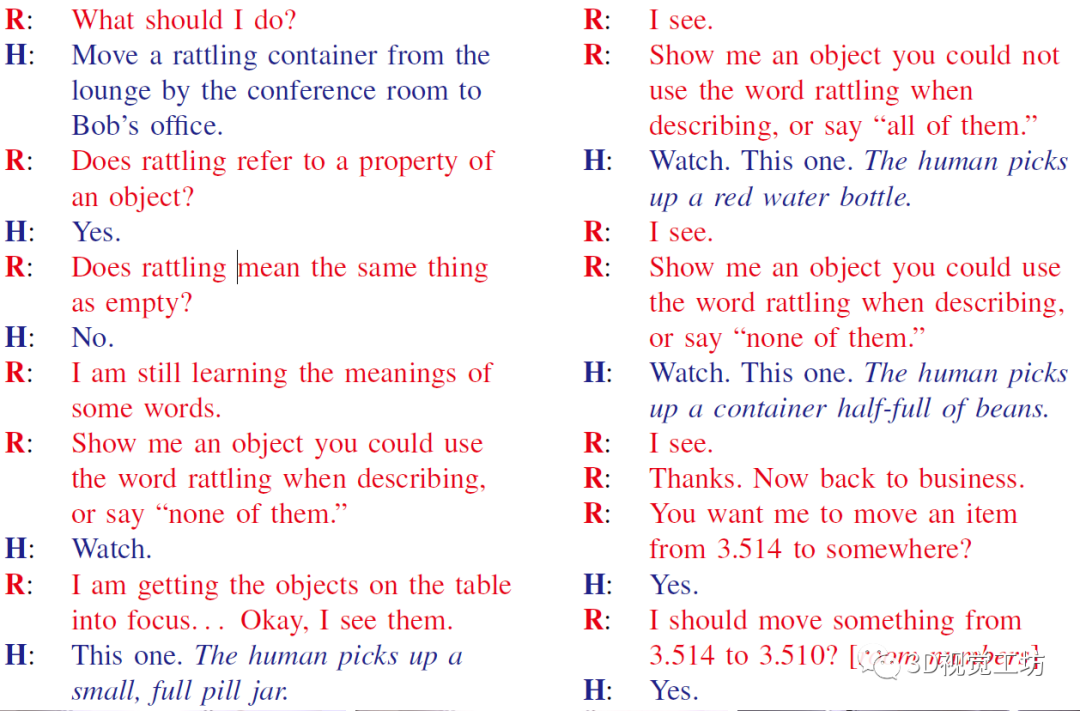

研究人員結合了通過對話的信號進行更好的語義解析(以前不使用物體的感官表征)和主動學習方法來獲取這些概念(以前僅限于對象識別任務)。因此,文中的系統能夠執行自然語言命令,例如將一個能發出叮叮當當響聲的容器從會議室的休息室移到Bob的辦公室,其中包含組成語言(例如,語義分析器理解的會議室休息室以及將由其識別的對象的物理性質,如能發出叮叮當當響聲的容器)。系統僅用少量的用于語義解析的自然語言數據進行初始化,沒有將概念詞與物理對象綁定的初始標簽,而是需要通過人機對話學習解析和接地。

本文的貢獻主要是:1)提出了一種對話策略,僅利用少量初始領域內的訓練數據來提高語言理解;2)利用對話問題在現場實時獲取感知認識,而不是僅從預先標記的數據或過去的交互過程中獲取;3)在一個完整的物理機器人平臺上部署對話智能體。

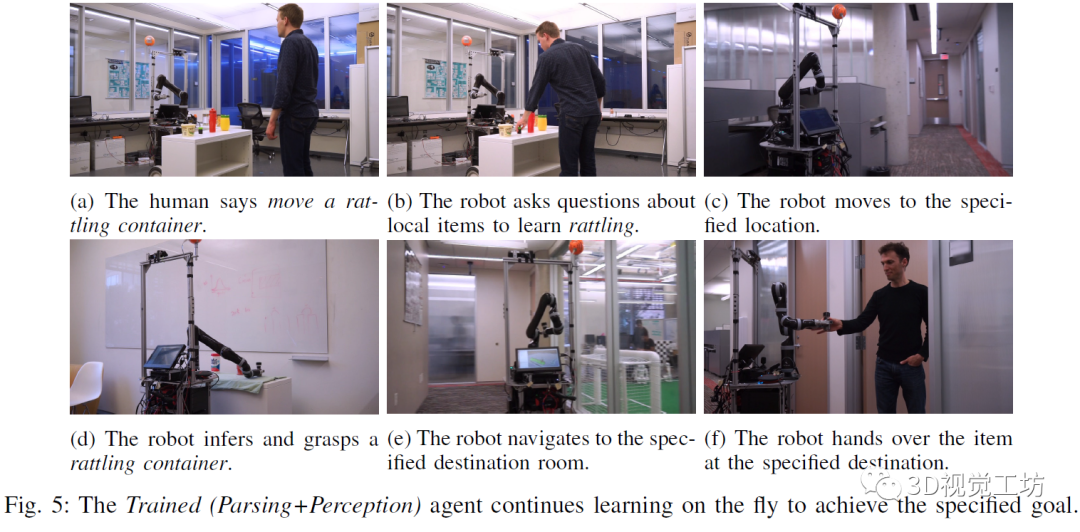

研究人員在Mechanical Turk上評估智能體的學習能力和可用性,要求用戶通過對話指揮智能體去完成三個任務:導航(由廚房去休息室),傳遞(將紅色的罐子拿給Bob),和搬運(將一個空瓶子從廚房休息室轉移到愛麗絲的辦公室)。研究發現,根據之前對話中提取的信息對智能體進行訓練后,它的評價指標會更好。然后,研究人員將經過訓練的智能體轉移到物理機器人上,并在人機對話中演示它的持續學習過程。

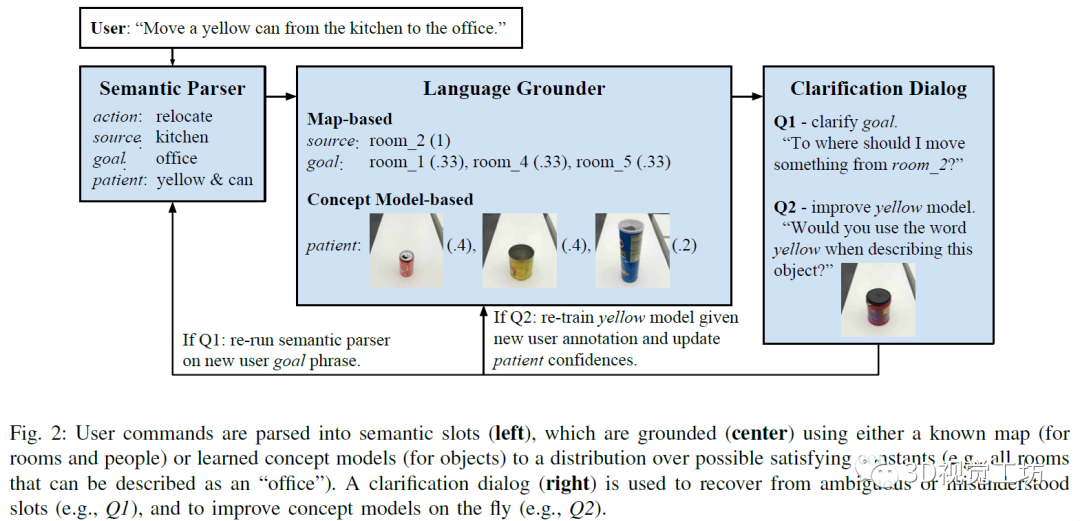

該會話智能體主要通過視覺信息和自然語言結合完成請求。整體主要包括以下幾個部分。

1)語義解析器:智能體通過獲取的單詞序列推斷任務的語義表示,使用組合類別語法(CCG)形式來進行解析。

2)語言接地,根據不同的外部環境,相同的語義也可能會以不同的方式接地。例如,廚房旁邊的辦公室指的是一個物理位置,但這個位置取決于建筑。

3)對話框,人機之間的對話常常從人類用戶開始,指示智能體完成某項任務,智能體會對未觀察到的真實任務進行建模,并使用來自用戶的語言信號推斷該任務。該命令由語義解析和基礎組件處理,以獲得成對的符號和置信狀態值。置信狀態值通過語義解析(例如,“在北邊的辦公室的豆莢”中的介詞歧義;豆莢還是辦公室向北)和語言理解(例如,嘈雜的概念模型)步驟對不確定性進行建模。

4)從對話中學習:該智能體通過在完成的對話中引入訓練數據來改進其語義解析器,智能體能夠將用戶的初始命令與確認的動作進行匹配,從會話中學習語義。同時,采用主動學習的方式,從向用戶提出的問題中快速擴展感知概念模型,然后在各個用戶之間匯總擴展,并且可以將學習到的概念應用于遠程測試對象,有助于獲取新概念。

會話智能體的組成如下圖所示,左側是將用戶的命令進行語義解析,中間為利用已有的地圖和概念模型等信息對指令進行接地,右側是利用對話改進完善智能體的認知模型。

實驗中指定的任務包含:根據用戶指示完成到達指定地點,將物品遞送給某人,將物品從指定地點移動到目的地。下圖為受過訓練的智能體采用動態學習的方式實現指定的目標。

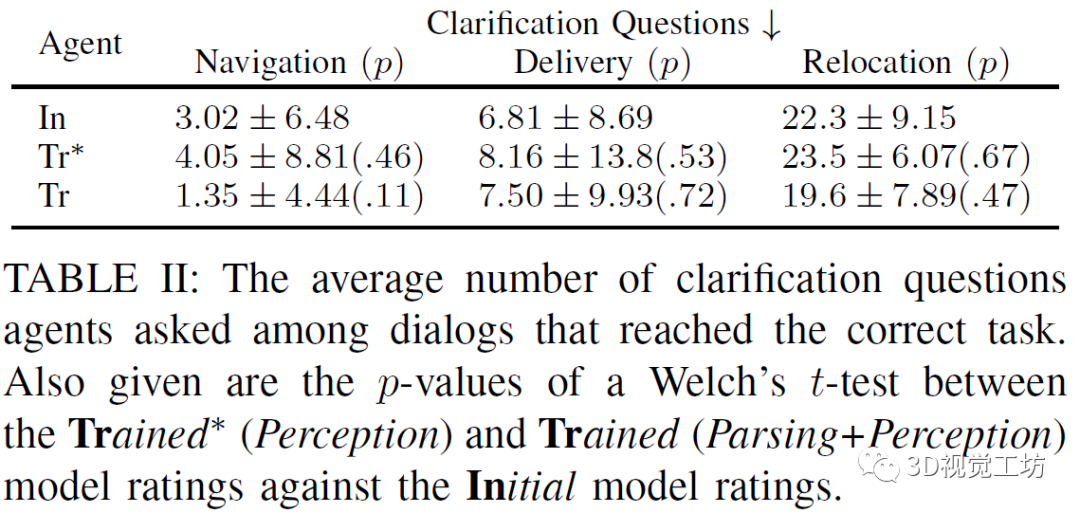

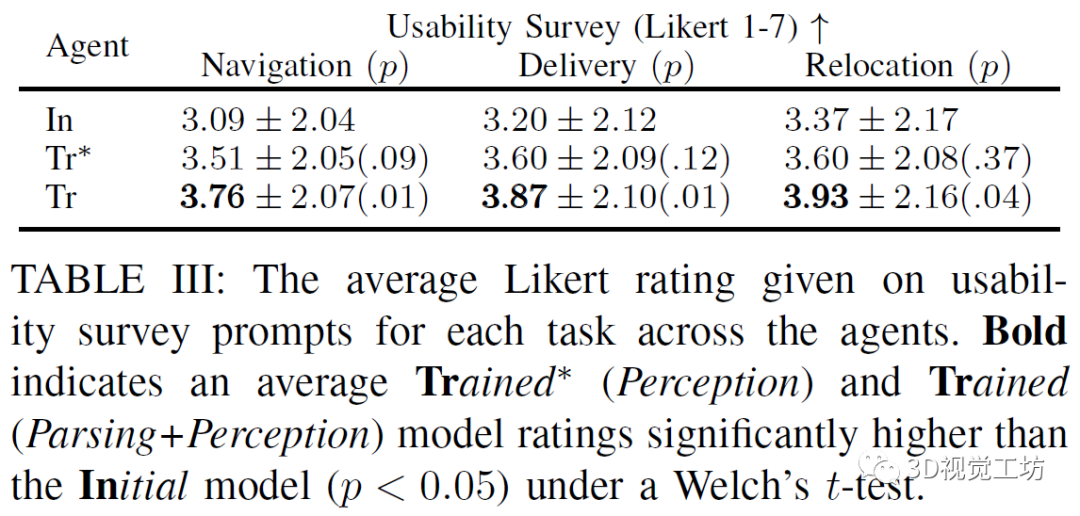

上表比較初始智能體,受過訓練(僅感知訓練)智能體,受過訓練(解析訓練和感知訓練)的智能體三者的實驗情況,衡量的標準是在滿足正確的任務規范之前,需要進行的詢問的問題的個數,實驗顯示受過訓練(僅感知訓練)智能體表現較差,可能是由于對話中的許多形容詞和名詞的屬性沒有及時更新。

上表比較初始智能體,受過訓練(僅感知訓練)智能體,受過訓練(解析訓練和感知訓練)的智能體三者的實驗情況,衡量的標準是用戶對智能體表現的定性的評價,主要包括:我將使用這樣的機器人來幫助導航到一棟新樓;我將會用這樣的機器人為自己或其他人拿取東西;我將會用這樣的機器人來將物品從一個地方移到另一個地方。實驗顯示受過訓練(解析和感知)的智能體的表現最好。

該研究提出了一種機器人智能體,其可以利用與人類的對話來擴展自定義的小型化的語言理解資源,利用這些資源既可以將自然語言命令翻譯為抽象的語義形式,又可以將物理對象的抽象屬性接地。在這項工作中,機器人可以執行的動作可以分解為離散語義角色的元組,但是通常,他們需要推理更多的連續動作空間,并獲取新的、與人類對話中看不見的行為和知識。該研究中的智能體可以從人機對話中學習知識,甚至可以處理復雜的形容詞和名詞之間的依賴和上下文關系。

3、基于視覺和觸覺信息的機器人抓取

人類使用視覺、聽覺和觸覺等多種模式的感覺輸入來感知世界。在這項工作中研究了視覺和觸覺之間的交叉模式連接。跨模態建模任務的主要挑戰在于兩者之間在比例上存在顯著差異:雖然我們的眼睛一次性就可以感知到整個視覺場景,但人類在任何給定時刻只能觸碰感覺到物體的一個小部分。為了連接視覺和觸覺,文中合成來自視覺輸入的合理的觸覺信號,以及想象我們如何與以觸覺數據作為輸入的對象進行交互。為了實現該目標,研究人員首先為機器人配備了視覺和觸覺傳感器,并收集了相應視覺和觸覺圖像序列的大規模數據集。為了縮小規模差距,研究中提出了一個新的條件對抗模型,該模型結合了觸摸的規模和位置信息。人類的感知研究表明,本文中的模型可以從觸覺數據中產生逼真的視覺圖像,反之亦然。最后,展示了有關不同系統設計的定性和定量實驗結果,以及可視化了模型的學習表示。

文中提出了一種跨模態預測方法,用于從觸摸預測視覺,反之亦可。研究人員首先將觸覺中的程度、規模、范圍和位置信息結合在模型中。然后,使用數據平衡的方法多樣化其結果。最后,通過考慮時間信息的方法進一步提高準確性。

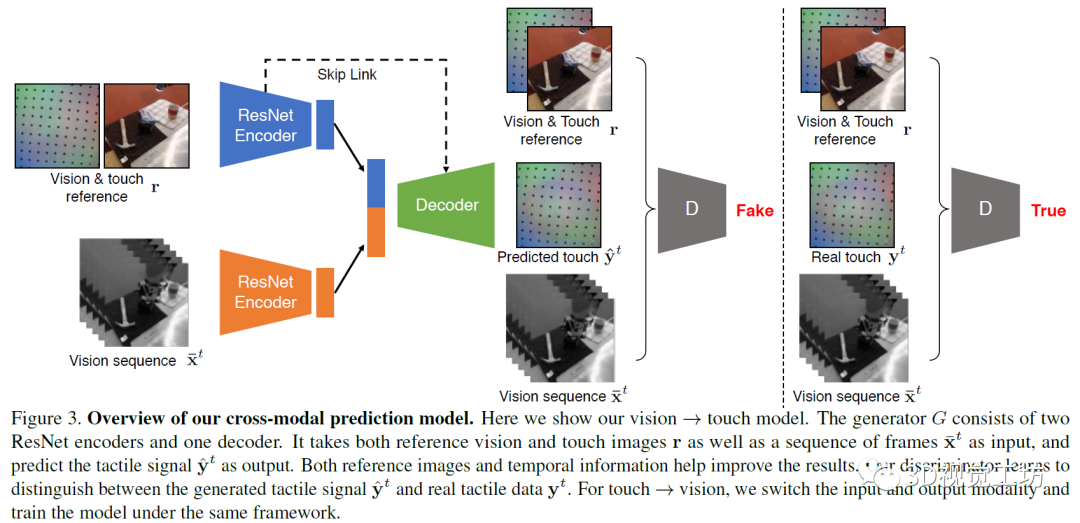

研究中的模型基于pix2pix方法,是一個用于圖像到圖像任務的條件GAN框架。在任務中,生成器接受視覺圖像或觸覺圖像作為輸入,并生成一個對應的觸覺或視覺圖像。而判別器觀察輸入的圖像和輸出的圖像。在訓練中,對判別器進行訓練,以分辨合成圖片和真實圖片之間的差異,而生成器則是用于產生可以欺騙判別器的圖片。在實驗中,研究人員使用視覺-觸覺圖像對訓練模型。在從觸覺還原視覺的任務中,輸入觸覺圖像,而輸出是對應的視覺圖像。而在視覺預測觸覺的任務中,則輸入和輸出對調。

模型使用編碼器-解碼器架構用于生成任務。在編碼器上分別使用兩個ResNet-18模型用于輸入圖像(視覺或觸覺圖像)和參考的視覺-觸覺圖像,將兩個編碼器的向量合并為一個1024維向量,將其輸入解碼器。解碼器包括五層標準的卷積神經網絡,并在編碼器和解碼器間加入了跨層連接,研究中使用的判別器為ConvNets。

研究發現,實驗結果不是很好,圖片中有嚴重的視覺偽影,并且生成的結果與輸入信號不一致。為解決上述問題,研究人員對基本算法進行修改和完善。首先將觸覺和視覺參考圖像提供給生成器和判別器,以便該模型只需要學習為交叉模式變化建模,而不是整個信號。其次,為防止模式崩塌,研究人員采取數據重均衡策略幫助生成器生成不同的模式,性能更加健壯。最后,從輸入視頻的多個相鄰幀而不是僅從當前幀中提取信息,從而產生時間相干的輸出。

研究人員在一個KUKA機械手臂上放置GelSight傳感器,機械臂背面的三腳架上安裝了一個網絡攝像頭,以捕捉機械臂觸摸物體的場景視頻,實驗中讓機械臂去戳弄不同的物體。GelSight表面有一層薄膜,在接觸物體的過程中會發生形變,進而采集到高質量的觸覺數據。研究團隊總共記錄了195件物品的12000次觸碰,這些物品屬于不同類別。每個觸摸動作包含一個250幀的視頻序列,產生了300萬視覺和觸覺成對的圖像的數據集—VisGel。根據此數據集,當模型辨認到接觸位置的形狀和材料,與參考圖像進行比較,以識別觸摸的位置和范圍。

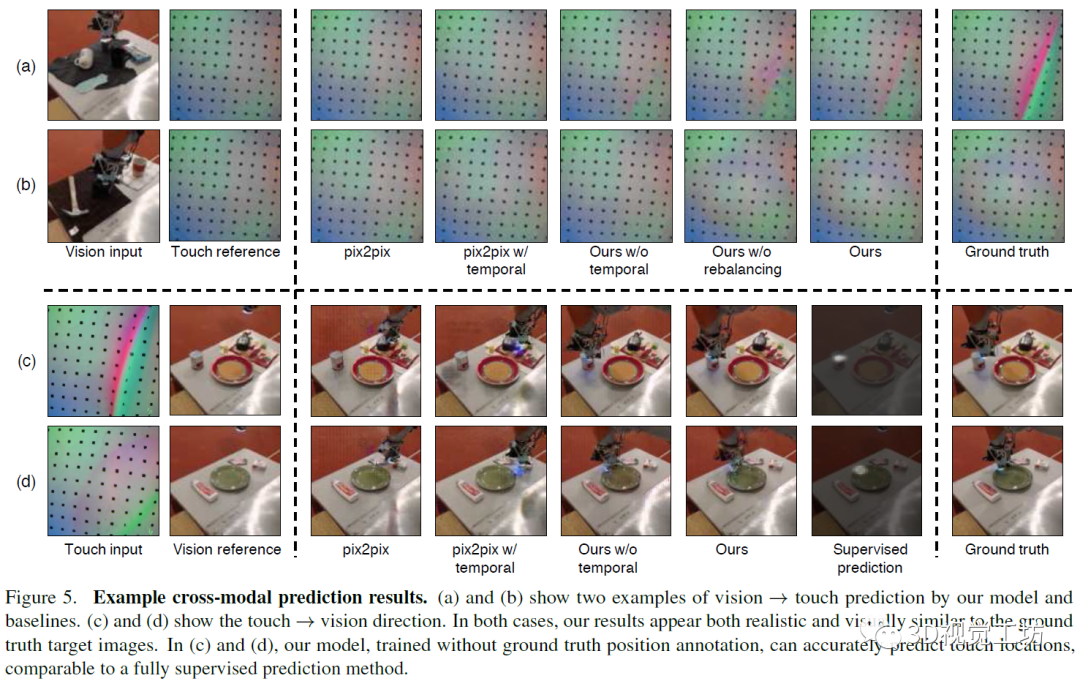

上圖是本文模型和其他基線模型實驗結果的可視化對比,該模型可以更好地根據視覺信息預測物體表面的觸覺信息,也能夠更好地根據觸覺信息還原圖像表面。

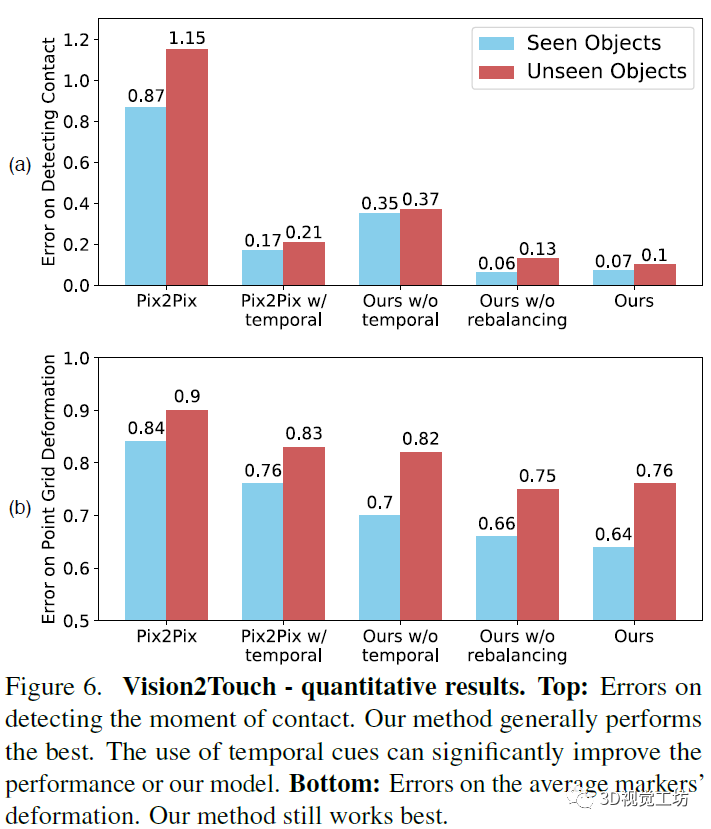

上圖是從視覺到觸覺的量化評測結果。a圖的評價指標是測試機器人是否已經認知到觸摸了物體表面的錯誤數。b圖的評價指標是根據圖像還原觸覺點位置的失真錯誤情況。本文中的模型表現優于其它模型。

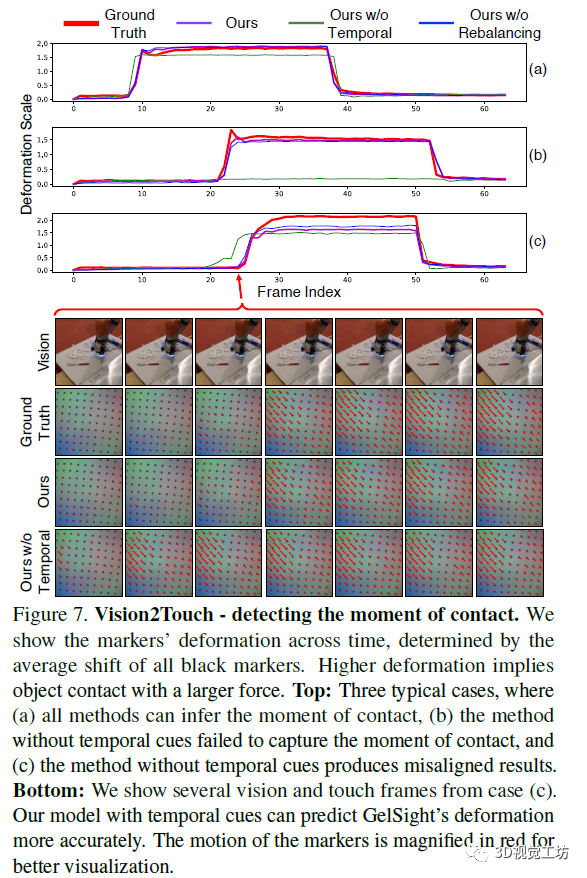

上圖是從視覺還原觸覺的情況,其中顯示了標記隨時間的變形,該變形由所有黑色標記的平均位移確定,較高的變形意味著物體以較大的力接觸。下圖是根據圖像還原的觸覺點陣信息,為便于增強可視化的效果,圖片中的標記的運動以紅色放大。

該項工作提出了在視覺和觸覺與條件對抗網絡之間建立聯系。當與外界互動時,人類非常依賴視覺和觸覺的感官方式。該模型可以為已知物體和未知物體進行跨模態的預測。研究人員認為在將來,視觸交叉的模式可以幫助視覺和機器人技術應用,例如在弱光環境下的物體識別和抓取以及物理場景理解。

審核編輯:劉清

-

機器人

+關注

關注

213文章

29504瀏覽量

211621 -

計算機視覺

+關注

關注

9文章

1706瀏覽量

46580 -

機器人控制

+關注

關注

0文章

15瀏覽量

6800

原文標題:一文帶你了解基于視覺的機器人抓取自學習(Robot Learning)

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

機器人視覺——機器人的“眼睛”

【MYD-CZU3EG開發板試用申請】基于機器視覺的工業機器人抓取工作站

【瑞芯微RK1808計算棒試用申請】基于機器視覺的工業機器人抓取工作站

如何讓電機自學習?

如何設計具有自學習循路功能的輪式移動機器人模型的方法資料說明

一文解析工業機器人視覺檢測系統

淺談機器人視覺抓取的目的

基于視覺的自主導航移動抓取機器人搭建方案

一文帶你了解基于視覺的機器人抓取自學習

一文帶你了解基于視覺的機器人抓取自學習

評論