為什么仿佛一夜之間,自然語言處理(NLP)領(lǐng)域就突然突飛猛進(jìn),摸到了通用人工智能的門檻?如今的大語言模型(LLM)發(fā)展到了什么程度?未來短時間內(nèi),AGI 的發(fā)展路線又將如何?

自 20 世紀(jì) 50 年代圖靈測試提出以來,人們始終在探索機(jī)器處理語言智能的能力。語言本質(zhì)上是一個錯綜復(fù)雜的人類表達(dá)系統(tǒng),受到語法規(guī)則的約束。因此,開發(fā)能夠理解和精通語言的強(qiáng)大 AI 算法面臨著巨大挑戰(zhàn)。過去二十年,語言建模方法被廣泛用于語言理解和生成,包括統(tǒng)計語言模型和神經(jīng)語言模型。

近些年,研究人員通過在大規(guī)模語料庫上預(yù)訓(xùn)練 Transformer 模型產(chǎn)生了預(yù)訓(xùn)練語言模型(PLMs),并在解決各類 NLP 任務(wù)上展現(xiàn)出了強(qiáng)大的能力。并且研究人員發(fā)現(xiàn)模型縮放可以帶來性能提升,因此他們通過將模型規(guī)模增大進(jìn)一步研究縮放的效果。有趣的是,當(dāng)參數(shù)規(guī)模超過一定水平時,這個更大的語言模型實(shí)現(xiàn)了顯著的性能提升,并出現(xiàn)了小模型中不存在的能力,比如上下文學(xué)習(xí)。為了區(qū)別于 PLM,這類模型被稱為大型語言模型(LLMs)。

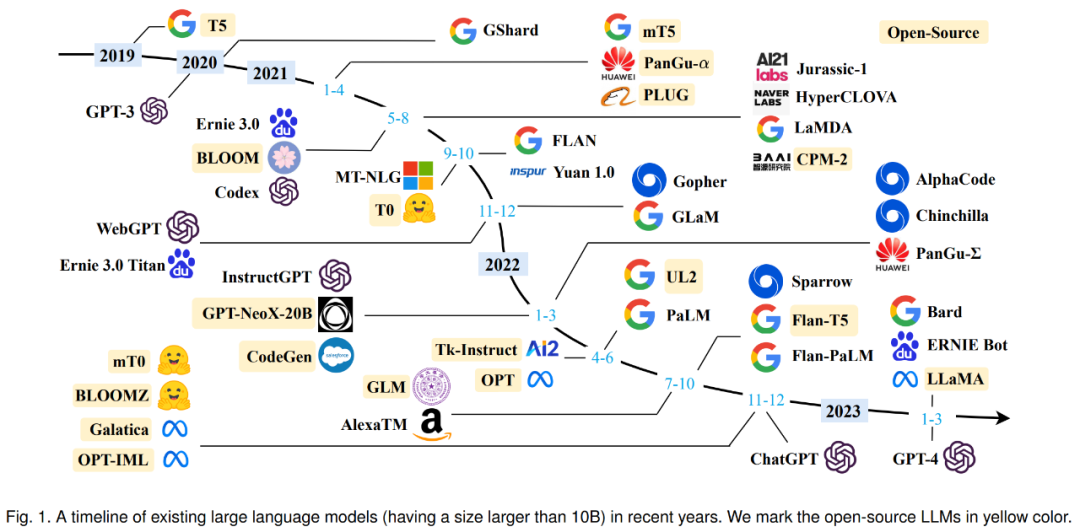

從 2019 年的谷歌 T5 到 OpenAI GPT 系列,參數(shù)量爆炸的大模型不斷涌現(xiàn)。可以說,LLMs 的研究在學(xué)界和業(yè)界都得到了很大的推進(jìn),尤其去年 11 月底對話大模型 ChatGPT 的出現(xiàn)更是引起了社會各界的廣泛關(guān)注。LLMs 的技術(shù)進(jìn)展對整個 AI 社區(qū)產(chǎn)生了重要影響,并將徹底改變?nèi)藗冮_發(fā)和使用 AI 算法的方式。

考慮到 LLMs 的快速技術(shù)進(jìn)步,中國人民大學(xué)的二十幾位研究者通過背景知識、關(guān)鍵發(fā)現(xiàn)和主流技術(shù)等三方面回顧了 LLMs 的最新進(jìn)展,尤其關(guān)注 LLMs 的預(yù)訓(xùn)練、自適應(yīng)調(diào)優(yōu)、使用和能力評估。此外他們還總結(jié)和開發(fā) LLMs 的可用資源,討論了未來發(fā)展方向等問題。對于領(lǐng)域內(nèi)研究人員和工程師而言,這份綜述是一份極其有用的學(xué)習(xí)資源。

論文鏈接:https://arxiv.org/abs/2303.18223

在進(jìn)入正文前,我們先來看 2019 年以來出現(xiàn)的各種大語言模型(百億參數(shù)以上)時間軸,其中標(biāo)黃的大模型已開源。

LLMs 概覽

在第一節(jié)中,研究者詳細(xì)介紹了 LLMs 的背景、能力和關(guān)鍵技術(shù)。

LLMs 的背景

通常,大型語言模型(LLM)是指包含數(shù)千億(或更多)參數(shù)的語言模型,這些參數(shù)是在大量文本數(shù)據(jù)上訓(xùn)練的,例如模型 GPT-3、PaLM、Galactica 和 LLaMA。具體來說,LLM 建立在 Transformer 架構(gòu)之上,其中多頭注意力層堆疊在一個非常深的神經(jīng)網(wǎng)絡(luò)中。現(xiàn)有的 LLM 主要采用與小語言模型類似的模型架構(gòu)(即 Transformer)和預(yù)訓(xùn)練目標(biāo)(即語言建模)。作為主要區(qū)別,LLM 在很大程度上擴(kuò)展了模型大小、預(yù)訓(xùn)練數(shù)據(jù)和總計算量(擴(kuò)大倍數(shù))。他們可以更好地理解自然語言,并根據(jù)給定的上下文(例如 prompt)生成高質(zhì)量的文本。這種容量改進(jìn)可以用標(biāo)度律進(jìn)行部分地描述,其中性能大致遵循模型大小的大幅增加而增加。然而根據(jù)標(biāo)度律,某些能力(例如,上下文學(xué)習(xí))是不可預(yù)測的,只有當(dāng)模型大小超過某個水平時才能觀察到。

LLMs 的涌現(xiàn)能力

LLM 的涌現(xiàn)能力被正式定義為「在小型模型中不存在但在大型模型中出現(xiàn)的能力」,這是 LLM 與以前的 PLM 區(qū)分開來的最顯著特征之一。當(dāng)出現(xiàn)這種新的能力時,它還引入了一個顯著的特征:當(dāng)規(guī)模達(dá)到一定水平時,性能顯著高于隨機(jī)的狀態(tài)。以此類推,這種新模式與物理學(xué)中的相變現(xiàn)象密切相關(guān)。原則上,這種能力也可以與一些復(fù)雜的任務(wù)有關(guān),而人們更關(guān)心可以應(yīng)用于解決多個任務(wù)的通用能力。這里簡要介紹了 LLM 的三種代表性的涌現(xiàn)能力:

上下文學(xué)習(xí)。GPT-3 正式引入了上下文學(xué)習(xí)能力:假設(shè)語言模型已經(jīng)提供了自然語言指令和多個任務(wù)描述,它可以通過完成輸入文本的詞序列來生成測試實(shí)例的預(yù)期輸出,而無需額外的訓(xùn)練或梯度更新。

指令遵循。通過對自然語言描述(即指令)格式化的多任務(wù)數(shù)據(jù)集的混合進(jìn)行微調(diào),LLM 在微小的任務(wù)上表現(xiàn)良好,這些任務(wù)也以指令的形式所描述。這種能力下,指令調(diào)優(yōu)使 LLM 能夠在不使用顯式樣本的情況下通過理解任務(wù)指令來執(zhí)行新任務(wù),這可以大大提高泛化能力。

循序漸進(jìn)的推理。對于小語言模型,通常很難解決涉及多個推理步驟的復(fù)雜任務(wù),例如數(shù)學(xué)學(xué)科單詞問題。同時,通過思維鏈推理策略,LLM 可以通過利用涉及中間推理步驟的 prompt 機(jī)制來解決此類任務(wù)得出最終答案。據(jù)推測,這種能力可能是通過代碼訓(xùn)練獲得的。

關(guān)鍵技術(shù)

接下來來看 LLMs 的關(guān)鍵技術(shù),包括了縮放、訓(xùn)練、能力激發(fā)、對齊調(diào)優(yōu)、工具利用等。

縮放。縮放是增加 LLMs 模型容量的關(guān)鍵因素,最開始 GPT-3 將模型參數(shù)增至 1750 億,隨后 PaLM 進(jìn)一步將模型參數(shù)增至 5400 億。大規(guī)模參數(shù)對于涌現(xiàn)能力至關(guān)重要。縮放不僅針對模型大小,還與數(shù)據(jù)大小和總計算量有關(guān)。

訓(xùn)練。由于規(guī)模巨大,成功訓(xùn)練一個具備強(qiáng)大能力的 LLMs 非常具有挑戰(zhàn)性。因此需要分布式訓(xùn)練算法來學(xué)習(xí) LLMs 的網(wǎng)絡(luò)參數(shù),經(jīng)常聯(lián)合使用各種并行策略。為了支持分布式訓(xùn)練,DeepSpeed 和 Megatron-LM 等優(yōu)化框架被用來促進(jìn)并行算法的實(shí)現(xiàn)和部署。此外,優(yōu)化技巧對訓(xùn)練穩(wěn)定性和模型性能也很重要,例如重新啟動訓(xùn)練損失尖峰和混合精度訓(xùn)練。最近的 GPT-4 開發(fā)了特殊的基礎(chǔ)設(shè)施和優(yōu)化方法,從而利用小得多的模型來預(yù)測大模型的性能。

能力激發(fā)。在大規(guī)模語料庫上經(jīng)過預(yù)訓(xùn)練后,LLMs 被賦予了解決一般任務(wù)的潛在能力。然而當(dāng) LLMs 執(zhí)行某個特定任務(wù)時,這些能力可能不會顯式地表現(xiàn)出來。因此設(shè)計適合的任務(wù)指令或特定的上下文策略來激發(fā)這些能力非常有用,比如思維鏈 prompt 有助于通過中間推理步驟等解決復(fù)雜推理任務(wù)。此外還可以進(jìn)一步對具有自然語言任務(wù)描述的 LLMs 進(jìn)行指令調(diào)優(yōu),以提高對未見過任務(wù)的泛化能力。

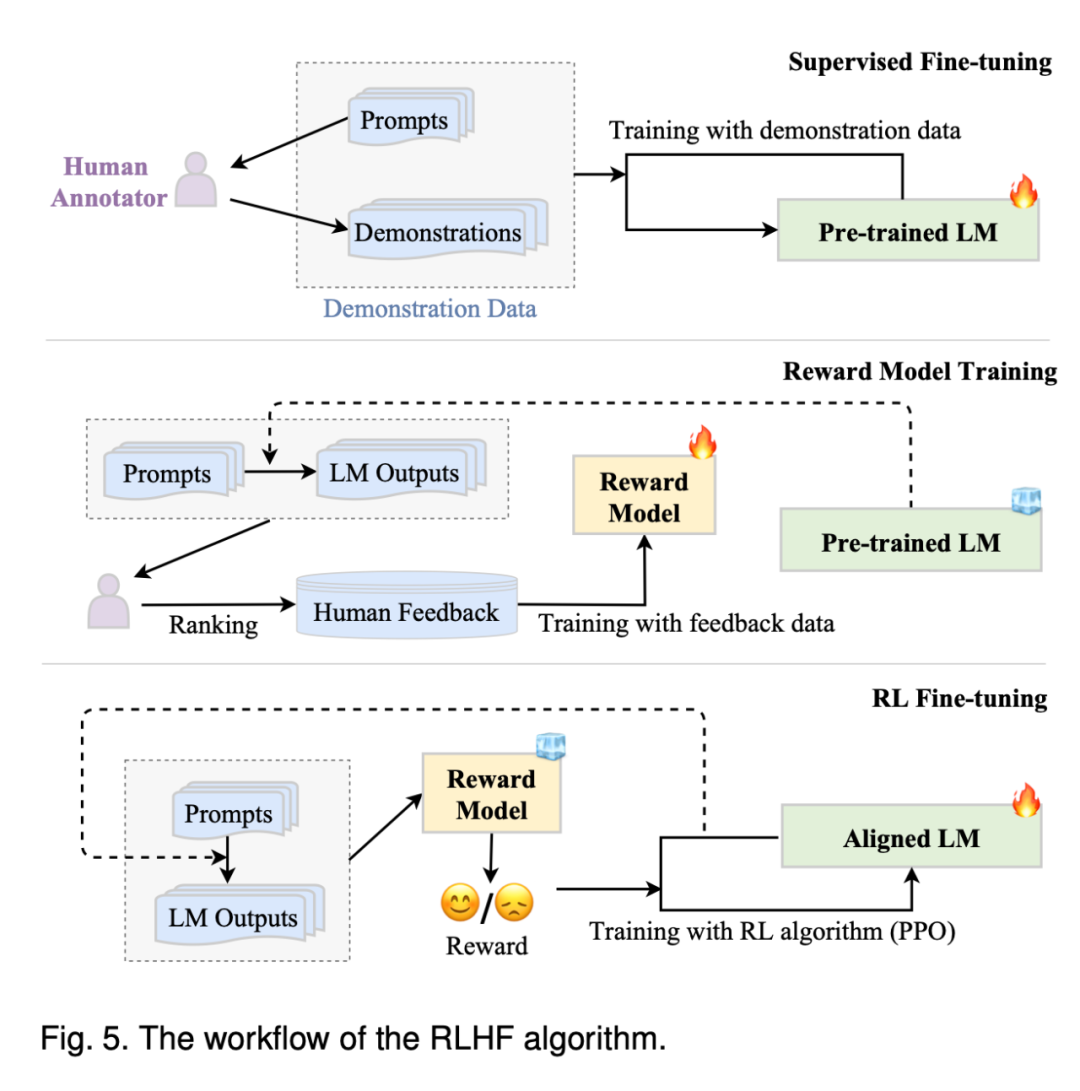

對齊調(diào)優(yōu)。由于 LLMs 被訓(xùn)練用來捕獲預(yù)訓(xùn)練語料庫的數(shù)據(jù)特征(包括高質(zhì)量和低質(zhì)量的數(shù)據(jù)),它們很可能生成對有毒、有偏見和有害的文本內(nèi)容。為了使 LLMs 與人類價值觀保持一致,InstructGPT 設(shè)計了一種利用強(qiáng)化學(xué)習(xí)和人類反饋的高效調(diào)優(yōu)方法,使得 LLMs 能夠遵循預(yù)期指令。ChatGPT 是在類似 InstructGPT 的技術(shù)上開發(fā)的,在產(chǎn)生高質(zhì)量、無害的響應(yīng)方面表現(xiàn)出了強(qiáng)大的對齊能力。

工具利用。LLMs 本質(zhì)上是基于大規(guī)模純文本語料庫訓(xùn)練的文本生成器,因此在數(shù)值計算等文本表達(dá)不佳的任務(wù)上表現(xiàn)沒那么好。此外 LLMs 的能力受限于預(yù)訓(xùn)練數(shù)據(jù),無法捕獲最新信息。針對這些問題,人們提出使用外部工具來彌補(bǔ) LLMs 的不足,比如可以利用計算器進(jìn)行精確計算,使用搜索引擎檢索未知信息。ChatGPT 更是利用外部插件來聯(lián)網(wǎng)學(xué)習(xí)新知識,這種機(jī)制可以廣泛擴(kuò)展 LLMs 的能力范圍。

LLMs 資源

考慮到具有挑戰(zhàn)性的技術(shù)問題和巨大的計算資源需求,開發(fā)或復(fù)制 LLMs 絕不是一件容易的事情。一個可行的方法是從現(xiàn)有的 LLMs 中學(xué)習(xí)經(jīng)驗(yàn),并重新使用公開的資源來進(jìn)行漸進(jìn)式的開發(fā)或?qū)嶒?yàn)研究。

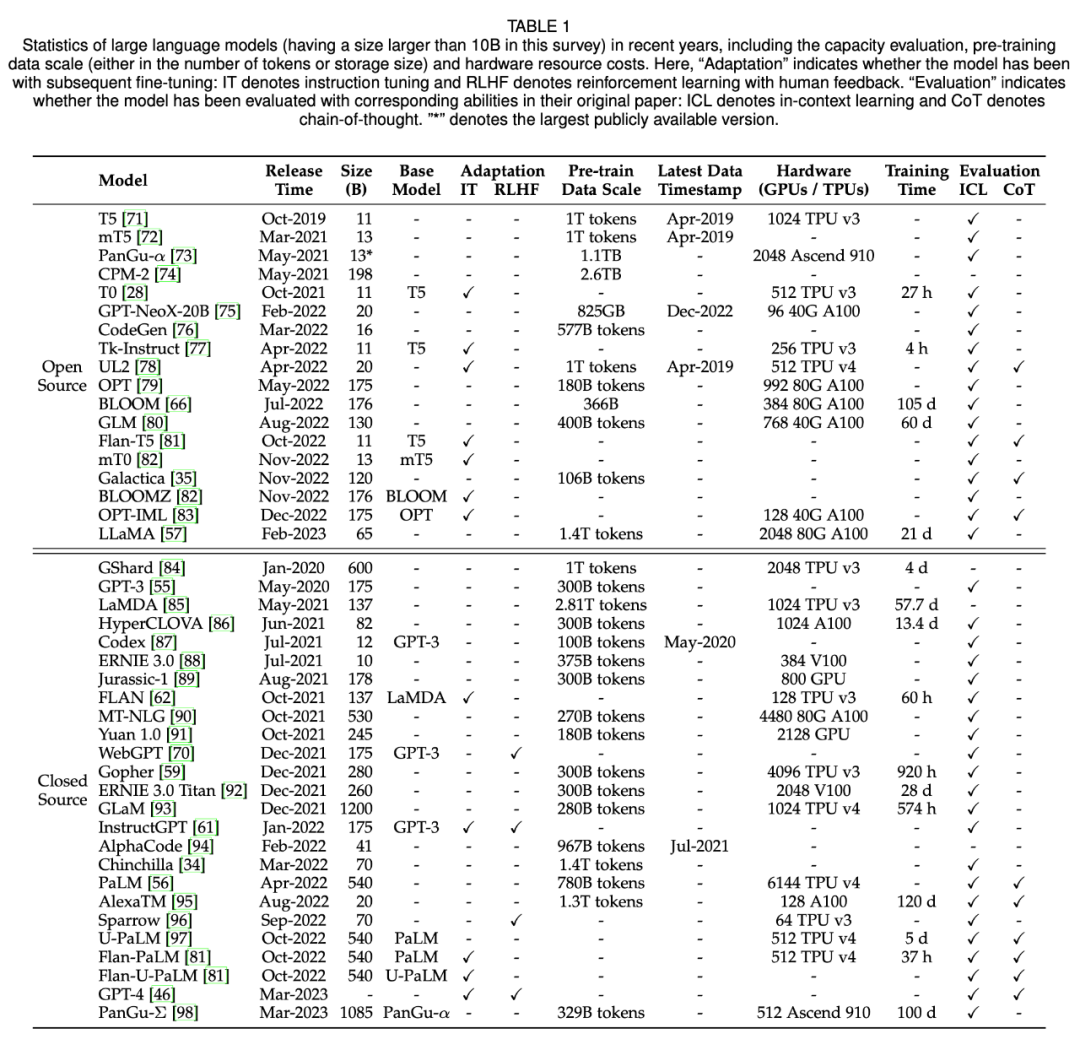

在第三節(jié)中,研究者主要總結(jié)了開源的模型檢查點(diǎn)或 API、可用的語料庫以及對 LLM 有用的庫。下表 1 為近年來百億參數(shù)以上大模型的統(tǒng)計數(shù)據(jù)。

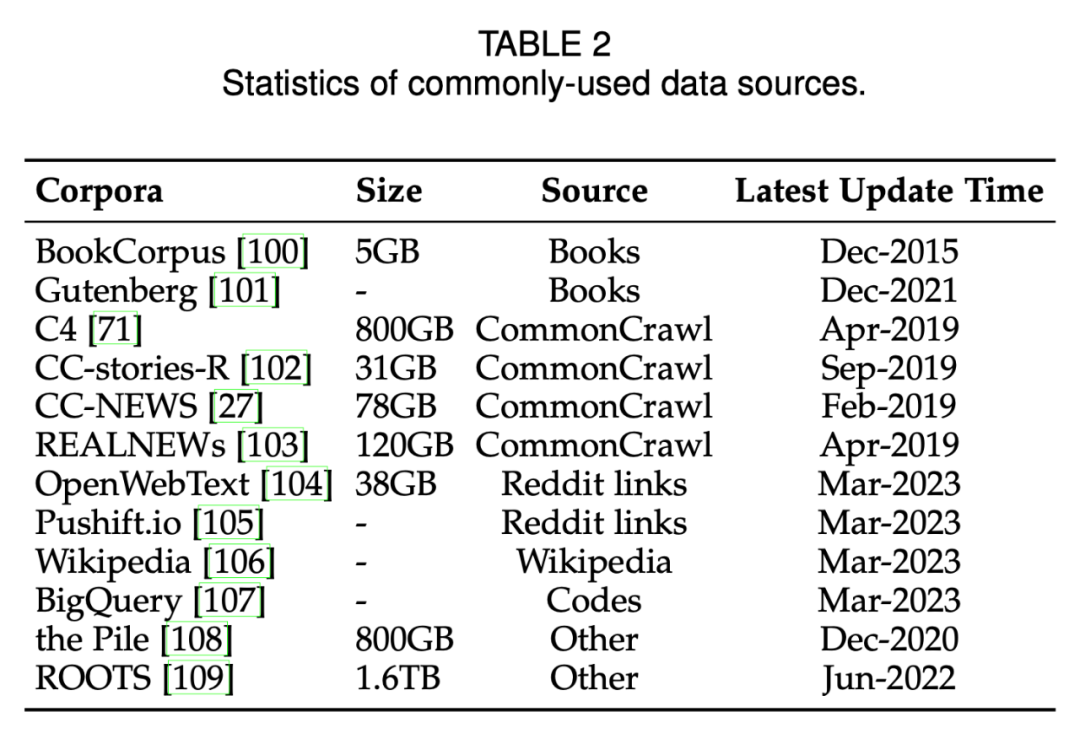

下表 2 列出了常用的數(shù)據(jù)源。

預(yù)訓(xùn)練

預(yù)訓(xùn)練建立了 LLMs 的能力基礎(chǔ)。通過對大規(guī)模語料庫的預(yù)訓(xùn)練,LLMs 可以獲得基本的語言理解和生成技能。在這個過程中,預(yù)訓(xùn)練語料庫的規(guī)模和質(zhì)量是 LLMs 獲得強(qiáng)大能力的關(guān)鍵。此外,為了有效地預(yù)訓(xùn)練 LLMs,模型架構(gòu)、加速方法和優(yōu)化技術(shù)都需要精心設(shè)計。在第四節(jié)中,研究者首先在第 4.1 節(jié)討論了數(shù)據(jù)的收集和處理,然后在第 4.2 節(jié)介紹了常用的模型架構(gòu),最后在第 4.3 節(jié)介紹了穩(wěn)定和有效優(yōu)化 LLMs 的訓(xùn)練技術(shù)。

數(shù)據(jù)收集

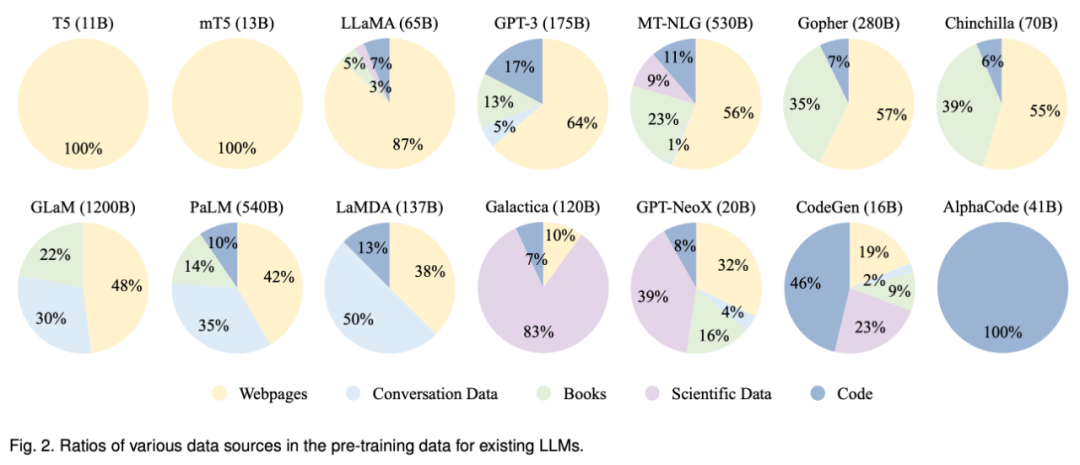

要開發(fā)一個強(qiáng)大的 LLM,從各種數(shù)據(jù)源中收集大量的自然語言語料至關(guān)重要。現(xiàn)有 LLMs 主要利用各種公共文本數(shù)據(jù)集作為預(yù)訓(xùn)練語料庫。下圖 2 列出了現(xiàn)有 LLMs 的預(yù)訓(xùn)練數(shù)據(jù)源分布。

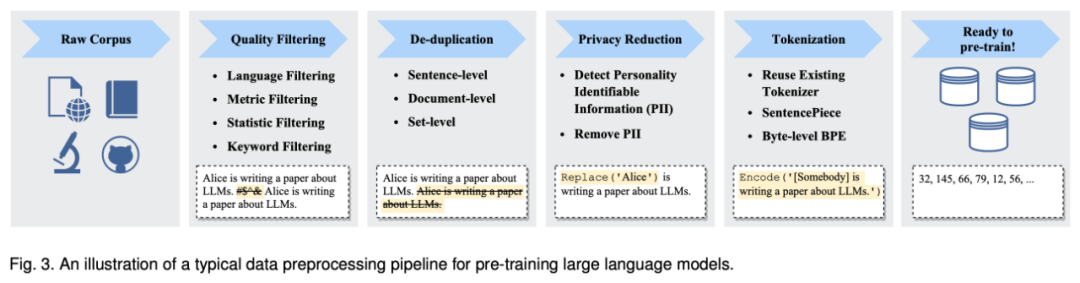

收集大量文本數(shù)據(jù)后,必須對它們進(jìn)行預(yù)訓(xùn)練以構(gòu)建預(yù)訓(xùn)練語料庫,包括去噪、去冗余、去除不相關(guān)和潛在有毒的數(shù)據(jù)。下圖 3 展示了為 LLMs 預(yù)訓(xùn)練數(shù)據(jù)的預(yù)處理 pipeline。

架構(gòu)

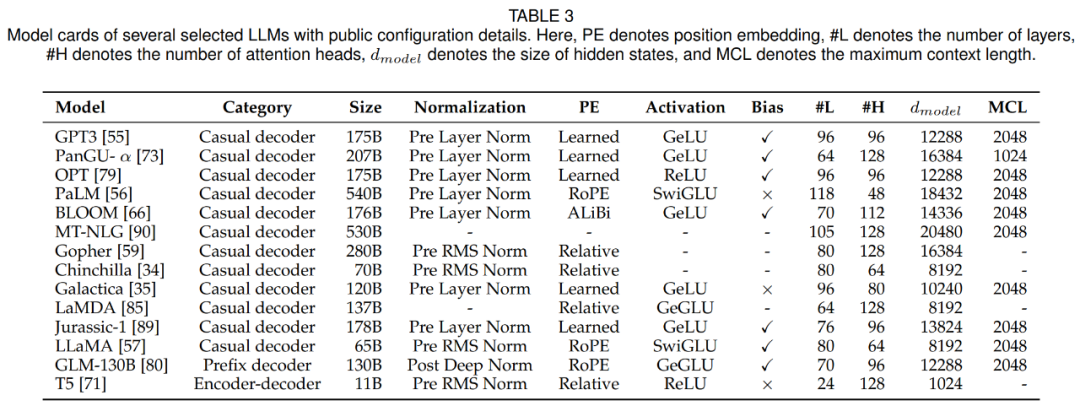

在本節(jié)中,研究者回顧了 LLMs 的架構(gòu)設(shè)計,即主流架構(gòu),預(yù)訓(xùn)練目標(biāo)和細(xì)節(jié)配置。下表 3 列出了幾個具有代表性的 LLMs 的模型卡片以及公開的詳細(xì)信息。

由于出色的并行化性和容量,Transformer 架構(gòu)已成為開發(fā)各種 LLM 的 backbone,使得將語言模型擴(kuò)展到數(shù)千億個參數(shù)成為可能。一般來說,現(xiàn)有 LLMs 的主流架構(gòu)大致可以分為三大類,即編碼器 - 解碼器、臨時解碼器和前綴解碼器。

自 Transformer 出現(xiàn)以來,各種改進(jìn)被相繼提出以提高其訓(xùn)練穩(wěn)定性,性能和計算效率。在這一部分中,研究者討論了 Transformer 四個主要部分的相應(yīng)配置,包括歸一化、位置編碼、激活函數(shù)、注意力機(jī)制和偏置。

預(yù)訓(xùn)練起著十分關(guān)鍵的作用,它將一般知識從大規(guī)模語料庫編碼到大規(guī)模模型參數(shù)中。對于訓(xùn)練 LLMs,有語言建模和去噪自編碼兩個常用的預(yù)訓(xùn)練任務(wù)。

模型訓(xùn)練

在這一部分中,研究者回顧了訓(xùn)練 LLMs 的重要設(shè)置,技術(shù)和訓(xùn)練 LLMs 技巧。

對于 LLMs 的參數(shù)優(yōu)化,研究者提出了常用的批量訓(xùn)練、學(xué)習(xí)率、優(yōu)化器和訓(xùn)練穩(wěn)定性的設(shè)置。

隨著模型和數(shù)據(jù)規(guī)模的增加,在有限的計算資源下有效地訓(xùn)練 LLMs 模型已經(jīng)變得困難。特別是,需要解決兩個主要技術(shù)問題,例如通過輸入增加訓(xùn)練和將更大的模型加載到 GPU 內(nèi)存中。這一部分回顧了現(xiàn)有工作中幾種廣泛使用的方法,以解決上述兩個挑戰(zhàn),即 3D 并行、ZeRO 和混合精度訓(xùn)練,并就如何利用它們進(jìn)行訓(xùn)練給出了建議。

LLMs 的適應(yīng)性調(diào)優(yōu)

經(jīng)過預(yù)訓(xùn)練,LLMs 可以獲得解決各種任務(wù)的通用能力。然而越來越多的研究表明,LLMs 的能力可以根據(jù)具體目標(biāo)進(jìn)一步調(diào)整。在第五節(jié)中,研究者詳細(xì)介紹了調(diào)整預(yù)訓(xùn)練 LLMs 的兩個主要方法,即指令調(diào)優(yōu)(instruction tuning)和對齊調(diào)優(yōu)(alignment tuning)。前一種方法主要是為了提高或解鎖 LLMs 的能力,而后一種方法則是為了使 LLMs 的行為與人類的價值觀或偏好一致。

指令調(diào)優(yōu)

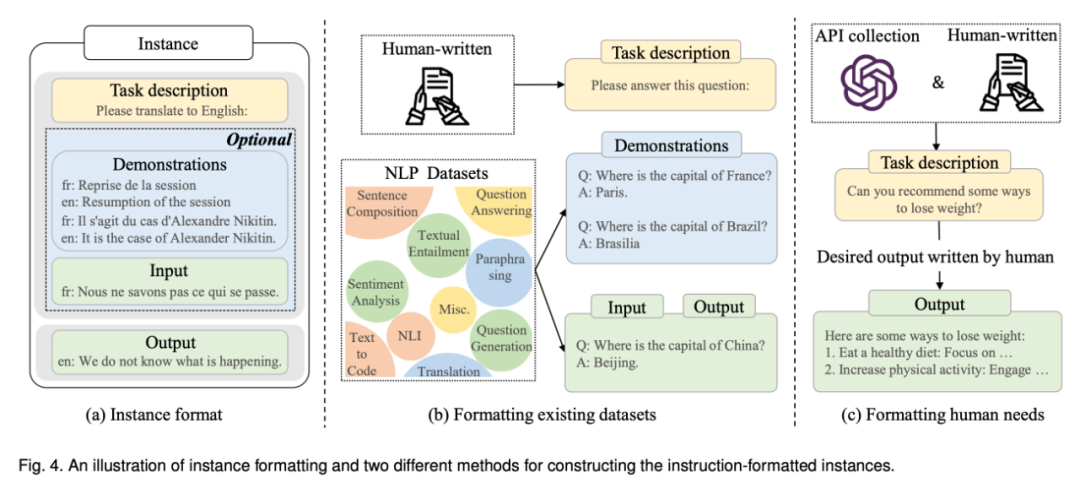

本質(zhì)上,指令調(diào)優(yōu)是在自然語言形式的格式化實(shí)例集合上微調(diào)預(yù)訓(xùn)練 LLMs 的方法,這與監(jiān)督微調(diào)和多任務(wù)提示訓(xùn)練高度相關(guān)。為了執(zhí)行指令調(diào)優(yōu),我們首先需要收集或構(gòu)建指令格式的實(shí)例。然后,我們通常使用這些格式化實(shí)例以監(jiān)督學(xué)習(xí)方式微調(diào) LLMs(例如,使用序列到序列損失進(jìn)行訓(xùn)練)。在指令調(diào)整后,LLMs 可以展示出卓越的能力,泛化出能解決未見任務(wù)的能力,即使在多語言環(huán)境中也是如此。

最近的一項(xiàng)調(diào)查對指令調(diào)優(yōu)研究進(jìn)行了系統(tǒng)的概述。相比之下,本文主要關(guān)注指令調(diào)優(yōu)對 LLMs 的影響,并提供實(shí)例收集和調(diào)優(yōu)的詳細(xì)指南或策略。此外,本文還討論了使用指令調(diào)優(yōu)來滿足用戶的實(shí)際需求,這已廣泛應(yīng)用于現(xiàn)有的 LLMs,例如 InstructGPT 和 GPT-4。

格式化實(shí)例構(gòu)建:通常,指令格式的實(shí)例由任務(wù)描述(稱為指令)、輸入輸出對和少量演示(可選)組成。作為重要的公共資源,現(xiàn)有研究已經(jīng)發(fā)布了大量以自然語言格式化的標(biāo)記數(shù)據(jù)(參見表 5 中的可用資源列表)。接下來,本文將介紹構(gòu)造格式化實(shí)例的兩種主要方法(參見圖 4 中的插圖),然后討論實(shí)例構(gòu)造的幾個關(guān)鍵因素。

指令調(diào)優(yōu)策略:與預(yù)訓(xùn)練不同,指令調(diào)優(yōu)通常更有效,因?yàn)橹挥羞m度數(shù)量的實(shí)例用于訓(xùn)練。雖然指令調(diào)優(yōu)可以被認(rèn)為是一個有監(jiān)督的訓(xùn)練過程,但它的優(yōu)化在幾個方面與預(yù)訓(xùn)練不同,例如訓(xùn)練目標(biāo)(即序列到序列損失)和優(yōu)化配置(例如更小的批次) 大小和學(xué)習(xí)率),這在實(shí)踐中需要特別注意。除了這些優(yōu)化配置之外,指令調(diào)優(yōu)還需要考慮兩個重要方面:

平衡數(shù)據(jù)分布。

結(jié)合指令調(diào)優(yōu)和預(yù)訓(xùn)練。

對齊調(diào)優(yōu)

這部分首先介紹了對齊的背景及其定義和標(biāo)準(zhǔn),然后重點(diǎn)介紹了用于對齊 LLMs 的人類反饋數(shù)據(jù)的收集,最后討論了用于對齊調(diào)整的人類反饋強(qiáng)化學(xué)習(xí)的關(guān)鍵技術(shù)。

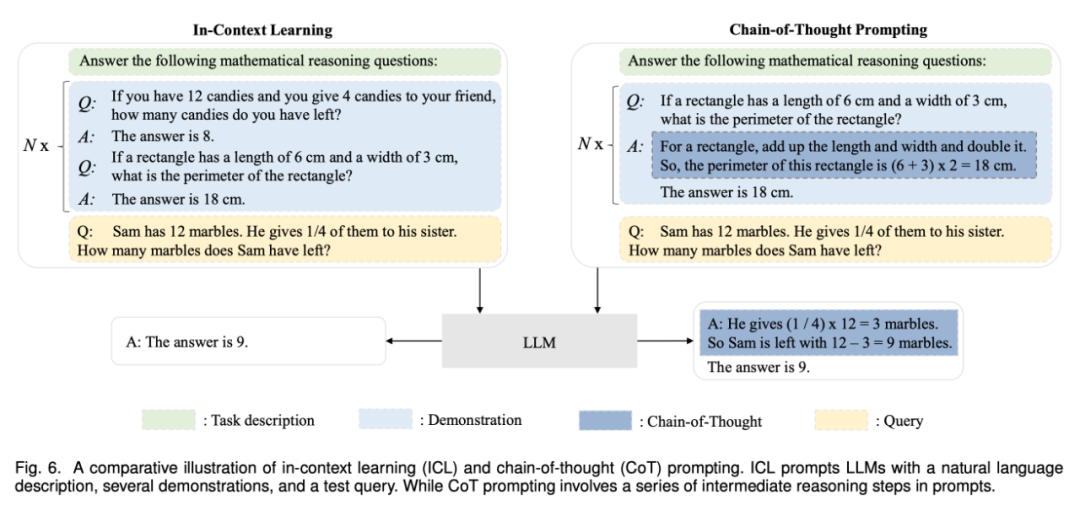

使用

在預(yù)訓(xùn)練或適應(yīng)性調(diào)整之后,使用 LLMs 的一個主要方法是為解決各種任務(wù)設(shè)計合適的 prompt 策略。一個典型的 prompt 方法是上下文學(xué)習(xí)(in-context learning),它以自然語言文本的形式制定了任務(wù)描述或演示。此外,思維鏈 prompting 方法可以通過將一系列中間推理步驟納入 prompt 中來加強(qiáng)上下文學(xué)習(xí)。在第六節(jié)中,研究者詳細(xì)介紹了這兩種技術(shù)的細(xì)節(jié)。

上下文學(xué)習(xí)

作為一種特殊的 prompt 形式,上下文學(xué)習(xí)(ICL)是 GPT-3 首次提出的,它已經(jīng)成為利用 LLMs 的一種典型方法。

思維鏈 prompt

思維鏈(CoT)是一種改進(jìn)的 prompt 策略,可以提高 LLM 在復(fù)雜推理任務(wù)中的表現(xiàn),如算術(shù)推理、常識推理和符號推理。CoT 不是像 ICL 那樣簡單地用輸入 - 輸出對來構(gòu)建 prompt,而是將能夠?qū)е伦罱K輸出的中間推理步驟納入 prompt。在第 6.2 節(jié)中,研究者詳細(xì)說明了 CoT 與 ICL 的用法,并討論 CoT 何時有效以及為何有效。

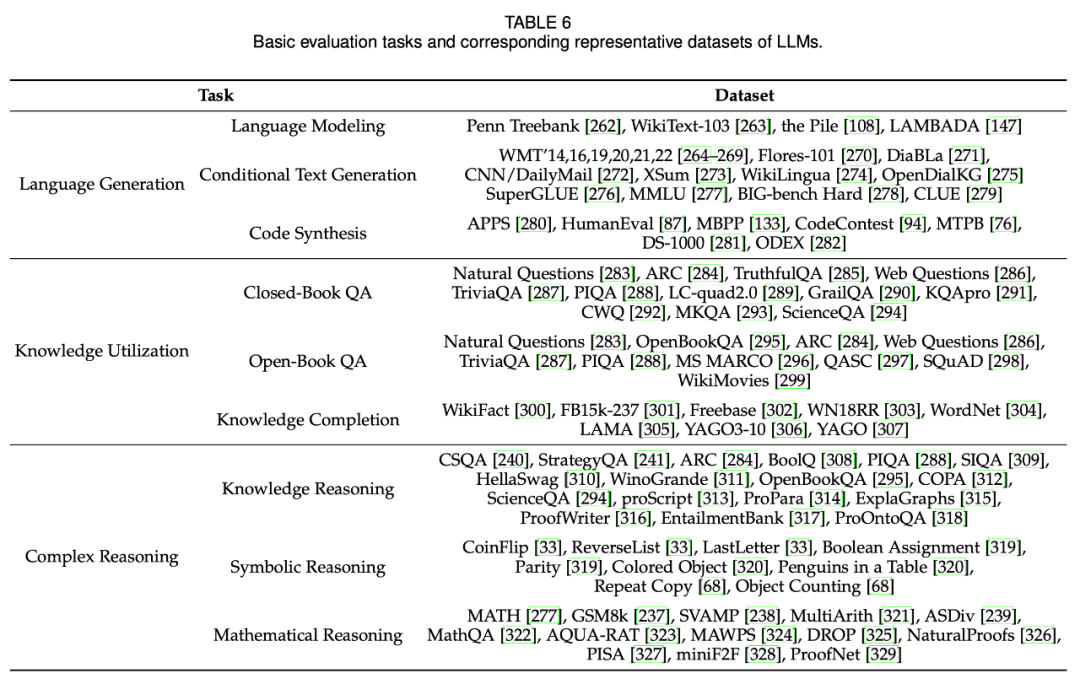

能力評估

為了研究 LLMs 的有效性和優(yōu)越性,研究者利用了大量的任務(wù)和基準(zhǔn)來進(jìn)行實(shí)證評估和分析。第七節(jié)首先介紹了三種用于語言生成和理解的 LLMs 的基本評估任務(wù),然后介紹幾種具有更復(fù)雜設(shè)置或目標(biāo)的 LLMs 的高級任務(wù),最后討論了現(xiàn)有的基準(zhǔn)和實(shí)證分析。

基本評估任務(wù)

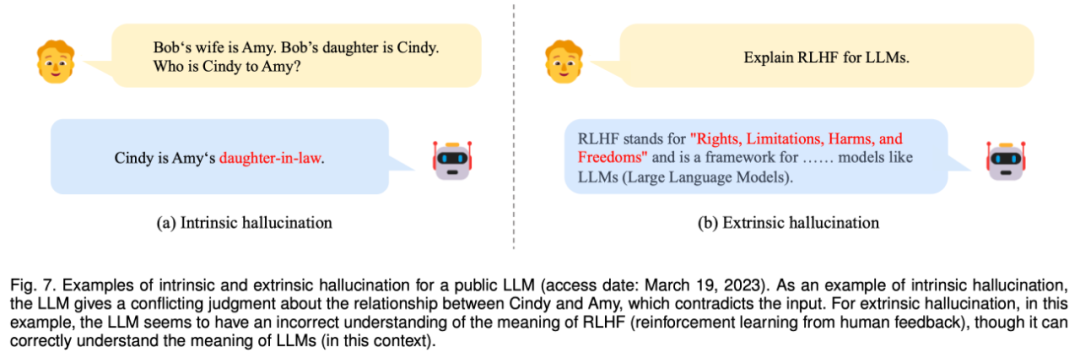

圖 7:一個公開 LLM 的內(nèi)在和外在幻覺的例子(訪問日期:2023 年 3 月 19 日)。作為內(nèi)在幻覺的例子,LLM 對 Cindy 和 Amy 之間的關(guān)系給出了一個與輸入相矛盾的判斷。對于外在幻覺,在這個例子中,LLM 似乎對 RLHF(從人類反饋中強(qiáng)化學(xué)習(xí))的含義有不正確的理解,盡管它能正確理解 LLM 的含義。

高級任務(wù)評估

除了上述基本評估任務(wù),LLMs 還表現(xiàn)出一些高級能力,需要特別評估。在第 7.2 節(jié)中,研究者討論了幾個有代表性的高級能力和相應(yīng)的評價方法,包括人工對齊、與外部環(huán)境的交互以及工具的操作。

總結(jié)與未來方向

在最后一節(jié)中,研究者總結(jié)了這次調(diào)查的討論,并從以下幾個方面介紹了 LLMs 的挑戰(zhàn)和未來發(fā)展方向。

理論和原理:為了理解 LLM 的基本工作機(jī)制,最大的謎團(tuán)之一是信息如何通過非常大的深度神經(jīng)網(wǎng)絡(luò)進(jìn)行分配、組織和利用。揭示建立 LLMs 能力基礎(chǔ)的基本原則或元素是很重要的。特別是,縮放似乎在提高 LLMs 的能力方面發(fā)揮了重要作用。已有研究表明,當(dāng)語言模型的參數(shù)規(guī)模增加到一個臨界點(diǎn)(如 10B)時,一些新興能力會以一種意想不到的方式出現(xiàn)(性能的突然飛躍),典型的包括上下文學(xué)習(xí)、指令跟隨和分步推理。這些「涌現(xiàn)」的能力令人著迷,但也令人困惑:LLMs 何時以及如何獲得這些能力?最近的一些研究要么是進(jìn)行廣泛的體驗(yàn),調(diào)查新興能力的效果和這些能力的促成因素,要么是用現(xiàn)有的理論框架解釋一些特定的能力。一個有見地的技術(shù)帖子將 GPT 系列模型作為目標(biāo)也專門討論了這個話題,然而仍然缺少更正式的理論和原則來理解、描述和解釋 LLM 的能力或行為。由于涌現(xiàn)能力與自然界中的相變有著密切的相似性,跨學(xué)科的理論或原則(例如 LLMs 是否可以被視為某種復(fù)雜系統(tǒng))可能對解釋和理解 LLMs 的行為有幫助。這些基本問題值得研究界探索,對于開發(fā)下一代的 LLMs 很重要。

模型架構(gòu):由于可擴(kuò)展性和有效性,由堆疊的多頭自注意力層組成的 Transformer 已經(jīng)成為構(gòu)建 LLMs 的普遍架構(gòu)。人們提出了各種策略來提高這個架構(gòu)的性能,如神經(jīng)網(wǎng)絡(luò)配置和可擴(kuò)展的并行訓(xùn)練(見 4.2.2 節(jié)討論)。為了進(jìn)一步提高模型的容量(如多輪對話能力),現(xiàn)有的 LLMs 通常保持較長的上下文長度,例如,GPT-4-32k 具有 32768 個 token 的超大上下文長度。因此,一個實(shí)際的考慮是減少標(biāo)準(zhǔn)的自注意力機(jī)制所產(chǎn)生的時間復(fù)雜性(原始的二次成本)。

此外,研究更高效的 Transformer 變體對構(gòu)建 LLMs 的影響是很重要的,例如稀疏注意力已經(jīng)被用于 GPT-3。災(zāi)難性遺忘也一直是神經(jīng)網(wǎng)絡(luò)的挑戰(zhàn),這也對 LLMs 產(chǎn)生了負(fù)面影響。當(dāng)用新的數(shù)據(jù)調(diào)整 LLMs 時,原先學(xué)到的知識很可能被破壞,例如根據(jù)一些特定的任務(wù)對 LLMs 進(jìn)行微調(diào)會影響它們的通用能力。當(dāng) LLMs 與人類的價值觀相一致時,也會出現(xiàn)類似的情況,這被稱為對齊稅(alignment tax)。因此有必要考慮用更靈活的機(jī)制或模塊來擴(kuò)展現(xiàn)有的架構(gòu),以有效支持?jǐn)?shù)據(jù)更新和任務(wù)專業(yè)化。

模型訓(xùn)練:在實(shí)踐中,由于巨大的計算量以及對數(shù)據(jù)質(zhì)量和訓(xùn)練技巧的敏感性,預(yù)訓(xùn)練可用的 LLMs 非常困難。因此,考慮到模型有效性、效率優(yōu)化和訓(xùn)練穩(wěn)定性等因素,開發(fā)更系統(tǒng)、更經(jīng)濟(jì)的預(yù)訓(xùn)練方法來優(yōu)化 LLMs 變得尤為重要。開發(fā)更多的模型檢查或性能診斷方法(例如 GPT-4 中的可預(yù)測縮放),便于在訓(xùn)練中發(fā)現(xiàn)早期的異常問題。此外,它還要求有更靈活的硬件支持或資源調(diào)度機(jī)制,以便更好地組織和利用計算集群中的資源。由于從頭開始預(yù)訓(xùn)練 LLMs 的成本很高,因此必須設(shè)計一個合適的機(jī)制,根據(jù)公開的模型檢查點(diǎn)(例如 LLaMA 和 Flan-T5)不斷地預(yù)訓(xùn)練或微調(diào) LLMs。為此,必須解決一些技術(shù)問題,包括數(shù)據(jù)不一致、災(zāi)難性遺忘和任務(wù)專業(yè)化。到目前為止,仍然缺乏具有完整的預(yù)處理和訓(xùn)練日志(例如準(zhǔn)備預(yù)訓(xùn)練數(shù)據(jù)的腳本)的開源模型檢查點(diǎn)以供重現(xiàn)的 LLM。為 LLMs 的研究提供更多的開源模型將是非常有價值的。此外,開發(fā)更多的改進(jìn)調(diào)整策略和研究有效激發(fā)模型能力的機(jī)制也很重要。

模型的使用:由于微調(diào)在實(shí)際應(yīng)用中的成本很高,prompt 已經(jīng)成為使用 LLMs 的突出方法。通過將任務(wù)描述和演示例子結(jié)合到 prompt 中,上下文學(xué)習(xí)(prompt 的一種特殊形式)賦予了 LLMs 在新任務(wù)上良好的表現(xiàn),甚至在某些情況下超過了全數(shù)據(jù)微調(diào)模型。此外,為了提高復(fù)雜推理的能力,人們提出了先進(jìn)的 prompt 技術(shù),例如思維鏈(CoT)策略,它將中間的推理步驟納入 prompt。然而,現(xiàn)有的 prompt 方法仍然有以下幾個不足之處。首先,它在設(shè)計 prompt 時需要大量的人力,因此為解決各種任務(wù)而自動生成有效的 prompt 將非常有用;其次,一些復(fù)雜的任務(wù)(如形式證明和數(shù)字計算)需要特定的知識或邏輯規(guī)則,而這些知識或規(guī)則可能無法用自然語言描述或用例子來證明,因此開發(fā)信息量更大、更靈活的任務(wù)格式化的 prompt 方法很重要;第三,現(xiàn)有的 prompt 策略主要集中在單圈的表現(xiàn)上,因此開發(fā)用于解決復(fù)雜任務(wù)的交互式 prompt 機(jī)制(如通過自然語言對話)非常有用,ChatGPT 已經(jīng)證明了這一點(diǎn)。

安全和對齊:盡管 LLMs 具備相當(dāng)?shù)哪芰Γ陌踩珕栴}與小型語言模型相似。例如,LLMs 表現(xiàn)出產(chǎn)生幻覺文本的傾向,比如那些看似合理但可能與事實(shí)不符的文本。更糟糕的是,LLMs 可能被有意的指令激發(fā),為惡意的系統(tǒng)產(chǎn)生有害的、有偏見的或有毒的文本,導(dǎo)致濫用的潛在風(fēng)險。要詳細(xì)討論 LLMs 的其他安全問題(如隱私、過度依賴、虛假信息和影響操作),讀者可以參考 GPT-3/4 技術(shù)報告。作為避免這些問題的主要方法,來自人類反饋的強(qiáng)化學(xué)習(xí)(RLHF)已被廣泛使用,它將人類納入訓(xùn)練循環(huán),以發(fā)展良好的 LLMs。為了提高模型的安全性,在 RLHF 過程中加入安全相關(guān)的 prompt 也很重要,如 GPT-4 所示。然而,RLHF 在很大程度上依賴于專業(yè)標(biāo)簽人員的高質(zhì)量的人類反饋數(shù)據(jù),使得它很難在實(shí)踐中得到正確的實(shí)施。因此,有必要改進(jìn) RLHF 框架,以減少人類標(biāo)簽員的工作,并尋求一種更有效的注釋方法,保證數(shù)據(jù)質(zhì)量,例如可以采用 LLMs 來協(xié)助標(biāo)注工作。最近,紅色團(tuán)隊(duì)被采用來提高 LLMs 的模型安全性,它利用收集的對抗性 prompt 來完善 LLMs(即避免紅色團(tuán)隊(duì)的攻擊)。此外,通過與人類交流建立 LLMs 的學(xué)習(xí)機(jī)制也很有意義,人類通過聊天給出的反饋可以直接被 LLMs 利用來進(jìn)行自我完善。

應(yīng)用和生態(tài)系統(tǒng):由于 LLMs 在解決各種任務(wù)方面表現(xiàn)出強(qiáng)大的能力,它們可以被應(yīng)用于廣泛的現(xiàn)實(shí)世界的應(yīng)用(例如,遵循特定的自然語言指令)。作為一個顯著的進(jìn)步,ChatGPT 已經(jīng)潛在地改變了人類獲取信息的方式,這帶來了新必應(yīng)的發(fā)布。在不久的將來,可以預(yù)見,LLMs 將對信息搜索技術(shù)產(chǎn)生重大影響,包括搜索引擎和識別系統(tǒng)。

此外,隨著 LLMs 的技術(shù)升級,智能信息助理的發(fā)展和使用將得到極大的促進(jìn)。在更廣泛的范圍內(nèi),這一波技術(shù)創(chuàng)新傾向于建立一個由 LLMs 授權(quán)的應(yīng)用程序的生態(tài)系統(tǒng)(例如,ChatGPT 對插件的支持),這將與人類生活密切相關(guān)。最后,LLMs 的崛起為通用人工智能(AGI)的探索提供了啟示。它有希望開發(fā)出比以往更多的智能系統(tǒng)(可能有多模態(tài)信號)。同時,在這個發(fā)展過程中,人工智能的安全性應(yīng)該是首要關(guān)注的問題之一,也就是說,讓人工智能為人類帶來好處而不是壞處。

審核編輯 :李倩

-

語言模型

+關(guān)注

關(guān)注

0文章

558瀏覽量

10681 -

nlp

+關(guān)注

關(guān)注

1文章

490瀏覽量

22488

原文標(biāo)題:大型語言模型綜述全新出爐!從T5到GPT-4最全盤點(diǎn),國內(nèi)20余位研究者聯(lián)合撰寫

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

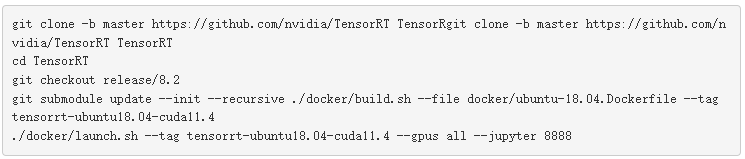

使用NVIDIA TensorRT優(yōu)化T5和GPT-2

GPT-4發(fā)布!多領(lǐng)域超越“人類水平”,專家:國內(nèi)落后2-3年

ChatGPT升級 OpenAI史上最強(qiáng)大模型GPT-4發(fā)布

語言模型GPT-4在北京高考題目上的測試結(jié)果

最新、最強(qiáng)大的模型GPT-4將向美國政府機(jī)構(gòu)開放

人工通用智能的火花:GPT-4的早期實(shí)驗(yàn)

GPT-4已經(jīng)會自己設(shè)計芯片了嗎?

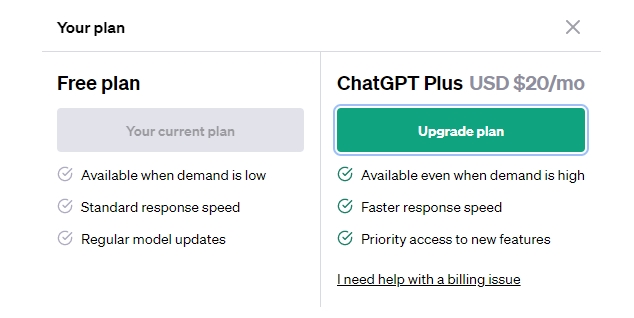

GPT-3.5 vs GPT-4:ChatGPT Plus 值得訂閱費(fèi)嗎 國內(nèi)怎么付費(fèi)?

GPT-4沒有推理能力嗎?

OpenAI最新大模型曝光!劍指多模態(tài),GPT-4之后最大升級!

ChatGPT plus有什么功能?OpenAI 發(fā)布 GPT-4 Turbo 目前我們所知道的功能

大型語言模型綜述全新出爐!從T5到GPT-4最全盤點(diǎn)

大型語言模型綜述全新出爐!從T5到GPT-4最全盤點(diǎn)

評論