1

LLama

[GPT3] 使用RMSNorm(即Root Mean square Layer Normalization)對輸入數據進行標準化,RMSNorm可以參考論文:Root mean square layer normalization。

[PaLM]使用激活函數SwiGLU, 該函數可以參考PALM論文:Glu variants improve transformer。

[GPTNeo]使用Rotary Embeddings進行位置編碼,該編碼可以參考論文 Roformer: Enhanced transformer with rotary position embedding。

使用了AdamW優化器,并使用cosine learning rate schedule,

使用因果多頭注意的有效實現來減少內存使用和運行時間。該實現可在xformers

2

Palm

采用SwiGLU激活函數:用于 MLP 中間激活,采用SwiGLU激活函數:用于 MLP 中間激活,因為與標準 ReLU、GELU 或 Swish 激活相比,《GLU Variants Improve Transformer》論文里提到:SwiGLU 已被證明可以顯著提高模型效果

提出Parallel Layers:每個 Transformer 結構中的“并行”公式:與 GPT-J-6B 中一樣,使用的是標準“序列化”公式。并行公式使大規模訓練速度提高了大約 15%。消融實驗顯示在 8B 參數量下模型效果下降很小,但在 62B 參數量下沒有模型效果下降的現象。

Multi-Query Attention:每個頭共享鍵/值的映射,即“key”和“value”被投影到 [1, h],但“query”仍被投影到形狀 [k, h],這種操作對模型質量和訓練速度沒有影響,但在自回歸解碼時間上有效節省了成本。

使用RoPE embeddings:使用的不是絕對或相對位置嵌入,而是RoPE,是因為 RoPE 嵌入在長文本上具有更好的性能 ,

采用Shared Input-Output Embeddings:輸入和輸出embedding矩陣是共享的,這個我理解類似于word2vec的輸入W和輸出W':

3

GLM

Layer Normalization的順序和殘差連接被重新排列,

用于輸出標記預測的單個線性層;

ReLU s替換為GELU s

二維位置編碼

4

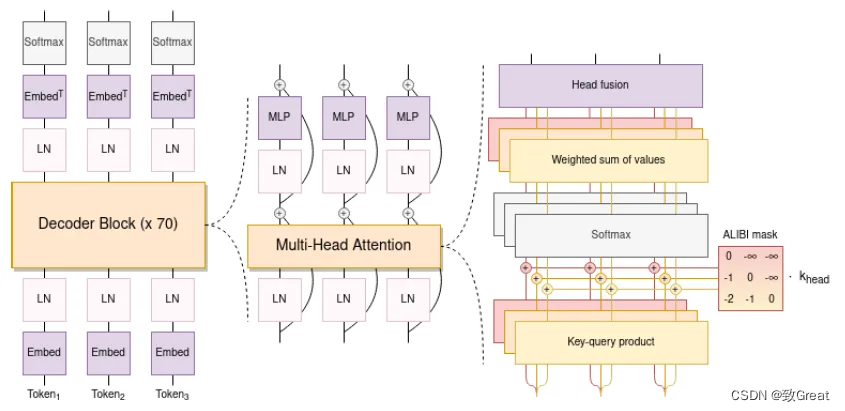

BLOOM

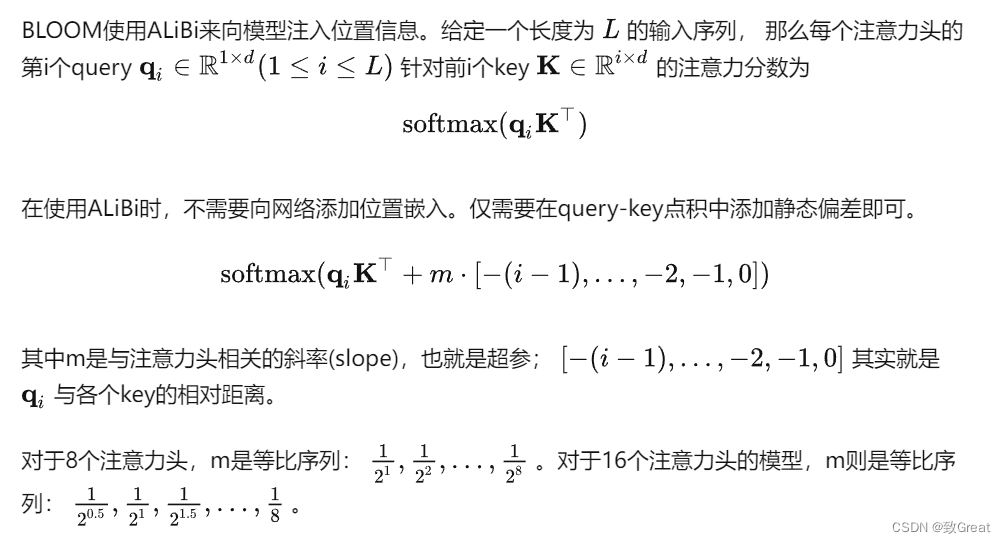

使用 ALiBi 位置嵌入,它根據鍵和查詢的距離直接衰減注意力分數。與原始的 Transformer 和 Rotary 嵌入相比,它可以帶來更流暢的訓練和更好的下游性能。ALiBi不會在詞嵌入中添加位置嵌入;相反,它會使用與其距離成比例的懲罰來偏向查詢鍵的注意力評分。

Embedding Layer Norm 在第一個嵌入層之后立即使用,以避免訓練不穩定。

使用了 25 萬個標記的詞匯表。使用字節級 BPE。這樣,標記化永遠不會產生未知標記

兩個全連接層:

5

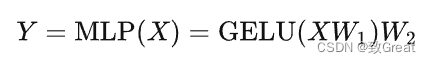

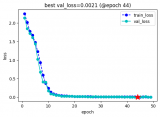

GPT

GPT 使用 Transformer 的 Decoder 結構,并對 Transformer Decoder 進行了一些改動,原本的 Decoder 包含了兩個 Multi-Head Attention 結構,GPT 只保留了 Mask Multi-Head Attention,如下圖所示:

審核編輯:劉清

-

電源優化器

+關注

關注

0文章

11瀏覽量

5474 -

GPT

+關注

關注

0文章

368瀏覽量

16069 -

BPEKF算法

+關注

關注

0文章

2瀏覽量

1119 -

MLP

+關注

關注

0文章

57瀏覽量

4598 -

LLM

+關注

關注

1文章

325瀏覽量

827

原文標題:LLM底座模型:LLaMA、Palm、GLM、BLOOM、GPT結構對比

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【飛騰派4G版免費試用】仙女姐姐的嵌入式實驗室之五~LLaMA.cpp及3B“小模型”OpenBuddy-StableLM-3B

【算能RADXA微服務器試用體驗】+ GPT語音與視覺交互:1,LLM部署

無法在OVMS上運行來自Meta的大型語言模型 (LLM),為什么?

各種大語言模型是徹底被解封了

號稱「碾壓」LLaMA的Falcon實測得分僅49.08,HuggingFace決定重寫排行榜代碼

Llama 2性能如何

Meta推出Llama 2 免費開放商業和研究機構使用

LLM底座模型:LLaMA、Palm、GLM、BLOOM、GPT結構對比

LLM底座模型:LLaMA、Palm、GLM、BLOOM、GPT結構對比

評論