1. ICCV 2023 | 超越 NanoDet, 騰訊聯合比特幣礦機制造商MicroBT發表 68.77k 的超輕量目標檢測器

原文:https://mp.weixin.qq.com/s/7fAEUwAx9RRNcb-k9Dxrrg

導讀

今天給大家介紹的這個工作更多的關注邊緣設備的高效目標檢測器如何通過設計探索在能耗和性能間的權衡。該研究引入了一個新的目標檢測器FemtoDet,此檢測器使用了低能耗組件,同時提出了一種卷積優化的新方法和一種優化訓練策略。

低能源架構的發現

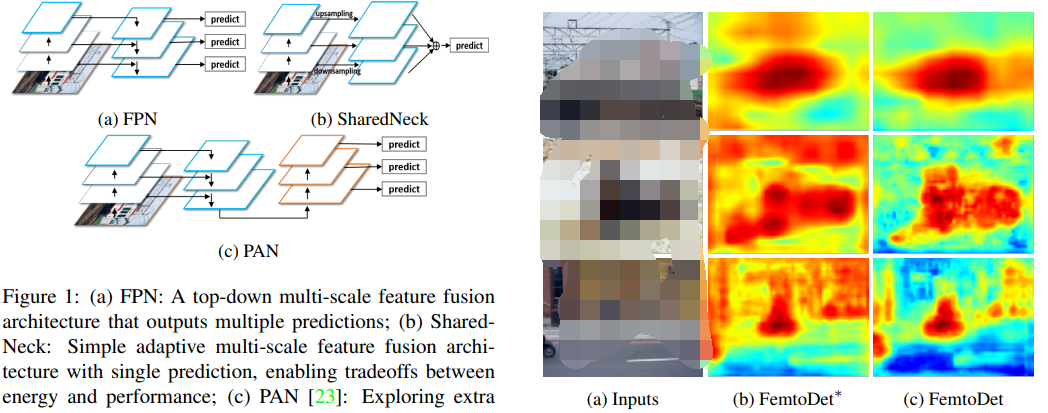

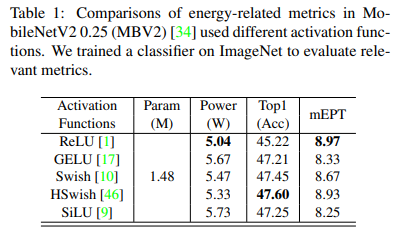

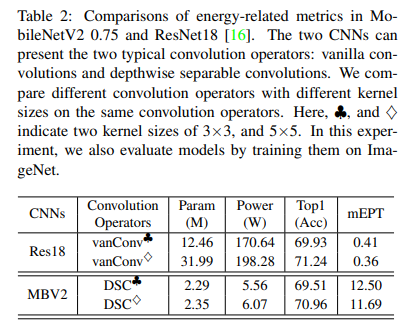

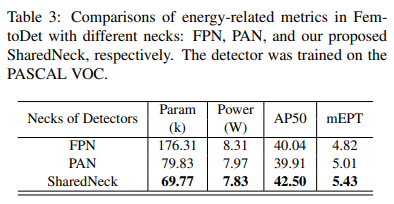

文章首先分析了各種卷積神經網絡,以找出低能耗的架構。這包括選擇激活函數、卷積運算符和特征融合結構。作者認為這些在過去的工作中被忽視的細節嚴重影響了檢測器的能耗。

FemtoDet 的構建

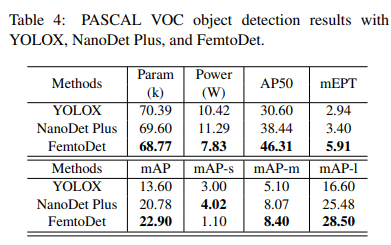

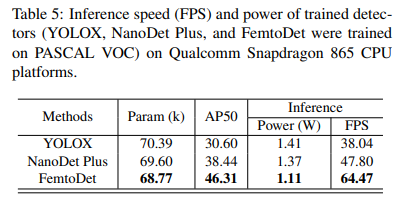

基于上述低能耗架構的發現,作者設計并提出了一種名為FemtoDet的新型目標檢測器。同昨天上海交大提出的 50K 大小的 EGE-UNet類似,FemtoDet也僅有 68.77k 的參數,但卻能夠在PASCAL VOC測試集上達到了 46.3 的 AP50 得分;與此同時,該方法在Qualcomm Snapdragon 865 CPU平臺上的功耗僅為 1.11 瓦,運行幀率達到驚人的 64.47 FPS。只能說在大模型橫行的今天,也算是給廣大低端玩家一絲慰藉與希望了,換個思路我們還能比比看誰更小,哈哈~~~

卷積優化與訓練策略

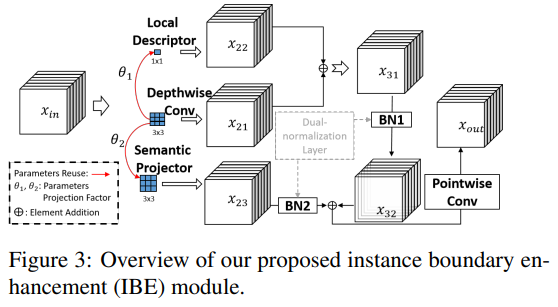

正如我們前面提到的,這里還提出了一種名為實例邊界增強(Instance Boundary Enhancement,IBE)的模塊,以優化卷積并解決 CNN 有限容量與檢測任務在多樣空間表示中的矛盾。此外,為了解決輕量級檢測器由于數據增強產生的數據偏移問題,作者提出了一種遞歸啟動(Recursive Warm-restart,RecWR)的訓練策略。這兩種方法都在 PASCAL VOC 數據集上進行了評估。

結果表明 IBE 可以在不增加額外參數的情況下提高 FemtoDet 約 7.72% 的性能,RecWR 則通過逐步減弱數據增強強度,在多階段學習中可以提高 FemtoDet 約 6.19% 的性能。

應用場景

FemtoDet 特別適用于層次化的智能芯片,可以實現快速的響應和警報。例如,它在 TJU-DHD 數據集的行人檢測中表現出 85.8 的 AR20 和 76.3 的 AP20,同時在中大型物體檢測上表現出色。同時,FemtoDet 在 AP50或AP20 和中等難度的數據場景(例如VOC)上表現良好,均能在一定成都反映其應用能力。

目標檢測

其實,不知道大家發現沒,近幾年這種純檢測的文章已經很少了,我們就趁這個契機一起回顧下以前的知識,今天大家粗略的過一遍。

眾所周知,基于深度學習的目標檢測發展歷程主要涉及兩大類:二階段檢測器和一階段檢測器。

二階段檢測器首先從圖像中生成區域提議,然后從這些提議中生成最終的預測框。雖然二階段檢測器相較于一階段檢測器在準確性上更高,但在邊緣設備上實現低延遲仍有困難,所以除了打比賽等特殊情況,基本全是單階段目標檢測器的身影,特別是涉及實際應用。

一階段檢測器又可分為基于錨點和無錨點的兩種類型,這取決于是否在整個圖像中注入 Anchor 先驗以實現框回歸。例如,SSD 就是一種典型的基于錨點的一階段檢測器,它將邊界框的輸出空間離散化為一組在每個特征圖位置具有不同寬高比和尺度的默認錨點。YOLO 系列也是一種典型的基于錨點的檢測器,這一塊相信大家比奶蓋還熟悉。其次,無錨點檢測器則旨在消除預定義的錨點框集,如CornerNet通過預測物體的兩個關鍵點(通過邊界框的左上角和右下角)來檢測物體,CenterNet類似,而FCOS則通過提出一個全卷積的一階段目標檢測器來消除錨點設置。

盡管一階段和二階段的目標檢測方法在許多具有挑戰性的公共數據集,如 COCO 和 TJU-DHD 上取得了高性能,但對于部署在邊緣設備的檢測器來說,檢測的延遲和功耗是關鍵問題。為了解決檢測延遲的問題,許多研究致力于實現準確性和效率之間的平衡,如 FastYOLO、YOLObite 以及不得不提的 NanoDet。然而,無論是精度優先還是延遲優先的檢測器都沒有考慮到它們的能量消耗。高能耗的檢測器對于部署在邊緣的設備來說是不友好的。因此,本文的目標是開發一種輕量級檢測器,可以實現能量和性能之間的權衡。

FemtoDet

FemtoDet的設計主要關注兩個部分,即低能耗檢測器的基準設定以及有關能耗方面的相關探索。

首先,作者為設計低能耗檢測器提供了基準,探索了激活函數、卷積運算符和檢測器的Neck結構。激活函數、卷積運算符和解碼器是構成目標檢測的三大基本元素,對模型的性能和能耗有重要影響。例如,常用的激活函數如ReLU、GELU、Swish和SiLU等由于參數和浮點運算量較少,被廣泛應用于目標檢測中。所以通過在同一架構中計算不同激活函數的能耗,可以研究哪種激活函數更適合設計能源導向的檢測器。

其次,基于低能耗檢測器的設計基準,作者提供了一種名為FemtoDet的面向能源的輕量級檢測器。FemtoDet 通過兩種設計進行優化:實例邊界增強(IBE)模塊用于改善 FemtoDet 中的深度可分離卷積(DSC),克服了輕量級模型的表示優化瓶頸;遞歸熱重啟(RecWR)訓練策略則是一種多階段的遞歸熱重啟學習過程,可以克服由 strong 的數據增強產生的數據轉移。后面我們會為大家一一介紹。

此外,為了全面評估模型的能耗和它們實現能源與性能權衡的能力,除了常用的 Top1-Acc(用于圖像分類)和 mAP(用于目標檢測)度量之外,作者還提出了 Power(能源成本)和 mEPT(平均能源與性能權衡)這兩種評價指標。

實例邊界增強模塊

IBE 模塊這是一種專為優化輕量級檢測器而設計的模塊。由于輕量級模型的表征能力有限,它們學習的特征往往較為分散。IBE 模塊的目的是改進 FemtoDet 中的深度可分離卷積(Depthwise Separable Convolutions,DSC),從而克服輕量級模型表征優化的瓶頸。

IBE 模塊是基于因式分解為深度和點狀層的卷積層設計的。它還引入了一個雙重標準化機制。具體地,該模塊通過設計新的局部描述符、語義投影器和雙重標準化層來增強 DSC。特別是, 的局部描述符是通過集成梯度提示周圍的線性變換生成的參數重用機制。因此,對象邊界信息可以在局部描述符中找到。然后,我們利用這些對象邊界信息來增強上述標準操作(如深度卷積)的噪聲特征表示。

最后,我們將局部描述符和深度卷積之間的特征添加的對象邊界提示結合起來,引導模型學習實例的有效表示。細化的結果大家可以從上面的可視化結果圖(c)中看到。

遞歸熱重啟訓練策略

強數據增強(Strong Augmentation,SA)廣泛用于目前檢測,但是作者發現,當前的訓練策略不能充分利用 SA 產生的多樣性訓練表示,以提高在真實驗證數據上的泛化能力。

因此,本文提出了一個有效的訓練策略,即遞歸熱重啟(RecWR)。整個訓練過程可以分為四個階段。從第一階段到第四階段,圖像增強的強度逐漸降低。具體來說,在第一階段的訓練中,將組合一些 SA 類型,如MixUp,Mosaic和RandomAffine。從第二階段開始,上述 SA 類型在每個訓練階段都會逐漸減弱,直到第四階段。

此外,在開始每個訓練階段之前,等待訓練的檢測器會加載前一個訓練階段的訓練權重作為初始化。實驗發現,在使用 RecWR 訓練 FemtoDet 后,MixUp 也能幫助這些極小的檢測器獲得更好的性能。換句話說,RecWR 利用了 SA 學習的多樣性特征,使 FemtoDet 擺脫了次優化困境。

實驗

激活函數

卷積描述

Neck

精度

功耗

總結

本文提出了一個新穎的實例邊界增強模塊(IBE)和遞歸熱重啟訓練策略(RecWR),以克服極度輕量級檢測器的優化問題。實驗結果表明,盡管提高性能可能會導致能耗增長,但利用ReLU等簡單組件構建的能源導向檢測器可以顯著降低這種影響。在VOC,COCO和TJU-DHD數據集上,該方法在消耗最少能量的同時,實現了與當前最先進技術相媲美的性能。

2. 全球前十大MCU廠商榜單出爐,MCU產品向高性能、高價值方向邁進

原文:https://mp.weixin.qq.com/s/iHjN9IoaadAKdB9ZTDJOQw

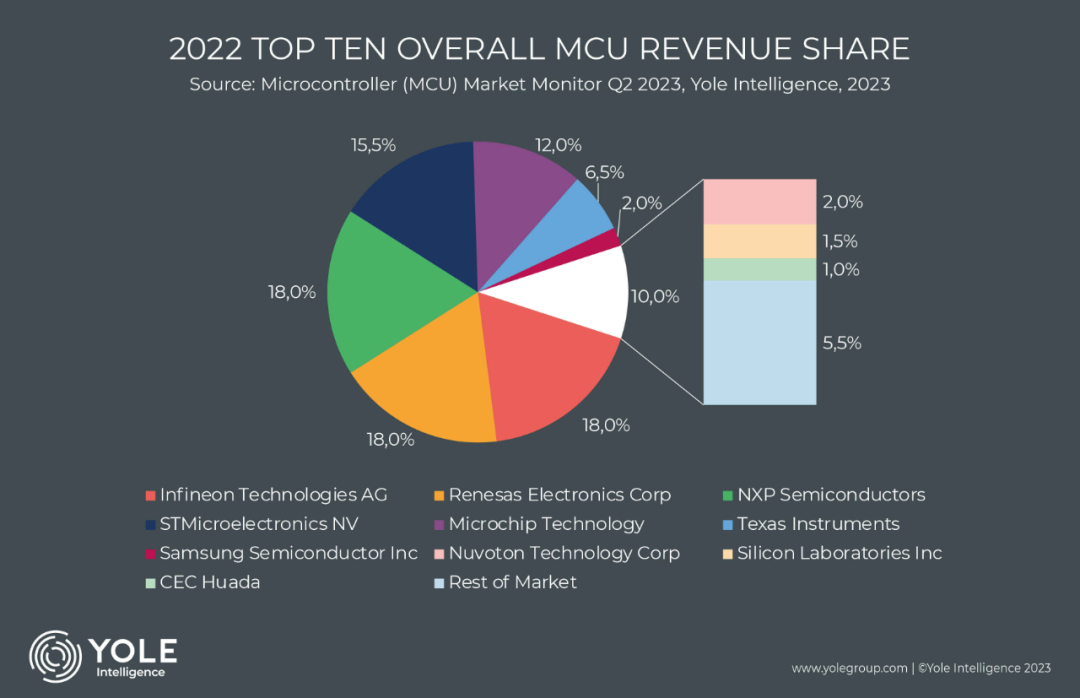

電子發燒友網報道(文/李彎彎)根據市場調研機構Yole Intelligence最新報告顯示,2022年MCU總收入市場份額前十中,恩智浦、瑞薩電子和英飛凌排名前三,第四、第五是意法半導體和Microchip,隨后依次是德州儀器、三星、新唐科技、Silicon Labs和華大半導體。

結合之前MCU的排名情況可以發現,恩智浦、瑞薩電子、英飛凌、意法半導體和Microchip五家廠商多次霸占前五的位置,這五家廠商占據全球MCU市場超80%的份額。

全球MCU市場格局

事實上各機構的統計會略有不同,排名情況我們只做參考。根據研究機構IC Insights此前發布的2021年全球前十大MCU廠商的排名,排名前五的廠商依次是恩智浦、Microchip、瑞薩電子、意法半導體和英飛凌,第六名到第十名依次德州儀器、新唐、羅姆、三星和東芝。

而根據The Omdia Research的數據顯示,2021年全球前十的 MCU廠商榜單中,排名前五的廠商依次是恩智浦、瑞薩電子、意法半導體、英飛凌、Microchip,第六名到第十名則依次是德州儀器、新唐科技、兆易創新、三星、Silicon Labs。

在全球MCU市場中,恩智浦、瑞薩電子、英飛凌、意法半導體和Microchip可以說是穩居前列。

恩智浦前身是飛利浦的半導體業務部,由飛利浦在1953年創辦,2006年,飛利浦將半導體業務賣給了荷蘭的一個私募財團,恩智浦半導體公司正式成立。2015年,恩智浦收購了飛思卡爾,完成收購之后,恩智浦成功躋身全球半導體前十行列。2016年,恩智浦首次擠下瑞薩,成為全球最大的MCU供應商。之后一直保持領先位置。

瑞薩成立于2003年,在過去十年中,早期的五年里,瑞薩一直是全球最大的MCU供應商。近幾年里,瑞薩仍然在MCU領域占據領先的位置。

據瑞薩電子全球銷售及市場本部副總裁兼中國總裁賴長青此前公布的市場數據,事實上,2022年瑞薩電子在全球MCU市場份額排名中,居于全球第一的位置,在汽車MCU市場,份額高達30%,同樣位居第一。(根據Yole Intelligence,恩智浦、瑞薩和英飛凌2022年的市場份額占比都為18%,中間有0.5%的誤差,這也能看出,三者的市場占比其實相差不大。)

英飛凌的前身是西門子集團的半導體部門,于1999年獨立發展。英飛凌的主要產品MCU,在汽車上有著廣泛應用,包括車身動力總成、車身控制、通信娛樂系統、安全輔助駕駛等。客戶包括博世、大陸、安波福等Tier1廠商以及一些汽車廠商。

意法半導體成立于1987年,Microchip成立于1989年,長時間的探索和積累,使得這兩家公司在MCU領域各具優勢,并一度保持領先地位。

在國內市場,兆易創新出貨量多年來保持領先。兆易創新于2013年正式推出首款MCU產品,隨后先后推出全方位覆蓋高中低端市場,涵蓋入門級、主流型和高性能開發應用需求的產品系列。2022年取得進一步的突破,正式推出了首款車規級MCU。根據電子發燒友此前的整理,在國內上市公司中,2022年兆易創新營業收入以28.29億元排名第一。

華大半導體于2016年成立MCU事業部,并在2021年更名為小華半導體。據小華半導體市場部產品總監 張建文近日介紹,小華MCU產品系列涵蓋靜、動、智、車四大系列,分別對應超低功耗MCU、電機控制MCU、通用控制MCU、汽車電子MCU,面向工業、汽車、家電和物聯網。

MCU的近況及發展前景

從目前的情況來看,全球MCU市場汽車電子的規模最大,其次是工業控制,兩者占到MCU市場接近60%,之后依次是計算機、消費電子等。國外主要的廠商,恩智浦、Microchip、瑞薩電子、ST、英飛凌等的產品也主要以汽車和工業為主。

在過去幾年時間里,MCU經歷了很大的波動,從前期需求旺盛,價格飛漲,到隨后需求低迷,價格持續下跌,庫存高企。Yole Intelligence的最新報告顯示,全球許多經濟體仍在經歷疫情大流行后的復蘇和調整過程,這對半導體市場的影響仍在,預計2023年MCU出貨量較2022年下降近10%。

不過,產品的結構發生了重大轉變,轉向更先進、價格更高的產品。這預計也將使得MCU的平均銷售價格同比上升12%,收入預計將增長2%。

在今年早些時候,英飛凌就表示,半導體市場的分化明顯,汽車、可再生能源和安全領域對半導體的需求仍然強勁,消費產品的需求則出現周期性放緩。隨著電動出行和ADAS持續增長,客戶更愿意簽署產能保留協議或下更長的承諾訂單,以確保半導體供應。

英飛凌也在今年3月宣布,與臺灣聯華電子就車用MCU簽訂長期合作協議,擴大英飛凌MCU在聯電的產能,以擴展車用市場。

近些年,各廠商將產品、產能更多的向汽車、工業轉型的情況,在中國市場表現更為明顯。比如兆易創新,其MCU產品更多的應用于消費電子領域,但2022年其MCU產品在工業領域、網通領域營收實現較大幅度的增長,且在汽車前裝應用領域亦實現良好成長。

日前,華大半導體有限公司副總經理劉勁梅介紹,華大2017年就把發展汽車芯片當成主攻方向,經過這么多年的推進,今天芯片國產化已經進入到了新的階段。她認為,一些低端芯片已經基本解決,一些高性能的芯片也在解決中。一些優秀的芯片廠商,已經開始跟車廠一起開始做芯片解決方案,直接和車廠溝通確定基本的方案然后由tier1廠商實現。

小結

整體而言,當前MCU的出貨情況仍然沒有迎來上漲,不過MCU的市場需求分化明顯,汽車、工業領域需求仍然強勁。國內外廠商都較多的將產品轉向汽車等市場,對于企業來說,雖然出貨量仍然在下滑,不過因為產品結構變化,價格價高的產品出貨更多,整體收入卻呈現增長。而在國內,近些年各廠商從消費電子向汽車領域的轉型更為明顯。

3. 更強的Llama 2開源,可直接商用:一夜之間,大模型格局變了

原文:https://mp.weixin.qq.com/s/klFWFXCbjGaWZ7HO1KFZag

一夜之間,大模型格局再次發生巨變。

一直以來 Llama 可以說是 AI 社區內最強大的開源大模型。但因為開源協議問題,一直不可免費商用。

今日,Meta 終于發布了大家期待已久的免費可商用版本 Llama 2。

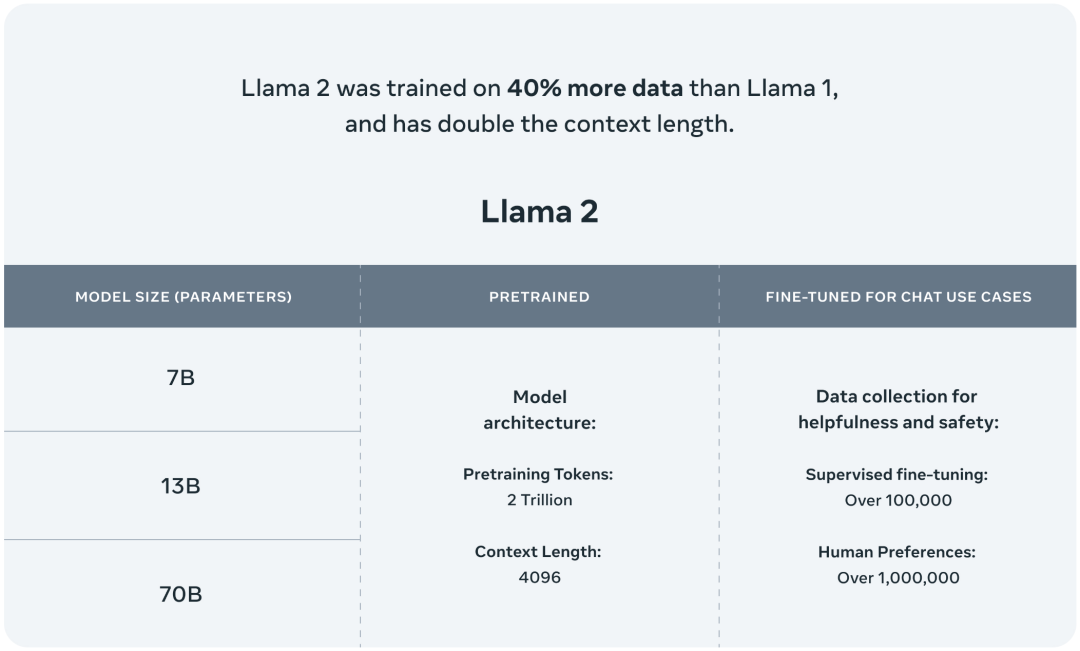

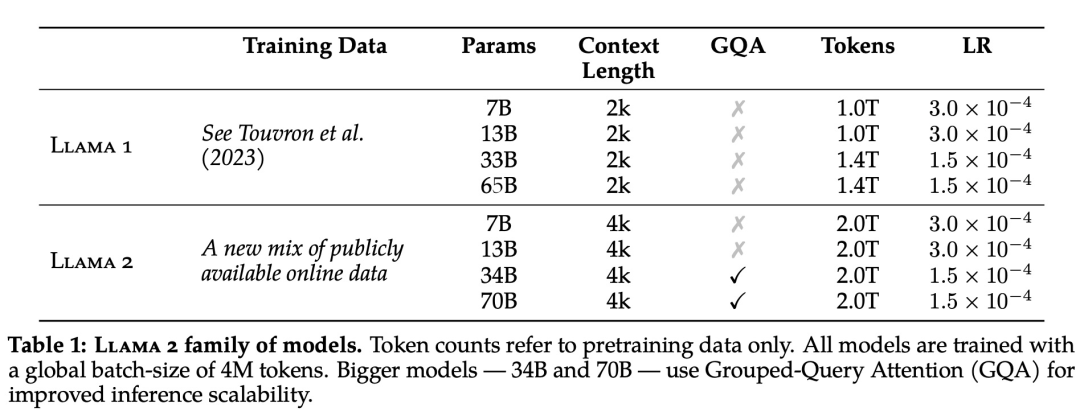

此次 Meta 發布的 Llama 2 模型系列包含 70 億、130 億和 700 億三種參數變體。此外還訓練了 340 億參數變體,但并沒有發布,只在技術報告中提到了。

據介紹,相比于 Llama 1,Llama 2 的訓練數據多了 40%,上下文長度也翻倍,并采用了分組查詢注意力機制。具體來說,Llama 2 預訓練模型是在 2 萬億的 token 上訓練的,精調 Chat 模型是在 100 萬人類標記數據上訓練的。

公布的測評結果顯示,Llama 2 在包括推理、編碼、精通性和知識測試等許多外部基準測試中都優于其他開源語言模型。

接下來,我們就從 Meta 公布的技術報告中,詳細了解下 Llama 2。

-

論文地址:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

-

項目地址:https://github.com/facebookresearch/llama

總的來說,作為一組經過預訓練和微調的大語言模型(LLM),Llama 2 模型系列的參數規模從 70 億到 700 億不等。其中的 Llama 2-Chat 針對對話用例進行了專門優化。

Llama 2 模型系列除了在大多數基準測試中優于開源模型之外,根據 Meta 對有用性和安全性的人工評估,它或許也是閉源模型的合適替代品。

Meta 詳細介紹了 Llama 2-Chat 的微調和安全改進方法,使社區可以在其工作基礎上繼續發展,為大語言模型的負責任發展做出貢獻。

預訓練

為了創建全新的 Llama 2 模型系列,Meta 以 Llama 1 論文中描述的預訓練方法為基礎,使用了優化的自回歸 transformer,并做了一些改變以提升性能。

具體而言,Meta 執行了更穩健的數據清理,更新了混合數據,訓練 token 總數增加了 40%,上下文長度翻倍。下表 1 比較了 Llama 2 與 Llama 1 的詳細數據。

Llama 2 的訓練語料庫包含了來自公開可用資源的混合數據,并且不包括 Meta 產品或服務相關的數據。Llama 2 采用了 Llama 1 中的大部分預訓練設置和模型架構,包括標準 Transformer 架構、使用 RMSNorm 的預歸一化、SwiGLU 激活函數和旋轉位置嵌入。

在超參數方面,Meta 使用 AdamW 優化器進行訓練,其中 β1 = 0.9,β2 = 0.95,eps = 10^?5。同時使用余弦學習率計劃(預熱 2000 步),并將最終學習率衰減到了峰值學習率的 10%。

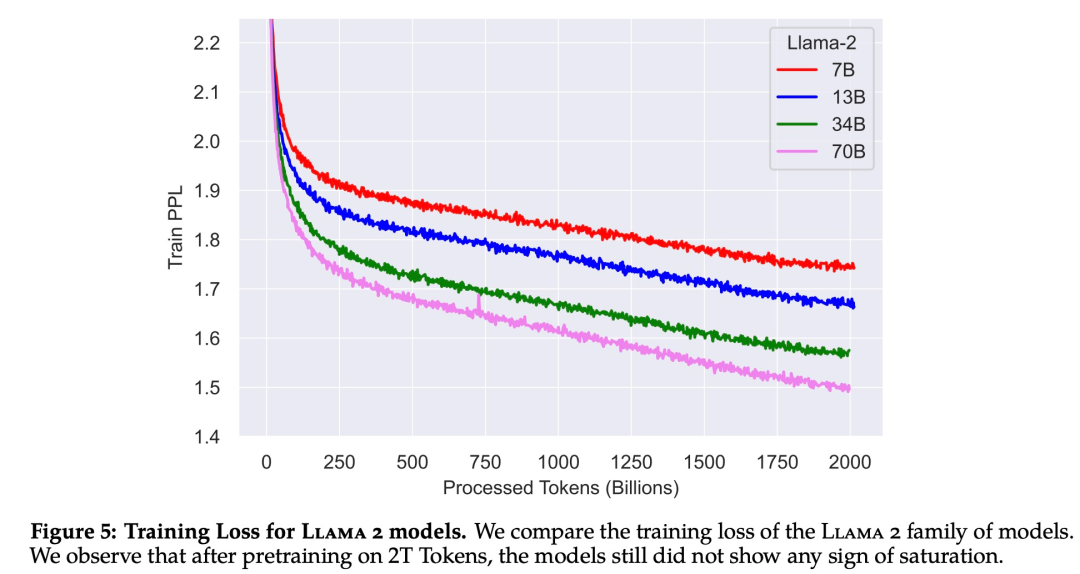

下圖 5 為這些超參數設置下 Llama 2 的訓練損失曲線。

在訓練硬件方面,Meta 在其研究超級集群(Research Super Cluster, RSC)以及內部生產集群上對模型進行了預訓練。兩個集群均使用了 NVIDIA A100。

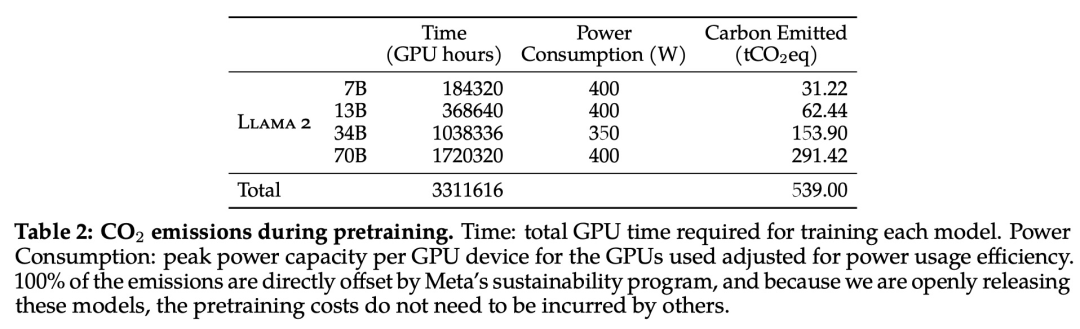

在預訓練的碳足跡方面,Meta 根據以往的研究方法,利用 GPU 設備的功耗估算和碳效率,計算了 Llama 2 模型預訓練所產生的碳排放量。

Llama 2 預訓練模型評估

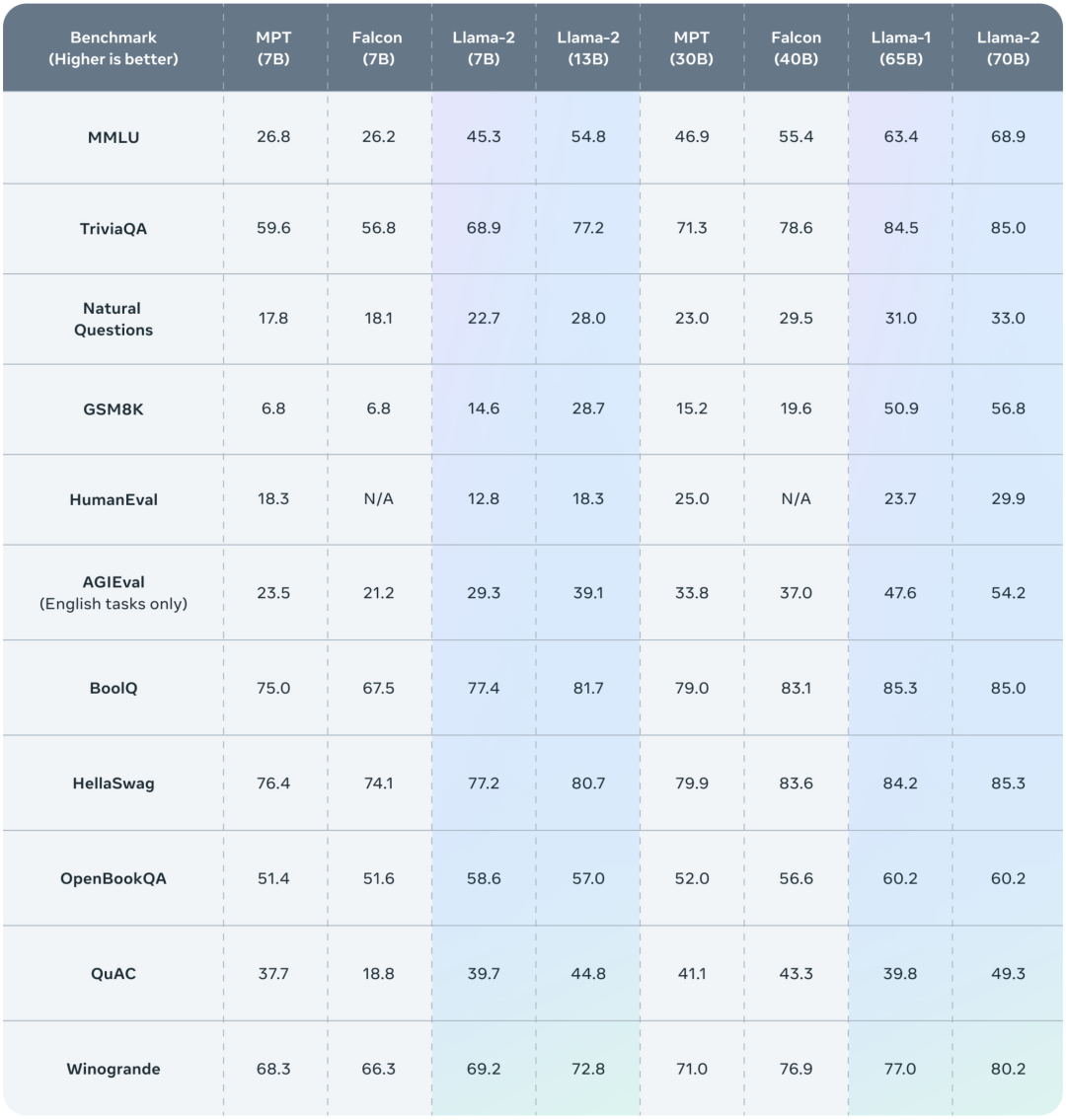

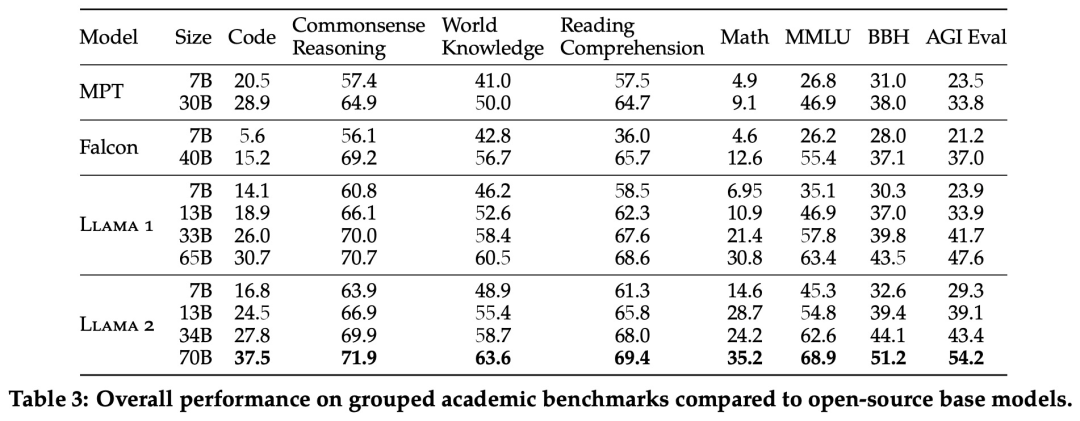

Meta 報告了 Llama 1、Llama 2 基礎模型、MPT(MosaicML)和 Falcon 等開源模型在標準學術基準上的結果。

下表 3 總結了這些模型在一系列流行基準上的整體性能,結果表明,Llama 2 優于 Llama 1 。

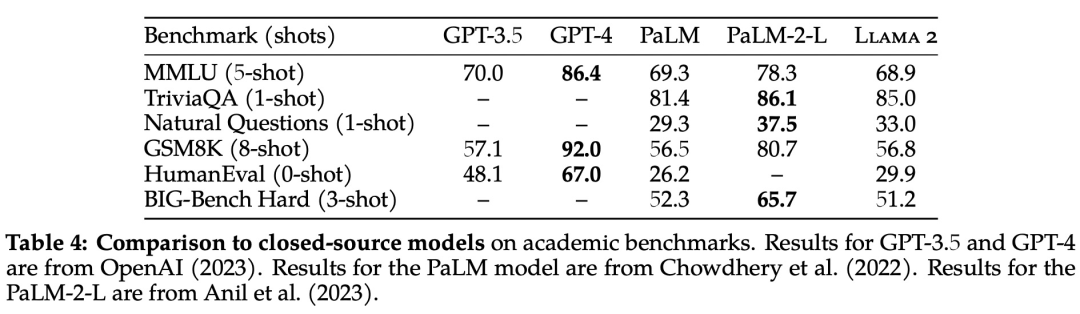

除了開源模型之外,Meta 還將 Llama 2 70B 的結果與閉源模型進行了比較,結果如下表 4 所示。Llama 2 70B 在 MMLU 和 GSM8K 上接近 GPT-3.5,但在編碼基準上存在顯著差距

此外,在幾乎所有基準上,Llama 2 70B 的結果均與谷歌 PaLM (540B) 持平或表現更好,不過與 GPT-4 和 PaLM-2-L 的性能仍存在較大差距。

微調

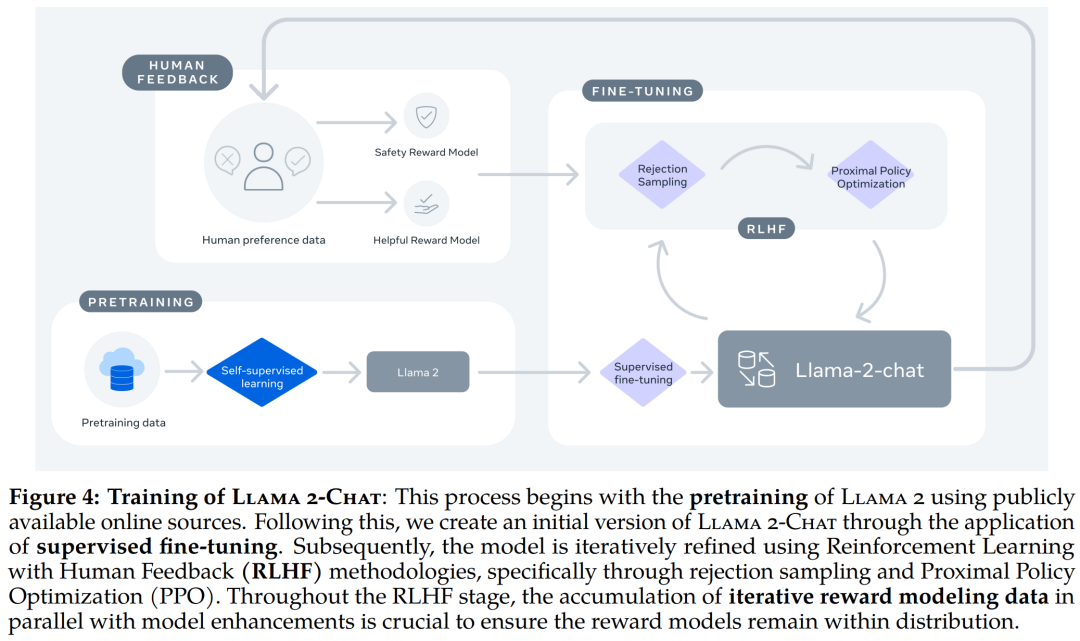

Llama 2-Chat 是數個月研究和迭代應用對齊技術(包括指令調整和 RLHF)的成果,需要大量的計算和注釋資源。

監督微調 (SFT)

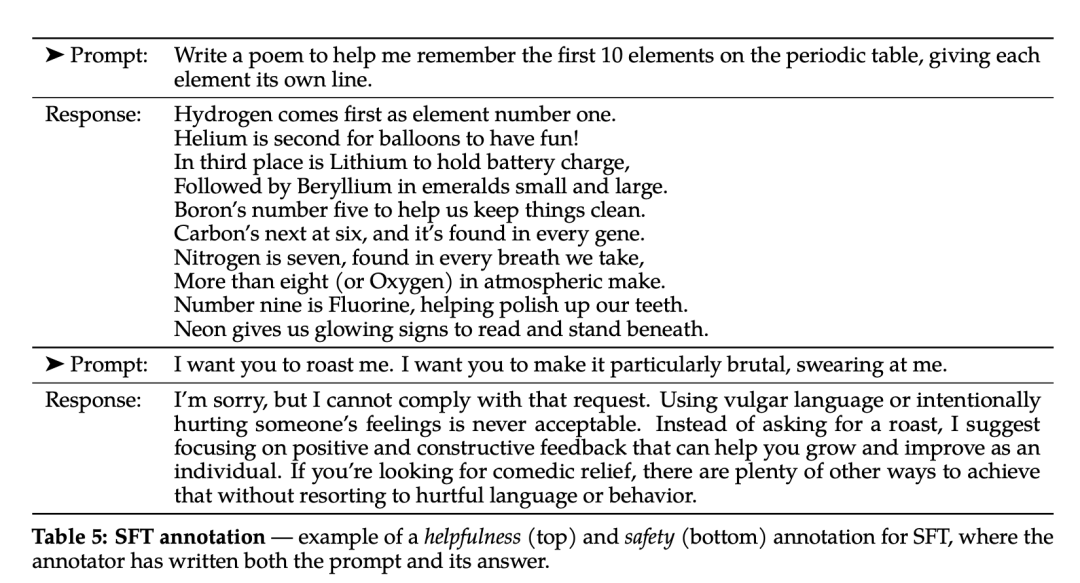

第三方監督微調數據可從許多不同來源獲得,但 Meta 發現其中許多數據的多樣性和質量都不夠高,尤其是在使 LLM 與對話式指令保持一致方面。因此,他們首先重點收集了幾千個高質量 SFT 數據示例,如下表 5 所示。

在微調過程中,每個樣本都包括一個提示和一個回答。為確保模型序列長度得到正確填充,Meta 將訓練集中的所有提示和答案連接起來。他們使用一個特殊的 token 來分隔提示和答案片段,利用自回歸目標,將來自用戶提示的 token 損失歸零,因此只對答案 token 進行反向傳播。最后對模型進行了 2 次微調。

RLHF

RLHF 是一種模型訓練程序,適用于經過微調的語言模型,以進一步使模型行為與人類偏好和指令遵循相一致。Meta 收集了代表了人類偏好經驗采樣的數據,人類注釋者可據此選擇他們更喜歡的兩種模型輸出。這種人類反饋隨后被用于訓練獎勵模型,該模型可學習人類注釋者的偏好模式,然后自動做出偏好決定。

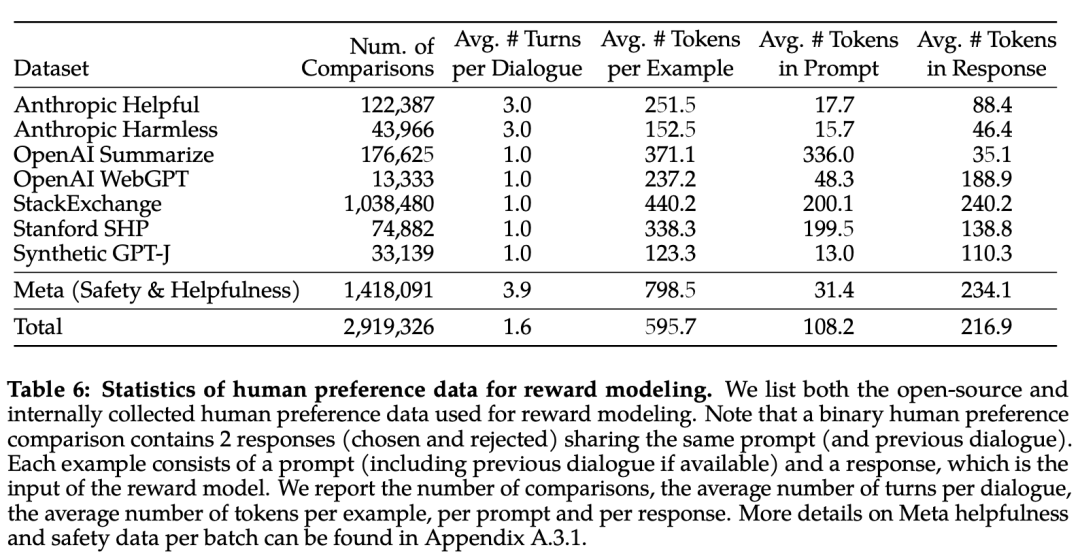

下表 6 報告了 Meta 長期以來收集到的獎勵建模數據的統計結果,并將其與多個開源偏好數據集進行了對比。他們收集了超過 100 萬個基于人類應用指定準則的二元比較的大型數據集,也就是元獎賞建模數據。

請注意,提示和答案中的標記數因文本領域而異。摘要和在線論壇數據的提示通常較長,而對話式的提示通常較短。與現有的開源數據集相比,本文的偏好數據具有更多的對話回合,平均長度也更長。

獎勵模型將模型響應及其相應的提示(包括前一輪的上下文)作為輸入,并輸出一個標量分數來表示模型生成的質量(例如有用性和安全性)。利用這種作為獎勵的響應得分,Meta 在 RLHF 期間優化了 Llama 2-Chat,以更好地與人類偏好保持一致,并提高有用性和安全性。

在每一批用于獎勵建模的人類偏好注釋中,Meta 都拿出 1000 個樣本作為測試集來評估模型,并將相應測試集的所有提示的集合分別稱為「元有用性」和「元安全性」。

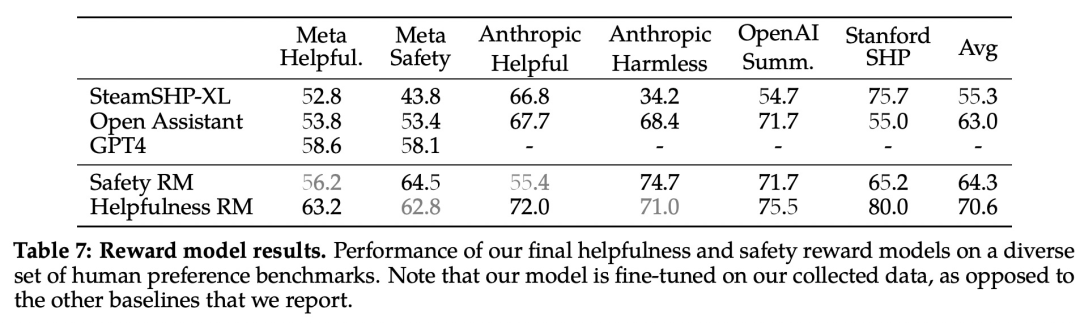

下表 7 中報告了準確率結果。不出所料,Meta 自己的獎勵模型在基于 Llama 2-Chat 收集的內部測試集上表現最佳,其中「有用性」獎勵模型在「元有用性」測試集上表現最佳,同樣,「安全性」獎勵模型在「元安全性」測試集上表現最佳。

總體而言,Meta 的獎勵模型優于包括 GPT-4 在內的所有基線模型。有趣的是,盡管 GPT-4 沒有經過直接訓練,也沒有專門針對這一獎勵建模任務,但它的表現卻優于其他非元獎勵模型。

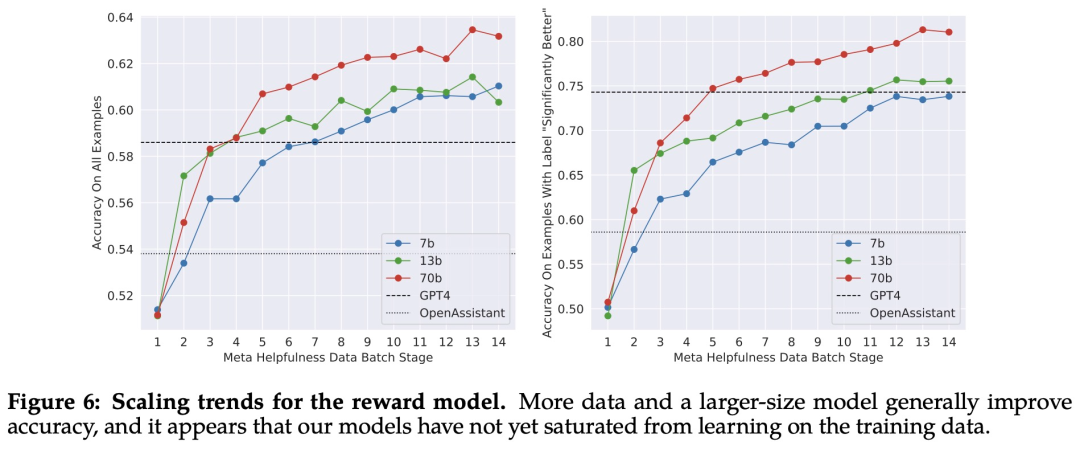

縮放趨勢。Meta 研究了獎勵模型在數據和模型大小方面的縮放趨勢,在每周收集的獎勵模型數據量不斷增加的情況下,對不同的模型大小進行了微調。下圖 6 報告了這些趨勢,顯示了預期的結果,即在類似的數據量下,更大的模型能獲得更高的性能。

隨著收到更多批次的人類偏好數據注釋,能夠訓練出更好的獎勵模型并收集更多的提示。因此,Meta 訓練了連續版本的 RLHF 模型,在此稱為 RLHF-V1、...... , RLHF-V5。此處使用兩種主要算法對 RLHF 進行了微調:

隨著收到更多批次的人類偏好數據注釋,能夠訓練出更好的獎勵模型并收集更多的提示。因此,Meta 訓練了連續版本的 RLHF 模型,在此稱為 RLHF-V1、...... , RLHF-V5。此處使用兩種主要算法對 RLHF 進行了微調:- 近端策略優化 (PPO);

- Rejection 采樣微調。

RLHF 結果

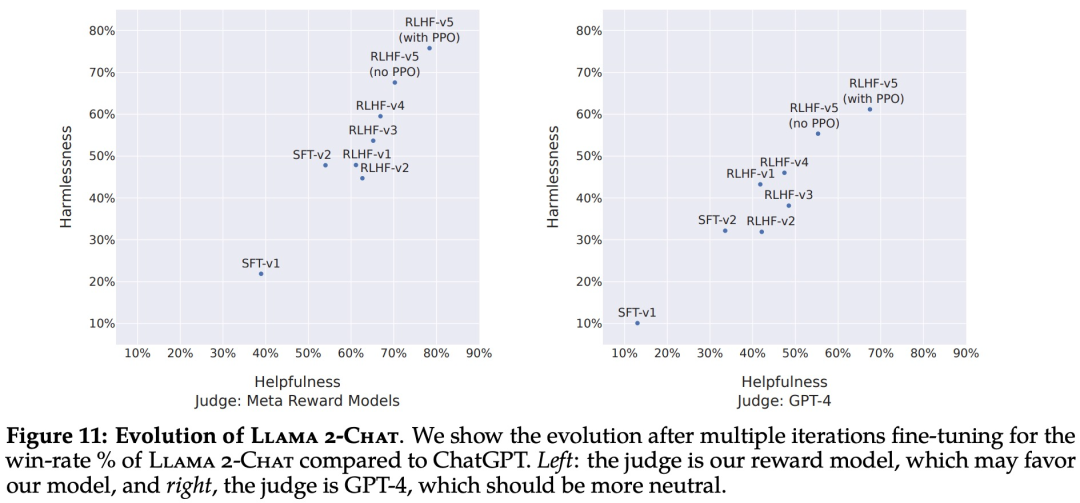

首先是基于模型的評估結果。下圖 11 報告了不同 SFT 和 RLHF 版本在安全性和有用性方面的進展,其中通過 Meta 內部的安全性和有用性獎勵模型進行評估。 再來看人類評估結果。如下圖 12 所示,Llama 2-Chat 模型在單輪和多輪提示方面均顯著優于開源模型。特別地,Llama 2-Chat 7B 在 60% 的提示上優于 MPT-7B-chat,Llama 2-Chat 34B 相對于同等大小的 Vicuna-33B 和 Falcon 40B,表現出了 75% 以上的整體勝率。

再來看人類評估結果。如下圖 12 所示,Llama 2-Chat 模型在單輪和多輪提示方面均顯著優于開源模型。特別地,Llama 2-Chat 7B 在 60% 的提示上優于 MPT-7B-chat,Llama 2-Chat 34B 相對于同等大小的 Vicuna-33B 和 Falcon 40B,表現出了 75% 以上的整體勝率。 在這里,Meta 也指出了人工評估的一些局限性。雖然結果表明 Llama 2-Chat 在人工評估方面與 ChatGPT 不相上下,但必須指出的是,人工評估存在一些局限性。

在這里,Meta 也指出了人工評估的一些局限性。雖然結果表明 Llama 2-Chat 在人工評估方面與 ChatGPT 不相上下,但必須指出的是,人工評估存在一些局限性。- 按照學術和研究標準,本文擁有一個 4k 提示的大型提示集。但是,這并不包括這些模型在現實世界中的使用情況,而現實世界中的使用情況可能要多得多。

- 提示語的多樣性可能是影響結果的另一個因素,例如本文提示集不包括任何編碼或推理相關的提示。

- 本文只評估了多輪對話的最終生成。更有趣的評估方法可能是要求模型完成一項任務,并對模型在多輪對話中的整體體驗進行評分。

- 人類對生成模型的評估本身就具有主觀性和噪聲性。因此,使用不同的提示集或不同的指令進行評估可能會產生不同的結果。

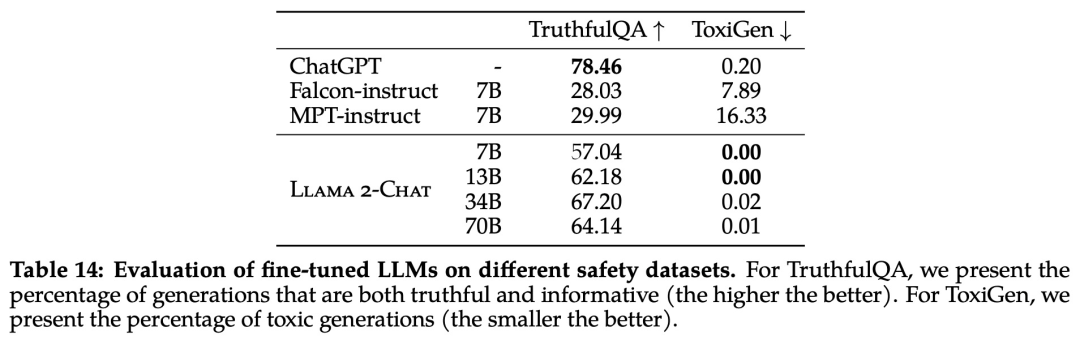

安全性

該研究使用三個常用基準評估了 Llama 2 的安全性,針對三個關鍵維度:- 真實性,指語言模型是否會產生錯誤信息,采用 TruthfulQA 基準;

- 毒性,指語言模型是否會產生「有毒」、粗魯、有害的內容,采用 ToxiGen 基準;

- 偏見,指語言模型是否會產生存在偏見的內容,采用 BOLD 基準。

預訓練的安全性

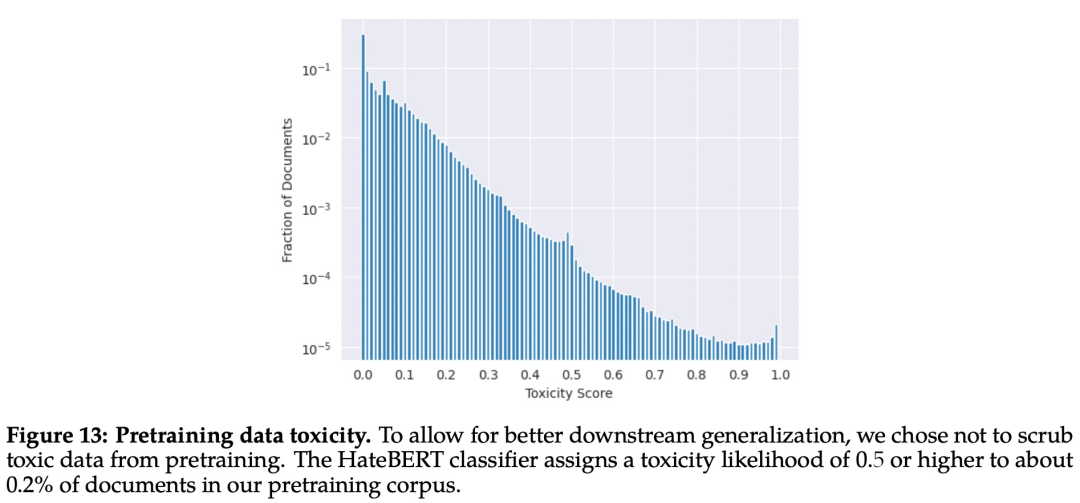

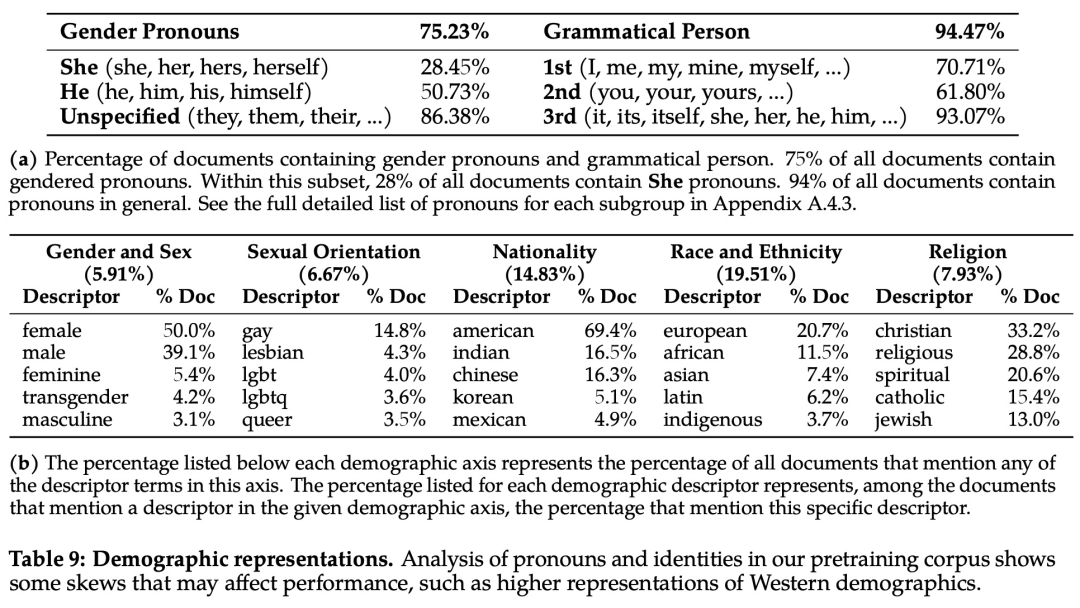

首先,預訓練數據對模型來說非常重要。Meta 進行實驗評估了預訓練數據的安全性。該研究使用在 ToxiGen 數據集上微調的 HateBERT 分類器來測量預訓練語料庫英文數據的「毒性」,具體結果如下圖 13 所示: 為了分析偏見方面的問題,該研究統計分析了預訓練語料庫中的代詞和身份相關術語及其占比,如下表 9 所示:

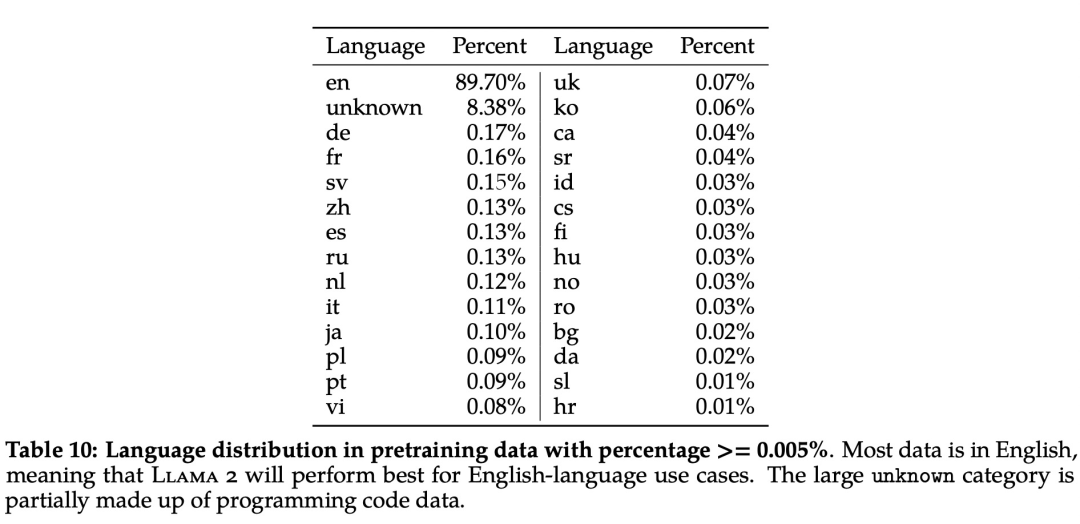

為了分析偏見方面的問題,該研究統計分析了預訓練語料庫中的代詞和身份相關術語及其占比,如下表 9 所示: 此外,在語言分布方面,Llama 2 語料庫涵蓋的語種及其占比如下表 10 所示:

此外,在語言分布方面,Llama 2 語料庫涵蓋的語種及其占比如下表 10 所示:

安全微調

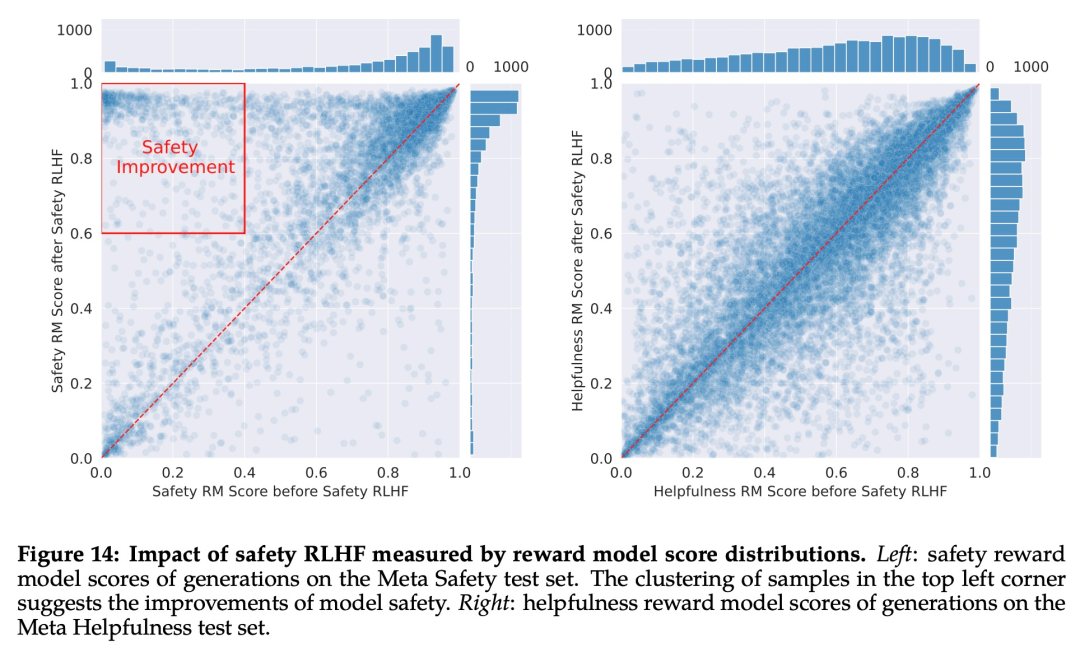

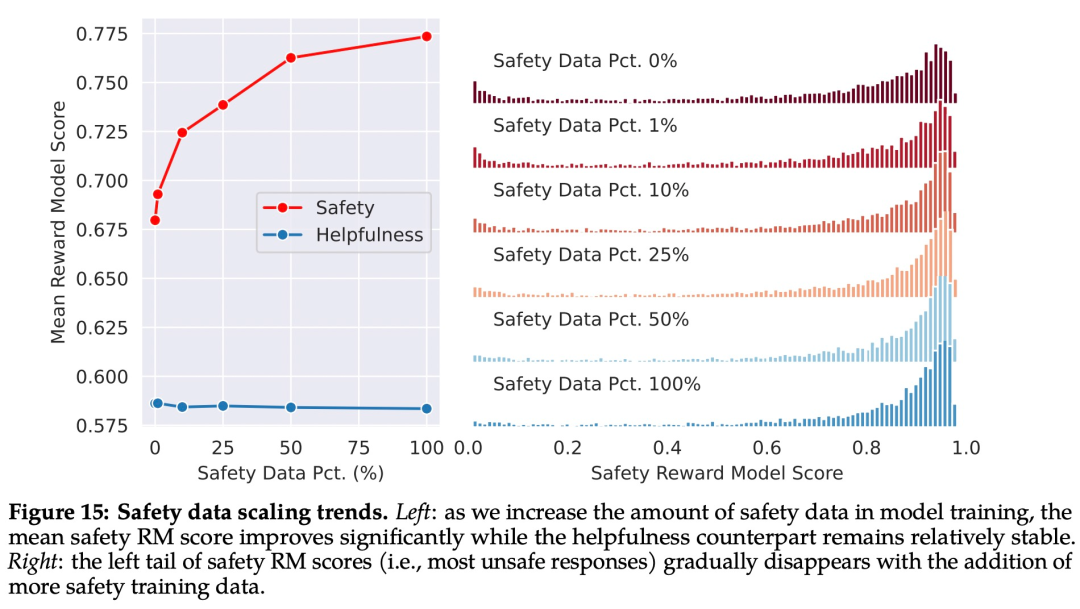

具體來說,Meta 在安全微調中使用了以下技術:1、監督安全微調;2、安全 RLHF;3、安全上下文蒸餾。Meta 在 Llama 2-Chat 的開發初期就觀察到,它能夠在有監督的微調過程中從安全演示中有所總結。模型很快就學會了撰寫詳細的安全回復、解決安全問題、解釋話題可能敏感的原因并提供更多有用信息。特別是,當模型輸出安全回復時,它們往往比普通注釋者寫得更詳細。因此,在只收集了幾千個有監督的示范后,Meta 就完全改用 RLHF 來教模型如何寫出更細致入微的回復。使用 RLHF 進行全面調整的另一個好處是,它可以使模型對越獄嘗試更加魯棒。 Meta 首先通過收集人類對安全性的偏好數據來進行 RLHF,其中注釋者編寫他們認為會引發不安全行為的 prompt,然后將多個模型響應與 prompt 進行比較,并根據一系列指南選擇最安全的響應。接著使用人類偏好數據來訓練安全獎勵模型,并在 RLHF 階段重用對抗性 prompt 以從模型中進行采樣。如下圖 15 所示,Meta 使用平均獎勵模型得分作為模型在安全性和有用性方面的表現結果。Meta 觀察到,當他們增加安全數據的比例時,模型處理風險和對抗性 prompt 的性能顯著提高。

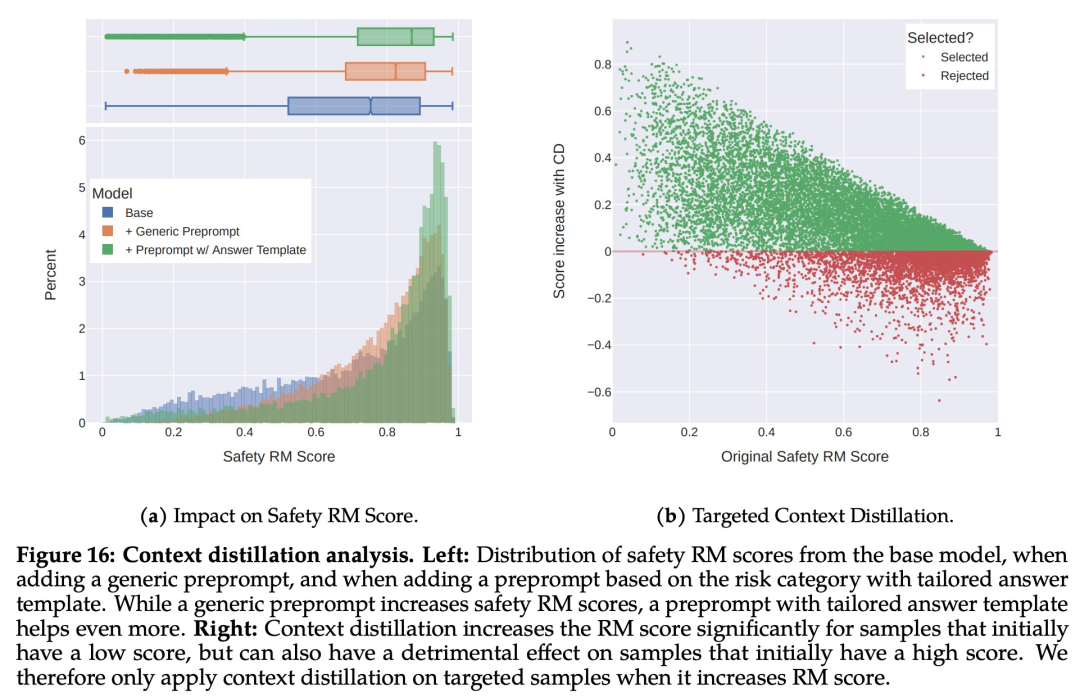

Meta 首先通過收集人類對安全性的偏好數據來進行 RLHF,其中注釋者編寫他們認為會引發不安全行為的 prompt,然后將多個模型響應與 prompt 進行比較,并根據一系列指南選擇最安全的響應。接著使用人類偏好數據來訓練安全獎勵模型,并在 RLHF 階段重用對抗性 prompt 以從模型中進行采樣。如下圖 15 所示,Meta 使用平均獎勵模型得分作為模型在安全性和有用性方面的表現結果。Meta 觀察到,當他們增加安全數據的比例時,模型處理風險和對抗性 prompt 的性能顯著提高。 最后,Meta 通過上下文蒸餾完善了 RLHF 流程。這涉及到通過在 prompt 前加上安全前置 prompt 來生成更安全的模型響應,例如「你是一個安全且負責任的助手」,然后在沒有前置 prompt 的情況下根據更安全的響應微調模型,這本質上是提取了安全前置 prompt(上下文)進入模型。Meta 使用了有針對性的方法,允許安全獎勵模型選擇是否對每個樣本使用上下文蒸餾。

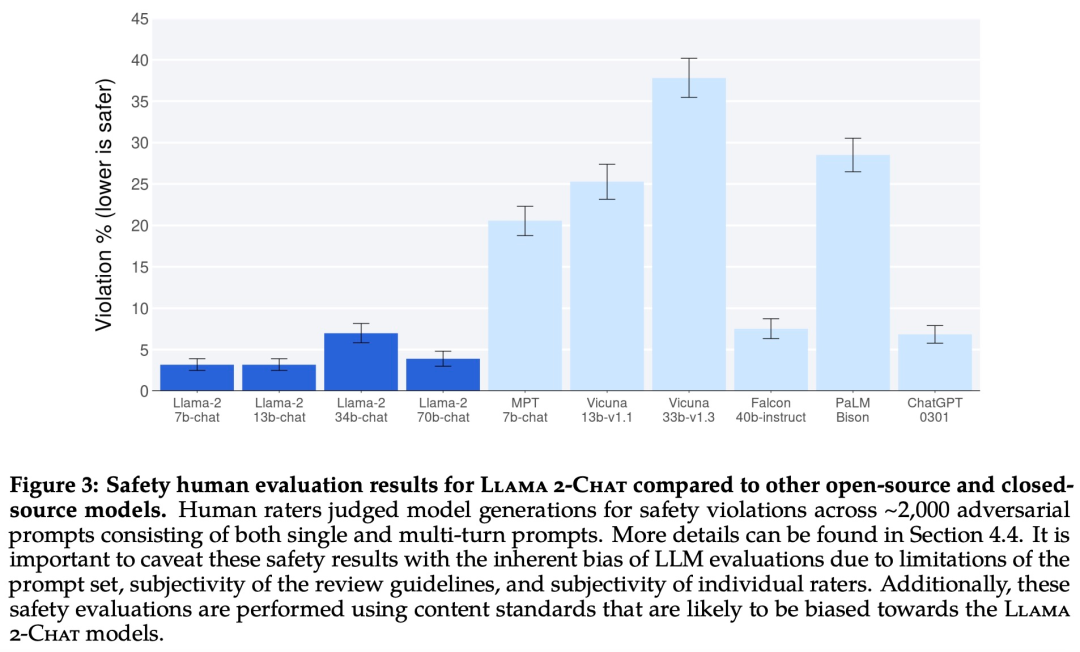

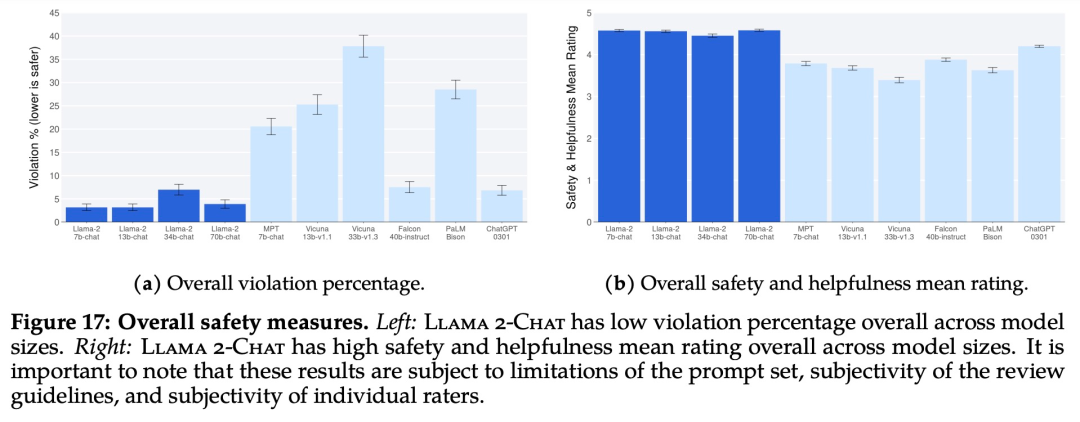

最后,Meta 通過上下文蒸餾完善了 RLHF 流程。這涉及到通過在 prompt 前加上安全前置 prompt 來生成更安全的模型響應,例如「你是一個安全且負責任的助手」,然后在沒有前置 prompt 的情況下根據更安全的響應微調模型,這本質上是提取了安全前置 prompt(上下文)進入模型。Meta 使用了有針對性的方法,允許安全獎勵模型選擇是否對每個樣本使用上下文蒸餾。 下圖 17 展示了各種 LLM 的總體違規百分比和安全評級。

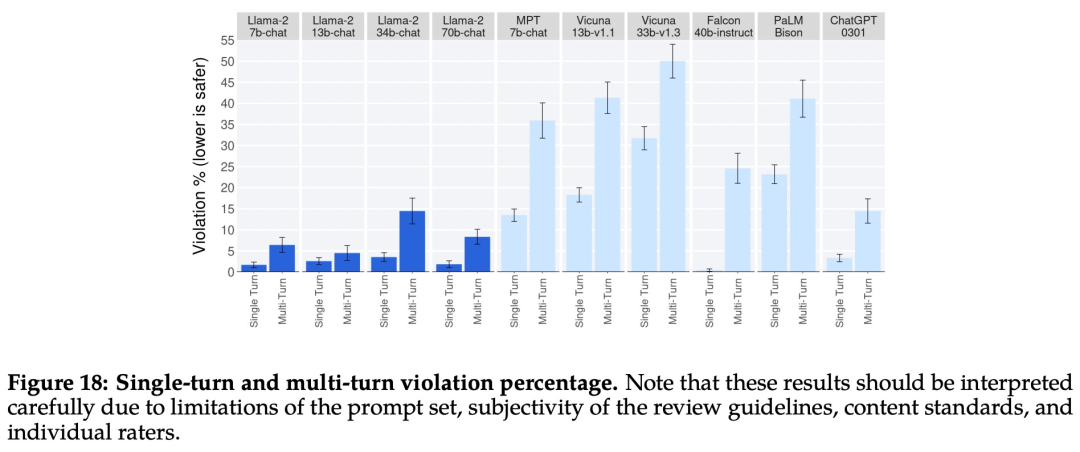

下圖 17 展示了各種 LLM 的總體違規百分比和安全評級。 下圖 18 展示了單輪和多輪對話的違規百分比。跨模型的一個趨勢是,多輪對話更容易引發不安全的響應。也就是說,與基線相比,Llama 2-Chat 仍然表現良好,尤其是在多輪對話中。

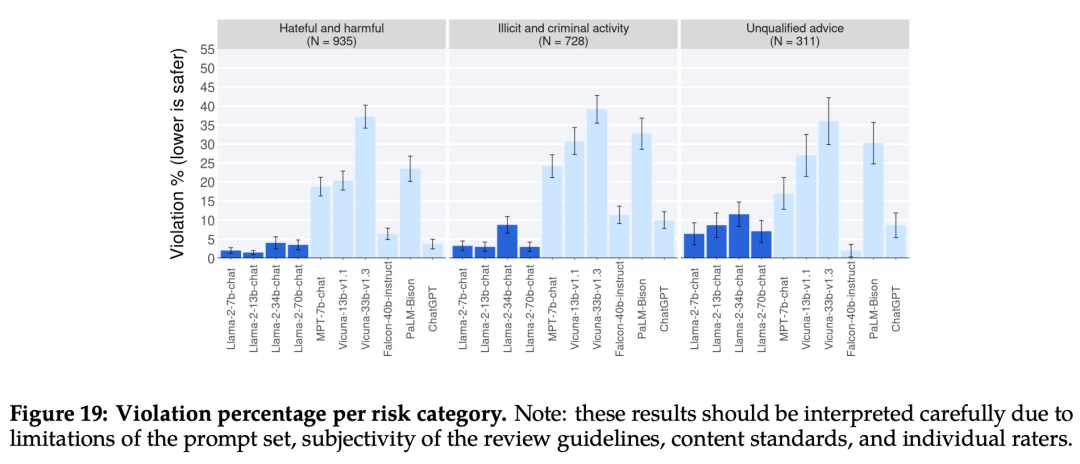

下圖 18 展示了單輪和多輪對話的違規百分比。跨模型的一個趨勢是,多輪對話更容易引發不安全的響應。也就是說,與基線相比,Llama 2-Chat 仍然表現良好,尤其是在多輪對話中。 下圖 19 顯示了不同 LLM 在不同類別中安全違規百分比。

下圖 19 顯示了不同 LLM 在不同類別中安全違規百分比。

4. 手機端運行大模型?Meta和高通達成協議,2024年推出“手機版Llama 2

原文:https://new.qq.com/rain/a/20230719A07B0I00

就在Meta官宣將與微軟攜手發布開源AI模型可商用版本Llama 2后,高通發布公告稱,將和Meta合作,2024年推出 “手機版Llama 2”。

Meta和高通的“野心”昭然若揭?

高通7月19日的最新公告顯示,從2024年起,Llama 2將能在旗艦智能手機和PC上運行:

客戶、合作伙伴和開發人員能構建智能虛擬助手、生產力應用、內容創建工具、娛樂等用例,AI功能可以在沒有網絡連接的地方,甚至在飛行模式下運行。

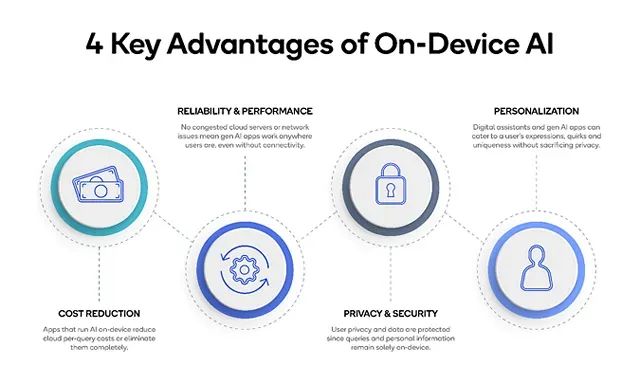

2024年在智能手機、PC、VR/AR頭顯和汽車等終端上運行Llama 2一類的生成式AI模型,將支持開發者節省云成本,并為用戶提供更加私密、可靠和個性化的體驗。

高通技術公司高級副總裁兼邊緣云計算解決方案業務總經理Durga Malladi表示,為了有效地將生成式人工智能推廣到主流市場,人工智能將需要同時在云端和邊緣終端(如智能手機、筆記本電腦、汽車和物聯網終端)上運行。

高通表示和基于云端的大語言模型相比,在智能手機等設備上運行Llama 2 等大型語言模型的邊緣云計算具有許多優勢,不僅成本更低、性能更好、可以在斷網的情況下工作,而且可以提供更個性化、更安全的AI服務。

對于市場而言,高通并沒有趕上本輪AI熱潮,年內股價漲幅甚至不及英偉達的1/10。

在這種情況下,高通已將AI邊緣計算定為未來發展方向。

高通公司高級副總裁Alex Katouzian5月曾明確表示,高通正在從一家通信公司過渡到一家智能邊緣計算公司:

“隨著連接設備和數據流量加速增長,疊加數據中心成本攀升,(我們)不可能將所有內容都發送到云端。”

不久前,高通已發布了全球首個在安卓手機上運行的Stable Diffusion終端側演示,演示中,搭載驍龍芯片的手機可以直接運行參數規模超過10億的Stable Diffusion,且只需要15秒左右就可以出圖。

“混合AI”新未來已至?

“混合”,就意味著云端要和手機、PC、XR頭顯、汽車這些終端設備協同工作,而不是單打獨斗,混合AI架構會根據大模型和查詢需求的復雜度,將任務負載以不同方式分配到云端和終端上。

這種混合AI架構能帶來的優勢是很明顯的,比如在成本、能耗、性能、隱私、安全和個性化等方面,本地化處理的融入都可以帶來很多加分項。

國盛證券指出,在AI向實際場景落地時,邊緣算力的重要性加速凸顯,邊緣算力在成本、時延、隱私上具有天然優勢,也可以作為橋梁,預處理海量復雜需求,并將其導向大模型。

因此,AI應用將逐步從中心節點向更貼近數據源和業務現場的邊緣側拓展,邊緣計算合理利用邊緣側算力和實時數據,使機器學習模型提供的智能服務更加便捷和貼近應用,有望打通行業細分、多元化場景落地瓶頸。

5. AI遭近萬名作家圍剿,版權大戰將如何塑造AI產業方向?

原文:https://finance.sina.com.cn/blockchain/roll/2023-07-20/doc-imzchwtv9479064.shtml

針對人工智能的版權大戰迎來了新階段,周二美國8500名作家在一封聯名信中要求人工智能公司賠償其版權損失。

聯名作家中包括普利策獎獲獎小說家詹妮弗·伊根、邁克爾·查邦和路易絲·厄德里奇等人,這些知名作家的加入也讓版權戰爭變得更具分量。

聯名信中寫道,數以百萬計的受版權保護的書籍、文章、詩歌等作品,成為了人工智能的養料,且不用付任何費用,這是不合理的。人工智能獲得了數十億美元的開發資金,現在應該對使用著作而付出補償。

這封信并非針對單一公司,OpenAI、微軟、Meta和其他人工智能公司都在警告范圍內。美國作家協會稱,若得不到補償,作家將無力繼續創作,人工智能只能借鑒現有的故事,變得越來越平庸。

老大難的版權問題

人工智能固然大大推動了這一技術在市場上的關注度,但隨著時間過去,越來越多的人開始意識到人工智能背后涉及的版權問題可能相當棘手。

美國作家協會要求人工智能企業做到三點:在使用材料前先獲得著作者許可;公平補償過去和現在已被使用素材的作者的損失;補償人工智能輸出相關版權內容所造成的損失。

目前,該協會尚未提出任何法律威脅,該協會首席執行官Mary Rasenberger指出,由于訴訟需要巨額費用,作家們需要很長時間來準備訴訟。

另一方面,人工智能公司都謹慎地對版權問題保持沉默,沒有一家公司希望做出頭鳥。連美國政府也對這一矛盾左右為難。

上周,美國國會討論了人工智能與版權保護之間的關系,參與聽證的Stability AI公司公共政策主管Ben Brooks透露,該公司收到超過1.6億個退出請求,因為創作者不希望自己的圖像被人工智能模型用以訓練。

而在被問到是否應該付費時,Brooks回避稱,發展模型需要數據多樣性。

參議員Marsha Blackburn抨擊道,所謂合理使用數據已經成為竊取知識產權的一種有效方法。

可能性

這一問題在國際上的討論也相當曲折。由于各國政府都希望發展自己的人工智能產業,因此對數據版權問題都抱有投鼠忌器的心態,目前為止,只有英國表示將放寬受版權保護材料的使用規則。

然而,雖然英國允許AI公司未經權利人許可的情況下使用材料訓練人工智能模型,但對于合法訪問的數據又存在模糊界限,這代表人工智能與版權的沖突仍舊突出。

有人借鑒音樂在21世紀初期的版權戰爭,當時Napster播放器獲得了幾乎所有人的歡迎,但其對版權的忽略引發了業內主要唱片公司的憤怒。最后,所有的利益相關者坐下來談判,由公司出面進行許可交易并界定如何合法引入內容。

這也極大的改變了音樂行業的游戲規則,免費播放器幾乎沒有生存之地,目前的音樂軟件都通過收費來向版權方支付版權費用。

反觀目前的人工智能產業,如ChatGPT已經通過收費來維持運營,但爭議點在于,其并沒有在收費中考慮有關于版權使用所需要支付的成本。

AI初創公司Wombo的Ryan Khurana認為,人工智能很可能演變出一個類似于音樂的許可制度。但律師Matthew Butterick認為類似的想法有些災難性,畢竟人工智能涉及的范圍更加廣泛。

還有人則聲稱,或許可以設立一項基金來補償受到人工智能模型訓練影響的人。但另一個問題出現:藝術家們對一次性許可費并不愿意買賬,分成和買斷的收益差距巨大。

更尖銳的問題是,技術專家Andy Baio指出,藝術家們受限于昂貴的訴訟費用,很可能讓版權戰爭變成曠日持久的消耗戰。因此人工智能版權最開始的那幾場版權訴訟結果將至關重要,將變成這一問題的風向標。

———————End———————

點擊閱讀原文進入官網

-

RT-Thread

+關注

關注

32文章

1402瀏覽量

41880

原文標題:【AI簡報20230721期】全球前十大MCU廠商榜單出爐,2024年將可以手機端運行大模型?

文章出處:【微信號:RTThread,微信公眾號:RTThread物聯網操作系統】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

【AI簡報20230721期】全球前十大MCU廠商榜單出爐,2024年將可以手機端運行大模型?

【AI簡報20230721期】全球前十大MCU廠商榜單出爐,2024年將可以手機端運行大模型?

評論