一、領域技術標準文檔或領域相關數(shù)據(jù)是領域模型Continue PreTrain的關鍵。

現(xiàn)有大模型在預訓練過程中都會加入書籍、論文等數(shù)據(jù),那么在領域預訓練時這兩種數(shù)據(jù)其實也是必不可少的,主要是因為這些數(shù)據(jù)的數(shù)據(jù)質量較高、領域強相關、知識覆蓋率(密度)大,可以讓模型更適應考試。當然不是說其他數(shù)據(jù)不是關鍵,比如領域相關網(wǎng)站內容、新聞內容都是重要數(shù)據(jù),只不過個人看來,在領域上的重要性或者知識密度不如書籍和技術標準。

二、領域數(shù)據(jù)訓練后,往往通用能力會有所下降,需要混合通用數(shù)據(jù)以緩解模型遺忘通用能力。

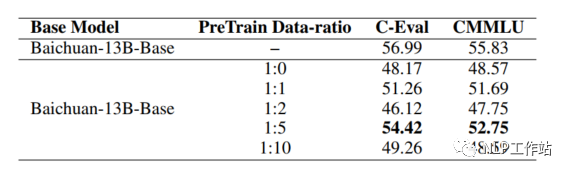

如果僅用領域數(shù)據(jù)進行模型訓練,模型很容易出現(xiàn)災難性遺忘現(xiàn)象,通常在領域訓練過程中加入通用數(shù)據(jù)。那么這個比例多少比較合適呢?目前還沒有一個準確的答案,BloombergGPT(從頭預訓練)預訓練金融和通用數(shù)據(jù)比例基本上為1:1,ChatHome(繼續(xù)預訓練)發(fā)現(xiàn)領域:通用數(shù)據(jù)比例為1:5時最優(yōu)。個人感覺應該跟領域數(shù)據(jù)量有關,當數(shù)據(jù)量沒有那多時,一般數(shù)據(jù)比例在1:5到1:10之間是比較合適的。

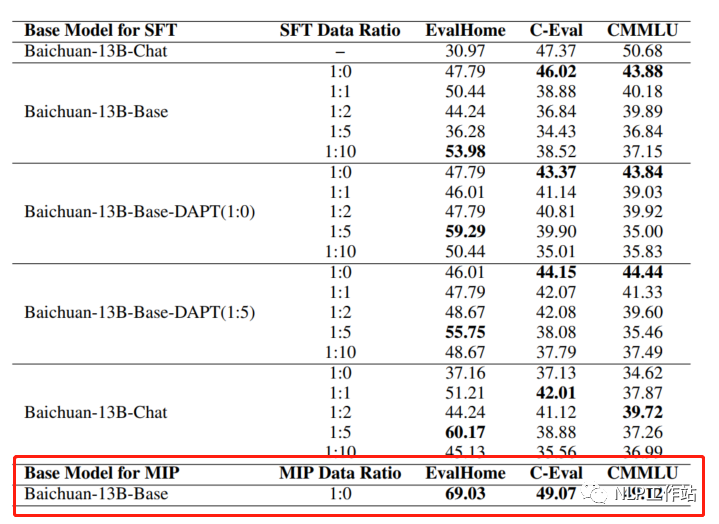

三、領域模型Continue PreTrain時可以同步加入SFT數(shù)據(jù),即MIP,Multi-Task Instruction PreTraining。

預訓練過程中,可以加下游SFT的數(shù)據(jù),可以讓模型在預訓練過程中就學習到更多的知識。例如:T5、ExT5、Glm-130b等多任務學習在預訓練階段可能比微調更有幫助。并且ChatHome發(fā)現(xiàn)MIP效果在領域上評測集上絕群。

四、 僅用SFT做領域模型時,資源有限就用在Chat模型基礎上訓練,資源充足就在Base模型上訓練。(資源=數(shù)據(jù)+顯卡)

跟很多人討論過一個問題,就是我們在SFT的時候是在Base模型上訓練還是在Chat模型上訓練。

其實很簡單,如果你只有5k數(shù)據(jù),建議你在Chat模型上進行微調;如果你有10w數(shù)據(jù),建議你在Base模型上進行微調。因為你不知Chat模型在SFT時的數(shù)據(jù)質量如何,當自己有能力時,靠人不如靠己。

五、在Chat模型上進行SFT時,請一定遵循Chat模型原有的系統(tǒng)指令&數(shù)據(jù)輸入格式。

如果你在Chat模型上進行SFT的時候,請跟Chat模型的輸入格式一致,否則當你數(shù)據(jù)量不足時,可能會導致訓練效果不明顯。并且建議不采用全量參數(shù)訓練,否則模型原始能力會遺忘較多。

六、領域評測集時必要內容,建議有兩份,一份選擇題形式自動評測、一份開放形式人工評測。

一定要有自己的領域數(shù)據(jù)集來驗證模型效果,來選擇最好的checkpoint。選擇題形式可以自動評測,方便模型進行初篩;開放形式人工評測比較浪費時間,可以用作精篩,并且任務形式更貼近真實場景。

七、領域模型詞表擴增是不是有必要的。

個人感覺,領域詞表擴增真實解決的問題是解碼效率的問題,給模型效果帶來的提升可能不會有很大。(這里領域詞表擴充是指在同語言模型上擴充詞表,而不是英文模型的中文漢化)

八、所謂的領域大模型會更新的越來越快,越來越多。

由于很多人&公司并沒有資源搞底座,因此需要在現(xiàn)有底座模型上進行增量預訓練、微調等。而以目前各廠(ChatGLM、BaiChuan、Qwen、Llama)搶占開源社區(qū)占比的架勢,感覺會有很多7B、13B級別模型開源。

請等待一言、ChatGPT開源小模型的一天,說不定GPT5出來的時候,Openai會開源個GPT3.5的小版本模型。

領域大模型落地的想法

一、常說通用模型的領域化可能是偽命題,那么領域大模型的通用化是否也是偽命題。

自訓練模型開始,就一直再跟Leader Battle這個問題,領域大模型需不需要有通用化能力。就好比華為盤古大模型“只做事不作詩”的slogan,是不是訓練的領域大模型可以解決固定的幾個任務就可以了。

個人的一些拙見是,如果想快速的將領域大模型落地,最簡單的是將系統(tǒng)中原有能力進行升級,即大模型在固定的某一個或某幾個任務上的效果超過原有模型。

以Text2SQL任務舉例,之前很多系統(tǒng)中的方法是通過抽取關鍵要素&拼接方式來解決,端到端解決的并不是很理想,那么現(xiàn)在完全可以用大模型SQL生成的能力來解決。在已有產(chǎn)品上做升級,是代價最小的落地方式。就拿我司做的“云中問道”來說,在解決某領域SQL任務上效果可以達到90%+,同比現(xiàn)有開源模型&開放API高了不少。

當然還有很多其他任務可以升級,例如:D2QA、D2SPO、Searh2Sum等等等。

二、領域大模型落地,任務場景要比模型能力更重要。

雖說在有產(chǎn)品上做升級,是代價最小的落地方式,但GPT4、AutoGPT已經(jīng)把人們胃口調的很高,所有人都希望直接提出一個訴求,大模型直接解決。但這對現(xiàn)有領域模型是十分困難的,所以在哪些場景上來用大模型是很關鍵的,并且如何將模型進行包裝,及時在模型能力不足的情況下,也可以讓用戶有一個很好的體驗。

現(xiàn)在很多人的疑惑是,先不說有沒有大模型,就算有了大模型都不知道在哪里使用,在私有領域都找不到一個Special場景。

所以最終大模型的落地,拼的不是模型效果本身,而是一整套行業(yè)解決方案,“Know How”成為了關鍵要素。

三、大多數(shù)企業(yè)最終落地的模型規(guī)格限制在了13B。

由于國情,大多數(shù)企業(yè)最終落地的方案應該是本地化部署,那么就會涉及硬件設備的問題。我并不絕的很有很多企業(yè)可以部署的起100B級別的模型,感覺真實部署限制在了10B級別。即使現(xiàn)在很多方法(例如:llama.cpp)可以對大模型進行加速,但100B級別的模型就算加速了,也是龐大資源消耗。

我之前說過“沒有體驗過33B模型的人,只會覺得13B就夠”,更大的模型一定要搞,但不影響最后落地的是10B級別。

做大模型的心路歷程

一開始ChatGPT剛剛爆火的時候,根本沒想過我們也配做大模型。但當國內涌現(xiàn)出了許多中文大模型,并Alpaca模型證明70億參數(shù)量的模型也有不錯效果的時候,給了我很大的信心,當然也給很多人和很多企業(yè)更多的信心。

在中小企業(yè)做大模型,經(jīng)常被質問的是“沒有100張卡也可以做大模型”,我只想說需要看對“大”的定義,175B的模型確實沒有資格觸碰,但33B的模型還是可以玩耍的。真正追趕OpenAI是需要一批人,但模型落地還是需要另外一批人的。

趕上大模型是我們的幸運,可以在領域大模型上發(fā)聲是我幸運。

總結

最后共勉:BERT時代況且還在用TextCNN,難道13B的模型就不叫大模型嗎?

審核編輯:劉清

-

MIP

+關注

關注

0文章

38瀏覽量

14236 -

SQL

+關注

關注

1文章

781瀏覽量

44848 -

SFT

+關注

關注

0文章

9瀏覽量

6882 -

OpenAI

+關注

關注

9文章

1204瀏覽量

8663 -

ChatGPT

+關注

關注

29文章

1588瀏覽量

8828

原文標題:領域大模型-訓練Trick&落地思考

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

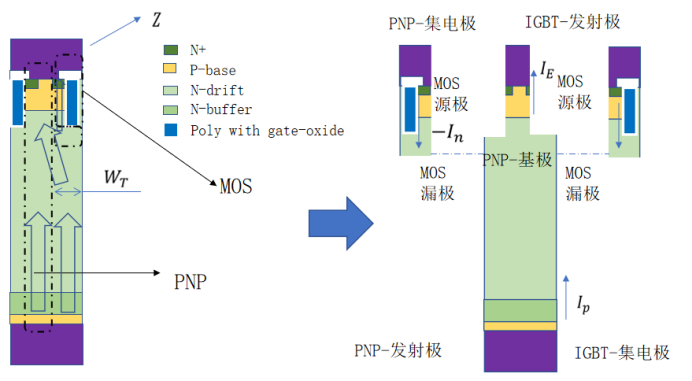

IGBT的物理結構模型—BJT&MOS模型(1)

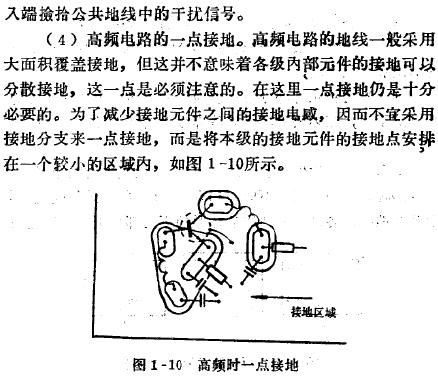

一點接地,什么是一點接地,一點接地應注意的問題

關于連接的問答:歐盟 Wi-Fi 6 &amp; 6E 的未來發(fā)展

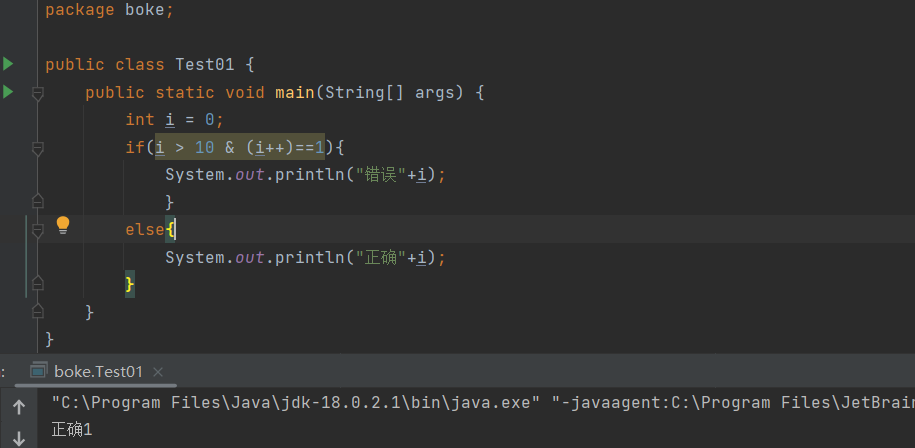

如何區(qū)分Java中的&amp;和&amp;&amp;

if(a==1 &amp;&amp; a==2 &amp;&amp; a==3),為true,你敢信?

攝像機&amp;amp;雷達對車輛駕駛的輔助

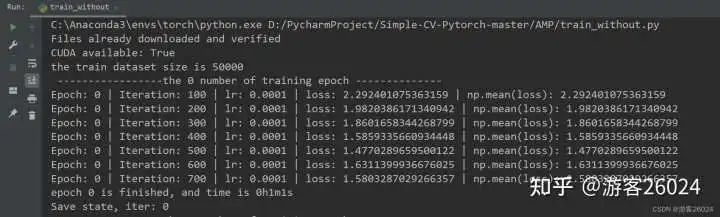

如何讓網(wǎng)絡模型加速訓練

關于領域大模型-訓練Trick&落地的一點思考

關于領域大模型-訓練Trick&落地的一點思考

評論