來自伯克利人工智能研究(BAIR)實驗室的研究人員開源深度學習模型 InstructPix2Pix,它可以遵循人類指令來編輯圖像。InstructPix2Pix 在合成數據上進行訓練,表現優于基線 AI 圖像編輯模型。

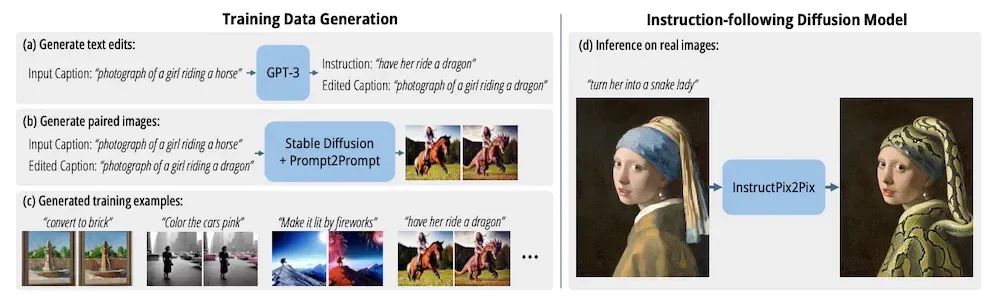

BAIR 團隊在最近舉行的 2023 年 IEEE/CVF 計算機視覺和模式識別(CVPR)大會上展示了他們的工作成果。他們先是生成了一個合成訓練數據集,其中的訓練樣本是成對的圖像以及用于將第一幅圖像轉換為第二幅圖像的編輯指令。該數據集用于訓練圖像生成擴散模型,該模型可以接受基于文本的指令來編輯圖像。例如,給定一張騎馬的人的圖片和提示詞“讓她變成騎龍”,它會輸出原始圖片,但原來的馬被替換了龍。BAIR 的研究人員的表示:

盡管模型完全是在合成樣本上進行訓練的,但它實現了對任意真實圖像和人類自然語言指令的零樣本泛化。我們的模型能夠進行直觀的圖像編輯,可以遵循人類指令執行多種編輯:替換對象、改變圖像風格、修改設置、藝術媒介等。

之前的 AI 圖像編輯能力通常是進行風格轉換,流行的文本到圖像生成模型(如 DALL-E 和 Stable Diffusion)也支持圖像到圖像風格轉換操作。然而,使用這些模型進行有針對性的編輯仍然具有挑戰性。最近,InfoQ 報道了微軟的 Visual ChatGPT,它可以調用外部工具來編輯圖像,前提是提供編輯操作的文本描述。

為了訓練 InstructPix2Pix,BAIR 首先創建了一個合成數據集。為此,團隊在一個由輸入文字說明、編輯指令和期望輸出文字說明組成的人類文本樣本的小數據集上對 GPT-3 進行了微調。然后,這個微調模型被給予一個大型的輸入圖像文字說明數據集,從中生成了超過 450k 次編輯和輸出文字說明。然后,團隊將輸入和輸出文字說明饋送到預訓練的 Prompt-to-Prompt 模型中,該模型根據文字說明生成成對的相似圖像。

InstructPix2Pix 的架構,圖片來源:https://arxiv.org/abs/2211.09800

研究人員鑒于這個數據集訓練了基于 Stable Diffusion 的 InstructPix2Pix。為了評估其性能,團隊將其輸出與基線模型 SDEdit 進行了比較。他們使用兩個指標之間的權衡:一致性(即輸入圖像和編輯后圖像的 CLIP 嵌入之間的余弦相似度)和方向相似性(即編輯后文字說明中的變化與編輯后圖像的變化在多大程度上保持一致)。在實驗中,對于給定的方向相似性值,InstructPix2Pix 產生的圖像比 SDEdit 具有更高的一致性。

人工智能研究員吳恩達在他的深度學習新聞郵件組“The Batch”中評價了 InstructPix2Pix:

這項工作簡化了生成和人造圖像的編輯操作,并提供了更一致的結果。巧妙地利用現有模型,模型作者能夠使用相對較少的人類標記樣本在新任務上訓練他們的模型。

InstructPix2Pix 的代碼可在 GitHub 上獲取,模型和基于 Web 的演示可在 Huggingface 上訪問。

-

Web

+關注

關注

2文章

1283瀏覽量

70845 -

人工智能

+關注

關注

1804文章

48737瀏覽量

246678 -

模型

+關注

關注

1文章

3488瀏覽量

50021 -

數據集

+關注

關注

4文章

1223瀏覽量

25284

原文標題:伯克利 AI 實驗室開源圖像編輯模型 InstructPix2Pix,簡化生成圖像編輯并提供一致結果

文章出處:【微信號:AI前線,微信公眾號:AI前線】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

利用NVIDIA 3D引導生成式AI Blueprint控制圖像生成

華為智算實驗室解決方案助力科研創新高質量發展

阿里巴巴Qwen大模型助力開發低成本DeepSeek替代方案

SparseViT:以非語義為中心、參數高效的稀疏化視覺Transformer

借助谷歌Gemini和Imagen模型生成高質量圖像

伯克利AI實驗室開源圖像編輯模型InstructPix2Pix,簡化生成圖像編輯并提供一致結果

伯克利AI實驗室開源圖像編輯模型InstructPix2Pix,簡化生成圖像編輯并提供一致結果

評論