Middlebury立體測(cè)評(píng)網(wǎng)站是計(jì)算機(jī)視覺領(lǐng)域的重要資源,它為研究人員和工程師提供了一個(gè)評(píng)估和比較立體視覺算法的標(biāo)準(zhǔn)化平臺(tái)。無論你是學(xué)術(shù)界的研究者還是工業(yè)界的從業(yè)者,通過使用Middlebury立體測(cè)評(píng)網(wǎng)站,你可以在算法開發(fā)中更好地了解和改進(jìn)立體匹配算法。本文將為你提供關(guān)于Middlebury立體測(cè)評(píng)網(wǎng)站的詳細(xì)使用指南,幫助你充分利用該平臺(tái)。

一、middlebury數(shù)據(jù)集是什么?

Middlebury數(shù)據(jù)集是用于立體視覺算法評(píng)估的一系列標(biāo)準(zhǔn)化數(shù)據(jù)集,由Middlebury大學(xué)維護(hù)。立體視覺是計(jì)算機(jī)視覺領(lǐng)域中的一個(gè)重要研究方向,其目標(biāo)是從不同角度獲取的圖像中,恢復(fù)出場(chǎng)景中物體的三維信息,即深度或視差圖。

Middlebury數(shù)據(jù)集的設(shè)計(jì)旨在提供一組公共標(biāo)準(zhǔn),讓研究者和開發(fā)者能夠在相同的基準(zhǔn)下比較和評(píng)估他們開發(fā)的立體視覺算法。這些數(shù)據(jù)集涵蓋了多個(gè)任務(wù),包括立體圖像重建、立體匹配、光流估計(jì)等。

Middlebury數(shù)據(jù)集是圖像計(jì)算領(lǐng)域中廣為使用的一系列立體和光流圖像數(shù)據(jù)集。它是由Middlebury計(jì)算機(jī)視覺研究組織創(chuàng)建和維護(hù)的,旨在為研究者和開發(fā)者提供可靠的圖像數(shù)據(jù),以評(píng)估和比較不同的計(jì)算機(jī)視覺算法。

其中,立體圖像數(shù)據(jù)集包含由兩個(gè)或多個(gè)攝像機(jī)捕獲的圖像對(duì),用于生成立體深度地圖。光流圖像數(shù)據(jù)集則包含了連續(xù)幀之間的像素位移信息,用于分析和推斷對(duì)象在時(shí)間上的運(yùn)動(dòng)。

Middlebury數(shù)據(jù)集以其高質(zhì)量的標(biāo)注和真實(shí)場(chǎng)景的代表性而聞名。這些數(shù)據(jù)集經(jīng)過仔細(xì)設(shè)計(jì)和選取,以提供豐富的挑戰(zhàn)性問題和復(fù)雜的圖像場(chǎng)景,以促進(jìn)對(duì)計(jì)算機(jī)視覺算法的真實(shí)性能評(píng)估。

對(duì)于研究者和開發(fā)者來說,Middlebury數(shù)據(jù)集是一份寶貴的資源,可以用于測(cè)試自己的算法、比較不同算法的性能,并為新算法的開發(fā)提供可靠的基準(zhǔn)。大量的研究論文和學(xué)術(shù)會(huì)議都使用Middlebury數(shù)據(jù)集作為他們算法的評(píng)估標(biāo)準(zhǔn)。

Middlebury數(shù)據(jù)集可以通過Middlebury計(jì)算機(jī)視覺研究組織的官方網(wǎng)站免費(fèi)獲取。研究者和開發(fā)者可以根據(jù)自己的需求和興趣,在這些數(shù)據(jù)集上進(jìn)行各種圖像計(jì)算任務(wù)的研究和實(shí)驗(yàn)。

二、middlebury網(wǎng)址是什么?

https://vision.middlebury.edu/

根據(jù) vision.middlebury.edu 網(wǎng)站的介紹,這是一個(gè)計(jì)算機(jī)視覺評(píng)估和數(shù)據(jù)集的存儲(chǔ)庫。網(wǎng)站包含以下內(nèi)容:

Middlebury立體視覺頁面:用于評(píng)估密集的雙幀立體視覺算法(詳細(xì)介紹見IJCV 2002)。

多視圖立體頁面:用于評(píng)估多視圖立體視覺算法(CVPR 2006上發(fā)布)。

MRF頁面:用于評(píng)估用于馬爾可夫隨機(jī)場(chǎng)的能量最小化方法(ECCV 2006上發(fā)布)。

光流頁面:用于評(píng)估光流算法(ICCV 2007上發(fā)布)。

色彩頁面:提供用于評(píng)估數(shù)字相機(jī)色彩處理的數(shù)據(jù)集(BMVC 2009上發(fā)布)

三、middlebury立體測(cè)評(píng)?

https://vision.middlebury.edu/stereo/

https://vision.middlebury.edu/stereo/ 是Middlebury立體視覺頁面的鏈接,在這個(gè)頁面上,你可以找到關(guān)于立體視覺算法的評(píng)估和數(shù)據(jù)集的詳細(xì)信息。

Middlebury立體視覺頁面是用于評(píng)估密集的兩幀立體視覺算法的平臺(tái)。它包括了:

當(dāng)前算法的在線排名

許多具有地面實(shí)況差異的立體數(shù)據(jù)集

一個(gè)離線腳本,評(píng)估立體聲算法

一個(gè)在線提交腳本,評(píng)估立體聲算法

在這個(gè)頁面上,你可以找到每個(gè)數(shù)據(jù)集的詳細(xì)描述,包括數(shù)據(jù)集的來源、圖像數(shù)量、分辨率和深度圖等。此外,頁面還提供了一些參考算法和評(píng)價(jià)標(biāo)準(zhǔn),用于幫助評(píng)估和比較不同算法的性能。該頁面還包含了一些用于可視化和比較算法結(jié)果的工具和軟件。你可以使用這些工具來直觀地呈現(xiàn)立體視覺算法的輸出,并與其他算法進(jìn)行比較。

3.1 當(dāng)前算法的在線排名

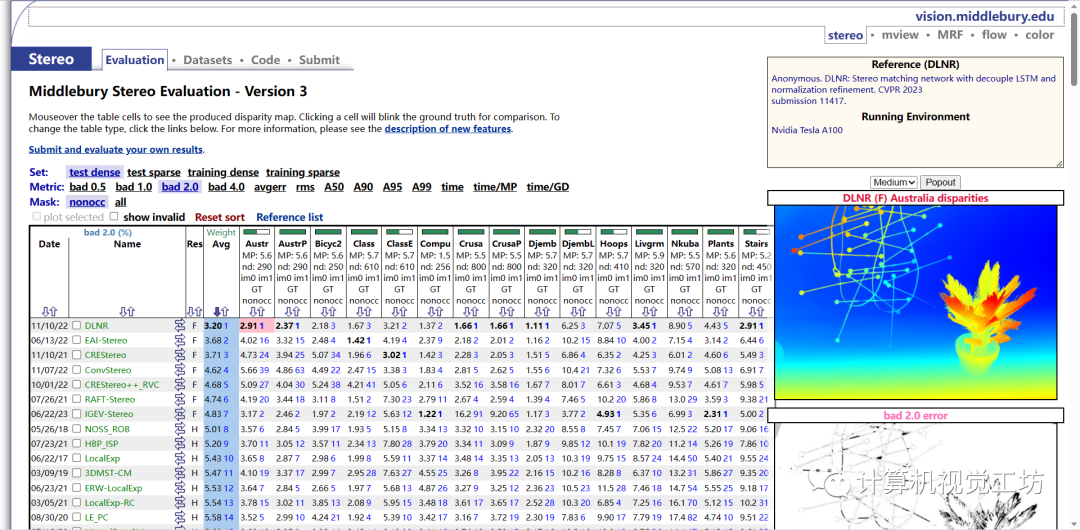

該頁面包含了一個(gè)交互式的表格,用于展示不同數(shù)據(jù)集和評(píng)估指標(biāo)的結(jié)果。你可以通過鼠標(biāo)懸停在表格單元格上,查看生成的視差圖。同時(shí),點(diǎn)擊單元格可以切換顯示地面真實(shí)值以進(jìn)行比較。你還可以通過點(diǎn)擊頁面上的鏈接,切換表格類型或了解新功能的描述。

Set: 設(shè)置或數(shù)據(jù)集的不同類型。在這種情況下,可能有以下設(shè)置/數(shù)據(jù)集:

test: 測(cè)試集

densetest: 密集測(cè)試集

sparsetraining: 稀疏訓(xùn)練集

densetraining: 密集訓(xùn)練集

sparse: 稀疏數(shù)據(jù)

Metric: 表示用于對(duì)視差圖進(jìn)行評(píng)估的不同指標(biāo)。在這種情況下,可能有以下指標(biāo):

bad 0.5: 視差值誤差小于等于0.5的比例

bad 1.0: 視差值誤差小于等于1.0的比例

bad 2.0: 視差值誤差小于等于2.0的比例

bad 4.0: 視差值誤差小于等于4.0的比例

avgerr: 平均誤差

rms: 均方根誤差

A50: 視差誤差小于等于50%的比例

A90: 視差誤差小于等于90%的比例

A95: 視差誤差小于等于95%的比例

A99: 視差誤差小于等于99%的比例

time: 執(zhí)行時(shí)間

time/MP: 每百萬像素的執(zhí)行時(shí)間

time/GD: 每個(gè)視差的執(zhí)行時(shí)間

Mask: 掩碼或遮擋的類型。在這種情況下,可能有以下類型:

nonocc: 非遮擋的區(qū)域

all: 所有區(qū)域(包括遮擋區(qū)域和非遮擋區(qū)域)

3.2 許多具有地面實(shí)況差異的立體數(shù)據(jù)集

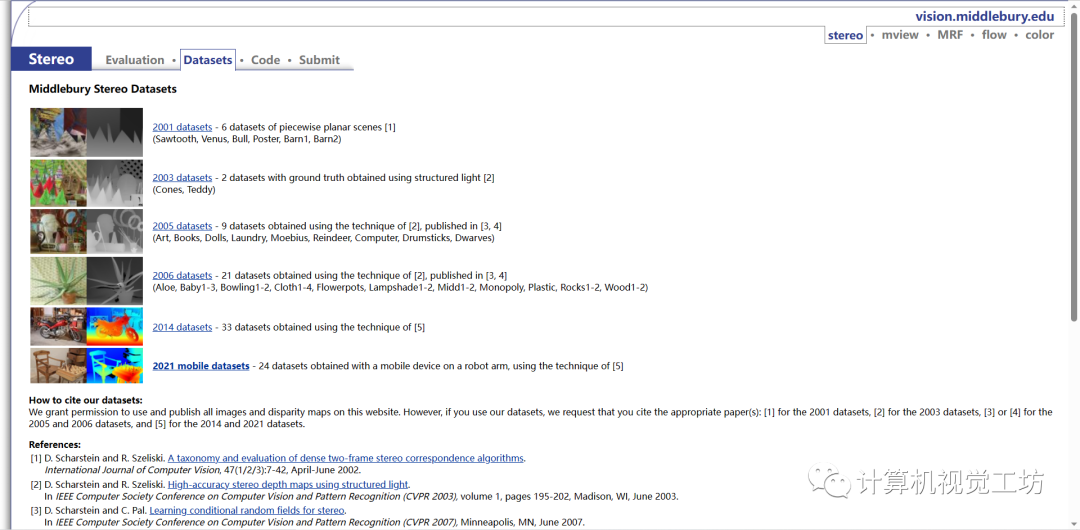

在該頁面上,你可以找到middleburry提供的多個(gè)立體數(shù)據(jù)集的詳細(xì)信息和下載鏈接。這些數(shù)據(jù)集包含了成對(duì)的左右圖像,以及對(duì)應(yīng)的地面真實(shí)視差圖。這些數(shù)據(jù)集的制作遵循一定的標(biāo)準(zhǔn)和規(guī)范,廣泛應(yīng)用于立體視覺算法的訓(xùn)練和評(píng)估。

頁面上列出的數(shù)據(jù)集包括了各種場(chǎng)景和復(fù)雜度,并標(biāo)注了不同數(shù)據(jù)集的特點(diǎn)和用途。你可以瀏覽不同數(shù)據(jù)集的描述,了解其特點(diǎn)以及適用的應(yīng)用場(chǎng)景。同時(shí),你也可以點(diǎn)擊鏈接下載對(duì)應(yīng)數(shù)據(jù)集的圖像和視差文件。

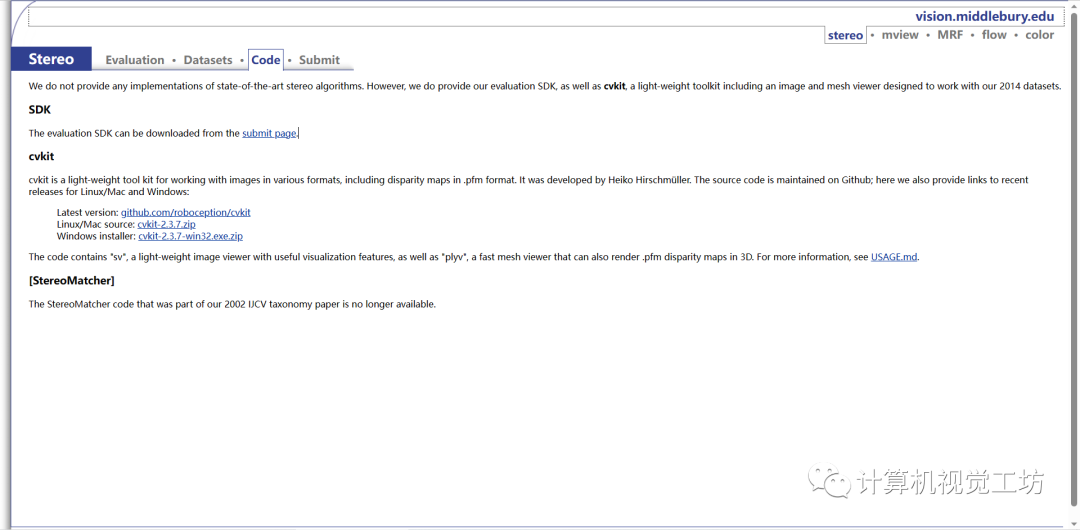

3.3 一個(gè)離線腳本,評(píng)估立體聲算法

cvkit是一個(gè)輕量級(jí)的圖像處理工具包,可用于處理各種格式的圖像,包括.pfm格式的視差圖。它由Heiko Hirschmüller開發(fā)。源代碼在Github上維護(hù);在這里,作者還提供了針對(duì)Linux/Mac和Windows最近發(fā)布版本的鏈接:

最新版本:https://github.com/roboception/cvkit

該代碼包含了名為"sv"的輕量級(jí)圖像查看器,具有有用的可視化功能,并且包含了"plyv",一個(gè)快速的網(wǎng)格查看器,也可以在3D中呈現(xiàn).pfm的視差圖。有關(guān)更多信息,請(qǐng)參閱USAGE.md。這里也推薦「3D視覺工坊」新課程《徹底剖析激光-視覺-IMU-GPS融合SLAM算法:理論推導(dǎo)、代碼講解和實(shí)戰(zhàn)》

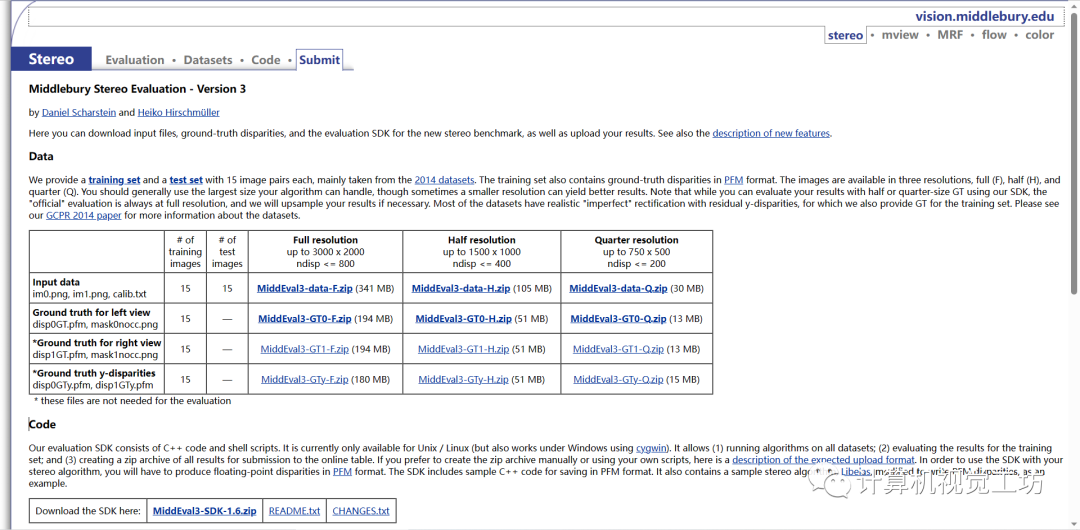

3.4 一個(gè)在線提交腳本,評(píng)估立體聲算法

調(diào)整 SDK 以運(yùn)行算法或手動(dòng)創(chuàng)建 zip 文件后,您可以上傳結(jié)果。您可以根據(jù)需要多次上傳和評(píng)估訓(xùn)練集上的結(jié)果。與之前版本的立體評(píng)估一樣,您將在臨時(shí)表中看到您的結(jié)果與訓(xùn)練集上所有其他提交的結(jié)果的比較情況。獲得最終結(jié)果集后,您可以將結(jié)果上傳到訓(xùn)練集和測(cè)試集上,并請(qǐng)求發(fā)布這兩組結(jié)果。為了防止擬合測(cè)試數(shù)據(jù),我們只允許每個(gè)方法這樣做一次,并且在測(cè)試結(jié)果發(fā)布之前,您將無法看到測(cè)試結(jié)果。請(qǐng)僅上傳“最終”結(jié)果(已發(fā)表或即將提交給會(huì)議或期刊)。請(qǐng)注意,我們只允許表中每個(gè)發(fā)布有一個(gè)結(jié)果。如果您有多個(gè)算法變體,則可以在訓(xùn)練集上評(píng)估它們,但應(yīng)僅選擇并上傳一個(gè)結(jié)果進(jìn)行發(fā)布。

審核編輯:彭菁

-

圖像

+關(guān)注

關(guān)注

2文章

1094瀏覽量

41083 -

網(wǎng)站

+關(guān)注

關(guān)注

2文章

259瀏覽量

23483 -

計(jì)算機(jī)視覺

+關(guān)注

關(guān)注

9文章

1706瀏覽量

46617 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25317

原文標(biāo)題:總結(jié)!Middlebury立體測(cè)評(píng)網(wǎng)站使用指南

文章出處:【微信號(hào):3D視覺工坊,微信公眾號(hào):3D視覺工坊】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

請(qǐng)問NanoEdge AI數(shù)據(jù)集該如何構(gòu)建?

請(qǐng)問NanoEdge AI數(shù)據(jù)集該如何構(gòu)建?

數(shù)據(jù)集下載失敗的原因?

自己數(shù)據(jù)如何制作tfrecords格式數(shù)據(jù)集

多維數(shù)據(jù)集是什么

基于非對(duì)稱空間金字塔池化模型的CNN結(jié)構(gòu)

基于非對(duì)稱空間金字塔池化模型的CNN結(jié)構(gòu)

最全自動(dòng)駕駛數(shù)據(jù)集分享系列一:目標(biāo)檢測(cè)數(shù)據(jù)集

middlebury數(shù)據(jù)集是什么

middlebury數(shù)據(jù)集是什么

評(píng)論