本次文章介紹我們于 TPAMI-2023 發表的一項用于視覺識別的相互對比學習在線知識蒸餾(Online Knowledge Distillation via Mutual Contrastive Learning for Visual Recognition)工作,該工作是我們發表在 AAAI-2022 論文 Mutual contrastive learning for visual representation learning [1] 的擴展版本,論文講解鏈接為:

https://zhuanlan.zhihu.com/p/574701719 摘要:無需教師的在線知識蒸餾聯合地訓練多個學生模型并且相互地蒸餾知識。雖然現有的在線知識蒸餾方法獲得了很好的性能,但是這些方法通常關注類別概率作為核心知識類型,忽略了有價值的特征表達信息。 本文展示了一個相互對比學習(Mutual Contrastive Learning,MCL)框架用于在線知識蒸餾。MCL 的核心思想是在一個網絡群體中利用在線的方式進行對比分布的交互和遷移。MCL 可以聚合跨網絡的嵌入向量信息,同時最大化兩個網絡互信息的下界。這種做法可以使得每一個網絡可以從其他網絡中學習到額外的對比知識,從而有利于學習到更好的特征表達,提升視覺識別任務的性能。 相比于會議版本,期刊版本將 MCL 擴展到中間特征層并且使用元優化來訓練自適應的層匹配機制。除了最后一層,MCL 也在中間層進行特征對比學習,因此新方法命名為 Layer-wise MCL(L-MCL)。在圖像分類和其他視覺識別任務上展示了 L-MCL 相比于先進在線知識蒸餾方法獲得了一致的提升。此優勢表明了 L-MCL 引導網絡產生了更好的特征表達。

論文地址:

https://arxiv.org/pdf/2207.11518.pdf

代碼地址:https://github.com/winycg/L-MCL

引言

傳統的離線知識蒸餾需要預訓練的教師模型對學生模型進行監督。在線知識蒸餾在無需教師的情況下同時聯合訓練兩個以上的學生模型。深度相互學習(Deep Mutual Learning,DML)[2]表明了模型群體可以從相互學習類別概率分布(圖像分類任務最后的輸出預測)中獲益。每一個模型在同伴教授的模式下相比傳統的單獨訓練效果更好。 現有的在線知識蒸餾方法通常僅僅關注結果驅動的蒸餾,但是忽略了在線蒸餾特征方面的應用。雖然先前的 AFD [3]嘗試通過在線的方式在多個網絡間對齊中間特征圖,Zhang 等人[2]指出這種做法會減少群體多樣性,降低相互學習能力。為了學習更有意義的特征嵌入,我們認為一個更好的方式是從視覺表征學習角度的對比學習。

方法

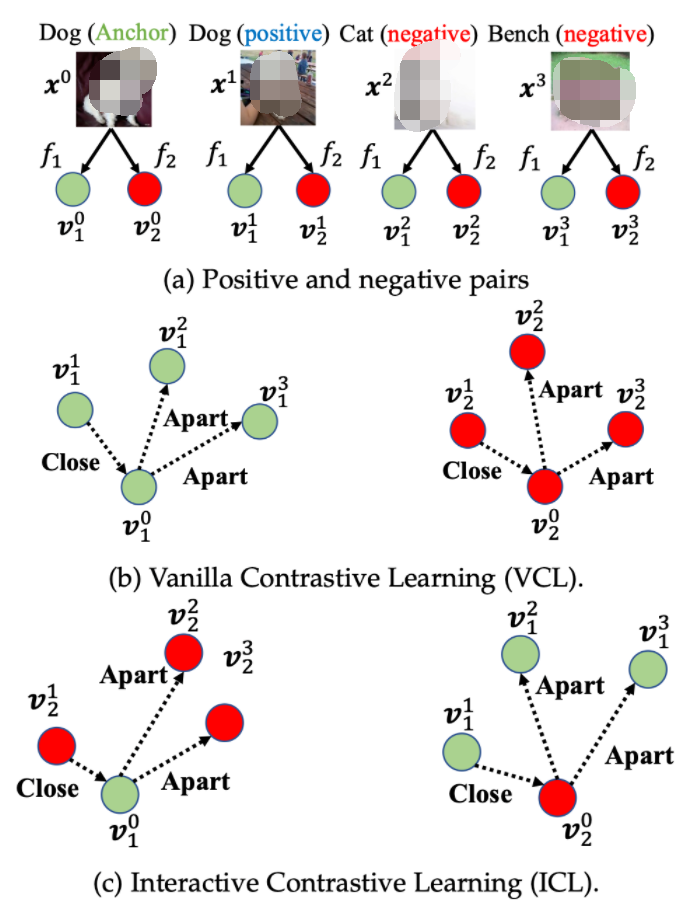

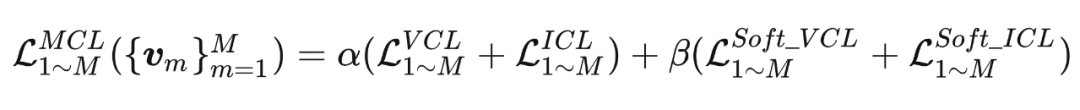

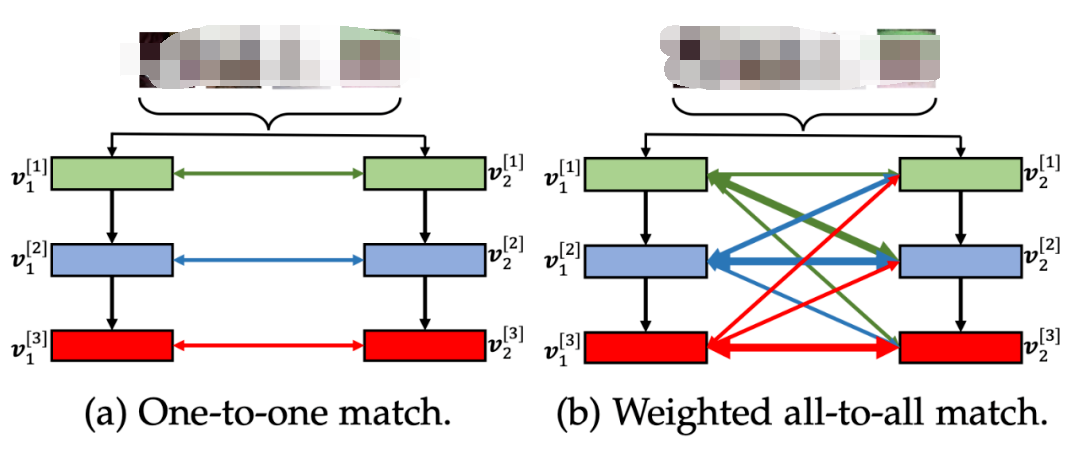

2.1. 相互對比學習MCL(AAAI-2022)

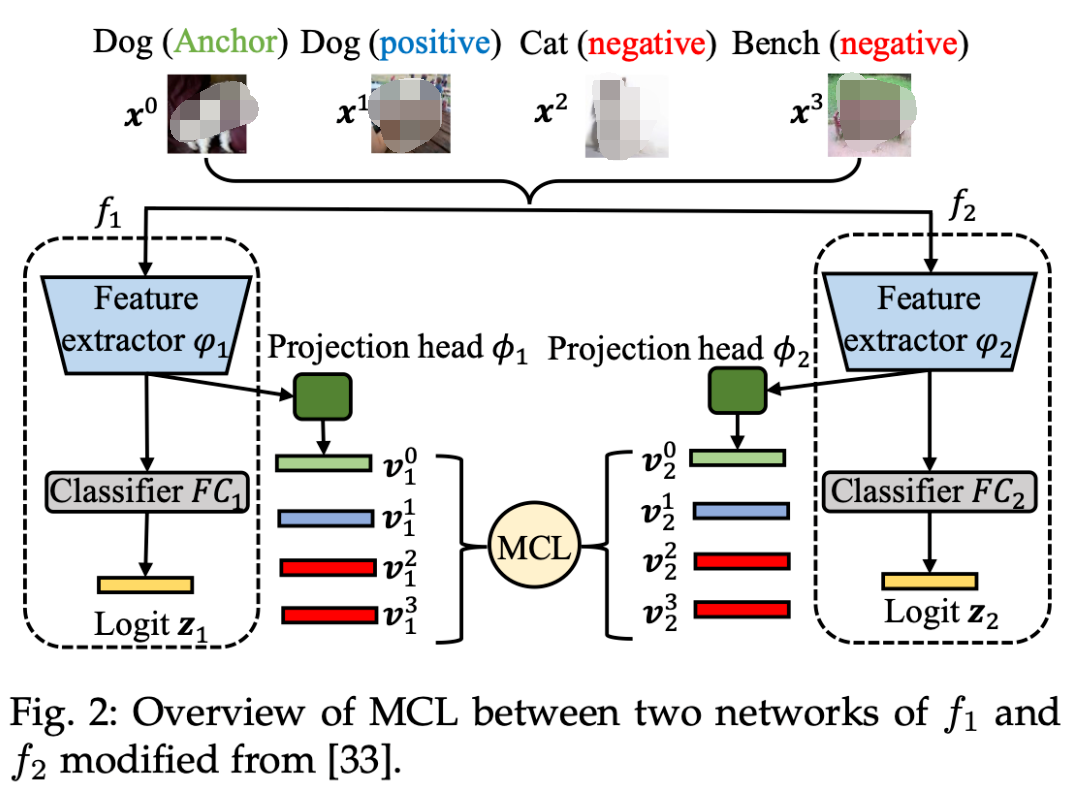

▲ 圖2. 相互對比學習整體示意圖

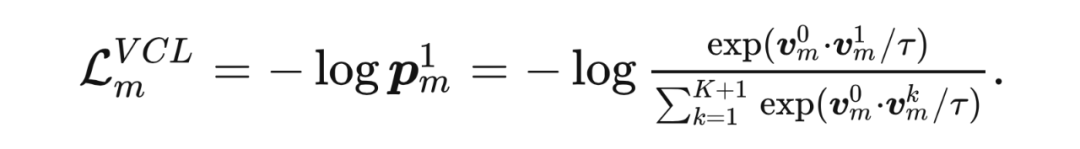

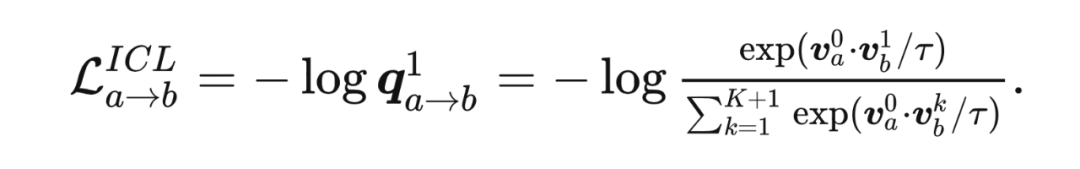

2.1.1 傳統對比學習(Vanilla Contrastive Learning,VCL) 為了便于描述,本方法將 anchor 樣本向量表示為 , 正樣本向量表示為 和 個負樣本向量表達為。 表示向量產生自網絡 。這里,特征向量通過 標準化進行預處理。使用基于 InfoNCE 的交叉熵作為對比誤差:

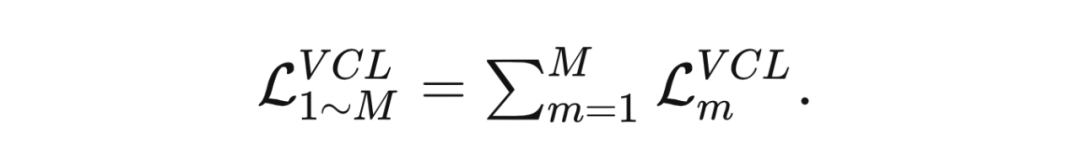

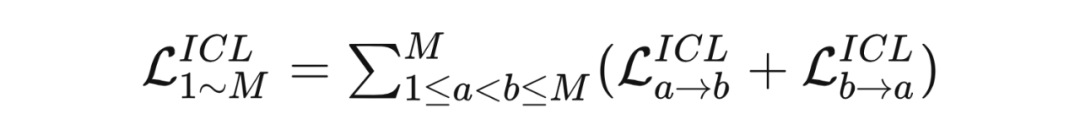

?對于總共 個網絡來說,所有的對比誤差表示為:

?對于總共 個網絡來說,所有的對比誤差表示為:

理論分析:

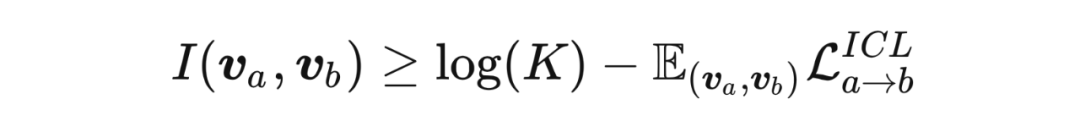

相比于誤差 ,最小化 等價于最大化網絡 互信息 的下界:

理論分析:

相比于誤差 ,最小化 等價于最大化網絡 互信息 的下界:

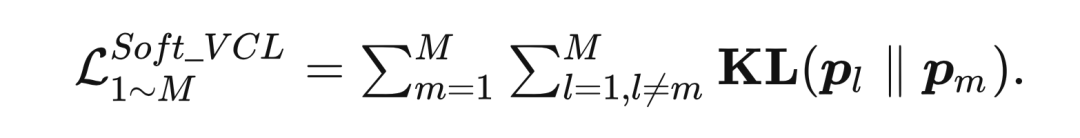

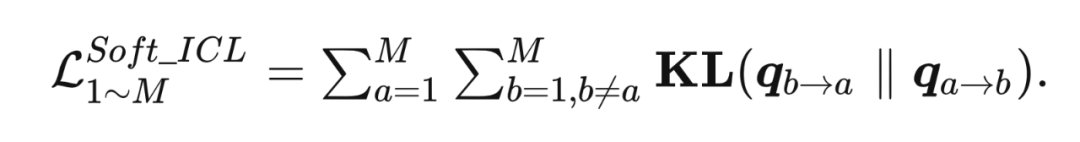

2.1.3 基于在線相互遷移的軟對比學習 收到深度相互學習(Deep Mutual Learning,DML)[1] 的啟發,本方法利用 KL 散度來對齊網絡間的對比分布,根據本文提出的兩種對比學習方法 VCL 和 ICL 來進行對比分布的雙向遷移:

2.1.3.1 Soft VCL: 對于產生 的分布 來說,其監督信號是其他網絡產生的分布,利用 KL 散度使得 與其他分布接近:

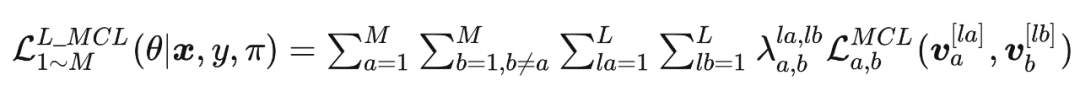

下一個章節,本文展示如何利用元網絡 來優化匹配權重 。

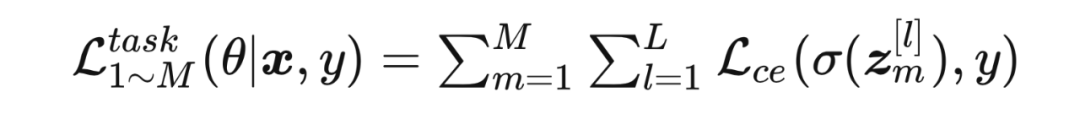

下一個章節,本文展示如何利用元網絡 來優化匹配權重 。2.2.2 訓練元網絡 2.2.2.1 交叉熵任務誤差 使用交叉熵誤差訓練 個網絡:

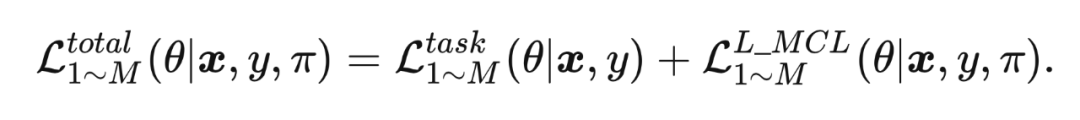

?將基礎的任務誤差和 L-MCL 誤差相加作為總誤差來進行特征層面的在線蒸餾誤差:

?將基礎的任務誤差和 L-MCL 誤差相加作為總誤差來進行特征層面的在線蒸餾誤差:

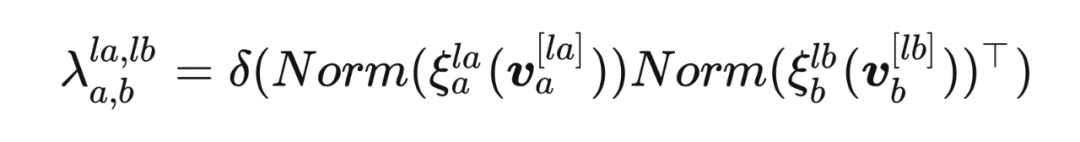

2.2.2.3 元網絡 結構元網絡包含了兩個線性轉換層 和 ,來對輸入的特征向量 進行轉換。轉換之后,特征向量通過 正則化 來進行標準化。受到自注意力機制的啟發,本文利用點乘得到匹配特征的相似性,從而衡量匹配層的相關性,然后引入 sigmoid 激活函數 來將輸出值縮放到 作為層匹配權重 。整體的過程被規則化為:

實驗

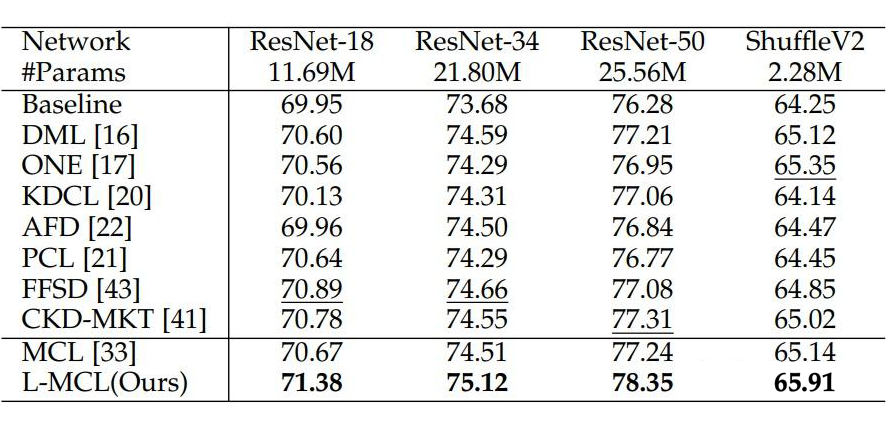

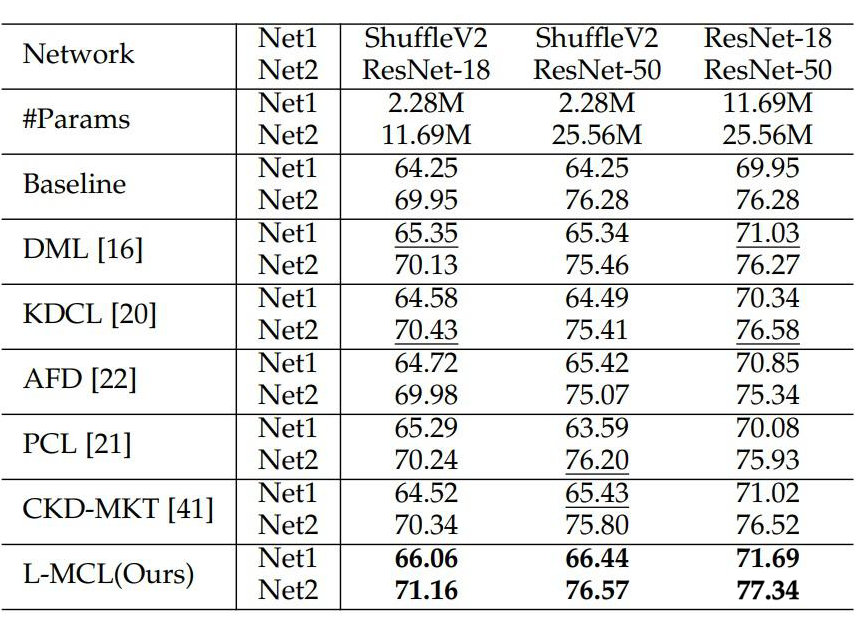

在 ImageNet 上的實驗結果如下所示,表 1 和表 2 分別展示了兩個同構和異構網絡利用相互對比學習的實驗結果。

▲表2. 兩個異構網絡利用相互對比學習的實驗結果

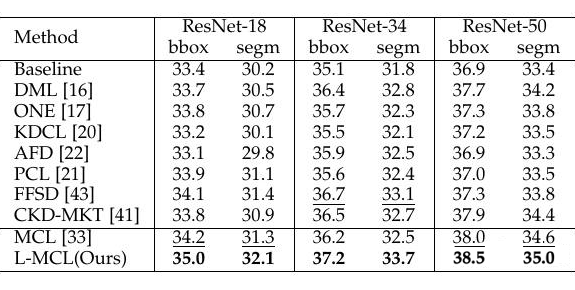

實驗結果表明本文提出的 L-MCL 相比于 baseline 以及先前流行的在線知識蒸餾方法都獲得了顯著的性能提升,表明在多個網絡之間使用特征層面的對比學習蒸餾相比概率分布效果更好。在下游的目標檢測和實例分割實驗上表明了該方法相比先前的蒸餾方法引導網絡學習到了更好的視覺表征,從而提升了視覺識別效果。

▲表2. 兩個異構網絡利用相互對比學習的實驗結果

實驗結果表明本文提出的 L-MCL 相比于 baseline 以及先前流行的在線知識蒸餾方法都獲得了顯著的性能提升,表明在多個網絡之間使用特征層面的對比學習蒸餾相比概率分布效果更好。在下游的目標檢測和實例分割實驗上表明了該方法相比先前的蒸餾方法引導網絡學習到了更好的視覺表征,從而提升了視覺識別效果。

▲ 表3. 通過在線蒸餾的預訓練網絡遷移到下游的目標檢測和與實例分割的實驗

參考文獻

?[1] Yang C, An Z, Cai L, et al. Mutual contrastive learning for visual representation learning[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2022, 36(3): 3045-3053.[2] Zhang Y, Xiang T, Hospedales T M, et al. Deep mutual learning[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2018: 4320-4328.[3] Chung I, Park S U, Kim J, et al. Feature-map-level online adversarial knowledge distillation[C]//International Conference on Machine Learning. PMLR, 2020: 2006-2015.

·

?[1] Yang C, An Z, Cai L, et al. Mutual contrastive learning for visual representation learning[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2022, 36(3): 3045-3053.[2] Zhang Y, Xiang T, Hospedales T M, et al. Deep mutual learning[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2018: 4320-4328.[3] Chung I, Park S U, Kim J, et al. Feature-map-level online adversarial knowledge distillation[C]//International Conference on Machine Learning. PMLR, 2020: 2006-2015.

·

-

物聯網

+關注

關注

2928文章

46032瀏覽量

389699

原文標題:TPAMI 2023 | 用于視覺識別的相互對比學習在線知識蒸餾

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯網技術研究所】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

基于LockAI視覺識別模塊:C++條碼識別

基于LockAI視覺識別模塊:C++同時識別輪廓和色塊

基于LockAI視覺識別模塊:C++圖像采集例程

大連理工提出基于Wasserstein距離(WD)的知識蒸餾方法

ASR與傳統語音識別的區別

使用 TMP1826 嵌入式 EEPROM 替換用于模塊識別的外部存儲器

TPAMI 2023 | 用于視覺識別的相互對比學習在線知識蒸餾

TPAMI 2023 | 用于視覺識別的相互對比學習在線知識蒸餾

評論