★OpenAI;ChatGPT;Sam Altman;Assistance API;GPT4 Turbo;DALL-E 3;多模態(tài)交互;算力調(diào)度;算力調(diào)優(yōu);大模型訓(xùn)練;GH200;snowflake;AGI;AIGC;H100;A100;DGX Cloud 集群;Base Command;GPU算力;華為 Atlas 900 集群;NVIDIA NVLink;開發(fā)者大會

北京時間11月7日凌晨2點,OpenAI在舊金山舉行的開發(fā)者大會吸引了全球的關(guān)注。在不到一小時的線上發(fā)布會上,OpenAI發(fā)布許多重磅消息,鼓勵企業(yè)使用OpenAI的技術(shù)構(gòu)建基于人工智能的聊天機(jī)器人和自主智能體。

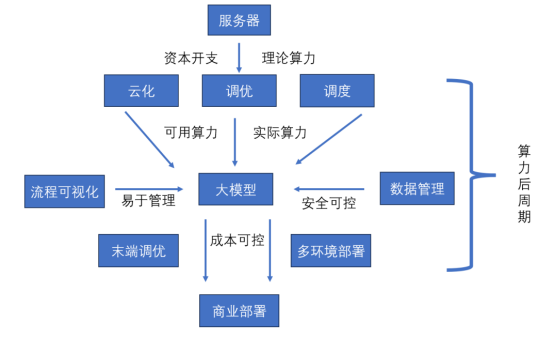

算力對訓(xùn)練模型的重要性日益凸顯。隨著大模型訓(xùn)練的流行,全球顯卡和算力正在快速增長。算力后周期市場也在迅速崛起。其中“后”更多是指后服務(wù)市場,涵蓋從顯卡服務(wù)器到貨IDC之后,形成穩(wěn)定算力到輸出穩(wěn)定商業(yè)推理結(jié)果全過程。該過程主要涉及云化、調(diào)優(yōu)、調(diào)度、部署、落地和數(shù)據(jù)管理等環(huán)節(jié)。

算力的后周期

大模型訓(xùn)練困難、商用成本高昂和安全問題擔(dān)憂,催生算力后周期市場需求。大模型訓(xùn)練面臨超大規(guī)模參數(shù)和運算量問題,需要解決顯卡之間數(shù)據(jù)并行和運算合作,使得后周期需求如云化、調(diào)優(yōu)、調(diào)度等應(yīng)運而生。參數(shù)多則準(zhǔn)確度高,而反應(yīng)時間和消耗費用也愈增,開發(fā)者需要面對如何快速將新模型部署到應(yīng)用場景問題。另外,大模型安全問題也令人擔(dān)憂,需要考慮如何實現(xiàn)在保證數(shù)據(jù)安全的前提下,企業(yè)原有數(shù)據(jù)庫與訓(xùn)練系統(tǒng)的相互調(diào)用,以及如何實現(xiàn)原有數(shù)據(jù)對“AI”訓(xùn)練的可用等。

全球算力后周期發(fā)展呈現(xiàn)出兩個截然不同生態(tài)。在涉及算力使用和大模型訓(xùn)練等上層建筑時,整個行業(yè)對于資本支出、模型經(jīng)驗積累等方面的壁壘正在逐漸加深。大模型時代,天量資本支出已經(jīng)成為入場券,模型研究從“巧奪天工”到“重劍無鋒”的轉(zhuǎn)變,使得大算力、大模型的壁壘不斷提高,行業(yè)格局加速走向巨頭通吃。

Buy More Save More 的典型代表 英偉達(dá)GH200 芯片

在商業(yè)落地、數(shù)據(jù)安全和平臺可視化等模型下游環(huán)節(jié)中,北美創(chuàng)業(yè)公司展現(xiàn)出百花齊放的生態(tài)。在訓(xùn)練過程與資源可視化、數(shù)據(jù)庫調(diào)用、模型加速部署與性價比調(diào)節(jié)等方面,涌現(xiàn)出一批優(yōu)秀創(chuàng)業(yè)公司與解決方案。同時,原有領(lǐng)域龍頭軟件公司也在積極開發(fā)方案,對接AI需求。與大模型和算力戰(zhàn)爭中的巨頭壟斷不同,這個領(lǐng)域各個環(huán)節(jié)充滿生機(jī),更容易在細(xì)分環(huán)節(jié)中成長出新的優(yōu)秀獨角獸公司。

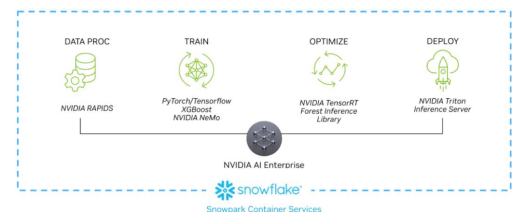

數(shù)據(jù)庫巨頭 Snowflake 與英偉達(dá)合作

隨著國內(nèi)算力資源增長和模型訓(xùn)練深入,對算力和模型層面的投資將重新聚焦。受海外算力制裁的影響,國內(nèi)如昇騰等國產(chǎn)優(yōu)秀生態(tài)發(fā)展和起量過程中,可能也將涌現(xiàn)出一批優(yōu)秀的行業(yè)加速庫、生態(tài)軟件公司,擴(kuò)展出具有中國特色的相關(guān)模型服務(wù)體系,走出一條有中國特色的模型服務(wù)體系之路。

OpenAI開發(fā)者大會亮點

OpenAICEOSam Altman在會上介紹了公司的一系列重要進(jìn)展,包括推出新的GPT-4 Turbo模型,該模型具有更強(qiáng)大的功能、更長的上下文和更強(qiáng)的控制能力。同時,OpenAI還推出Assistance API,旨在簡化開發(fā)者構(gòu)建輔助代理。

Altman強(qiáng)調(diào)自然語言將成為未來與計算機(jī)互動的重要方式,并展示通過對話編程GPT的能力。GPT商店即將推出,允許用戶分享和發(fā)現(xiàn)創(chuàng)新的GPT應(yīng)用,并提供收入分享激勵。此外,OpenAI還與微軟深化合作,展示新的文本到語音模型和改進(jìn)的功能調(diào)用。

一、GPT4 Turbo發(fā)布

GPT-4 Turbo,在6個方面對GPT-4進(jìn)行升級:

上下文對話長度:GPT-4 Turbo支持更長的上下文對話長度,達(dá)到128K,是GPT-4的16倍。

模型控制:采用新模型控制技術(shù),使開發(fā)者更精細(xì)地調(diào)整輸出,提升用戶體驗。

知識庫更新:至2023年4月,比GPT-4的知識庫新近2年。

多模態(tài)API:集成DALL-E 3、帶視覺輸入的GPT-4 Turbo和新的語音合成模型。

定制微調(diào):允許開發(fā)者針對特定領(lǐng)域進(jìn)行自定義微調(diào)。

更低價格和更高限制:價格更低但使用限制更高,輸入輸出token價格僅為GPT-4的1/3和1/2,每分鐘限制提升一倍。

SamAltman聲稱,GPT-4 Turbo可供所有付費開發(fā)者通過gpt-4-1106-preview API進(jìn)行嘗鮮,相關(guān)穩(wěn)定版本預(yù)計將在未來幾周內(nèi)發(fā)布。

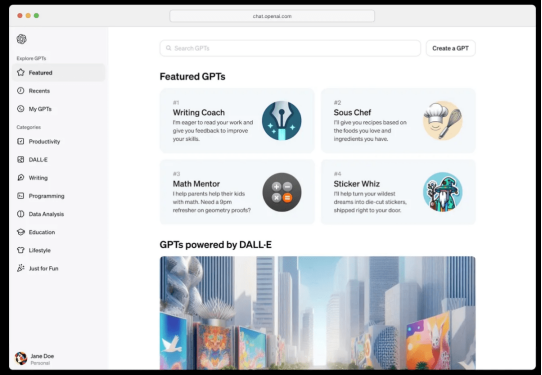

二、GPT Store將上線

定制版GPT可以根據(jù)用戶日常生活、特定任務(wù)或工作需求提供個性化幫助,如學(xué)習(xí)棋類游戲規(guī)則、輔導(dǎo)孩子數(shù)學(xué)、提高寫作能力或設(shè)計貼紙等。用戶甚至可以與他人分享自己定制的GPT。

用戶無需編程就可以創(chuàng)建自己的GPT,過程非常簡單,只需給GPT輸入指令和知識,然后選擇其功能,例如網(wǎng)絡(luò)搜索、圖像生成或數(shù)據(jù)分析。定制GPT可以私人使用,也可以面向公司內(nèi)部或制作公共通用版本。

OpenAI正在為ChatGPT Plus和企業(yè)版ChatGPT用戶提供定制GPT示例,例如AI圖像生成應(yīng)用Canva和自動化平臺Zapier。從本周三開始,企業(yè)版用戶可以為特定客戶、部門或數(shù)據(jù)集創(chuàng)建自己的ChatGPT,并可以授權(quán)內(nèi)部用戶無代碼設(shè)計企業(yè)定制GPT,并安全發(fā)布到內(nèi)部工作區(qū)。管理控制臺可以選擇如何在公司內(nèi)共享這些GPT,以及是否允許使用外部GPT。

三、New GPT Draft

OpenAI表示,即使不會編程也可以制作GPT模型。只需與ChatGPT聊天,描述需求,就可以定制一個GPT模型,使GPT變得非常容易使用,可為每個人提供代理權(quán),做想做的事。

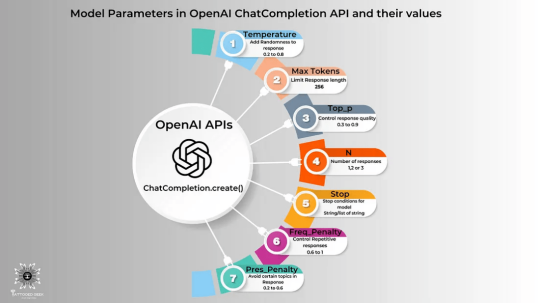

四、全面的API助手

API是一種計算接口,規(guī)定了不同軟件組件之間的交互方式、可進(jìn)行調(diào)用或請求的種類、如何進(jìn)行調(diào)用或請求,以及應(yīng)使用的數(shù)據(jù)格式和應(yīng)遵循的慣例等。

根據(jù)OpenAI公司的官方信息,目前使用GPT-4和GPT-3.5 Turbo上傳750詞的文檔分別需要支付0.06美元和0.003美元(以最高速度計算)。在這次大會上,OpenAI還發(fā)布具有記憶功能的內(nèi)存存儲API,可以提高大模型的計算速度,并將開發(fā)者的API調(diào)用成本降低95%。

此外,OpenAI還發(fā)布專門的Assistants API,使開發(fā)人員可以更輕松地構(gòu)建自己的輔助AI應(yīng)用,調(diào)用模型和工具以實現(xiàn)自己的目標(biāo)。

Assistants API 提供代碼解釋、檢索和函數(shù)調(diào)用等新功能,幫助開發(fā)者處理繁重工作,從而構(gòu)建高質(zhì)量AI應(yīng)用。OpenAI介紹,這種API是為了靈活性設(shè)計,用例范圍廣泛,包括基于自然語言的數(shù)據(jù)分析應(yīng)用、編碼助手、AI驅(qū)動的假期規(guī)劃器、語音控制DJ、智能視覺畫布。Assistants API功能和新GPT產(chǎn)品相同,都支持自定義指令和一些工具,例如代碼解釋器、檢索和函數(shù)調(diào)用。

五、多模態(tài)交互

新版本GPT增加多模態(tài)功能,包括視覺、圖像創(chuàng)建和文本轉(zhuǎn)語音。GPT-4 Turbo可以接受圖像作為輸入,從而實現(xiàn)生成標(biāo)題、分析現(xiàn)實世界圖像和閱讀帶圖形文檔等用例。視覺輸入的定價根據(jù)圖像大小而定。

此外,OpenAI計劃為主要GPT-4Turbo模型提供視覺支持。對于新版本GPT付費用戶,主要功能更新包括更方便地上傳多種格式文件,如PDF、數(shù)據(jù)文件等(未來將支持更多文件類型)。

GPT-4 Turbo的不同模式具有不同優(yōu)勢和功能短板,其中多模態(tài)模式可以同時處理文本、圖像、聲音等多種類型數(shù)據(jù),但僅支持圖片上傳;數(shù)據(jù)分析模式具備較強(qiáng)的數(shù)據(jù)處理和分析能力,但不能實時聯(lián)網(wǎng);實時聯(lián)網(wǎng)模式和DALL-E則不支持文件上傳。在舊版本中,用戶需要自己選擇模式;在新版本中,GPT-4 Turbo將根據(jù)用戶需求自動選擇和編排多個工具完成任務(wù),向AI智能體角色迭代。

云化-調(diào)優(yōu)-調(diào)度

巨頭戰(zhàn)場,技術(shù)為骨,通信為魂

一、算力云化:算力租賃勢起,被 AI 重定義的云計算

1、AGI 時代到來,GPU 算力需求爆發(fā),云計算面臨新挑戰(zhàn)

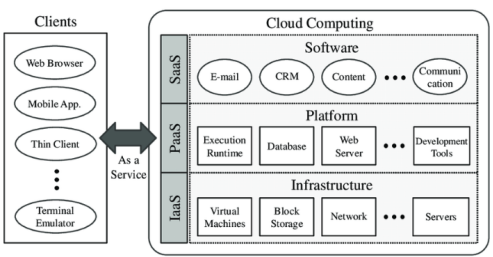

云計算是科技行業(yè)過去十年發(fā)展最迅速領(lǐng)域之一,推動全球數(shù)字化程度持續(xù)提升。隨著互聯(lián)網(wǎng)高速發(fā)展和眾多中小型及初創(chuàng)公司對數(shù)字化需求爆發(fā),自購ICT基礎(chǔ)設(shè)施投入巨大且運維難度高,不適合具有靈活需求高速發(fā)展長尾客戶。而通過云計算,用戶可以隨時獲取云上資源,按需使用按需付費,可無限擴(kuò)展。云計算將計算資源池化,通過軟件實現(xiàn)自動化管理,提高資源利用效率,并發(fā)展出IaaS、PaaS、SaaS等多種形式,極大地促進(jìn)互聯(lián)網(wǎng)發(fā)展和全球數(shù)字化進(jìn)程。

云計算原理圖

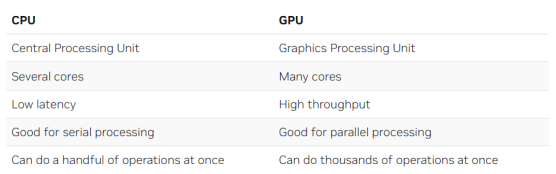

隨著OpenAIChatGPT引領(lǐng)的生成式AI的崛起,算力需求正在從CPU向GPU躍遷。企業(yè)人工智能發(fā)展需求爆發(fā),需要支持開發(fā)人員創(chuàng)建新一代人工智能應(yīng)用程序的基礎(chǔ)設(shè)施。許多企業(yè)轉(zhuǎn)向云計算,采用越來越復(fù)雜的基礎(chǔ)設(shè)施,從GPU到GPU集群,以滿足人工智能模型訓(xùn)練需求。

CPU 和 GPU 的對比

隨著大模型的持續(xù)發(fā)展,如OpenAI的GPT-3擁有1750億個參數(shù),規(guī)模前所未有,模型迭代需要更大規(guī)模。對于大模型訓(xùn)練而言,高速互聯(lián)的高性能GPU集群是關(guān)鍵門檻,不僅涉及GPU本身,還包括GPU之間高速互聯(lián)以及與交換機(jī)、光模塊等基礎(chǔ)設(shè)施的互聯(lián)。與此相比,以CPU和存儲服務(wù)器為主傳統(tǒng)基礎(chǔ)設(shè)施明顯不夠,資本開支和技術(shù)難度也明顯提升,抬高了進(jìn)入大模型的門檻。

英偉達(dá) H100 集群

大模型訓(xùn)練需要大規(guī)模GPU集群進(jìn)行數(shù)月連續(xù)訓(xùn)練,同時產(chǎn)生大量計算和數(shù)據(jù)交換需求。與此相比,傳統(tǒng)CPU和存儲集群的內(nèi)部通信互聯(lián)要求明顯提高。在傳統(tǒng)云計算時代,高速光模塊和高端交換機(jī)只在超大型數(shù)據(jù)中心核心節(jié)點使用,例如400G和對應(yīng)的光模塊。但在超算集群中,使用H100集群,第一層便使用400G光模塊,向上則使用800G光模塊和相應(yīng)交換機(jī),網(wǎng)絡(luò)互聯(lián)要求明顯提高。

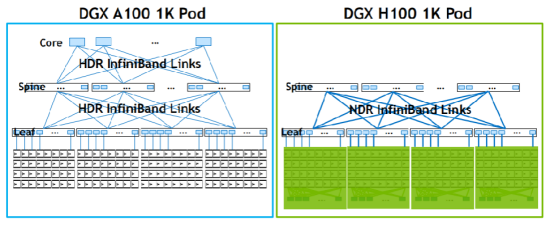

英偉達(dá) DGX A100 與 DGX H100 互聯(lián)結(jié)構(gòu)

隨著基礎(chǔ)設(shè)施日益復(fù)雜,宕機(jī)風(fēng)險增加,維持運行需耗費更多精力和資源。開發(fā)人工智能不僅需要基礎(chǔ)設(shè)施服務(wù),更需要全棧能力。企業(yè)需將所有功能集成到平臺中:

1)用于開發(fā)和部署端到端人工智能工作流的框架和工具,涵蓋數(shù)據(jù)準(zhǔn)備、訓(xùn)練、推理和部署。

2)面向開發(fā)人員的平臺,管理從簡單計算機(jī)視覺應(yīng)用到復(fù)雜大型語言模型的所有內(nèi)容。

3)智能編排層和調(diào)度程序,為每個作業(yè)提供適當(dāng)資源,動態(tài)回收和重新分配資源。

4)自動化基礎(chǔ)設(shè)施管理,優(yōu)化平臺性能和正常運行時間,確保每項工作無憂執(zhí)行。

5)超高帶寬、低延遲網(wǎng)絡(luò)集群,專為多節(jié)點訓(xùn)練設(shè)計,可在多個加速計算節(jié)點上并行處理大型人工智能模型。

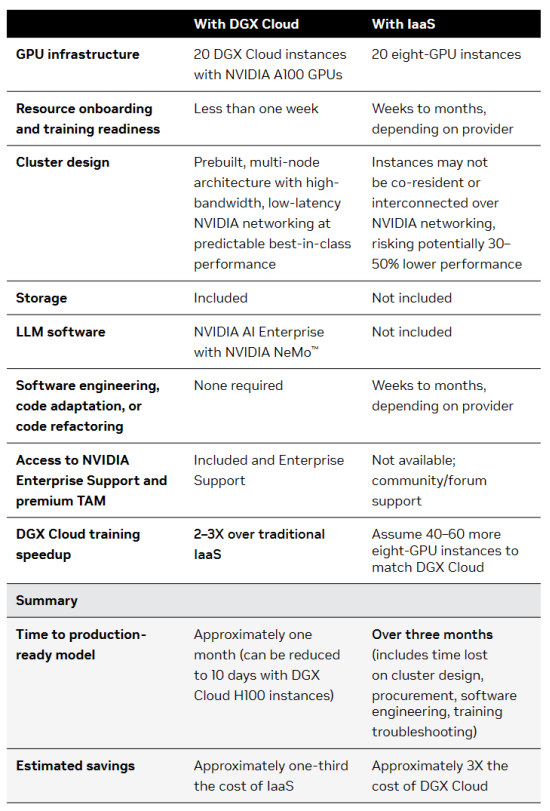

2、DGX Cloud 發(fā)布,云算力進(jìn)入 GPU 新時代

英偉達(dá)于2023年3月21日發(fā)布的DGX Cloud改變傳統(tǒng)計算框架,為現(xiàn)代深度學(xué)習(xí)提供理想環(huán)境。DGX Cloud結(jié)合人工智能和云計算,旨在為企業(yè)提供最先進(jìn)的AI訓(xùn)練服務(wù)。該平臺采用NVIDIA DGX SuperPOD架構(gòu),具備分布式訓(xùn)練能力,其速度較不支持NVIDIA網(wǎng)絡(luò)的服務(wù)快兩倍以上。

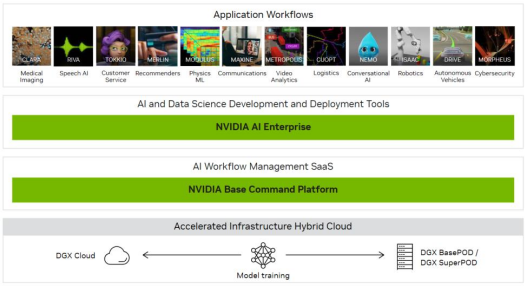

英偉達(dá)的DGX Cloud為現(xiàn)代AI開發(fā)樹立新的標(biāo)桿,是世界上第一個專用于開發(fā)生成式人工智能的平臺。DGX Cloud是英偉達(dá)針對傳統(tǒng)IaaS產(chǎn)品在AI時代面臨的困境而推出的產(chǎn)品,其使用效率是傳統(tǒng)基礎(chǔ)設(shè)施的三倍。DGX Cloud集成NVIDIA基礎(chǔ)命令平臺,簡化人工智能開發(fā)的過程。

NVIDIA DGX 云人工智能軟件堆棧

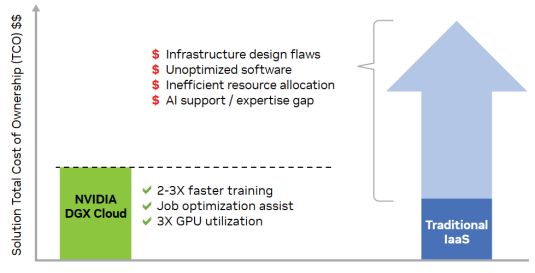

DGX Cloud在傳統(tǒng)IaaS上展現(xiàn)出全面領(lǐng)先優(yōu)勢。其基于NVIDIA DGX技術(shù),為各行業(yè)創(chuàng)新提供加速解決方案。通過DGX Cloud,企業(yè)可專注于人工智能創(chuàng)新,無需糾纏于基礎(chǔ)設(shè)施。企業(yè)能夠獲得可靠、快速的資源分配,完全優(yōu)化執(zhí)行工作負(fù)載,并減少所需時間和精力,從而降低總體擁有成本。根據(jù)英偉達(dá)官網(wǎng)的比較,DGX Cloud相比傳統(tǒng)IaaS服務(wù)具有2-3倍的訓(xùn)練速度優(yōu)勢和三倍的GPU利用率提升。

NVIDIA DGX 與傳統(tǒng) IaaS 比較優(yōu)勢明顯

NVIDIA DGX 與傳統(tǒng) IaaS 比較優(yōu)勢明顯

3、現(xiàn)狀:GPU 禁令,國產(chǎn)算力進(jìn)程加速,合理分配利用資源重要性突顯

根據(jù)英偉達(dá)2023 年 10 月 23 日向 SEC 提交的 8-K文件,美國政府已通知英偉達(dá),對總處理性能為4800或更高的數(shù)據(jù)中心設(shè)計或銷售產(chǎn)品實施新的出口管制,并適用于題為“實施附加出口管制:某些先進(jìn)計算項目;超級計算機(jī)和半導(dǎo)體最終用途;更新和更正”的法規(guī)。受影響的產(chǎn)品包括 A100、A800、H100、H800 和 L40S,這些產(chǎn)品于 10 月 17 日被要求在 30 天后禁售。

隨著高端算力芯片禁令生效,國內(nèi)AI產(chǎn)業(yè)發(fā)展受到制約。華為、寒武紀(jì)、海光、壁仞、摩爾線程等國產(chǎn)算力芯片的商業(yè)化和生態(tài)建設(shè)有望加速。科大訊飛與華為昇騰已啟動專項攻關(guān),合力打造通用人工智能新底座,華為昇騰910B能力已基本可對標(biāo)英偉達(dá)A100。

5、跨區(qū)域、跨集群、跨架構(gòu)的算力調(diào)度調(diào)優(yōu)能力日益重要

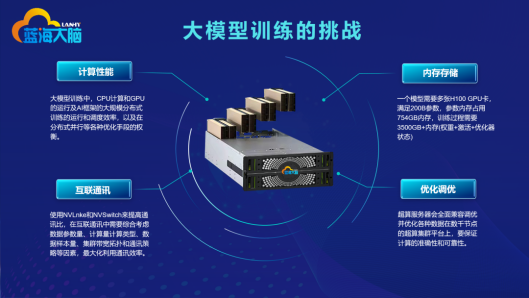

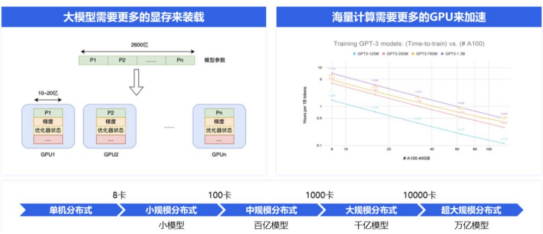

在大規(guī)模訓(xùn)練中,相比傳統(tǒng)云計算,需要考慮的問題更為復(fù)雜。如何利用多卡突破內(nèi)存限制?如何實現(xiàn)大量計算資源的通信和協(xié)作?如何將各種大規(guī)模訓(xùn)練技術(shù)整合成一個完整高效的方案?因此,大規(guī)模訓(xùn)練技術(shù)的挑戰(zhàn)可歸納為內(nèi)存、通訊、計算和調(diào)優(yōu)四個方面。

大模型訓(xùn)練四大挑戰(zhàn)

在大模型訓(xùn)練中,數(shù)據(jù)和算力是最核心的兩個要素。過去AI的發(fā)展方向是使用少量數(shù)據(jù)和參數(shù)來構(gòu)建模型,而現(xiàn)在隨著OpenAI現(xiàn)象級產(chǎn)品出現(xiàn),人們發(fā)現(xiàn)使用海量數(shù)據(jù)和算力訓(xùn)練模型能力有了質(zhì)的飛躍。目前大模型還處于早期階段,未來大模型的發(fā)展將主要集中在提高參數(shù)數(shù)量和提升算力集群規(guī)模上。

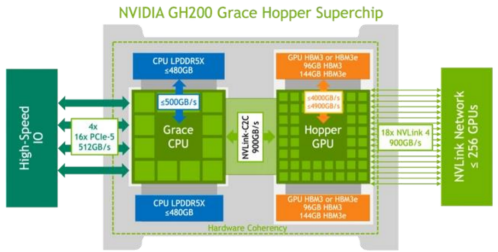

英偉達(dá)作為全球GPU領(lǐng)軍企業(yè),很早就開始布局AI領(lǐng)域。回顧英偉達(dá)超算方案,從DGX A100到DGX H100,再到最新的DGX GH200,除GPU算力提升外,通信能力的大幅持續(xù)增長也非常明顯。在AI領(lǐng)域中,通信作用的重要性不亞于計算能力。英偉達(dá)早在2019年就收購網(wǎng)絡(luò)交換公司Mellanox,以增強(qiáng)其在數(shù)據(jù)中心網(wǎng)絡(luò)交換領(lǐng)域的實力,這充分體現(xiàn)了英偉達(dá)的超前眼光和對通信的重視。

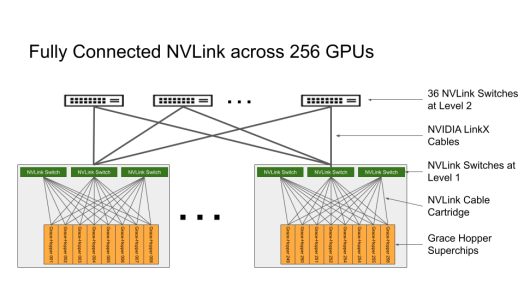

以GH200為例,其NVLink提供高達(dá)900GB/s雙向帶寬,單向帶寬為450GB/s。當(dāng)8張卡一起使用時,總帶寬高達(dá)28.8TBps。這些帶寬分?jǐn)偟饺齻€NVLink Switch上,每個Switch的上下行帶寬為9.6TBps。這意味著,對于800G的光模塊來說,每個Switch需要24只。一臺服務(wù)器中共有72只800G光模塊,GPU與800G光模塊的比例為1:9。相比之下,DGX H100架構(gòu)的GPU與800G光模塊比例約為1:3,而DGX A100主要使用400G光模塊。從英偉達(dá)產(chǎn)品的迭代可以看出,公司在通信方面持續(xù)發(fā)力,以匹配計算能力的提升。

英偉達(dá) DGX GH200,256 個 GPU 組成的完全連接的 NVIDIA NVLink 交換機(jī)系統(tǒng)拓?fù)浣Y(jié)構(gòu)

要高效發(fā)揮算力集群能力,打破通信墻是唯一的選擇。隨著集群中顯卡數(shù)量的增長,如果算力不能線性提升,就無法充分利用高價購買的GPU能力。目前,最佳的方式是通過高速互聯(lián)打破通信墻,允許萬卡規(guī)模集群中的跨GPU數(shù)據(jù)交換,保證數(shù)據(jù)交換暢通無阻。提高通信能力是目前最有效的“調(diào)優(yōu)”方式,無論多么出色的調(diào)度和調(diào)優(yōu),都無法比擬使用高性能交換機(jī)和高速光模塊構(gòu)建的集群內(nèi)部“高速公路”。

此外,跨架構(gòu)、跨集群的算力調(diào)度也是一個現(xiàn)實問題。跨區(qū)域算力調(diào)度需求也在增長,例如東數(shù)西算等。在模型訓(xùn)練層面,調(diào)優(yōu)也是一個重要方面。

二、算力調(diào)優(yōu):大模型時代,通信即調(diào)優(yōu)

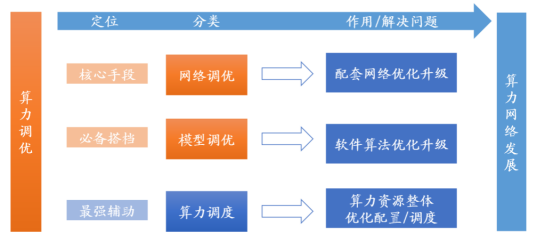

1、算力調(diào)優(yōu)是算力發(fā)展的終身課題

算力調(diào)優(yōu)本質(zhì)上是將有限的算力資源進(jìn)行重新配置并達(dá)到最優(yōu)狀態(tài)。在微觀層面,算力調(diào)優(yōu)關(guān)注模型調(diào)優(yōu),包括減少模型訓(xùn)練和推理時占用的顯存。在宏觀層面,算力調(diào)優(yōu)涉及模型調(diào)優(yōu)、網(wǎng)絡(luò)調(diào)優(yōu)和算力調(diào)度三個層次。其中,網(wǎng)絡(luò)調(diào)優(yōu)在大規(guī)模分布式并行訓(xùn)練背景下愈發(fā)重要,高性能網(wǎng)絡(luò)應(yīng)具備超大規(guī)模、超高帶寬和超長穩(wěn)定三大性能。算力調(diào)度則是將算力作為資源進(jìn)行優(yōu)化分配,解決算力資源供需不匹配問題。

三大算力調(diào)優(yōu)措施針對解決不同的算力問題

算力發(fā)展帶來三個重大變化,這促使算力調(diào)優(yōu)成為核心議題。這三個變化分別是:算力需求總量的增加、算力需求的擴(kuò)散和算力需求的多樣化。

1)隨著5G和AI等產(chǎn)業(yè)的快速發(fā)展,通用算力和智能算力需求都在不斷增加。

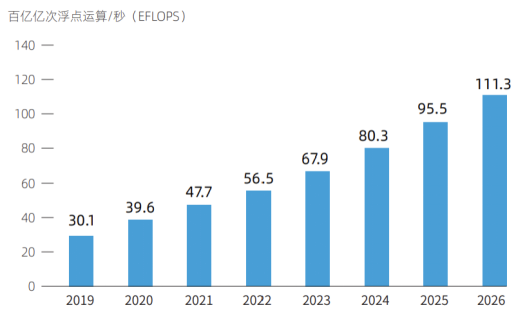

通用算力需求因各種應(yīng)用逐漸興起而提升,同時大數(shù)據(jù)、智能汽車、智慧城市、物聯(lián)網(wǎng)等新業(yè)態(tài)新平臺出現(xiàn)也加大了通用算力的需求量。而智能算力需求隨著AIGC產(chǎn)業(yè)的迅速發(fā)展,國內(nèi)大模型訓(xùn)練和推理的快速推進(jìn),智算成為大模型落地不可或缺的生產(chǎn)力之一,需求空間巨大。據(jù)IDC和浪潮預(yù)測,到2026年,國內(nèi)通用算力規(guī)模將達(dá)到111.3EFLOPS,智能算力規(guī)模將達(dá)到1271.4EFLOPS。

2019-2026 中國通用算力規(guī)模及預(yù)測

2)算力需求最初主要集中在單一設(shè)備上,如計算機(jī)和工業(yè)智能設(shè)備等。但隨著5G和AI時代的到來,海量數(shù)據(jù)已經(jīng)擴(kuò)散到各類設(shè)備上,如汽車、公路、城市智慧屏等各類終端都需要數(shù)據(jù)處理能力。

3)隨著數(shù)字經(jīng)濟(jì)的崛起,算力需求逐漸走向多元化。自動駕駛的算力需求主要集中在高性能、低延遲和實時性上;而生成式AI的算力需求則需要大量GPU并行計算,主要集中在穩(wěn)定長時間輸出能力上;邊緣計算的算力需求主要在于短距離和低時延。

2、網(wǎng)絡(luò)調(diào)優(yōu):算力調(diào)優(yōu)的核心手段

1)源起:從 GPU 的通信出發(fā)

在AI時代GPU成為核心處理器,廣泛應(yīng)用于圖像圖形處理和AI推理。然而,隨著大模型復(fù)雜度不斷提升,單卡GPU顯存有限,難以滿足訓(xùn)練需求。例如,百度文心一言大模型擁有2600億個參數(shù),而一個80GB顯存的A800只能存儲10-20億參數(shù),因此需要100-200塊GPU來存放2600億的模型。此外未來大模型訓(xùn)練將需要更多的參數(shù)和計算,進(jìn)一步增加GPU需求。為適應(yīng)算力需求,多張GPU甚至多臺服務(wù)器需要聯(lián)合工作,分布式訓(xùn)練成為核心訓(xùn)練方式。

大模型發(fā)展下對分布式訓(xùn)練訴求提升

網(wǎng)絡(luò)連接在分布式系統(tǒng)中發(fā)揮重要作用,根據(jù)連接層級可分為單卡、多卡和多機(jī)互聯(lián)。單卡內(nèi)的網(wǎng)絡(luò)為計算用的神經(jīng)網(wǎng),多卡之間的連接通常采用PCIe或高帶寬通信網(wǎng)絡(luò),而多機(jī)之間的連接則通常采用RDMA網(wǎng)絡(luò)。

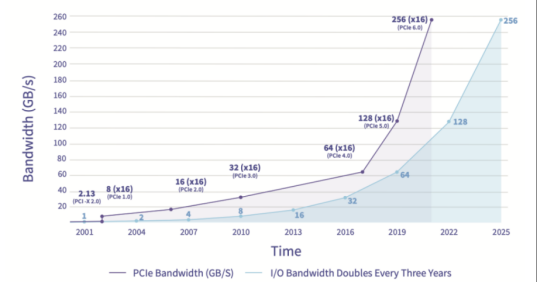

多卡互聯(lián):傳統(tǒng) PCIe 與 NVLINK/CAPI/GenZ/CCIX/CXL 的“百家爭鳴”

總線是數(shù)據(jù)通信中必不可少的通道,PCIe是最廣泛使用的總線協(xié)議。總線是服務(wù)器主板上不同硬件之間進(jìn)行數(shù)據(jù)通信管道,對數(shù)據(jù)傳輸速度起到?jīng)Q定性作用。PCIe協(xié)議由英特爾于2001年提出,主要用于連接CPU與其他高速設(shè)備如GPU、SSD、網(wǎng)卡、顯卡等。PCIe經(jīng)歷多個版本的更新,傳輸速率和帶寬不斷提高,目前已經(jīng)更新到6.0版本,傳輸速率高達(dá)64GT/s,16通道的帶寬達(dá)到256GB/s。

PCIe6.0 版本的帶寬大幅提高

隨著AIGC的發(fā)展,算力需求大幅增加,GPU多卡組合成為趨勢。然而,PCIe的數(shù)據(jù)傳輸速率和網(wǎng)絡(luò)延遲無法滿足這種需求。為提高總線通信效率和降低延遲,各家紛紛推出替代協(xié)議。

CAPI協(xié)議最早由IBM推出,本質(zhì)上是在現(xiàn)有高速I/O標(biāo)準(zhǔn)之上的應(yīng)用程序擴(kuò)展,增加緩存一致性和更低延遲等內(nèi)容。但由于IBM服務(wù)器份額的持續(xù)下降,CAPI協(xié)議缺少用戶基礎(chǔ),最終未能廣泛流傳。

GenZ協(xié)議是一個不依賴于任何芯片平臺的開放性組織,眾多廠家參與其中,包括AMD、ARM、IBM、Nvidia、Xilinx等。GenZ將總線協(xié)議拓展成交換式網(wǎng)絡(luò)并加入GenZSwitch,提高拓展性。

CXL協(xié)議于2019年由Intel推出,與CAPI協(xié)議思路類似。2021年底吸收了GenZ協(xié)議共同發(fā)展,2022年兼并了OpenCAPI協(xié)議。CXL具備內(nèi)存接口,逐漸成長為設(shè)備互連標(biāo)準(zhǔn)的重要主導(dǎo)協(xié)議之一。

CCIX協(xié)議是ARM加入的另一個開放協(xié)議,功能類似GenZ但未被吸收兼并。

NVLINK協(xié)議是英偉達(dá)提出的高速GPU互聯(lián)協(xié)議,相比傳統(tǒng)PCIe總線協(xié)議,NVLINK在三個方面做出重大改變。首先支持網(wǎng)狀拓?fù)浣Y(jié)構(gòu),解決通道數(shù)量有限問題;其次統(tǒng)一內(nèi)存,允許GPU共享公共內(nèi)存池,減少GPU之間復(fù)制數(shù)據(jù)需要,提高效率;最后支持直接內(nèi)存訪問,不需要CPU參與,GPU可以直接讀取彼此內(nèi)存,從而降低網(wǎng)絡(luò)延遲。此外,為解決GPU之間通訊不均衡問題,英偉達(dá)還引入NVSwitch,一種類似于交換機(jī)ASIC的物理芯片,通過NVLink接口將多個GPU高速互聯(lián),創(chuàng)建高帶寬多節(jié)點GPU集群。2023年5月29日,英偉達(dá)推出AI超級計算機(jī)DGX GH200,通過NVLink和NVSwitch連接256個GH200芯片,所有GPU連接成一個整體協(xié)同運行,可訪問內(nèi)存突破100TB。

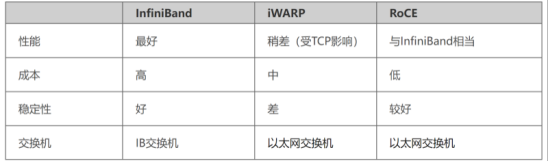

多機(jī)互聯(lián):IB 網(wǎng)絡(luò)與以太網(wǎng)絡(luò)并存

在分布式訓(xùn)練中,RDMA網(wǎng)絡(luò)成為最佳選擇,包括IB網(wǎng)絡(luò)和以太網(wǎng)絡(luò)。傳統(tǒng)的TCP/IP網(wǎng)絡(luò)通信通過內(nèi)核發(fā)送消息,涉及較多數(shù)據(jù)移動和復(fù)制,不適合高性能計算、大數(shù)據(jù)分析等需要高并發(fā)、低時延場景。RDMA是一種計算機(jī)網(wǎng)絡(luò)技術(shù),可直接遠(yuǎn)程訪問內(nèi)存數(shù)據(jù),無需內(nèi)核介入,不占用CPU資源,可顯著提高數(shù)據(jù)傳輸性能并降低延遲,適合大規(guī)模并行計算機(jī)集群網(wǎng)絡(luò)需求。

目前有三種RDMA:Infiniband、RoCE和iWARP,后兩者基于以太網(wǎng)技術(shù)。Infiniband是專為RDMA設(shè)計的網(wǎng)絡(luò),從硬件級別保證可靠傳輸,成本高但帶寬和延遲更優(yōu);RoCE基于以太網(wǎng)做RDMA,可使用普通以太網(wǎng)交換機(jī),成本較低但需要支持RoCE的網(wǎng)卡;iWARP基于TCP的RDMA網(wǎng)絡(luò),利用TCP達(dá)到可靠傳輸,在大型組網(wǎng)中會占用大量內(nèi)存資源,對系統(tǒng)規(guī)格要求更高,但也可使用普通以太網(wǎng)交換機(jī)并需要支持iWARP的網(wǎng)卡。

RoCE 、iWARP和 InfiniBand 比較

3)現(xiàn)狀:AI 的網(wǎng)絡(luò)新需求

AI大模型訓(xùn)練和推理對網(wǎng)絡(luò)提出超大規(guī)模、超高帶寬和超長穩(wěn)定的需求。超大規(guī)模的模型直接影響訓(xùn)練速度,使用更多的GPU可以縮短訓(xùn)練時間。超高帶寬的Allreduce直接影響大規(guī)模分布式下的整體效率,高帶寬可以獲得更高的加速比。

大模型訓(xùn)練時長通常至少為幾個星期,穩(wěn)定性非常重要,包括GPU可用性和網(wǎng)絡(luò)可用性。在千卡規(guī)模下,如果GPU的月可用性為99.9%,模型訓(xùn)練一月內(nèi)遇到故障發(fā)生中斷的概率較高。網(wǎng)絡(luò)可用性對于大模型的訓(xùn)練至關(guān)重要,包括數(shù)據(jù)集的讀取以及訓(xùn)練過程中checkpoint的讀寫,必須保證更高的可用性以減少模型訓(xùn)練中斷。因此,在大規(guī)模分布式AI訓(xùn)練中,需要使用更多的GPU和更高的帶寬,并確保網(wǎng)絡(luò)的可用性和穩(wěn)定性。

OpenAI 在訓(xùn)練過程中使用 checkpoint 來保證連續(xù)性。Checkpoint 是訓(xùn)練過程中保存的已訓(xùn)練模型在特定時間點的版本,包含模型的權(quán)重、參數(shù)和其他重要信息。加入 checkpoint 后,即使訓(xùn)練中斷,也可以隨時回到并使用已保存 checkpoint 處的模型,而無需從頭開始訓(xùn)練。此外,checkpoint 還可以提高實驗的可重現(xiàn)性、進(jìn)行模型評估以及實現(xiàn)遷移學(xué)習(xí)等功能。

4)未來:網(wǎng)絡(luò)為主,可視化為輔

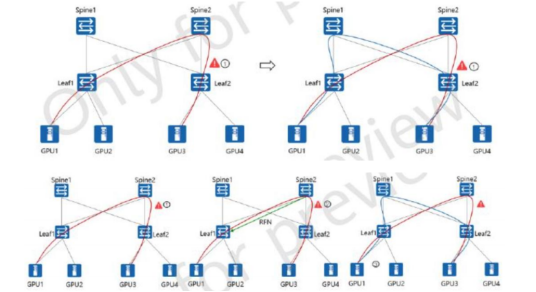

面對AI大模型對算力網(wǎng)絡(luò)通信提出的新需求,提升網(wǎng)絡(luò)通信能力是核心,同時需要輔助智算可視化等硬件。三大需求(超大規(guī)模、超高帶寬和超長穩(wěn)定)都強(qiáng)調(diào)網(wǎng)絡(luò)通信能力的提升。優(yōu)化過程中,網(wǎng)絡(luò)可視化等核心硬件也起到重要作用。

在算力集群中,無論使用以太網(wǎng)還是InfiniBand協(xié)議構(gòu)建通信網(wǎng)絡(luò),數(shù)據(jù)都以包的形式傳輸。為監(jiān)控網(wǎng)絡(luò)流量,避免擁堵或硬件故障影響系統(tǒng)效率,需要實時監(jiān)測每條通信鏈路的狀態(tài)。如在三層網(wǎng)絡(luò)架構(gòu)中,有一種名為DPFR(Data Plane Fast Recovery)的經(jīng)典優(yōu)化方法,可以實現(xiàn)毫秒級收斂。DPFR分為本地快速收斂和遠(yuǎn)端快速收斂。本地收斂是指葉交換機(jī)掌握指揮權(quán),可以自行選擇要訪問的脊交換機(jī);遠(yuǎn)端收斂是指脊交換機(jī)掌握指揮權(quán),如果該交換機(jī)南向通道故障,脊交換機(jī)可以向正常運行的葉交換機(jī)發(fā)送故障報文,指揮葉交換機(jī)切換線路。

DPFR 本地快速收斂(上)和遠(yuǎn)端快速收斂(下)

網(wǎng)絡(luò)調(diào)優(yōu)的核心是利用軟件或硬件技術(shù)抓取數(shù)據(jù)包進(jìn)行分析。數(shù)據(jù)包嗅探抓取分為軟件實現(xiàn)和硬件實現(xiàn)兩種方式。常用的軟件實現(xiàn)包括Wireshark(處理TCP/UDP)、Fiddler(處理HTTP/HTTPS)、tcpdump&windump、solarwinds、nast、Kismet等。

軟件抓包會消耗部分系統(tǒng)性能。首先,混雜模式下的網(wǎng)卡處于“廣播模式”,需要處理網(wǎng)絡(luò)下層收發(fā)的所有數(shù)據(jù)包,這本身就會消耗一部分網(wǎng)卡性能。其次,軟件抓包需要復(fù)制和存儲數(shù)據(jù)包,會占用一部分CPU和存儲資源。同時,像Wireshark這種軟件大多只能監(jiān)控系統(tǒng)內(nèi)單一網(wǎng)絡(luò)節(jié)點的流量,難以覆蓋全局網(wǎng)絡(luò),更適合被動故障排除作業(yè),而不適用于主動風(fēng)險監(jiān)測。

為確保不影響系統(tǒng)整體性能,并行或串行接入的軟硬件結(jié)合工具應(yīng)運而生,其中常用的包括DPI和DFI。DPI(深度報文檢測)是一種基于報文應(yīng)用層信息進(jìn)行流量檢測和控制的功能,著重分析應(yīng)用層,能夠識別各種應(yīng)用及其內(nèi)容。當(dāng)IP數(shù)據(jù)包、TCP或UDP數(shù)據(jù)流經(jīng)過支持DPI技術(shù)硬件設(shè)備時,設(shè)備會深入讀取報文載荷進(jìn)行分析和重組,識別應(yīng)用程序內(nèi)容,然后根據(jù)設(shè)備定義的管理策略對流量進(jìn)行后續(xù)處理。DFI(深度/動態(tài)流檢測)采用基于流量行為應(yīng)用識別技術(shù),即不同應(yīng)用類型在會話連接或數(shù)據(jù)流上的狀態(tài)各不相同。DPI技術(shù)適用于需要精細(xì)和準(zhǔn)確識別、精細(xì)管理的環(huán)境;而DFI技術(shù)適用于需要高效識別、粗放管理的環(huán)境。

DPI 和 DFI 的流程比較

DPI/DFI由獨立硬件串/并接在物理層,對物理層性能無影響。以浩瀚深度的DPI軟硬件產(chǎn)品為例,可部署在電信網(wǎng)絡(luò)各層級節(jié)點,通過SaaS/PaaS實現(xiàn)數(shù)據(jù)收集、分析和呈現(xiàn)。DPI硬件串接或并接在通信物理層,通過鏡像數(shù)據(jù)包實現(xiàn)無損網(wǎng)絡(luò)監(jiān)測。DPI軟件可嵌入DPI硬件、獨立服務(wù)器或交換機(jī)/路由器中,實現(xiàn)網(wǎng)絡(luò)監(jiān)測。

網(wǎng)絡(luò)可視化是一種高效流量監(jiān)控工具。通過SaaS/PaaS,可以實現(xiàn)對各層級DPI監(jiān)測節(jié)點的數(shù)據(jù)收集、分析和呈現(xiàn),將這些網(wǎng)絡(luò)數(shù)據(jù)以客戶和應(yīng)用所需的方式展示出來,幫助用戶準(zhǔn)確掌握網(wǎng)絡(luò)運行情況以及其中的有價值信息。結(jié)合大數(shù)據(jù)分析與挖掘、多維度數(shù)據(jù)關(guān)聯(lián)分析、流量控制和管理等手段,實現(xiàn)網(wǎng)絡(luò)管理、信息安全和商業(yè)智能的一類應(yīng)用系統(tǒng),通常稱為網(wǎng)絡(luò)視化。

5)模型調(diào)優(yōu)

模型層面調(diào)優(yōu)和軟件層面調(diào)優(yōu)不同于傳統(tǒng)性能優(yōu)化,如游戲或軟件的優(yōu)化。在當(dāng)前模型快速迭代、參數(shù)競爭激烈的情況下,削減參數(shù)、減少GPU集群訓(xùn)練時間或算力總量并不是主要關(guān)注問題。頭部玩家更關(guān)心如何讓重金投入的GPU集群充分發(fā)揮其算力,以實現(xiàn)更快模型迭代和參數(shù)擴(kuò)展。因此,模型層面的調(diào)優(yōu)可以理解為如何通過設(shè)計模型架構(gòu)來最大化GPU性能,而非壓縮非必要環(huán)節(jié)以節(jié)省算力。

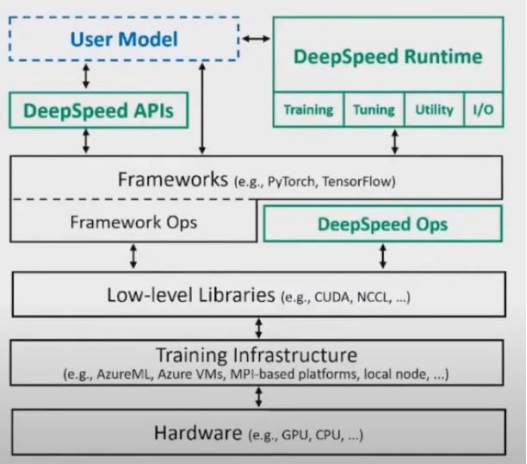

AI模型訓(xùn)練主要基于Tensor Flow和PyTorch兩個框架。這些框架提供AI訓(xùn)練所需的操作系統(tǒng)、工具和運算流程,同時也提供優(yōu)化GPU使用的完善框架。模型訓(xùn)練過程類似于生產(chǎn)線,每層訓(xùn)練步驟對應(yīng)生產(chǎn)線上一個工序。優(yōu)化GPU使用的方法主要是并行處理,即對流水線任務(wù)進(jìn)行分配或優(yōu)化。

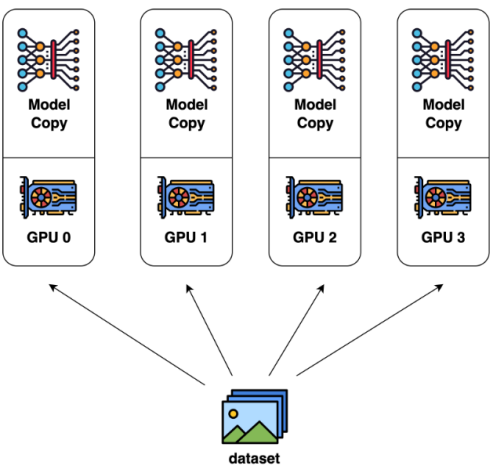

模型層面的并行主要有兩種:數(shù)據(jù)并行和模型并行。數(shù)據(jù)并行是指將一層模型運算所需的數(shù)據(jù)分配到多張顯卡上進(jìn)行計算,然后匯總結(jié)果進(jìn)行下一層運算。而模型并行是將一次訓(xùn)練所需的多個運算步驟分別放在多張顯卡上進(jìn)行計算,但隨著模型體積不斷增大,單個顯卡難以承載完整的計算任務(wù),因此模型并行正在逐漸被數(shù)據(jù)并行所取代。數(shù)據(jù)并行的瓶頸在于數(shù)據(jù)的實時切分和通信,進(jìn)一步突顯了通信能力的重要性。

數(shù)據(jù)并行

除框架或訓(xùn)練原理自帶并行能力外,專用訓(xùn)練調(diào)優(yōu)工具也進(jìn)一步方便用戶使用。目前,全球模型訓(xùn)練者主要使用微軟提供的開源工具庫DeepSpeed來進(jìn)行訓(xùn)練調(diào)優(yōu)。DeepSpeed通過預(yù)處理訓(xùn)練數(shù)據(jù)等方式,優(yōu)化了數(shù)據(jù)進(jìn)入GPU的效率和所需空間,從而為發(fā)揮GPU集群性能或提高小GPU訓(xùn)練上限提供解決方案。

DeepSpeed

利用框架和DeepSpeed兩大工具進(jìn)行模型調(diào)優(yōu)后,積累的經(jīng)驗將加深各大模型廠商的訓(xùn)練能力壁壘,提高訓(xùn)練效率和性能。隨著大模型時代的到來,模型算法層面的優(yōu)化和算力、金錢性價比的追求日漸式微,而重參數(shù)、數(shù)據(jù)、算力堆疊被認(rèn)為是通向AGI的必經(jīng)之路。因此,模型層面的進(jìn)化更多地發(fā)生在如何更好地調(diào)用GPU算力的訓(xùn)練系統(tǒng)和工具庫層面。

三、算力調(diào)度:全局最強(qiáng)輔助

1、算力調(diào)度是什么?

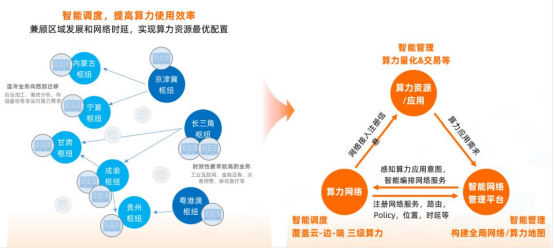

算力調(diào)度是將算力作為資源進(jìn)行分配和優(yōu)化的過程,實現(xiàn)算力靈活流動,解決算力供需矛盾、網(wǎng)絡(luò)傳輸問題和資源普惠問題。根據(jù)供給能力和動態(tài)需求,進(jìn)行算力資源整合和分配,涉及基礎(chǔ)設(shè)施底層計算、存儲、網(wǎng)絡(luò)等多維資源統(tǒng)一管理和調(diào)度。

智能調(diào)度和智能管理算力量化&交易圖

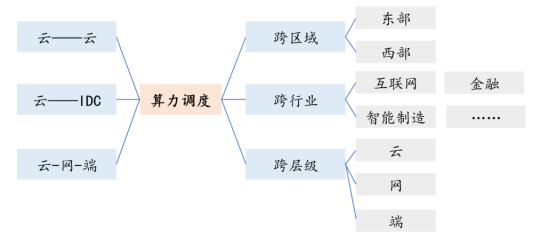

2、算力在哪里調(diào)度?

算力調(diào)度適用于多種場景,包括云與云之間、云和數(shù)據(jù)中心之間、云網(wǎng)端之間,以及按行業(yè)、地區(qū)、層級劃分。其中,跨區(qū)域調(diào)度和跨層級調(diào)度是較為典型的兩個場景。跨區(qū)域調(diào)度是指實現(xiàn)東西部算力協(xié)同,打通需求估計不足的算力資源,以實現(xiàn)算力資源跨區(qū)域調(diào)度。而跨層級調(diào)度則是指將算力資源協(xié)調(diào)應(yīng)用于云、邊緣、終端等不同層級,實現(xiàn)算力靈活調(diào)度和優(yōu)化分配。

算力調(diào)度場景分布

3、如何實施?

算力調(diào)度目前尚處于逐步落地階段,具體實施步驟有待在執(zhí)行中逐漸完善。根據(jù)算力分布分散、需求具備多樣性和靈活性等特質(zhì),通常算力調(diào)度需要包含三個核心步驟:

1)整合多元異構(gòu)資源

對底層算力資源進(jìn)行標(biāo)準(zhǔn)化,建立度量模型和評估標(biāo)準(zhǔn),摸清算力調(diào)度區(qū)域的設(shè)施和資源情況,整合不同所有方的閑置資源;

2)搭建算力調(diào)度平臺

整合實時感知、供需匹配、智能調(diào)度、服務(wù)運營和監(jiān)測管理等多種功能,根據(jù)資源分布情況動態(tài)計算最佳調(diào)度策略,實現(xiàn)統(tǒng)一的算力交易和售賣;

3)建立標(biāo)準(zhǔn)規(guī)范體系

包括算力交易、管理和安全規(guī)則,涉及產(chǎn)品定價、自動結(jié)算、賬本記錄、權(quán)利義務(wù)和可信服務(wù)機(jī)制。

4、誰在參與?

算力調(diào)度平臺作為算網(wǎng)大腦,在算力發(fā)展中后期的重要性將進(jìn)一步提升。目前,國內(nèi)已經(jīng)涌現(xiàn)多個算力調(diào)度平臺,按主導(dǎo)方可分為四大類,其中運營商算力調(diào)度平臺的基礎(chǔ)能力較為顯著。這些平臺包括電信運營商主導(dǎo)平臺、地方政府主導(dǎo)平臺、企業(yè)主導(dǎo)平臺和行業(yè)機(jī)構(gòu)主導(dǎo)型平臺。不同平臺的優(yōu)勢和特點各不相同,但都致力于整合和優(yōu)化算力資源的分配。

其中,中國電信、中國移動、中國聯(lián)通等運營商在算力調(diào)度方面具有強(qiáng)大的網(wǎng)絡(luò)基礎(chǔ)設(shè)施和資源整合能力,能夠?qū)崿F(xiàn)算力資源的高速互聯(lián)和數(shù)據(jù)傳輸?shù)姆€(wěn)定運行。此外,一些互聯(lián)網(wǎng)和科技巨頭企業(yè)也在算力調(diào)度方面進(jìn)行了積極探索和實踐,如阿里云、中科曙光等。同時,行業(yè)機(jī)構(gòu)也在推動算力調(diào)度平臺的發(fā)展,如中國信通院聯(lián)合中國電信發(fā)布的一體化算力算網(wǎng)調(diào)度平臺等。

軟件服務(wù)

海外先行,百花齊放,部署先行

軟件服務(wù)的三個方向:數(shù)據(jù)管理、模型落地、訓(xùn)練可視化

一、數(shù)據(jù)管理

模型微調(diào)的基礎(chǔ)是優(yōu)質(zhì)、結(jié)構(gòu)化的數(shù)據(jù)管理,推動大模型訓(xùn)練向高精度、高安全和垂直專業(yè)化發(fā)展。現(xiàn)有的開源 LLM 是“預(yù)訓(xùn)練模型”,即已收集大量訓(xùn)練數(shù)據(jù)并提前訓(xùn)練模型,如 NVIDIA NeMo 和 MetaLlama 能流利使用各種語言,對各種話題有一定了解,但受訓(xùn)練數(shù)據(jù)限制,對某些專業(yè)領(lǐng)域不夠深入。以 Snowflake 為例,該平臺支持客戶使用自己的數(shù)據(jù)集進(jìn)行模型的進(jìn)一步訓(xùn)練和微調(diào),以保證定制的模型在特定領(lǐng)域做到專精。Snowflake 子公司 Applica 憑借 TILT(Text-Image-Layout-Transformer)模型,專精于智能文檔。

二、模型落地

Modular Mojo 是一種下一代設(shè)計模型和加速庫設(shè)計語言。其通過創(chuàng)建 Mojo 編程語言,利用 Python 的語法和社區(qū)生態(tài),以及 MILR(一種開源編譯器),針對 AI 開發(fā)中的異構(gòu)計算和 Python 的多線程編譯問題進(jìn)行優(yōu)化。

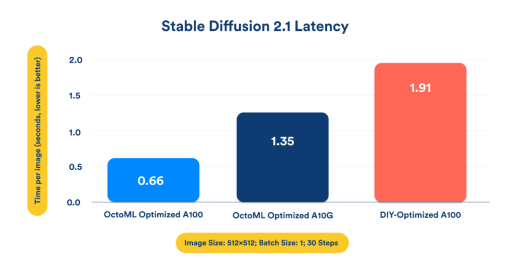

OctoML 是一種模型部署工具,能夠快速實現(xiàn)成品模型在各種算力設(shè)備上的優(yōu)化和部署。以 OctoML 部署的 StableDiffusion 為例,OctoML 利用機(jī)器學(xué)習(xí)優(yōu)化技術(shù)能夠?qū)崿F(xiàn)三倍的推理速度,支持快速模型微調(diào)。

OctoML 優(yōu)化多 GPU 部署和連續(xù)批處理,Llama2 實現(xiàn) 3 倍性能提升。隨著大模型參數(shù)量增加,GPU 負(fù)載并非線性增長,而是呈指數(shù)增長。因為參數(shù)數(shù)量的提升帶來多 GPU 并行計算問題和大模型最為經(jīng)典的 KV 緩存問題。針對這些問題,OctoAI 進(jìn)行優(yōu)化。

OctoAI 多 GPU 跑分結(jié)果

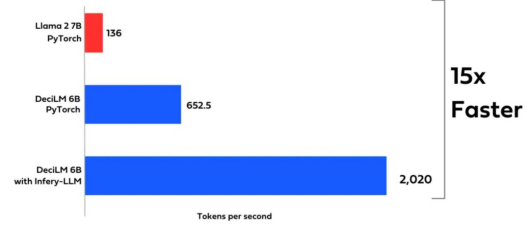

Deci 致力于模型部署層面的優(yōu)化和小模型功能的提升。DeciLM 解碼器的 Transformer 具備可變的 Grouped-Query Attention(GQA)能力,即能夠改變不同 Transformer 層的 attention 組、鍵值和數(shù)值的數(shù)量。DeciLM 是首個在 Transformer 層結(jié)構(gòu)上實現(xiàn)互不重復(fù)的語言模型。60 億參數(shù)的 DeciLM 模型在性能上超越 PyTorch 的 70 億參數(shù) Llama2。

DeciLM 與 Llama2 在 token 生成上的性能對比

三、訓(xùn)練可視化

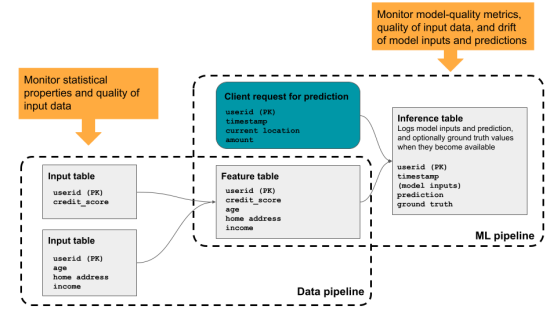

Databricks 是一款 GPU 資源管理工具,提供模型和訓(xùn)練進(jìn)度的可視化功能。其核心業(yè)務(wù)是將數(shù)據(jù)湖和數(shù)據(jù)倉庫統(tǒng)一到一個平臺,即湖倉一體。與 Snowflake 類似,在數(shù)據(jù)庫功能實現(xiàn)方式上存在一定的差異。通過 Lakehouse AI 的算力集群資源管理,開發(fā)者可以更好地進(jìn)行模型訓(xùn)練和推理的監(jiān)控。Databricks Lakehouse Monitoring 通過監(jiān)控數(shù)據(jù)管道和訓(xùn)練管道來實現(xiàn) LLM 的性能和質(zhì)量管理,并創(chuàng)建可視化界面。

Databricks Lakehouse Monitoring 幫助開發(fā)者監(jiān)控模型的訓(xùn)練推理

藍(lán)海大腦大模型訓(xùn)練平臺

藍(lán)海大腦大模型訓(xùn)練平臺提供強(qiáng)大的算力支持,包括基于開放加速模組高速互聯(lián)的AI加速器。配置高速內(nèi)存且支持全互聯(lián)拓?fù)洌瑵M足大模型訓(xùn)練中張量并行的通信需求。支持高性能I/O擴(kuò)展,同時可以擴(kuò)展至萬卡AI集群,滿足大模型流水線和數(shù)據(jù)并行的通信需求。強(qiáng)大的液冷系統(tǒng)熱插拔及智能電源管理技術(shù),當(dāng)BMC收到PSU故障或錯誤警告(如斷電、電涌,過熱),自動強(qiáng)制系統(tǒng)的CPU進(jìn)入ULFM(超低頻模式,以實現(xiàn)最低功耗)。致力于通過“低碳節(jié)能”為客戶提供環(huán)保綠色的高性能計算解決方案。主要應(yīng)用于深度學(xué)習(xí)、學(xué)術(shù)教育、生物醫(yī)藥、地球勘探、氣象海洋、超算中心、AI及大數(shù)據(jù)等領(lǐng)域。

構(gòu)建基于英偉達(dá)GPU的全場景AI基礎(chǔ)設(shè)施方案,適用于“端、邊、云”等各種應(yīng)用環(huán)境。幫助開發(fā)者更快速、更高效地構(gòu)建和部署AI應(yīng)用。

一、為什么需要大模型?

1、模型效果更優(yōu)

大模型在各場景上的效果均優(yōu)于普通模型。

2、創(chuàng)造能力更強(qiáng)

大模型能夠進(jìn)行內(nèi)容生成(AIGC),助力內(nèi)容規(guī)模化生產(chǎn)。

3、靈活定制場景

通過舉例子的方式,定制大模型海量的應(yīng)用場景。

4、標(biāo)注數(shù)據(jù)更少

通過學(xué)習(xí)少量行業(yè)數(shù)據(jù),大模型就能夠應(yīng)對特定業(yè)務(wù)場景的需求。

二、平臺特點

1、異構(gòu)計算資源調(diào)度

一種基于通用服務(wù)器和專用硬件的綜合解決方案,用于調(diào)度和管理多種異構(gòu)計算資源,包括CPU、GPU等。通過強(qiáng)大的虛擬化管理功能,能夠輕松部署底層計算資源,并高效運行各種模型。同時充分發(fā)揮不同異構(gòu)資源的硬件加速能力,以加快模型的運行速度和生成速度。

2、穩(wěn)定可靠的數(shù)據(jù)存儲

支持多存儲類型協(xié)議,包括塊、文件和對象存儲服務(wù)。將存儲資源池化實現(xiàn)模型和生成數(shù)據(jù)的自由流通,提高數(shù)據(jù)的利用率。同時采用多副本、多級故障域和故障自恢復(fù)等數(shù)據(jù)保護(hù)機(jī)制,確保模型和數(shù)據(jù)的安全穩(wěn)定運行。

3、高性能分布式網(wǎng)絡(luò)

提供算力資源的網(wǎng)絡(luò)和存儲,并通過分布式網(wǎng)絡(luò)機(jī)制進(jìn)行轉(zhuǎn)發(fā),透傳物理網(wǎng)絡(luò)性能,顯著提高模型算力的效率和性能。

4、全方位安全保障

在模型托管方面,采用嚴(yán)格的權(quán)限管理機(jī)制,確保模型倉庫的安全性。在數(shù)據(jù)存儲方面,提供私有化部署和數(shù)據(jù)磁盤加密等措施,保證數(shù)據(jù)的安全可控性。同時,在模型分發(fā)和運行過程中,提供全面的賬號認(rèn)證和日志審計功能,全方位保障模型和數(shù)據(jù)的安全性。

三、常用配置

1、CPU:

Intel Xeon Gold 8358P 32C/64T 2.6GHz 48MB,DDR4 3200,Turbo,HT 240W

Intel Xeon Platinum 8350C 32C/64T 2.6GHz 48MB,DDR4 3200,Turbo,HT 240W

Intel Xeon Platinum 8458P 28C/56T 2.7GHz 38.5MB,DDR4 2933,Turbo,HT 205W

Intel Xeon Platinum 8468 Processor 48C/64T 2.1GHz 105M Cache 350W

AMD EPYC? 7742 64C/128T,2.25GHz to 3.4GHz,256MB,DDR4 3200MT/s,225W

AMD EPYC? 9654 96C/192T,2.4GHz to 3.55GHz to 3.7GHz,384MB,DDR5 4800MT/s,360W

2、GPU:

NVIDIA L40S GPU 48GB

NVIDIA NVLink-A100-SXM640GB

NVIDIA HGX A800 80GB

NVIDIA Tesla H800 80GB HBM2

NVIDIA A800-80GB-400Wx8-NvlinkSW×8

審核編輯 黃宇

-

Turbo

+關(guān)注

關(guān)注

1文章

59瀏覽量

19510 -

GPT

+關(guān)注

關(guān)注

0文章

368瀏覽量

16069 -

超算

+關(guān)注

關(guān)注

1文章

117瀏覽量

9350 -

大模型

+關(guān)注

關(guān)注

2文章

3132瀏覽量

4045

發(fā)布評論請先 登錄

華為助力算力互聯(lián)網(wǎng)跨域算間無損互聯(lián)

華為AI WAN智算IP廣域網(wǎng)助力算力互聯(lián)網(wǎng)建設(shè)

華為助力湖北移動打造“九州”算力互聯(lián)網(wǎng)區(qū)域標(biāo)桿

華為助力中國移動全面升級“九州”算力互聯(lián)網(wǎng)

阿里最新消息:國家超算互聯(lián)網(wǎng)平臺、廣州算力中心、多所高校接入通義千問大模型

用PaddleNLP在4060單卡上實踐大模型預(yù)訓(xùn)練技術(shù)

國家超算互聯(lián)網(wǎng)平臺上線多款A(yù)I模型

xgboost超參數(shù)調(diào)優(yōu)技巧 xgboost在圖像分類中的應(yīng)用

全球首顆!中國移動聯(lián)合產(chǎn)業(yè)伙伴發(fā)布全調(diào)度以太網(wǎng)(GSE)DPU芯片

GPT-4 Turbo 發(fā)布 | 大模型訓(xùn)練的新時代:超算互聯(lián)網(wǎng)的調(diào)度與調(diào)優(yōu)

GPT-4 Turbo 發(fā)布 | 大模型訓(xùn)練的新時代:超算互聯(lián)網(wǎng)的調(diào)度與調(diào)優(yōu)

評論