斯坦福大學研發的大語言模型評測 AlpacaEvalLeaderboard備受業內認可,在 2023 年 12 月 7 日 更新的排行榜中,Yi-34B-Chat 以 94.08% 的勝率,超越 LLaMA2 Chat 70B、Claude 2、ChatGPT,在 Alpaca 經認證的模型類別中,成為僅次于 GPT-4 英語能力的大語言模型。

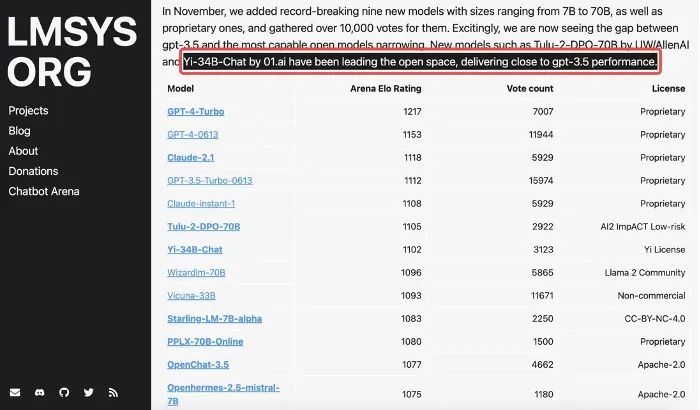

同一周,在加州大學伯克利分校主導的LMSYS ORG排行榜中,Yi-34B-Chat也以1102的Elo評分,晉升最新開源SOTA開源模型之列,性能表現追平GPT-3.5。

多個Benchmark遙遙領先

在五花八門的大模型評測中,伯克利LMSYS ORG排行榜采用了一個最為接近用戶體感的「聊天機器人競技場」特殊測評模式,讓眾多大語言模型在評測平臺隨機進行一對一 battle,通過眾籌真實用戶來進行線上實時盲測和匿名投票,11月份經25000的真實用戶投票總數計算了20個大模型的總得分。

Elo評分越高,說明模型在真實用戶體驗上的表現越出色,可說是眾多大模型評測集中最能展現「Moment of Truth」真實關鍵一刻” 的用戶導向體驗對決。

在開源模型中,Yi-34B-Chat成為當之無愧的「最強王者」之一(英語能力),LMSYS ORG 在12月8日官宣11月份總排行時評價:「Yi-34B-Chat 和 Tulu-2-DPO-70B 在開源界的進擊表現已經追平 GPT-3.5」。

風波終結,爭議理清

Yi-34B開源發布后,開發者Eric Hartford發現了模型存在的一個問題,就簡略留言在 Yi 的項目頁面。然而Eric自己也沒有預想到,他的留言引發了后續輿論關于Yi模型「抄襲」LLaMA的質疑。

他在郵件中寫道,「感謝你們提供了一個優秀的模型。Yi模型使用了與LLaMA模型完全相同的架構,只是將兩個張量改了名字。由于圍繞LLaMA架構有很多投資和工具,保持張量名稱的一致性是有價值的。」Eric建議,在Yi被廣泛傳播前,及時恢復張量名稱。 客觀來說,一個模型核心技術護城河是在架構之上,通過數據訓練獲得的參數和代碼。大多數有志于參與基座大模型競爭的團隊,也多是從零開始,用高質量的數據集再進行訓練,普遍都是在沿用LLaMA架構。零一后來解釋他們為了執行對比實驗的需要,對部分推理參數進行了重新命名,原始出發點是為了充分測試模型,而非刻意隱瞞來源。

身處這場輿論風暴的中心,Eric 意識到了可能給一些人帶來了誤解,開始解釋自己之前的發言。

他在X(twitter)上寫道,「他們沒有在任何事情上撒謊。所有的模型都是在相互借鑒架構。架構是學術研究的產物,已經發表在論文中,任何人都可以自由使用,這絲毫不減損Yi團隊的成就。他們從零開始使用自己創建的數據集訓練Yi,對開源領域的貢獻是值得贊揚的。使用Llama架構沒有任何問題。訓練才是關鍵。Yi給了我們目前可獲得的最佳模型,沒有任何可抱怨的。」 現在,Eric 自己也在使用Yi-34B 系列,用Yi-34b-200k數據集訓練其他的模型產品。 Yi模型開源首月,數據也很亮眼。在Hugging Face社區下載量為16.8萬,魔搭社區下載量1.2萬。在GitHub 獲得超過4900個Stars。

由于性能表現強勁,多家知名公司和機構推出了基于Yi模型基座的微調模型,比如獵豹旗下的獵戶星空公司推出的OrionStar-Yi-34B-Chat模型,南方科技大學和粵港澳大灣區數字經濟研究院(簡稱IDEA研究院)認知計算與自然語言研究中心(簡稱CCNL中心)聯合發布的SUS-Chat-34B等,均性能表現優異。 而AMD和Hugging Face合作的GPU加速大模型的實驗中,也選擇了Yi-6B作為范例項目。

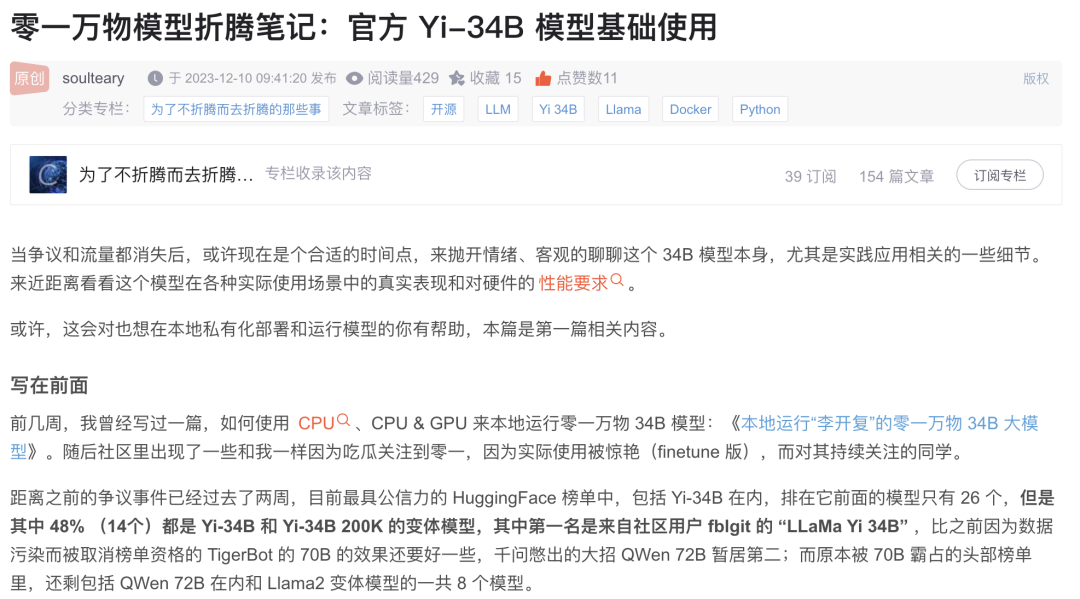

模型好不好,開發者最知道在大模型實際使用體驗上,最有發言權的還是一線的開發者。 知名技術作者蘇洋表示,在他觀察的近期Hugging Face榜單中,前三十名有一半多都是 Yi 和其他用戶微調的 Yi-34B 的變體模型,原本占據榜單頭部的 68B 和 70B 模型的數量目前只留有幾個,「從這點看 Yi 對于開源生態的幫助還是非常巨大的。」 他會時不時的瀏覽下 HF 的榜單,在最近榜單中的前三十名,有一半多都是 Yi 和其他用戶微調的 Yi-34B 的變體模型,原本占據榜單頭部的 68B 和 70B 模型的數量目前只留有幾個,從這點看 Yi 對于開源生態的幫助還是非常巨大的。

蘇洋還將他的訓練經驗和心得在CSDN上做了分享(https://blog.csdn.net/soulteary/article/details/134904434)。

蘇洋認為 34B 普通用戶努努力還是能自己相對低成本跑起來的,68 和 70B 的模型想要本地運行,需要更多的資源。但其實目前分數其實相比較 34B 拉不開太多,也就三四分平均分,但參數量差了一倍。換言之,企業想部署使用,所需要的成本也可以得到非常大的節約。

目前國產大模型在開源榜單上已經是第一梯隊,但如果把競爭范圍追加到閉源模型、尤其是海外的模型,仍有很大的距離要去追趕。目前的普遍體驗是開源模型最多只有 GPT-3.5 + 的水平。

蘇洋認為國產大模型,是能夠很快追趕至第一梯隊的。時間也會證明大模型自身的價值,以及驗證出團隊是否對開源有真的持續投入。

-

語言模型

+關注

關注

0文章

561瀏覽量

10739 -

聊天機器人

+關注

關注

0文章

348瀏覽量

12766 -

大模型

+關注

關注

2文章

3094瀏覽量

3984

原文標題:開源風波后在 AlpacaEval 直追 GPT4,零一靠技術如何重建生態信心

文章出處:【微信號:AI科技大本營,微信公眾號:AI科技大本營】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

開源鴻蒙硬件生態分論壇圓滿舉辦

開源鴻蒙大屏生態分論壇圓滿舉辦

誠邁科技攜HongZOS亮相開源鴻蒙開發者大會,加速生態繁榮與產業躍遷

OpenAI宣布GPT 4o升智計劃

OpenAI即將發布GPT-4.5與GPT-5

deepin社區助力開源教育與生態發展

開源鴻蒙技術分論壇在武漢成功舉辦

OpenHarmony人才生態大會南向生態社區發展論壇在武漢圓滿舉辦

Llama 3 與 GPT-4 比較

如何使用 ChatGPT 進行內容創作

請回答OpenHarmony | 關于開源生態的未來想象,我們現場回答

迅龍軟件出席2024開放原子開源生態大會,共謀開源生態繁榮之路

開放原子開源生態大會OpenHarmony生態主題演講報名開啟

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

開源風波后在AlpacaEval直追GPT4,零一靠技術如何重建生態信心

開源風波后在AlpacaEval直追GPT4,零一靠技術如何重建生態信心

評論