幻方量化旗下組織深度求索發(fā)布了國內(nèi)首個開源 MoE 大模型 ——DeepSeekMoE,全新架構(gòu),免費商用。

今年 4 月,幻方量化發(fā)布公告稱,公司將集中資源和力量,全力投身到服務(wù)于全人類共同利益的人工智能技術(shù)之中,成立新的獨立研究組織,探索 AGI 的本質(zhì)。幻方將這個新組織命名為 “深度求索 (DeepSeek)”。

DeepSeekMoE 的模型、代碼、論文均已同步發(fā)布。

模型下載:https://huggingface.co/deepseek-ai

微調(diào)代碼:https://github.com/deepseek-ai/DeepSeek-MoE

技術(shù)報告:https://github.com/deepseek-ai/DeepSeek-MoE/blob/main/DeepSeekMoE.pdf

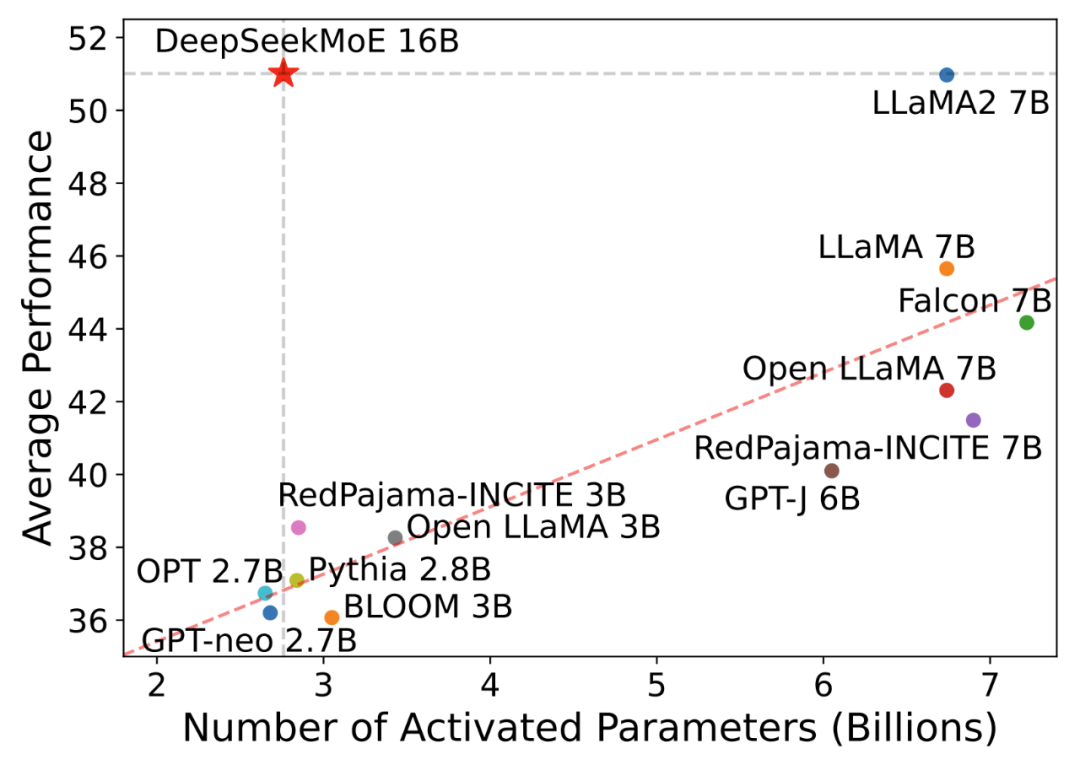

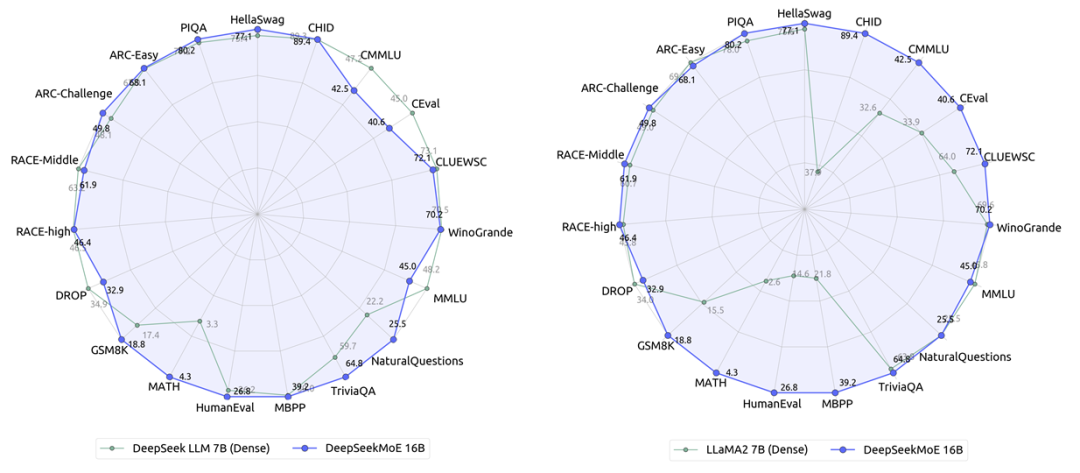

據(jù)介紹,DeepSeekMoE 的多尺度(2B->16B->145B)模型效果均領(lǐng)先:

DeepSeekMoE-2B 可接近 MoE 模型的理論上限2B Dense 模型性能(即相同 Attention/FFN 參數(shù)配比的 2B Dense 模型),僅用了 17.5% 計算量

DeepSeekMoE-16B 性能比肩 LLaMA2 7B 的同時,僅用了 40% 計算量,也是本次主力開源模型,40G 顯存可單卡部署

DeepSeekMoE-145B 上的早期實驗進一步證明該 MoE 架構(gòu)明顯領(lǐng)先于 Google 的 MoE 架構(gòu) GShard,僅用 28.5%(甚至 18.2%)計算量即可匹配 67B Dense 模型的性能

混合專家模型 (Mixed Expert Models,簡稱 MoEs)是用于提高大語言模型效率和準確度的技術(shù)。這種方法的核心是將復(fù)雜任務(wù)劃分為更小、更易管理的子任務(wù),每個子任務(wù)由專門的小型模型或 “專家” 負責(zé),然后根據(jù)輸入數(shù)據(jù)的特性選擇性地激活這些 “專家”。 MoE 核心組成:

專家 (Experts):訓(xùn)練有素的小型神經(jīng)網(wǎng)絡(luò),擅長特定領(lǐng)域。每個專家通常專注于處理一種特定類型的數(shù)據(jù)或任務(wù)。專家的設(shè)計可以是多種形式,如完全連接的網(wǎng)絡(luò)、卷積網(wǎng)絡(luò)等。

門控機制 (Gating Mechanism):MoE 架構(gòu)決策者,這是一個智能路由系統(tǒng),負責(zé)決定哪些專家應(yīng)該被激活來處理當前的輸入數(shù)據(jù)。門控機制基于輸入數(shù)據(jù)的特性,動態(tài)地將數(shù)據(jù)分配給不同的專家。

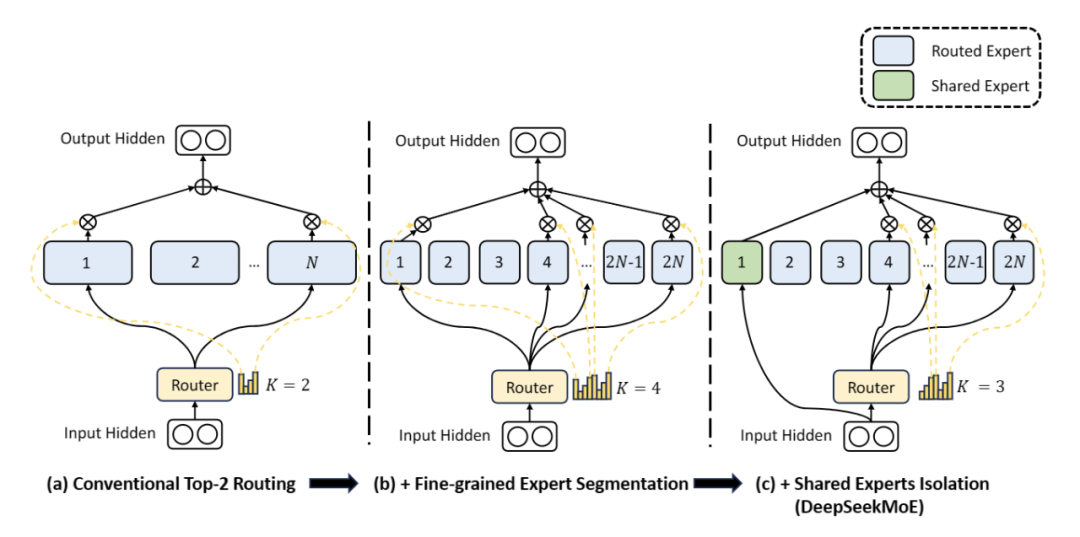

官方稱 DeepSeekMoE 是自研的全新 MoE 框架,主要包含兩大創(chuàng)新:

細粒度專家劃分:不同于傳統(tǒng) MoE 直接從與標準 FFN 大小相同的 N 個專家里選擇激活 K 個專家(如 Mistral 7B8 采取 8 個專家選 2 專家),DeepSeekMoE把 N 個專家粒度劃分更細,在保證激活參數(shù)量不變的情況下,從 mN 個專家中選擇激活 mK 個專家(如 DeepSeekMoE 16B 采取 64 個專家選 8 個專家),如此可以更加靈活地組合多個專家

共享專家分離:DeepSeekMoE 把激活專家區(qū)分為共享專家(Shared Expert)和獨立路由專家(Routed Expert),此舉有利于將共享和通用的知識壓縮進公共參數(shù),減少獨立路由專家參數(shù)之間的知識冗余

審核編輯:劉清

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4811瀏覽量

103074 -

智能路由

+關(guān)注

關(guān)注

0文章

9瀏覽量

7198 -

卷積網(wǎng)絡(luò)

+關(guān)注

關(guān)注

0文章

43瀏覽量

2464 -

DeepSeek

+關(guān)注

關(guān)注

1文章

785瀏覽量

1511

原文標題:幻方量化開源國內(nèi)首個MoE大模型,全新架構(gòu)、免費商用

文章出處:【微信號:OSC開源社區(qū),微信公眾號:OSC開源社區(qū)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

瑞芯微模型量化文件構(gòu)建

上新:小米首個推理大模型開源 馬斯克:下周推出Grok 3.5

DeepSeek扔的第二枚開源王炸是什么

Meta組建四大專研小組,深入探索DeepSeek模型

字節(jié)跳動發(fā)布豆包大模型1.5 Pro

獵戶星空發(fā)布Orion-MoE 8×7B大模型及AI數(shù)據(jù)寶AirDS

騰訊發(fā)布開源MoE大語言模型Hunyuan-Large

全球首個開源AI標準正式發(fā)布

Meta發(fā)布Llama 3.2量化版模型

深開鴻聯(lián)合深天使發(fā)布國內(nèi)首個開源鴻蒙產(chǎn)業(yè)加速營

深開鴻聯(lián)合中軟國際、粵科金融集團發(fā)布國內(nèi)首個開源鴻蒙創(chuàng)業(yè)投資基金

深開鴻聯(lián)合深天使發(fā)布國內(nèi)首個開源鴻蒙產(chǎn)業(yè)加速營

全球首個芯片設(shè)計開源大模型SemiKong正式發(fā)布

“燃鴻”重磅發(fā)布!國內(nèi)首個燃氣行業(yè)開源鴻蒙化智能產(chǎn)品及解決方案

幻方量化發(fā)布了國內(nèi)首個開源MoE大模型—DeepSeekMoE

幻方量化發(fā)布了國內(nèi)首個開源MoE大模型—DeepSeekMoE

評論