之前介紹的項目《優秀的 Verilog/FPGA開源項目介紹(十四)- 使用FPGA實現LeNet-5 深度神經網絡模型》最后我們分析了,純FPGA實現神經網絡的缺點,以及現在FPGA廠家的加速方案,這里引用一下:

到底純FPGA適不適合這種大型神經網絡的設計?這個問題其實我們不適合回答,但是FPGA廠商是的實際操作是很有權威性的,現在不論是Intel還是Xilinx都沒有在自己傳統的FPGA上推廣AI,都是在基于FPGA的SoC上推廣(Vitis和OpenVINO,前者Xilinx后者Intel),總結來看就是:純 RTL 硬件設計不是AI的好選擇。特別是對于大規模網絡,權重和中間結果需要存儲在外部存儲器中。并且數據迭代器會更加復雜。設計周期長,AI相關領域迭代速度快,綜上以上幾點,可以很容易給你們指引一條道路。

目前主流的解決方案就是使用通用或專用處理器來做控制工作,讓硬件來執行計算(加速的概念),今天就介紹兩個針對以上解決方案的開源項目,這兩個項目是用FPGA進行硬件加速的必備項目。

AI算法流程

在進行項目介紹前,我們先介紹一下軟件架構和工具集。這個后面會影響理解。

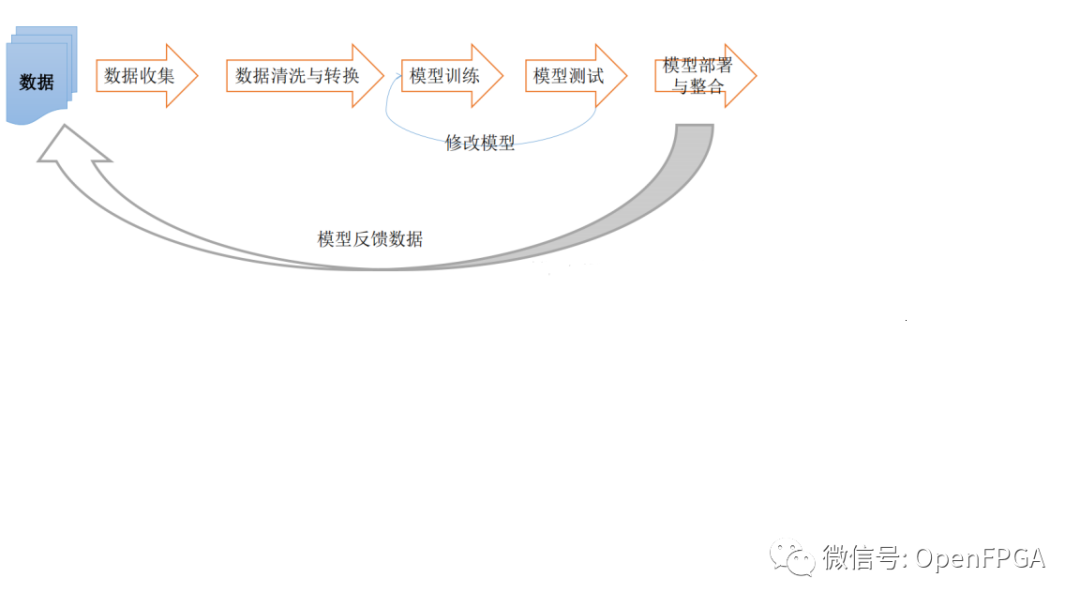

一個完整的深度學習框架中主要分為下面幾個流程:

有一些是我們不太關心的部分(對于FPGA實現應用),即數據收集等,所以上訴流程再簡單分為幾個主要部分,即訓練(training)和推理(inference)、部署(deployment)。

訓練(Training)

使用訓練模型(Caffe、TensorFlow、MxNET、ONNX等)根據訓練數據得到相關的參數。舉個例子,我現在想要設備識別貓和狗,我首先需要收集貓和狗的圖片(這些圖片稱為訓練數據集(training dataset)),但是這些數據集在進行訓練前要有標簽(即每張照片是狗,那張照片是貓),選擇好訓練模型后,將上訴數據給訓練模型進行訓練,訓練模型不是萬能的,雖然能通過訓練不斷的優化參數,但是在訓練完還不一定能達到你想要的識別率(比如100張圖片有50張能識別),接下來就是通過優化參數,讓另外50張錯的也變成對的。這整個過程就稱之為訓練(Traning)。

推理(Inference)

這個過程比較簡單,就是把上面訓練好的模型,去識別不是訓練集里的圖片(這種圖片就叫做現場數據(live data)),如果對這些現場數據的識別也非常NICE,那么證明你的網絡訓練的是非常好的,如果不是特別好,就需要把訓練數據集增加,重復這一過程,直到現場數據也達到比較好的效果。把訓練好的模型拿出來進行現場實驗推理的過程,稱為推理(Inference)。

部署(deployment)

部署的理解很簡單,就是經過上面兩個步驟的模型應用,把它放在某個硬件平臺上運行,這個過程稱之為部署(deployment)。

其實各大廠家推出自己的架構/工具都是基于上訴流程,不同點就是會針對自家的硬件做細節優化。

現在常見的模型推理部署框架有很多,比如:英特爾的OpenVINO,英偉達的TensorRT,谷歌的Mediapipe,Xilinx Vitis。

Intel FPGA OpenVINO

介紹

OpenVINO是Intel推出的用于優化和部署 AI 推理的開源工具包。

提升計算機視覺、自動語音識別、自然語言處理和其他常見任務中的深度學習性能

使用通過 TensorFlow、PyTorch 等流行框架訓練的模型

減少資源需求并在從邊緣到云的一系列英特爾平臺上高效部署

來源:知乎@火狐貍

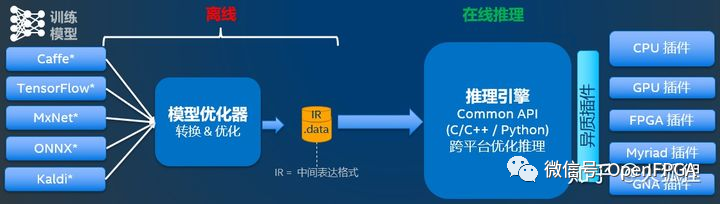

上圖就是OpenVINO的組成,針對第一節的 AI算法流程 理解起來不是很難。其中,模型優化器是線下模型轉換,推理引擎是部署在設備上運行的AI負載。

因為OpenVINO還有針對自己CPU的架構,沒有對FPGA部分過多介紹,所以一些細節會在下一個項目介紹。

視頻介紹

關于OpenFPGA在FPGA方面的加速應用,可以查看下面的兩個官方中文視頻介紹,這里就不再贅述。

Xilinx FPGA Vitis AI

2019年10月,Xilinx正式發布了統一開發軟件平臺Vitis。Vitis平臺無需用戶深入掌握硬件專業知識,即軟件和算法自動適配到Xilinx的硬件架構。Xilinx Vitis AI是針對自家硬件平臺推出的針對AI模型的硬件實現。Vitis AI 提供的工具鏈能在數分鐘內完成優化、量化和編譯操作,在賽靈思器件上高效地運行預先訓練好的AI模型。

介紹

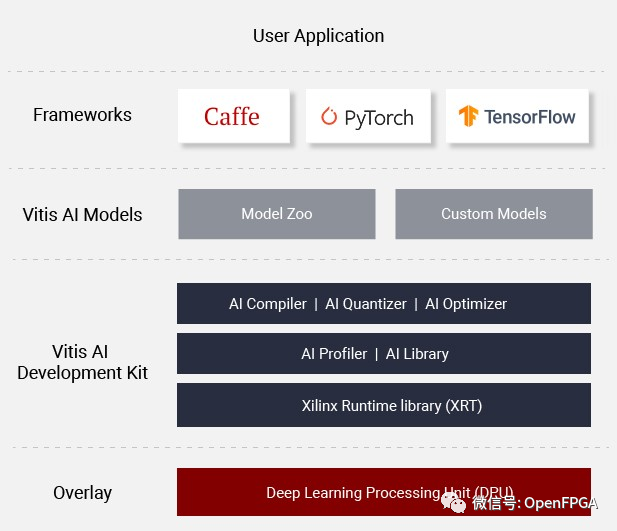

上圖就是Vitis AI的整體架構,主要分為AI Model Zoo、AI 優化器、AI 量化器、AI 編譯器、AI 配置器、AI 庫、XRT、以及核心DPU。

整個流程和上圖類似,下面針對每個部分簡單介紹(Intel的類似)。

AI Model Zoo

這個就是最流行框架 Pytorch、Tensorflow、Tensorflow 2 和 Caffe 的現成深度學習模型的集合,也就是我們可以簡單及快速的進行AI模型的訓練和優化。

AI 優化器、AI 量化器、AI 編譯器

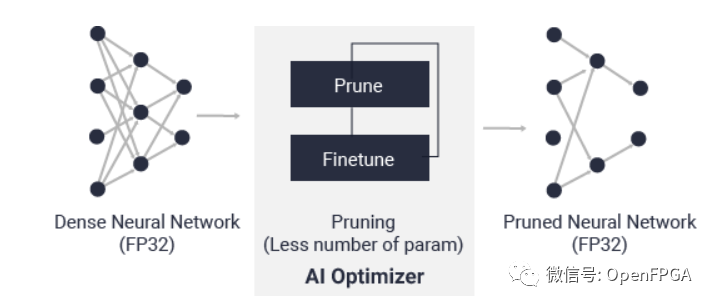

AI 優化器功能簡介

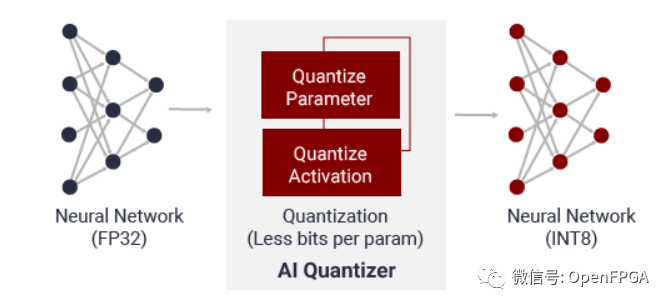

這三個作用就是將訓練好的模型進行優化,其中AI 優化器是在犧牲很少的精度情況下降模型的復雜度;AI 量化器的作用其實和FPGA的結構有關(FPGA無法處理浮點數據),AI 量化器就是將32 位浮點權值和激活量轉換為 INT8 這樣的定點數據。

AI 量化器功能簡介

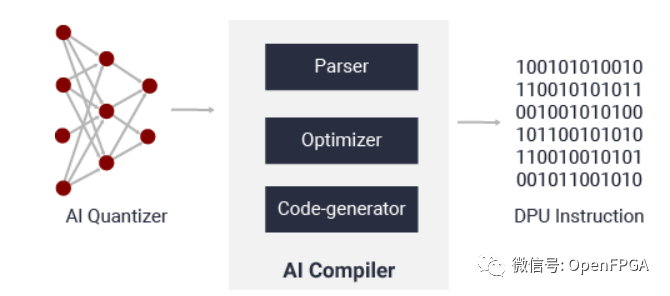

AI 編譯器的作用就是將 AI 模型進行高級優化,主要包括指令集、數據流、層融合和指令排程等,并可盡量重復使用片上內存。

AI 編譯器功能簡介

AI 配置器、AI 庫

AI 配置器功能簡介

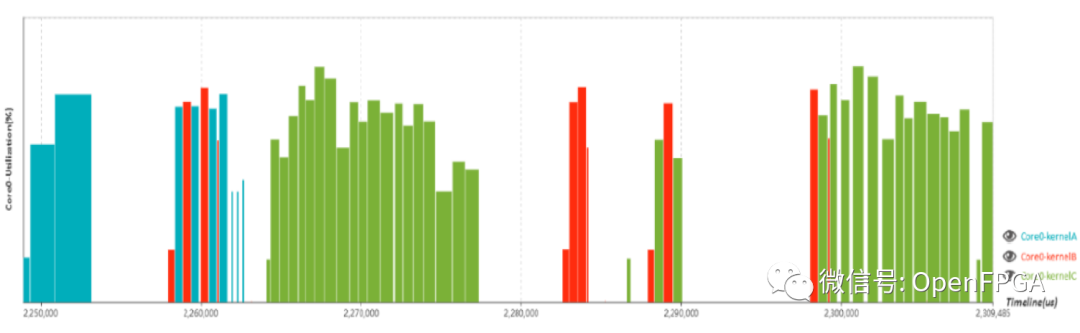

AI 配置器主要是輔助開發人員對AI模型的方案實施的效率和利用率進行分析的性能分析器。

AI 庫功能簡介

AI庫主要功能就是將DPU和上層進行鏈接(基于帶有統一 API 的 Vitis AI Runtime 構建)。

XRT、DPU

這兩個是Xilinx的“王牌”了,其中DPU大家應該不陌生,是DNNDK的升級版本(DNNDK官方應該已經不維護了)。

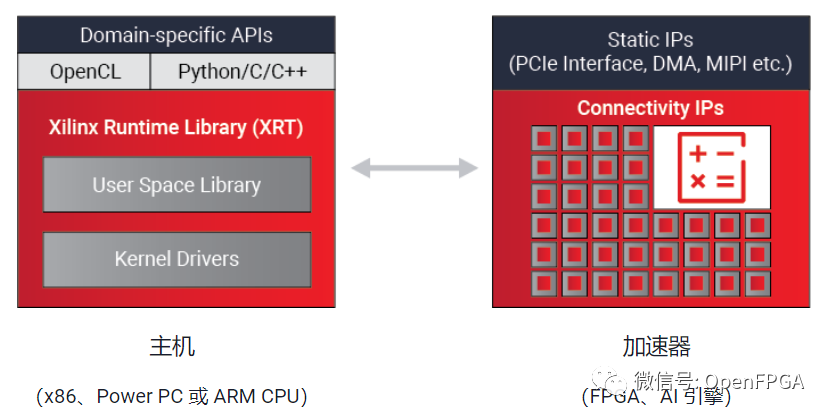

XRT

Xilinx 運行時庫 (XRT) 是 Vitis 統一軟件平臺和 Vitis AI 開發環境的一個重要組成部分,其可幫助開發人員繼續使用熟悉的編程語言(如 C/C++、Python 以及高層次特定域框架 TensorFlow 和咖啡等)在 Xilinx 靈活應變的平臺上部署。

主要功能如下圖所示:

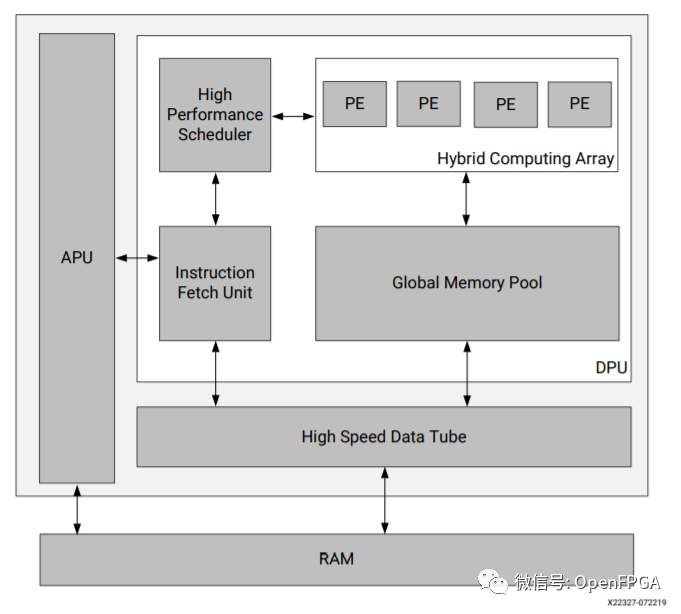

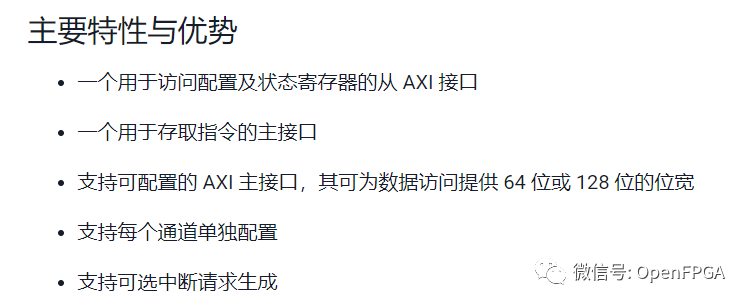

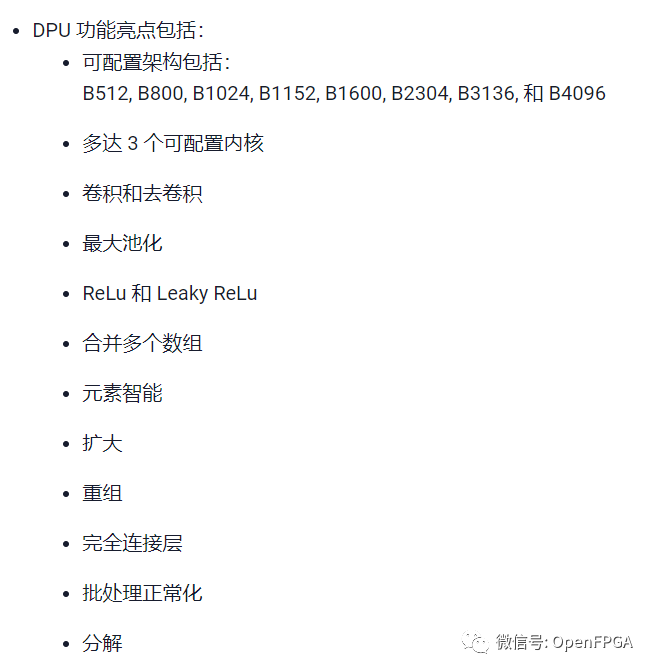

DPU

詳細介紹:PG338 PG366

Xilinx深度學習處理器單元 (DPU) 是一個專門用于卷積神經網絡的可編程引擎。該單元包含寄存器配置模塊、數據控制器模塊和卷積計算模塊。在 DPU 中部署的卷積神經網絡包括 VGG、ResNet、GoogLeNet、YOLO、SSD、MobileNet 以及 FPN 等。

總結

今天介紹了兩個最重要的FPGA加速神經網絡的開源項目,而且經過幾年的發展越發穩定,總結一下就是,如果想用FPGA加速神經網絡就快點去看看吧,這里在簡單推薦一下這兩個項目的入門開發板。

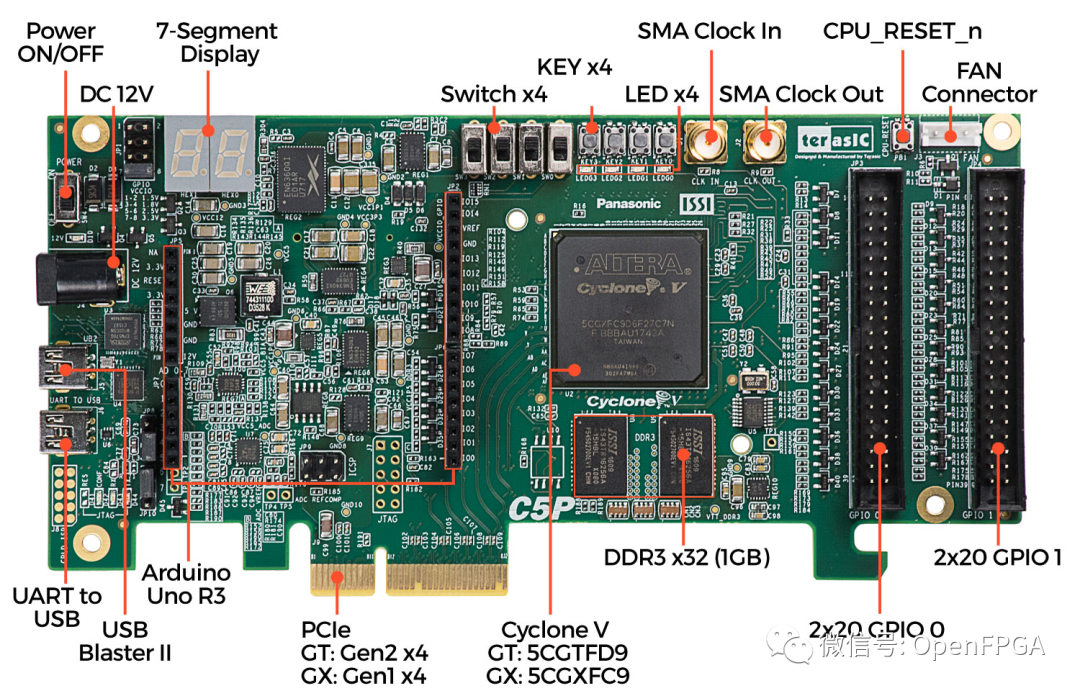

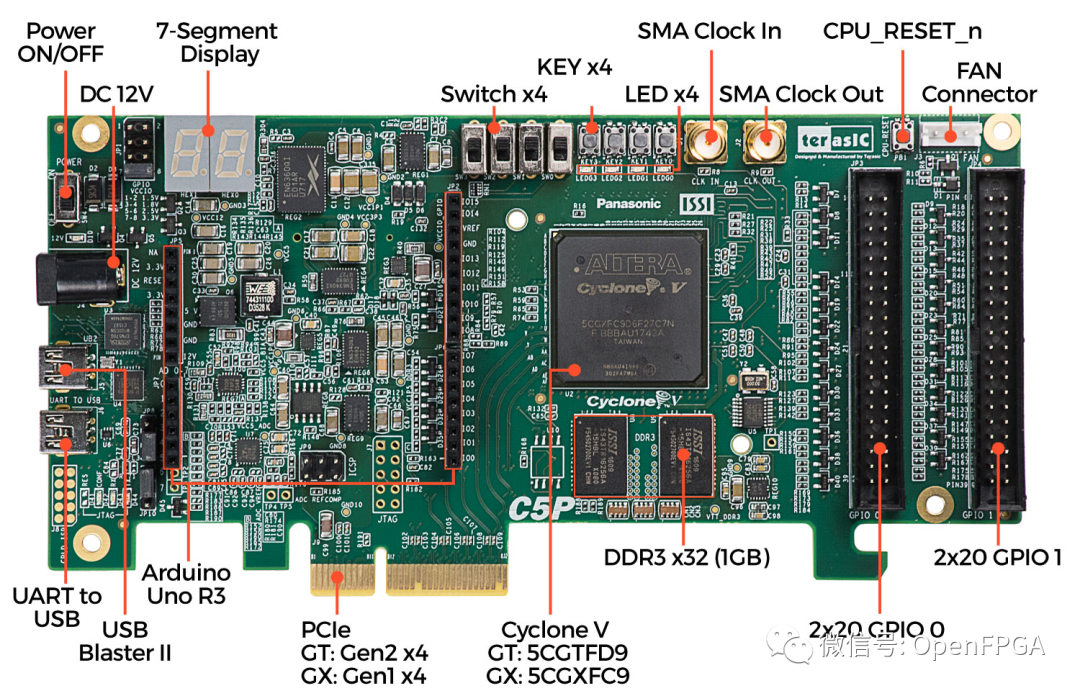

Intel C5P 開發板

Intel OpenVINO入門開發板

Xilinx Kria KV260開發板

最后,還是感謝各個大佬開源的項目,讓我們受益匪淺。后面有什么感興趣方面的項目,大家可以在后臺留言或者加微信留言,今天就到這,我是爆肝的碎碎思,期待下期文章與你相見。

審核編輯:湯梓紅

-

FPGA

+關注

關注

1644文章

21993瀏覽量

615370 -

神經網絡

+關注

關注

42文章

4811瀏覽量

103043 -

Xilinx

+關注

關注

73文章

2184瀏覽量

124591 -

開源

+關注

關注

3文章

3634瀏覽量

43584

原文標題:想用FPGA加速神經網絡,這兩個開源項目你必須要了解

文章出處:【微信號:Open_FPGA,微信公眾號:OpenFPGA】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

如何用FPGA加速神經網絡

如何用FPGA加速神經網絡

評論