借助 TensorRT-LLM,Google 全新開放語言模型可在 NVIDIA AI 平臺(包括本地 RTX AI PC)上加速運行。

2024 年 2 月 21 日,NVIDIA 攜手 Google 在所有 NVIDIA AI 平臺上發布面向 Gemma 的優化功能,Gemma 是 Google 最先進的新型輕量級 2B 和 7B 開放語言模型,可在任何地方運行,從而降低成本并加快特定領域用戶案例的創新工作。

NVIDIA 和 Google 的團隊緊密合作,利用 NVIDIA TensorRT-LLM(用于優化大語言模型推理性能的開源庫),在數據中心的 NVIDIA GPU、云計算和搭載 NVIDIA RTX GPU 的 PC 上運行時,加速 Gemma 性能(Gemma 由創建 Gemini 模型的相同研究和技術構建)。

這使開發者能將全球高性能 AI PC 中超過 1 億臺搭載 NVIDIA RTX GPU 的用戶作為潛在用戶進行開發。

開發者還可在搭載 NVIDIA GPU 的云端運行 Gemma,該實例擁有 141GB HBM3e 顯存,速度為 4.8TB/秒,Google 將于今年部署該實例。

此外,企業級開發者還可利用 NVIDIA 豐富的工具生態系統(包括依托 NeMo 框架的 NVIDIA AI Enterprise 和 TensorRT-LLM),對 Gemma 進行微調,并將優化后的模型部署到生產應用中。

審核編輯:劉清

-

NVIDIA

+關注

關注

14文章

5246瀏覽量

105777 -

云計算

+關注

關注

39文章

7972瀏覽量

139371 -

gpu

+關注

關注

28文章

4912瀏覽量

130662

原文標題:共耀光芒:Google Gemma 優化后可在 NVIDIA GPU 上運行

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

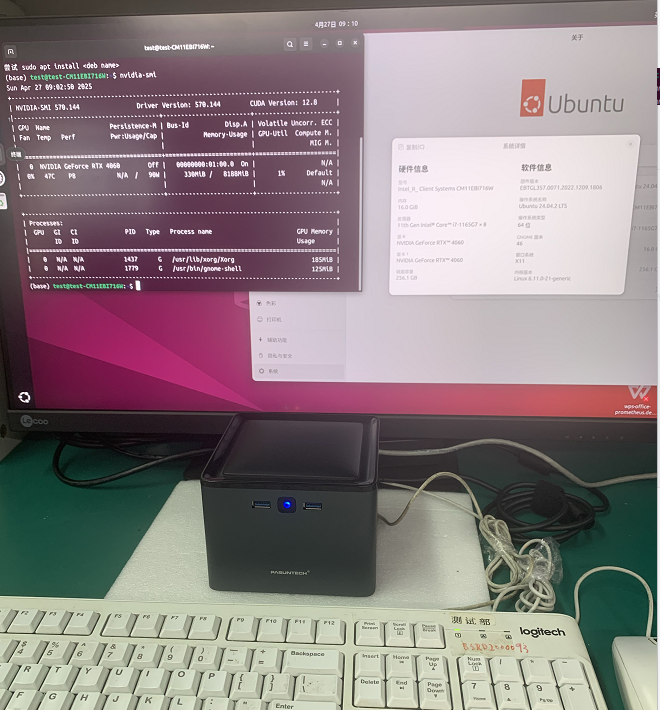

如何在Ubuntu上安裝NVIDIA顯卡驅動?

NVIDIA攜手谷歌云助力企業引入代理式AI

Google Gemma 3開發者指南

NVIDIA虛擬GPU 18.0版本的亮點

使用NVIDIA RTX PRO Blackwell系列GPU加速AI開發

Google發布最新AI模型Gemma 3

無法在GPU上運行ONNX模型的Benchmark_app怎么解決?

在龍芯3a6000上部署DeepSeek 和 Gemma2大模型

《CST Studio Suite 2024 GPU加速計算指南》

AMD與NVIDIA GPU優缺點

Google Gemma 2模型的部署和Fine-Tune演示

Google Gemma優化后可在NVIDIA GPU上運行

Google Gemma優化后可在NVIDIA GPU上運行

評論