在人工智能的世界里,正在發生一場翻天覆地的變化,隨著 ChatGPT、Sora 的橫空出世,我們正在從深度學習時代轉向生成式人工智能時代,而在這場巨變中,芯片成為了科技巨頭們的必爭之地。

近日,硅谷一家初創企業以一款獨特的芯片產品攻占各大科技媒體板塊頭條。該公司正以一種與過往不同的方式推動這場人工智能革命。該公司名為 Groq,是一家人工智能解決方案公司。

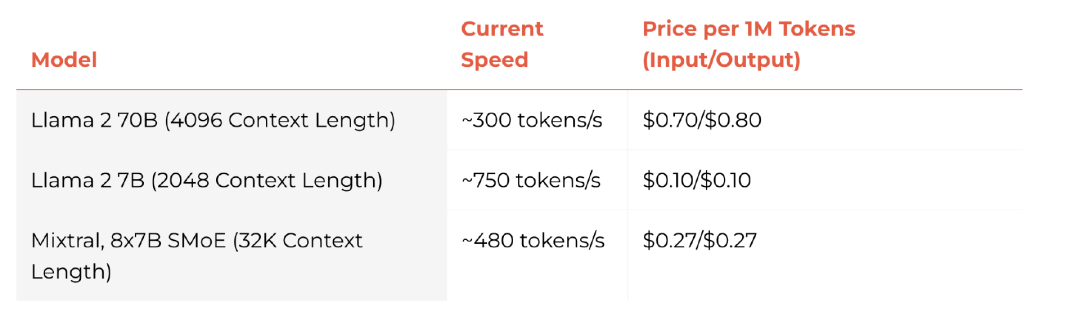

據多家外媒報道,Groq 剛剛推出了 alpha 預覽版的推理引擎,該引擎使用其定制的語言處理單元 (LPU) 芯片架構。這款推理引擎主打一個“快”字,每秒能輸出 500 個 token。相比之下,Chat GPT-3.5 每秒生成速度為 40 個 token。

“Groq 那疾如閃電的演示開始瘋傳,讓人們第一次意識到當前版本的 ChatGPT、Gemini 甚至是 Grok 看起來是多么笨拙和遲緩。”有網友感嘆道。

“你必須嘗試的瘋狂技術!” HyperWriteAI CEO Matt Shumer 在 X 上極力稱贊 Groq:“以 500 tok/s 的速度運行 Mixtral 8x7B-32k,答案幾乎是即時的。開辟新的用例,并徹底改變現有用例的用戶體驗可能性。”

根據 Shumer 發布在 X 上的演示,Groq 能夠瞬間給出包含數百個單詞的事實性答案,并提供邏輯鏈上的消息來源。

在另一段演示中,Groq 公司創始人兼 CEO Jonathon Ross 還邀請 CNN 主持人以實時對話的方式,跟跨越半個地球的 AI 聊天機器人來了場電視直播交流。雖然之前的 ChatGPT、Gemini 等其他聊天機器人也都帶來令人印象深刻的表現,但 Groq 單憑速度一項就傾倒了眾生。正所謂“天下武功,唯快不破”,速度往往是決定技術成果能否實際應用的關鍵。

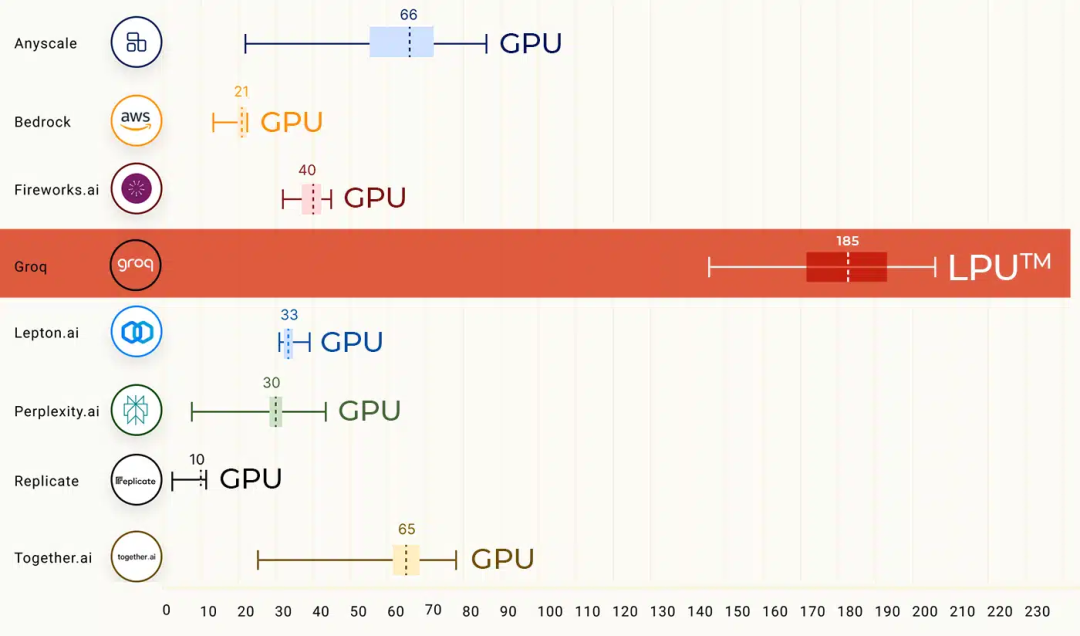

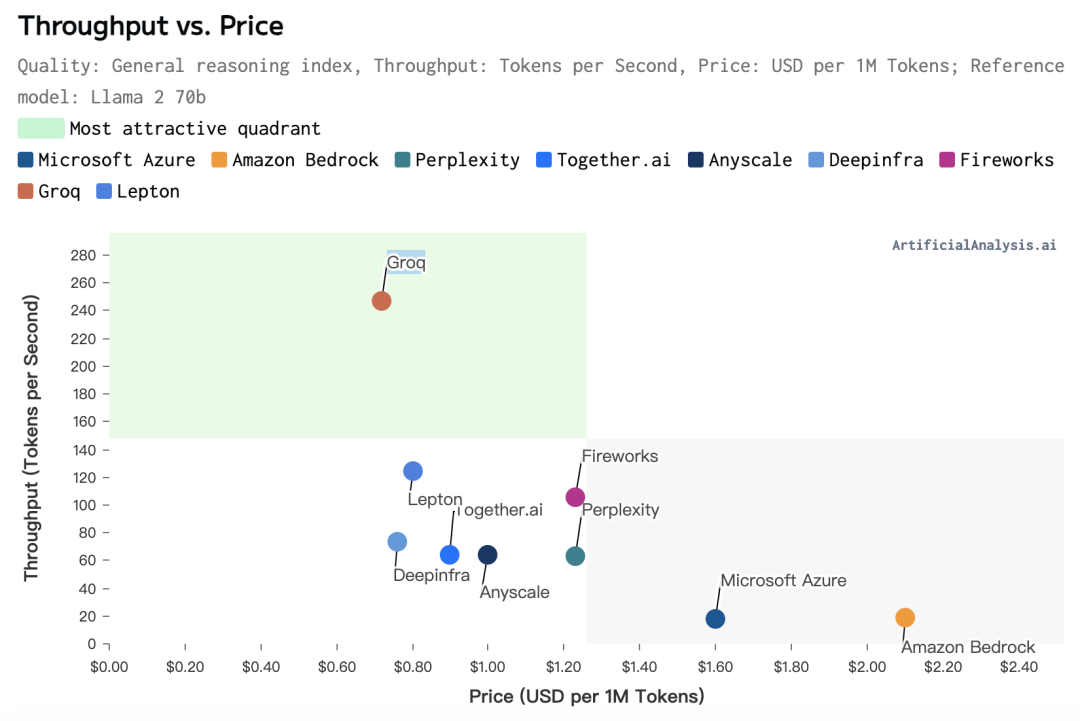

在 Groq 的第一個公開基準測試中,Meta AI 的 Llama 2 70B 在 Groq LPU 推理引擎上運行,其輸出令牌吞吐量快了 18 倍,優于所有其他基于云的推理提供商。

此外,根據 Artificial Analysis 上周公布的第三方測試結果,Groq 每秒能夠生成 247 個 token,遠遠高于微軟的 18 個 token。也就是說如果將 ChatGPT 運行在 Groq 芯片之上,其速度將可提高 13 倍有余。

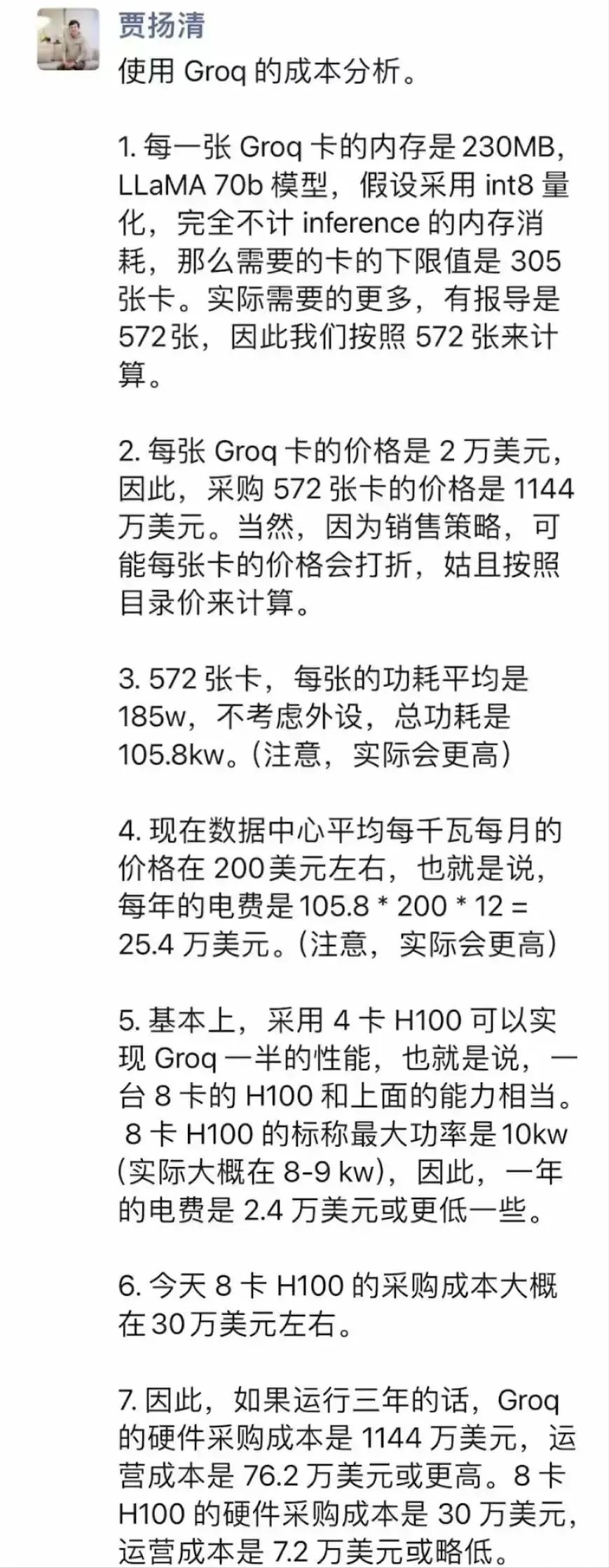

成本推算屢受質疑

在傳統 CPU 和 GPU 領域,更快的推理速度往往意味著要付出更高的成本。但從成立之初,Groq 就在強調公司的使命是將計算成本降至零。

在面對成本問題時,Ross 曾在兩年前接受《福布斯》采訪時表示:“Groq 決定做一些完全不同的事情,進行與傳統半導體行業智慧相反的創新。我們的使命是將計算成本降至零。我知道每個人都討厭高昂的計算成本。但是,如果你回顧一下計算的歷史就會發現計算成本避無可避。因此,當我們說‘將計算成本降至零’時,我們仍然以具有競爭力的行業價格點來銷售我們的解決方案。也就是說,當我們提供數量級的性能改進(200 倍、600 倍、1000 倍)時,我們每美元所提供的性能是 200、600、1000 倍。所以,它正在接近免費。”

Groq 在官網上稱“保證擊敗同等上市模型的已發布提供商所發布的每百萬 token 的價格。”

但一些業內人士以及開發者群體對于 Groq 卡的高昂價格和 CEO 主張的的“價格正在接近免費”的說辭提出了質疑。原 Facebook 人工智能科學家、原阿里巴巴技術副總裁賈揚清就給 Grop 算了一筆賬,Groq 的成本到底如何,且看大佬的分析。

(圖片來自網絡)

此外,也有 Groq 前員工在 Hacker News 上表示 Groq 理論上的推理成本是不切合實際的。

Groq 曾在發文中指出,他們使用了 576 個芯片來實現以 500 T/s 的速度運行 Mixtral 8x7B-32k 這樣的結果。但不得不注意的是,每個單獨的用戶都需要一個單獨的 KV 緩存,每個用戶將增加更多千兆字節。

我曾在 Groq 工作兩年,我預計他們實現這些性能數字的總費用將超過數百萬美元,他們發布的理論價格應該比實際使用價格更低,因此這個結果是不切實際的。從每美元實際性能的角度來看,它們似乎不可行,但如果你將成本問題拋到九霄云外,那么它們確實挺酷的。

Groq 背后的秘密:架構和編譯器

那么,Groq 又是如何做到如此之快呢?據悉,Groq 能做到如此之快背后的秘訣是架構和編譯器的創新。

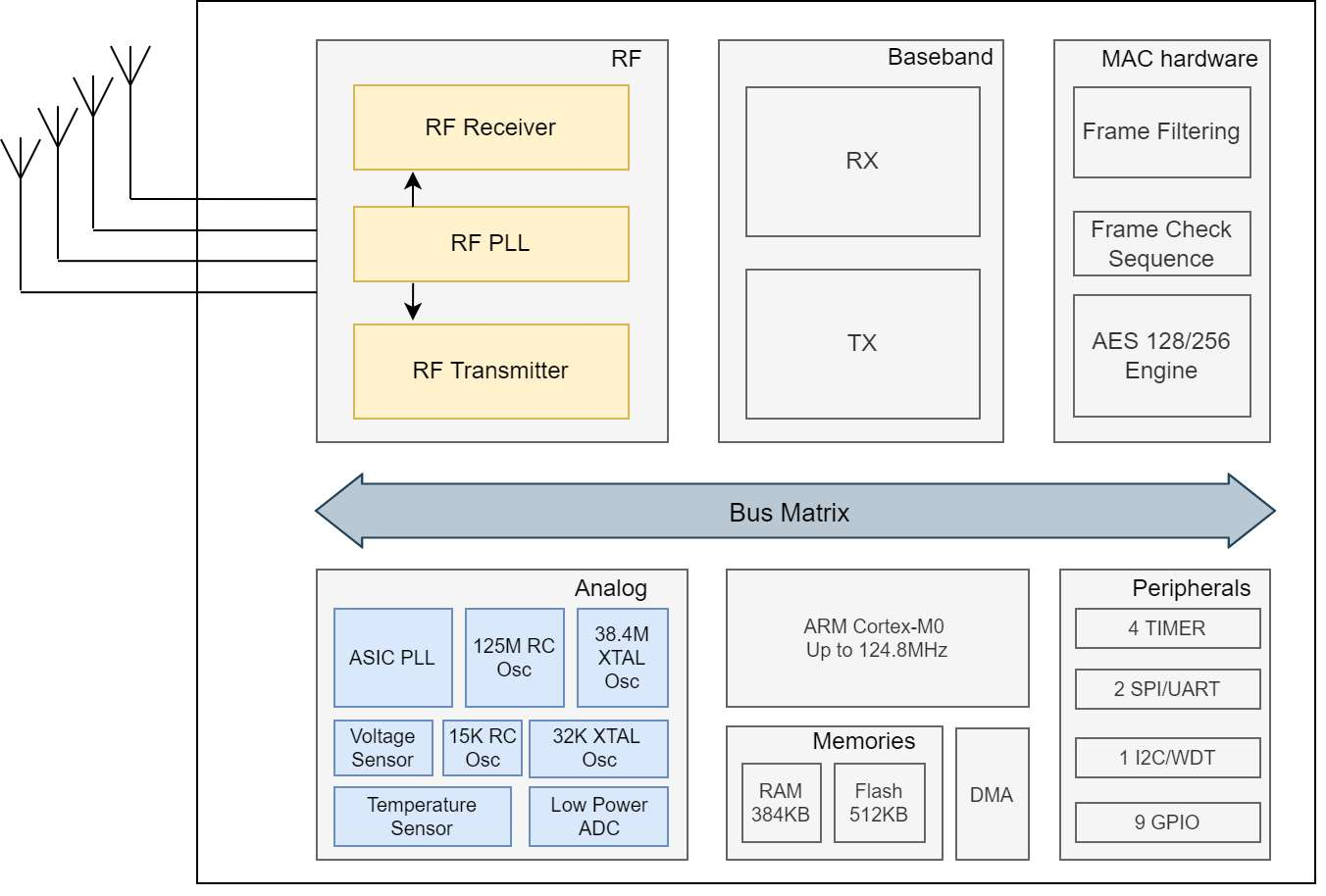

從零開始設計芯片架構

在一次公開技術分享中,Groq CEO Ross 透露, Groq 芯片的架構從頭開始設計的,其中包含數千個并行處理推理查詢的多線程處理器。每個芯片周圍都有一個獨特的、確定性的數據流架構,可最大限度地提高吞吐量,同時最大限度地減少延遲和功耗。

Groq 的 TSP 處理器繞過了造成時序不可預測性的緩存和控制邏輯。相反,結果按照軟件定義的序列直接從一個執行單元流向下一個執行單元,從輸入到輸出僅花費幾微秒。

對于大規模部署,GroqNode 服務器提供機架就緒的可擴展計算系統。GroqNode 是八個 GroqCard 加速器組,在 4U 服務器機箱中具有集成芯片到芯片連接以及雙服務器級 CPU 和高達 1 TB 的 DRAM。GroqNode 旨在實現大型深度學習模型的高性能和低延遲部署。

最后,對于數據中心部署,GroqRacks 提供了可擴展的加速器網絡。GroqRack 結合了 8 個 GroqNode 集的功能,具有多達 64 個互連芯片。其結果是一個確定性網絡,單個機架的端到端延遲僅為 1.6 微秒,非常適合海量工作負載,并且旨在擴展到整個數據中心。

在面對面的基準測試中,與基于 GPU 的大型語言模型推理系統相比,Groq 系統的延遲時間提高了 100 倍,而成本僅為 1/5。當 GPU 性能受到批處理要求和內存層次結構的影響時,Groq 的架構是從頭開始構建的,以最大限度地減少單個查詢的延遲。

通過消除昂貴的數據移動,GroqChips 僅消耗幾瓦的功率,而不是像 GPU 那樣消耗數百瓦的功率。這使得能源效率提高了 10 倍,這對于控制爆炸式增長的 AI 計算成本至關重要。

值得注意的是,Groq 自稱“第一個語言處理單元 (LPU) 的創建者”。它的核心壁壘在于其獨特的 LPU 推理引擎,LPU 代表語言處理單元,這是一種新型的端到端處理單元系統,可為具有順序組件的計算密集型應用程序提供最快的推理,例如人工智能大語言模型。

Groq 一直在強調,LPU 解決了大語言模型的兩個瓶頸:計算密度和內存帶寬。就大語言模型而言,LPU 比 GPU 和 CPU 具有更大的計算能力。這減少了每個單詞的計算時間,從而可以更快地生成文本序列。此外,消除外部內存瓶頸使 LPU 推理引擎能夠在大語言模型上提供比 GPU 好幾個數量級的性能。

根據推特上與 Groq 關系密切的投資人 k_zeroS 分享,LPU 的工作原理與 GPU 截然不同。它采用了時序指令集計算機(Temporal Instruction Set Computer)架構,這意味著它無需像使用高帶寬存儲器(HBM)的 GPU 那樣頻繁地從內存中加載數據。這一特點不僅有助于避免 HBM 短缺的問題,還能有效降低成本。

與傳統 GPU、GPU、TPU 相比,Groq 的 LPU 也有其自身優勢。

一直以來,使用現有架構并連接許多 CPU 解決了訓練挑戰。人工智能推理要困難得多,因為它是實時的、對延遲敏感的,并且需要高性能和高效率。

隨著時間的推移,CPU 變得越來越大、越來越復雜,具有多個內核、多個線程、片上網絡和控制電路。負責加速軟件性能和輸出的開發人員必須處理復雜的編程模型、安全問題以及由于處理抽象層而導致編譯器控制可見性的喪失。簡而言之,標準計算架構具有不提供推理性能優勢的硬件功能和元素。

GPU 架構專為 DRAM 帶寬而設計,并構建在多數據或多任務固定結構處理引擎上。GPU 執行大規模并行處理任務,但存在內存訪問延遲,而 ML 已經突破了外部內存帶寬的限制。

不同于英偉達 GPU 需要依賴高速數據傳輸,Groq 的 LPU 在其系統中沒有采用高帶寬存儲器(HBM)。它使用的是 SRAM,其速度比 GPU 所用的存儲器快約 20 倍。

鑒于 AI 的推理計算相較于模型訓練需要的數據量遠小,Groq 的 LPU 因此更節能。在執行推理任務時,它從外部內存讀取的數據更少,消耗的電量也低于英偉達的 GPU。

如果在 AI 處理場景中采用 Groq 的 LPU,可能就無需為英偉達 GPU 配置特殊的存儲解決方案。LPU 并不像 GPU 那樣對存儲速度有極高要求。Groq 公司宣稱,其技術能夠通過其強大的芯片和軟件,在 AI 任務中取代 GPU 的角色。

編譯器是重要基石

在編譯器部分,Groq 也做了大量創新。Jonathan Ross 堅持將編譯器作為公司技術能力的基石,因此設計團隊在做芯片的前六個月的時間里專注于設計和構建編譯器。只有在團隊對編譯器感到滿意后,才開始研究芯片架構。

與傳統編譯器不同,Groq 不依賴內核或手動干預。通過編譯器和硬件的軟件優先協同設計方法,Groq 構建了編譯器,自動將模型直接映射到底層架構。自動編譯過程允許編譯器優化硬件上的模型執行,而無需手動開發或調整內核。

該編譯器還可以輕松添加資源和擴展。到目前為止,Groq 已經使用剛剛描述的自動化流程編譯了 500 多個用于實驗目的的 AI 模型。

當 Groq 將客戶的工作負載從 GPU 移植到 Groq LPU 時,第一步是刪除針對 GPU 的不可移植的供應商特定內核,然后刪除任何手動并行或內存語義。當所有非必要的內容都被剝離后,剩下的代碼會變得更加簡單和優雅。

目前,在 Groq 網站上,用戶可以隨意測試不同的聊天機器人,并查看它們在 Groq LPU 上的運行速度。感興趣的朋友可以點擊嘗試:https://groq.com/

Groq 為何備受關注?

Groq/Grok 這個詞來自 Robert Heinlein 于 1961 年創作的科幻小說《異鄉異客》(Stranger in a Strange Land),本身的意思是“深刻而直觀地理解”。也許正是為了達成這樣的效果,眾多 AI 廠商才爭相用它來形容自己的 AI 產品。

那么,Groq 為何能在短期內獲得如此大的關注?

有分析認為,之所以備受關注,原因主要有三點:其一,是 Groq 在架構和編譯器上的創新(上文已經詳解,不再贅述);其二,是谷歌芯片大佬光環加持;其三,是 Groq LPU 的出現有望使客戶擺脫硬件的鎖定。

2016 年底,Jonathon Ross 從谷歌離職創辦了 Groq,希望能為 AI 和 HPC 工作負載提供毫不妥協的低延遲和高性能。Ross 此前發明了驅動谷歌機器學習(ML)軟件的張量處理單元(TPU),這兩項技術為當時紅極一時的 AlphaGo 提供了重要的技術支撐。當時,谷歌的這支工程團隊在大約 14 個月內就完成了第一代 TPU,因此被外界認為是一支技術實力超群的技術團隊。

就在那一年,這支技術實力超強的谷歌 TPU 團隊中的前 10 名成員中有 8 名成員跟隨 Ross 離開了谷歌。

2017 年,這家初創公司從風險投資家 Chamath Palihapitiya 那里獲得了 1030 萬美元的資金,公司最近還聘請了 Xilinx 銷售副總裁 Krishna Rangasayee 擔任首席運營官。

這個神秘的團隊在成立后的三年時間里幾乎從社交媒體中“隱身”,沒有過多關于公司的消息爆出。直到 2019 年 10 月,Groq 發布了一篇名為《世界,認識 Groq》的博客,向世界宣告了自己的存在。

此后的時間里,Groq 打造出了名為語言處理單元(LPU)的 AI 芯片,并向外界放出消息稱其速度已經超越了英偉達的圖形處理單元(GPU)。換句話說,從早期結果來看,LPU 的確有希望擊敗已經在 AI 模型領域成為行業標準的英偉達 GPU。

迄今為止,Groq 已從頂級風險投資公司獲得了約 3.62 億美元的資金。

據 Ross 介紹,Groq 的軟件定義架構提供了更大的靈活性,有望幫助客戶擺脫傳統硬件解決方案中將用戶鎖定在特定于供應商的框架(例如 CUDA 和英偉達生態系統)中的處境。

正如 Ross 所描述的,“我們的編譯器會自動執行此操作。因此,您可以在其中放入一行 groq.it,然后將模型放在括號中,就這樣了。” 這種便攜式方法允許使用 PyTorch 等標準框架訓練的模型無需修改即可在 Groq 系統上高效運行。

通過避免專有接口,Groq 能夠與最新出現的機器學習創新兼容,而不需要模型轉換。因此,Groq 的平臺設計旨在防止當今困擾許多 GPU 部署的硬件鎖定問題。對于平衡新興需求與遺留約束的開發團隊來說,Groq 的靈活性提供了一條前進的道路。

盡管 Groq 贏得了一波廣泛關注,但其 AI 芯片是否真能與英偉達 GPU 或者谷歌 TPU 在計算性能和可擴展性上正面對抗仍然有待觀察。

英偉達的霸主地位, 短期內誰都撼動不了

在近期 Groq 攻占各大科技媒體頭條板塊之時,老牌 AI 芯片霸主英偉達剛剛公布了去年第四季度財報。

據英偉達最新財報顯示,截至 2024 年 1 月 28 日,2024 財年第四季度收入達到 221 億美元,環比增長 22%,同比增長 265%,凈利潤為 122.85 億美元,同比增長 769%。值得一提的是,英偉達單季度收入甚至已高于 2021 年全年。這一增長主要得益于人工智能技術的快速發展,特別是在加速計算和生成式 AI 領域。

受此影響,該公司股價在美股盤后一度大漲 10%。英偉達 CEO 黃仁勛表示,加速計算和生成式人工智能已經達到了引爆點,全球各個公司、行業和國家的需求都在飆升。

多年來,通過巧妙的收購、內部硬件 / 軟件開發和戰略聯盟,以及利用 ChatGPT 發布所引發的生成式 AI 熱潮,英偉達以壓倒性優勢牢牢占領了芯片霸主地位。無論是全行業的芯片短缺,還是其擬斥資 400 億美元收購芯片競爭對手 Arm 的失敗,都沒有對英偉達的驚人增長產生任何明顯影響。

“一個新的計算時代已經開始。世界各地的公司正在從通用計算向加速計算和生成式人工智能轉型。”英偉達創始人兼首席執行官黃仁勛在公司財報中表示。

每家芯片公司都把英偉達列為了一個巨大的目標,如今,Groq 似乎距離趕超英偉達這一目標更近了些。

審核編輯:劉清

-

人工智能

+關注

關注

1807文章

49028瀏覽量

249548 -

GPU芯片

+關注

關注

1文章

305瀏覽量

6205 -

聊天機器人

+關注

關注

0文章

348瀏覽量

12800 -

ChatGPT

+關注

關注

29文章

1590瀏覽量

9106

原文標題:賈揚清質疑 Groq CEO “其芯片價格接近免費”說法,前員工出來實錘:根本不切實際!

文章出處:【微信號:AI前線,微信公眾號:AI前線】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

PCBA貼片價格“水很深”?七大核心要素拆解,幫你避開成本陷阱!

VirtualLab Fusion應用:多反射系統的非序列建模

揚我國威 興旺中華—專訪YXC揚興科技蔡欽洪先生

集成電路制造工藝中的偽柵去除技術介紹

賈揚清質疑Groq CEO“其芯片價格接近免費” 前員工:不切實際!

賈揚清質疑Groq CEO“其芯片價格接近免費” 前員工:不切實際!

評論