GPU在人工智能中相當(dāng)于稀土金屬,甚至黃金,它們在當(dāng)今生成式人工智能時(shí)代中的作用不可或缺。那么,為什么GPU在人工智能發(fā)展中如此重要呢?

什么是GPU

圖形處理器(GPU)是一種通常用于進(jìn)行快速數(shù)學(xué)計(jì)算來渲染圖形和圖像的計(jì)算機(jī)芯片專業(yè)和個(gè)人計(jì)算。最初,GPU負(fù)責(zé)渲染2D和3D圖像、動(dòng)畫和視頻,但現(xiàn)在它們的應(yīng)用范圍更廣,尤其在人工智能領(lǐng)域。

GPU應(yīng)用

具有嵌入式或離散GPU的電子設(shè)備能夠流暢地渲染3D圖形和視頻內(nèi)容,非常適用于人工智能視覺應(yīng)用。現(xiàn)代可編程GPU也適用于更廣泛的場景,一些常見應(yīng)用包括:加速實(shí)時(shí)2D和3D圖形應(yīng)用的渲染;視頻編輯和視頻內(nèi)容創(chuàng)建,視頻游戲圖形,加速圖像識(shí)別、面部檢測和識(shí)別等機(jī)器學(xué)習(xí)應(yīng)用,訓(xùn)練深度學(xué)習(xí)神經(jīng)網(wǎng)絡(luò)。

GPU如何工作

GPU通過使用并行處理的方法工作,多個(gè)處理器處理單個(gè)任務(wù)的不同部分。GPU還有單獨(dú)的內(nèi)存用于存儲(chǔ)正在處理的數(shù)據(jù)。這種內(nèi)存專門設(shè)計(jì)用于容納大量的信息,以應(yīng)對高度密集的圖形使用情況。

對于圖形應(yīng)用程序,CPU向GPU發(fā)送指令以在屏幕上繪制圖形內(nèi)容。GPU以并行和高速的方式執(zhí)行指令,將內(nèi)容顯示在設(shè)備上,這個(gè)過程被稱為圖形或渲染流水線。

GPU與CPU:哪個(gè)更適合人工智能?

GPU包含數(shù)百個(gè)或數(shù)千個(gè)核心,其晶體管比CPU還多,可以進(jìn)行并行計(jì)算和快速的圖形輸出。

由于其更快的時(shí)鐘速度和較少的核心,CPU更適合處理日常的單線程任務(wù),而不是人工智能工作負(fù)載。而GPU則處理更復(fù)雜的數(shù)學(xué)和幾何計(jì)算。這意味著GPU在人工智能訓(xùn)練和推理方面能夠提供更高的性能,同時(shí)也可以受益于各種加速計(jì)算負(fù)載。

為什么GPU對于當(dāng)今的人工智能如此重要?

在人工智能領(lǐng)域,GPU發(fā)揮著重要作用,為人工智能的訓(xùn)練和推理提供了出色的性能,在需要加速計(jì)算的各種應(yīng)用中也提供了顯著的優(yōu)勢。

GPU的關(guān)鍵功能有3個(gè):

GPU并行處理

人工智能模型主要由層層疊加的線性代數(shù)方程組成。每個(gè)方程反映了一組數(shù)據(jù)與另一組數(shù)據(jù)之間的關(guān)聯(lián)可能性。GPU包含數(shù)千個(gè)核心,這些微小的計(jì)算器并行工作,分片處理構(gòu)成人工智能模型的計(jì)算,為人工智能工作負(fù)載提供高效的計(jì)算能力。此外,GPU核心不斷升級(jí)以滿足人工智能模型的不斷變化需求。

模型復(fù)雜性和系統(tǒng)擴(kuò)展

人工智能模型的復(fù)雜性以每年10倍的速度增長。前沿大型語言模型(LLM)GPT-4包含超過一萬億個(gè)參數(shù),其數(shù)學(xué)密度令人矚目。GPU系統(tǒng)通過有效的協(xié)作巧妙地應(yīng)對了這一挑戰(zhàn)。它們輕松擴(kuò)展到超級(jí)計(jì)算級(jí)別,利用快速的NVLink互連和強(qiáng)大的Quantum InfiniBand網(wǎng)絡(luò)。

廣泛而深入的GPU軟件堆棧

自2007年以來,不斷擴(kuò)大的英偉達(dá)(NVIDIA) GPU軟件已經(jīng)涵蓋了人工智能的各個(gè)方面,從高級(jí)功能到高級(jí)應(yīng)用。CUDA編程語言和cuDNN-X深度學(xué)習(xí)庫為開發(fā)人員構(gòu)建軟件提供了基礎(chǔ),例如NVIDIA NeMo。它使用戶能夠創(chuàng)建、配置和推理自己的生成式人工智能模型。其中許多元素都可作為開源軟件提供,這對軟件開發(fā)人員來說是必不可少的。

GPU對人工智能發(fā)展的貢獻(xiàn)

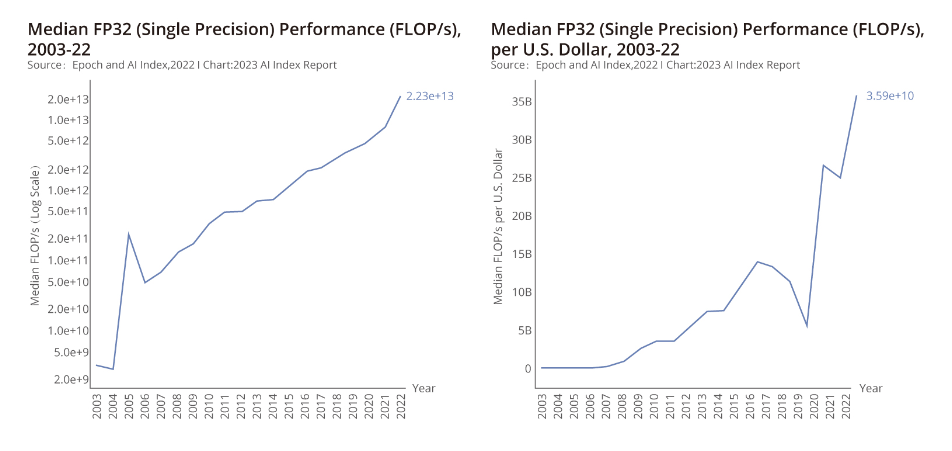

斯坦福大學(xué)人工智能小組的報(bào)告強(qiáng)調(diào)自2003年以來GPU性能的迅速提升,性能提高7000倍,而性價(jià)比提高5600倍。GPU已經(jīng)成為加速機(jī)器學(xué)習(xí)工作負(fù)載的主要計(jì)算平臺(tái),在近年來顯著促進(jìn)了人工智能的進(jìn)步。值得注意的是,在過去5年中,主要的人工智能模型都是在GPU上進(jìn)行訓(xùn)練的,例如ChatGPT的成功,它是一個(gè)為超過1億用戶提供服務(wù)的大型語言模型。

GPU在人工智能領(lǐng)域的廣闊前景

人工智能對全球經(jīng)濟(jì)的預(yù)期影響巨大,麥肯錫預(yù)測生成式人工智能在各個(gè)領(lǐng)域每年可能貢獻(xiàn)18.7萬億至31.7萬億。在這個(gè)變革的背景下,GPU發(fā)揮著優(yōu)化性能和推動(dòng)創(chuàng)新的關(guān)鍵作用。

計(jì)算機(jī)處理器是任何計(jì)算系統(tǒng)中至關(guān)重要的組件。在這個(gè)數(shù)字時(shí)代,了解CPU、GPU、ASIC和FPGA之間的區(qū)別對于優(yōu)化整體性能至關(guān)重要。飛速(FS)將深入探討CPU、GPU、ASIC和FPGA之間的區(qū)別,以增強(qiáng)您的技術(shù)知識(shí),并決定如何選擇合適的處理器。

CPU, GPU,ASIC,和FPGA對比分析

CPU、GPU、ASIC和FPGA是四種計(jì)算機(jī)處理器類型,在任何計(jì)算系統(tǒng)中都起著至關(guān)重要的作用,并且對整體性能有著顯著影響。每種處理器類型(CPU、GPU、ASIC和FPGA)都具有其獨(dú)特的優(yōu)勢,為提供高效和有效的計(jì)算解決方案做出了自己的貢獻(xiàn)。

CPU(中央處理器)

CPU是應(yīng)用于設(shè)備(如計(jì)算機(jī)、手機(jī)、電視等)中的主要芯片。其主要功能是在集成到主板中的各個(gè)組件之間傳播指令。技術(shù)原理:通過協(xié)調(diào)和管理計(jì)算機(jī)系統(tǒng)中的各個(gè)元素,CPU執(zhí)行指令并處理數(shù)據(jù),完成各種復(fù)雜的計(jì)算和任務(wù)管理。應(yīng)用場景:CPU專為各種電子設(shè)備設(shè)計(jì),包括計(jì)算機(jī)和智能手機(jī),作為核心計(jì)算單元負(fù)責(zé)執(zhí)行各種軟件和應(yīng)用任務(wù)。此外,它對外部外設(shè)(如鍵盤和鼠標(biāo))與設(shè)備的交互具有重要控制作用。

區(qū)別:CPU是一種通用處理器,能夠處理各種任務(wù)。然而,這種通用性其性能可能不如其他專用芯片那樣專業(yè)。

GPU(圖形處理器)

GPU,通常被稱為顯卡,旨在高效處理圖形并將其渲染到屏幕上。它是一種高度專業(yè)化的工具。隨著計(jì)算機(jī)能力的提升,GPU的應(yīng)用范圍已經(jīng)從圖形擴(kuò)展到通用計(jì)算任務(wù)。技術(shù)原理:利用其強(qiáng)大的并行處理架構(gòu),能夠同時(shí)執(zhí)行大量計(jì)算,處理大量圖像和圖形數(shù)據(jù),實(shí)現(xiàn)快速渲染和處理圖形,提供更出色的視覺體驗(yàn)。應(yīng)用場景:適用于需要圖形加速的任務(wù),如游戲、虛擬現(xiàn)實(shí)、3D建模等,以提供更流暢和逼真的視覺效果。近年來,GPU在人工智能、計(jì)算機(jī)視覺和超級(jí)計(jì)算等領(lǐng)域發(fā)揮著重要作用。

區(qū)別:GPU具有強(qiáng)大的圖形處理能力,能夠執(zhí)行大量簡單的計(jì)算。由于其架構(gòu)的限制,它無法取代CPU,但可以與CPU共同工作。

ASIC(專用集成電路)

ASIC是一種專為特定邏輯功能而設(shè)計(jì)的硅芯片,因此在性能和速度上相對于通用處理器具有優(yōu)勢,但不能快速適應(yīng)執(zhí)行其他任務(wù)。

技術(shù)原理:通過將特定算法和功能轉(zhuǎn)化為硬件,實(shí)現(xiàn)高效、高性能、低功耗的計(jì)算加速,需要根據(jù)具體應(yīng)用進(jìn)行硬件設(shè)計(jì)和優(yōu)化。

應(yīng)用場景:適用于對性能和功耗有嚴(yán)格要求的應(yīng)用,包括數(shù)據(jù)中心和人工智能推斷等領(lǐng)域。

區(qū)別:ASIC對于特定任務(wù)非常高效,但不能像CPU和GPU那樣用于通用計(jì)算。ASIC的計(jì)算能力消耗較少的功耗、體積較小,且易于安裝。

FPGA(現(xiàn)場可編程門陣列)

FPGA也是一種基于硅的半導(dǎo)體,但其架構(gòu)與其他處理器不同,依靠一組可配置的邏輯塊(CLB)通過可編程互連,F(xiàn)PGA可以重新編程以執(zhí)行多個(gè)任務(wù),使同一硬件可以在不同的項(xiàng)目中使用。技術(shù)原理:FPGA可以通過可編程邏輯單元和互連實(shí)現(xiàn)多種邏輯功能和計(jì)算加速。它們具有根據(jù)特定要求進(jìn)行配置和編程的能力,能夠適應(yīng)實(shí)際需求。應(yīng)用場景:FPGA適用于需要靈活性和可重配置性的場景,如通信設(shè)備和圖像處理,可以快速適應(yīng)不同的算法和任務(wù)需求。

區(qū)別:與ASIC相比,F(xiàn)PGA在靈活性方面具有明顯優(yōu)勢。然而,由于其增加的復(fù)雜性,F(xiàn)PGA通常需求功耗較高,因此不太適合對能源效率或極端便攜性要求嚴(yán)格的項(xiàng)目。

怎樣選擇CPU, GPU,ASIC,和FPGA

在選擇滿足計(jì)算需求的處理器時(shí),有多種選擇:

CPU(通常在日常設(shè)備中使用的處理器)提供可靠的性能,功耗相對較低。

由于其出色的計(jì)算能力,GPU的應(yīng)用主要集中在大規(guī)模擴(kuò)展計(jì)算能力的高性能計(jì)算上,未來將深入到人工智能計(jì)算(AIGPU)領(lǐng)域。

ASIC表現(xiàn)出色,但專注于單一任務(wù)。ASIC在人工智能深度學(xué)習(xí)領(lǐng)域并沒有得到廣泛應(yīng)用。在比特幣挖礦領(lǐng)域,它展現(xiàn)了其高計(jì)算能力,低功耗,低價(jià)格和強(qiáng)大的專用性。谷歌最近發(fā)布專門用于人工智能深度學(xué)習(xí)計(jì)算的TPU,實(shí)際上也是一種ASIC。

與ASIC相比,F(xiàn)PGA具有更大的靈活性,但需要更高的功耗。GPU專為圖形處理而設(shè)計(jì),由于其強(qiáng)大的并行處理架構(gòu),在通用計(jì)算任務(wù)中表現(xiàn)出色。

來源:架構(gòu)師技術(shù)聯(lián)盟

-

gpu

+關(guān)注

關(guān)注

28文章

4921瀏覽量

130812 -

AI

+關(guān)注

關(guān)注

88文章

34588瀏覽量

276175 -

人工智能

+關(guān)注

關(guān)注

1805文章

48843瀏覽量

247408

發(fā)布評(píng)論請先 登錄

搭建萬卡GPU集群,小米AI大模型即將全力啟動(dòng)

摩爾線程GPU原生FP8計(jì)算助力AI訓(xùn)練

從圖形處理到AI加速,一文看懂Imagination D系列GPU

當(dāng)我問DeepSeek AI爆發(fā)時(shí)代的FPGA是否重要?答案是......

GPU按需計(jì)費(fèi)的優(yōu)勢

NVIDIA和GeForce RTX GPU專為AI時(shí)代打造

小米加速布局AI大模型,搭建GPU萬卡集群

GPU是如何訓(xùn)練AI大模型的

絕緣電阻測試的基礎(chǔ)以及為什么它如此重要

《算力芯片 高性能 CPUGPUNPU 微架構(gòu)分析》第3篇閱讀心得:GPU革命:從圖形引擎到AI加速器的蛻變

GPU服務(wù)器AI網(wǎng)絡(luò)架構(gòu)設(shè)計(jì)

為什么GPU對AI如此重要?

為什么GPU對AI如此重要?

評(píng)論