神經網絡是一種強大的機器學習模型,廣泛應用于各種分類任務。在本文中,我們將詳細介紹幾種適合分類任務的神經網絡模型,包括前饋神經網絡、卷積神經網絡、循環神經網絡、深度信念網絡和長短期記憶網絡等。

- 前饋神經網絡(Feedforward Neural Networks)

前饋神經網絡是一種最基本的神經網絡結構,由輸入層、隱藏層和輸出層組成。每個神經元接收前一層神經元的輸出作為輸入,并通過激活函數生成輸出,傳遞給下一層神經元。前饋神經網絡的訓練過程通常使用反向傳播算法和梯度下降法。

前饋神經網絡的優點是結構簡單,易于實現和訓練。然而,它在處理復雜的分類任務時可能表現不佳,因為它不能很好地捕捉數據的非線性特征。

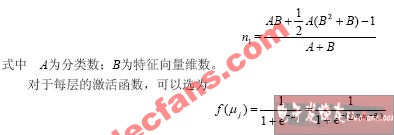

1.1 多層感知器(Multilayer Perceptron, MLP)

多層感知器是一種包含多個隱藏層的前饋神經網絡。通過增加隱藏層的數量,多層感知器可以更好地捕捉數據的非線性特征,提高分類性能。然而,過多的隱藏層可能導致過擬合問題。

1.2 徑向基函數神經網絡(Radial Basis Function Neural Networks, RBFNN)

徑向基函數神經網絡是一種特殊的前饋神經網絡,其隱藏層神經元使用徑向基函數作為激活函數。徑向基函數可以捕捉數據的局部特征,使得RBFNN在處理高維數據時具有較好的泛化能力。

- 卷積神經網絡(Convolutional Neural Networks, CNN)

卷積神經網絡是一種針對圖像數據設計的神經網絡結構,由卷積層、池化層和全連接層組成。卷積層通過卷積操作提取圖像的局部特征,池化層對特征進行降維處理,全連接層則用于分類任務。

卷積神經網絡的優點是可以自動學習圖像的局部特征,減少參數數量,提高計算效率。此外,卷積神經網絡在圖像分類任務中表現出色,已成為圖像識別領域的主流模型。

2.1 AlexNet

AlexNet是一種深度卷積神經網絡,由5個卷積層和3個全連接層組成。AlexNet在2012年的ImageNet競賽中取得了突破性的成績,開啟了深度學習在計算機視覺領域的應用。

2.2 VGGNet

VGGNet是一種使用更小的卷積核和更深的網絡結構的卷積神經網絡。VGGNet通過重復使用3x3的卷積核和2x2的池化操作,實現了更深的網絡結構,提高了分類性能。

2.3 ResNet

ResNet是一種引入殘差連接的卷積神經網絡,可以解決深度網絡訓練中的梯度消失問題。ResNet通過添加跳躍連接,使得網絡可以學習到更深層次的特征,提高了分類性能。

- 循環神經網絡(Recurrent Neural Networks, RNN)

循環神經網絡是一種適合處理序列數據的神經網絡結構,由循環單元組成。循環單元可以存儲和傳遞前一個時間步的信息,使得RNN可以捕捉序列數據的時間依賴性。

循環神經網絡的優點是可以處理序列數據,適用于自然語言處理、語音識別等領域。然而,RNN在處理長序列數據時可能遇到梯度消失或梯度爆炸的問題。

3.1 長短期記憶網絡(Long Short-Term Memory, LSTM)

長短期記憶網絡是一種改進的循環神經網絡,通過引入門控機制解決了梯度消失問題。LSTM通過輸入門、遺忘門和輸出門控制信息的流動,使得網絡可以學習到長序列數據的特征。

3.2 門控循環單元(Gated Recurrent Unit, GRU)

門控循環單元是一種與LSTM類似的循環神經網絡,通過引入更新門和重置門控制信息的流動。GRU的結構相對簡單,但在某些任務中可以與LSTM相媲美。

- 深度信念網絡(Deep Belief Networks, DBN)

深度信念網絡是一種由多層受限玻爾茲曼機(RBM)堆疊而成的神經網絡結構。DBN可以通過無監督預訓練的方式學習數據的層次特征,然后通過有監督微調的方式進行分類任務。

深度信念網絡的優點是可以通過無監督預訓練提高模型的泛化能力,適用于數據量較小的任務。然而,DBN的訓練過程較為復雜,且在某些任務中可能不如其他神經網絡模型。

- 長短期記憶網絡(Long Short-Term Memory, LSTM)

長短期記憶網絡是一種特殊的循環神經網絡,通過引入門控機制解決了梯度消失問題。LSTM在處理序列數據時具有較好的性能,已被廣泛應用于自然語言處理、語音識別等領域。

-

非線性

+關注

關注

1文章

214瀏覽量

23340 -

函數

+關注

關注

3文章

4362瀏覽量

63695 -

神經網絡模型

+關注

關注

0文章

24瀏覽量

5696 -

神經元

+關注

關注

1文章

368瀏覽量

18684

發布評論請先 登錄

相關推薦

什么神經網絡模型適合做分類

什么神經網絡模型適合做分類

評論