卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks,簡稱CNN)是一種深度學(xué)習(xí)模型,廣泛應(yīng)用于圖像識(shí)別、視頻分析、自然語言處理等領(lǐng)域。本文將詳細(xì)介紹卷積神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)原理、結(jié)構(gòu)、訓(xùn)練過程以及應(yīng)用場(chǎng)景。

- 卷積神經(jīng)網(wǎng)絡(luò)的基本原理

1.1 卷積操作

卷積神經(jīng)網(wǎng)絡(luò)的核心是卷積操作。卷積操作是一種數(shù)學(xué)運(yùn)算,用于提取輸入數(shù)據(jù)的特征。在圖像處理中,卷積操作通常用于提取圖像的局部特征,如邊緣、紋理等。

假設(shè)輸入數(shù)據(jù)為一個(gè)二維矩陣,卷積核(或濾波器)是一個(gè)較小的二維矩陣。卷積操作的過程如下:

- 將卷積核覆蓋在輸入矩陣的左上角。

- 計(jì)算卷積核和輸入矩陣覆蓋區(qū)域的元素對(duì)應(yīng)相乘后的和。

- 將卷積核向右滑動(dòng)一個(gè)元素,重復(fù)步驟2,直到覆蓋整個(gè)輸入矩陣的一行。

- 將卷積核向下滑動(dòng)一個(gè)元素,重復(fù)步驟2和3,直到覆蓋整個(gè)輸入矩陣。

1.2 激活函數(shù)

卷積操作后,通常會(huì)使用激活函數(shù)對(duì)結(jié)果進(jìn)行非線性變換。常見的激活函數(shù)有ReLU(Rectified Linear Unit)、Sigmoid、Tanh等。ReLU函數(shù)因其計(jì)算簡單、訓(xùn)練速度快等優(yōu)點(diǎn),在卷積神經(jīng)網(wǎng)絡(luò)中被廣泛使用。

1.3 池化操作

池化操作(Pooling)用于降低卷積層輸出的空間維度,減少計(jì)算量,同時(shí)使特征檢測(cè)更加魯棒。常見的池化操作有最大池化(Max Pooling)和平均池化(Average Pooling)。最大池化操作是取輸入矩陣中覆蓋區(qū)域的最大值,平均池化操作是取輸入矩陣中覆蓋區(qū)域的平均值。

- 卷積神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)

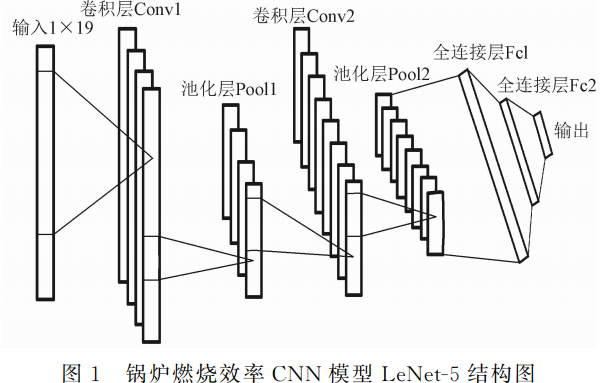

2.1 卷積層

卷積層是卷積神經(jīng)網(wǎng)絡(luò)的基本單元,由多個(gè)卷積核組成。每個(gè)卷積核負(fù)責(zé)提取輸入數(shù)據(jù)的一種特征。卷積層的輸出稱為特征圖(Feature Map)。

2.2 池化層

池化層對(duì)卷積層的輸出進(jìn)行降維處理,減少計(jì)算量,提高特征檢測(cè)的魯棒性。

2.3 全連接層

全連接層是卷積神經(jīng)網(wǎng)絡(luò)的最后一層,用于將特征圖轉(zhuǎn)換為最終的輸出結(jié)果。全連接層的神經(jīng)元數(shù)量通常與分類任務(wù)的類別數(shù)相同。

2.4 歸一化層

歸一化層用于調(diào)整卷積層輸出的數(shù)值范圍,使其在訓(xùn)練過程中更穩(wěn)定。常見的歸一化方法有批量歸一化(Batch Normalization)和局部響應(yīng)歸一化(Local Response Normalization)。

- 卷積神經(jīng)網(wǎng)絡(luò)的訓(xùn)練過程

3.1 數(shù)據(jù)預(yù)處理

在訓(xùn)練卷積神經(jīng)網(wǎng)絡(luò)之前,需要對(duì)輸入數(shù)據(jù)進(jìn)行預(yù)處理,包括歸一化、數(shù)據(jù)增強(qiáng)等操作。歸一化是將輸入數(shù)據(jù)的數(shù)值范圍調(diào)整到[0,1]或[-1,1]之間,以提高訓(xùn)練速度和模型性能。數(shù)據(jù)增強(qiáng)是通過旋轉(zhuǎn)、縮放、裁剪等操作生成更多的訓(xùn)練樣本,以提高模型的泛化能力。

3.2 損失函數(shù)

損失函數(shù)用于衡量模型預(yù)測(cè)結(jié)果與真實(shí)標(biāo)簽之間的差異。常見的損失函數(shù)有均方誤差(Mean Squared Error,MSE)、交叉熵?fù)p失(Cross-Entropy Loss)等。對(duì)于分類任務(wù),通常使用交叉熵?fù)p失。

3.3 優(yōu)化算法

優(yōu)化算法用于更新模型的參數(shù),以最小化損失函數(shù)。常見的優(yōu)化算法有梯度下降(Gradient Descent)、隨機(jī)梯度下降(Stochastic Gradient Descent,SGD)、Adam等。

3.4 反向傳播

反向傳播(Backpropagation)是一種訓(xùn)練神經(jīng)網(wǎng)絡(luò)的算法,通過計(jì)算損失函數(shù)關(guān)于模型參數(shù)的梯度,更新模型參數(shù)。在卷積神經(jīng)網(wǎng)絡(luò)中,反向傳播需要計(jì)算卷積層、激活函數(shù)、池化層等操作的梯度。

3.5 超參數(shù)調(diào)整

超參數(shù)是模型訓(xùn)練過程中需要手動(dòng)設(shè)置的參數(shù),如學(xué)習(xí)率、批大小、迭代次數(shù)等。超參數(shù)調(diào)整是提高模型性能的關(guān)鍵步驟,通常通過交叉驗(yàn)證、網(wǎng)格搜索等方法進(jìn)行。

- 卷積神經(jīng)網(wǎng)絡(luò)的應(yīng)用場(chǎng)景

4.1 圖像分類

圖像分類是卷積神經(jīng)網(wǎng)絡(luò)的典型應(yīng)用之一。通過訓(xùn)練大量標(biāo)注好的圖像數(shù)據(jù),卷積神經(jīng)網(wǎng)絡(luò)可以自動(dòng)識(shí)別圖像中的物體類別。

4.2 目標(biāo)檢測(cè)

目標(biāo)檢測(cè)是識(shí)別圖像中的目標(biāo)物體,并確定其位置。卷積神經(jīng)網(wǎng)絡(luò)可以用于實(shí)現(xiàn)目標(biāo)檢測(cè)任務(wù),如人臉檢測(cè)、行人檢測(cè)等。

-

圖像識(shí)別

+關(guān)注

關(guān)注

9文章

526瀏覽量

38937 -

模型

+關(guān)注

關(guān)注

1文章

3499瀏覽量

50081 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5555瀏覽量

122541 -

卷積神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

4文章

369瀏覽量

12216

發(fā)布評(píng)論請(qǐng)先 登錄

【飛凌嵌入式OK3576-C開發(fā)板體驗(yàn)】RKNN神經(jīng)網(wǎng)絡(luò)-車牌識(shí)別

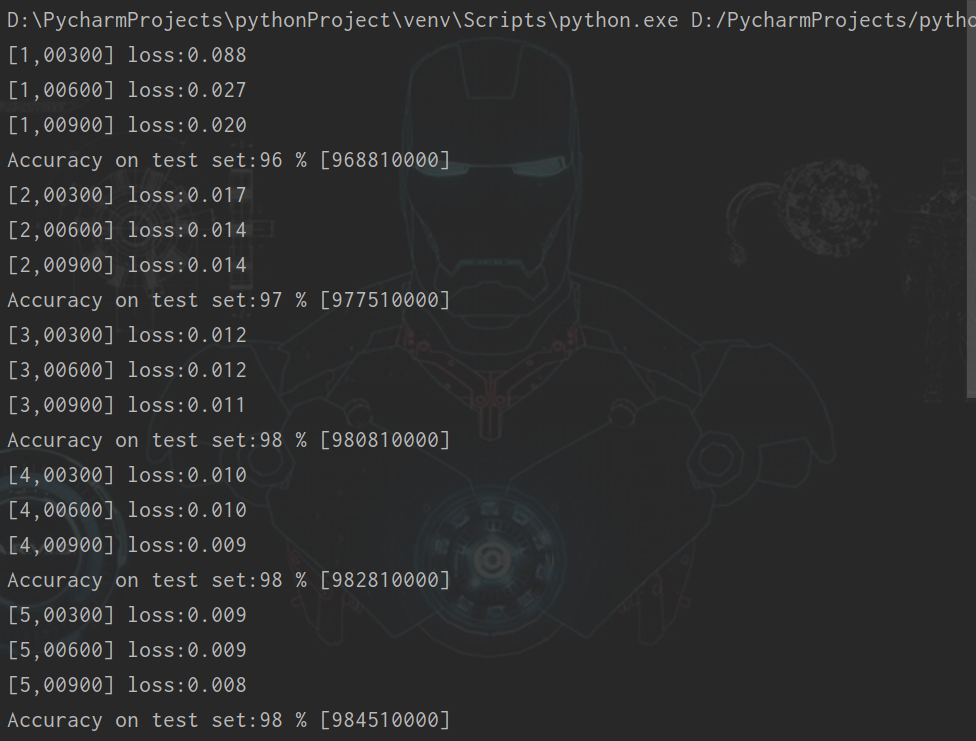

5 實(shí)例:卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)手寫數(shù)字識(shí)別(1)#神經(jīng)網(wǎng)絡(luò)

5 實(shí)例:卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)手寫數(shù)字識(shí)別(2)#神經(jīng)網(wǎng)絡(luò)

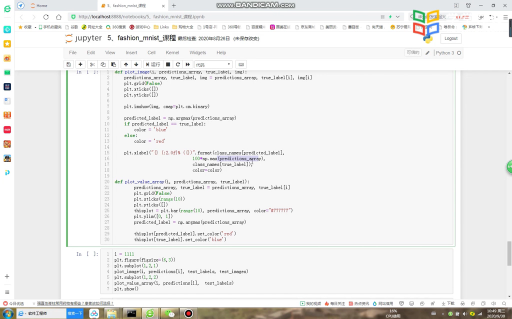

卷積神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)服飾圖片的分類(1)#計(jì)算思維與人工智能

卷積神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)服飾圖片的分類(2)#計(jì)算思維與人工智能

基于賽靈思FPGA的卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)設(shè)計(jì)

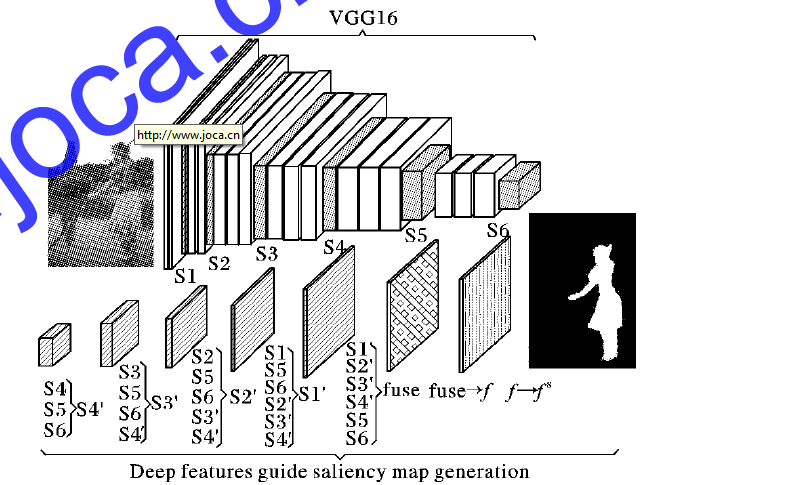

使用深度卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)深度導(dǎo)向顯著性檢測(cè)算法

如何使用卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)電站鍋爐燃燒效率建模的方法詳細(xì)說明

如何使用多尺度和多任務(wù)卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)人群計(jì)數(shù)

卷積神經(jīng)網(wǎng)絡(luò)是實(shí)現(xiàn)深度學(xué)習(xí)的重要方法之一

通過卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)MNIST數(shù)據(jù)集分類

利用卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)SAR目標(biāo)分類的研究

卷積神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)原理

卷積神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)原理

評(píng)論