問題

對比單個全連接網絡,在卷積神經網絡層的加持下,初始時,整個神經網絡模型的性能是否會更好。

方法

模型設計

兩層卷積神經網絡(包含池化層),一層全連接網絡。

-

選擇 5 x 5 的卷積核,輸入通道為 1,輸出通道為 10:

此時圖像矩陣經過 5 x 5 的卷積核后會小兩圈,也就是4個數位,變成 24 x 24,輸出通道為10;

-

選擇 2 x 2 的最大池化層:

此時圖像大小縮短一半,變成 12 x 12,通道數不變;

-

再次經過5 x 5的卷積核,輸入通道為 10,輸出通道為 20:

此時圖像再小兩圈,變成 8*8,輸出通道為20;

-

再次經過2 x 2的最大池化層:

此時圖像大小縮短一半,變成 4 x 4,通道數不變;

-

最后將圖像整型變換成向量,輸入到全連接層中:

輸入一共有 4 x 4 x 20 = 320個元素,輸出為 10.

代碼

準備數據集

準備數據集

batch_size = 64

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.1307,), (0.3081,))

])

train_dataset = datasets.MNIST(root='data’,

train=True,

download=True,

transform=transform)

train_loader = DataLoader(train_dataset,

shuffle=True,

batch_size=batch_size)

test_dataset = datasets.MNIST(root='data',

train=False,

download=True,

transform=transform)

test_loader = DataLoader(test_dataset,

shuffle=False,

batch_size=batch_size)

建立模型

class Net(torch.nn.Module):

def init (self):

super(Net, self).__init__()

self.conv1 = torch.nn.Conv2d(1, 10, kernel_size=5)

self.conv2 = torch.nn.Conv2d(10, 20, kernel_size=5)

self.pooling = torch.nn.MaxPool2d(2)

self.fc = torch.nn.Linear(320, 10)

def forward(self, x):

batch_size = x.size(0)

x = F.relu(self.pooling(self.conv1(x)))

x = F.relu(self.pooling(self.conv2(x)))

x = x.view(batch_size, -1)

x = self.fc(x)

return x

model = Net()

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

model.to(device)

構造損失函數+優化器

criterion = torch.nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.5)

訓練+測試

def train(epoch):

running_loss = 0.0

for batch_idx, data in enumerate(train_loader, 0):

inputs, target = data

inputs,target=inputs.to(device),target.to(device)

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, target)

loss.backward()

optimizer.step()

running_loss += loss.item()

if batch_idx % 300 == 299:

print('[%d,%.5d] loss:%.3f' % (epoch + 1, batch_idx + 1, running_loss / 2000))

running_loss = 0.0

def test():

correct=0

total=0

with torch.no_grad():

for data in test_loader:

inputs,target=data

inputs,target=inputs.to(device),target.to(device)

outputs=model(inputs)

_,predicted=torch.max(outputs.data,dim=1)

total+=target.size(0)

correct+=(predicted==target).sum().item()

print('Accuracy on test set:%d %% [%d%d]' %(100*correct/total,correct,total))

if name ==' main ':

for epoch in range(10):

train(epoch)

test()

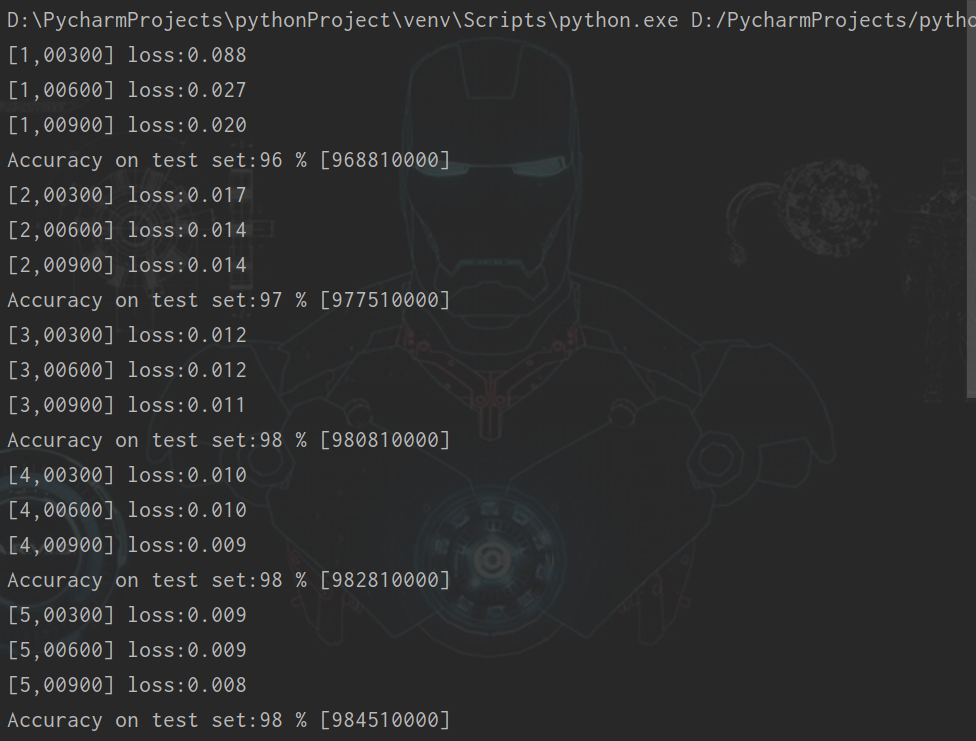

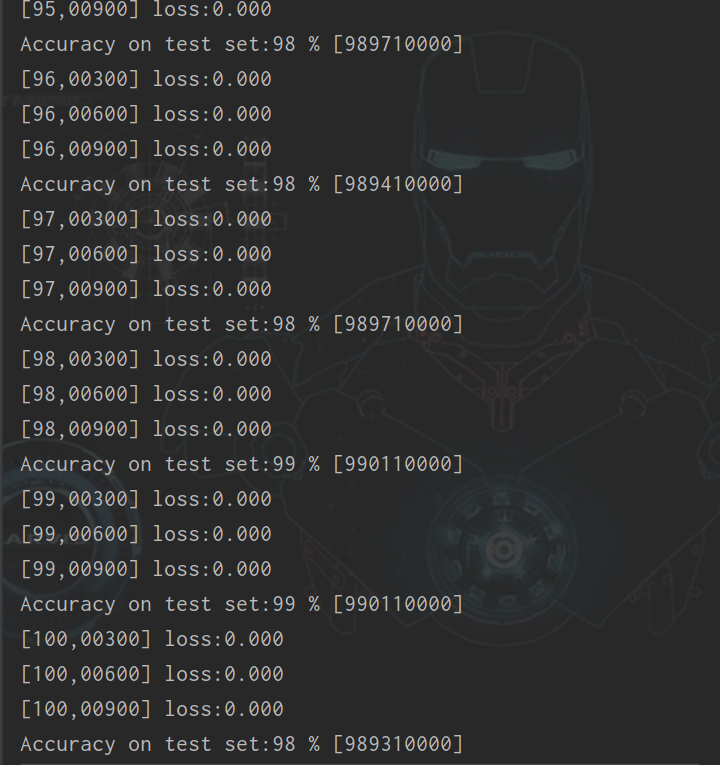

運行結果

(1)batch_size:64,訓練次數:10

(2)batch_size:128,訓練次數:10

(3)batch_size:128,訓練次數:10

結語

對比單個全連接網絡,在卷積神經網絡層的加持下,初始時,整個神經網絡模型的性能顯著提升,準確率最低為96%。在batch_size:64,訓練次數:100情況下,準確率達到99%。下一階在平均池化,3*3卷積核,以及不同通道數的情況下,探索對模型性能的影響。

-

代碼

+關注

關注

30文章

4889瀏覽量

70282 -

數據集

+關注

關注

4文章

1223瀏覽量

25284 -

卷積神經網絡

+關注

關注

4文章

369瀏覽量

12199

發布評論請先 登錄

通過卷積神經網絡實現MNIST數據集分類

通過卷積神經網絡實現MNIST數據集分類

評論