隨著物聯網(IoT)技術的飛速發展,微控制器單元(MCU)作為物聯網設備的核心處理單元,其性能和應用范圍不斷拓展。近年來,將AI深度學習技術引入MCU成為了一個熱門話題,旨在提升設備的智能化水平和自主決策能力。然而,由于MCU在資源(如計算能力、存儲空間和功耗)上的限制,這一目標的實現面臨著諸多挑戰。本文將從技術路徑、關鍵技術、挑戰應對及未來展望等方面,深入探討在MCU上實現AI深度學習的可行性、方法與前景。

一、技術路徑

1.1 模型選擇與設計

首先,針對MCU的資源限制,需要選擇或設計適合在資源受限環境下運行的深度學習模型。這通常意味著采用輕量級、高效的神經網絡架構,如MobileNet、SqueezeNet或專為嵌入式設備設計的網絡結構。在設計模型時,應優先考慮模型的復雜度、參數量、計算量以及對特定任務的適應性。

1.2 模型訓練與轉換

模型訓練通常在高性能計算平臺上進行,使用大型數據集和復雜的訓練算法。訓練完成后,需要將模型從訓練框架(如TensorFlow、PyTorch)轉換為適合MCU的格式,如TensorFlow Lite、ONNX等。這一轉換過程通常涉及模型的剪枝、量化等優化操作,以減少模型的大小和計算復雜度,同時盡量保持模型的精度。

1.3 模型部署與推理

將優化后的模型部署到MCU上,并通過MCU的處理器進行推理。這一過程需要確保模型能夠在MCU的有限資源下穩定運行,并滿足實時性要求。為了提高推理效率,可以使用專門的推理引擎或庫,如TensorFlow Lite Micro、CMSIS-NN等,這些工具針對MCU進行了優化,能夠提供更高效的推理能力。

二、關鍵技術

2.1 模型量化

模型量化是減少模型大小和計算復雜度的重要手段之一。通過將模型的權重和激活值從浮點數轉換為定點數(通常是8位或16位),可以顯著降低模型的存儲需求和計算復雜度。量化過程中需要仔細調整量化參數,以確保量化后的模型精度損失在可接受范圍內。

2.2 模型剪枝

模型剪枝是另一種有效的模型壓縮方法。通過刪除模型中不重要的連接或神經元(即剪枝),可以減少模型的參數量和計算量。剪枝過程可以基于不同的準則進行,如權重大小、梯度大小或激活值等。剪枝后的模型在保持較高精度的同時,能夠顯著降低計算復雜度和存儲需求。

2.3 推理引擎優化

針對MCU的推理引擎優化是提高推理效率的關鍵。這包括優化內存訪問模式、減少數據搬移次數、利用硬件加速單元(如DSP、GPU)等。此外,還可以采用動態調度、任務并行化等技術來進一步提高推理性能。

三、挑戰與應對

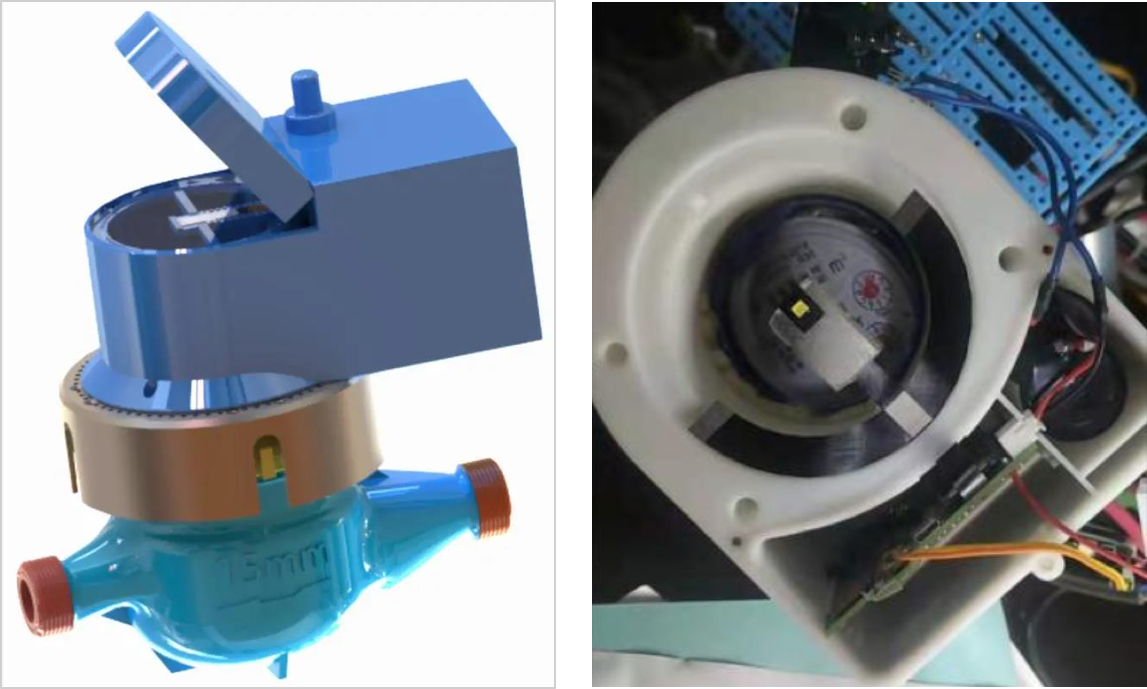

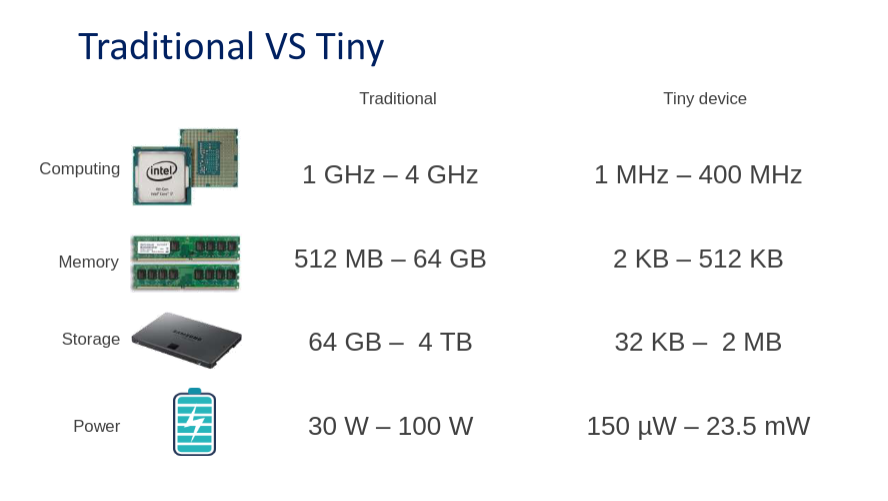

3.1 資源限制

MCU在計算能力、存儲空間和功耗等方面存在顯著限制。為了應對這些挑戰,需要采取一系列措施來優化模型和資源利用。例如,通過量化、剪枝等技術減少模型大小和計算復雜度;通過優化內存管理、減少數據搬移次數來提高資源利用率;通過低功耗設計來延長設備續航時間。

3.2 實時性要求

嵌入式設備通常需要實時處理數據并作出響應。為了滿足實時性要求,需要確保模型推理過程能夠在規定的時間內完成。這要求在選擇和設計模型時充分考慮其推理速度;在部署和推理過程中采用高效的推理引擎和優化技術;在硬件設計上考慮使用高速存儲器和處理器等。

3.3 精度與效率的平衡

在保證模型精度的同時降低其計算復雜度和存儲需求是一個復雜的問題。需要在模型設計、訓練和轉換過程中進行多次迭代和優化;在量化、剪枝等壓縮操作中仔細調整參數以平衡精度和效率;在推理過程中采用適當的后處理技術來恢復精度損失。

四、未來展望

隨著硬件技術的不斷進步和深度學習算法的持續優化,在MCU上實現AI深度學習將變得更加可行和高效。未來,我們可以期待以下幾個方面的發展:

4.1 專用硬件加速器

針對深度學習推理的專用硬件加速器將不斷涌現。這些加速器將針對特定類型的計算任務進行優化,提供更高的計算效率和更低的功耗。通過與MCU的集成或外部連接,這些加速器將能夠顯著提升深度學習推理的性能。

4.2 更高效的推理引擎和庫

隨著對嵌入式設備AI需求的增加,將有更多的推理引擎和庫被開發出來以支持MCU上的深度學習推理。這些工具將針對MCU的特點進行優化,提供更高效、更靈活的推理能力。

4.3 自動化工具鏈

自動化工具鏈將逐漸完善并普及到MCU的AI開發過程中。這些工具鏈將涵蓋從模型設計、訓練、轉換到部署和推理的全流程,幫助開發者快速構建和優化適用于MCU的AI應用。具體來說,自動化工具鏈可以包括:

- 自動模型剪枝與量化 :開發者可以指定精度損失閾值和資源限制,工具鏈將自動探索最佳的剪枝和量化策略,以在滿足精度要求的同時最小化模型大小和計算復雜度。

- 一鍵式部署 :通過集成模型轉換、編譯和燒錄工具,開發者只需點擊一個按鈕即可將訓練好的模型部署到目標MCU上,極大地簡化了部署流程。

- 性能分析與優化 :工具鏈提供性能分析工具,幫助開發者識別推理過程中的瓶頸,并給出優化建議。這些建議可能包括調整模型結構、優化內存訪問模式、使用硬件加速單元等。

4.4 標準化與互操作性

隨著AI在MCU上的普及,標準化和互操作性將變得越來越重要。標準化的模型格式、推理引擎接口和API將有助于不同廠商和開發者之間的合作與交流,促進技術的快速發展。同時,互操作性也將使得開發者能夠更容易地將現有模型遷移到不同的MCU平臺上,提高開發效率和靈活性。

4.5 安全與隱私保護

在MCU上運行AI應用時,安全和隱私保護是不可忽視的問題。MCU設備通常部署在邊緣環境中,直接與物理世界交互,因此容易受到各種攻擊。為了保障安全和隱私,需要采取一系列措施,如數據加密、安全啟動、運行時監控等。同時,也需要考慮如何在保證模型精度的同時減少敏感信息的泄露風險。

4.6 生態系統建設

構建一個完善的生態系統對于推動MCU上AI深度學習的發展至關重要。這包括吸引更多的開發者、研究者、企業和投資者參與到這個領域中來;建立開放、共享的知識庫和社區;提供豐富的開發資源、工具和文檔;以及推動產學研合作,加速技術創新和成果轉化。

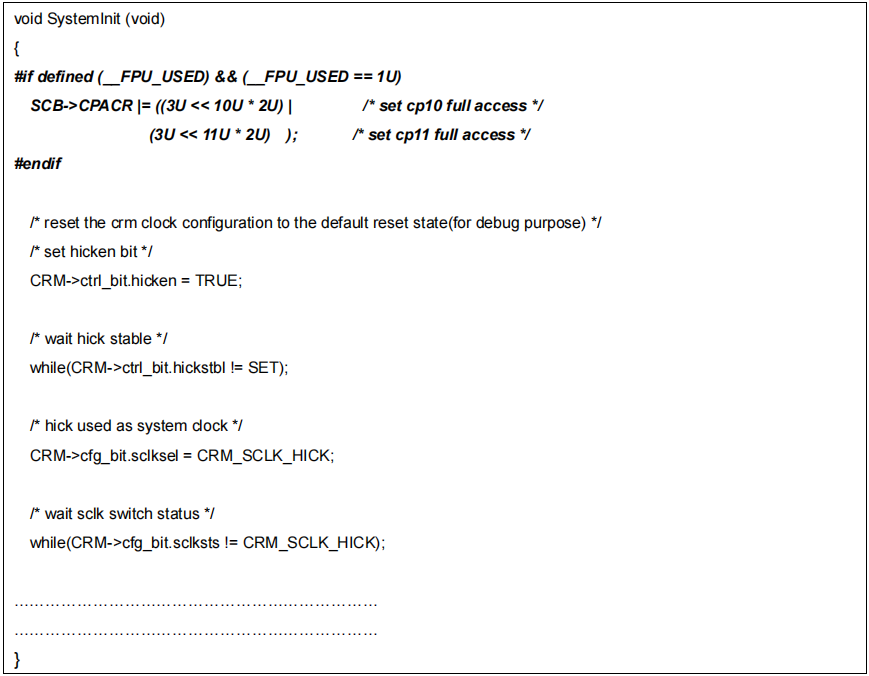

五、代碼示例

以下是一個簡化的代碼示例,展示了如何在STM32 MCU上使用TensorFlow Lite Micro進行模型推理。

#include "tensorflow/lite/micro/kernels/all_ops_resolver.h"

#include "tensorflow/lite/micro/micro_interpreter.h"

#include "tensorflow/lite/micro/micro_mutable_op_resolver.h"

#include "tensorflow/lite/schema/schema_generated.h"

// 假設已經有一個優化后的TensorFlow Lite模型文件(.tflite)

extern const unsigned char g_model_data[];

extern const int g_model_data_len;

// 輸入和輸出張量的指針

TfLiteTensor* input = nullptr;

TfLiteTensor* output = nullptr;

// 初始化TensorFlow Lite Micro解釋器

tflite::MicroInterpreter interpreter;

tflite::ops::micro::AllOpsResolver resolver;

// 設置模型數據和分配張量

if (interpreter.AllocateTensors(&resolver, g_model_data, g_model_data_len) != kTfLiteOk) {

// 錯誤處理

}

// 獲取輸入和輸出張量的指針

interpreter.input(0, &input);

interpreter.output(0, &output);

// 準備輸入數據(這里以固定值為例)

float input_data[NUM_INPUTS] = {/* 初始化輸入數據 */};

for (int i = 0; i < NUM_INPUTS; ++i)

{

input- >data.f[i] = input_data[i];

}

// 執行模型推理

TfLiteStatus invoke_status = interpreter.Invoke();

if (invoke_status != kTfLiteOk) {

// 錯誤處理:推理失敗

}

// 讀取并處理輸出結果

float* output_data = output- >data.f;

for (int i = 0; i < NUM_OUTPUTS; ++i) {

// 根據輸出數據執行相應操作,如控制外設等

// 例如,輸出值大于某個閾值時,控制LED點亮

if (output_data[i] > THRESHOLD) {

// 控制LED點亮的代碼

}

}

// 清理資源(可選,根據實際情況決定是否需要)

// 注意:在MCU上,由于資源有限,通常不建議頻繁地創建和銷毀解釋器實例

// 因此,這里的清理資源代碼可能只是示例,實際使用時可能需要根據具體情況調整

// interpreter.~MicroInterpreter(); // 注意:這通常不是C++的正確銷毀方式,僅為示意

// 注意:上述代碼僅為示例,實際使用時需要根據具體的MCU和TensorFlow Lite Micro版本進行調整

// 特別是與硬件相關的部分(如控制外設的代碼)和與模型數據相關的部分(如輸入和輸出的維度、類型等)

六、結論

在MCU上實現AI深度學習是一個充滿挑戰但也極具前景的領域。通過合理的模型設計、轉換與優化,以及選擇適合MCU的推理引擎和工具鏈,我們可以在保證模型精度的同時滿足MCU對計算復雜度、存儲需求和功耗等方面的限制。未來,隨著硬件技術的不斷進步、深度學習算法的持續優化以及生態系統的逐步完善,我們有理由相信MCU上的AI深度學習將在物聯網、智能家居、智能制造等領域發揮越來越重要的作用,推動這些領域的智能化升級和變革。

總之,MCU上的AI深度學習是一個值得深入研究和探索的領域。它要求我們在技術、算法、工具鏈和生態系統等多個層面進行創新和突破。只有通過持續的努力和合作,我們才能真正實現MCU設備的智能化和自主化,為人類社會帶來更多的便利和福祉。

-

mcu

+關注

關注

146文章

17889瀏覽量

361718 -

物聯網

+關注

關注

2928文章

46015瀏覽量

389336 -

AI

+關注

關注

88文章

34553瀏覽量

276106

發布評論請先 登錄

如何在NXP MCU上啟用D-Cache?

labview實現深度學習,還在用python?

在一顆通用MCU上也能暢玩深度學習嗎?

如何在Hadoop上運行這些深度學習工作

在MCU上實現AI深度學習,你想知道的都在這兒!

如何在深度學習結構中使用紋理特征

如何在MCU上實現AI深度學習

如何在MCU上實現AI深度學習

評論