來源:優(yōu)維科技UWin

大型語言模型是 2023 年生成式人工智能熱潮背后的推動(dòng)力。然而,它們已經(jīng)存在了一段時(shí)間了。

LLM是黑盒 AI 系統(tǒng),它使用深度學(xué)習(xí)對(duì)超大數(shù)據(jù)集進(jìn)行處理,以理解和生成新文本。現(xiàn)代 LLM 開始成型于 2014 年,當(dāng)時(shí)一篇題為“通過聯(lián)合學(xué)習(xí)對(duì)齊和翻譯的神經(jīng)機(jī)器翻譯”的研究論文中引入了注意力機(jī)制(一種旨在模仿人類認(rèn)知注意力的機(jī)器學(xué)習(xí)技術(shù))。2017 年,另一篇論文“注意力就是你所需要的”中引入了 Transformer 模型,這種注意力機(jī)制得到了進(jìn)一步完善。當(dāng)今一些最著名的語言模型都是基于 transformer 模型的,包括生成式預(yù)訓(xùn)練 transformer 系列LLM 和來自 transformer 的雙向編碼器表示 (BERT)。ChatGPT運(yùn)行在 OpenAI 的一組語言模型上,在 2022 年發(fā)布后僅兩個(gè)月就吸引了超過 1 億用戶。此后,許多競(jìng)爭(zhēng)模型相繼發(fā)布。其中一些屬于谷歌和微軟等大公司;另一些則是開源的。

以下是當(dāng)今最相關(guān)的一些大型語言模型。它們進(jìn)行自然語言處理并影響未來模型的架構(gòu)。

BERTBERT是 Google 于 2018 年推出的 LLM 系列。BERT 是一種基于 Transformer 的模型,可以將數(shù)據(jù)序列轉(zhuǎn)換為其他數(shù)據(jù)序列。BERT 的架構(gòu)是 Transformer 編碼器的堆棧,具有 3.42 億個(gè)參數(shù)。BERT 在大量數(shù)據(jù)上進(jìn)行了預(yù)訓(xùn)練,然后進(jìn)行了微調(diào)以執(zhí)行特定任務(wù)以及自然語言推理和句子文本相似性。它被用于提高 Google 搜索 2019 年迭代中的查詢理解能力。

Claude

Claude 法學(xué)碩士專注于體質(zhì)人工智能,它以一系列原則為指導(dǎo)塑造人工智能輸出,這些原則有助于它所支持的人工智能助手有用、無害且準(zhǔn)確。Claude 由 Anthropic 公司創(chuàng)建。Claude 法學(xué)碩士的最新版本是 Claude 3.0。

CohereCohere 是一個(gè)企業(yè) AI 平臺(tái),提供多種 LLM,包括 Command、Rerank 和 Embed。這些LLM 可以根據(jù)特定公司的用例進(jìn)行定制訓(xùn)練和微調(diào)。創(chuàng)建 Cohere LLM 的公司是由《Attention Is All You Need》的作者之一創(chuàng)立的。Cohere 的優(yōu)勢(shì)之一是它不依賴于單一云——不像 OpenAI 那樣依賴于 Microsoft Azure。

Ernie

Ernie 是百度的大型語言模型,為 Ernie 4.0 聊天機(jī)器人提供支持。該機(jī)器人于 2023 年 8 月發(fā)布,已擁有超過 4500 萬用戶。據(jù)傳 Ernie 擁有 10 萬億個(gè)參數(shù)。該機(jī)器人最適合普通話,但也能夠處理其他語言。

Falcon 40B

Falcon 40B 是一種基于 Transformer 的因果解碼器專用模型,由技術(shù)創(chuàng)新研究所開發(fā)。它是開源的,并基于英語數(shù)據(jù)進(jìn)行訓(xùn)練。該模型還有兩個(gè)較小的版本:Falcon 1B 和 Falcon 7B(10 億和 70 億個(gè)參數(shù))。亞馬遜已在Amazon SageMaker上提供 Falcon 40B 。它也可以在 GitHub 上免費(fèi)獲取。

Gemini

Gemini是 Google 的 LLM 系列,為該公司的同名聊天機(jī)器人提供支持。該模型取代了 Palm 為聊天機(jī)器人提供支持,在模型切換后,聊天機(jī)器人從 Bard 更名為 Gemini。Gemini 模型是多模式的,這意味著它們可以處理圖像、音頻和視頻以及文本。Gemini 還集成在許多 Google 應(yīng)用程序和產(chǎn)品中。它有三種尺寸——Ultra、Pro 和 Nano。Ultra 是最大、功能最強(qiáng)大的模型,Pro 是中端模型,Nano 是最小的模型,專為提高設(shè)備上任務(wù)的效率而設(shè)計(jì)。Gemini 在大多數(shù)評(píng)估基準(zhǔn)上都優(yōu)于 GPT-4。

Gemma

Gemma是 Google 的開源語言模型系列,使用與 Gemini 相同的資源進(jìn)行訓(xùn)練。Gemma 有兩種規(guī)模——20 億參數(shù)模型和 70 億參數(shù)模型。Gemma 模型可以在個(gè)人電腦本地運(yùn)行,并且在多個(gè)評(píng)估基準(zhǔn)上超越了類似規(guī)模的 Llama 2 模型。

GPT-3

GPT-3是 OpenAI 于 2020 年發(fā)布的大型語言模型,擁有超過 1750 億個(gè)參數(shù)。GPT-3 采用僅解碼器的 Transformer 架構(gòu)。2022 年 9 月,微軟宣布獨(dú)家使用 GPT-3 的底層模型。GPT-3 比其前身大 10 倍。GPT-3 的訓(xùn)練數(shù)據(jù)包括 Common Crawl、WebText2、Books1、Books2 和 Wikipedia。GPT-3 是 OpenAI 公開參數(shù)計(jì)數(shù)的 GPT 系列模型中的最后一款。GPT 系列于 2018 年首次推出,當(dāng)時(shí) OpenAI 發(fā)表了一篇論文《通過生成式預(yù)訓(xùn)練提高語言理解能力》。

GPT-3.5GPT-3.5 是 GPT-3 的升級(jí)版,參數(shù)更少。GPT-3.5 使用來自人類反饋的強(qiáng)化學(xué)習(xí)進(jìn)行了微調(diào)。GPT-3.5 是支持 ChatGPT 的 GPT 版本。據(jù) OpenAI 稱,有幾種模型,其中 GPT-3.5 turbo 是最強(qiáng)大的。GPT-3.5 的訓(xùn)練數(shù)據(jù)延伸到 2021 年 9 月。它也曾被集成到 Bing 搜索引擎中,但后來被 GPT-4 取代。

GPT-4GPT-4是OpenAI 的 GPT 系列中最大的模型,于 2023 年發(fā)布。與其他模型一樣,它也是基于 Transformer 的模型。與其他模型不同的是,它的參數(shù)數(shù)量尚未向公眾公布,盡管有傳言稱該模型的參數(shù)數(shù)量超過 170 萬億。OpenAI 將 GPT-4 描述為多模態(tài)模型,這意味著它可以處理和生成語言和圖像,而不僅限于語言。GPT-4 還引入了系統(tǒng)消息,讓用戶可以指定語調(diào)和任務(wù)。GPT-4 在多項(xiàng)學(xué)術(shù)考試中表現(xiàn)出了與人類水平相當(dāng)?shù)谋憩F(xiàn)。在該模型發(fā)布時(shí),有人猜測(cè) GPT-4 已經(jīng)接近通用人工智能(AGI),這意味著它與人類一樣聰明甚至比人類更聰明。GPT-4 為 Microsoft Bing 搜索提供支持,可在 ChatGPT Plus 中使用,最終將集成到 Microsoft Office 產(chǎn)品中。

GPT-4oGPT-4 Omni(GPT-4o)是 OpenAI 的 GPT-4 繼任者,與之前的模型相比有多項(xiàng)改進(jìn)。GPT-4o 為 ChatGPT 創(chuàng)造了更自然的人機(jī)交互,是一個(gè)大型多模態(tài)模型,接受音頻、圖像和文本等各種輸入。對(duì)話讓用戶可以像在正常的人類對(duì)話中一樣參與,實(shí)時(shí)互動(dòng)還可以捕捉情緒。GPT-4o 可以在交互過程中查看照片或屏幕并提出相關(guān)問題。GPT-4o 的響應(yīng)時(shí)間僅為 232 毫秒,與人類的響應(yīng)時(shí)間相似,比 GPT-4 Turbo 更快。GPT-4o 模型是免費(fèi)的,將提供給開發(fā)者和客戶產(chǎn)品。

LamdaLamda(對(duì)話應(yīng)用語言模型)是 Google Brain 于 2021 年發(fā)布的 LLM 系列。Lamda 使用了僅解碼器的轉(zhuǎn)換器語言模型,并在大量文本語料庫上進(jìn)行了預(yù)訓(xùn)練。2022 年,當(dāng)時(shí)的谷歌工程師 Blake Lemoine 公開聲稱該程序具有感知能力, LaMDA 引起了廣泛關(guān)注。它建立在 Seq2Seq 架構(gòu)上。

Llama大型語言模型 Meta AI (Llama) 是 Meta 于 2023 年發(fā)布的 LLM。最大版本的大小為 650 億個(gè)參數(shù)。Llama 最初發(fā)布給經(jīng)批準(zhǔn)的研究人員和開發(fā)人員,但現(xiàn)在已開源。Llama 的規(guī)模較小,使用、測(cè)試和實(shí)驗(yàn)所需的計(jì)算能力較少。Llama 使用轉(zhuǎn)換器架構(gòu),并在各種公共數(shù)據(jù)源上進(jìn)行訓(xùn)練,包括 CommonCrawl、GitHub、Wikipedia 和 Project Gutenberg 的網(wǎng)頁。Llama 被有效泄露并衍生出許多后代,包括 Vicuna 和 Orca。

MistralMistral 是一個(gè) 70 億參數(shù)的語言模型,在所有評(píng)估基準(zhǔn)上都優(yōu)于 Llama 類似規(guī)模的語言模型。Mistral 還擁有一個(gè)經(jīng)過微調(diào)的模型,專門用于遵循指令。其較小的尺寸使其能夠?qū)崿F(xiàn)自托管,并具有出色的業(yè)務(wù)性能。它是根據(jù) Apache 2.0 許可證發(fā)布的。

OrcaOrca 由微軟開發(fā),擁有 130 億個(gè)參數(shù),這意味著它足夠小,可以在筆記本電腦上運(yùn)行。它旨在通過模仿 LLM 實(shí)現(xiàn)的推理過程來改進(jìn)其他開源模型所取得的進(jìn)步。Orca 以明顯更少的參數(shù)實(shí)現(xiàn)了與 GPT-4 相同的性能,并且在許多任務(wù)上與 GPT-3.5 相當(dāng)。Orca 建立在 130 億個(gè)參數(shù)版本的 LLaMA 之上。

PathwaysPathways 語言模型是谷歌推出的一款基于 5400 億參數(shù)轉(zhuǎn)換器的模型,為它的 AI 聊天機(jī)器人Bard提供支持。該模型在多個(gè)TPU 4 Pod(谷歌為機(jī)器學(xué)習(xí)定制的硬件)上進(jìn)行訓(xùn)練。Palm 擅長推理任務(wù),例如編碼、數(shù)學(xué)、分類和問答。Palm 還擅長將復(fù)雜任務(wù)分解為更簡單的子任務(wù)。PaLM 的名稱源自 Google 的一項(xiàng)研究計(jì)劃,該計(jì)劃旨在構(gòu)建 Pathways,最終創(chuàng)建一個(gè)單一模型,作為多種用例的基礎(chǔ)。Palm 有多個(gè)經(jīng)過微調(diào)的版本,包括用于生命科學(xué)和醫(yī)療信息的 Med-Palm 2 以及用于網(wǎng)絡(luò)安全部署以加快威脅分析的 Sec-Palm。

Phi-1Phi-1 是微軟推出的一款基于 Transformer 的語言模型。Phi-1 僅包含 13 億個(gè)參數(shù),在一系列教科書級(jí)數(shù)據(jù)上訓(xùn)練了四天。Phi-1 是使用更高質(zhì)量數(shù)據(jù)和合成數(shù)據(jù)進(jìn)行訓(xùn)練的小型模型趨勢(shì)的一個(gè)例子。特斯拉前人工智能總監(jiān)、OpenAI 員工 Andrej Karpathy 在推文中寫道:“我們可能會(huì)看到更多富有創(chuàng)意的縮減工作量的做法:優(yōu)先考慮數(shù)據(jù)質(zhì)量和多樣性而不是數(shù)量,生成更多的合成數(shù)據(jù),以及小型但功能強(qiáng)大的專家模型。”Phi-1 專注于Python編碼,由于規(guī)模較小,通用能力較差。

StableLMStableLM 是 Stability AI 開發(fā)的一系列開源語言模型,該公司是圖像生成器 Stable Diffusion 的幕后推手。截至撰寫本文時(shí),已有 30 億和 70 億參數(shù)模型可用,150 億、300 億、650 億和 1750 億參數(shù)模型正在開發(fā)中。StableLM 的目標(biāo)是透明、可訪問且支持性強(qiáng)。

Vicuna 33B

Vicuna 是另一個(gè)有影響力的開源 LLM,源自 Llama。它由 LMSYS 開發(fā),并使用 sharegpt.com 的數(shù)據(jù)進(jìn)行了微調(diào)。根據(jù)幾個(gè)基準(zhǔn)測(cè)試,它比 GPT-4 更小、功能更弱,但對(duì)于其大小的模型來說,它表現(xiàn)不錯(cuò)。Vicuna 只有 330 億個(gè)參數(shù),而 GPT-4 有數(shù)萬億個(gè)參數(shù)。

-

AI

+關(guān)注

關(guān)注

87文章

33553瀏覽量

274171 -

人工智能

+關(guān)注

關(guān)注

1804文章

48449瀏覽量

244884 -

語言模型

+關(guān)注

關(guān)注

0文章

557瀏覽量

10594

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

無法在OVMS上運(yùn)行來自Meta的大型語言模型 (LLM),為什么?

大語言模型的解碼策略與關(guān)鍵優(yōu)化總結(jié)

電子發(fā)燒友榮獲人民郵電出版社-異步社區(qū)“2024年度最佳合作伙伴獎(jiǎng)”

大語言模型開發(fā)框架是什么

Google Play 2024年度最佳榜單揭幕

安波福蘇州榮獲“2024大蘇州最佳雇主”及“2024最佳HR團(tuán)隊(duì)獎(jiǎng)”

如何利用大型語言模型驅(qū)動(dòng)的搜索為公司創(chuàng)造價(jià)值

小米集團(tuán)榮獲《機(jī)構(gòu)投資者》“2024年亞洲最佳管理團(tuán)隊(duì)”多項(xiàng)殊榮

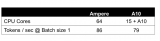

基于CPU的大型語言模型推理實(shí)驗(yàn)

英偉達(dá)開源Nemotron-4 340B系列模型,助力大型語言模型訓(xùn)練

大語言模型:原理與工程時(shí)間+小白初識(shí)大語言模型

了解大型語言模型 (LLM) 領(lǐng)域中的25個(gè)關(guān)鍵術(shù)語

2024 年 19 種最佳大型語言模型

2024 年 19 種最佳大型語言模型

評(píng)論