近日,DeepMind在論文Population Based Training of Neural Networks中提出了一種超參數(shù)優(yōu)化方法,在沿用傳統(tǒng)隨機(jī)搜索的并行訓(xùn)練的同時,從GA算法中獲得靈感引入了從其他個體復(fù)制參數(shù)更新迭代的做法,效果顯著。據(jù)官方稱,使用這種名為PBT的方法可大幅提高計算機(jī)資源利用效率,訓(xùn)練更穩(wěn)定,模型性能也更好。

從圍棋到雅達(dá)利游戲到圖像識別和語言翻譯,神經(jīng)網(wǎng)絡(luò)在各領(lǐng)域都取得了極大的成功。但經(jīng)常被忽視的一點是,神經(jīng)網(wǎng)絡(luò)在特定應(yīng)用中的成功往往取決于研究開始時做出的一系列選擇,包括使用何種類型的網(wǎng)絡(luò)、訓(xùn)練數(shù)據(jù)和訓(xùn)練方法。目前,這些選擇(超參數(shù))的選取主要基于經(jīng)驗、隨機(jī)搜索和計算機(jī)密集搜索。

在DeepMind新近發(fā)表的一篇論文中,團(tuán)隊提出了一種訓(xùn)練神經(jīng)網(wǎng)絡(luò)的新方法——Population Based Training (PBT,暫譯為基于群體的訓(xùn)練),通過同時訓(xùn)練和優(yōu)化一系列網(wǎng)絡(luò),它能幫開發(fā)者迅速選擇最佳超參數(shù)和模型。

該方法其實是兩種最常用的超參數(shù)優(yōu)化方法的整合:隨機(jī)搜索(random search)和手動調(diào)試(hand-tuning)。如果單純使用隨機(jī)搜索,神經(jīng)網(wǎng)絡(luò)群體并行訓(xùn)練,并在訓(xùn)練結(jié)束時選擇性能最好的模型。一般來說,這意味著只有一小部分群體能接受良好的超參數(shù)訓(xùn)練,而剩下的大部分訓(xùn)練質(zhì)量不佳,基本上只是在浪費計算機(jī)資源。

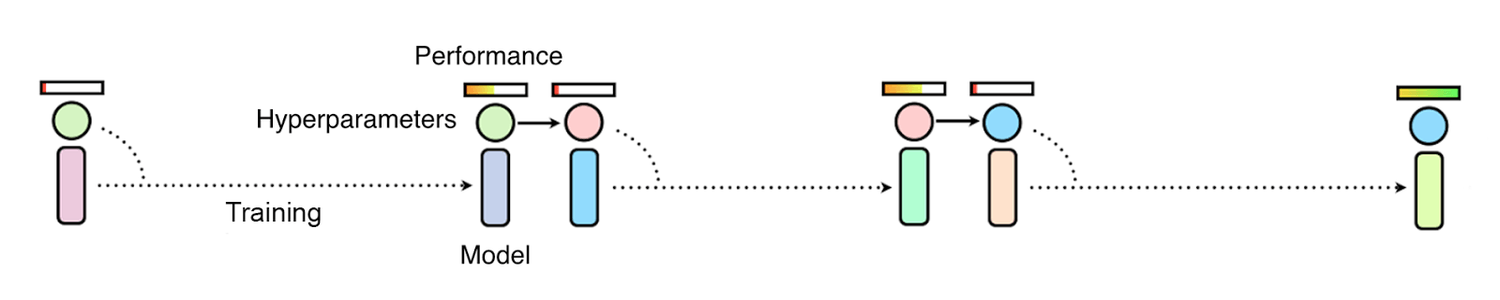

隨機(jī)搜索選取超參數(shù),超參數(shù)并行訓(xùn)練而又各自獨立。一些超參數(shù)可能有助于建立更好的模型,但其他的不會

而如果使用的是手動調(diào)試,研究人員必須首先推測哪種超參數(shù)最合適,然后把它應(yīng)用到模型中,再評估性能,如此循環(huán)往復(fù),直到他對模型的性能感到滿意為止。雖然這樣做可以實現(xiàn)更好的模型性能,但缺點同樣很突出,就是耗時太久,有時需要數(shù)周甚至數(shù)月才能完成優(yōu)化。

如果使用手動調(diào)試或貝葉斯優(yōu)化等方法通過依次觀察訓(xùn)練效果選取超參數(shù),整體進(jìn)度會異常緩慢

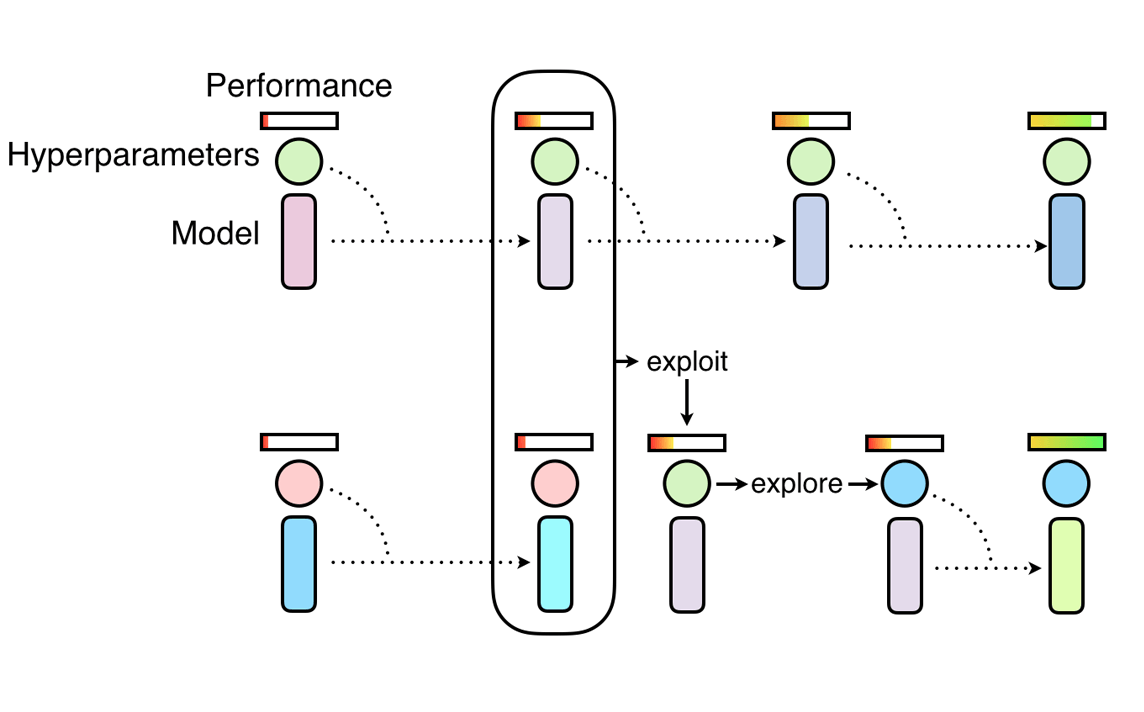

PBT結(jié)合兩種方法的優(yōu)勢。和隨機(jī)搜索一樣,它首先會訓(xùn)練大量神經(jīng)網(wǎng)絡(luò)供隨機(jī)超參數(shù)實驗,但不同的是,這些網(wǎng)絡(luò)不是獨立訓(xùn)練的,它們會不斷整合其他超參數(shù)群體的信息來進(jìn)行自我完善,同時將計算資源集中給最有潛力的模型。這個靈感來自遺傳算法(GA),在GA中,每個個體(候選解)能通過利用其他個體的參數(shù)信息進(jìn)行迭代,如,一個個體能從另一個性能較優(yōu)的個體中復(fù)制參數(shù)模型。同理,PBT鼓勵每個超參數(shù)通過隨機(jī)更改當(dāng)前值來探索形成新的超參數(shù)。

隨著對神經(jīng)網(wǎng)絡(luò)訓(xùn)練的不斷深入,這個開發(fā)和探索的過程是定期進(jìn)行的,以確保所有超參數(shù)都有一個良好的基礎(chǔ)性能,同時,新超參數(shù)也在不斷形成。這意味著PBT可以迅速選取優(yōu)質(zhì)超參數(shù),并把更多的訓(xùn)練時間投入到最有潛力的模型中,最關(guān)鍵的是,它還允許在訓(xùn)練過程中調(diào)整超參數(shù)值,從而自動學(xué)習(xí)最佳配置。

PBT的神經(jīng)網(wǎng)絡(luò)訓(xùn)練從隨機(jī)搜索開始,但允許個體利用其他個體的部分結(jié)果,并隨著訓(xùn)練的進(jìn)行探索形成新超參數(shù)

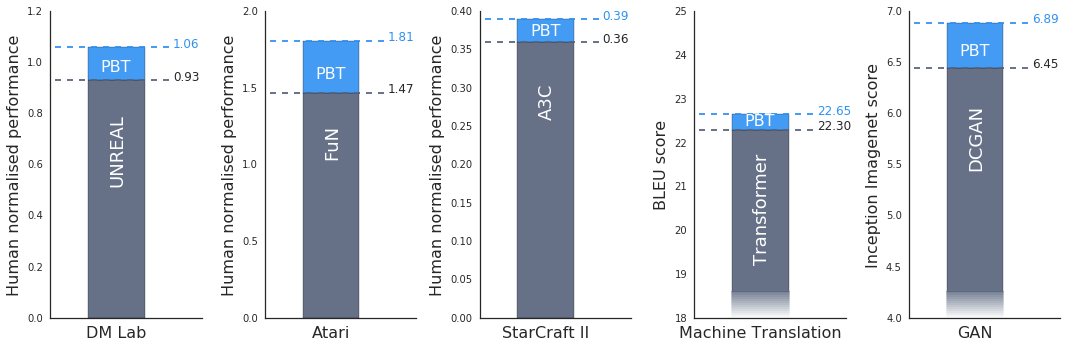

為了測試PBT的效果,DeepMind做了一些實驗。如研究人員在DeepMind Lab、雅達(dá)利和星際2三個游戲平臺上用最先進(jìn)的方法測試了一套具有相當(dāng)挑戰(zhàn)性的強(qiáng)化學(xué)習(xí)問題。實驗證明,在所有情況下,PBT都訓(xùn)練穩(wěn)定,并且迅速找到了最佳超參數(shù),提供了超出最新基線的結(jié)果。

他們還發(fā)現(xiàn)PBT同樣適用于生成對抗網(wǎng)絡(luò)(GAN)。一般來說,GAN的超參數(shù)很難調(diào)試,但在一次實驗中,DeepMind的PBT框架使模型的Inception Score(圖像保真度分?jǐn)?shù))達(dá)到了新高,從6.45躍升至6.89(如上圖最后一幅圖所示)。

PBT也在Google的機(jī)器翻譯神經(jīng)網(wǎng)絡(luò)上進(jìn)行了實驗。作為谷歌最先進(jìn)的機(jī)翻工具,這些神經(jīng)網(wǎng)絡(luò)使用的超參數(shù)優(yōu)化方法是手動調(diào)試,這意味著在投入使用前,它們需要按照研究人員精心設(shè)計的超參數(shù)時間表進(jìn)行長達(dá)數(shù)月的訓(xùn)練。使用PBT,計算機(jī)自動建立了時間表,該訓(xùn)練計劃所獲得的模型性能和現(xiàn)用方法差不多,甚至更好,而且只需進(jìn)行一次訓(xùn)練就可以獲得滿意的模型。

PBT在GAN和雅達(dá)利游戲“吃豆子女士”上的表現(xiàn):粉色點為初代,藍(lán)色點為末代,分支代表操作已執(zhí)行(參數(shù)已復(fù)制),路徑表示步驟的連續(xù)更新

DeepMind相信,這只是超參數(shù)優(yōu)化方法創(chuàng)新的一個開始。綜合論文可知,PBT對于訓(xùn)練引入新超參數(shù)的算法和神經(jīng)網(wǎng)絡(luò)結(jié)果特別有用,它為尋找和開發(fā)更復(fù)雜、更強(qiáng)大的神經(jīng)網(wǎng)絡(luò)模型提供了可能性。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4810瀏覽量

102918

原文標(biāo)題:DeepMind最新研究:基于群體的神經(jīng)網(wǎng)絡(luò)訓(xùn)練

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

2006 年微控制器五大趨勢-外圍篇(微控制器基本功效解讀)

【免費直播】李增和大家一起學(xué)習(xí)S參數(shù)的相關(guān)知識及提取解讀分析優(yōu)化S參數(shù)的方法

【免費直播】李增和大家一起學(xué)習(xí)S參數(shù)的相關(guān)知識及提取解讀分析優(yōu)化S參數(shù)的方法

【免費直播】李增和大家一起學(xué)習(xí)S參數(shù)的相關(guān)知識及提取解讀分析優(yōu)化S參數(shù)的方法

改善深層神經(jīng)網(wǎng)絡(luò)--超參數(shù)優(yōu)化、batch正則化和程序框架 學(xué)習(xí)總結(jié)

優(yōu)化面向超低功耗設(shè)計的微控制器功效

PID調(diào)節(jié)器參數(shù)優(yōu)化設(shè)計的改進(jìn)方法

調(diào)參心得:如何優(yōu)化超參數(shù)的,如何證實方法是有效的

PerferredNetworks發(fā)布了其超參數(shù)優(yōu)化框架的beta版本

機(jī)器學(xué)習(xí)的超參數(shù)調(diào)優(yōu)方法

機(jī)器學(xué)習(xí)的幾個超參數(shù)調(diào)試方法

基于樹狀結(jié)構(gòu)Parzen估計方法的超參數(shù)優(yōu)化方法

PyTorch教程19.1之什么是超參數(shù)優(yōu)化

PyTorch教程19.2之超參數(shù)優(yōu)化API

超參數(shù)優(yōu)化方法PBT的原理和功效解讀

超參數(shù)優(yōu)化方法PBT的原理和功效解讀

評論