近年來,基于神經網絡的深度學習方法在自然語言處理領域已經取得了不少進展。作為NLP領域的基礎任務—命名實體識別(Named Entity Recognition,NER)也不例外,神經網絡結構在NER中也取得了不錯的效果。最近,本文作者也閱讀學習了一系列使用神經網絡結構進行NER的相關論文,在此進行一下總結,和大家一起分享學習。

1 引言

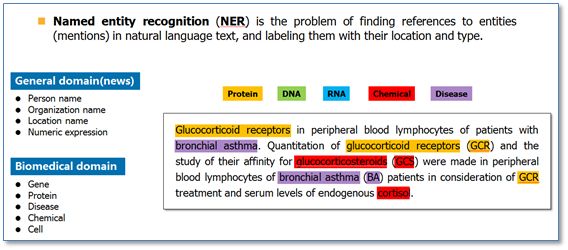

命名實體識別(Named Entity Recognition,NER)就是從一段自然語言文本中找出相關實體,并標注出其位置以及類型,如下圖。它是NLP領域中一些復雜任務(例如關系抽取,信息檢索等)的基礎。

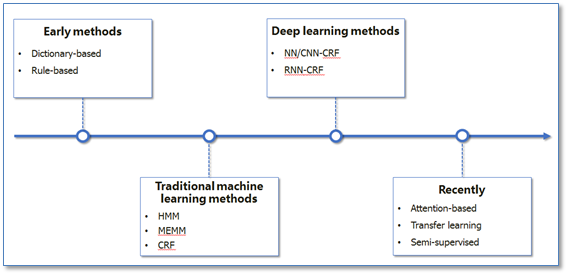

NER一直是NLP領域中的研究熱點,從早期基于詞典和規則的方法,到傳統機器學習的方法,到近年來基于深度學習的方法,NER研究進展的大概趨勢大致如下圖所示。

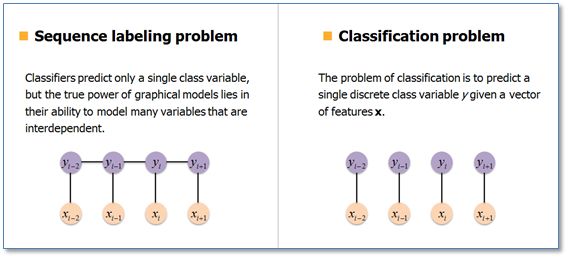

在基于機器學習的方法中,NER被當作是序列標注問題。與分類問題相比,序列標注問題中當前的預測標簽不僅與當前的輸入特征相關,還與之前的預測標簽相關,即預測標簽序列之間是有強相互依賴關系的。例如,使用BIO標簽策略進行NER時,正確的標簽序列中標簽O后面是不會接標簽I的。

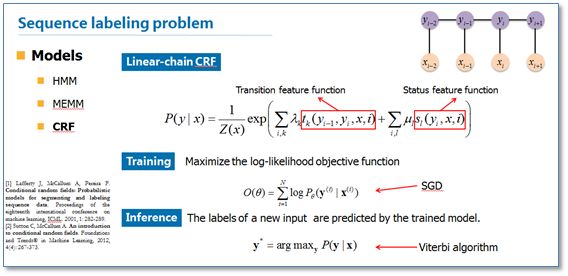

在傳統機器學習中,條件隨機場(Conditional Random Field,CRF)是NER目前的主流模型。它的目標函數不僅考慮輸入的狀態特征函數,而且還包含了標簽轉移特征函數。在訓練時可以使用SGD學習模型參數。在已知模型時,給輸入序列求預測輸出序列即求使目標函數最大化的最優序列,是一個動態規劃問題,可以使用維特比算法進行解碼。

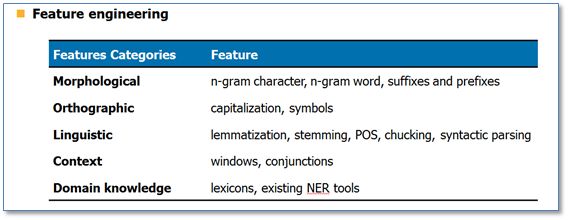

在傳統機器學習方法中,常用的特征如下:

接下里我們重點看看如何使用神經網絡結構來進行NER 。

2 NER中主流的神經網絡結構

2.1 NN/CNN-CRF模型

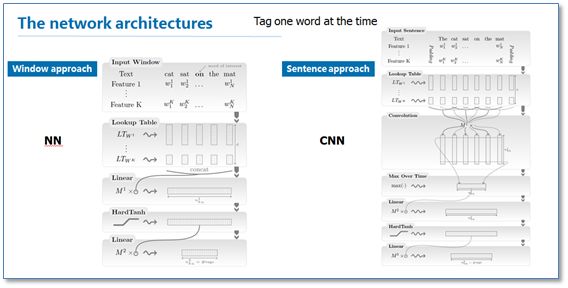

《Natural language processing (almost) from scratch》是較早使用神經網絡進行NER的代表工作之一。在這篇論文中,作者提出了窗口方法與句子方法兩種網絡結構來進行NER。這兩種結構的主要區別就在于窗口方法僅使用當前預測詞的上下文窗口進行輸入,然后使用傳統的NN結構;而句子方法是以整個句子作為當前預測詞的輸入,加入了句子中相對位置特征來區分句子中的每個詞,然后使用了一層卷積神經網絡CNN結構。

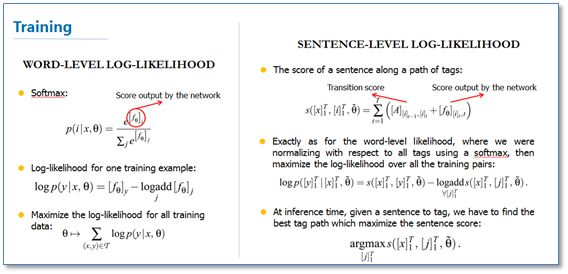

在訓練階段,作者也給出了兩種目標函數:一種是詞級別的對數似然,即使用softmax來預測標簽概率,當成是一個傳統分類問題;另一種是句子級別的對數似然,其實就是考慮到CRF模型在序列標注問題中的優勢,將標簽轉移得分加入到了目標函數中。后來許多相關工作把這個思想稱為結合了一層CRF層,所以我這里稱為NN/CNN-CRF模型。

在作者的實驗中,上述提到的NN和CNN結構效果基本一致,但是句子級別似然函數即加入CRF層在NER的效果上有明顯提高。

2.2 RNN-CRF模型

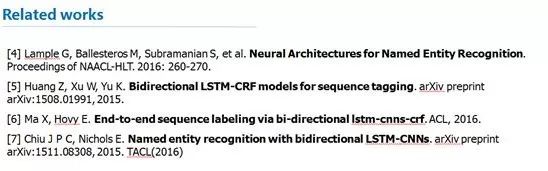

借鑒上面的CRF思路,在2015年左右出現了一系列使用RNN結構并結合CRF層進行NER的工作。代表工作主要有: 將這些工作總結起來就是一個RNN-CRF模型,模型結構如下圖:

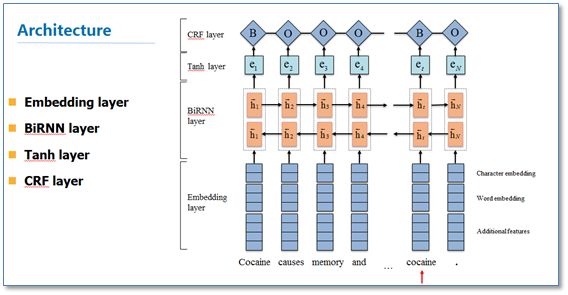

將這些工作總結起來就是一個RNN-CRF模型,模型結構如下圖:

它主要有Embedding層(主要有詞向量,字符向量以及一些額外特征),雙向RNN層,tanh隱層以及最后的CRF層構成。它與之前NN/CNN-CRF的主要區別就是他使用的是雙向RNN代替了NN/CNN。這里RNN常用LSTM或者GRU。實驗結果表明RNN-CRF獲得了更好的效果,已經達到或者超過了基于豐富特征的CRF模型,成為目前基于深度學習的NER方法中的最主流模型。在特征方面,該模型繼承了深度學習方法的優勢,無需特征工程,使用詞向量以及字符向量就可以達到很好的效果,如果有高質量的詞典特征,能夠進一步獲得提高。

3 最近的一些工作

最近的一年在基于神經網絡結構的NER研究上,主要集中在兩個方面:一是使用流行的注意力機制來提高模型效果(Attention Mechanism),二是針對少量標注訓練數據進行的一些研究。

3.1 Attention-based

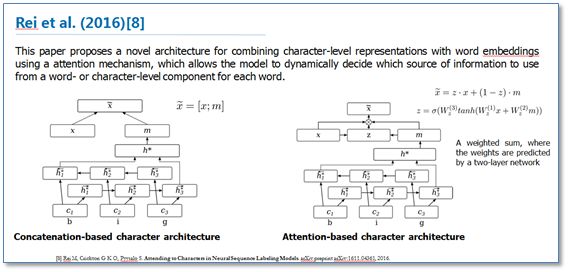

《Attending to Characters in Neural Sequence Labeling Models》該論文還是在RNN-CRF模型結構基礎上,重點改進了詞向量與字符向量的拼接。使用attention機制將原始的字符向量和詞向量拼接改進為了權重求和,使用兩層傳統神經網絡隱層來學習attention的權值,這樣就使得模型可以動態地利用詞向量和字符向量信息。實驗結果表明比原始的拼接方法效果更好。

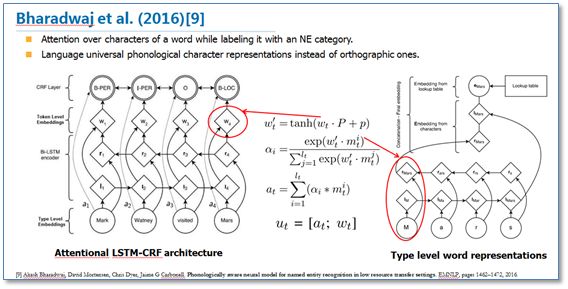

另一篇論文《Phonologically aware neural model for named entity recognition in low resource transfer settings》,在原始BiLSTM-CRF模型上,加入了音韻特征,并在字符向量上使用attention機制來學習關注更有效的字符,主要改進如下圖。

3.2 少量標注數據

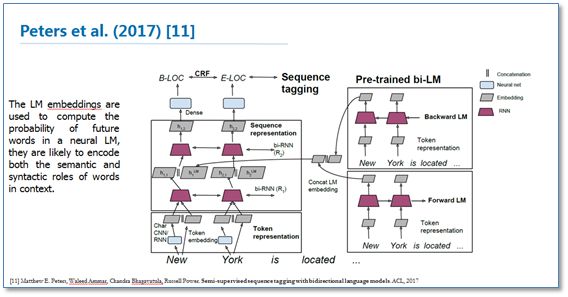

對于深度學習方法,一般需要大量標注數據,但是在一些領域并沒有海量的標注數據。所以在基于神經網絡結構方法中如何使用少量標注數據進行NER也是最近研究的重點。其中包括了遷移學習《Transfer Learning for Sequence Tagging with Hierarchical Recurrent Networks》和半監督學習。這里我提一下最近ACL2017剛錄用的一篇論文《Semi-supervised sequence tagging with bidirectional language models》。該論文使用海量無標注語料庫訓練了一個雙向神經網絡語言模型,然后使用這個訓練好的語言模型來獲取當前要標注詞的語言模型向量(LM embedding),然后將該向量作為特征加入到原始的雙向RNN-CRF模型中。實驗結果表明,在少量標注數據上,加入這個語言模型向量能夠大幅度提高NER效果,即使在大量的標注訓練數據上,加入這個語言模型向量仍能提供原始RNN-CRF模型的效果。整體模型結構如下圖:

4 總結

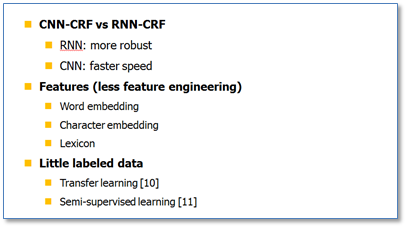

最后進行一下總結,目前將神經網絡與CRF模型相結合的NN/CNN/RNN-CRF模型成為了目前NER的主流模型。我認為對于CNN與RNN,并沒有誰占據絕對的優勢,各自有相應的優點。由于RNN有天然的序列結構,所以RNN-CRF使用更為廣泛。基于神經網絡結構的NER方法,繼承了深度學習方法的優點,無需大量人工特征。只需詞向量和字符向量就能達到主流水平,加入高質量的詞典特征能夠進一步提升效果。對于少量標注訓練集問題,遷移學習,半監督學習應該是未來研究的重點。

-

神經網絡

+關注

關注

42文章

4810瀏覽量

102929 -

nlp

+關注

關注

1文章

490瀏覽量

22514

原文標題:神經網絡結構在命名實體識別(NER)中的應用

文章出處:【微信號:Imgtec,微信公眾號:Imagination Tech】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

粒子群優化模糊神經網絡在語音識別中的應用

HanLP分詞命名實體提取詳解

基于結構化感知機的詞性標注與命名實體識別框架

HanLP-命名實體識別總結

神經網絡結構搜索有什么優勢?

新型中文旅游文本命名實體識別設計方案

一種改進的深度神經網絡結構搜索方法

命名實體識別的遷移學習相關研究分析

基于神經網絡結構在命名實體識別中應用的分析與總結

基于神經網絡結構在命名實體識別中應用的分析與總結

評論