概要:2017年,機器學習和各種人工智能應用在高性能計算領域持續發揮著重要影響力。

2017年12月9日,TOP500官網刊文總結了高性能計算在2017年取得的新進展,以及未來發展趨勢,主要內容如下所示。

1、機器學習技術成為高性能計算的殺手級應用

2017年,機器學習和各種人工智能應用在高性能計算領域持續發揮著重要影響力。隨著越來越復雜的神經網絡模型被開發和應用,智能搜索引擎、廣告投放、語言翻譯以及圖像識別等應用變得越來越智能。機器學習技術與傳統高性能計算技術的結合成為新的發展趨勢。

在天氣建模、金融風險分析、天體物理建模以及醫學診斷等特殊應用中,開發人員越來越依靠機器學習技術來提高模型準確率及模型實現速度。同時,傳統的超算平臺在機器學習算法的研發過程中發揮著越來越重要的作用。由于超級計算機中圖形圖像處理單元(GPU)的功能越來越強大,它們也擔負起越來越多的機器學習研究任務。

英偉達公司推出VoltaV100 GPU,鞏固了其在人工智能領域的統治地位。VoltaV100 GPU是Volta架構下的首款高性能GPU,每個內核具有高達120萬億次(teraflops)的深度學習能力,并可以在任何具有備用PCIe端口的機器上部署使用。亞馬遜、微軟和百度等公司將相繼使用該設備。

除了超強的深度學習能力以外,V100 GPU的雙精度浮點運算能力可以達到每秒7 teraflops,使其同樣適合傳統的高性能計算機的配置。美國能源部的兩臺功能最強大的超級計算機Summit和Sierra都將配置該GPU。在該款GPU的推動下,Volta架構能同時滿足傳統的高性能計算機與最新的機器學習應用的需求。

3、英特爾探索近百億億次超算,拋棄Knights Hill產品

2017年10月,美國能源部發布報告表示,將取消于2018年在阿貢國家實驗室部署180千萬億次(petaflop)超級計算機Aurora的計劃。這臺超級計算機原計劃將使用英特爾的下一代至強(Xeon Phi)處理器——Knights Hill。而現在,Aurora將在2020-2021年間被新打造為一個具有接近百億億次運算能力的新系統。11月份,英特爾透露他們已放棄Knights Hill產品,尚未公布任何有關Xeon Phi產品線的替代路線圖。

4、AMD產品試圖替代英特爾和英偉達芯片

2017年6月,AMD公司推出EPYC芯片,這是該公司自皓龍(Opteron)處理器發布以來第一款可以替代英特爾Xeon處理器系列的產品。同英特爾在7月份推出的全新SkylakeXeon系列處理器相比,EPYC具有更多的核心數、更高的I/O連接以及更大的內存帶寬。雖然EPYC錯過了在2017國際超級計算大會(ISC 2017)上亮相的機會,但隨后的第三方測試和它在全球超級計算大會(SC17)上的表現證明,EPYC處理器對提升很多高性能計算機的工作負荷具有一定的優勢。

在SC17上,AMD在2016年12月發布的一款GPU——Radeon Instinct也受到了廣泛的關注,該款GPU標志著AMD公司開始涉足機器學習領域。該款GPU雖然也能提供很強的浮點計算能力,但與英偉達V100的深度學習能力相比還是有很大的差距,因為英偉達公司在其產品上增加了專門用于加速神經網絡模型的算術單元。因此,AMD公司轉而選擇通過更開放的GPU支持軟件來吸引更多的用戶。

5、凱為(Cavium)半導體公司成為ARM高性能計算的重點

2016年5月,Cavium公司推出第二代系統級芯片——ThunderX2 ARM處理器,直到2017年,該款產品才受到消費者和供應商的關注。該處理器憑借其良好的性能、超大內存帶寬以及豐富的外部鏈接能力,戰勝了很多ARM處理器廠商的產品。

2017年,Atos/Bull、Cray、HPE等公司相繼選擇ThunderX2 ARM處理器來支持其高性能計算機的設計。隨著ARM生態日趨成熟,2018年高性能計算在框架設計方面有望取得重大突破。

6、微軟在高性能計算領域的影響力逐漸提升

2017年8月,微軟公司收購Cycle Computing公司,以加速其Azure公有云中的高性能計算,該舉措大大提升了微軟在高性能計算領域的競爭力。盡管微軟仍在Azure云中為其客戶提供NVIDIA GPU技術支持以滿足他們對于高性能計算、數據分析以及深度學習任務的需求,但從長期來看微軟還是在朝著大量應用現場可編程門陣列(FPGA)技術的方向發展。如果該計劃最終能實現的話,微軟有望引起那些更加注重計算性能的用戶對可重構計算的興趣,并最終成為這一技術領域的領導者。

7、量子計算成為研究熱點

2017年,量子計算是高性能計算領域發展最快的技術之一。短時間內,量子計算從晦澀難懂的研究項目一躍成為各大公司競相研究的技術。IBM和谷歌在2017年構建出功能越來越強大的量子計算機。IBM目前已經部署一臺具有20量子位的機器供用戶使用,并設計了一臺具有50量子位的原型機。與此同時,谷歌正在部署一臺具有22量子位的機器和一臺49量子位的機器。

2017年10月,Intel公司也向外界公布了量子計算領域規劃,并披露一款17量子位的處理器。同時,微軟將會研發一種拓撲結構的量子計算機,雖然該計劃還是處于研發階段,但微軟已經針對該技術研發成功了一個使用量子計算編程語言(Q#)的軟件包。同時歐洲公司Atos/Bull在2017年推出了一款40量子位的量子模擬器,這是在硬件開發方面的一大進步。

8、百億億次計算研究遇到瓶頸

同上一年相比,2017年各個國家和地區在百億億次級運算項目方面的競爭逐漸緩和了下來。究其原因,可能是因為各個國家和地區的相關技術已基本成熟,現在更多的是按照自己的節奏往前發展。

有分析師指出,高性能計算的未來進展并不一定在于實現百億億次級別的計算能力,而是通過機器學習技術來實現相應的功能。高性能計算和機器學習技術的融合甚至可能會重新定義百億億次運算系統的模式。

-

人工智能

+關注

關注

1804文章

48449瀏覽量

245043 -

機器學習

+關注

關注

66文章

8481瀏覽量

133864 -

高性能計算

+關注

關注

0文章

84瀏覽量

13580

原文標題:2017年高性能計算領域的成功與失敗

文章出處:【微信號:AItists,微信公眾號:人工智能學家】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

工業電機行業現狀及未來發展趨勢分析

汽車結構件焊接技術進展與應用分析

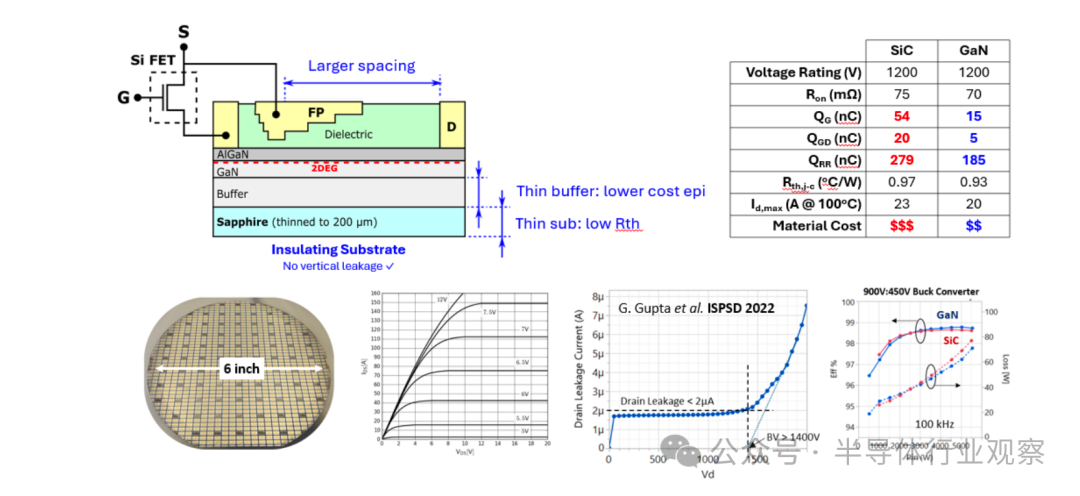

垂直氮化鎵器件的最新進展和可靠性挑戰

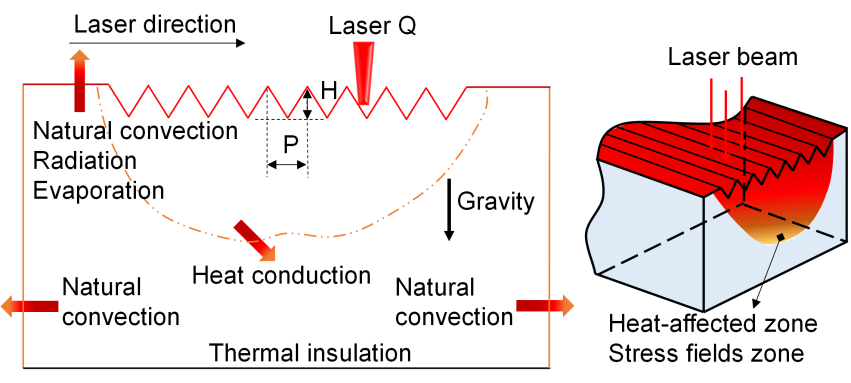

上海光機所在激光燒蝕波紋的調制機理研究中取得新進展

總結了高性能計算在2017年取得的新進展,以及未來發展趨勢

總結了高性能計算在2017年取得的新進展,以及未來發展趨勢

評論