使用LLaMA 3(Large Language Model Family of AI Alignment)進(jìn)行文本生成,可以通過(guò)以下幾種方式實(shí)現(xiàn),取決于你是否愿意在本地運(yùn)行模型或者使用現(xiàn)成的API服務(wù)。以下是主要的幾種方法:

方法一:使用現(xiàn)成的API服務(wù)

許多平臺(tái)提供了LLaMA 3的API接口,例如Hugging Face的Transformers庫(kù)和Inference API。

- 使用Hugging Face Transformers庫(kù) :

- 首先,確保你已經(jīng)安裝了

transformers庫(kù)和torch庫(kù)。bash復(fù)制代碼pip install transformers torch - 使用Hugging Face的pipeline進(jìn)行文本生成。

python復(fù)制代碼from transformers import pipeline # 加載LLaMA 3模型(注意:實(shí)際LLaMA 3模型可能非常大,需要額外下載) generator = pipeline("text-generation", model="meta-research/llama3-7b") # 這里使用7B版本作為示例 # 生成文本 prompt = "Once upon a time, in a faraway kingdom," output = generator(prompt, max_length=50, num_return_sequences=1) for i, text in enumerate(output): print(f"{i+1}: {text['generated_text']}")

- 首先,確保你已經(jīng)安裝了

- 使用Hugging Face Inference API :

- 注冊(cè)并獲取Hugging Face Spaces的API密鑰。

- 使用API進(jìn)行請(qǐng)求。

python復(fù)制代碼import requests import json HEADERS = { "Authorization": f"Bearer YOUR_API_KEY", "Content-Type": "application/json", } DATA = { "inputs": "Once upon a time, in a faraway kingdom,", "parameters": { "max_length": 50, "num_return_sequences": 1, }, } response = requests.post( "https://api-inference.huggingface.co/models/meta-research/llama3-7b", headers=HEADERS, data=json.dumps(DATA), ) print(response.json())

方法二:在本地運(yùn)行LLaMA 3

由于LLaMA 3模型非常大(從7B參數(shù)到65B參數(shù)不等),在本地運(yùn)行需要強(qiáng)大的計(jì)算資源(如多個(gè)GPU或TPU)。

- 準(zhǔn)備環(huán)境 :

- 確保你有一個(gè)強(qiáng)大的計(jì)算集群,并安裝了CUDA支持的PyTorch。

- 下載LLaMA 3的模型權(quán)重文件(通常從Hugging Face的模型庫(kù)中獲取)。

- 加載模型并生成文本 :

- 使用PyTorch加載模型并進(jìn)行推理。

python復(fù)制代碼import torch from transformers import AutoTokenizer, AutoModelForCausalLM # 加載模型和分詞器 tokenizer = AutoTokenizer.from_pretrained("meta-research/llama3-7b") model = AutoModelForCausalLM.from_pretrained("meta-research/llama3-7b") # 準(zhǔn)備輸入文本 prompt = "Once upon a time, in a faraway kingdom," inputs = tokenizer(prompt, return_tensors="pt") # 生成文本 outputs = model.generate(inputs.input_ids, max_length=50, num_return_sequences=1) # 打印生成的文本 print(tokenizer.decode(outputs[0], skip_special_tokens=True))

- 使用PyTorch加載模型并進(jìn)行推理。

注意事項(xiàng)

- 計(jì)算資源 :LLaMA 3模型非常大,尤其是更高參數(shù)版本的模型,需要強(qiáng)大的計(jì)算資源。

- 模型加載時(shí)間 :加載模型可能需要幾分鐘到幾小時(shí),具體取決于你的硬件。

- API限制 :如果使用API服務(wù),請(qǐng)注意API的調(diào)用限制和費(fèi)用。

通過(guò)上述方法,你可以使用LLaMA 3進(jìn)行文本生成。選擇哪種方法取決于你的具體需求和計(jì)算資源。

-

API接口

+關(guān)注

關(guān)注

1文章

85瀏覽量

10699

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

如何構(gòu)建文本生成器?如何實(shí)現(xiàn)馬爾可夫鏈以實(shí)現(xiàn)更快的預(yù)測(cè)模型

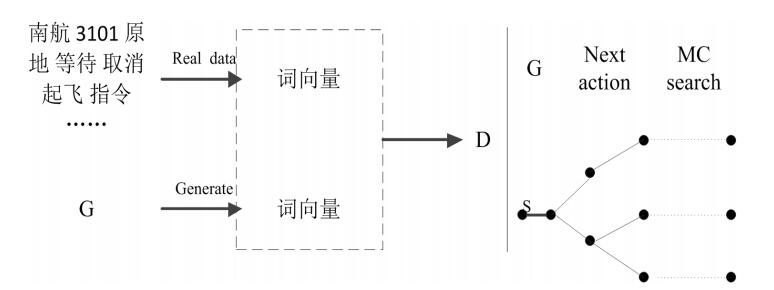

基于生成對(duì)抗網(wǎng)絡(luò)GAN模型的陸空通話(huà)文本生成系統(tǒng)設(shè)計(jì)

基于生成器的圖像分類(lèi)對(duì)抗樣本生成模型

基于生成式對(duì)抗網(wǎng)絡(luò)的深度文本生成模型

文本生成任務(wù)中引入編輯方法的文本生成

受控文本生成模型的一般架構(gòu)及故事生成任務(wù)等方面的具體應(yīng)用

基于GPT-2進(jìn)行文本生成

深度學(xué)習(xí)——如何用LSTM進(jìn)行文本分類(lèi)

基于VQVAE的長(zhǎng)文本生成 利用離散code來(lái)建模文本篇章結(jié)構(gòu)的方法

通俗理解文本生成的常用解碼策略

Meta提出Make-A-Video3D:一行文本,生成3D動(dòng)態(tài)場(chǎng)景!

ETH提出RecurrentGPT實(shí)現(xiàn)交互式超長(zhǎng)文本生成

面向結(jié)構(gòu)化數(shù)據(jù)的文本生成技術(shù)研究

Meta發(fā)布一款可以使用文本提示生成代碼的大型語(yǔ)言模型Code Llama

如何使用 Llama 3 進(jìn)行文本生成

如何使用 Llama 3 進(jìn)行文本生成

評(píng)論