測試結果并不一定意味著人工智能可以“理解”人。

心智理論是指可以理解他人心理狀態的能力,正是它驅使著人類社會運轉。它幫助你決定在緊張的情況下該說什么、猜測其他車輛的駕駛員將要做什么,以及與電影中的角色產生共鳴。一項最新的研究表明,ChatGPT等工具所使用的大語言模型在模仿這一典型人類特征方面表現得非常出色。

“在進行這項研究之前,我們都相信大語言模型無法通過這些測試,特別是那些判斷不易察覺的心理狀態能力的測試。”該研究的合著者克里斯蒂娜?貝奇奧(Cristina Becchio)說,她是德國漢堡-埃彭多夫大學醫學中心的認知神經科學教授。這項她認為“出乎意料和令人驚訝”的研究結果發表在2024年5月20日的《自然?人類行為》雜志中。

貝奇奧和她的同事并不是首先提出證據表明大語言模型的反應能夠表現這種推理能力的人。在2023年發表的一篇預印本論文中,斯坦福大學心理學家邁克爾?科辛斯基(Michal Kosinski)報告了幾個模型在幾種常見心智理論測試中的測試情況。他發現,其中最好的是OpenAI的GPT-4,它正確完成了75%的任務,他說,這相當于過去研究中6歲兒童的表現。不過,這項研究中的方法遭到了其他研究人員的批評,他們進行了后續實驗,并得出結論,大語言模型之所以能得出正確答案,往往是基于“淺顯的啟發”和捷徑,而不是真正基于心智理論推理。

本研究的作者很清楚這種爭論。“在論文中,我們的目標是使用廣泛的心理測試,以更加系統的方式來應對機器心智理論的評估挑戰。”該研究的合著者詹姆斯?斯特拉坎(James Strachan)說,他是一名認知心理學家,目前是漢堡-埃彭多夫大學醫學中心的訪問科學家。他指出,進行嚴謹的研究意味著要測試人類和大語言模型處理相同任務的能力,這項研究比較了1907個人與幾個流行的大語言模型的能力。

大語言模型和人類都完成了5種典型的心智理論測試,前3種是理解暗示、反語和失禮。此外,他們還回答了“錯誤信念”問題,這些問題通常用于確定幼兒心智理論的發展程度。這些問題是這樣的:如果愛麗絲在鮑勃不在房間的時候移動了某樣東西,那么鮑勃回來后應該去哪里找這個東西?最后,他們回答了“奇怪故事”中一些相當復雜的問題,這些故事中的人物相互撒謊、操縱并產生了很多誤解。

總體而言,GPT-4占據了優勢。它的得分在錯誤信念測試中與人類相當,在反語、暗示和奇怪故事方面的總分高于人類,只在失禮測試中表現不如人類。為了理解失禮測試結果有所不同的原因,研究人員對該模型進行了一系列后續測試,探索了幾種假設。他們得出的結論是,GPT-4能夠對有關失禮的問題給出正確答案,但在固執己見方面受到“極端保守”編程的限制。斯特拉坎指出,OpenAI在模型周圍設置了許多圍欄,“旨在保持模型真實、誠實和正確”,他認為,旨在防止GPT-4產生幻覺(即編造內容)的策略可能會妨礙它對一些問題輸出觀點,比如故事角色是否在高中同學聚會上無意間侮辱了老同學。

研究人員很謹慎。他們沒有說自己的研究結果表明大語言模型實際上擁有心智理論能力,而是說大語言模型“在心智理論任務中的表現與人類行為沒有區別”。這就引出了一個問題:如果一個仿品和真品一樣好,那你怎么知道它不是真品?斯特拉坎說,這是一個社會科學家以前從未嘗試回答的問題,因為對人類的測試會假設這種品質在某種程度上是存在的。“我們目前還沒有一種方法甚至是一種理念來測試心智理論的存在,這是一種現象學品質。”他說。

華盛頓大學計算語言學教授艾米麗?本德(Emily Bender)因堅持揭露人工智能行業的膨脹炒作而成為了該領域的傳奇人物。她對這個激勵著研究人員的問題提出了異議。“面對相同問題,文本處理系統能否產生與人類相似的答案為什么如此重要?”她問道,“我們能夠了解大語言模型內部是如何運作的嗎?它們可能有什么用處,又可能帶來哪些危險?”

本德對論文中的擬人化表示擔憂,論文研究人員說大語言模型有認知、推理和作出選擇的能力,還使用了“大語言模型和人類參與者之間的物種公平比較”這一措辭。本德說,這“完全沒有將軟件囊括在內”。

漢堡-埃彭多夫大學醫學中心團隊的研究結果可能并不表明人工智能真的能理解我們,但值得思考的是,人工智能能夠做出令人信服的行為,這會帶來什么影響。雖然這種大語言模型在與人類用戶交互和預測用戶需求方面會做得更好,但它們也可能更多地用于欺騙和操縱。它們會引來更多的擬人化,讓人類用戶相信用戶界面的另一端是有思想的。

-

人工智能

+關注

關注

1804文章

48788瀏覽量

246915

原文標題:人工智能在心智理論測試中戰勝人類

文章出處:【微信號:AI智勝未來,微信公眾號:AI智勝未來】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

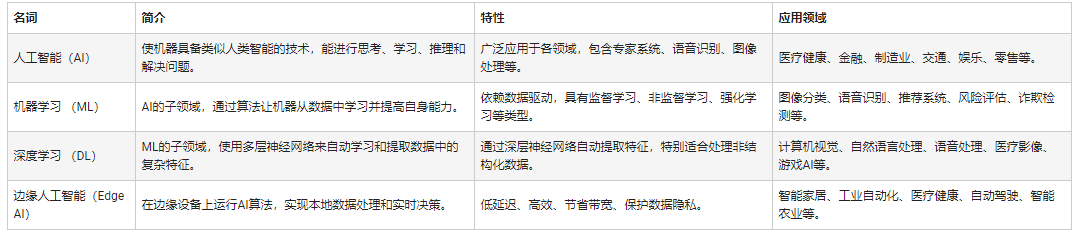

人工智能和機器學習以及Edge AI的概念與應用

心智理論測試:人工智能擊敗人類

心智理論測試:人工智能擊敗人類

評論