生成式預(yù)訓(xùn)練Transformer(GPT)被吹捧為將徹底改變機器人技術(shù)。但實際應(yīng)用中,GPT需要龐大且昂貴的計算資源、冗長的訓(xùn)練時間以及(通常)非機載無線控制,諸多限制之下,GPT技術(shù)真的實用嗎?

? 文章:

Are Transformers Truly Foundational for Robotics?

? 作者:

James A. R. Marshall, Andrew B. Barron

? 論文鏈接:

https://arxiv.org/abs/2411.16917

? 編譯:

INDEMIND

本文核心內(nèi)容

近年來,由于新型架構(gòu)GPT的發(fā)展和部署,生成式人工智能取得了重大進展。通過在深度神經(jīng)網(wǎng)絡(luò)中添加注意力機制并應(yīng)用于互聯(lián)網(wǎng)規(guī)模的訓(xùn)練集,Transformer極大地推動了自然語言處理和大語言模型(LLMs)的發(fā)展。在早期應(yīng)用之后,transformers與擴散模型等其他架構(gòu)一起被應(yīng)用于開發(fā)文本到圖像和視頻的視覺語言模型以及其他多模態(tài)應(yīng)用。這些成功激發(fā)了人們在機器人領(lǐng)域探索Transformer架構(gòu)的興趣。

在復(fù)雜環(huán)境中感知到的無結(jié)構(gòu)多模態(tài)輸入,以及機器人控制的高自由度,限制了機器人同時具備普遍適用性和魯棒性的發(fā)展。Transformer在機器人領(lǐng)域的潛力似乎是值得期待的。大規(guī)模訓(xùn)練可以針對更小規(guī)模的訓(xùn)練集進行專業(yè)化,從而為各種機器人任務(wù)提供通用且適應(yīng)性強的解決方案。由于可以在許多應(yīng)用領(lǐng)域中應(yīng)用,基于Transformer的方法被貼上了“基礎(chǔ)模型”的標簽,這意味著它們具有基礎(chǔ)性地位,只是仍不成熟。

Transformers起源于大語言模型(LLM)。LLM也已被證明在許多應(yīng)用中具有通用性和變革性,但它并非沒有局限性。正如我們下面所討論的,LLM在訓(xùn)練數(shù)據(jù)集大小、訓(xùn)練所需計算資源、訓(xùn)練成本以及行為輸出的魯棒性等方面存在越來越被認可的問題。在本文中,我們質(zhì)疑Transformer架構(gòu)是否真的能成為機器人學(xué)的基礎(chǔ)。我們想知道Transformer是否是實現(xiàn)通用人工智能的唯一或最佳途徑。我們提出,與“智能”不同,機器人系統(tǒng)的自主程度是明確定義的、可測量的,并且具有經(jīng)濟意義。

基于之前對GPT及其相關(guān)方法的批評,我們主張Transformer模型提供了一種仿真的自主性,而不是真正的自主性。然后,我們回顧了其他提出的替代方法。GPT解決自主機器人技術(shù)問題的方式與動物大腦通過生物方式實現(xiàn)自主行為控制的方式形成了鮮明對比。我們探討了這種對比,并提出當前GPT方法中缺失了什么,以及如何添加新內(nèi)容以增強機器人的穩(wěn)健性和可擴展的自主性。

將Transformer架構(gòu)應(yīng)用于自主系統(tǒng)的進展

Transforme在機器人自主性方面得到了迅速應(yīng)用。除了備受矚目的商業(yè)公告和演示外,學(xué)術(shù)界和工業(yè)界都已在同行評審的文獻中開發(fā)出完整的機器人自主性解決方案,重點是機器人導(dǎo)航和靈巧性。

盡管Transformer在機器人自主性方面的早期目標似乎正在實現(xiàn),但要實現(xiàn)通用且可擴展的解決方案,必須認識到這項技術(shù)仍然存在重大局限性,這將限制未來的性能和采用。盡管其中一些局限性可能會隨著新型技術(shù)開發(fā)和部署的傳統(tǒng)效率得到改善而變得不那么嚴重,但我們認為當前的Transformer架構(gòu)存在根本性的結(jié)構(gòu)性問題。

訓(xùn)練數(shù)據(jù)的規(guī)模和成本需求可能會增加

Transformer方法解決任何問題的核心是縮放要求。這些學(xué)習系統(tǒng)缺乏誘導(dǎo)偏置,因此具有高度的靈活性,但其代價是需要大量的訓(xùn)練數(shù)據(jù)。通常情況下,部署基于Transformer的基礎(chǔ)模型的模型是通過在互聯(lián)網(wǎng)規(guī)模的語料庫上進行訓(xùn)練,使模型獲得多模態(tài)對應(yīng)關(guān)系和領(lǐng)域知識,然后在較小的訓(xùn)練數(shù)據(jù)集上進一步進行特定任務(wù)的專門訓(xùn)練。這些成本非常高昂。即使不考慮環(huán)境影響,當前最先進的LLMs每輪訓(xùn)練的成本在數(shù)百萬美元至數(shù)千萬美元之間。對于機器人應(yīng)用,通常還需要針對特定任務(wù)(如導(dǎo)航和操作)進行進一步的訓(xùn)練。獲取良好訓(xùn)練數(shù)據(jù)集的可用性和成本被認為是一個主要問題。提出的解決方案包括創(chuàng)建涵蓋多種任務(wù)和機器人類型的開放數(shù)據(jù)集,盡管目前這些數(shù)據(jù)集可能只適用于相對較少的任務(wù)。還廣泛使用了基于物理學(xué)的模擬器來生成訓(xùn)練數(shù)據(jù)。我們認為,與LLMs類似,為了維持性能的提升,可能需要指數(shù)級增加的數(shù)據(jù)量。即使對于文本和多模態(tài)數(shù)據(jù)集,互聯(lián)網(wǎng)也提供了大量的免費訓(xùn)練數(shù)據(jù),但可用的訓(xùn)練數(shù)據(jù)仍可能成為限制因素。對于機器人數(shù)據(jù)集,無論是通過物理方式還是模擬方式收集有用的訓(xùn)練數(shù)據(jù),成本都將更加高昂。此外,由于Transformer性能的提升取決于訓(xùn)練數(shù)據(jù)規(guī)模和權(quán)重的增加,這個問題只會越來越嚴重。

計算和基礎(chǔ)設(shè)施成本及需求將持續(xù)存在

除了基于Transformer架構(gòu)的訓(xùn)練成本外,部署時的推理成本仍然可能相當高。例如,Meta的Llama3.1擁有云規(guī)模部署(405億雙精度參數(shù))。也有適用于在本地GPU上部署的減小尺寸和精度的版本(例如,8億半精度整數(shù)參數(shù)),這在推理時可能需要20-100GB的內(nèi)存。即使是運行在機器人上的最簡單的模型也需要相當大的GPU。雖然量化、二進制化和其他方法已被用于幫助設(shè)計邊緣AI加速器以加速深度和卷積神經(jīng)網(wǎng)絡(luò),但對于Transformer的問題規(guī)模要大得多。例如,對于深度神經(jīng)網(wǎng)絡(luò)研究中最廣泛應(yīng)用之一——目標檢測,一種最先進的算法具有數(shù)百萬至數(shù)千萬的網(wǎng)絡(luò)權(quán)重,而上述用于最先進LLM的權(quán)重則為80億至405億。這在規(guī)模上相差四個數(shù)量級,即使不考慮為機器人任務(wù)訓(xùn)練Transformer的額外要求。因此,人們正在積極研究避免云計算瓶頸的方法,包括采用新技術(shù),如6G、摩爾定律和新型并行計算架構(gòu),這些在過去曾拯救了人工智能和計算機軟件。然而,對于基礎(chǔ)模型來說,我們認為盡管可用的計算能力可以按指數(shù)級擴展,但模型大小和吞吐量的指數(shù)級需求將相互抵消。只有當前者的指數(shù)大于后者時,在追求性能提升的過程中才能實現(xiàn)實際的計算需求減少。然而,越來越多的人認為我們已經(jīng)進入了一個摩爾定律之后的時代,需要在材料方面進行進一步創(chuàng)新才能取得進展。

機器人中的Transformer可能出現(xiàn)幻覺

由于接受了統(tǒng)計學(xué)方面的訓(xùn)練和推斷,LLMs容易產(chǎn)生混淆和幻覺。與人類一樣,幻覺可能會以可能對機器人或他人造成傷害的方式顯現(xiàn),并且已經(jīng)展示了針對機器人技術(shù)中Transformer的守門人(guardrails)的對抗性攻擊。這可能需要人類作為遠程操作員繼續(xù)留在控制環(huán)路中,以確保機器人受到遠程監(jiān)督,或者需要將機器人與人類隔離開來,或者兩者兼而有之。當然,任何一種結(jié)果都會限制機器人技術(shù)所承諾的好處。其他研究人員也認為,統(tǒng)計方法在AI方面的結(jié)構(gòu)性問題,除非進行重大的架構(gòu)改變,否則不太可能得到解決。

Transformers賦予了仿真智能自主性

為什么transformers在機器人領(lǐng)域越來越受歡迎?我們將其歸因于兩個因素:首先,與LLMs和VLMs一樣,在傳統(tǒng)上非常困難的領(lǐng)域,如人形控制、操作和自然語言界面,已經(jīng)取得了顯著的早期進展。其次,我們認為,人類觀察者往往傾向于將機器擬人化,這導(dǎo)致他們賦予機器一些并不具備的技術(shù)能力和理解能力。

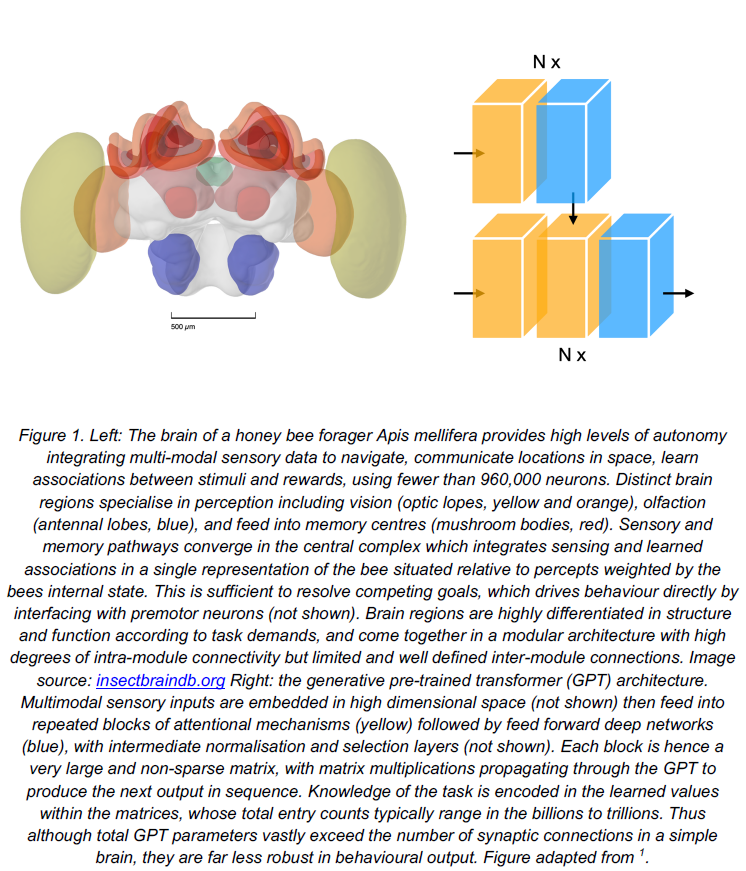

雖然有各種類型的Transformer,但其核心構(gòu)思是一個由自注意力塊(self-attentionblock)和多層感知器(multilayerperceptronblock)組成的重復(fù)單元(如圖1右側(cè)所示)。控制流是前饋的,而注意力機制則學(xué)習在預(yù)測下一個適當動作時應(yīng)關(guān)注輸入的哪些早期元素。與LLMs一樣,機器人領(lǐng)域中Transformer的強大和泛化能力都源于其廣泛的訓(xùn)練,使得訓(xùn)練完成后,它們可以執(zhí)行將輸入與預(yù)測輸出匹配的操作。在機器人領(lǐng)域中,Transformer成功地從輸入中解析并執(zhí)行動作,但這是通過對訓(xùn)練集進行插值和外推實現(xiàn)的,在離訓(xùn)練集的性能上存在不可靠的情況。Transformer沒有推理能力,也沒有理由選擇一個響應(yīng)而不是另一個,除了在訓(xùn)練后選擇的選項攜帶了最高的預(yù)測權(quán)重。LLMs的語言能力也可以用“隨機鸚鵡”來形容。

訓(xùn)練和借鑒已有經(jīng)驗也是生物自主決策的重要組成部分,但對于人類和其他動物來說,決策過程還受到對世界運行模式、其他相關(guān)行為體應(yīng)如何運作以及為何選擇的行動與當前情況相適應(yīng)的推理的支持。Transformers缺乏這些模型。

一個自主機器人的能力將受到訓(xùn)練數(shù)據(jù)范圍的限制。由于Transformer的響應(yīng)是訓(xùn)練數(shù)據(jù)的無理由產(chǎn)物,任何基于Transformer的應(yīng)用程序無法通過統(tǒng)計相關(guān)性以外的理由來證明其決策的合理性。這給任何形式的人機交互都帶來了嚴重的挑戰(zhàn)。如果我們問一個懷有良好意愿的人類同事為什么犯了錯誤,他們會盡最大努力解釋自己行為背后的道理。如果我們問一個基于Transformer的機器人為什么犯了錯誤,那么它不會有任何有道理的答案;對于這個問題的回答,至多只有相關(guān)性,而沒有與錯誤之間的因果關(guān)系。

用于自主性的Transformers的替代品和補充

如果Transformers不是問題的全部答案,那么什么才是呢?下面我們將回顧主要的替代方案,重點介紹我們偏好的方法,該方法從生物大腦解決自主性問題的方式中汲取了深刻靈感。

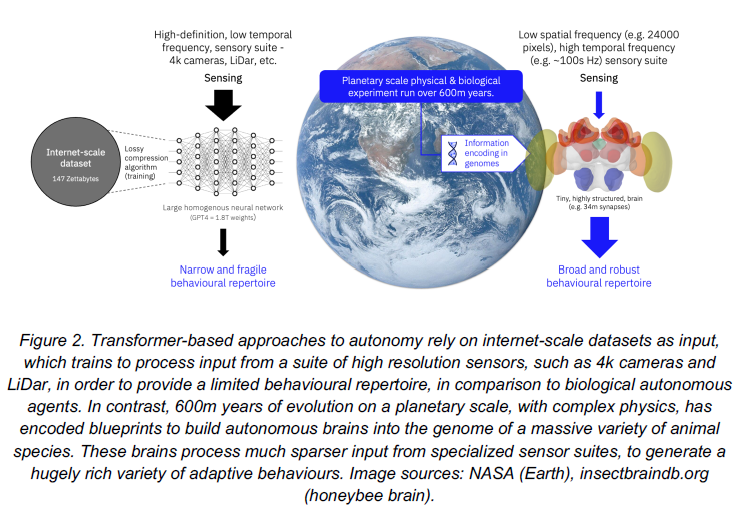

自然智能

圖1顯示了機器人技術(shù)與生物大腦產(chǎn)生自主行為之間的巨大差距。通常,人們將LLMs、GPTs與人類推理進行比較,但與動物大腦和動物推理的比較更為明顯。例如,蜜蜂的大腦很小(僅略大于1立方毫米),包含的神經(jīng)元數(shù)量不到100萬29。蜜蜂大腦的突觸數(shù)量尚未知曉,但如果我們根據(jù)果蠅的連接組(connectome)進行推測,蜜蜂大腦的突觸數(shù)量將少于5億個(圖1,左)。顯然,蜜蜂僅憑這些就足以可靠地在長達數(shù)公里的距離上導(dǎo)航,自主地從環(huán)境中采集花粉和花蜜,進行溝通和協(xié)調(diào),并完成所有必要的工作,包括養(yǎng)育下一代。它們可以解決復(fù)雜的覓食經(jīng)濟問題,重點是其蜂群所需的資源,并從環(huán)境中分散分布的隱蔽和短暫的花朵中采集它們31。蜜蜂無需練習就能飛行,在蜂巢周圍進行20分鐘有組織的飛行訓(xùn)練就足以使它們能夠熟練地在環(huán)境中導(dǎo)航。與需要長時間訓(xùn)練的變形者相比,這種對比再明顯不過了。蜜蜂大腦在進行完全自主的決策時的能量消耗與任何GPT相比都是微不足道的。與transformers不同,動物的大腦在行星尺度上已經(jīng)進行了大規(guī)模的“預(yù)訓(xùn)練”,能夠使用最少的信息生成非常廣泛的行為(如圖2所示)。

弱小的蜜蜂在計算能力、能量消耗和訓(xùn)練時間上如何優(yōu)于Transformer?

一句話——結(jié)構(gòu)。Transformer的通用性和優(yōu)雅性是因為在預(yù)訓(xùn)練之前,它們在功能上沒有結(jié)構(gòu)上的差異。相反,昆蟲大腦是一個結(jié)構(gòu)-功能專門化的案例研究。昆蟲大腦被細分為模塊(如圖1左側(cè)所示)。每個模塊都專門用于處理自主決策挑戰(zhàn)的不同領(lǐng)域。每個模塊中的每個專業(yè)化都利用其處理信息的規(guī)律性和屬性來減少計算量并提高整體系統(tǒng)效率。例如,蜜蜂、螞蟻和蒼蠅大腦中的專用模塊處理太陽周圍產(chǎn)生的偏振光圖案。這是一個有價值且穩(wěn)定的導(dǎo)航線索。其結(jié)構(gòu)由拓撲處理器——中央復(fù)合體的前腦橋——保存,該處理器將輸出發(fā)送到一個區(qū)域,該區(qū)域作為環(huán)形吸引子來確定動物相對于外部線索的方位。這又連接到另一個專門處理視覺信息的區(qū)域。

這種專門化不僅限于視覺處理。例如,蒼蠅的大腦中有專門處理氣味的模塊,蜜蜂的大腦中有專門處理視覺和氣味信息的模塊。每個模塊的結(jié)構(gòu)和功能專門化都使它們能夠更有效地處理特定類型的信息,從而減少計算量并提高整體系統(tǒng)效率。

相比之下,Transformer在預(yù)訓(xùn)練之前沒有結(jié)構(gòu)上的專門化,這使得它們在處理不同類型的信息時效率較低。例如,在圖像識別任務(wù)中,Transformer需要對整個圖像進行處理,這需要大量的計算資源和能量。而蜜蜂的大腦只需要處理來自太陽的偏振光圖案,這只需要很少的計算資源和能量。

因此,盡管Transformer在某些任務(wù)上的性能優(yōu)于蜜蜂的大腦,但在計算能力、能量消耗和訓(xùn)練時間方面,蜜蜂的大腦通常表現(xiàn)出更好的性能。該模塊在空間上按方位排列,并能夠支持昆蟲對外部物體的相對定位。昆蟲大腦中對外部世界的規(guī)律性是如何進行編碼的,這傳達了一種直觀的物理學(xué)(盡管與人工智能中使用的物理學(xué)引擎類型有很大不同)。嗅覺和視覺感覺葉各自專門處理其感官領(lǐng)域的輸入特性。感覺葉會銳化、增強并最終壓縮感官信號,以便投射到多模態(tài)感覺整合區(qū)域。其中最大的是蘑菇體,其結(jié)構(gòu)類似于三層神經(jīng)網(wǎng)絡(luò)的擴展中間層。這似乎特別擅長多模態(tài)分類。

昆蟲缺乏人類的陳述性推理能力,但它們的推理是建立在一種基本的世界模型之上的。昆蟲擁有一個統(tǒng)一且連貫的外部空間表征,在其中它們對周圍的物體具有第一人稱視角。物體的極性受到昆蟲與其之間學(xué)習經(jīng)驗、固有極性和主觀生理狀態(tài)的影響。物體極性和位置的差異決定了昆蟲的選擇。這種推理方式或許很簡單,但它仍然比那些沒有理由的“變形金剛”更易于理解和明確。越來越多的人認識到,人工智能可以從昆蟲神經(jīng)科學(xué)中汲取概念和算法,從而獲得巨大的益處。

目標:AI與世界模型

其他研究人員提出,動物(包括那些比人類“更簡單”的動物)的自主能力確實可以為AI研究人員提供靈感。然而,這種靈感比上述的自然智能方法要松散得多。雖然“客觀AI”方法確實提出了與在神經(jīng)科學(xué)、認知科學(xué)和心理學(xué)中對人類大腦的理解相匹配的模塊化AI架構(gòu),但這一提法實際上大不相同;與其直接試圖逆向工程專業(yè)腦模塊中的神經(jīng)回路,不如設(shè)計可訓(xùn)練的模塊,以便相互交互以產(chǎn)生比大型未分化神經(jīng)網(wǎng)絡(luò)預(yù)期的更適應(yīng)性行為。因此,例如,與其直接試圖理解早期靈長類視覺系統(tǒng)中的特征檢測器如何工作,不如訓(xùn)練一個特征檢測器模塊。該提案的關(guān)鍵部分是重新引入顯式和可配置的世界模型,從認知科學(xué)中汲取靈感;然而,這些模型也仍然需要從數(shù)據(jù)中學(xué)習。

混合方法

另有一些研究人員基于一項長期以來的提議,但同時又從人工智能領(lǐng)域的最新發(fā)展中獲得了新的動力,提出了“神經(jīng)符號方法”。該方法認為,雖然深度神經(jīng)網(wǎng)絡(luò)非常適合諸如物體檢測等感知任務(wù),但它們在本質(zhì)上并不適合推理、規(guī)劃和決策過程中的符號操作。在Transformer的背景下,最近的觀察表明,LLMs無法有效地處理和操作符號知識。因此該提案是將統(tǒng)計AI的感知優(yōu)勢與較老的、符號化的AI方法的因果優(yōu)勢結(jié)合起來。鑒于大腦中符號推理的神經(jīng)基礎(chǔ)尚未被充分理解,這是一種特別務(wù)實的方法。通過繞過它們在處理現(xiàn)實世界感知復(fù)雜性時遇到的問題,希望可以緩解第一波符號AI的局限性。我們建議,可以將自然智能方法應(yīng)用于對空間和決策選項集的感知和建模,以實現(xiàn)更強大的組合。

總結(jié)

Transformer架構(gòu)已經(jīng)將它們在自然語言和多模態(tài)AI領(lǐng)域取得的巨大進步帶到了機器人領(lǐng)域。然而,仍然需要繼續(xù)尋找解決機器人自主性的方案。Transformer架構(gòu)從純統(tǒng)計的角度來處理世界,盡管其基礎(chǔ)是感知輸入。這可能是對“苦澀教訓(xùn)”的一種有意識的選擇,即人工智能歷史上的歸納偏見。然而,這導(dǎo)致了與唯一真正自主的人類制品——生物大腦——運作方式完全不同的自主性解決方案。我們在這里強調(diào)了這一點,并認為,隨著對各種大腦的大量數(shù)據(jù)和理解的巨大進步,是時候重新審視“苦澀教訓(xùn)”,看看從對它們的研究中可以為AI學(xué)到哪些新的教訓(xùn)。

-

機器人

+關(guān)注

關(guān)注

213文章

29749瀏覽量

213010 -

Transformer

+關(guān)注

關(guān)注

0文章

151瀏覽量

6525 -

LLM

+關(guān)注

關(guān)注

1文章

325瀏覽量

850

原文標題:Transformer真的是機器人技術(shù)的基礎(chǔ)嗎?

文章出處:【微信號:gh_c87a2bc99401,微信公眾號:INDEMIND】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

Transformer是機器人技術(shù)的基礎(chǔ)嗎

Transformer是機器人技術(shù)的基礎(chǔ)嗎

評論