作者:Arm 基礎設施事業部高級產品經理 Ashok Bhat

由 Arm Neoverse V2 平臺賦能的 Google Axion 處理器已在 Google Cloud 上正式上線,其中,C4A 是首款基于 Axion 的云虛擬機,為基于 CPU 的人工智能 (AI) 推理和通用云工作負載實現了顯著的性能飛躍。

Axion CPU 延續了 Google Cloud 的定制芯片計劃,旨在提高工作負載性能和能效,標志著在重塑 AI 云計算格局方向上的重大進步。Google 選擇 Arm Neoverse 平臺是因為它具備高性能、高能效和創新靈活性,而且有著強大的軟件生態系統和廣泛的行業應用,可確保與現有應用的輕松集成。

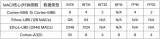

Neoverse V2 平臺引入了新的硬件擴展,例如 SVE/SVE2、BF16 和 i8mm,與上代 Neoverse N1 相比,顯著增強了機器學習性能。這些擴展增強了向量處理、BFloat16 運算和整數矩陣乘法,使得基于 Neoverse V2 的 CPU 每周期執行的 MAC 運算次數比 N1 提高最多四倍。

從生成式 AI 到計算機視覺:加快 AI 工作負載推理速度并提升性能

立足于開源為原則的 AI 具備眾多領先的開源項目。近年來,Arm 一直與合作伙伴開展密切合作,以提高這些開源項目的性能。在許多情況下,我們會利用 Arm Kleidi 技術來提高 Neoverse 平臺上的性能,Kleidi 技術可通過 Arm Compute Library 和 KleidiAI 庫訪問。

大語言模型

由 Meta 開發的 Llama 模型包含一系列先進的大語言模型 (LLM),專為各種生成任務而設計,模型大小從 10 億到 4,050 億個參數不等。這些模型針對性能進行了優化,并可針對特定應用進行微調,因而在自然語言處理任務中用途廣泛。

Llama.cpp 是一個 C++ 實現方案,可以在不同的硬件平臺上實現這些模型的高效推理。它支持 Q4_0 量化方案,可將模型權重減少為 4 位整數。

為了展示基于 Arm 架構的服務器 CPU 在 LLM 推理方面的能力,Arm 軟件團隊和 Arm 合作伙伴對 llama.cpp 中的 int4 內核進行了優化,以利用這些新的指令。具體來說,我們增加了三種新的量化格式:為僅支持 Neon 的設備添加了 Q4_0_4_4,為支持 SVE/SVE2 和 i8mm 的設備添加了 Q4_0_4_8,為支持 SVE 256 位的設備添加了 Q4_0_8_8。

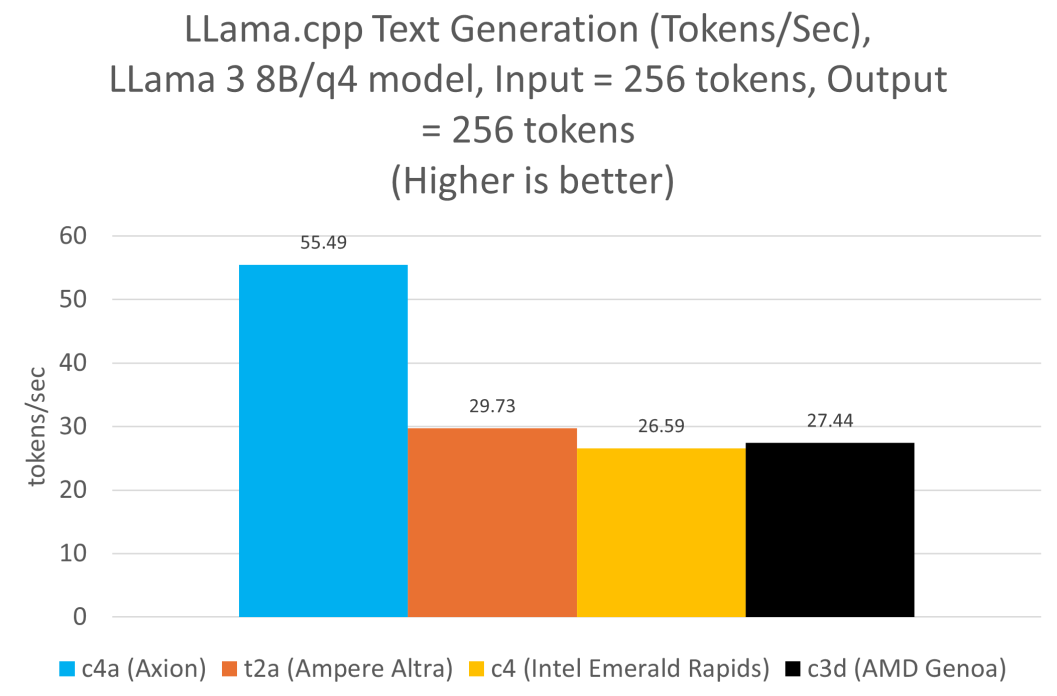

因此,與當前的 x86 架構實例相比,基于 Axion 的虛擬機在提示詞處理和詞元 (token) 生成方面的性能高出兩倍。

我們在所有實例上運行了 Llama 3.1 8B 模型,并對每個實例使用了推薦的 4 位量化方案。Axion 的數據是在 c4a-standard-48 實例上使用 Q4_0_4_8 量化方案生成的,而 Ampere Altra 的數據是在 t2a-standard-48 實例上使用 Q4_0_4_4 生成的。x86 架構的數據是在 c4-standard-48 (Intel Emerald Rapids) 和 c3d-standard-60 (AMD Genoa) 上使用 Q4_0 量化格式生成的。在所有實例中,線程數始終設置為 48。

BERT

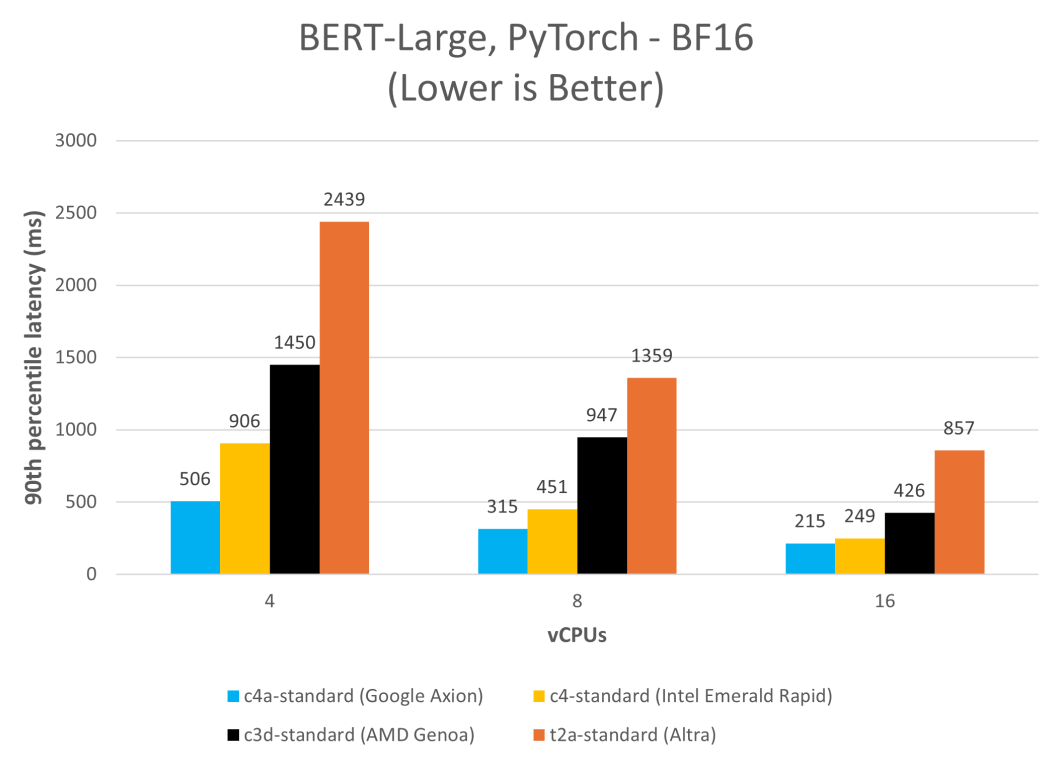

在 C4A 虛擬機上運行 BERT 取得了顯著的速度提升,大幅減少了延遲并提高了吞吐量。此例中,我們在各種 Google Cloud 平臺實例上以單流模式(批量大小為 1)使用 PyTorch 2.2.1 運行 MLPerf BERT 模型,并測量第 90 百分位的延遲。

ResNet-50

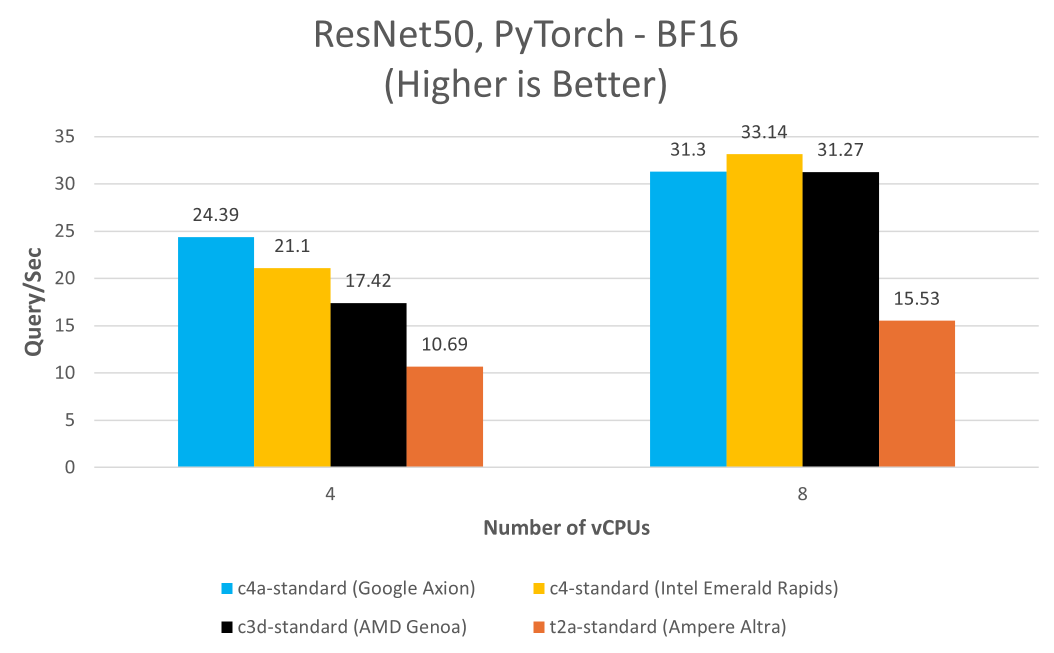

此外,Google Axion 的功能不僅限于 LLM,還可應用于圖像識別模型,例如 ResNet-50 就能受益于此硬件的先進特性。BF16 和 i8mm 指令集成后,實現了更高的精度和更快的訓練速度,展現了 Axion 相較基于 x86 架構實例的性能優勢。

此例中,我們在各種 Google Cloud 平臺實例上以單流模式(批量大小為 1)使用 PyTorch 2.2.1 運行 MLPerf ResNet-50 PyTorch 模型。

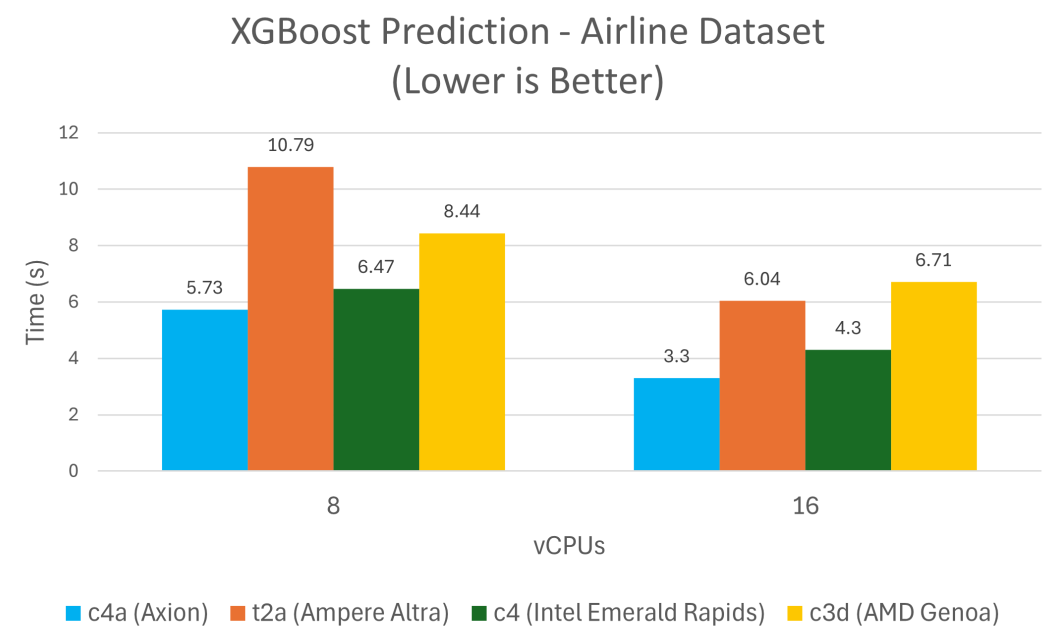

XGBoost

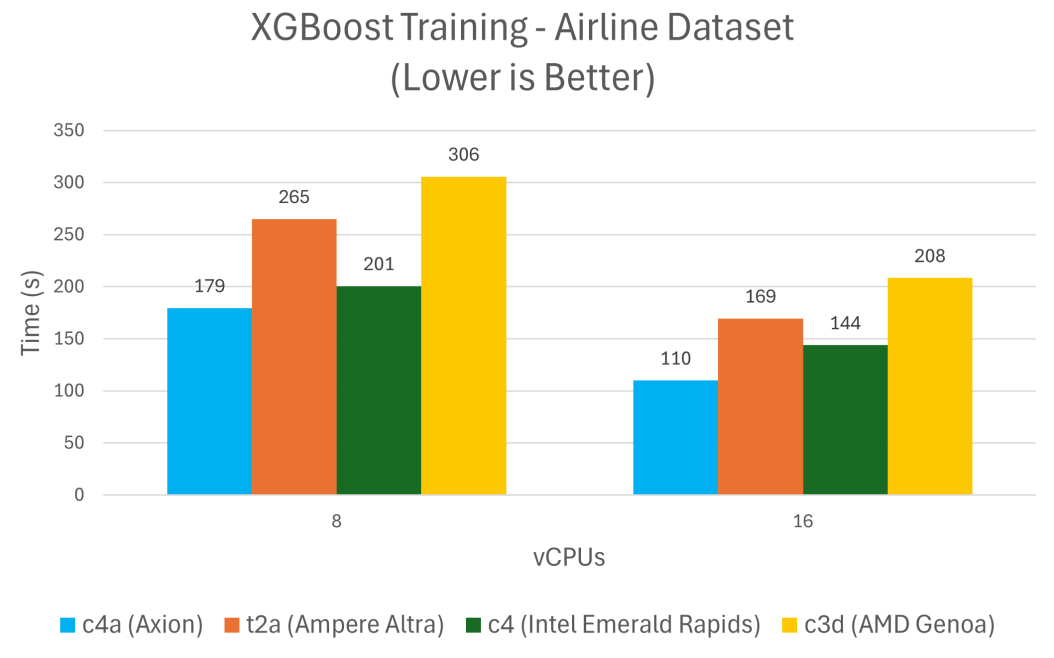

XGBoost 是一個領先的機器學習算法庫,用于解決回歸、分類和排序問題,與 Google Cloud 上類似的 x86 架構實例相比,在 Axion 上訓練和預測所需的時間減少了 24% 到 48%。

結論

從上述結果,可以發現基于 Axion 的虛擬機在性能方面超越了上一代基于 Neoverse N1 的虛擬機和 Google Cloud 上其他的 x86 架構替代方案。Google Cloud C4A 虛擬機能夠處理從 XGBoost 等傳統機器學習任務到 Llama 等生成式 AI 應用的各類工作負載,是AI 推理的理想之選。

Arm 資源:助力云遷移

為了提升 Google Axion 的使用體驗,Arm 匯集了各種資源:

[1] 通過 Arm Learning Paths 遷移到 Axion:依照詳細的指南和最佳實踐,簡化向 Axion 實例的遷移。

[2] Arm Software Ecosystem Dashboard:獲取有關 Arm 的最新軟件支持信息。

[3] Arm 開發者中心:無論是剛接觸 Arm 平臺,還是正在尋找開發高性能軟件解決方案的資源,Arm 開發者中心應有盡有,可以幫助開發者構建更卓越的軟件,為數十億設備提供豐富的體驗。歡迎開發者在 Arm 不斷壯大的全球開發者社區中,下載內容、交流學習和討論。

-

ARM

+關注

關注

134文章

9309瀏覽量

375059 -

計算機

+關注

關注

19文章

7630瀏覽量

90189 -

AI

+關注

關注

87文章

34256瀏覽量

275411 -

Neoverse

+關注

關注

0文章

12瀏覽量

4752

原文標題:基于 Arm Neoverse 的 Google Axion 以更高性能加速 AI 工作負載推理

文章出處:【微信號:Arm社區,微信公眾號:Arm社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

解讀基于Arm Neoverse V2平臺的Google Axion處理器

Banana Pi 發布 BPI-AI2N & BPI-AI2N Carrier,助力 AI 計算與嵌入式開發

Oracle 與 NVIDIA 合作助力企業加速代理式 AI 推理

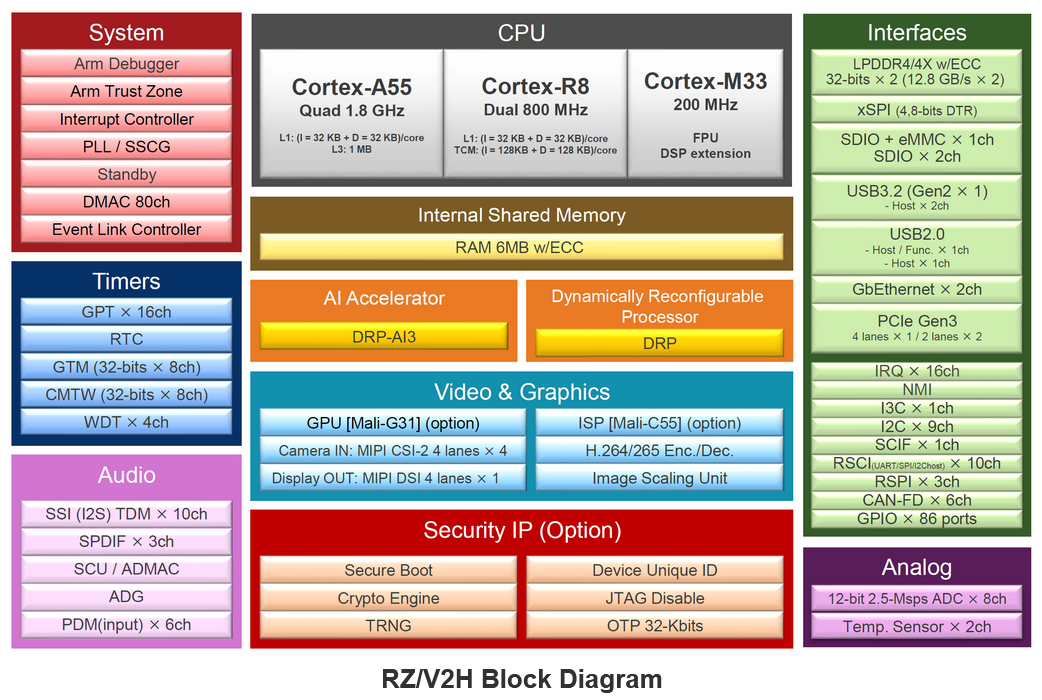

AI MPU# 瑞薩RZ/V2H 四核視覺 ,采用 DRP-AI3 加速器和高性能實時處理器

Arm Cortex-A320 CPU助力嵌入式設備實現高能效AI計算

Arm KleidiAI助力提升PyTorch上LLM推理性能

Google AI技術助力中國品牌出海增長

ARM處理器的尋址方式

英特爾?至強?可擴展處理器助力智慧醫療的數字化轉型

AMD助力HyperAccel開發全新AI推理服務器

英特爾? 酷睿? Ultra 處理器面向多行業加速AI產業升級

Arm技術助力Google Axion處理器加速AI工作負載推理

Arm技術助力Google Axion處理器加速AI工作負載推理

評論