01性能炸裂

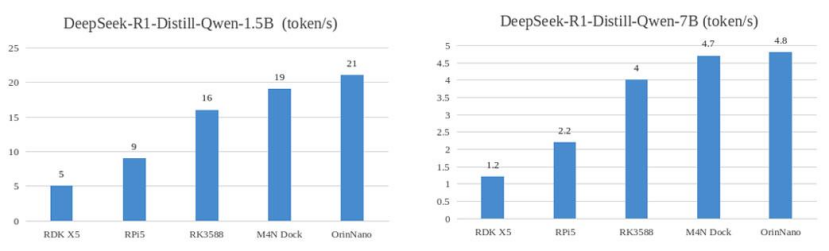

速度領先RK358815%,性能直逼OrinNano!

久等了!矽速 M4N Dock(愛芯派Pro,AX650N) 已支持部署 DeepSeek R1 大模型,實測運行速度超越 RK3588 達15% ,距離 40TOPS 算力的 Nvidia Orin Nano 8G版僅差10% !

圖1:DeepSeek-R1 Distill Qwen 運行速度對比

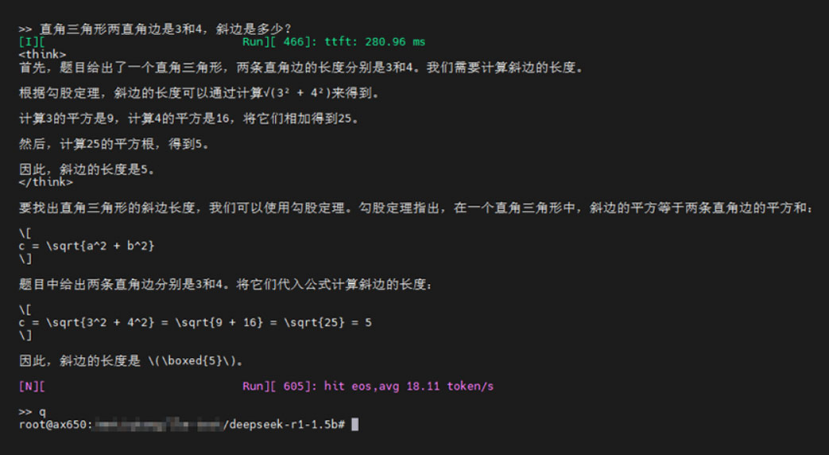

圖2:運行實測圖

02開發者福利

開源模型+一鍵部署!

為助力開發者快速上手,現已開源 DeepSeek-R1-Distill-Qwen-1.5B 輕量化模型,支持 GPTQ-Int4 高效推理!

模型下載:Huggingface倉庫直達 鏡像支持:基于Ubuntu系統的最新鏡像 AX650_pipro_box_ubuntu_rootfs_desktop_V1.45.0內置預裝環境,用戶root,密碼1234566,

03

即刻入手

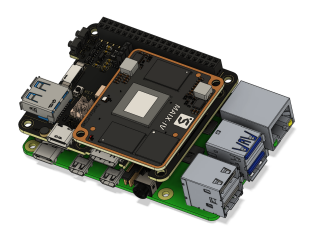

M4N Dock,體驗極致性能!

圖3:M4N Dock產品圖

超高性價比,AI推理性能比肩旗艦支持多模態大模型部署即插即用,開發板+算法一站式體驗立即購買:Sipeed官方店

04

新品劇透

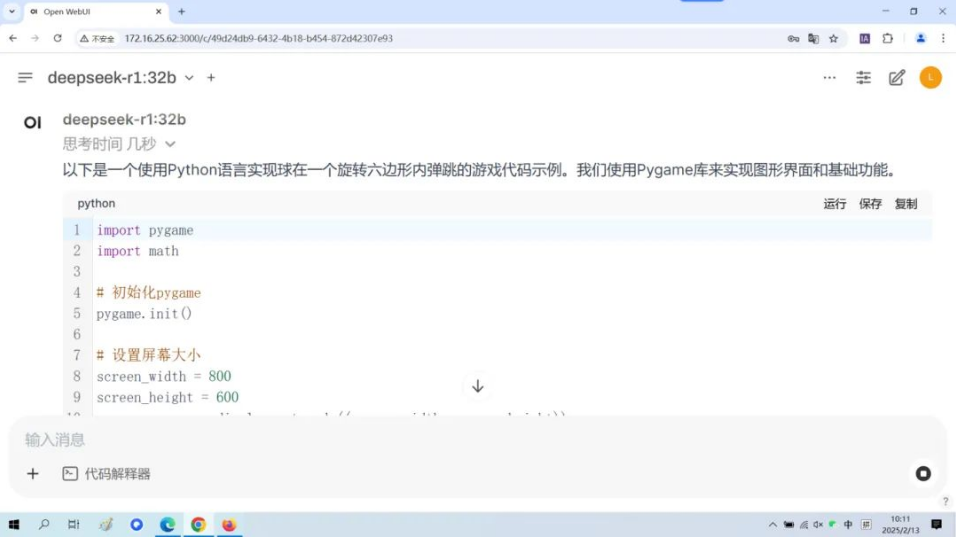

百元級LLM硬件即將登場!

2025年矽速科技將推出 MaixHAT —— 百元級端側大模型硬件平臺!

圖4:MaixHAT產品預覽圖

核心優勢

支持串口LLM推理,可獨立運行或作為開發模塊

高性價比,加速AIoT產品落地

發布日期:未來2個月內,敬請期待!

-

RK3588

+關注

關注

7文章

409瀏覽量

5667 -

大模型

+關注

關注

2文章

3062瀏覽量

3908 -

DeepSeek

+關注

關注

1文章

785瀏覽量

1489

發布評論請先 登錄

DeepSeek R1模型本地部署與產品接入實操

【幸狐Omni3576邊緣計算套件試用體驗】DeepSeek 部署及測試

RK3588開發板上部署DeepSeek-R1大模型的完整指南

研華發布昇騰AI Box及Deepseek R1模型部署流程

研華邊緣AI Box MIC-ATL3S部署Deepseek R1模型

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

Deepseek R1大模型離線部署教程

端側AI元年爆發!廣和通AI模組及解決方案全面支持DeepSeek-R1蒸餾模型

部署DeepSeek R1于AX650N與AX630C平臺

扣子平臺支持DeepSeek R1與V3模型

deepin UOS AI接入DeepSeek-R1模型

云天勵飛上線DeepSeek R1系列模型

重磅發布 | 矽速 M4N Dock 支持 DeepSeek R1,端側大模型部署新標桿!

重磅發布 | 矽速 M4N Dock 支持 DeepSeek R1,端側大模型部署新標桿!

評論