日前,為了使 deepin 和 UOS AI 更加開(kāi)放,我們正式開(kāi)放了 UOS AI 的模型接入接口。這意味著,所有符合 OpenAI 接口格式的大模型,都可以無(wú)縫接入 UOS AI。大家可以根據(jù)自身需求,自由接入心儀的大模型,讓 UOS AI 成為更具個(gè)性化的智能伙伴。

在上一篇文章中,我們?yōu)榇蠹以敿?xì)介紹了 UOS AI 如何離線(xiàn)或在線(xiàn)接入 DeepSeek-R1 模型。今天我們將進(jìn)一步深入,為大家詳細(xì)講解如何借助 Ollama 在本地部署并運(yùn)行 DeepSeek-R1 模型。

* 感謝社區(qū)用戶(hù)「Feelup」提供的教程,本次本地部署在 deepin 25 Preview 環(huán)境中通過(guò)Ollama 完成。

1

Ollama 部署

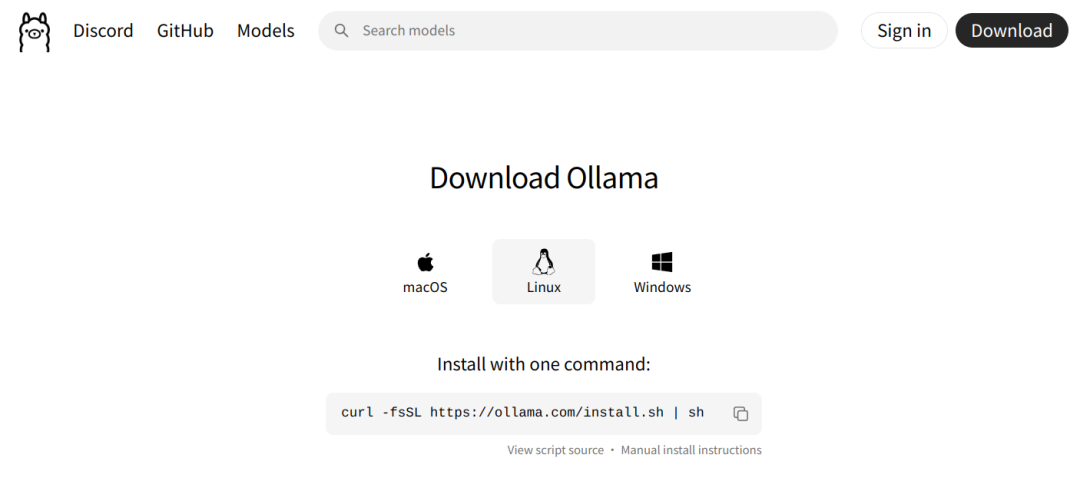

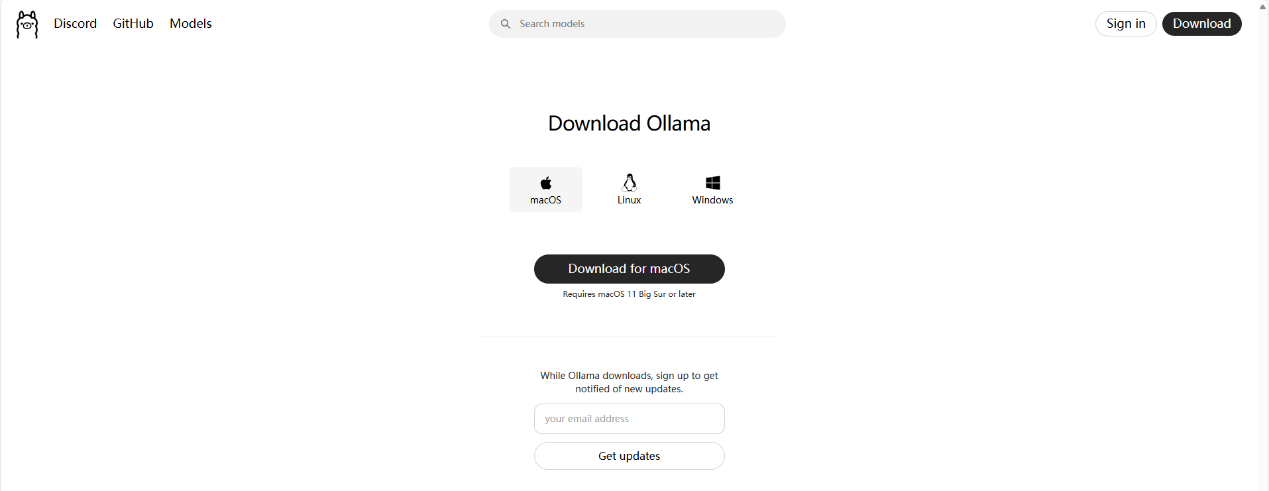

進(jìn)入 Ollama 網(wǎng)站并復(fù)制 Linux 下需要使用的命令,并粘貼到終端中執(zhí)行。

Ollama下載完成后,通過(guò)以下命令可查看當(dāng)前 Ollama 版本

ollama --version

2

Ollama 服務(wù)配置

說(shuō)明1:若您只希望簡(jiǎn)單使用,可跳過(guò)此處服務(wù)配置。 說(shuō)明2:此處 Ollama 服務(wù)配置主要調(diào)整了 Ollama 下載模型文件的保存位置和服務(wù)訪(fǎng)問(wèn)限制調(diào)整。

sudo vim /etc/systemd/system/ollama.service默認(rèn)的配置文件內(nèi)容

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/local/bin/ollama serve User=ollama Group=ollama Restart=always RestartSec=3 Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin" [Install] WantedBy=default.target

非 deepin 25 服務(wù)修改參考

該 Ollama 服務(wù)配置適用于 Ubuntu、RedHat、deepin 23 等大多數(shù) Linux 系統(tǒng)

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/local/bin/ollama serve User=nano #此處為當(dāng)前的用戶(hù)名(可選:如果調(diào)整了模型的下載保存位置的話(huà),可解決權(quán)限問(wèn)題) Group=nano #此處為當(dāng)前的用戶(hù)名(可選:如果調(diào)整了模型的下載保存位置的話(huà),可解決權(quán)限問(wèn)題) Restart=always RestartSec=3 Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin" Environment="OLLAMA_MODELS=/media/nano/Date/Ollama_Models" #可選:設(shè)置模型的下載位置 Environment="OLLAMA_HOST=0.0.0.0:11434" #可選:設(shè)置可訪(fǎng)問(wèn)ollama服務(wù)的地址與端口(此處表示任意IP地址都可以從端口11434訪(fǎng)問(wèn)此ollama服務(wù)) [Install] WantedBy=default.target

deepin 25 服務(wù)修改參考

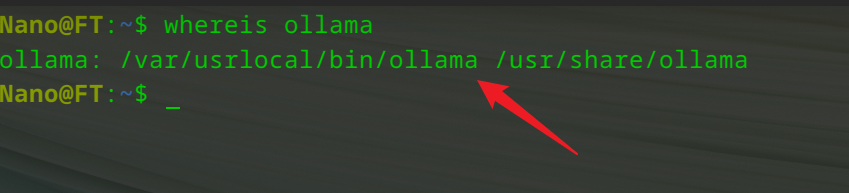

由于 deepin 25 采用了不可變系統(tǒng)設(shè)計(jì),Ollama 安裝完成后,程序的執(zhí)行文件位置出現(xiàn)了一些變化。

在進(jìn)行 Ollama 服務(wù)配置時(shí)也需要做相應(yīng)的修改(否則可能會(huì)出現(xiàn)服務(wù)運(yùn)行異常)

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/var/usrlocal/bin/ollama serve #此處調(diào)整了ollama程序的位置 User=nano #此處為當(dāng)前的用戶(hù)名(可選:如果調(diào)整了模型的下載保存位置的話(huà),可解決權(quán)限問(wèn)題) Group=nano #此處為當(dāng)前的用戶(hù)名(可選:如果調(diào)整了模型的下載保存位置的話(huà),可解決權(quán)限問(wèn)題) Restart=always RestartSec=3 Environment="PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin" Environment="OLLAMA_MODELS=/media/nano/Date/Ollama_Models" #可選:設(shè)置模型的下載位置 Environment="OLLAMA_HOST=0.0.0.0:11434" #可選:設(shè)置可訪(fǎng)問(wèn)ollama服務(wù)的地址與端口(此處表示任意IP地址都可以從端口11434訪(fǎng)問(wèn)此ollama服務(wù)) [Install] WantedBy=default.target

3

Ollama服務(wù)啟動(dòng)

更新服務(wù)配置:

sudo systemctl daemon-reload重啟 Ollama 服務(wù):

sudo systemctl restart ollama.service查看 Ollama 服務(wù)運(yùn)行狀態(tài):

systemctl status ollama.service

4

DeepSeek-R1模型下載

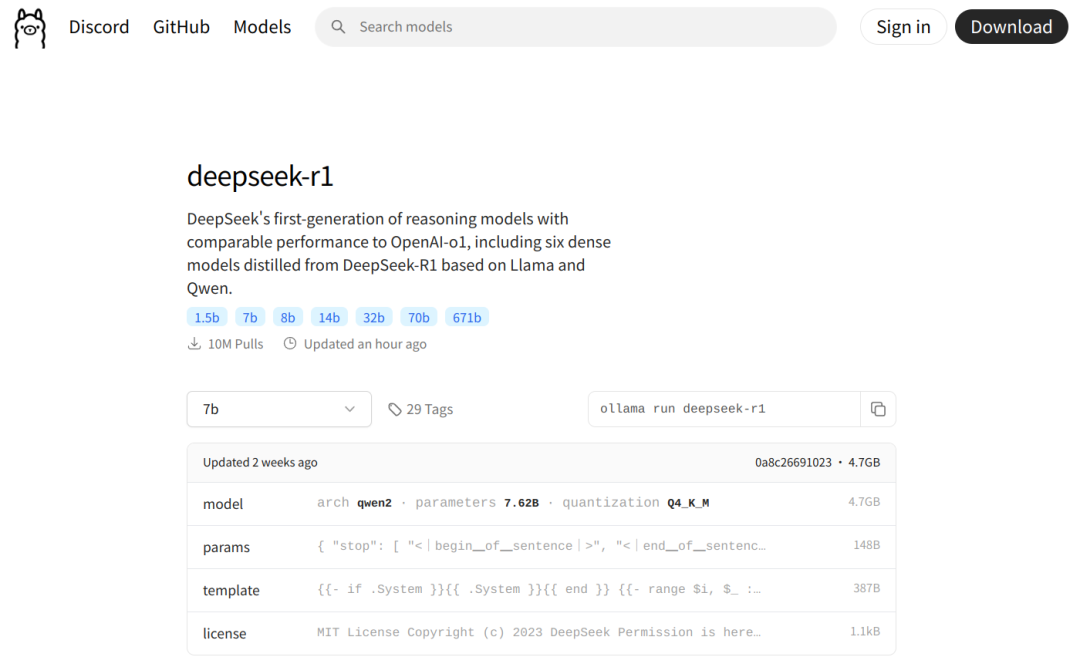

在 Ollama 站內(nèi)檢索您所需要下載的模型名稱(chēng)關(guān)鍵字,根據(jù)個(gè)人電腦配置選擇合適大小的參數(shù)模型,點(diǎn)擊復(fù)制模型下載命令,并將命令粘貼到終端中進(jìn)行下載即可。

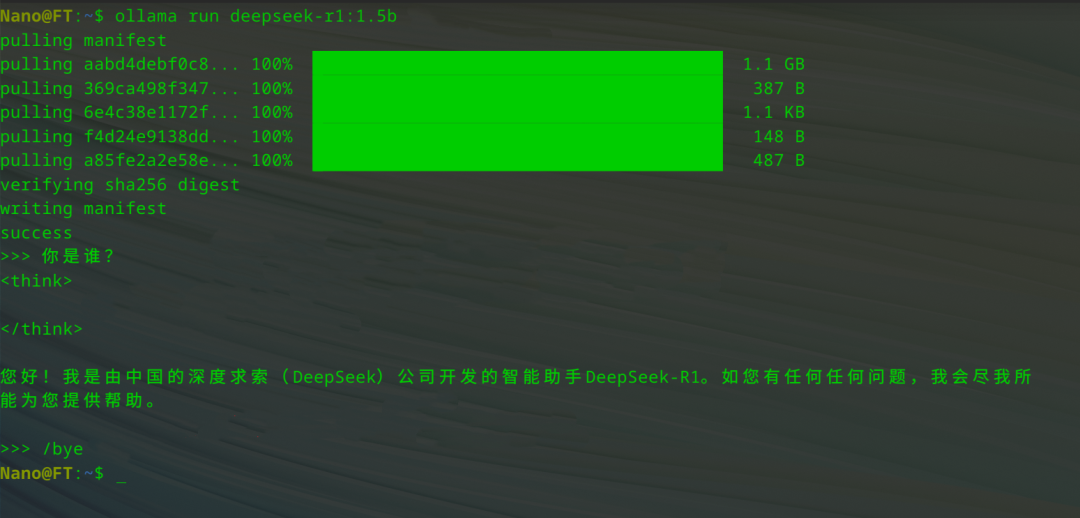

本例選擇下載 1.5b 參數(shù)量大小的模型,模型下載完成后將自動(dòng)運(yùn)行,此時(shí)可以使用如下命令在「終端」中與它進(jìn)行對(duì)話(huà):

ollama run deepseek-r1:1.5b下面是一個(gè)簡(jiǎn)單的運(yùn)行示例

5

在 UOS AI 中添加 DeepSeek-R1

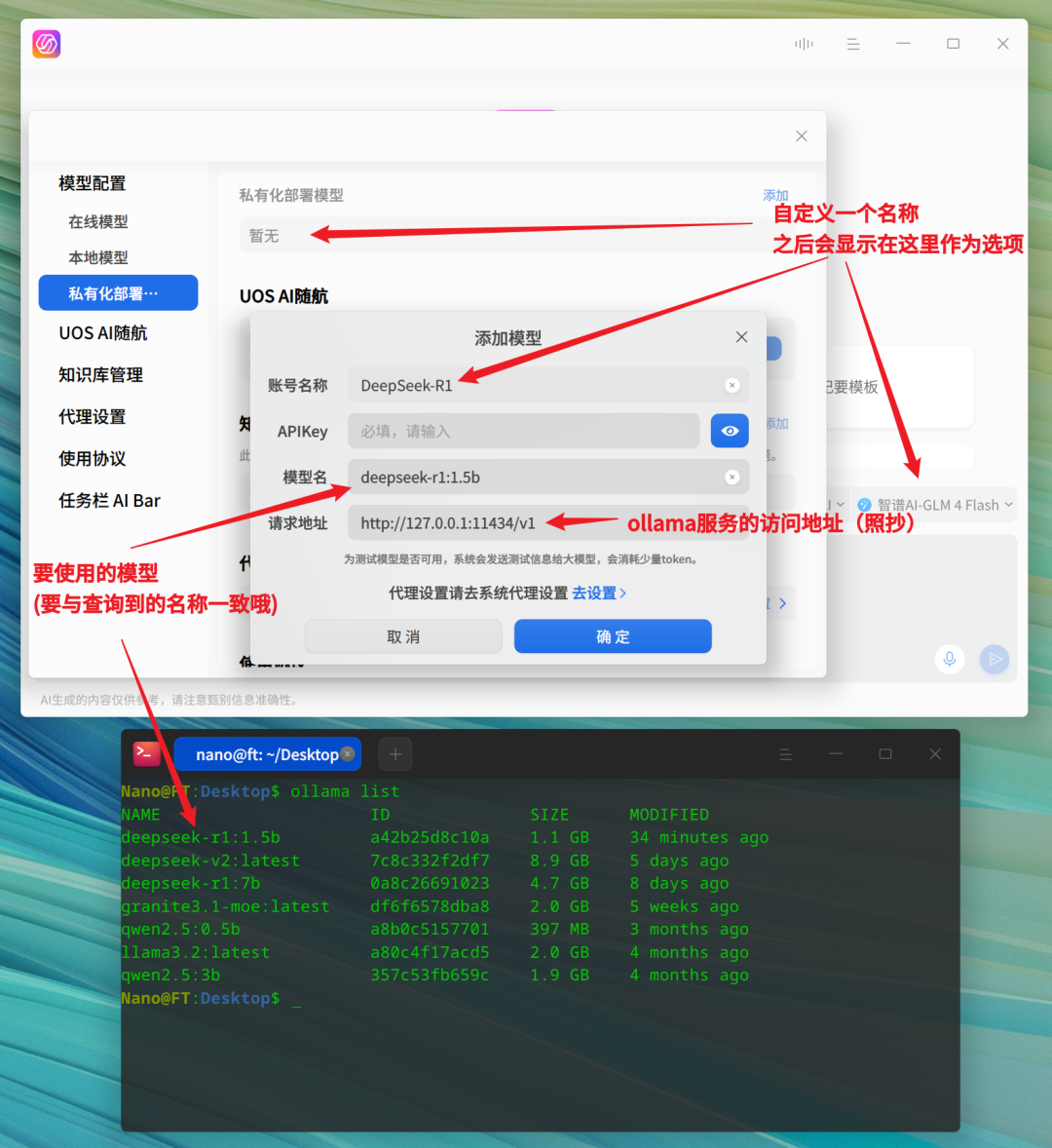

打開(kāi) UOS AI 的「設(shè)置」選項(xiàng),在「模型配置」中選擇「私有化部署模型-添加」,進(jìn)入 UOS AI 的模型添加界面。

完成添加窗口中的內(nèi)容填寫(xiě),并點(diǎn)擊確定即可,本例中使用到的信息參考如下:

賬號(hào)名稱(chēng):DeepSeek-R1 模型名:deepseek-r1:1.5b 請(qǐng)求地址:http://127.0.0.1:11434/v1

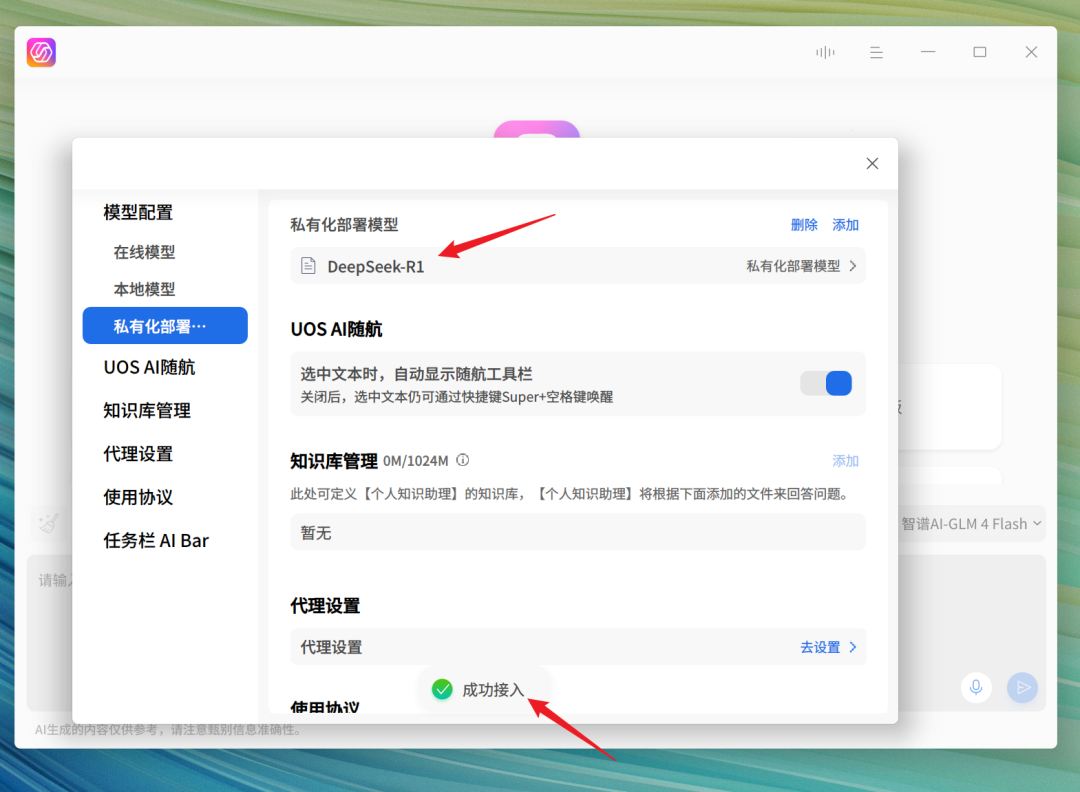

填寫(xiě)完畢并提交確定后,程序會(huì)驗(yàn)證對(duì)應(yīng)的大模型是否可用,驗(yàn)證成功后,DeepSeek-R1 便被添加至本地模型。

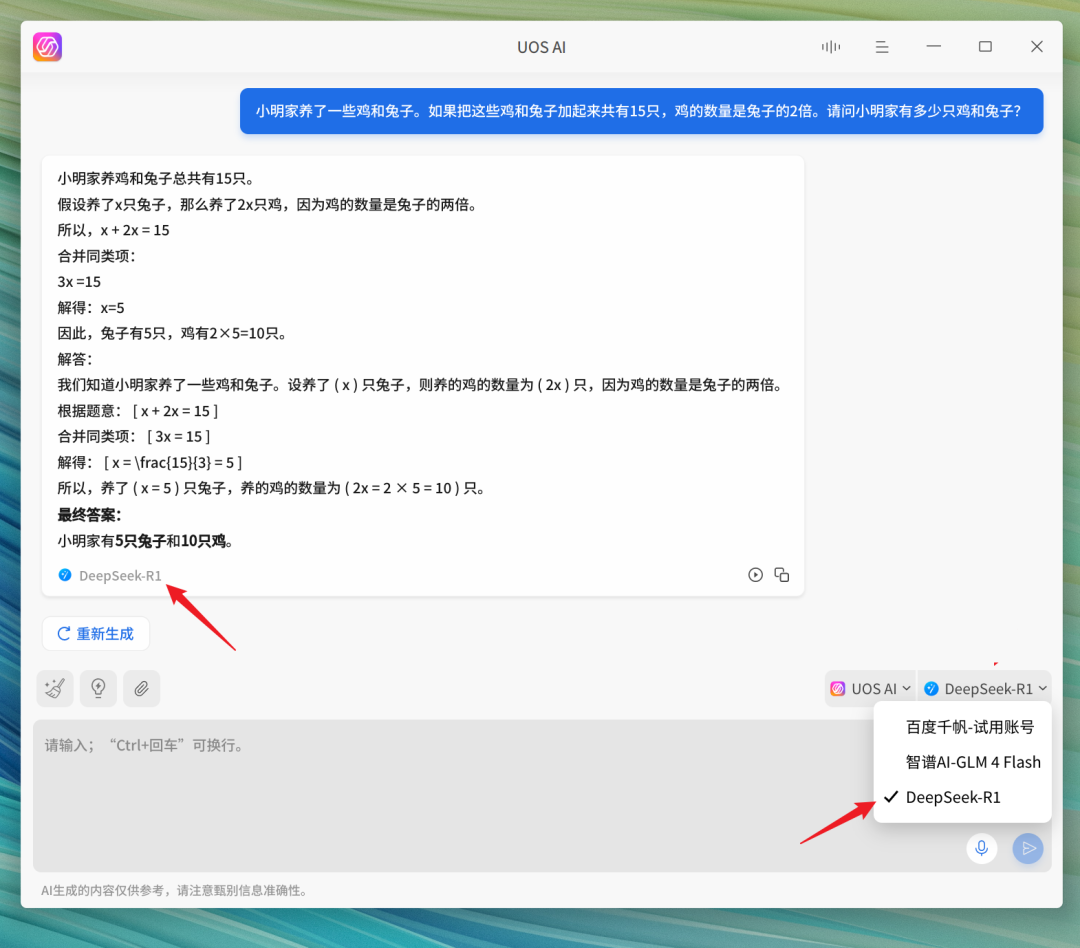

隨后即可在 UOS AI 中選擇 DeepSeek-R1 模型進(jìn)行使用。

注:以上本地部署流程不僅僅適用于 DeepSeek-R1 模型,同樣也適用于其它模型的本地部署。

附錄:

[1]deepin UOS AI 離線(xiàn)、在線(xiàn)接入 DeepSeek-R1 教程 [2] deepin UOS AI 如何配置自定義模型

-

AI

+關(guān)注

關(guān)注

87文章

34275瀏覽量

275464 -

UOS系統(tǒng)

+關(guān)注

關(guān)注

0文章

9瀏覽量

2303 -

DeepSeek

+關(guān)注

關(guān)注

1文章

777瀏覽量

1358

原文標(biāo)題:deepin 25 + DeepSeek-R1 + Ollama 本地搭建全流程

文章出處:【微信號(hào):linux_deepin,微信公眾號(hào):深度操作系統(tǒng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

【幸狐Omni3576邊緣計(jì)算套件試用體驗(yàn)】CPU部署DeekSeek-R1模型(1B和7B)

SL1680 SoC本地運(yùn)行DeepSeek R1 1.5B大模型

在MAC mini4上安裝Ollama、Chatbox及模型交互指南

技術(shù)融合實(shí)戰(zhàn)!Ollama攜手Deepseek搭建知識(shí)庫(kù),Continue入駐VScode

RK3588開(kāi)發(fā)板上部署DeepSeek-R1大模型的完整指南

9.9萬(wàn)元用上“滿(mǎn)血”DeepSeek R1一體機(jī),本地部署成新商機(jī)?引發(fā)外媒熱議

行芯完成DeepSeek-R1大模型本地化部署

了解DeepSeek-V3 和 DeepSeek-R1兩個(gè)大模型的不同定位和應(yīng)用選擇

【實(shí)測(cè)】用全志A733平板搭建一個(gè)端側(cè)Deepseek算力平臺(tái)

實(shí)戰(zhàn)案例 | 眺望RK3588 RKLLM部署DeepSeek-R1全流程

DeepSeek-R1本地部署指南,開(kāi)啟你的AI探索之旅

deepin 25+DeepSeek-R1+Ollama本地搭建全流程

deepin 25+DeepSeek-R1+Ollama本地搭建全流程

評(píng)論