概述

隨著大模型技術的進步,具身智能也迎來了快速的發展。但在國內眾多企業與高校推動相關技術發展的過程中,核心挑戰仍在于具身操作泛化能力,即如何在有限的具身數據下,使機器人適應復雜場景并實現技能高效遷移。

為此,京東探索研究院李律松、李東江博士團隊聯合地瓜機器人秦玉森團隊、中科大徐童團隊、深圳大學鄭琪團隊、松靈機器人及睿爾曼智能吳波團隊共同提出具身智能原子技能庫架構,并得到了清華 RDT 團隊在baseline 方法上的技術支持。

該方案是業界首個基于三輪數據驅動的具身智能原子技能庫構建框架,突破了傳統端到端具身操作的數據瓶頸,可動態自定義和更新原子技能,并結合數據收集與 VLA 少樣本學習構建高效技能庫。

與此同時,這也將是首個面向具身產業應用的數據采集新范式,旨在形成數據標準,解決當前具身智能領域數據匱乏的問題,特別是在高校與產業之間數據和范式的流動上,從而加速具身大模型研究的推進與實際落地。

論文標題:An Atomic Skill Library Construction Method for Data-Efficient EmbodiedManipulation

原文鏈接:https://arxiv.org/pdf/2501.15068

研究背景

具身智能,即具身人工智能,在生成式 AI 時代迎來重要突破。通過跨模態融合,將文本、圖像、語音等數據映射到統一的語義向量空間,為具身智能技術發展提供新契機。VLA(視覺-語言-動作)模型在數據可用性與多模態技術推動下不斷取得進展。然而,現實環境的復雜性使具身操作模型在泛化性上仍面臨挑戰。端到端訓練依賴海量數據,會導致“數據爆炸”問題,限制 VLA 發展。將任務分解為可重用的原子技能降低數據需求,但現有方法受限于固定技能集,無法動態更新。

為解決此問題,團隊提出了基于三輪數據驅動的原子技能庫構建方法,可在仿真或真實環境的模型訓練中減少數據需求。如圖所示,VLP(視覺-語言-規劃)模型將任務分解為子任務,高級語義抽象模塊將子任務定義為通用原子技能集,并通過數據收集與VLA微調構建技能庫。隨著三輪更新策略的動態擴展,技能庫不斷擴增,覆蓋任務范圍擴大。該方法將重點從端到端技能學習轉向細顆粒度的原子技能構建,有效解決數據爆炸問題,并提升新任務適應能力。

基于三輪數據驅動的原子技能庫構建與推理流程

基于三輪數據驅動的原子技能庫構建與推理流程為什么需要 VLP?

VLP 需要具有哪些能力?

從產業落地角度看,具身操作是關鍵模塊。目前,端到端 VLA 進行高頻開環控制,即便中間動作失敗,仍輸出下一階段控制信號。因此,VLA 在高頻控制機器人/機械臂時,強烈依賴VLP提供低頻智能控制,以指導階段性動作生成,并協調任務執行節奏。

為統一訓練與推理的任務分解,本文構建了集成視覺感知、語言理解和空間智能的VLP Agent。如圖所示,VLP Agent 接收任務指令文本與當前觀察圖像,并利用Prismatic生成場景描述。考慮到 3D 世界的復雜性,我們設計了一種空間智能感知策略:首先,Dino-X檢測任務相關物體并輸出邊界框;然后,SAM-2提供精細分割掩碼,并基于規則判斷物體間的空間關系。最終,這些視覺與空間信息與任務指令一同輸入GPT-4,生成完整執行計劃并指定下一個子任務。VLP Agent 通過該方法在原子技能庫構建中有效分解端到端任務,并在推理過程中提供低頻控制信號,規劃并指導高頻原子技能的執行。

基于空間智能信息的 VLP Agent 具身思維鏈框架

基于空間智能信息的 VLP Agent 具身思維鏈框架VLA 存在的問題是什么?

在框架中起什么作用?

VLA 技術從專用數據向通用數據演進,機器人軌跡數據已達1M episodes級別;模型參數規模從千億級向端側部署發展;性能上,VLA 從單一場景泛化至多場景,提升技能遷移能力。盡管端到端任務采集與訓練有助于科研算法優化,但在通用機器人應用中,人為定義端到端任務易導致任務窮盡問題。在單任務下,物品位置泛化、背景干擾、場景變化仍是主要挑戰,即便強大預訓練模型仍需大量數據克服;多任務下,數據需求呈指數級增長,面臨“數據爆炸”風險。

提出的三輪數據驅動的原子技能庫方法可結合SOTA VLA模型,通過高級語義抽象模塊將復雜子任務映射為結構化原子技能,并結合數據收集與 VLA 少樣本學習高效構建技能庫。VLA 可塑性衡量模型從多本體遷移至特定本體的能力,泛化性則評估其應對物體、場景、空間變化的表現。以RDT-1B作品為例,我們基于6000 條開源數據及2000 條自有數據微調VLA 模型。測試結果表明,模型在物品和場景泛化上表現優異,但在物品位置泛化方面存在一定局限,且訓練步數對最終性能影響顯著。為進一步優化,團隊進行了兩項實驗包括位置泛化能力提升及訓練步長優化測試。這類VLA 模型性能測試對于原子技能庫構建至關重要,測試結果不僅優化了Prompt 設計,也進一步增強了高級語義抽象模塊在子任務映射與技能定義中的精準性。

為什么構建原子技能庫?

怎樣構建?

具身操作技能學習數據源包括互聯網、仿真引擎和真實機器人數據,三者獲取成本遞增,數據價值依次提升。在多任務多本體機器人技能學習中,OpenVLA和Pi0依托預訓練VLM,再用真實軌跡數據進行模態對齊并訓練技能,而RDT-1B直接基于百萬級機器人真實軌跡數據預訓練,可適配不同本體與任務。無論模型架構如何,真實軌跡數據仍是關鍵。原子技能庫的構建旨在降低數據采集成本,同時增強任務適配能力,提升具身操作的通用性,以滿足產業應用需求。

基于數據驅動的原子技能庫構建方法,結合端到端具身操作VLA與具身規劃VLP,旨在構建系統化的技能庫。VLP 將TASK A, B, C, ..., N分解為Sub-task #1, #2, ..., #a+1。高級語義抽象模塊基于SOTAVLA模型測試可調整任務粒度,進一步將子任務映射為通用原子技能定義*1, *2, ..., *b+1,并通過數據收集與 VLA 少樣本學習,構建包含*1', *2', ..., *b+1'的原子技能庫。面對新任務TASK N+1,若所需技能已在庫中,則可直接執行;若缺失,則觸發高級語義抽象模塊,基于現有技能庫進行原子技能定義更新,僅需對缺失的原子技能收集額外數據與 VLA 微調。隨著原子技能庫動態擴增,其適應任務范圍不斷增加。相比傳統TASK 級數據采集,提出的原子技能庫所需要的數據采集量根據任務難度成指數級下降,同時提升技能適配能力。

實驗與結果分析

驗證問題

- 在相同物體點位下采集軌跡數據,所提方法能否以更少數據達到端到端方法性能?

- 在收集相同數量的軌跡數據下,所提方法能否優于端到端方法?

- 面對新任務,所提方法是否能夠在不依賴或者少依賴新數據的條件下仍然有效?

- 所提方法是否適用于不同VLA模型,并保持有效性和效率?

實驗設置

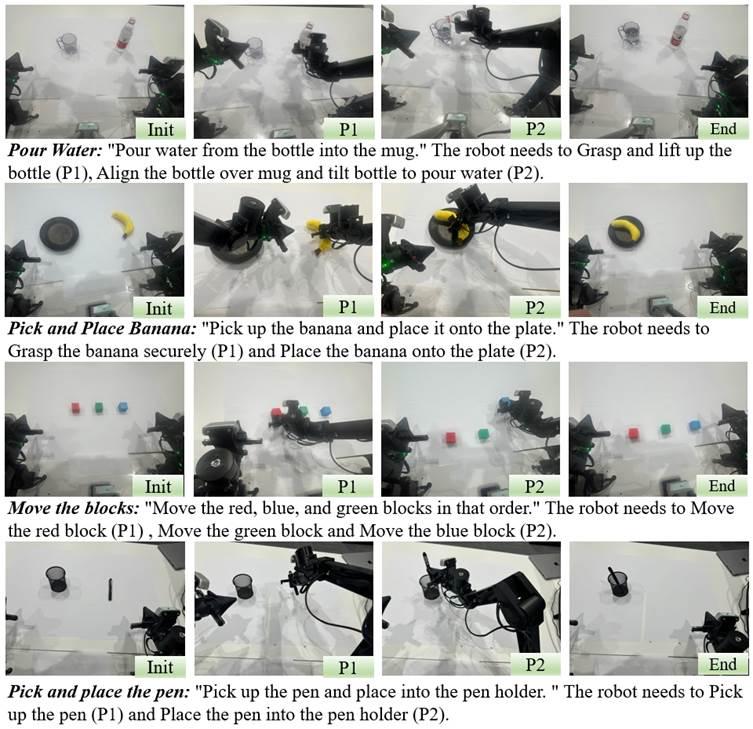

針對上述問題,我們設計了四個挑戰性任務,并在RDT-1B和Octo基準模型上,以Agilex 雙臂機器人進行測試。實驗采用端到端方法和所提方法分別采集數據,以對比兩者在數據利用效率和任務泛化能力上的表現。具體實驗設置如下:

- 拿起香蕉并放入盤子

- 端到端方法:從4 個香蕉點位和2 個盤子點位采集24 條軌跡。

- 所提方法:保持數據分布一致,分解為12 條抓取香蕉軌跡和6 條放置香蕉軌跡。

- 為匹配端到端數據量,進一步擴大采樣范圍,從8 個香蕉點位采集24 條抓取軌跡,3 個盤子點位采集24 條放置軌跡。

- 拿起瓶子并向杯中倒水

- 端到端方法:從3 個瓶子點位和3 個杯子點位采集27 條軌跡。

- 所提方法:分解為9 條抓取瓶子軌跡和9 條倒水軌跡,確保數據分布一致。

- 進一步擴大采樣范圍,從9 個瓶子點位采集27 條抓取軌跡,9 個杯子點位采集27 條倒水軌跡。

- 拿起筆并放入筆筒

- 端到端方法:從4 個筆點位和2 個筆筒點位采集24 條軌跡。

- 所提方法:分解為12 條抓取筆軌跡和6 條放置筆軌跡,保持數據分布一致。

- 進一步擴大采樣范圍,從8 個筆點位采集24 條抓取軌跡,3 個筆筒點位采集24 條放置軌跡。

- 按指定順序抓取積木(紅、綠、藍)

- 端到端方法:采集10 條軌跡,固定積木位置,按順序抓取紅色、綠色、藍色積木。

- 所提方法:為匹配端到端數據量,分別采集10 條抓取紅色、綠色、藍色積木軌跡,共30 條。

任務定義與可視化

任務定義與可視化實驗結果

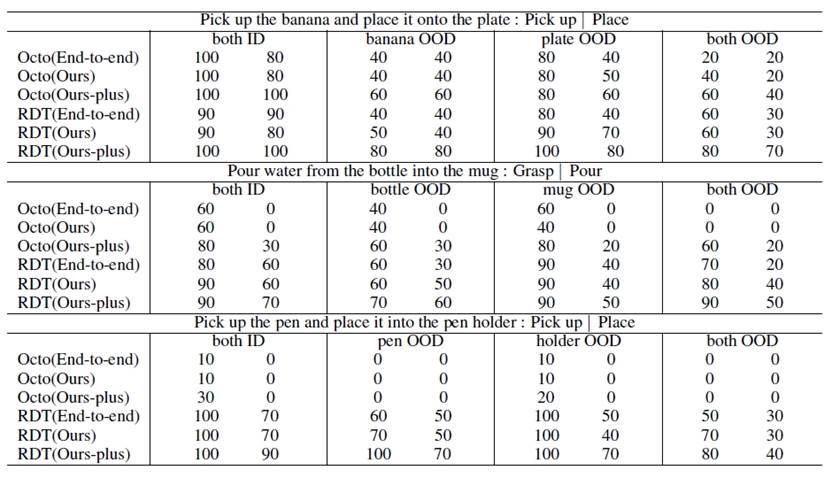

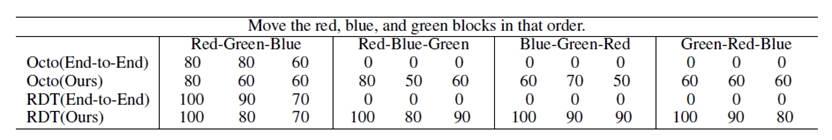

前三個任務用于驗證所提方法在數據效率和操作性能上的表現,第四個任務則評估其新任務適應能力。為確保公平性,每種實驗設置均在Octo和RDT-1B上進行10 次測試,對比端到端方法與所提方法(“Ours” 和 “Ours-plus”)。如表1所示,“End-To-End”:原始端到端VLA方法;“Ours”:保持數據分布一致,但數據量更小;“Ours-plus”:保持數據量一致,但采集更多點位;“ID”:任務點位在訓練數據分布內;“OOD”:任務點位超出訓練數據分布。在第四個任務中,設定紅-綠-藍順序抓取積木為已知任務,并采集數據訓練模型。針對其他顏色順序的未知任務,直接調用已訓練的技能進行測試,以評估方法的泛化能力(見表 2)。結果分析如下:

Q1: 從表 1 可見,Octo 和 RDT-1B在使用所提方法后,成功率與端到端方法相當甚至更高。在拿起瓶子并向杯中倒水任務中,OOD 測試成功率提升 20%,表明該方法在相同點位分布下,減少數據需求同時提升性能。

Q2: 在相同數據量下,所提方法顯著提升成功率。例如,在拿起香蕉并放入盤子任務中,OOD 情況下成功率提高 40%,歸因于從更多點位采集數據,增強模型泛化能力。

Q3: 從表 2 可見,端到端方法僅適用于已知任務,無法泛化新任務,而所提方法能通過已有技能組合成功執行不同的新任務。

Q4: 表 1 和表 2 進一步驗證,所提方法在多種VLA模型上均提升數據效率、操作性能和新任務適應能力,適用于不同模型的泛化與優化。

表1:與原始端到端方法實驗結果對比

表1:與原始端到端方法實驗結果對比 表2:與原始端到端方法方塊抓取任務實驗結果對比

表2:與原始端到端方法方塊抓取任務實驗結果對比小結

基于三輪數據驅動的原子技能庫構建框架,旨在解決傳統端到端具身操作策略帶來的“數據爆炸”問題,為具身智能產業應用提供創新解決方案。該框架具有廣泛價值,可用于提升物流倉儲、智能制造、醫療輔助等領域的自動化水平。例如,在醫療輔助和服務機器人領域,它能夠增強自主交互能力,助力精準操作。希望此項工作能夠為行業提供重要啟示,促進學術界與產業界的深度合作,加速具身智能技術的實際應用。

-

機器人

+關注

關注

212文章

29319瀏覽量

211060 -

數據

+關注

關注

8文章

7233瀏覽量

90834 -

人工智能

+關注

關注

1804文章

48511瀏覽量

245349 -

具身智能

+關注

關注

0文章

101瀏覽量

348

發布評論請先 登錄

樂聚機器人與地瓜機器人達成戰略合作,聯合發布Aelos Embodied具身智能

喜訊 | 京東聯合地瓜機器人等多家企業高校,推出業內首個具身智能原子技能庫架構

喜訊 | 京東聯合地瓜機器人等多家企業高校,推出業內首個具身智能原子技能庫架構

評論