前言:

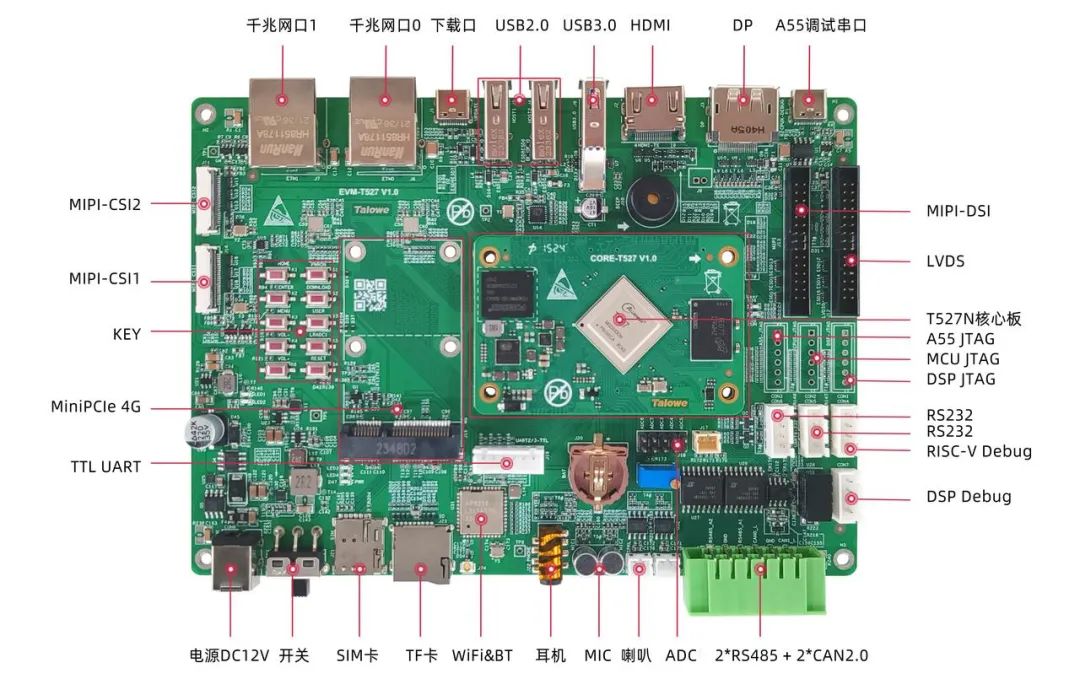

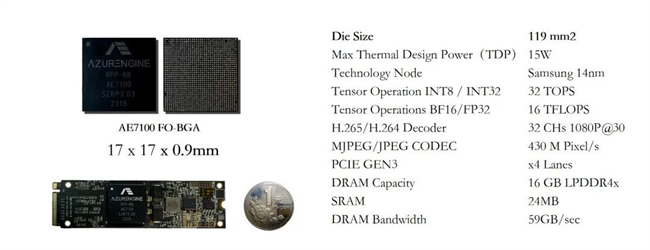

在AIoT領域,搭載Ubuntu系統的眺望T527開發板,僅憑2GB內存便成功運行15億參數的DeepSeek-R1輕量級大模型!在邊緣端上演一場算力革命,這一突破性進展不僅刷新了邊緣AI設備的性能天花板,更昭示著低成本、低功耗的AI普惠時代加速到來。

一、DeepSeek-R1 x Ollama簡介

1.1DeepSeek-R1模型

DeepSeek-R1 1.5B作為一款輕量級語言模型,擁有 15 億參數。該模型不僅在文本生成、對話交互和代碼補全領域表現優異,更通過精簡參數規模實現了顯著效率提升——其優化的推理速度、較低的計算需求以及靈活的部署特性,使得在資源受限的嵌入式設備上也能實現流暢運行,有效降低硬件門檻。該模型具備跨平臺兼容性,全面支持 Linux/Windows/macOS 操作系統及 ARM 架構設備,使開發者無需依賴云端服務即可在本地環境中高效部署 AI 應用。

1.2Ollama開源框架

Ollama 是一個開源的大型語言模型(LLM)平臺,旨在讓用戶能夠輕松地在本地運行、管理和與大型語言模型進行交互。提供了一個簡單的方式來加載和使用各種預訓練的語言模型,支持文本生成、翻譯、代碼編寫、問答等多種自然語言處理任務。不僅僅提供了現成的模型和工具集,還提供了方便的界面和 API,使得從文本生成、對話系統到語義分析等任務都能快速實現。

二、部署實戰:Ollama環境下的三步極速部署

2.1Step1 環境搭建

#ollama安裝推薦兩種方式#官網提供Linux腳本安裝curl -fsSL https://ollama.com/install.sh | sh

#手動安裝https://github.com/ollama/ollama/releases

2.2Step2 模型加載

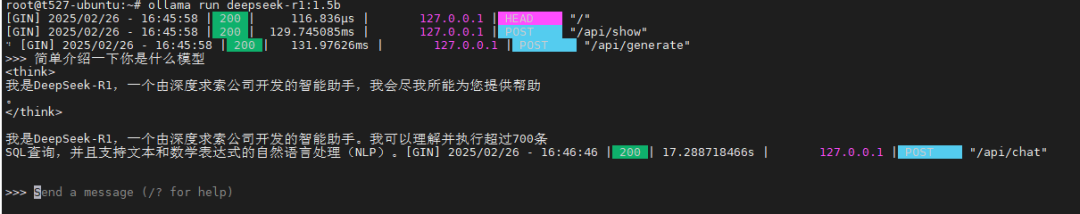

ollama run deepseek-r1:1.5b

2.3Step3 實時推理驗證

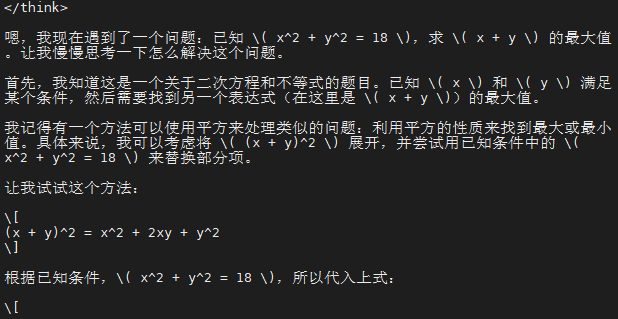

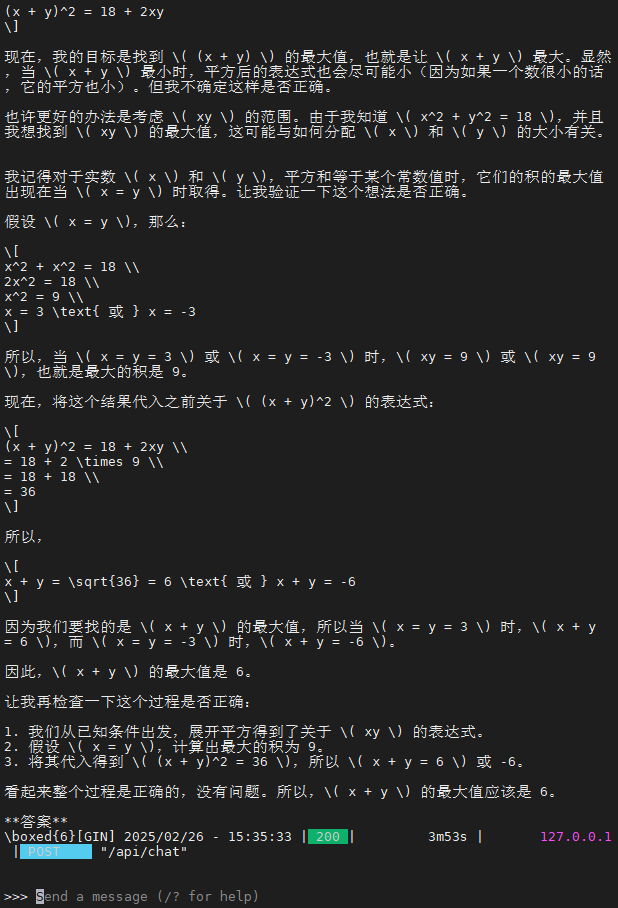

已知x2+y2=18,求x+y的最大值

三、T527評估板測試效果

3.1環境說明

使用眺望電子EVM-T527N開發套件,搭載2GB內存配置,板載運行Ubuntu20.04系統。通過SSH登入主板運行模型,Debug調試口用于監測運行器件資源消耗。

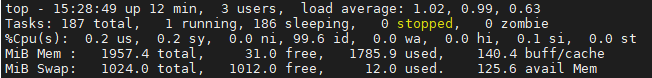

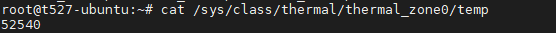

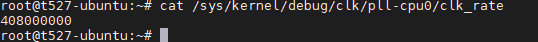

3.1資源監控

Ollama 是一個開源的大模型服務工具,調用的是CPU進行的運算,內存資源和CPU使用消耗較大,在無風扇環境下,溫升約30℃。

結語

當主流AI芯片還在比拼NPU算力時,全志T527用實際表現證明,真正的邊緣智能不在于參數堆砌,而在于在嚴苛資源限制下實現可用、易用、好用的AI賦能。2GB內存跑通Ubuntu系統下15億參數DeepSeek大模型驗證了眺望電子對T527系列處理器的深度優化與強大可靠。這背后是眺望電子在低功耗、低成本AI解決方案領域的技術實力體現。如果您對部署過程感興趣,歡迎隨時與我們聯系,我們可以為您提供專業的技術支持,期待與您合作!

-

AI

+關注

關注

88文章

35041瀏覽量

279078 -

核心板

+關注

關注

5文章

1157瀏覽量

30851 -

AIoT

+關注

關注

8文章

1502瀏覽量

32388 -

DeepSeek

+關注

關注

1文章

795瀏覽量

1698

發布評論請先 登錄

從DeepSeek到Qwen,AI大模型的移植與交互實戰指南-飛凌嵌入式

了解DeepSeek-V3 和 DeepSeek-R1兩個大模型的不同定位和應用選擇

添越智創基于 RK3588 開發板部署測試 DeepSeek 模型全攻略

RK3588開發板上部署DeepSeek-R1大模型的完整指南

100%國產化FPGA核心板!骨折價——限時僅售299元!

芯動力神速適配DeepSeek-R1大模型,AI芯片設計邁入“快車道”!

deepin UOS AI接入DeepSeek-R1模型

DeepSeek-R1本地部署指南,開啟你的AI探索之旅

AIBOX 全系產品已適配 DeepSeek-R1

廣和通支持DeepSeek-R1蒸餾模型

Deepseek R1大模型離線部署教程

Infinix AI接入DeepSeek-R1滿血版

行芯完成DeepSeek-R1大模型本地化部署

在英特爾哪吒開發套件上部署DeepSeek-R1的實現方式

實戰案例 | 299元國產工業級AI核心板部署DeepSeek-R1

實戰案例 | 299元國產工業級AI核心板部署DeepSeek-R1

評論