[中國,深圳,2025年6月30日] 今日,華為正式宣布開源盤古70億參數(shù)的稠密模型、盤古Pro MoE 720億參數(shù)的混合專家模型和基于昇騰的模型推理技術。

此舉是華為踐行昇騰生態(tài)戰(zhàn)略的又一關鍵舉措,推動大模型技術的研究與創(chuàng)新發(fā)展,加速推進人工智能在千行百業(yè)的應用與價值創(chuàng)造。

盤古Pro MoE 72B模型權重、基礎推理代碼,已正式上線開源平臺。

基于昇騰的超大規(guī)模MoE模型推理代碼,已正式上線開源平臺。

盤古7B相關模型權重與推理代碼將于近期上線開源平臺。

我們誠邀全球開發(fā)者、企業(yè)伙伴及研究人員下載使用,反饋使用意見,共同完善。請訪問https://gitcode.com/ascend-tribe

-

華為

+關注

關注

216文章

35160瀏覽量

255465 -

人工智能

+關注

關注

1805文章

48913瀏覽量

248052 -

昇騰AI

+關注

關注

0文章

85瀏覽量

753 -

盤古大模型

+關注

關注

1文章

111瀏覽量

716

原文標題:華為宣布開源盤古7B稠密和72B混合專家模型

文章出處:【微信號:huaweicorp,微信公眾號:華為】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

在阿里云PAI上快速部署NVIDIA Cosmos Reason-1模型

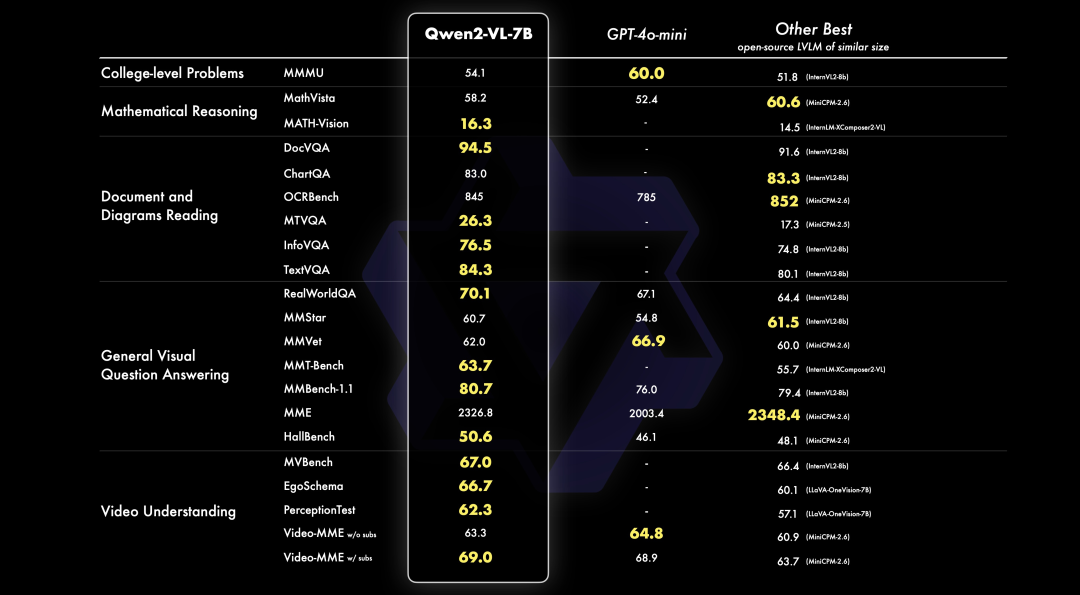

NVIDIA RTX 5880 Ada與Qwen3系列模型實測報告

【幸狐Omni3576邊緣計算套件試用體驗】CPU部署DeekSeek-R1模型(1B和7B)

利用英特爾OpenVINO在本地運行Qwen2.5-VL系列模型

阿里云發(fā)布開源多模態(tài)推理模型QVQ-72B-Preview

獵戶星空發(fā)布Orion-MoE 8×7B大模型及AI數(shù)據(jù)寶AirDS

阿里通義千問代碼模型全系列開源

PerfXCloud重磅升級 阿里開源最強視覺語言模型Qwen2-VL-7B強勢上線!

華為正式開源盤古7B稠密和72B混合專家模型

華為正式開源盤古7B稠密和72B混合專家模型

評論