繼上周在 Nature 發(fā)表極受關(guān)注的“網(wǎng)格細胞”研究后,DeepMind今天又在《自然-神經(jīng)科學》發(fā)表一篇重磅論文:利用強化學習探索多巴胺對學習的作用,發(fā)現(xiàn)AI的學習方式與神經(jīng)科學實驗中動物的學習方式類似。該研究提出的理論可以解釋神經(jīng)科學和心理學中的許多神秘發(fā)現(xiàn)。

AI系統(tǒng)已經(jīng)掌握了多種電子游戲,如雅達利經(jīng)典的“突出重圍”(Breakout)和“乒乓球”(Pong)游戲。但盡管AI在玩游戲方便的表現(xiàn)令人印象深刻,它們?nèi)匀皇且揽肯喈斢跀?shù)千小時的游戲時間訓(xùn)練,才達到或超越人類的水平。相比之下,我們?nèi)祟愅ǔV换◣追昼娋湍苷莆找豢钗覀儚奈赐孢^的電子游戲的基礎(chǔ)知識。

為什么只有這么少的先驗知識,人類的大腦卻能做這么多的事情呢?這就引出了“元學習”(meta-learning)的理論,或者說“學習如何學習”(learning to learn)。人們認為,人是在兩個時間尺度上學習的——在短期,我們專注于學習具體的例子;而在較長的時間尺度,我們學習完成一項任務(wù)所需的抽象技能或規(guī)則。正是這種組合被認為有助于人高效地學習,并將這些知識快速靈活地應(yīng)用于新任務(wù)。

在 AI 系統(tǒng)中重建這種元學習結(jié)構(gòu)——稱為元強化學習(meta-reinforcement learning)——已經(jīng)被證明能夠促進智能體(agents)快速、one-shot的學習。這方面的研究已經(jīng)有很多,例如DeepMind的論文“Learning to reinforcement learn”和OpenAI的“RL2: Fast Reinforcement Learning via Slow Reinforcement Learning”。然而,促使這個過程在大腦中發(fā)生的具體機制是怎樣的,這在神經(jīng)科學中大部分仍未得到解釋。

今天,DeepMind在《自然-神經(jīng)科學》(Nature Neuroscience)發(fā)表的新論文中,研究人員使用AI研究中開發(fā)的元強化學習框架來探索多巴胺在大腦中幫助我們學習時所起的作用。論文題為:Prefrontal cortex as a meta-reinforcement learning system。

多巴胺——通常被稱為大腦的愉悅因子——被認為與AI強化學習算法中使用的獎勵預(yù)測誤差信號類似。AI系統(tǒng)通過獎勵(reward)指引的試錯來學習如何行動。研究者認為,多巴胺的作用不僅僅是利用獎勵來學習過去行為的價值,而且,多巴胺在大腦的前額葉皮層區(qū)扮演者不可或缺的角色,使我們能夠高效、快速、靈活地學習新任務(wù)。

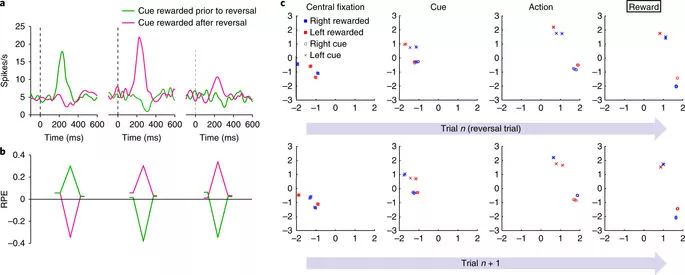

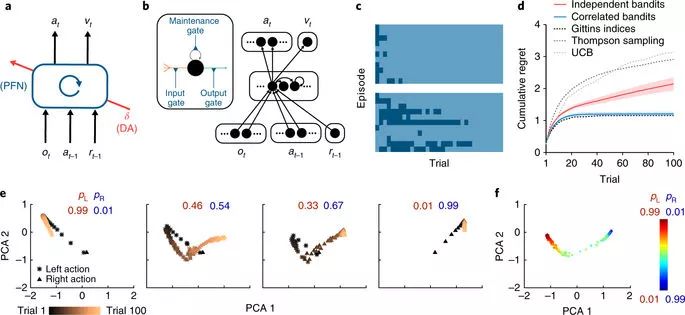

模擬agent的獎勵預(yù)測誤差反映了推斷值,而不僅僅是經(jīng)驗值,類似于在猴子中觀察到的。

DeepMind的研究人員通過模擬重建神經(jīng)科學領(lǐng)域的6個元學習實驗來測試他們的理論——每個實驗都要求一個agent執(zhí)行任務(wù),這些任務(wù)使用相同的基礎(chǔ)原則(或同一套技能),但在某些方面有所不同。

我們使用標準深度強化學習技術(shù)(代表多巴胺的作用)訓(xùn)練了一個循環(huán)神經(jīng)網(wǎng)絡(luò)(代表前額葉皮質(zhì)),然后將這個循環(huán)網(wǎng)絡(luò)的活動狀態(tài)與之前在神經(jīng)科學實驗中得到的實際數(shù)據(jù)進行比較。對于元學習來說,循環(huán)網(wǎng)絡(luò)是一個很好的代理,因為它們能夠?qū)⑦^去的行為和觀察內(nèi)在化,然后在訓(xùn)練各種各樣的任務(wù)時借鑒這些經(jīng)驗。

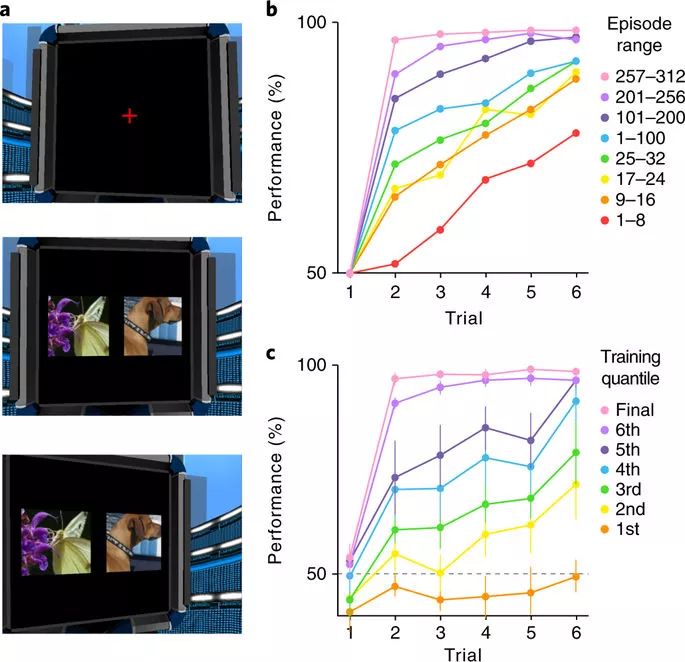

我們重建的一個實驗叫做Harlow實驗,這是20世紀40年代的一個心理學實驗,用于探索元學習的概念。在原版的測試中,一組猴子被展示兩個不熟悉的物體,只有其中一個會給他們食物獎勵。兩個物體一共被展示了6次,每次的左右放置都是隨機的,所以猴子必須要知道哪個會給它們食物獎勵。然后,他們再次被展示另外兩個新的物體,同樣,只有其中一個會給它們食物。

在這個訓(xùn)練過程中,猴子發(fā)展出一種策略來選擇能得到獎勵的物體:它學會了在第一次的時候隨機選擇,然后,下一次根據(jù)獎勵的反饋選擇特定的對象,而不是從左到右選擇。這個實驗表明,猴子可以將任務(wù)的基本原理內(nèi)化,學會一種抽象的規(guī)則結(jié)構(gòu)——實際上就是學會了如何學習。

meta-RL 的架構(gòu)

當我們使用虛擬的計算機屏幕和隨機選擇的圖像來模擬一個非常相似的測試時,我們發(fā)現(xiàn),我們的“元強化學習智能體”(meta-RL agent)似乎是以類似于Harlow實驗中的動物的方式在學習,甚至在被顯示以前從未見過的全新圖像時也是如此。

在模擬的Harlow實驗中,agent必須將它的視線轉(zhuǎn)向它認為能得到獎勵的對象

實際上,我們發(fā)現(xiàn)meta-RL agent可以學習如何快速適應(yīng)規(guī)則和結(jié)構(gòu)不同的各種任務(wù)。而且,由于網(wǎng)絡(luò)學會了如何適應(yīng)各種任務(wù),它也學會了關(guān)于如何有效學習的一般原則。

很重要的一點是,我們發(fā)現(xiàn)大部分的學習發(fā)生在循環(huán)網(wǎng)絡(luò)中,這支持了我們的觀點,即多巴胺在元學習過程中的作用比以前人們認為的更為重要。傳統(tǒng)上,多巴胺被認為能夠加強前額葉系統(tǒng)的突觸連接,從而強化特定的行為。

在AI中,這意味著類多巴胺的獎勵信號在神經(jīng)網(wǎng)絡(luò)中調(diào)整人工突觸的權(quán)重,因為它學會了解決任務(wù)的正確方法。然而,在我們的實驗中,神經(jīng)網(wǎng)絡(luò)的權(quán)重被凍結(jié),這意味著在學習過程中權(quán)重不能被調(diào)整。但是,meta-RL agent仍然能夠解決并適應(yīng)新的任務(wù)。這表明,類多巴胺的獎勵不僅用于調(diào)整權(quán)重,而且還能傳遞和編碼有關(guān)抽象任務(wù)和規(guī)則結(jié)構(gòu)的重要信息,從而加快對新任務(wù)的適應(yīng)。

Meta-RL在視覺豐富的3D環(huán)境中學習抽象結(jié)構(gòu)和新的刺激

長期以來,神經(jīng)科學家在大腦的前額葉皮質(zhì)中觀察到類似的神經(jīng)活動模式,這種模式能夠快速適應(yīng),而且很靈活,但一直以來科學家難以找到能夠解釋為什么會這樣的充分理由。前額葉皮層不依賴突觸重量的緩慢變化來學習規(guī)則結(jié)構(gòu),而是使用直接編碼在多巴胺上的、抽象的基于模式的信息,這一觀點提供了一個更令人信服的解釋。

為了證明AI中存在的引起元強化學習的關(guān)鍵因素也存在于大腦中,我們提出了一個理論,該理論不僅與已知的關(guān)于多巴胺和前額葉皮層的了解相符,而且可以解釋神經(jīng)科學和心理學中的許多神秘發(fā)現(xiàn)。特別是,該理論對了解大腦中結(jié)構(gòu)化的、基于模式的學習是如何出現(xiàn)的,為什么多巴胺本身包含有基于模式的信息,以及前額葉皮質(zhì)中的神經(jīng)元是如何調(diào)整為與學習相關(guān)的信號等問題提出了新的啟發(fā)。

來自AI研究的見解可以用于解釋神經(jīng)科學和心理學的發(fā)現(xiàn),這強調(diào)了,一個研究領(lǐng)域的價值可以提供給另一個領(lǐng)域。展望未來,我們期望能從反過來的方向得到更多益處,通過在為強化學習智能體的學習設(shè)計新的模型時,從特定腦回路組織得到啟發(fā)。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4811瀏覽量

103033 -

AI

+關(guān)注

關(guān)注

88文章

34588瀏覽量

276143 -

強化學習

+關(guān)注

關(guān)注

4文章

269瀏覽量

11534

原文標題:DeepMind用強化學習探索大腦多巴胺對學習的作用

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

什么是深度強化學習?深度強化學習算法應(yīng)用分析

深度強化學習實戰(zhàn)

將深度學習和強化學習相結(jié)合的深度強化學習DRL

薩頓科普了強化學習、深度強化學習,并談到了這項技術(shù)的潛力和發(fā)展方向

如何深度強化學習 人工智能和深度學習的進階

人工智能機器學習之強化學習

什么是強化學習?純強化學習有意義嗎?強化學習有什么的致命缺陷?

基于強化學習的MADDPG算法原理及實現(xiàn)

深度強化學習到底是什么?它的工作原理是怎么樣的

DeepMind發(fā)布強化學習庫RLax

機器學習中的無模型強化學習算法及研究綜述

模型化深度強化學習應(yīng)用研究綜述

利用強化學習探索多巴胺對學習的作用

利用強化學習探索多巴胺對學習的作用

評論