聚焦 ICML—— Deep Mind 今天在 ICML 大會(huì)上發(fā)表了他們的最新研究,從人類的 IQ 測(cè)試?yán)镉脕砗饬砍橄笸评淼姆椒ㄖ蝎@得靈感,探索深層神經(jīng)網(wǎng)絡(luò)的抽象推理和概括的能力。一開始看到文章的前半部分的 IQ 測(cè)試題數(shù)據(jù)集,我在凌晨十二點(diǎn)花了一些時(shí)間把幾個(gè)測(cè)試題做完了,但是并不是以預(yù)期中的飛速完成,然后回想體會(huì)了一下我“是如何理解題目,進(jìn)而做出這些題目得到結(jié)果的”。我就很好奇這將會(huì)是如何開展的一個(gè)研究;隨著歲月的流逝,我們會(huì)不斷地遺忘知識(shí),漸漸地還給老師了,但是我們學(xué)習(xí)新知識(shí)的能力,推理思維力也不如以前, 那這個(gè)研究的成果又會(huì)是如何呢?今天人工智能頭條也為大家介紹一下 Deep Mind 的這項(xiàng)最新研究:測(cè)量神經(jīng)網(wǎng)絡(luò)的抽象推理能力。看到最后覺得需要練練的怕是我吧~~

神經(jīng)網(wǎng)絡(luò)是否可以學(xué)習(xí)抽象推理,還是僅僅淺顯地學(xué)習(xí)統(tǒng)計(jì)數(shù)據(jù)學(xué)習(xí),是最近學(xué)術(shù)界辯論的主題。在本文中,受到一個(gè)著名 IQ 測(cè)試的靈感啟發(fā),我們提出一個(gè)抽象推理挑戰(zhàn)及其相應(yīng)的數(shù)據(jù)集。為了成功應(yīng)對(duì)這一挑戰(zhàn),模型必須應(yīng)對(duì)訓(xùn)練和測(cè)試階段不同數(shù)據(jù)方法情況下的各種泛化情況,我們展示了即使是在訓(xùn)練集和測(cè)試集的差別很小的情況下,像 ResNet 這樣的模型也難以取得很好的泛化表現(xiàn)。

為了解決這個(gè)問題,我們?cè)O(shè)計(jì)了一種用于抽象推理的新穎結(jié)構(gòu),當(dāng)訓(xùn)練數(shù)據(jù)和測(cè)試數(shù)據(jù)不同時(shí),我們發(fā)現(xiàn)該模型能夠精通某些特定形式的泛化,但在其他方面能力較弱。進(jìn)一步地,當(dāng)訓(xùn)練時(shí)模型能夠?qū)Υ鸢高M(jìn)行解釋性的預(yù)測(cè),那么我們模型的泛化能力將會(huì)得到明顯的改善。總的來說,我們介紹并探索兩種方法用于測(cè)量和促使神經(jīng)網(wǎng)絡(luò)擁有更強(qiáng)的抽象推理能力,而我們公開的抽象推理數(shù)據(jù)集也將促進(jìn)在該領(lǐng)域進(jìn)一步的研究進(jìn)展。

在機(jī)器學(xué)習(xí)問題上,基于神經(jīng)網(wǎng)絡(luò)的模型已經(jīng)取得了長足而又令人印象深刻的成果,但同時(shí)其對(duì)抽象概念的推理能力的研究也是一大難題。先前的研究主要集中于解決通用學(xué)習(xí)系統(tǒng)的重要特征,而我們的最新論文提出了一種在學(xué)習(xí)機(jī)器的過程中測(cè)量抽象推理的方法,并揭示了關(guān)于泛化本質(zhì)問題的一些重要見解。

要理解為什么抽象推理對(duì)于通用人工智能如此得重要,首先了解阿基米德提出的 “famous Eureka” :即物體的體積等于所取代的水體積,他從概念層面理解體積,因此能夠推斷出其他不規(guī)則形狀物體的體積。

我們希望AI 也擁有這樣類似的能力。盡管當(dāng)前的人工智能系統(tǒng)可以在復(fù)雜的戰(zhàn)略游戲中擊敗人類的世界冠軍,但它們經(jīng)常掙扎于其他一些看似簡(jiǎn)單的任務(wù),特別是在新環(huán)境中需要發(fā)現(xiàn)并重復(fù)應(yīng)用抽象概念。例如,如果專門訓(xùn)練我們系統(tǒng)只學(xué)習(xí)計(jì)算三角形,那么即便是當(dāng)前最好的AI 系統(tǒng)也無法計(jì)算方形或其他先前未見過的對(duì)象。

因此,要構(gòu)建更好、更智能的系統(tǒng),了解當(dāng)前神經(jīng)網(wǎng)絡(luò)處理抽象概念的方式并尋求改進(jìn)的地方是非常重要的。為了實(shí)現(xiàn)這一目標(biāo),我們從人類智商測(cè)試中汲取用于測(cè)量抽象推理的靈感。

▌創(chuàng)建抽象推理數(shù)據(jù)庫

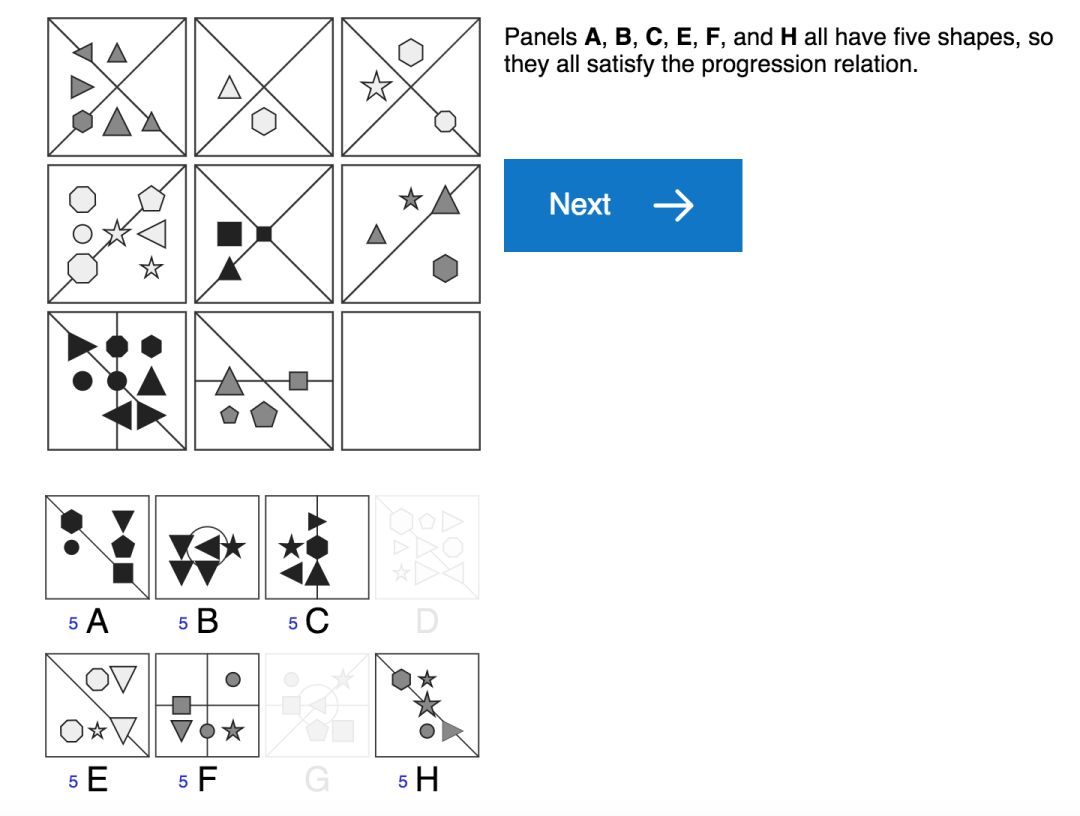

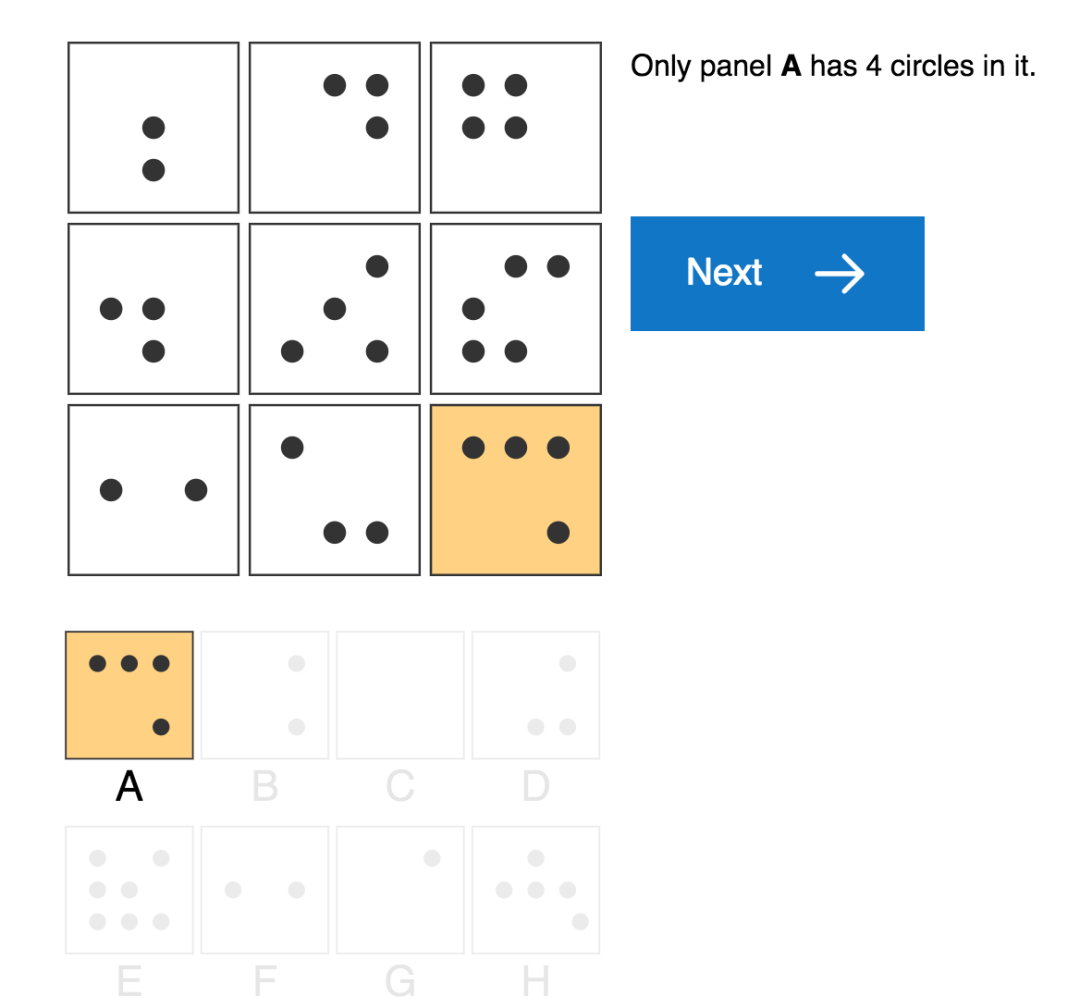

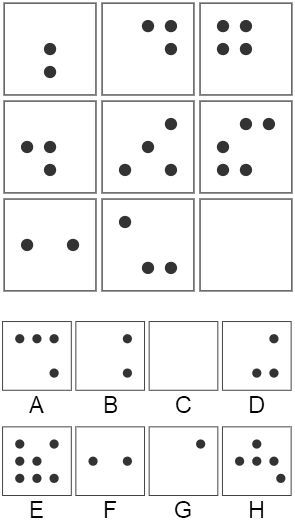

標(biāo)準(zhǔn)的人類 IQ 測(cè)試 (如上圖),通常要求測(cè)試者通過應(yīng)用他們?nèi)粘=?jīng)驗(yàn)學(xué)習(xí)到的原則來解釋一些簡(jiǎn)單感知上的視覺場(chǎng)景。例如,人類測(cè)試者可以通過觀察植物或建筑物的增長,或通過數(shù)學(xué)課上學(xué)習(xí)的加法運(yùn)算,或通過跟蹤銀行余額帶來的累積利息,來了解 “progressions” 這個(gè)概念 (表示屬性增加、遞增的概念)。然后,他們可以在謎題中應(yīng)用這一概念,來推斷形狀的數(shù)量,大小,甚至它們的顏色強(qiáng)度將沿著序列增加的情況。

我們還沒有辦法能讓機(jī)器學(xué)習(xí)智能體學(xué)習(xí)到這樣的“日常體驗(yàn)”,我們就無法輕易的去衡量如何它們將知識(shí)從現(xiàn)實(shí)世界轉(zhuǎn)化成視覺推理測(cè)試的能力。盡管如此,我們?nèi)匀豢梢詣?chuàng)建一個(gè)實(shí)驗(yàn)設(shè)置,以便能夠充分利用人類視覺推理測(cè)試。我們要研究的是從一組受控的視覺推理問題到另一組問題上的知識(shí)轉(zhuǎn)移,而不是研究從日常生活到視覺推理問題的知識(shí)轉(zhuǎn)移 (如人類測(cè)試中那樣)。

為了實(shí)現(xiàn)這個(gè)目標(biāo),我們構(gòu)建了一個(gè)用于創(chuàng)建矩陣問題的生成器,稱之為“程序生成矩陣數(shù)據(jù)集” (Proceduralyly Generated Matrices, PGM),用于抽象推理的模型試驗(yàn)。、該數(shù)據(jù)集涉及一組抽象因素并通過原始數(shù)據(jù)隨機(jī)采樣得到,這些抽象因素包括“漸進(jìn) (progressions)” 之類的關(guān)系、以及顏色大小等屬性數(shù)據(jù)。雖然該問題生成器只使用了一小部分的潛在因素,但它仍然會(huì)產(chǎn)生大量獨(dú)特的問題,以構(gòu)成豐富的矩陣數(shù)據(jù)集。

關(guān)系類型數(shù)據(jù)集 (R,元素是 r):包括 progression,XOR,OR,AND,consistent union關(guān)系等。

目標(biāo)類型數(shù)據(jù)集 (O,元素是 o):包括 shape,line 類型等。

屬性類型數(shù)據(jù)集 (A,元素是 a):包括 type,color,position,number 等屬性。

接著,我們對(duì)生成器可用的因素或組合進(jìn)行了約束,使生成器能夠創(chuàng)建用于模型訓(xùn)練和測(cè)試的不同問題數(shù)據(jù)集,以便我們進(jìn)一步測(cè)量模型推廣到測(cè)試集的泛化能力。例如,我們創(chuàng)建了一組謎題訓(xùn)練集,其中只有當(dāng)應(yīng)用線條顏色時(shí)才會(huì)遇到漸進(jìn) (progressions) 關(guān)系,而測(cè)試集中的情況是當(dāng)應(yīng)用形狀大小時(shí)才會(huì)發(fā)現(xiàn)該關(guān)系。如果模型在該測(cè)試集上表現(xiàn)良好,即使是訓(xùn)練時(shí)從未見過的數(shù)據(jù)情況下也是如此,就證明了我們的模型具有推斷和應(yīng)用抽象概念的能力。

▌抽象推理模型

在機(jī)器學(xué)習(xí)評(píng)估中所應(yīng)用的典型的泛化方案中,訓(xùn)練和測(cè)試數(shù)據(jù)是服從相同的基礎(chǔ)分布采樣的,所測(cè)試的所有網(wǎng)絡(luò)都表現(xiàn)出良好的泛化誤差,其中有一些絕對(duì)性能甚至超過75%,實(shí)現(xiàn)了令人印象深刻的結(jié)果。對(duì)于性能最佳的網(wǎng)絡(luò),它不僅能夠明確地計(jì)算不同圖像面板之間的關(guān)系,還能并行地評(píng)估了每個(gè)潛在答案的適合性。我們將此網(wǎng)絡(luò)架構(gòu)稱為—— Wild Relation Network (WReN),其模型結(jié)構(gòu)示意圖如下:

WReN模型結(jié)構(gòu)

其中,每個(gè) CNN 能夠獨(dú)立處理每個(gè)上下文面板 (panel),而每個(gè)上下文面板將用于返回一個(gè)單獨(dú)的答案并生成9個(gè)嵌入矢量。隨后,將這組得到的嵌入向量傳遞給 RN,其輸出的是單個(gè) sigmoid 單元,用于對(duì)問題答案的關(guān)聯(lián)得分進(jìn)行編碼。 通過這樣的網(wǎng)絡(luò)傳遞過程,得到8個(gè)問題的答案及其相應(yīng)的得分,最終通過一個(gè) softmax 函數(shù)得分來確定模型的預(yù)測(cè)答案。

▌實(shí)驗(yàn)分析

為了驗(yàn)證抽象推理模型,我們?cè)?PGM 數(shù)據(jù)集上進(jìn)行了大量的實(shí)驗(yàn)測(cè)試,并對(duì)比分析了不同模型的表現(xiàn),不同類型問題模型的表現(xiàn),模型的泛化表現(xiàn),輔助訓(xùn)練對(duì)模型表現(xiàn)的影響。

總的說來,當(dāng)需要在先前見過的屬性值之間進(jìn)行屬性值“內(nèi)插值(interpolated)”時(shí),以及在不熟悉的因素組合中應(yīng)用已知抽象關(guān)系進(jìn)行推理時(shí),模型表現(xiàn)出非常好的泛化能力。然而,同樣的網(wǎng)絡(luò)在“外推 (extrapolation)”方案中卻表現(xiàn)的更差。在這種情況下,測(cè)試集中的屬性值與訓(xùn)練集中的屬性值不在同一范圍內(nèi)。例如,對(duì)于訓(xùn)練期間包含深色物體而在測(cè)試期間包含淺色物體的謎題,就會(huì)出現(xiàn)這種情況。此外,當(dāng)模型訓(xùn)練時(shí)將先前學(xué)習(xí)到的關(guān)系 (如形狀數(shù)量的遞增關(guān)系) 應(yīng)用于新的屬性 (如大小) 時(shí),其泛化性能也會(huì)表現(xiàn)的更糟糕。

最后,我們觀察到當(dāng)訓(xùn)練的模型不僅能夠預(yù)測(cè)正確的答案,還能推理出正確答案 (即能夠考慮解決這個(gè)難題的特定關(guān)系和屬性) 時(shí),我們模型的泛化性能得到了改進(jìn)。更有趣的是,模型的準(zhǔn)確性與其矩陣潛在的正確推理能力密切相關(guān):當(dāng)推理解釋正確時(shí),模型的準(zhǔn)確性將達(dá)到87%;而當(dāng)其推理解釋錯(cuò)誤時(shí),這種準(zhǔn)確性表現(xiàn)將下降到只有32%。這表明當(dāng)模型能夠正確推斷出任務(wù)背后的抽象概念時(shí),它們可以獲得更好的性能。

▌總結(jié)

最近的研究主要集中探索用于解決機(jī)器學(xué)習(xí)問題的神經(jīng)網(wǎng)絡(luò)模型方法的優(yōu)點(diǎn)和缺點(diǎn),通常是基于模型的能力或泛化能力的研究。我們的研究結(jié)果表明,關(guān)于泛化能力的一般結(jié)論可能是無益的:我們的神經(jīng)網(wǎng)絡(luò)在某些泛化方案測(cè)試中表現(xiàn)良好,而在其他測(cè)試中表現(xiàn)很差。其中的成功取決于一系列因素,包括所用模型的架構(gòu)以及模型是否經(jīng)過訓(xùn)練來為其答案選擇提供可解釋的推理等。在幾乎所有的情況下,在超出模型經(jīng)驗(yàn)范圍的外推輸入或用于解決完全不熟悉的屬性問題時(shí),模型都會(huì)表現(xiàn)不佳。因此,這也為這個(gè)關(guān)鍵而又重要的研究領(lǐng)域未來的工作提供了一個(gè)明確的焦點(diǎn)。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4813瀏覽量

103383 -

人工智能

+關(guān)注

關(guān)注

1806文章

48971瀏覽量

248654

原文標(biāo)題:天啊,你要的智商已下線——用我們的IQ測(cè)試題研究測(cè)量神經(jīng)網(wǎng)絡(luò)的抽象推理能力

文章出處:【微信號(hào):AI_Thinker,微信公眾號(hào):人工智能頭條】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

測(cè)量神經(jīng)網(wǎng)絡(luò)的抽象推理能力

測(cè)量神經(jīng)網(wǎng)絡(luò)的抽象推理能力

評(píng)論