編者按:書籍、文章、圖像、視頻……在大眾眼里,創(chuàng)作者對這些成果都擁有無可爭議的知識版權(quán),為了防止作品被他人盜取、濫用,他們也會通過加上水印聲明自己的權(quán)益。那么,同樣是知識、創(chuàng)意的結(jié)晶,研究人員該如何保護自己的機器學習模型不被盜用呢?近日,IBM研究人員開發(fā)了一種將水印嵌入ML模型的技術,可以識別被盜模型。

論文作者:Jialong Zhang和Marc Ph. Stoecklin

作為人工智能服務的關鍵組成部分,如今深度學習已經(jīng)在模擬人類能力方面取得了巨大成功,如基于這項技術的計算機視覺、語音識別和自然語言處理。

然而,光鮮事物背后總有陰影。訓練一個深度學習模型通常意味著大量訓練數(shù)據(jù)、龐大的計算資源和擁有人性化專業(yè)知識的專家學者。雖然截至目前全球還沒有出現(xiàn)過針對模型的大型訴訟,而且開源是社區(qū)一貫以來的特色,但隨著技術發(fā)展日益成熟,未來,盜用模型用以非法牟利等事件的興起是可以預見的。

更嚴峻的是,我們不能指望用專利來保護自己的機器學習成果。眾所周知,機器學是一個日新月異的領域,全球各地的研究人員每天都能在前人基礎上提出更好的改進,一方面,算法和技術方案數(shù)量正在因此不斷增加,另一方面,這種情況卻為專利所有人界定造成了麻煩。

上月,DeepMind的一份專利單曝光,他們把強化學習,RNN,用神經(jīng)網(wǎng)絡處理序列、生成音頻、生成視頻幀、理解場景等12項成果打包申請專利,引發(fā)學界恐慌。雖然事后有人辟謠稱這是“防御性專利”,但這個事件確實也反映了業(yè)內(nèi)成果的一脈相承。

在這個背景下,保護企業(yè)、個人花大量時間、精力構(gòu)建的機器學習成果是有意義的。

為DNN模型添加水印

當我們往視頻和圖像上添加水印時,從技術角度看它們離不開兩個階段:嵌入和檢測。對于嵌入,開發(fā)者可以在圖像上加上自制的水印標記(可見/不可見);對于檢測,如果圖片確實被盜,開發(fā)者應該能提取嵌入的水印,以此證明自己的所有權(quán)。

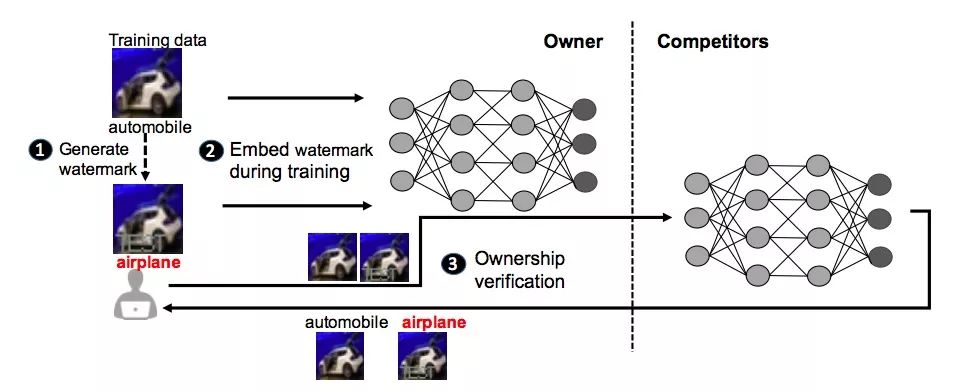

IBM提出的模型保護方法正是受這種思想啟發(fā),上圖是為DNN添加水印框架的主要流程。

首先,該框架會為模型所有者生成定制水印和預定義標簽(?);其次,生成水印后,它會將生成的水印嵌入到目標DNN中,這是通過訓練實現(xiàn)的(?);完成嵌入后,新生成的模型能夠進行所有權(quán)驗證,一旦發(fā)現(xiàn)模型被盜用,所有者可以把水印作為輸入,檢查它的輸出(?)。

研究人員開發(fā)了三種不同的算法來為神經(jīng)網(wǎng)絡生成水印:

將有意義的內(nèi)容與原始訓練數(shù)據(jù)一起作為水印嵌入到受保護的DNN中

將不相關的數(shù)據(jù)樣本作為水印嵌入到受保護的DNN中

將噪聲作為水印嵌入受保護的DNN中

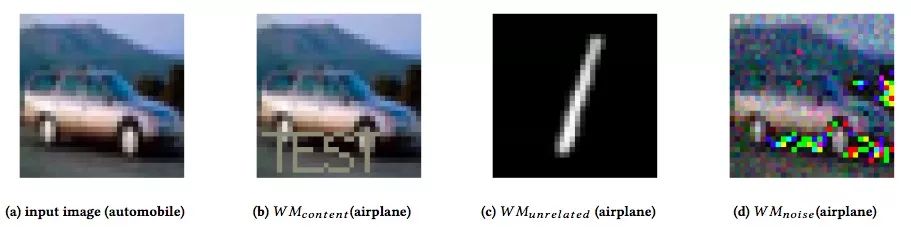

算法一(WMcontent):第一種算法是對原數(shù)據(jù)集進行加工。他們把訓練數(shù)據(jù)中的圖像作為輸入,并在上面加入額外的、有意義的內(nèi)容,比如下圖(b)中的特殊字符串“TEST”。輸入這張圖后,原模型會把它歸類為“飛機”,如果是其他沒有在帶“TEST”的數(shù)據(jù)上訓練過的模型,它們遇到這類圖時應該還是會輸出“汽車”。

算法二(WMunrelated):為了避免嵌入水印影響模型原始性能,他們提出的第二種算法是把和任務無關的其他類圖像作為水印,讓模型學會“額外”技能。如下圖(c)所示,他們設置了一幅手寫數(shù)字圖像,并分配給它一個特殊標簽:“飛機”。如果沒有盜用模型,其他模型是無法把“1”識別成“飛機”的。

算法三(WMnoise):這種方法是第一種算法的升級版,比起添加有意義標志,算法三加入的是無意義的噪聲。簡而言之,輸入圖像(a)后,原模型能識別這是“汽車”,但輸入圖像(d)后,只有原模型才會把它認做“飛機”。它的好處是加入的高斯噪聲和純噪聲是可以分開的,但盜用者不知道具體方法。

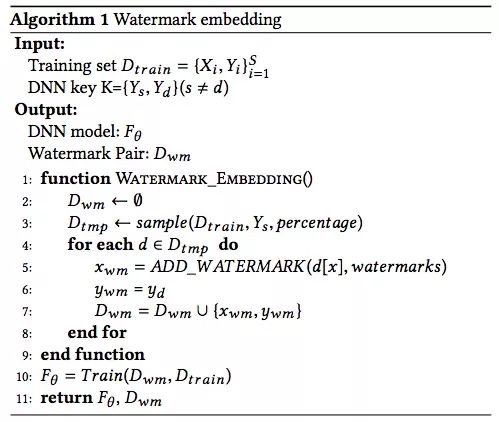

有了水印,之后就是把它們部署進DNN,下面是具體算法:

實驗結(jié)果

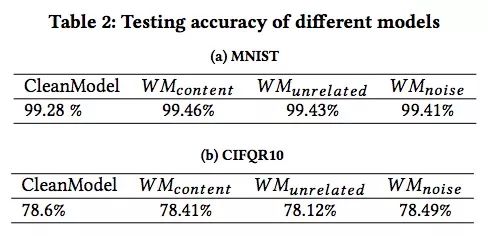

為了測試水印框架,研究人員使用了兩個公共數(shù)據(jù)集:MNIST,一個擁有60,000個訓練圖像和10,000個測試圖像的手寫數(shù)字識別數(shù)據(jù)集;CIFAR10,一個包含50,000個訓練圖像和10,000個測試圖像的對象分類數(shù)據(jù)集。

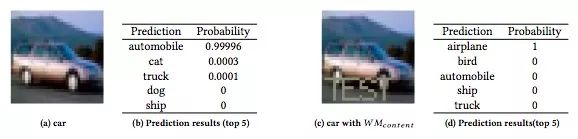

上圖是原模型在CIFAR10上的測試表現(xiàn):輸入一幅汽車圖,模型預測它為汽車的概率有0.99996,其次是貓、卡車等;輸入一幅帶“TEST”的汽車圖,模型預測它為飛機的概率是100%。這表示水印已經(jīng)生成,而且模型表現(xiàn)良好。

那么這三種水印會對模型性能造成多大影響呢?

如上圖所示,有水印模型的分類準確率和干凈模型基本一致。而綜合其他穩(wěn)健性檢測數(shù)據(jù),WMnoise是最安全的加水印方法,盜用者很難把新增的噪聲和原始噪聲區(qū)分開來;WMcontent雖然做法質(zhì)樸,但它在兩個數(shù)據(jù)集上表現(xiàn)更穩(wěn)健;而WMunrelated是最易于使用的,畢竟無論是添加有意義標記還是無意義噪聲,這里面都包含一定的工作量,而加入一個自帶預設標簽的無關圖像自然是懶人首選。

小結(jié)

當然,這種給深度學習模型加水印的方法也有缺陷。首先,既然是盜用模型,盜用者肯定是遠程部署的,這意味著模型參數(shù)不會被公開。其次,如果盜用者開發(fā)出不同的反水印機制,DNN模型水印本身的穩(wěn)健性也會發(fā)生不同變化。

此外,如果泄露的模型不是在線部署的,而是作為內(nèi)部服務,那這種方法也無法檢測其中是否存在盜用行為。不過這種情況也有好處,就是盜用者無法直接用模型來非法牟利。

目前,IBM正在內(nèi)部普及這一技術,未來可能會開發(fā)面向用戶的相關服務。當然,作為一個在美國專利榜連續(xù)制霸25年的科技大廠,IBM已經(jīng)為這種方法申請了專利。

-

IBM

+關注

關注

3文章

1823瀏覽量

75829 -

神經(jīng)網(wǎng)絡

+關注

關注

42文章

4814瀏覽量

103631 -

機器學習

+關注

關注

66文章

8503瀏覽量

134625

原文標題:IBM最新專利:為機器學習模型打上水印

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

探索一種降低ViT模型訓練成本的方法

LabVIEW進行癌癥預測模型研究

研究人員開發(fā)了一種“波浪形”晶體管結(jié)構(gòu),可以提升顯示電路的性能

研究人員開發(fā)了一種新穎的機器學習管道

研究人員通過AI和機器人來治療手部震顫疾病

麥克斯·德爾布呂克分子醫(yī)學中心的研究人員開發(fā)了一種新工具

研究人員開發(fā)了一種新型的磁力驅(qū)動高速軟件機器人

關于研究人員開發(fā)了一種高容量的陰極材料的特性與能效

研究人員開發(fā)出新型數(shù)學模型的應用與人工智能的復雜性和訓練

澳大利亞國立大學研究人員開發(fā)了一種新型夜視技術

研究人員開發(fā)新技術以提高電池壽命

研究人員找到了一種更好的方法來冷卻 GaN 器件

IBM研究人員開發(fā)了一種將水印嵌入ML模型的技術,可以識別被盜模型

IBM研究人員開發(fā)了一種將水印嵌入ML模型的技術,可以識別被盜模型

評論