機(jī)器學(xué)習(xí)發(fā)展至今,我們看到很多AI模型經(jīng)過(guò)大量數(shù)據(jù)能畫畫、能作曲。但是現(xiàn)在一個(gè)“神奇”的網(wǎng)站可以通過(guò)你的文字生成意想不到的圖像。事情還要從大半年前的一篇論文說(shuō)起。

在今年一月份發(fā)表的一篇論文中,微軟研究院的實(shí)習(xí)生們訓(xùn)練了一個(gè)機(jī)器學(xué)習(xí)算法,稱為AttnGAN。這是GAN的一種變體,可以根據(jù)寫下的文字生成圖像,圖像質(zhì)量是之前技術(shù)生成的圖像質(zhì)量的三倍。

這項(xiàng)技術(shù)可以生成任意圖像,從普通的田園風(fēng)光到抽象的場(chǎng)景,每幅圖都能將文字描述詳細(xì)地表示出來(lái)。

論文簡(jiǎn)介

最近很多文本生成圖像的方法都是基于生成對(duì)抗網(wǎng)絡(luò)(GAN)的,常用方法是將完整的文本描述編寫進(jìn)整個(gè)句子向量中作為圖片生成的條件。雖然已經(jīng)能生成質(zhì)量不錯(cuò)的圖像了,但是由于句子向量缺少在詞語(yǔ)層面上的微調(diào)信息,GAN無(wú)法生成更高質(zhì)量的圖像。這一問題在生成復(fù)雜場(chǎng)景時(shí)更嚴(yán)重。

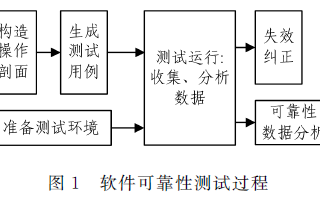

為了解決這一問題,作者提出了注意力生成對(duì)抗網(wǎng)絡(luò)(AttnGAN),用注意力驅(qū)動(dòng)、多階段的方法對(duì)文本生成圖像的問題進(jìn)行微調(diào)。AttnGAN的整體結(jié)構(gòu)如圖:

模型有兩個(gè)創(chuàng)新元素。首先是注意力生成網(wǎng)絡(luò),其中的注意力機(jī)制是通過(guò)觀察與該區(qū)域最相關(guān)的文字,生成器畫出圖像的不同部分。

更具體地說(shuō),除了將自然語(yǔ)言描述編碼到全局句子向量中,句中的每個(gè)單詞同樣有對(duì)應(yīng)的向量。在第一階段,生成網(wǎng)絡(luò)利用全局句子向量生成一個(gè)低分辨率的圖像。接著,它會(huì)通過(guò)注意力層用每個(gè)區(qū)域的圖片向量查詢?cè)~向量,從而形成一個(gè)詞-語(yǔ)境向量。之后,它會(huì)將區(qū)域圖像向量和對(duì)應(yīng)的詞-語(yǔ)境向量相結(jié)合,形成一個(gè)多模態(tài)的語(yǔ)境向量。這就能夠在各個(gè)階段生成細(xì)節(jié)更豐富的高分辨率圖像。

該結(jié)構(gòu)中的另一個(gè)重要組成部分是深度注意力多模態(tài)相似模型(DAMSM)。由于有注意力機(jī)制,DAMSM可以計(jì)算生成圖像和句子之間的相似性。所以,DAMSM對(duì)訓(xùn)練生成器提供了額外的調(diào)整損失函數(shù)。

模型試驗(yàn)

與此前的方法相同,這篇論文提出的方法也在CUB和COCO兩個(gè)數(shù)據(jù)集上測(cè)試。最終訓(xùn)練的結(jié)果如下:

每個(gè)場(chǎng)景的第一張圖片都是AttnGAN的第一階段(G0),僅僅描繪出了場(chǎng)景的原始輪廓,圖像分辨率很低。基于詞向量,接下來(lái)的兩個(gè)階段(G1和G2)學(xué)習(xí)糾正前面的結(jié)果。

在CUB數(shù)據(jù)集上的生成結(jié)果

經(jīng)過(guò)COCO數(shù)據(jù)集訓(xùn)練的模型生成的結(jié)果,圖中的描述幾乎是不可能在現(xiàn)實(shí)中出現(xiàn)的

奇怪的方向

總的來(lái)說(shuō),AttnGAN的表現(xiàn)還是不錯(cuò)的。但是國(guó)外一些研究者逐漸找到了新的玩法。研究者Cristóbal Valenzuela根據(jù)論文搭建了一個(gè)網(wǎng)站,用戶可以嘗試AttnGAN,但不同的是,訓(xùn)練數(shù)據(jù)換成了更大的數(shù)據(jù)集。機(jī)器學(xué)習(xí)愛好者Janelle Shane在博客中寫道:“當(dāng)把這個(gè)算法在另一個(gè)更大的、內(nèi)容更多樣的數(shù)據(jù)集上訓(xùn)練后,生成的圖片難以符合文字描述(并且變得非常奇怪)。”例如下面這個(gè)例子,同樣的一句話,用原始模型生成的圖片是這樣的:

然而換了訓(xùn)練數(shù)據(jù)集后:

這是……什么?由于在更大的數(shù)據(jù)集上訓(xùn)練過(guò),所以當(dāng)GAN要畫出我要求的內(nèi)容時(shí),它要搜索的圖像就更多,問題也變得廣泛。不僅僅在小鳥的生成上有限制,在生成人像上也會(huì)出現(xiàn)bug,例如下圖:

這個(gè)表現(xiàn)得就很糟了,根本分不清哪里是人臉。其他類似的還有很多,完全就是超現(xiàn)實(shí)主義作品。

Janelle Shane表示:“這個(gè)demo非常有趣,它也體現(xiàn)了目前先進(jìn)的圖像識(shí)別算法是如何理解圖像和文字的。它們?nèi)绾卫斫狻贰颉祟悺吭?D圖像中,算法看到的人指向前方和側(cè)面是完全不同的。”

對(duì)于這一結(jié)果,AttnGAN論文的作者Tao Xu也給予了回復(fù)。Xu目前是美國(guó)理海大學(xué)一名研究生,她認(rèn)為這是對(duì)論文結(jié)果的重要改進(jìn):

“隨著深度學(xué)習(xí)的快速發(fā)展,計(jì)算機(jī)視覺系統(tǒng)非常強(qiáng)大。例如它們可以從醫(yī)學(xué)影像中診斷疾病、在自動(dòng)駕駛系統(tǒng)中定位行人和汽車。但是,我們?nèi)匀徊荒苷J(rèn)為這些系統(tǒng)完全理解了它們所看到的東西。因?yàn)椋绻麢C(jī)器真的擁有了智慧,它們不會(huì)僅識(shí)別圖像,而是可以生成圖像。

我們的AttnGAN將注意力機(jī)制和生成對(duì)抗網(wǎng)絡(luò)結(jié)合了起來(lái),大大提高了文本生成圖像的模型性能。由于注意力是人類特有的概念,我們的AttnGAN就能學(xué)習(xí)這種”智慧“,像人類一樣畫畫,即注意相關(guān)詞語(yǔ)以及相關(guān)圖像區(qū)域。

雖然AttnGAN比之前的文本到圖像的模型表現(xiàn)得更好,但是生成多種“現(xiàn)實(shí)畫風(fēng)”的物體對(duì)整個(gè)領(lǐng)域還是待解決的問題。我們希望未來(lái)在這一方向進(jìn)行更多研究。”

-

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8497瀏覽量

134231 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1223瀏覽量

25321 -

自然語(yǔ)言

+關(guān)注

關(guān)注

1文章

291瀏覽量

13617

原文標(biāo)題:雖然很驚悚,但這個(gè)AI靈魂畫手真的很努力了

文章出處:【微信號(hào):jqr_AI,微信公眾號(hào):論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

基于擴(kuò)散模型的圖像生成過(guò)程

HarmonyOS NEXT意圖框架習(xí)慣推薦一場(chǎng)景說(shuō)明

六月,帶你品味合心鎮(zhèn)的合心瓜,享受田園采摘生活

點(diǎn)陣式液晶任意圖片顯示的實(shí)現(xiàn)

MAX4455 任意圖形隨屏顯示視頻發(fā)生器

紅外場(chǎng)景仿真在導(dǎo)引頭圖像實(shí)時(shí)生成中的應(yīng)用

基于形式概念分析的圖像場(chǎng)景語(yǔ)義標(biāo)注模型

GAN在圖像生成應(yīng)用綜述

基于生成式對(duì)抗網(wǎng)絡(luò)的端到端圖像去霧模型

一種基于改進(jìn)的DCGAN生成SAR圖像的方法

如何去解決文本到圖像生成的跨模態(tài)對(duì)比損失問題?

AIGC最新綜述:從GAN到ChatGPT的AI生成歷史

基于文本到圖像模型的可控文本到視頻生成

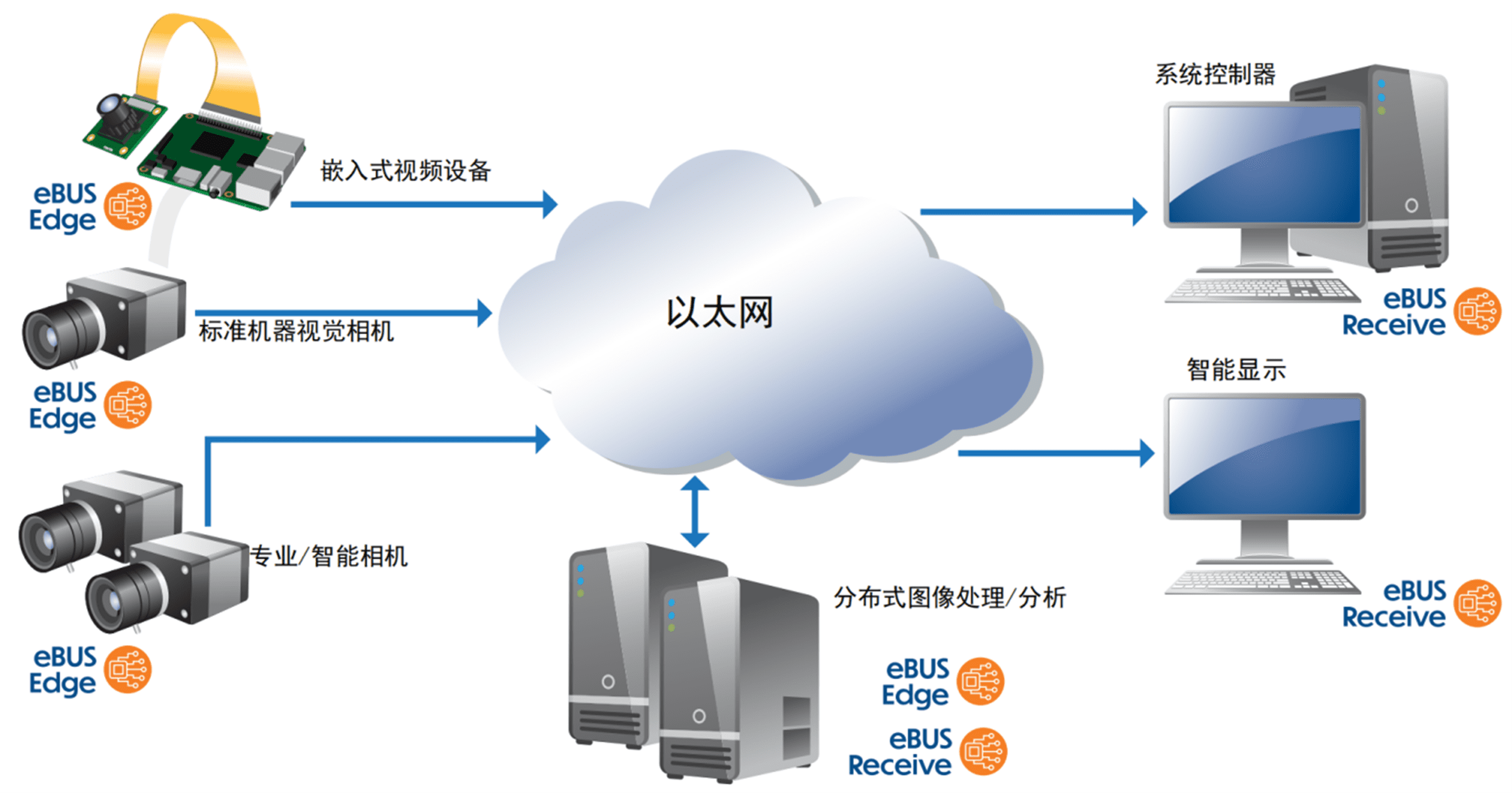

一鍵解鎖:將任意圖像設(shè)備秒變GigE Vision設(shè)備的終極秘訣

AttnGAN可以生成任意圖像,從普通的田園風(fēng)光到抽象的場(chǎng)景

AttnGAN可以生成任意圖像,從普通的田園風(fēng)光到抽象的場(chǎng)景

評(píng)論