昨天arXiv出現了好幾篇被CVPR 2019接收的論文。

其中來自微軟和中國科技大學研究學者的論文《Deep High-Resolution Representation Learning for Human Pose Estimation》和相應代碼甫一公布,立刻引起大家的關注,不到一天之內,github上已有將近50顆星。

今天就跟大家一起來品讀此文妙處。

該文作者信息:

該文為第一作者Ke Sun在微軟亞洲研究院實習期間發明的算法。

基本思想

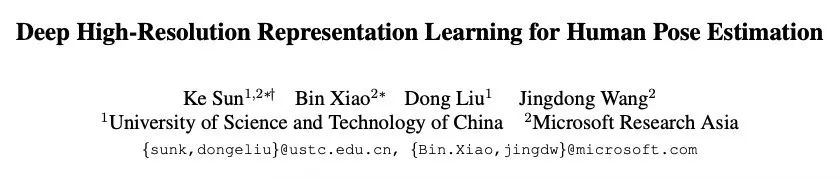

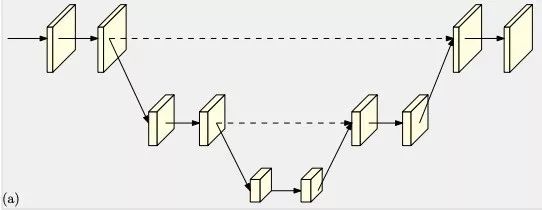

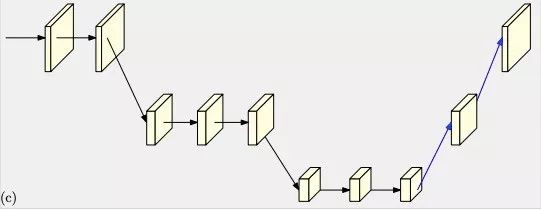

作者觀察到,現有姿態估計算法中往往網絡會有先降低分辨率再恢復高分辨率的過程,比如下面的幾種典型網絡。

為便于表達,在下面的a、b、c、d四幅圖中,同一水平線上的特征圖為相同分辨率,越向下分辨率越小,在最終的高分辨率特征圖heatmap中計算姿態估計的關鍵點。

Hourglass

Cascaded pyramid networks

Simple baseline

Combined with dilated convolutions

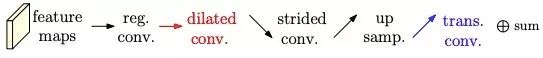

其中的網絡結構說明如下:

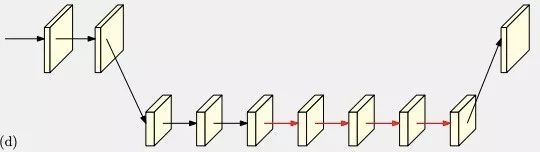

作者希望不要有這個分辨率恢復的過程,在網絡各個階段都存在高分辨率特征圖。

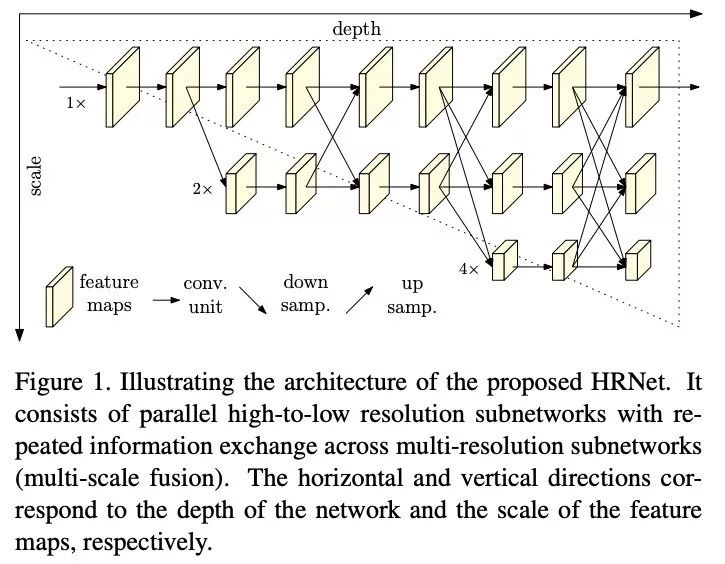

下圖簡潔明了地表達作者的思想。

在上圖中網絡向右側方向,深度不斷加深,網絡向下方向,特征圖被下采樣分辨率越小,相同深度高分辨率和低分辨率特征圖在中間有互相融合的過程。

作者描述這種結構為不同分辨率子網絡并行前進。

關鍵點的heatmap是在最后的高分辨率特征圖上計算的。

網絡中不同分辨率子網絡特征圖融合過程如下:

主要是使用strided 3*3的卷積來下采樣和up sample 1*1卷積上采樣。

這么做有什么好處?

作者認為:

1)一直維護了高分辨率特征圖,不需要恢復分辨率。

2)多次重復融合特征的多分辨率表示。

實驗結果

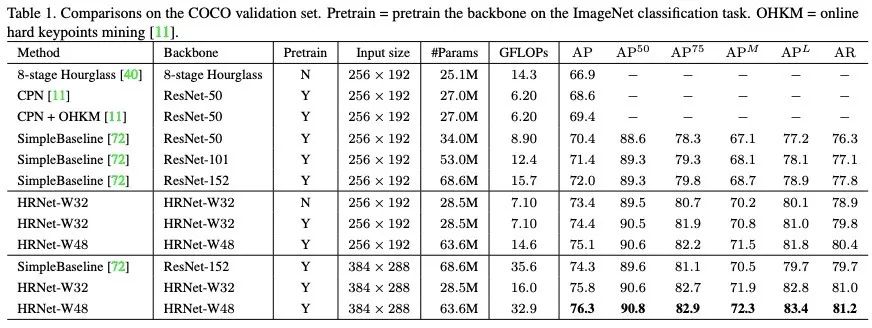

該算法在COCO姿態估計數據集的驗證集上測試結果:

與目前的state-of-the-art比較,取得了各個指標的最高值。相同分辨率的輸入圖像,與之前的最好算法相比增長了3個百分點!

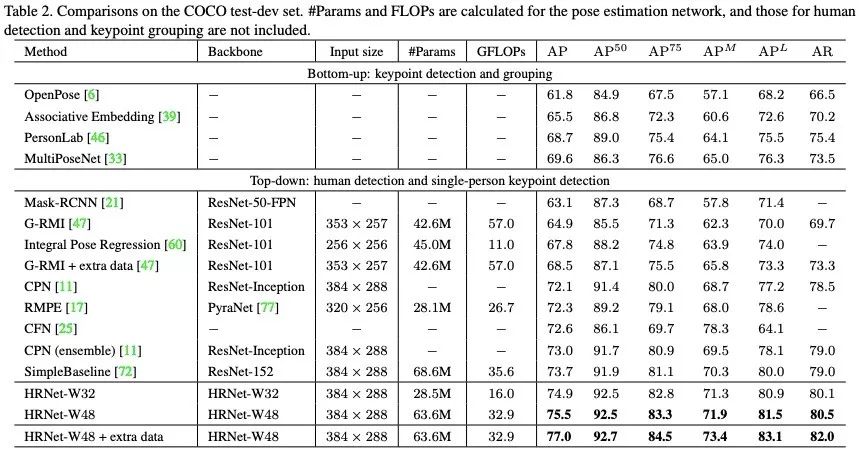

在COCO test-dev數據集上,同樣一騎絕塵!

在MPII test 數據集上,同樣取得了最好的結果!

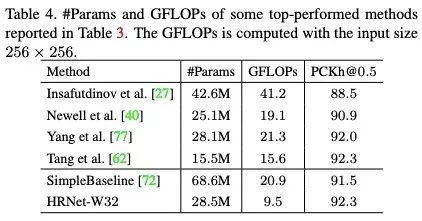

作者進一步與之前最好模型比較了參數量、計算量,該文發明的HRNet-W32在精度最高的同時,計算量最低!

如下圖:

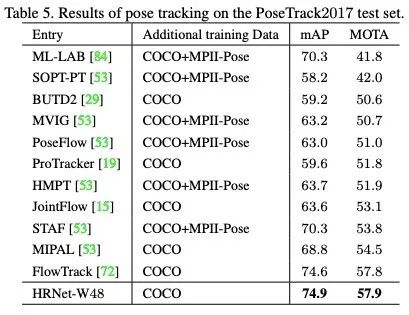

在PoseTrack2017姿態跟蹤數據集上的結果比較:

同樣取得了最好的結果。

下圖是算法姿態估計的結果示例:

(請點擊查看大圖)

不僅僅是姿態估計

作者在官網指出,深度高分辨率網絡不僅對姿態估計有效,也可以應用到計算機視覺的其他任務,諸如語義分割、人臉對齊、目標檢測、圖像分類中,期待更多具有說服力的結果公布。

-

數據集

+關注

關注

4文章

1223瀏覽量

25304 -

GitHub

+關注

關注

3文章

481瀏覽量

17488 -

姿態估計

+關注

關注

0文章

8瀏覽量

2182

原文標題:CVPR2019|微軟、中科大開源基于深度高分辨表示學習的姿態估計算法

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

基于深度學習的二維人體姿態估計算法

微軟、中科大開源基于深度高分辨表示學習的姿態估計算法

微軟、中科大開源基于深度高分辨表示學習的姿態估計算法

評論