Facebook AI、新加坡國(guó)立大學(xué)、360 人工智能研究院的研究人員提出一種新的卷積操作OctConv,可以直接替代傳統(tǒng)卷積,持續(xù)提高圖像和視頻識(shí)別任務(wù)的精度,同時(shí)降低內(nèi)存和計(jì)算成本。

傳統(tǒng)卷積運(yùn)算,有了一種全新的替代方法。

近日,F(xiàn)acebook AI、新加坡國(guó)立大學(xué)、360人工智能研究院的研究人員提出一種新的卷積操作——Octave Convolution (OctConv)。

論文地址:

https://export.arxiv.org/pdf/1904.05049

其中,論文一作陳云鵬現(xiàn)于新加坡國(guó)立大學(xué)讀博士,師從顏水成和馮佳時(shí),兩人也是這篇論文的作者。其他作者來(lái)自Facebook AI。

作者表示,OctConv 是一種即插即用的卷積單元,可以直接替代傳統(tǒng)的卷積,而無(wú)需對(duì)網(wǎng)絡(luò)架構(gòu)進(jìn)行任何調(diào)整。

在自然的圖像中,信息以不同的頻率傳遞,其中較高的頻率通常以精細(xì)的細(xì)節(jié)編碼,較低的頻率通常以全局結(jié)構(gòu)編碼。

類似地,卷積層的輸出特征圖也可以看做是不同頻率的信息的混合。

在這項(xiàng)工作中,作者提出將混合特征映射根據(jù)其頻率進(jìn)行分解,并設(shè)計(jì)了一種全新的卷積運(yùn)算:Octave Convolution (OctConv),用以存儲(chǔ)和處理在較低空間分辨率下空間變化 “較慢” 的特征圖,從而降低了內(nèi)存和計(jì)算成本。

Octave 一詞表示 “八音階” 或 “八度”,音樂(lè)里降 8 個(gè)音階表示頻率減半。通過(guò)降低低頻特征的分辨率,從而節(jié)省內(nèi)存和計(jì)算。

實(shí)驗(yàn)表明,通過(guò)簡(jiǎn)單地用OctConv 替代卷積,我們可以持續(xù)提高圖像和視頻識(shí)別任務(wù)的精度,同時(shí)降低內(nèi)存和計(jì)算成本。

采用 OctConv 的 ResNet-152 僅用 22.2 GFLOPs 就能在 ImageNet 上實(shí)現(xiàn) 82.9% 的top-1 分類精度。

完美替代傳統(tǒng)卷積,即插即用無(wú)需調(diào)參

卷積神經(jīng)網(wǎng)絡(luò) (CNNs) 在許多計(jì)算機(jī)視覺(jué)任務(wù)中都取得了顯著的成功,并且隨著最近的研究在降低密集模型參數(shù)和特征圖通道維數(shù)的固有冗余,它們的效率不斷提高。然而,CNN 生成的特征圖在空間維度上也存在大量冗余,其中每個(gè)位置獨(dú)立存儲(chǔ)自己的特征描述符,忽略了可以一起存儲(chǔ)和處理的相鄰位置之間的公共信息。

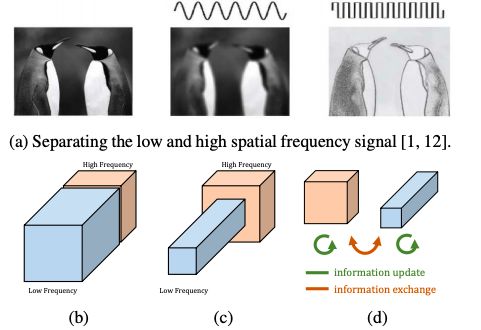

圖 1:(a) 動(dòng)機(jī)。視覺(jué)的空間頻率模型的相關(guān)研究表明,自然圖像可以分解為低空間頻率和高空間頻率兩個(gè)部分。(b) 卷積層的輸出圖也可以根據(jù)其空間頻率進(jìn)行分解和分組。(c) 所提出的多頻特征表示將平滑變化的低頻映射存儲(chǔ)在低分辨率張量中,以減少空間冗余。(d) 所提出的 Octave Convolution 直接作用于這個(gè)表示。它會(huì)更新每個(gè)組的信息,并進(jìn)一步支持組之間的信息交換。

如圖 1(a) 所示,自然圖像可以分解為描述平穩(wěn)變化結(jié)構(gòu)的低空間頻率分量和描述快速變化的精細(xì)細(xì)節(jié)的高空間頻率分量。

類似地,我們認(rèn)為卷積層的輸出特征映射也可以分解為不同空間頻率的特征,并提出了一種新的多頻特征表示方法,將高頻和低頻特征映射存儲(chǔ)到不同的組中,如圖 1(b) 所示。因此,通過(guò)相鄰位置間的信息共享,可以安全地降低低頻組的空間分辨率,減少空間冗余,如圖 1(c) 所示。

為了適應(yīng)新的特征表示,我們提出 Octave Convolution (OctConv),它接收包含兩個(gè)頻率的特征映射,并直接從低頻映射中提取信息,而無(wú)需解碼回到高頻,如圖 1(d) 所示。

作為傳統(tǒng)卷積的替代,OctConv 消耗的內(nèi)存和計(jì)算資源都大大減少。此外,OctConv利用相應(yīng)的 (低頻) 卷積處理低頻信息,有效地?cái)U(kuò)大了原始像素空間的感受野,從而提高識(shí)別性能。

我們以一種通用的方式設(shè)計(jì) OctConv,使它成為卷積的替代,而且即插即用。由于OctConv 主要側(cè)重于處理多空間頻率的特征映射并減少其空間冗余,它與現(xiàn)有的方法是相交且互補(bǔ)的,現(xiàn)有的方法側(cè)重于構(gòu)建更好的 CNN 拓?fù)浣Y(jié)構(gòu),減少卷積特征映射中的信道冗余和密集模型參數(shù)中的冗余。

此外,與利用多尺度信息的方法不同,OctConv 可以很容易地部署為即插即用單元,以替代卷積,而不需要改變網(wǎng)絡(luò)結(jié)構(gòu)或需要超參數(shù)調(diào)優(yōu)。

我們的實(shí)驗(yàn)證明,通過(guò)簡(jiǎn)單地用 OctConv 代替?zhèn)鹘y(tǒng)卷積,可以持續(xù)提高流行的 2D CNN 模型的 ImageNet 圖像識(shí)別性能,包括 ResNet ResNeXt, DenseNet, MobileNet,以及 SE-Net。

采用 OctConv 的 Oct-ResNet-152 超過(guò)了手工設(shè)計(jì)的 state-of-the-art 網(wǎng)絡(luò),并且所需的內(nèi)存和計(jì)算成本更低。

我們的貢獻(xiàn)可以總結(jié)如下:

我們提出將卷積特征映射分解成不同空間頻率的兩個(gè)組,并分別以相應(yīng)的頻率處理不同的卷積,相隔一個(gè)八度 (octave)。由于可以降低低頻圖的分辨率,因此能夠節(jié)省存儲(chǔ)和計(jì)算。這也有助于每一層獲得更大的感受野,以捕獲更多的上下文信息。

我們?cè)O(shè)計(jì)了一種即插即用的運(yùn)算,名為 OctConv,用來(lái)代替?zhèn)鹘y(tǒng)的卷積運(yùn)算。OctConv直接對(duì)新的特征表示進(jìn)行運(yùn)算,減少了空間冗余。更重要的是,OctConv 在實(shí)踐中速度很快,達(dá)到了接近理論極限的加速。

我們廣泛研究了所提出的 OctConv 在用于圖像和視頻任務(wù)的各種骨干 CNN 上的特性,并獲得了顯著的性能提高,甚至可以與最好的 AutoML 網(wǎng)絡(luò)相媲美。

Octave Convolution:方法詳解

octave feature representation 減少了空間冗余,比原始表示更加緊湊。然而,由于輸入特征的空間分辨率不同,傳統(tǒng)卷積不能直接對(duì)這種表示進(jìn)行操作。

避免這個(gè)問(wèn)題的一種簡(jiǎn)單方法是將低頻部分 上采樣到原始的空間分辨率,將它與

上采樣到原始的空間分辨率,將它與 連接起來(lái),然后進(jìn)行卷積,這將導(dǎo)致額外的計(jì)算和內(nèi)存開銷。

連接起來(lái),然后進(jìn)行卷積,這將導(dǎo)致額外的計(jì)算和內(nèi)存開銷。

為了充分利用緊湊的多頻特征表示,我們提出 Octave Convolution,它可以直接在分解張量 上運(yùn)行,而不需要任何額外的計(jì)算或內(nèi)存開銷。

上運(yùn)行,而不需要任何額外的計(jì)算或內(nèi)存開銷。

傳統(tǒng)卷積(Vanilla Convolution)

令 表示一個(gè) k×k 卷積核,

表示一個(gè) k×k 卷積核, 表示輸入張量和輸出張量。

表示輸入張量和輸出張量。

中的每個(gè) feature map 可以下面的公式計(jì)算:

中的每個(gè) feature map 可以下面的公式計(jì)算:

式中 (p, q) 為位置坐標(biāo),

定義了一個(gè)局部鄰域。

Octave Convolution.

我們的設(shè)計(jì)目標(biāo)是有效地處理相應(yīng)頻率張量中的低頻和高頻分量,同時(shí)使我們的 Octave特征表示的高頻分量和低頻分量之間能夠有效地通信。

設(shè) X, Y 為分解輸入和輸出張量。那么輸出 的高頻和低頻特征映射將由

的高頻和低頻特征映射將由 和

和

給出。

給出。

Octave Convolution 的設(shè)計(jì)細(xì)節(jié)。綠色箭頭表示信息更新,紅色箭頭表示兩個(gè)頻率之間的信息交換。

Octave Convolution kernel。k×k Octave 卷積核與普通卷積核等價(jià),即二者具有完全相同的參數(shù)量。

實(shí)驗(yàn)和評(píng)估

在實(shí)驗(yàn)和評(píng)估部分,我們驗(yàn)證了 Octave Convolution 在 2D 和 3D 網(wǎng)絡(luò)中的有效性和效率。

我們分別進(jìn)行了 ImageNet 上圖像分類的研究,然后將其與目前最先進(jìn)的方法進(jìn)行了比較。

然后,我們用 Kinetics-400 和 dynamics 600 數(shù)據(jù)集,證明所提出的 OctConv 也適用于 3D CNN。

圖 4:ImageNet 上的結(jié)果

如圖 4 所示,采用 OctConv 的模型比基線模型更有效、更準(zhǔn)確。圖中每條線的黑色標(biāo)記表示不采用 OctConv 的相應(yīng)基線模型的精度。

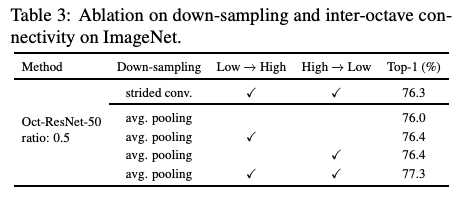

表 2:ResNet-50 的結(jié)果

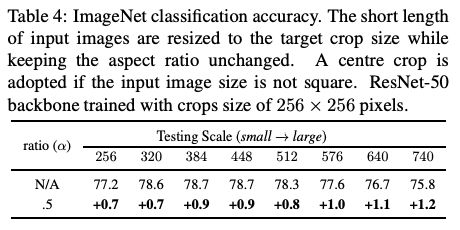

表 4:ImageNet 分類精度

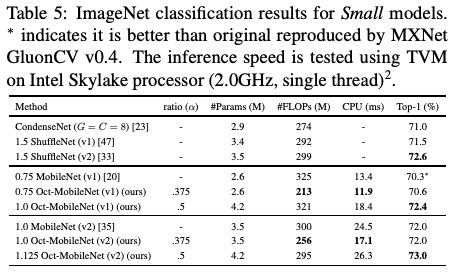

表 5:小型模型的 ImageNet 分類精度

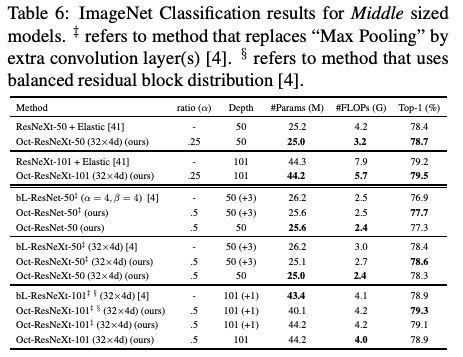

表 6:中型模型的 ImageNet 分類精度

表 7:大型模型的 ImageNet 分類精度

表 8:視頻動(dòng)作識(shí)別的結(jié)果

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4814瀏覽量

103696 -

圖像識(shí)別

+關(guān)注

關(guān)注

9文章

527瀏覽量

39124 -

Facebook

+關(guān)注

關(guān)注

3文章

1432瀏覽量

56787

原文標(biāo)題:完美代替?zhèn)鹘y(tǒng)卷積!Facebook等提出全新卷積操作OctConv,速度接近理論極限

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

verilog實(shí)現(xiàn)卷積運(yùn)算

Nexar如何為FPGA設(shè)計(jì)提供一種全新的方法?

一種伺服電機(jī)的控制方法

利用卷積調(diào)制構(gòu)建一種新的ConvNet架構(gòu)Conv2Former

簡(jiǎn)談卷積—幽默笑話談卷積

一種全新的深亞微米IC設(shè)計(jì)方法

一種級(jí)數(shù)混合運(yùn)算產(chǎn)生SPWM波新方法

一種卷積神經(jīng)網(wǎng)絡(luò)和極限學(xué)習(xí)機(jī)相結(jié)合的人臉識(shí)別方法_余丹

一種改進(jìn)的基于卷積神經(jīng)網(wǎng)絡(luò)的行人檢測(cè)方法

一種基于深度學(xué)習(xí)的焊點(diǎn)位置檢測(cè)方法

一種輕量級(jí)時(shí)間卷積網(wǎng)絡(luò)設(shè)計(jì)方案

一種優(yōu)化的分布式二維卷積算法

一種基于DSCNN-BILSTM的入侵檢測(cè)方法

傳統(tǒng)卷積運(yùn)算,有了一種全新的替代方法

傳統(tǒng)卷積運(yùn)算,有了一種全新的替代方法

評(píng)論